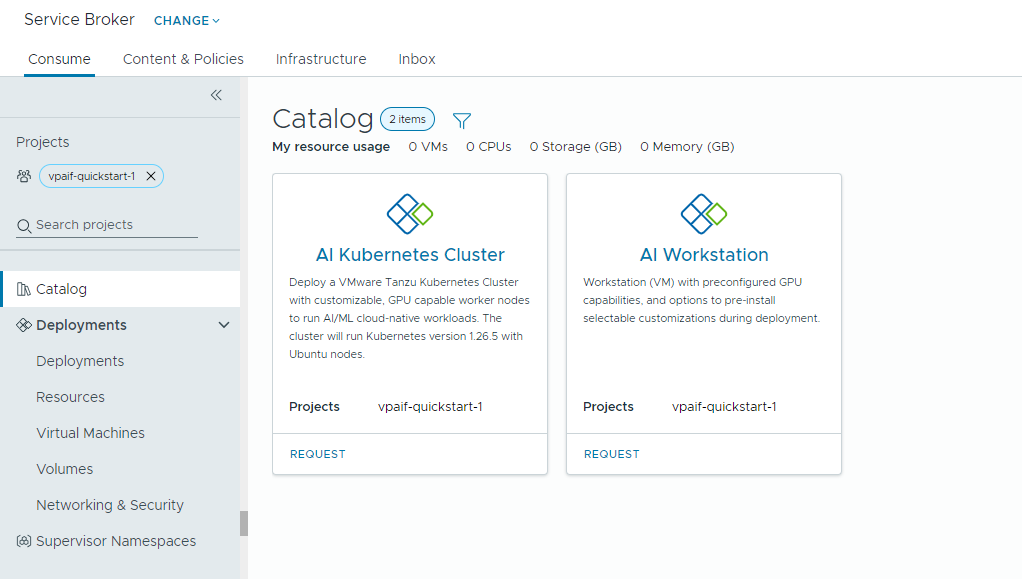

Se o administrador de nuvem tiver configurado o Private AI Automation Services no VMware Aria Automation, você poderá solicitar cargas de trabalho de IA usando o catálogo do Automation Service Broker.

O Private AI Automation Services oferece suporte a dois itens de catálogo no Automation Service Broker que os usuários com as respectivas permissões podem acessar e solicitar.

- Workstation de IA – uma máquina virtual ativada para GPU que pode ser configurada com os softwares vCPU, vGPU, memória e AI/ML desejados do NVIDIA.

- Cluster do Kubernetes de IA: um cluster do Tanzu Kubernetes ativado para GPU que pode ser configurado com um operador de GPU do NVIDIA.

Antes de começar

- Verifique se o Private AI Automation Services está configurado para o seu projeto e se você tem permissões para solicitar itens de catálogo de IA.

Lembre-se de que todos os valores aqui são exemplos de casos de uso. Os valores da sua conta dependem do seu ambiente.

Implantar uma máquina virtual de aprendizagem profunda em um domínio de carga de trabalho VI

Como cientista de dados, você pode implantar um único ambiente de desenvolvimento definido por software de GPU a partir do catálogo do Automation Service Broker de autoatendimento. Você pode personalizar a máquina virtual ativada para GPU com parâmetros de máquina para modelar requisitos de desenvolvimento, especificar as configurações de software de AI/ML para atender aos requisitos de treinamento e inferência e especificar os pacotes de AI/ML do registro do NVIDIA NGC por meio de uma chave de acesso ao portal.

Procedimento

Implantar um cluster do Tanzu Kubernetes ativado para IA

Como engenheiro do DevOps, você pode solicitar um cluster do Tanzu Kubernetes ativado para GPU, no qual os nós de trabalhador podem executar cargas de trabalho de AI/ML.

O cluster do TKG contém um operador de GPU NVIDIA, que é um operador Kubernetes responsável por configurar o driver NVIDIA adequado para o hardware de GPU NVIDIA nos nós do cluster TKG. O cluster implantado está pronto para uso para cargas de trabalho de AI/ML sem precisar de configuração adicional relacionada à GPU.

Procedimento

- Localize o cartão Cluster do Kubernetes de IA e clique em Solicitar.

- Selecione um projeto.

- Digite um nome e uma descrição para a sua implantação.

- Selecione o número de nós do painel de controle.

Configuração Valor de amostra Contagem de nós 1 Classe de VM cpu-only-medium - 8 CPUs e memória de 16 GB A seleção de classe define os recursos disponíveis na máquina virtual.

- Selecione o número de nós de trabalho.

Configuração Descrição Contagem de nós 3 Classe de VM a100-medium - 4 vGPU (64 GB), 16 CPUs e memória de 32 GB - Clique em Enviar.

Resultados

A implantação contém um namespace de supervisor, um cluster TKG com três nós de trabalho, vários recursos dentro do cluster TKG e um aplicativo carvel que implanta o aplicativo operador de GPU.

Monitorar suas implantações de IA privada

Você usa a página Implantações para gerenciar suas implantações e os recursos associados, fazendo alterações nas implantações, solucionando problemas de implantações com falha, fazendo alterações nos recursos e destruindo implantações não utilizadas.

Para gerenciar suas implantações, selecione .

Para obter mais informações, consulte Como gerenciar minhas implantações do Automation Service Broker.