如果云管理员在 VMware Aria Automation 中设置了Private AI Automation Services,则可以使用 Automation Service Broker 目录访问和请求 AI 工作负载。

注: 本文档基于

VMware Aria Automation 8.18。有关

VMware Aria Automation 8.18.1 中

VMware Private AI Foundation 功能的信息,请参见

VMware Private AI Foundation with NVIDIA 文档。

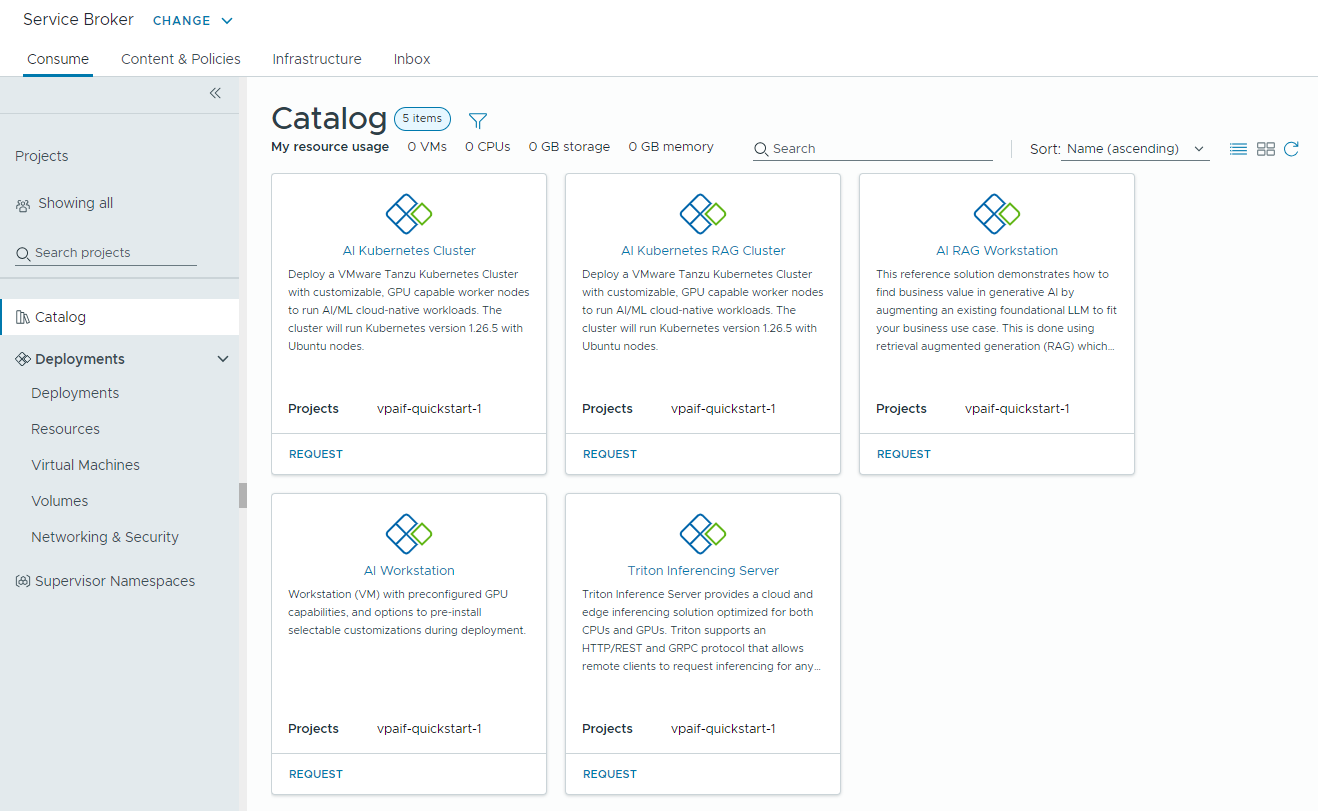

作为数据科学家或 DevOps 工程师,您可以请求以下

Private AI Automation Services 目录项:

- AI Workstation – 启用了 GPU 的虚拟机(可以配置所需的 vCPU、vGPU、内存)以及用于预安装 AI/ML 框架(如 PyTorch、CUDA Samples 和 TensorFlow)的选项。

- AI RAG Workstation – 启用了 GPU 的虚拟机,具有检索增强生成 (RAG) 参考解决方案。

- Triton Inference Server – 启用了 GPU 的虚拟机,具有 NVIDIA Triton Inference Server。

- AI Kubernetes 集群 – VMware Tanzu Kubernetes Grid 集群,具有支持 GPU 的 Worker 节点,可运行 AI/ML 云原生工作负载。

- AI Kubernetes RAG 集群 – VMware Tanzu Kubernetes Grid 集群,具有支持 GPU 的 Worker 节点,可运行参考 RAG 解决方案。

开始之前

- 确认云管理员已为您的项目配置了 Private AI Automation Services。

- 确认您具有请求 AI 目录项的权限。

如何访问Private AI Automation Services目录项

在 Automation Service Broker 中,打开“使用”选项卡,然后单击“目录”。可用的目录项取决于您选择的项目。如果未选择项目,则目录中将显示可供您使用的所有目录项。

请注意,此部分所述过程中显示的所有值均为用例示例。您的帐户值取决于您的环境。

如何监控专用 AI 部署

可以使用 Automation Service Broker 中的“部署”页面管理部署和关联的资源,对部署进行更改,对失败的部署进行故障排除,对资源进行更改以及销毁未使用的部署。

要管理部署,请选择。

有关详细信息,请参见如何管理我的 Automation Service Broker 部署。