将此部分用作参考,帮助您以服务提供商管理员身份使用 VMware Cloud Director Container Service Extension。

可以在 Kubernetes Container Clusters UI 的“集群信息”页面的事件选项卡中查看错误。

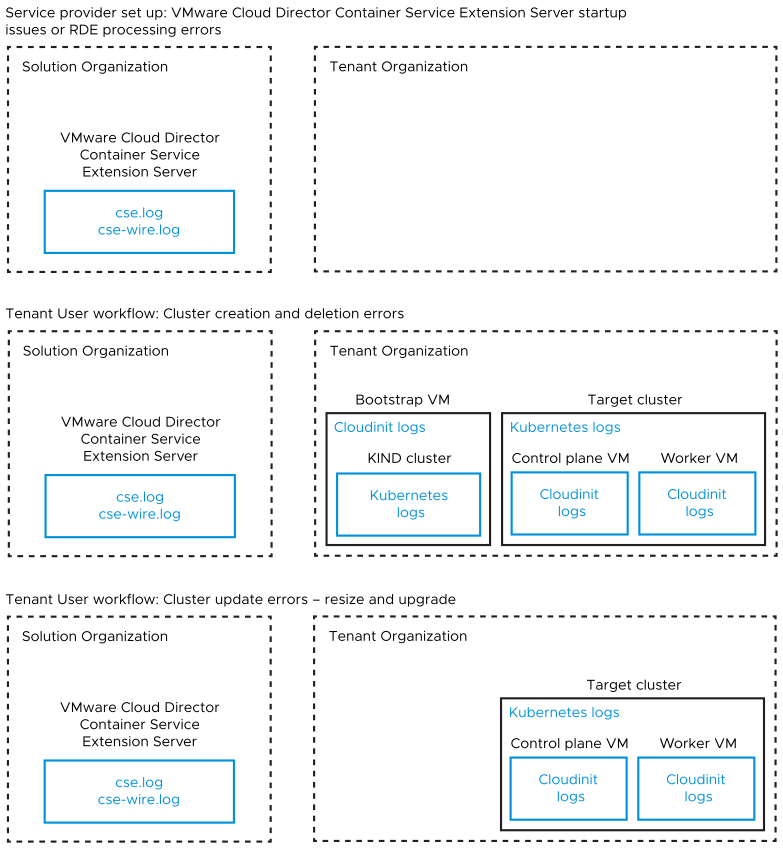

VMware Cloud Director Container Service Extension 4.x 系列涉及多个组件在不同的虚拟机中运行。对于任何错误,有必要从各种源收集和分析日志。下图详细说明了 Tanzu Kubernetes Grid 集群生命周期管理工作流的各种日志源。

- 在上图中,Kubernetes 日志可以包括 CAPI、Kubernetes Cluster API Provider for VMware Cloud Director、Kubernetes Cloud Provider for VMware Cloud Director、Kubernetes Container Storage Interface driver for VMware Cloud Director、RDE Projector 和其他 pod 日志。

- 在上图中,

Cloudinit日志可以包括cloud-final.out、cloud-final.err和cloud-****。

注: 引导 VM 仅与集群创建和删除操作相关。

通过 Kubernetes Container Clusters UI 进行故障排除

可以在 Kubernetes Container Clusters UI 的“集群信息”页面的事件选项卡中查看错误。

从 VMware Cloud Director Container Service Extension 服务器进行日志分析

登录到 VMware Cloud Director Container Service Extension 服务器 VM,然后收集并分析以下日志:

.~/cse.log- 。

~/cse-wire.log(如果存在) .~/cse.sh.log.~/cse-init-per-instance.log.~/config.toml注: 上载日志之前,必须移除 API 令牌。

从引导 VM 进行日志分析

登录到引导 VM -“EPHEMERAL-TEMP-VM”。此 VM 存在于名为

<cluster name> 的 vApp 中。如果该 VM 不存在,请跳过此步骤。

/var/log/cloud-init.out/var/log/cloud-init.err/var/log/cloud-config.out/var/log/cloud-config.err/var/log/cloud-final.out/var/log/cloud-final.err/var/log/script_err.log- 使用以下脚本从引导 VM 上运行的 KIND 集群收集并分析 Kubernetes 日志。有关详细信息,请参见 https://github.com/vmware/cloud-provider-for-cloud-director/tree/main/scripts。

- 使用

kind get kubeconfig检索 kubeconfig >chmod u+x generate-k8s-log-bundle.sh>./generate-k8s-log-bundle.sh <kubeconfig of the KIND cluster>

- 使用

来自目标集群的日志分析

从 Kubernetes Container Clusters UI 下载目标集群的 kubeconfig,然后运行以下脚本,并将 kubeconfig 设置为目标集群。

- 使用以下脚本从控制平面和工作节点 VM 上运行的目标集群收集并分析 Kubernetes 日志。有关详细信息,请参见 https://github.com/vmware/cloud-provider-for-cloud-director/tree/main/scripts。

- 从 Kubernetes Container Clusters UI 下载目标集群的

kubeconfig。 >chmod u+x generate-k8s-log-bundle.sh>./generate-k8s-log-bundle.sh <kubeconfig of the target cluster>

- 从 Kubernetes Container Clusters UI 下载目标集群的

从目标集群的不正常控制平面或工作节点进行日志分析

登录到与 Kubernetes 节点关联的问题 VM,然后收集并分析以下事件:

/var/log/capvcd/customization/error.log/var/log/capvcd/customization/status.log/var/log/cloud-init-output.log/root/kubeadm.err

分析关联的服务器配置和集群信息实体

VCDKEConfigRDE 实例:VMware Cloud Director Container Service Extension 服务器的配置详细信息。- 获取 https://{{vcd}}/cloudapi/1.0.0/entities/types/vmware/VCDKEConfig/1.1.0 的结果。

- 在上载或共享此实体之前,请先移除 Github 个人令牌。

- 与集群关联的

capvcdClusterRDE 实例。这表示集群的当前状态。- 从 Kubernetes Container Clusters UI 的 集群信息页面中检索 RDE ID。

- 获取 https://{{vcd}}/cloudapi/1.0.0/entities/{{cluster-id}} 的结果

- 上载或共享实体之前移除 API 令牌和

kubeconfig(如果 RDE 的版本低于 1.2)。注: 对于版本 >= 1.2 的 RDE,API 令牌和kubeconfig详细信息已隐藏并加密。无需执行任何操作。