Das Design des physischen Datencenter-Netzwerks umfasst die Definition der Netzwerktopologie für die Verbindung physischer Switches und ESXi-Hosts, die Ermittlung der Switch Port-Einstellungen für VLANs und Link-Aggregation und den Routing-Entwurf.

Ein softwaredefiniertes Netzwerk (SDN) wird mit Komponenten des physischen Datencenters vernetzt und verwendet diese. Ein SDN wird mit Ihrem physischen Netzwerk vernetzt, um den Ost-West-Transit im Datencenter und den Nord-Süd-Transit zu und von den SDDC-Netzwerken zu unterstützen.

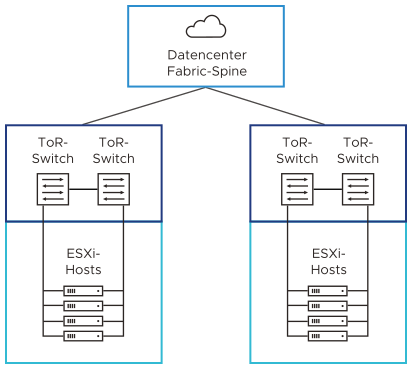

Es gibt mehrere typische Bereitstellungstopologien für Datencenter-Netzwerke:

Core-Aggregation-Zugriff

Leaf-Spine

Hardware-SDN

Leaf-Spine ist die standardmäßige Bereitstellungstopologie für Datencenter-Netzwerke für VMware Cloud Foundation

VLANs und Subnetze für VMware Cloud Foundation

Konfigurieren Sie Ihre VLANs und Subnetze gemäß den Richtlinien und Anforderungen für VMware Cloud Foundation.

Beachten Sie beim Entwerfen der VLAN- und Subnetzkonfiguration für Ihre VMware Cloud Foundation-Bereitstellung die folgenden Richtlinien:

Alle Bereitstellungstopologien |

Mehrere Verfügbarkeitszonen |

NSX-Verbund zwischen mehreren VMware Cloud Foundation-Instanzen |

|---|---|---|

|

|

|

Wenn VLANs und Subnetze für VMware Cloud Foundation bereitgestellt werden, müssen sie die folgenden Anforderungen gemäß der VMware Cloud Foundation-Topologie erfüllen:

Funktion |

VMware Cloud Foundation-Instanzen mit einer einzelnen Verfügbarkeitszone |

VMware Cloud Foundation-Instanzen mit mehreren Verfügbarkeitszonen |

|---|---|---|

Verwaltung – erste Verfügbarkeitszone |

|

|

vSphere vMotion – erste Verfügbarkeitszone |

|

|

vSAN – erste Verfügbarkeitszone |

|

|

Host-Overlay – erste Verfügbarkeitszone |

|

|

Uplink01 |

|

|

Uplink02 |

|

|

Edge-Overlay |

|

|

Verwaltung – zweite Verfügbarkeitszone |

|

|

vSphere vMotion – zweite Verfügbarkeitszone |

|

|

vSAN – zweite Verfügbarkeitszone |

|

|

Host-Overlay – zweite Verfügbarkeitszone |

|

|

Edge-RTEP |

|

|

Management und Zeuge – Zeugen-Appliance an einem dritten Standort |

|

|

Anforderungen und Empfehlungen für das Design für physische Leaf-Spine-Netzwerke für VMware Cloud Foundation

Bei Leaf-Spine handelt es sich um die standardmäßige Netzwerkbereitstellungstopologie des Datencenters für VMware Cloud Foundation. Berücksichtigen Sie die Netzwerkbandbreite, die Konfiguration des Zugriffsports, Jumbo-Frames, Routing-Konfiguration und DHCP-Verfügbarkeit für NSX in einer Bereitstellung mit einer einzelnen oder mehreren VMware Cloud Foundation-Instanzen.

Logisches Design des physischen Leaf-Spine-Netzwerks

Anforderungen und Empfehlungen für physische Leaf-Spine-Netzwerke

Die Anforderungen und Empfehlungen für die Leaf-Spine-Netzwerkkonfiguration bestimmen das physische Layout und die Verwendung von VLANs. Sie enthalten auch Anforderungen und Empfehlungen für Jumbo-Frames sowie zu netzwerkbezogenen Anforderungen wie DNS und NTP.

Anforderungs-ID |

Designanforderung |

Begründung |

Auswirkung |

|---|---|---|---|

VCF-NET-REQD-CFG-001 |

Verwenden Sie keine EtherChannel-Konfiguration (LAG, LACP oder vPC) für ESXi Host-Uplinks. |

|

Keine. |

VCF-NET-REQD-CFG-002 |

Verwenden Sie VLANs, um physische Netzwerkfunktionen zu trennen. |

|

Erfordert eine einheitliche Konfiguration und Präsentation auf allen Trunks, die den ESXi-Hosts zur Verfügung gestellt werden. |

VCF-NET-REQD-CFG-003 |

Konfigurieren Sie die VLANs als Mitglieder eines 802.1Q-Trunks. |

Alle VLANs werden auf denselben physischen Netzwerkadaptern auf den ESXi Hosts verfügbar. |

Optional kann das Verwaltungs-VLAN als natives VLAN fungieren. |

VCF-NET-REQD-CFG-004 |

Legen Sie die MTU-Größe auf mindestens 1.700 Byte (empfohlen 9.000 Byte für Jumbo-Frames) auf den physischen Switch-Ports, vSphere Distributed Switches, vSphere Distributed Switch Portgruppen und N-VDS Switches fest, die die folgenden Datenverkehrstypen unterstützen:

|

|

Beim Anpassen der MTU-Paketgröße müssen Sie auch den gesamten Netzwerkpfad (VMkernel-Netzwerkadapter, virtuelle Switches, physische Switches und Router) so konfigurieren, dass er dieselbe MTU-Paketgröße unterstützt. In einer Umgebung mit mehreren Verfügbarkeitsbereichen muss die MTU auf dem gesamten Netzwerkpfad zwischen den Zonen konfiguriert werden. |

Anforderungs-ID |

Designanforderung |

Begründung |

Auswirkung |

|---|---|---|---|

VCF-NET-REQD-CFG-005 |

Legen Sie die MTU-Größe auf den Komponenten des physischen Netzwerks zwischen den VMware Cloud Foundation-Instanzen für die folgenden Datenverkehrstypen auf mindestens 1.500 Byte fest (1.700 Byte bevorzugt, 9.000 Byte empfohlen für Jumbo-Frames).

|

|

Beim Anpassen der MTU-Paketgröße müssen Sie auch den gesamten Netzwerkpfad konfigurieren, also virtuelle Schnittstellen, virtuelle Switches, physische Switches und Router, um dieselbe MTU-Paketgröße zu unterstützen. |

VCF-NET-REQD-CFG-006 |

Stellen Sie sicher, dass die Latenz zwischen VMware Cloud Foundation-Instanzen, die in einem NSX-Verbund verbunden sind, weniger als 150 ms beträgt. |

Für die folgenden Funktionen ist eine Latenz von weniger als 150 ms erforderlich:

|

Keine. |

VCF-NET-REQD-CFG-007 |

Stellen Sie eine geroutete Verbindung zwischen den NSX Manager-Clustern in VMware Cloud Foundation-Instanzen bereit, die in einem NSX-Verbund verbunden sind. |

Das Konfigurieren des NSX Verbunds erfordert Konnektivität zwischen den NSX Global Manager-Instanzen, NSX lokalen Manager-Instanzen und NSX Edge-Clustern. |

Sie müssen jeder Fehlerdomäne eindeutige routingfähige IP-Adressen zuweisen. |

Empfehlungs-ID |

Designempfehlung |

Begründung |

Auswirkung |

|---|---|---|---|

VCF-NET-RCMD-CFG-001 |

Verwenden Sie zwei ToR-Switches für jedes Rack. |

Unterstützt die Verwendung von zwei 10-GbE-Links (25 GbE oder höher empfohlen) zu jedem Server, bietet Redundanz und reduziert die allgemeine Designkomplexität. |

Erfordert zwei ToR-Switches pro Rack, was die Kosten erhöhen kann. |

VCF-NET-RCMD-CFG-002 |

Implementieren Sie die folgende physische Netzwerkarchitektur:

|

|

|

VCF-NET-RCMD-CFG-003 |

Verwenden Sie ein physisches Netzwerk, das für die BGP-Routing-Nachbarschaft konfiguriert ist. |

|

Erfordert eine BGP-Konfiguration im physischen Netzwerk. |

VCF-NET-RCMD-CFG-004 |

Weisen Sie dauerhafte IP-Konfigurationen für NSX-Tunnel-Endpoints (TEPs) zu, die eine dynamische IP-Zuweisung anstelle einer statischen IP-Pool-Adressierung nutzen. |

|

Ein DHCP-Server muss im TEP-VLAN verfügbar sein. |

VCF-NET-RCMD-CFG-005 |

Legen Sie die Lease-Dauer für den DHCP-Bereich für das Host-Overlay-Netzwerk auf mindestens 7 Tage fest. |

Die IP-Adressen der Host-Overlay-VMkernel-Ports werden mithilfe eines DHCP-Servers zugewiesen.

|

Erfordert die Konfiguration und Verwaltung eines DHCP-Servers. |

VCF-NET-RCMD-CFG-006 |

Legen Sie die mit ESXi-Netzwerkkarten verbundenen Trunk-Ports als Trunk-PortFast fest. |

Reduziert die Zeit für den Übergang der Ports in den Weiterleitungszustand. |

Bei diesem Design wird zwar kein STP verwendet.Bei Switches ist STP jedoch in der Regel standardmäßig konfiguriert. |

VCF-NET-RCMD-CFG-007 |

Konfigurieren Sie VRRP, HSRP- oder eine andere Layer-3-Gateway-Verfügbarkeitsmethode für diese Netzwerke.

|

Stellen Sie sicher, dass die VLANs, die zwischen Verfügbarkeitszonen ausgeweitet werden, mit einem hochverfügbaren Gateway verbunden sind. Andernfalls führt ein Ausfall im Layer-3-Gateway zu einer Unterbrechung des Datenverkehrs im SDN-Setup. |

Erfordert die Konfiguration einer Hochverfügbarkeitstechnologie für die Schicht-3-Gateways im Datencenter. |

Empfehlungs-ID |

Designempfehlung |

Begründung |

Auswirkung |

|---|---|---|---|

VCF-NET-RCMD-CFG-008 |

Stellen Sie Hochverfügbarkeit für den DHCP-Server oder DHCP-Hilfsdienst bereit, der für VLANs verwendet wird, die DHCP-Dienste benötigen, die zwischen Verfügbarkeitszonen ausgedehnt sind. |

Stellen Sie sicher, dass ein Failover-Vorgang einer einzelnen Verfügbarkeitszone keine Auswirkungen auf die DHCP-Verfügbarkeit hat. |

Erfordert die Konfiguration eines hochverfügbaren DHCP-Servers. |

Empfehlungs-ID |

Designempfehlung |

Begründung |

Auswirkung |

|---|---|---|---|

VCF-NET-RCMD-CFG-009 |

Stellen Sie BGP-Routing zwischen allen VMware Cloud Foundation-Instanzen bereit, die in einer NSX Federation-Einrichtung verbunden sind. |

BGP ist das unterstützte Routing-Protokoll für NSX Federation. |

Keine. |