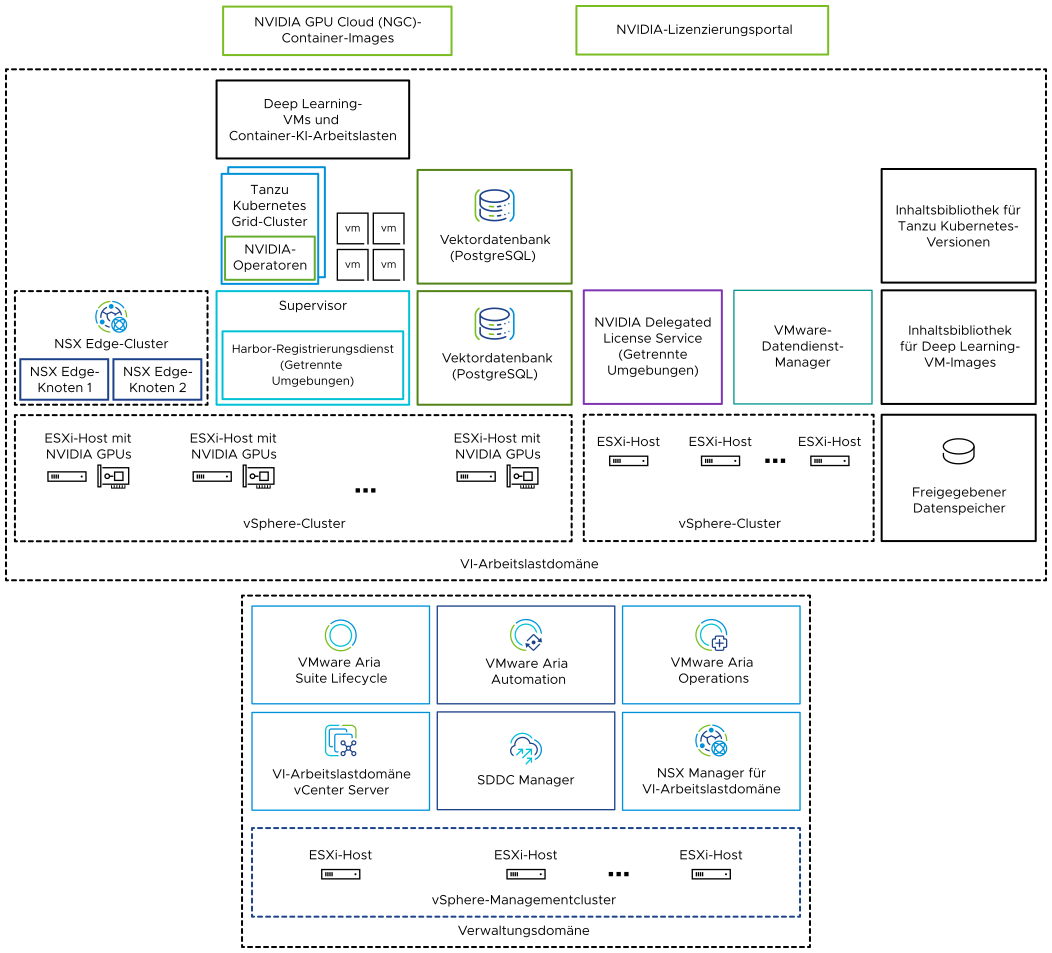

Als Lösung mit mehreren Komponenten können Sie VMware Private AI Foundation with NVIDIA verwenden, um generative KI-Arbeitslasten auszuführen, indem Sie beschleunigtes Computing von NVIDIA sowie die Verwaltung der virtuellen Infrastruktur und Cloud-Verwaltung von VMware Cloud Foundation verwenden.

VMware Private AI Foundation with NVIDIA bietet eine Plattform für die Bereitstellung von KI-Arbeitslasten auf ESXi-Hosts mit NVIDIA GPUs. Darüber hinaus wird die Ausführung von KI-Arbeitslasten basierend auf NVIDIA GPU Cloud (NGC)-Containern speziell durch VMware validiert.

VMware Private AI Foundation with NVIDIA unterstützt zwei Anwendungsfälle:

- Anwendungsfall Entwicklung

- Cloud-Administratoren und DevOps-Ingenieure können KI-Arbeitslasten, einschließlich Retrieval-Augmented Generation (RAG), in Form von Deep Learning-VMs bereitstellen. Datenwissenschaftler können diese Deep Learning-VMs für die KI-Entwicklung verwenden.

- Anwendungsfall Produktion

- Cloud-Administratoren können DevOps-Ingenieuren eine VMware Private AI Foundation with NVIDIA-Umgebung für die Bereitstellung produktionsbereiter KI-Arbeitslasten auf Tanzu Kubernetes Grid (TKG)-Clustern auf vSphere with Tanzu bereitstellen.

Lizenzierung

Sie benötigen die VMware Private AI Foundation with NVIDIA-Add-On-Lizenz, um auf die folgenden Funktionen zuzugreifen:

- Private AI-Einrichtung in VMware Aria Automation für Katalogelemente zwecks einfacher Bereitstellung von GPU-beschleunigten Deep Learning-VMs und TKG-Clustern.

- Bereitstellung von PostgreSQL-Datenbanken mit der pgvector-Erweiterung mit Enterprise-Unterstützung.

- Bereitstellen und Verwenden des Deep Learning-VM-Images, das von VMware von Broadcom bereitgestellt wird.

Sie können KI-Arbeitslasten mit und ohne aktivierten Supervisor bereitstellen und die GPU-Metriken in vCenter Server und VMware Aria Operations unter der VMware Cloud Foundation-Lizenz verwenden.

Die NVIDIA-Softwarekomponenten stehen unter einer NVIDIA AI Enterprise-Lizenz zur Verfügung.

Informationen zu den VMware Private AI Foundation with NVIDIA-Komponenten

| Komponente | Beschreibung |

|---|---|

| GPU-aktivierte ESXi-Hosts | ESXi Hosts, die wie folgt konfiguriert wurden:

|

| Supervisor | Mindestens ein vSphere-Cluster, der für vSphere with Tanzu aktiviert ist, sodass Sie virtuelle Maschinen und Container auf vSphere mithilfe der Kubernetes-API ausführen können. Ein Supervisor ist selbst ein Kubernetes-Cluster, der als Steuerungsebene zum Verwalten von Arbeitslastclustern und virtuellen Maschinen dient. |

| Harbor-Registrierung | Eine lokale Image-Registrierung in einer getrennten Umgebung, in der Sie die aus dem NVIDIA NGC-Katalog heruntergeladenen Container-Images hosten. |

| NSX Edge-Cluster | Ein Cluster aus NSX Edge-Knoten, der zweistufiges Nord-Süd-Routing für den Supervisor und die ausgeführten Arbeitslasten bereitstellt. Das Tier-0-Gateway auf dem NSX Edge-Cluster befindet sich im Aktiv/Aktiv-Modus. |

| NVIDIA-Operatoren |

|

| Vektordatenbank | Eine PostgreSQL-Datenbank, bei der die pgvector-Erweiterung aktiviert ist, sodass Sie sie in RAG-KI-Arbeitslasten (Retrieval Augmented Generation) verwenden können. |

|

Sie verwenden das NVIDIA-Lizenzierungsportal, um ein Clientkonfigurationstoken zu generieren, mit dem Sie dem vGPU-Gasttreiber in der Deep Learning-VM und den GPU-Operatoren auf TKG-Clustern eine Lizenz zuweisen. In einer getrennten Umgebung oder damit Ihre Arbeitslasten Lizenzinformationen erhalten, ohne eine Internetverbindung zu verwenden, hosten Sie die NVIDIA-Lizenzen lokal auf einer DLS-Appliance (Delegated License Service). |

| Inhaltsbibliothek | Inhaltsbibliotheken speichern die Images für die Deep Learning-VMs und für die Tanzu Kubernetes-Versionen. Sie verwenden diese Images für die Bereitstellung von KI-Arbeitslasten innerhalb der VMware Private AI Foundation with NVIDIA-Umgebung. In einer verbundenen Umgebung beziehen die Inhaltsbibliotheken ihre Inhalte aus den von VMware verwalteten öffentlichen Inhaltsbibliotheken. In einer nicht verbundenen Umgebung müssen Sie die erforderlichen Images manuell hochladen oder von einem internen Spiegelserver der Inhaltsbibliothek abrufen. |

| NVIDIA GPU Cloud (NGC)-Katalog | Ein Portal für GPU-optimierte Container für KI und maschinelles Lernen, die getestet wurden und für die lokale Ausführung auf unterstützten NVIDIA-GPUs zusätzlich zu VMware Private AI Foundation with NVIDIA bereit sind. |

Als Cloud-Administrator verwenden Sie die Verwaltungskomponenten in VMware Cloud Foundation

| Verwaltungskomponente | Beschreibung |

|---|---|

| SDDC Manager | Sie verwenden SDDC Manager für die folgenden Aufgaben:

|

| VI-Arbeitslastdomäne-vCenter Server | Sie verwenden diese vCenter Server-Instanz, um einen Supervisor zu aktivieren und zu konfigurieren. |

| NSX Manager für VI-Arbeitslastdomäne | SDDC Manager verwendet diese NSX Manager-Instanz, um NSX Edge-Cluster bereitzustellen und zu aktualisieren. |

| VMware Aria Suite Lifecycle | Sie verwenden VMware Aria Suite Lifecycle, um VMware Aria Automation und VMware Aria Operations bereitzustellen und zu aktualisieren. |

| VMware Aria Automation | Sie verwenden VMware Aria Automation, um Self-Service-Katalogelemente für die Bereitstellung von KI-Arbeitslasten für DevOps-Ingenieure und Datenwissenschaftler hinzuzufügen. |

| VMware Aria Operations | Sie verwenden VMware Aria Operations für die Überwachung der GPU-Auslastung in den GPU-fähigen Arbeitslastdomänen. |

| VMware Data Services Manager | Sie verwenden VMware Data Services Manager, um Vektordatenbanken zu erstellen, z. B. eine PostgreSQL-Datenbank mit der pgvector-Erweiterung. |