Im Rahmen des Overlay-Designs legen Sie die NSX-Konfiguration für die Verarbeitung des Datenverkehrs zwischen Verwaltungs- oder Kundenarbeitslasten in VMware Cloud Foundation fest. Sie bestimmen die NSX-Segmente und die Transportzonen.

Logisches Overlay-Design für VMware Cloud Foundation

Das logische Design umfasst das Netzwerkvirtualisierungsdesign der logischen Komponenten, die die Daten zu und von den Arbeitslasten in der Umgebung verarbeiten. Für eine Umgebung mit mehreren VMware Cloud Foundation-Instanzen replizieren Sie das Design der ersten VMware Cloud Foundation-Instanz auf die weiteren VMware Cloud Foundation-Instanzen.

ESXi-Host-Transportknoten

Ein Transportknoten in NSX ist ein Knoten, der an einer NSX-Datenebene teilnehmen kann. Die Arbeitslastdomänen enthalten mehrere ESXi-Hosts in einem vSphere-Cluster zur Unterstützung von Verwaltungs- oder Kundenarbeitslasten. Sie registrieren diese ESXi-Hosts als Transportknoten, damit Netzwerke und Arbeitslasten auf diesem Host die Funktionen von NSX nutzen können. Während des Vorbereitungsvorgangs wird der native vSphere Distributed Switch für die Arbeitslastdomäne um NSX-Funktionen erweitert.

Virtuelle Segmente

Geneve bietet die Overlay-Funktion zum Erstellen isolierter Broadcast-Domänen mit mehreren Mandanten in NSX über Datencenter-Fabrics hinweg und ermöglicht es Kunden, elastische, logische Netzwerke zu erstellen, die sich über physische Netzwerkgrenzen und physische Standorte erstrecken.

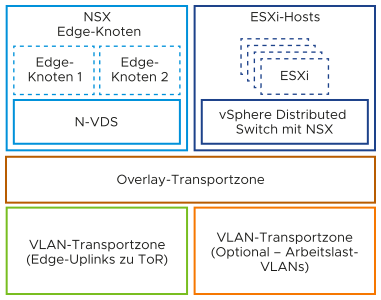

Transportzonen

Eine Transportzone gibt den Datenverkehrstyp, das VLAN oder das Overlay und den Namen des vSphere Distributed Switch an. Sie können eine oder mehrere VLAN-Transportzonen und eine einzelne Overlay-Transportzone pro virtuellem Switch konfigurieren. Eine Transportzone stellt keine Sicherheitsgrenze dar. VMware Cloud Foundation unterstützt eine einzelne Overlay-Transportzone pro NSX-Instanz. Die vSphere-Cluster innerhalb und über Arbeitslastdomänen hinweg, die dieselbe NSX-Instanz nutzen, teilen anschließend dieselbe Overlay-Transportzone.

Transportknotenprofile des Hosts

Bei einem Transportknotenprofil (TNP) handelt es sich um eine Vorlage zum Definieren der Netzwerkkonfiguration, die auf einen Hostcluster angewendet wird. Es enthält ein Uplink-Profil, Transportzonen und eine IP-Zuweisungsmethode sowie vSphere Distributed Switch-zu-NSX-Uplink-Zuordnungen. Nach dem Erstellen eines Transportknotenprofils hängen Sie es an einen Cluster an. Folglich werden die im Profil definierten NSX-Konfigurationen auf die Knoten im Cluster angewendet.

Uplink-Richtlinie für ESXi-Host-Transportknoten

Uplink-Profile definieren Richtlinien für die Links von ESXi-Hosts zu NSX-Segmenten oder von NSX Edge-Appliances zu Top-of-Rack-Switches. Mithilfe von Uplink-Profilen können Sie eine konsistente Konfiguration der Funktionen für Netzwerkadapter über mehrere ESXi-Hosts oder NSX Edge-Knoten hinweg anwenden.

Uplink-Profile können entweder Teaming der Lastausgleichsquellen oder der Failover-Reihenfolge verwenden. Bei Verwendung der Lastausgleichsquelle können mehrere Uplinks aktiv sein. Bei Verwendung der Failover-Reihenfolge kann nur ein einziger Uplink aktiv sein.

Sub-Transportknotenprofile

Bei einem Ein Sub-Transportknotenprofil (STNP) handelt es sich um eine Vorlage zum Definieren eines Netzwerks für eine Teilmenge von Hosts in einem Cluster (wird auch als Untercluster bezeichnet). Dieses Konstrukt eignet sich für Stretched Cluster oder Multi-Rack-Cluster mit Layer-3-Netzwerken, sodass die Knoten in jeder Verfügbarkeitszone oder jedem Rack in einer Multi-Rack-Konfiguration unterschiedliche Netzwerkkonfigurationen für Host-TEP-VLANs und Subnetze aufweisen können.

Replizierungsmodus von Segmenten

Die Steuerungsebene entkoppelt NSX vom physischen Netzwerk. Die Steuerungsebene verarbeitet den Broadcast-, unbekannten Unicast- und Multicast-Datenverkehr (BUM) in den virtuellen Segmenten.

Die folgenden Optionen sind für die BUM-Replizierung auf -Segmenten verfügbar.

BUM-Replizierungsmodus |

Beschreibung |

|---|---|

Hierarchischer Zwei-Ebenen-Modus |

Die ESXi-Host-Transportknoten werden nach ihrem TEP-IP-Subnetz gruppiert. Ein ESXi-Host in jedem Subnetz ist für die Replizierung auf einen ESXi-Host in einem anderen Subnetz verantwortlich. Der empfangende ESXi-Host repliziert den Datenverkehr auf die ESXi-Hosts in seinem lokalen Subnetz. Der quellseitige ESXi-Host-Transportknoten „kennt“ die Gruppen anhand der Informationen, die er von der Steuerungsebene erhalten hat. Das System kann einen beliebigen ESXi-Host-Transportknoten als Mediator für das Quellsubnetz auswählen, wenn der Remote-Mediator-ESXi-Hostknoten verfügbar ist. |

Head-End |

Der ESXi-Host-Transportknoten um Ursprung des Frames, der in einem Segment überflutet werden soll, sendet eine Kopie an jeden anderen ESXi-Host-Transportknoten, der mit diesem Segment verbunden ist. |

Anforderungen und Empfehlungen für das Overlay-Design für VMware Cloud Foundation

Berücksichtigen Sie als Anforderungen für die Konfiguration der ESXi-Hosts in einer Arbeitslastdomäne NSX Transportknoten, das Layout der Transportzone, Uplink-Teaming-Richtlinien und die Best Practices für die IP-Zuteilung und den BUM-Replizierungsmodus in einer VMware Cloud Foundation Bereitstellung.

Anforderungen an das Overlay-Design

Die folgenden Designanforderungen müssen in Ihrem Overlay-Design erfüllt werden.

Anforderungs-ID |

Designanforderung |

Begründung |

Auswirkung |

|---|---|---|---|

VCF-NSX-OVERLAY-REQD-CFG-001 |

Konfigurieren Sie alle ESXi-Hosts in der Arbeitslastdomäne als Transportknoten in NSX. |

Ermöglicht verteiltes Routing, logische Segmente und eine verteilte Firewall. |

Keine. |

VCF-NSX-OVERLAY-REQD-CFG-002 |

Konfigurieren Sie jeden ESXi-Host mithilfe von Transportknotenprofilen als Transportknoten. |

|

Keine. |

VCF-NSX-OVERLAY-REQD-CFG-003 |

Um virtualisierte Netzwerkfunktionen für Arbeitslasten bereitzustellen, verwenden Sie Overlay-Netzwerke mit NSX Edge-Knoten und verteiltem Routing. |

|

Erfordert die Konfiguration von Transportnetzwerken mit einer MTU-Größe von mindestens 1.600 Byte. |

VCF-NSX-OVERLAY-REQD-CFG-004 |

Erstellen Sie eine einzelne Overlay-Transportzone in der NSX-Instanz für den gesamten Overlay-Datenverkehr, der über den Host und die NSX Edge-Transportknoten der Arbeitslastdomäne oder mehrerer Arbeitslastdomänen mithilfe einer gemeinsam genutzten NSX-Instanz geleitet wird. |

|

Sämtliche Cluster in allen Arbeitslastdomänen, die denselben NSX Manager nutzen, verwenden auch dieselbe Overlay-Transportzone. |

VCF-NSX-OVERLAY-REQD-CFG-005 |

Erstellen Sie ein Uplink-Profil mit einer Teaming-Richtlinie für die Lastausgleichsquelle mit zwei aktiven Uplinks für ESXi-Hosts. |

Zur Verbesserung der Ausfallsicherheit und der Leistung wird die gleichzeitige Nutzung der beiden physischen Netzwerkkarten auf den ESXi-Hosts, die als Transportknoten konfiguriert sind, unterstützt. |

Keine. |

Anforderungs-ID |

Designanforderung |

Begründung |

Auswirkung |

|---|---|---|---|

VCF-NSX-L3MR-OVERLAY-REQD-CFG-001 |

Erstellen Sie ein Uplink-Profil für jedes Rack mit einer separaten Host-TEP-Transport-VLAN-ID pro Rack. |

Aktiviert eine Layer-3-Begrenzung bei den Top-of-Rack-Switches für den Host-TEP-Datenverkehr. |

Erfordert eine zusätzliche Host-TEP-VLAN-ID pro Rack. |

VCF-NSX-L3MR-OVERLAY-REQD-CFG-002 |

Erstellen Sie einen Host-TEP-IP-Pool für jedes Rack mit einem pro Rack zugeteilten Subnetz und einem Gateway für das Subnetz. |

|

Erfordert ein zusätzliches Subnetz pro Rack. |

VCF-NSX-L3MR-OVERLAY-REQD-CFG-003 |

Erstellen Sie Sub-Transportknotenprofile des NSX-Hosts für zusätzliche Racks. |

|

Keine |

Empfehlungen für das Overlay-Design

In Ihrem Overlay-Design für VMware Cloud Foundation können Sie bestimmte Best Practices anwenden.

Empfehlungs-ID |

Designempfehlung |

Begründung |

Auswirkung |

|---|---|---|---|

VCF-NSX-OVERLAY-RCMD-CFG-001 |

Verwenden Sie statische IP-Pools, um den TEP-Schnittstellen des Hosts IP-Adressen zuzuweisen. |

|

Keine. |

VCF-NSX-OVERLAY-RCMD-CFG-002 |

Verwenden Sie die hierarchische Zwei-Ebenen-Replizierung auf allen Overlay-Segmenten. |

Die hierarchische Zwei-Ebenen-Replizierung ist effizienter, da die Anzahl der ESXi-Hosts verringert wurde, auf die der quellseitige ESXi-Host den Datenverkehr replizieren muss, wenn Hosts verschiedene TEP-Subnetze haben. Dies ist in der Regel bei mehr als einem Cluster der Fall und verbessert die Leistung in diesem Szenario. |

Keine. |

Empfehlungs-ID |

Designempfehlung |

Begründung |

Auswirkung |

|---|---|---|---|

VCF-NSX-OVERLAY-RCMD-CFG-003 |

Konfigurieren Sie ein NSX-Sub-Transportknotenprofil. |

|

Änderungen an der Konfiguration des Host-Transportknotens erfolgen auf der Ebene des vSphere-Clusters. |