Der NSX Edge-Load Balancer ermöglicht einen High-Availability-Dienst und verteilt die Arbeitslast des Netzwerkdatenverkehrs auf mehrere Server. Er verteilt eingehende Dienstanforderungen über mehrere Server gleichmäßig auf eine Weise, dass die Lastverteilung für die Benutzer transparent ist. Das Load Balancing hilft deshalb dabei, optimale Ressourcennutzung, maximalen Durchsatz und minimale Reaktionszeit zu erreichen sowie Überlastung zu vermeiden. NSX Edge bietet ein Load Balancing bis Schicht 7.

Für den Load Balancer ordnen Sie eine externe oder öffentliche IP-Adresse einer Gruppe interner Server zu. Der Load Balancer akzeptiert TCP-, UDP-, HTTP- oder HTTPS-Anforderungen über die externe IP-Adresse und entscheidet, welcher interne Server verwendet werden soll. Port 80 ist der Standardport für HTTP und Port 443 der Standardport für HTTPS.

Sie müssen über eine gültige NSX Edge-Instanz verfügen, bevor Sie das Load Balancing konfigurieren können. Weitere Informationen zur Einrichtung von NSX Edge finden Sie unter Konfiguration von NSX Edge.

Weitere Informationen zur Konfiguration eines NSX Edge-Zertifikats finden Sie unter Arbeiten mit Zertifikaten.

- Protokolle: TCP, UDP, HTTP, HTTPS

- Algorithmen: Weighted Round Robin (WRR), IP Hash, URI, Letzte Verbindung

- SSL-Beendigung mit AES-NI-Beschleunigung

- SSL-Bridging (Client-seitiges SSL + Server-seitiges SSL)

- Verwaltung von SSL-Zertifikaten

- X-Header-Weiterleitung zur Client-Identifizierung

- Transparenter L4/L7-Modus

- Verbindungsdrosselung

- Aktivieren/deaktivieren einzelner Server (Poolmitglieder) für die Wartung

- Methoden zur Systemstatusprüfung (TCP, UDP, HTTP, HTTPS)

- Erweiterte Überwachung des Systemstatus

- Persistenz-/Stickiness-Methoden: SourceIP, MSRDP, COOKIE, SSLSESSIONID

- „One-Arm“-Modus (einarmiger Modus)

- Inline-Modus

- Erneutes Schreiben und umleiten der URL

- Anwendungsregeln für die erweiterte Datenverkehrsverwaltung

- Stickiness-Unterstützung für HA-Sitzungen für ein L7-Proxy-Load-Balancing

- IPv6-Unterstützung

- Erweiterte Load-Balancer-Befehlszeilenschnittstelle (CLI) zur Fehlerbehebung

- Verfügbar für alle Varianten eines NSX Edge-Dienstgateways, wobei für den Datenverkehr bei der Produktion die Option „X-Large“ oder „Quad Large“ empfohlen wird

Topologien

Es stehen zwei Typen von Load-Balancing-Diensten zur Konfiguration in NSX zur Verfügung: ein „Einarmiger“-Modus, auch „Proxy-Modus“ genannt, und der Inline-Modus, auch als „Transparenter Modus“ bezeichnet.

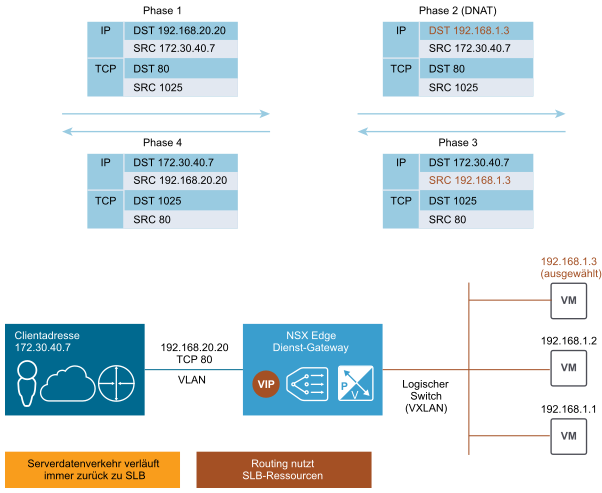

Logisches NSX Load Balancing: Inline-Topologie

Im Inline-Modus oder transparenten Modus wird das NSX Edge inline für den Datenverkehr bereitgestellt, der für die Serverfarm bestimmt ist. Der Datenverkehrsfluss im transparenten Modus wird wie folgt verarbeitet:

- Der externe Client sendet den Datenverkehr an die virtuelle IP-Adresse (VIP), die vom Load Balancer angegeben wurde.

- Der Load Balancer – ein zentralisiertes NSX Edge – führt nur einen Ziel-NAT-Vorgang (DNAT) durch, um die VIP durch die IP-Adresse eines der in der Serverfarm bereitgestellten Servers zu ersetzen.

- Der Server in der Serverfarm antwortet auf die ursprüngliche Client-IP-Adresse. Der Datenverkehr wird wieder vom Load Balancer empfangen, der er inline bereitgestellt wurde. Dies erfolgt normalerweise in Form des Standard-Gateways für die Serverfarm.

- Der Load Balancer führt einen Quell-NAT-Vorgang aus, um den Datenverkehr an den externen Client zu senden. Dabei nutzt er seine VIP als IP-Quelladresse.

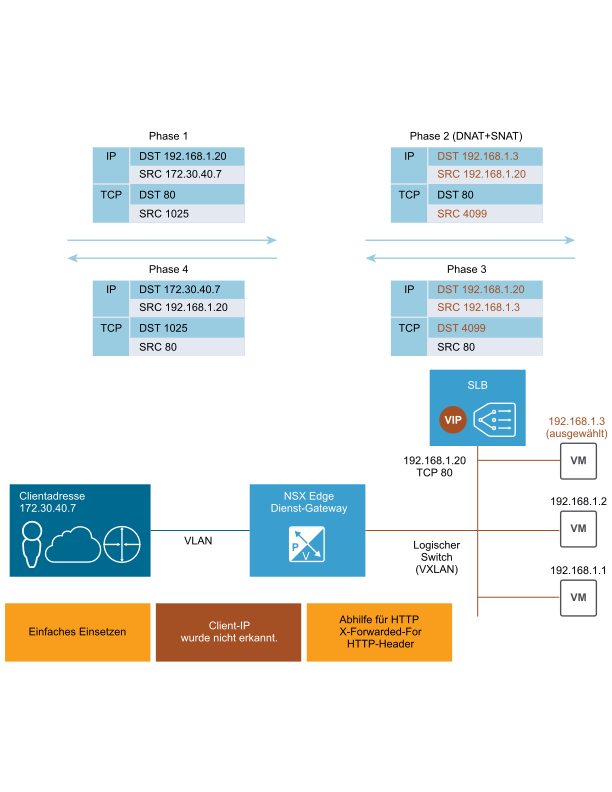

Logisches NSX Load Balancing: Einarmige Topologie

- Der externe Client sendet den Datenverkehr an die virtuelle IP-Adresse (VIP), die vom Load Balancer angegeben wurde.

- Der Load Balancer führt zwei Adressübersetzungen für die vom Client empfangenen Originalpakete durch: Ziel-NAT (DNAT) zum Ersetzen der VIP durch die IP-Adresse eines Servers, der in der Serverfarm bereitgestellt wurde und Quell-NAT (SNAT) zum Ersetzen der Client-IP-Adresse durch die IP-Adresse, anhand derer der Load Balancer selbst identifiziert wird. SNAT ist erforderlich, um den rückwärtigen Datenverkehr von der Serverfarm an den Client zwangsweise durch den Load Balancer zu leiten.

- Der Server in der Serverfarm antwortet, indem er den Datenverkehr per SNAT-Funktionalität an den Load Balancer sendet.

- Der Load Balancer führt wiederum einen Quell- und Ziel-NAT-Dienst aus, um den Datenverkehr an den externen Client zu senden. Dabei nutzt er seine VIP als IP-Quelladresse.