Anwendungsprofile sind mit virtuellen Servern verknüpft, um das Load Balancing im Netzwerkverkehr zu verbessern und Aufgaben zur Verwaltung des Datenverkehrs zu vereinfachen.

Mit Anwendungsprofilen definieren Sie das Verhalten eines bestimmten Netzwerkverkehrstyps. Der verknüpfte virtuelle Server verarbeitet den Datenverkehr gemäß den im Anwendungsprofil angegebenen Werten. Fast TCP-, Fast UDP- und HTTP- Anwendungsprofile sind die unterstützten Profiltypen.

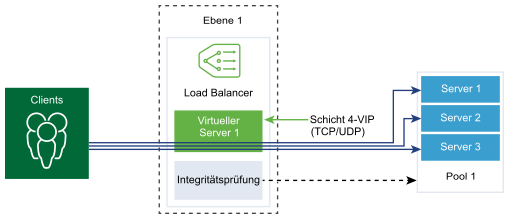

Das Anwendungsprofil TCP wird verwendet, wenn standardmäßig kein Anwendungsprofil mit einem virtuellen Server verknüpft ist. TCP- und UDP-Anwendungsprofile werden verwendet, wenn eine Anwendung auf einem TCP- oder UDP-Protokoll ausgeführt wird und kein Load Balancing auf Anwendungsebene benötigt, wie z. B. HTTP-URL-Load Balancing. Diese Profile werden auch verwendet, wenn Sie nur Load Balancing der Schicht 4 benötigen, der leistungsfähiger ist und Verbindungsspiegelung unterstützt.

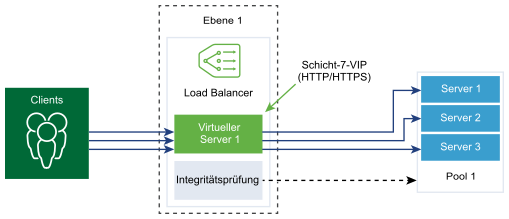

Das HTTP-Anwendungsprofil wird für HTTP- und HTTPS-Anwendungen verwendet, wenn der Load Balancer Aktionen auf Grundlage von Schicht 7 durchführen muss, wie z. B. das Durchführen von Load Balancing für alle Bildanforderungen auf einem bestimmten Serverpoolmitglied oder das Beenden von HTTPS zum Auslagern von SSL aus Poolmitgliedern. Im Gegensatz zum TCP-Anwendungsprofil beendet das HTTP-Anwendungsprofil die TCP-Verbindung des Clients am Load Balancer und wartet auf die HTTP- bzw. HTTPS-Anforderung des Clients, bevor das Serverpoolmitglied ausgewählt wird.