Der erweiterte Datenpfad (EDP) ist ein Netzwerk-Stack-Modus, der, wenn er konfiguriert ist, eine ausgezeichnete Netzwerkleistung bietet. Er ist in erster Linie NFV-Arbeitslasten vorgesehen, die durch die Nutzung der DPDK-Funktion Leistungsvorteile bieten.

Der VDS-Switch kann im Modus „Erweiterter Datenpfad“ nur auf einem ESXi-Host konfiguriert werden. Der erweiterte Datenpfad unterstützt auch Datenverkehr durch Edge-VMs.

Im Modus „Erweiterter Datenpfad“ werden beide Datenverkehrsmodi unterstützt:

- Overlay-Datenverkehr

- VLAN-Datenverkehr

Unterstützte VMkernel-Netzwerkkarten

Aufgrund der Tatsache, dass NSX mehrere Host-Switches mit erweitertem Datenpfad unterstützt, beträgt die maximale Anzahl an VMkernel-Netzwerkkarten pro Host 32.

Allgemeines Verfahren zum Konfigurieren des erweiterten Datenpfads

Als Netzwerkadministrator müssen Sie vor dem Erstellen von Transportzonen, die VDS im Modus „Erweiterter Datenpfad“ unterstützen, das Netzwerk mit den unterstützten NIC-Karten und -Treibern vorbereiten. Um die Netzwerkleistung zu verbessern, können Sie die Teaming-Richtlinie „Load Balanced Source“ aktivieren, um NUMA-Knoten zu erkennen.

Die allgemeinen Schritte sind wie folgt:

- Verwenden Sie NIC-Karten, welche den erweiterten Datenpfad unterstützen.

Finden Sie im VMware-Kompatibilitäts-Handbuch Netzwerkkarten, die den erweiterten Datenpfad unterstützen.

- Wählen Sie auf der Seite „VMware-Kompatibilitätshandbuch“ im Dropdown-Menü Systeme/Server die Option EA-Geräte aus.

- Wählen Sie auf der Seite EA-Geräte im Abschnitt Produktversion die Option ESXi <version> aus.

- Wählen Sie im Abschnitt EA-Gerätetyp die Option Network aus.

- Wählen Sie im Abschnitt Funktionen Erweiterter Datenpfad – Interrupt-Modus oder Erweiterter Datenpfad – Abfragemodus aus.

- Klicken Sie auf Aktualisieren und Ergebnisse anzeigen.

- In den Suchergebnissen finden Sie die unterstützten Netzwerkkarten, die mit der von Ihnen ausgewählten ESXi-Version kompatibel sind.

- Identifizieren Sie die Marke, für die Sie den Treiber herunterladen möchten, und klicken Sie auf die URL für dasModell, um den Treiber anzuzeigen und herunterzuladen.

- Laden Sie die aktuellen NIC-Treiber von der Seite Broadcom Support herunter und installieren Sie sie.

- Wählen Sie die VMware vSphere-Version aus.

- Wechseln Sie zu Treiber und Tools > Treiber-CDs.

- Laden Sie NIC-Treiber herunter.

- Um den Host als „Erweiterter Datenpfad“-Host zu verwenden, muss mindestens eine zum erweiterten Datenpfad fähige NIC auf dem System verfügbar sein. Wenn keine „Erweiterter Datenpfad“-fähigen NICs vorhanden sind, lässt die Management Plane nicht zu, dass den „Erweiterter Datenpfad“-Transportzonen Hosts hinzugefügt werden.

- Listen Sie den Treiber für den erweiterten Datenpfad auf.

esxcli software vib list | grep -E "i40|ixgben"

- Überprüfen Sie, ob die NIC den erweiterten Datenpfadverkehr verarbeiten kann.

esxcfg-nics -e

Name Driver ENS Capable ENS Driven MAC Address Description vmnic0 ixgben True False e4:43:4b:7b:d2:e0 Intel(R) Ethernet Controller X550 vmnic1 ixgben True False e4:43:4b:7b:d2:e1 Intel(R) Ethernet Controller X550 vmnic2 ixgben True False e4:43:4b:7b:d2:e2 Intel(R) Ethernet Controller X550 vmnic3 ixgben True False e4:43:4b:7b:d2:e3 Intel(R) Ethernet Controller X550 vmnic4 i40en True False 3c:fd:fe:7c:47:40 Intel(R) Ethernet Controller X710/X557-AT 10GBASE-T vmnic5 i40en True False 3c:fd:fe:7c:47:41 Intel(R) Ethernet Controller X710/X557-AT 10GBASE-T vmnic6 i40en True False 3c:fd:fe:7c:47:42 Intel(R) Ethernet Controller X710/X557-AT 10GBASE-T vmnic7 i40en True False 3c:fd:fe:7c:47:43 Intel(R) Ethernet Controller X710/X557-AT 10GBASE-T

- Installieren Sie den Treiber für den erweiterten Datenpfad.

esxcli software vib install -v file:///<DriverInstallerURL> --no-sig-check

- Laden Sie alternativ den Treiber auf das System herunter und installieren Sie ihn.

wget <DriverInstallerURL>

esxcli software vib install -v file:///<DriverInstallerURL> --no-sig-check

- Starten Sie den Host neu, um den Treiber zu laden. Fahren Sie mit dem nächsten Schritt fort.

- Führen Sie zum Laden des Treibers die folgenden Schritte aus:

vmkload_mod -u i40en

ps | grep vmkdevmgr

kill -HUP "$(ps | grep vmkdevmgr | awk {'print $1'})"

ps | grep vmkdevmgrkill -HUP <vmkdevmgrProcessID>

kill -HUP "$(ps | grep vmkdevmgr | awk {'print $1'})"

- Um den Treiber für den erweiterten Datenpfad zu deinstallieren, esxcli software vib remove --vibname=i40en-ens --force --no-live-install.

Hinweis: Für Overlay-Datenverkehr konfigurierte „Erweiterter Datenpfad“-Transportzonen: Vergewissern Sie sich bei einer virtuellen Microsoft Windows-Maschine mit dem vNIC-Typ VMXNET3, auf der eine VMware Tools-Version vor 11.0.0 ausgeführt wird, dass die MTU auf 1500 festgelegt ist. Stellen Sie bei einer virtuellen Microsoft Windows-Maschine, auf der vSphere 6.7 U1 und VMware Tools-Version 11.0.0 und höher ausgeführt werden, sicher, dass die MTU auf einen Wert kleiner als 8900 festgelegt ist. Stellen Sie bei virtuellen Maschinen, auf denen andere unterstützte Betriebssysteme ausgeführt werden, sicher, dass die MTU der virtuellen Maschine auf einen Wert kleiner als 8900 festgelegt ist.

- Legen Sie einen Host-Transportknoten an. Konfigurieren Sie den Modus „Erweiterter Datenpfad“ auf einem VDS-Switch mit logischen Kernen und NUMA-Knoten.

„Load Balanced Source“-Teaming-Richtlinienmodus erkennt NUMA

-

Die Latenzempfindlichkeit von VMs ist Hoch.

-

Der verwendete Netzwerkadaptertyp ist VMXNET3.

Wenn die NUMA-Knotenposition entweder der VM oder der physischen NIC nicht verfügbar ist, berücksichtigt die „Load Balanced Source“-Teaming-Richtlinie keine NUMA-Awareness, um VMs und NICs aufeinander abzustimmen.

- Der LAG-Uplink wird mit physischen Verbindungen von unterschiedlichen NUMA-Knoten konfiguriert.

- Die virtuelle Maschine (VM) verfügt über Affinität zu mehreren NUMA-Knoten.

- Der ESXi-Host konnte keine NUMA-Informationen für VM- oder physische Verbindungen definieren.

Unterstützung für erweiterten Datenpfad für Anwendungen, die zuverlässigen Datenverkehr benötigen

NFV-Arbeitslasten verwenden möglicherweise Multi-Homing- und Redundanzfunktionen, die von SCTP (Stream Control Transmission Protocol) zur Verfügung gestellt werden, um die Stabilität und Zuverlässigkeit des Datenverkehrs für Anwendungen zu erhöhen. Multihoming ist die Fähigkeit, redundante Pfade von einer Quell-VM zu einem Ziel-VM zu unterstützen.

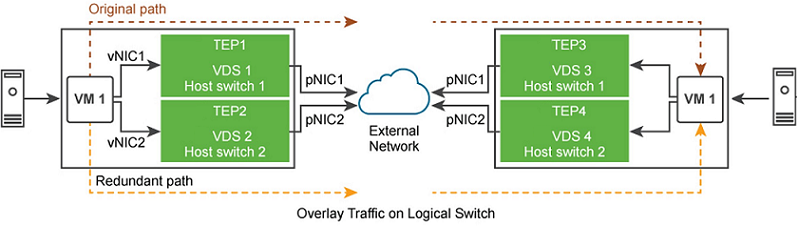

Je nach Anzahl der verfügbaren physischen Netzwerkkarten, die als Uplink für ein Overlay oder VLAN-Netzwerk verwendet werden sollen, sind viele redundante Netzwerkpfade für eine VM zum Senden von Datenverkehr über die Ziel-VM verfügbar. Die redundanten Pfade werden verwendet, wenn die angeheftete pNIC mit einem logischen Switch fehlschlägt. Der Switch im Modus „Erweiterter Datenpfad“ bietet redundante Netzwerkpfade zwischen den Hosts.

Die allgemeinen Aufgaben sehen wie folgt aus:

- Host als NSX-Transportknoten vorbereiten.

- VLAN oder Overlay-Transportzone mit zwei VDS-Switches im Modus „Erweiterter Datenpfad“ vorbereiten.

- Auf VDS-1 die erste physische Netzwerkkarte an den Switch heften.

- Auf VDS-2 die zweite physische Netzwerkkarte an den Switch heften.

Der VDS im Modus „Erweiterter Datenpfad“ gewährleistet, dass bei einem Ausfall von pNIC1 Datenverkehr von VM 1 über den redundanten Pfad (vNIC 1 → Tunnel-Endpoint 2 → pNIC 2 → VM 2) geleitet wird.