Verwenden Sie den PXE-Server, um die Installation von NSX Edge auf einem Bare Metal-Server zu automatisieren, oder verwenden Sie die ISO-Datei, um NSX Edge auf einem Bare Metal-Server zu installieren.

Der NSX Edge Bare Metal-Knoten ist ein dedizierter physischer Server, auf dem eine spezielle Version der NSX Edge-Software ausgeführt wird. Der Bare Metal NSX Edge-Knoten benötigt eine Netzwerkkarte, die das Data Plane Development Kit (DPDK) unterstützt. VMware pflegt eine Liste hinsichtlich der Kompatibilität mit Netzwerkkarten von verschiedenen Anbietern. Siehe Bare Metal Server-Systemanforderungen.

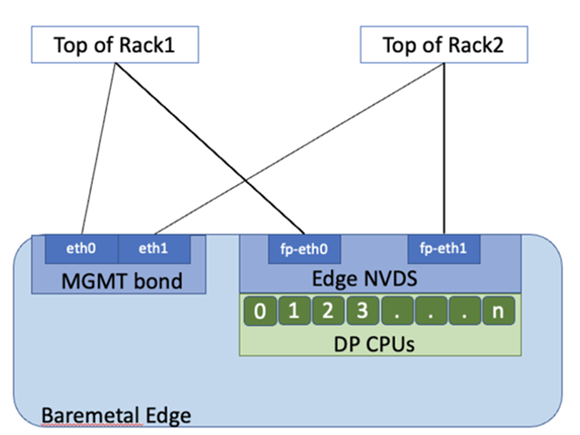

Die NSX Edge-Knoten im Diagramm sind mit einem einzelnen N-VDS-Switch dargestellt, der mit zwei Datenpfadschnittstellen und zwei dedizierten Netzwerkkarten für Hochverfügbarkeit der Management Plane konfiguriert ist.

Bare Metal NSX Edge Knoten können mit mehr als 2 Datenpfadschnittstellen konfiguriert werden, abhängig von der Anzahl der auf dem Server verfügbaren Netzwerkkarten. Bare Metal NSX Edge-Knoten verwenden pNICs als Uplinks, die direkt mit den Top-of-Rack-Switches verbunden sind. Um Hochverfügbarkeit für die Bare Metal-Edge-Verwaltung bereitzustellen, konfigurieren Sie zwei pNICs auf dem Server als aktive/Standby-Linux-Bindung.

Die CPUs auf dem Edge werden entweder als Datenpfad (DP)-CPUs zugewiesen, die Routing- und statusbehaftete Dienste bereitstellen, oder als Dienst-CPUs, die Load Balancing- und VPN-Dienste bereitstellen.

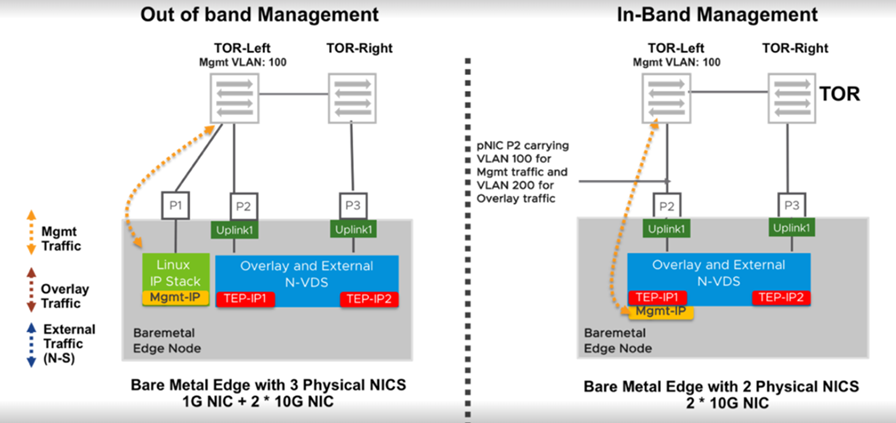

Wenn ein Bare Metal Edge-Knoten installiert ist, wird eine dedizierte Schnittstelle für die Verwaltung beibehalten. Diese Konfiguration wird als Out-of-Band-Verwaltung bezeichnet. Wenn Redundanz erwünscht wird, können zwei Netzwerkkarten für die Hochverfügbarkeit der Management Plane verwendet werden. Der Bare Metal Edge unterstützt auch die In-Band-Verwaltung, bei der der Verwaltungsdatenverkehr eine Schnittstelle nutzen kann, die wie im Diagramm für Overlay- oder externen Datenverkehr (N-S) verwendet wird.

Für Bare Metal-Edge-Knoten werden alle Kerne des ersten Knotens eines Servers mit mehreren NUMA-Knoten dem NSX-Datenpfad zugewiesen. Wenn der Bare Metal nur über einen NUMA-Knoten verfügt, werden 50 % der Kerne für den NSX-Datenpfad zugewiesen.

Bare Metal NSX Edge-Knoten unterstützen maximal zwei NUMA-Knoten.

Die Sub-NUMA-Clustering-Funktionalität ändert den Socket des Heap-Arbeitsspeichers von zwei NUMA-Domänen in vier NUMA-Domänen. Diese Änderung begrenzt die Größe des Heap-Arbeitsspeichers, der den einzelnen Sockets zugeteilt ist, und führt zu einem Mangel an Heap-Arbeitsspeicher für Socket 0, der vom Datenpfad benötigt wird. Sie müssen die Sub-NUMA-Funktion im BIOS deaktivieren. Jegliche am BIOS vorgenommenen Änderungen erfordern einen Neustart.

Um zu überprüfen, ob die Sub-NUMA-Funktionalität aktiviert ist, melden Sie sich beim Bare Metal-NSX Edge als Root an und führen Sie lscpu aus. Die Ausgabe wird auch im Support-Paket erfasst. Wenn mehr als zwei NUMA-Knoten vorhanden sind, ist die Sub-NUMA-Funktionalität aktiviert und muss über BIOS deaktiviert werden.

- Beim Konfigurieren von LACP-LAG-Bindungen auf Bare Metal NSX Edge-Knoten sollten Datenpfad-Kerne (unterstützende Netzwerkkarten) zum selben NUMA-Knoten gehören, damit das Load Balancing auf beiden Geräten erfolgt. Wenn Geräte, die die Bindung bilden, mehrere NUMA-Knoten umfassen, verwendet Bond zum Übertragen von Paketen nur die Netzwerkgeräte-CPU, bei der es sich um einen lokalen NUMA-Knoten (0) handelt. Daher werden nicht alle Geräte für den Ausgleich des Datenverkehrs verwendet, der aus dem Bond-Gerät gesendet wird.

In diesem Fall funktioniert das Failover weiterhin, da das Failover getrennt vom Load Balancing erfolgt. Wenn das an den lokalen NUMA-Knoten angehängte Ethernetgerät ausfällt, sendet der Bond den Datenverkehr an das andere Gerät, auch wenn es nicht NUMA-lokal ist. Die Optimierung des Lastausgleichs hat keine Auswirkung auf die Failover-Funktionalität.

Führen Sie den Befehl get dataplane aus, um den NUMA-Knoten anzuzeigen, der den einzelnen Datenpfadschnittstellen zugeordnet ist. Um dem Datenpfad zugeordnete Netzwerkkarten auf einen einzelnen NUMA-Knoten zu verschieben, ist eine physische Neukonfiguration des Servers über das BIOS erforderlich.

Voraussetzungen

- Deaktivieren Sie sub-NUMA-Clustering, indem Sie die BIOS-Einstellungen bearbeiten. NSX unterstützt kein sub-NUMA-Clustering. Weitere Einzelheiten finden Sie im KB-Artikel https://kb.vmware.com/s/article/91790.

- Ab NSX 3.1.3 müssen Sie Hyper-Threading auf Bare Metal NSX Edge-Knoten nicht deaktivieren. Hyper-Threading wird automatisch deaktiviert.