NSX ALB als Endpoint-Anbieter der Steuerungsebene

Bei der Vernetzung mit Tanzu Kubernetes Grid kann NSX ALB den Clustern eine Endpoint-VIP bereitstellen und einen Lastausgleich auf den Knoten der Steuerungsebene des Clusters durchführen. Mit dieser Funktion können Sie auch den API-Serverport und das VIP-Netzwerk des Clusters anpassen.

Die folgende Tabelle enthält einen Vergleich der Funktionen, die auf NSX ALB und Kube-Vip unterstützt werden:

| NSX ALB | Kube-Vip | |

|---|---|---|

| Cluster-Endpoint-VIP für IPAM | Bereitgestellt von NSX ALB |

Manuell vom Kunden verwaltet |

| Lastausgleich für die Knoten der Steuerungsebene | Für den Datenverkehr wird ein Lastausgleich für alle Knoten der Steuerungsebene durchgeführt |

Datenverkehr wird nur an den Leader-Knoten der Steuerungsebene weitergeleitet |

| Port für den API-Server | Beliebiger Port (Standard ist 6443) |

Beliebiger Port (Standard ist 6443) |

Konfigurieren von NSX ALB als VIP-Anbieter für Cluster-Endpoints

So konfigurieren Sie NSX ALB als VIP-Anbieter für Cluster-Endpoints in einem Verwaltungscluster:

-

Erstellen Sie eine YAML-Datei für die Verwaltungsclusterkonfiguration und fügen Sie das folgende Feld in der Datei hinzu:

AVI_CONTROL_PLANE_HA_PROVIDER: true -

Wenn Sie eine statische IP-Adresse für die Endpoint-VIP verwenden möchten, fügen Sie das folgende Feld in der Datei hinzu:

VSPHERE_CONTROL_PLANE_ENDPOINT: <IP-ADDRESS>Stellen Sie sicher, dass die VIP in dem statischen IP-Pool vorhanden ist, der in Ihrem VIP-Netzwerk angegeben ist.

-

Wenn Sie einen Port für den API-Server angeben möchten, fügen Sie das folgende Feld in der Datei hinzu:

AVI_CONTROL_PLANE_HA_PROVIDER: true CLUSTER_API_SERVER_PORT: <PORT-NUMBER>Hinweis

Der Verwaltungscluster und seine Arbeitslastcluster verwenden diesen Port, um eine Verbindung mit dem API-Server herzustellen.

- Erstellen Sie den Verwaltungscluster mit dem Befehl

tanzu management-cluster create.

NSX ALB ist jetzt als Endpoint-VIP-Anbieter für den Verwaltungscluster konfiguriert.

So konfigurieren Sie NSX ALB als VIP-Anbieter für Cluster-Endpoints in einem Arbeitslastcluster:

-

Erstellen Sie eine YAML-Datei für die Arbeitslastclusterkonfiguration und fügen Sie das folgende Feld hinzu:

AVI_CONTROL_PLANE_HA_PROVIDER: true -

Wenn Sie eine statische IP-Adresse für die Endpoint-VIP verwenden möchten, fügen Sie das folgende Feld in der Datei hinzu:

AVI_CONTROL_PLANE_HA_PROVIDER: true VSPHERE_CONTROL_PLANE_ENDPOINT: <IP-ADDRESS>Stellen Sie sicher, dass die VIP in dem statischen IP-Pool vorhanden ist, der in Ihrem VIP-Netzwerk angegeben ist.

-

Stellen Sie den Arbeitslastcluster mit dem Befehl

tanzu cluster createbereit.

NSX ALB ist jetzt als Endpoint-VIP-Anbieter für den Arbeitslastcluster konfiguriert.

Separate VIP-Netzwerke für Cluster-Endpoints und Arbeitslastdienste

Wenn Sie diese Funktion auf NSX ALB Essentials Edition verwenden möchten, stellen Sie sicher, dass für das verwendete Netzwerk keine Firewalls oder Netzwerkrichtlinien konfiguriert sind. Wenn Sie Firewalls oder Netzwerkrichtlinien im Netzwerk konfiguriert haben, stellen Sie die NSX ALB Enterprise Edition mit der Auto-Gateway-Funktion bereit, um diese Funktion zu nutzen.

Wenn Sie NSX ALB zur Bereitstellung der Cluster-Endpoint-VIP verwenden, können Sie das VIP-Netzwerk für Ihren Cluster-Endpoint und die externen IPs für Arbeitslastdienste (Lastausgleichsdienst und Ingress) anpassen. Sie können sie in verschiedene VIP-Netzwerke untergliedern, um die Sicherheit zu erhöhen und andere Anforderungen an die Netzwerktopologie zu erfüllen.

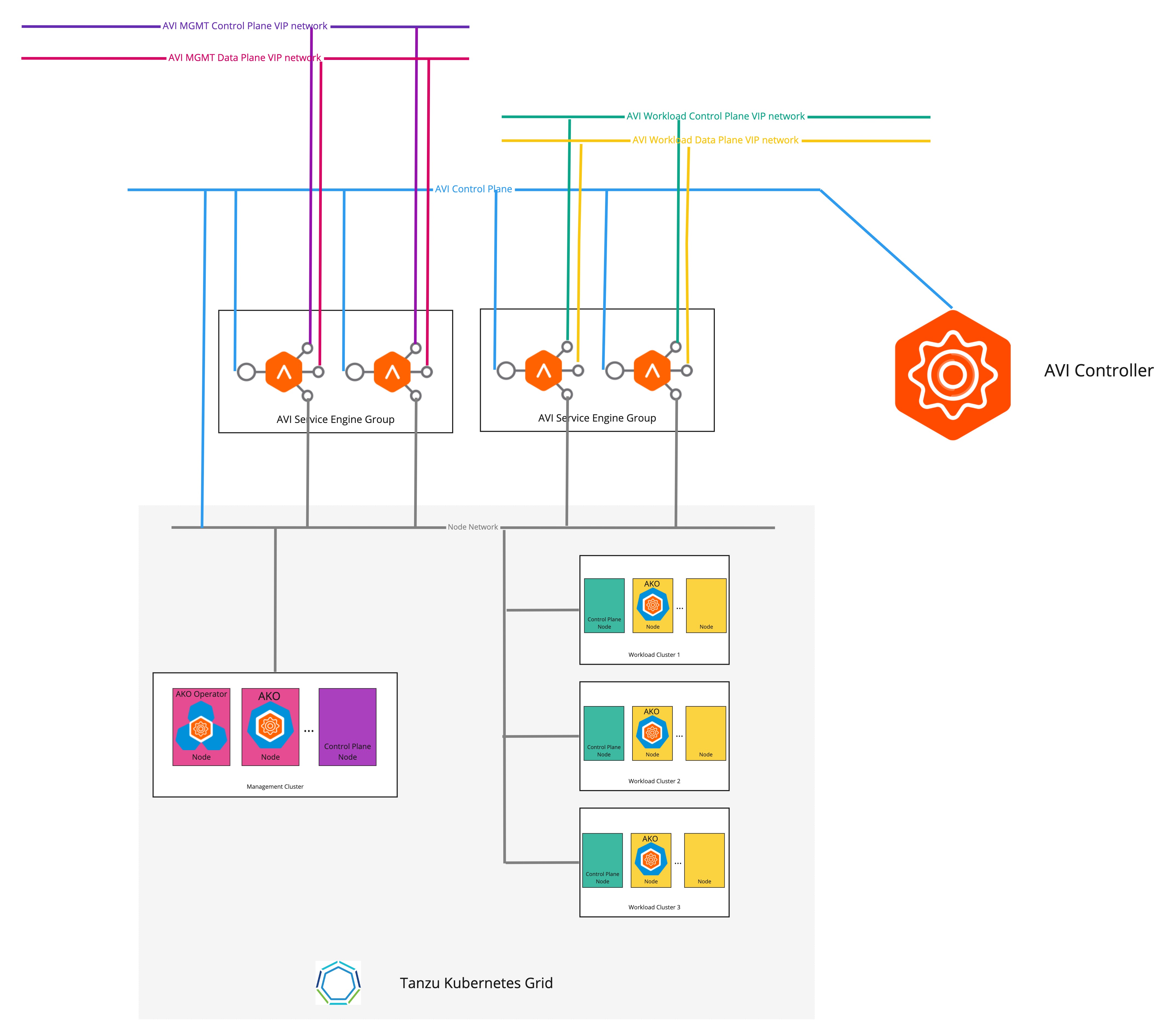

Konfigurieren separater VIP-Netzwerke für den Verwaltungscluster und die Arbeitslastcluster

Das folgende Diagramm beschreibt die Netzwerktopologie, wenn separate VIP-Netzwerke für den Verwaltungscluster und die Arbeitslastcluster konfiguriert werden:

So konfigurieren Sie separate VIP-Netzwerke für den Verwaltungscluster und die Arbeitslastcluster:

-

Erstellen Sie eine YAML-Datei für die Verwaltungsclusterkonfiguration und fügen Sie die folgenden Felder in der Datei hinzu:

AVI_CONTROL_PLANE_HA_PROVIDER: true # Network used to place workload clusters' services external IPs (load balancer & ingress services) AVI_DATA_NETWORK: AVI_DATA_NETWORK_CIDR: # Network used to place workload clusters' endpoint VIPs AVI_CONTROL_PLANE_NETWORK: AVI_CONTROL_PLANE_NETWORK_CIDR: # Network used to place management clusters' services external IPs (load balancer & ingress services) AVI_MANAGEMENT_CLUSTER_VIP_NETWORK_NAME: AVI_MANAGEMENT_CLUSTER_VIP_NETWORK_CIDR: # Network used to place management clusters' endpoint VIPs AVI_MANAGEMENT_CLUSTER_CONTROL_PLANE_VIP_NETWORK_NAME: AVI_MANAGEMENT_CLUSTER_CONTROL_PLANE_VIP_NETWORK_CIDR:Weitere Informationen zum Erstellen einer Konfigurationsdatei für den Verwaltungscluster finden Sie unter Erstellen einer Konfigurationsdatei für den Verwaltungscluster.

-

Erstellen Sie den Verwaltungscluster mit dem Befehl

tanzu management-cluster create.

Die Endpoint-VIP des Clusters und die externe IP des Lastausgleichsdiensts werden jetzt in unterschiedlichen Netzwerken platziert.

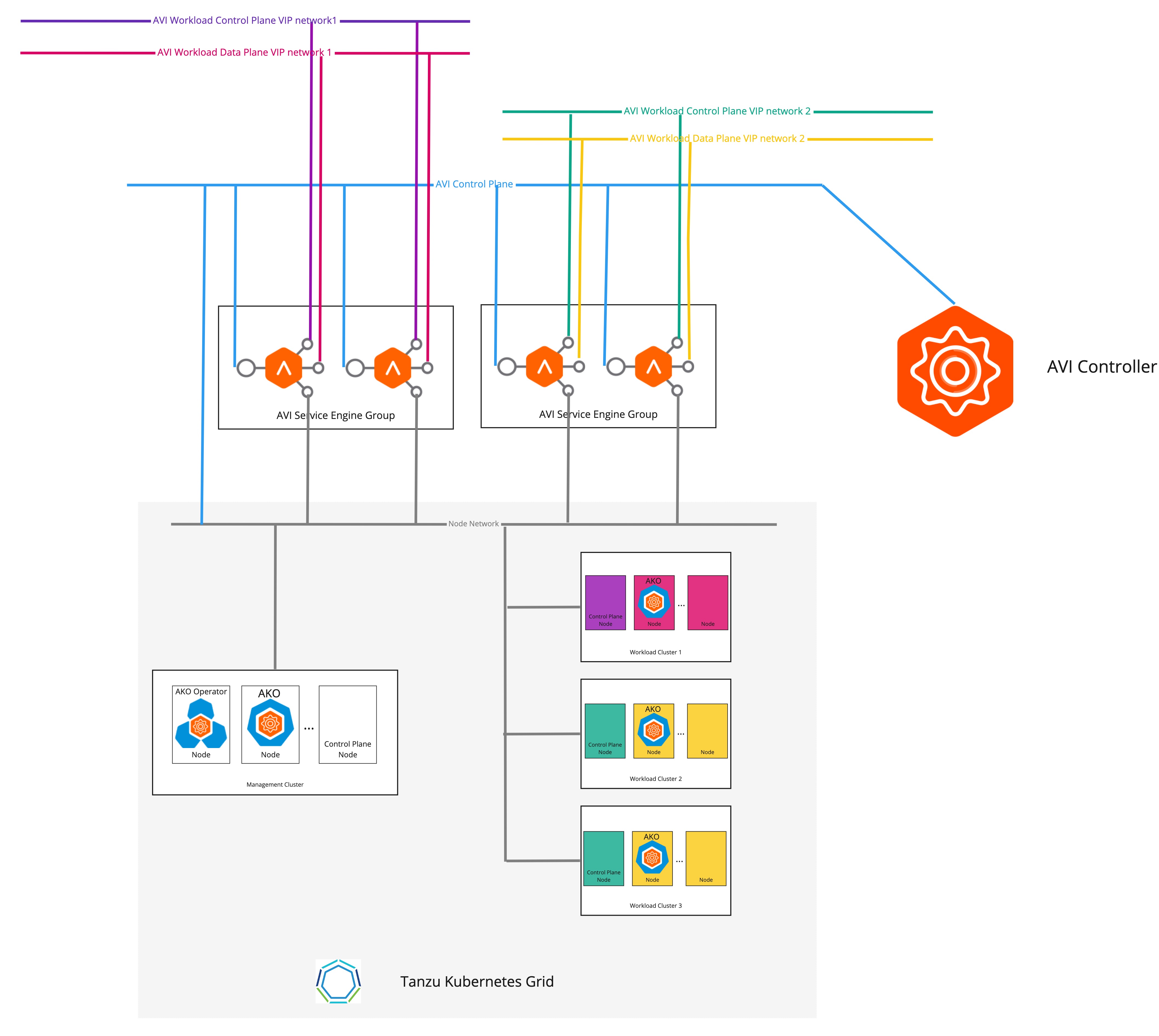

Konfigurieren separater VIP-Netzwerke für verschiedene Arbeitslastcluster

Das folgende Diagramm beschreibt die Netzwerktopologie, wenn separate VIP-Netzwerke für verschiedene Arbeitslastcluster konfiguriert sind.

So konfigurieren Sie separate VIP-Netzwerke für verschiedene Arbeitslastcluster:

-

Erstellen Sie ein

AKODeploymentConfig-CR-Objekt, wie im folgenden Beispiel gezeigt:apiVersion: networking.tkg.tanzu.vmware.com/v1alpha1 kind: AKODeploymentConfig metadata: name: install-ako-for-dev-cluster spec: adminCredentialRef: name: avi-controller-credentials namespace: tkg-system-networking certificateAuthorityRef: name: avi-controller-ca namespace: tkg-system-networking controller: 1.1.1.1 cloudName: Default-Cloud serviceEngineGroup: Default-Group clusterSelector: # match workload clusters with dev-cluster: "true" label matchLabels: dev-cluster: "true" controlPlaneNetwork: # clusters' endpoint VIP come from this VIP network cidr: 10.10.0.0/16 name: avi-dev-cp-network dataNetwork: # clusters' services external IP come from this VIP network cidr: 20.20.0.0/16 name: avi-dev-dp-network -

Wenden Sie die Änderungen auf den Verwaltungscluster an:

kubectl --context=MGMT-CLUSTER-CONTEXT apply -f <FILE-NAME> -

Fügen Sie in der YAML-Datei für die Arbeitslastclusterkonfiguration die erforderlichen Felder hinzu, wie im folgenden Beispiel gezeigt:

AVI_CONTROL_PLANE_HA_PROVIDER: true AVI_LABELS: '{"dev-cluster": "true"}' -

Erstellen Sie den Arbeitslastcluster mit dem Befehl

tanzu cluster create.

Die Endpoint-VIP der Cluster und die externe IP des Lastausgleichsdiensts werden jetzt in unterschiedlichen Netzwerken platziert.