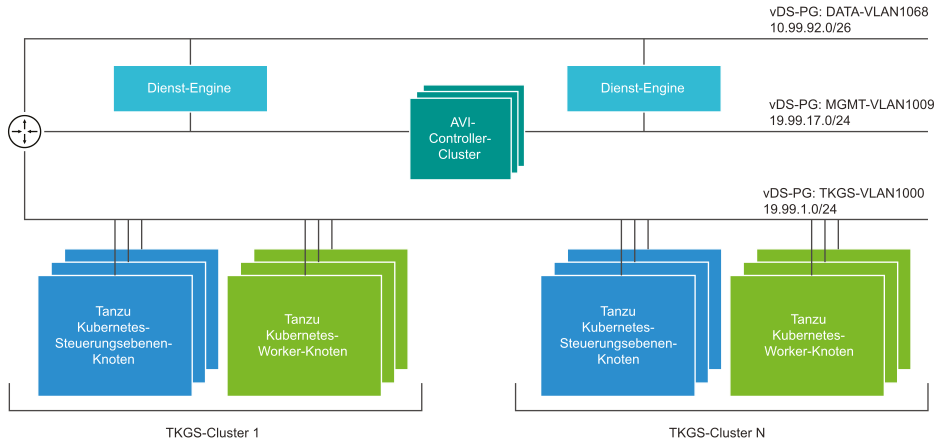

Der AVI-Controller wird immer im Verwaltungsnetzwerk bereitgestellt, in dem er mit dem vCenter Server, ESXi-Hosts und Supervisor-Cluster-Knoten der Steuerungsebene verbunden werden kann. Die Dienst-Engines werden mit Schnittstellen zum Verwaltungsnetzwerk und zum Datennetzwerk bereitgestellt.

Im Verwaltungsnetzwerk, z. B. MGMT-VLAN1009, befindet sich der Controller, und die Verwaltungsschnittstelle der Dienst-Engines ist mit dem Netzwerk verbunden.

Die Dienst-Engine-Schnittstellen, die eine Verbindung zur VIP-Platzierung herstellen, befinden sich im Datennetzwerk, wie z. B. DATA-VLAN1068. Der Client-Datenverkehr erreicht die VIP, und die Dienst-Engines verteilen den Datenverkehr zu den Arbeitslastnetzwerk-IPs über dieses Netzwerk.

Im Arbeitslastnetzwerk, wie z. B. TKGS-VLAN1000, werden die Tanzu Kubernetes-Cluster ausgeführt. Die Dienst-Engines benötigen keine Schnittstellen zum Arbeitslastnetzwerk.

Die Dienst-Engines werden im einarmigen Modus ausgeführt. Sie leiten den Lastausgleichsdatenverkehr über den Router an das Arbeitslastnetzwerk weiter. Die Dienst-Engines erhalten nicht die Standard-Gateway-IP von DHCP in den Datennetzwerken. Sie müssen statische Routen konfigurieren, damit die Dienst-Engines den Datenverkehr ordnungsgemäß an die Arbeitslastnetzwerke und die Client-IP weiterleiten können. Weitere Informationen zum Konfigurieren von statischen Routen finden Sie unter Konfigurieren eines Standard-Gateways.

Durch diese Topologie ist es möglich, dass die Dienst-Engine sich in einem einzelnen Netzwerk befindet und einen Lastausgleichsdienst für mehrere Arbeitslastnetzwerke bereitstellt, sofern vorhanden. Die Erstellung der Dienst-Engine und die Netzwerkverbindungen werden vom AVI-Controller automatisiert.