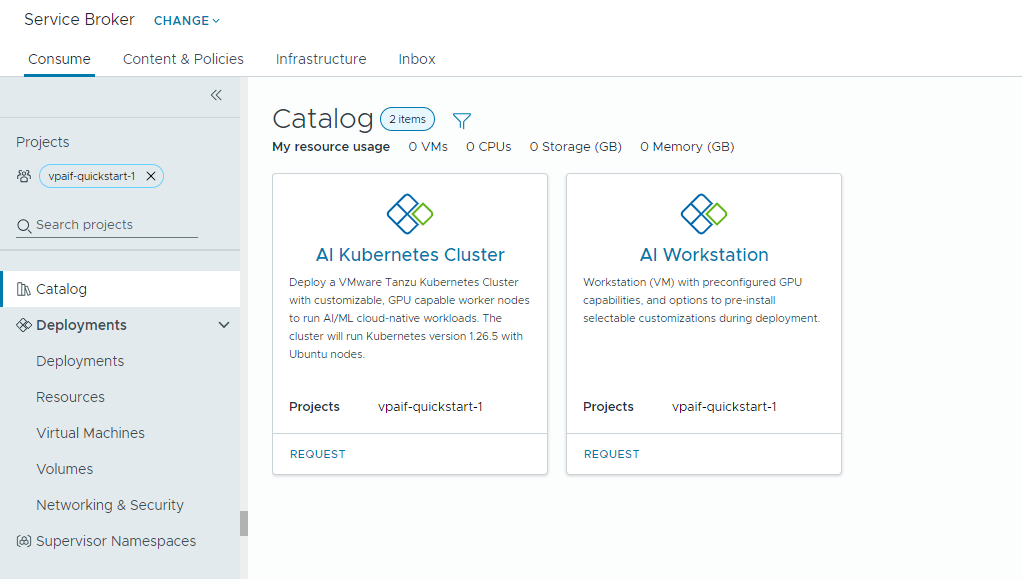

Si el administrador de nube configuró Private AI Automation Services en VMware Aria Automation, puede solicitar cargas de trabajo de AI mediante el catálogo de Automation Service Broker.

Private AI Automation Services admite dos elementos de catálogo en Automation Service Broker a los cuales pueden acceder los usuarios con los permisos correspondientes, además de poder solicitarlos.

- Estación de trabajo AI: una máquina virtual habilitada para GPU que se puede configurar con los elementos de vCPU, vGPU, memoria y software de AI/ML que se quiera de NVIDIA.

- Clúster de Kubernetes de AI: un clúster de Tanzu Kubernetes habilitado para GPU que se puede configurar con un operador de GPU de NVIDIA.

Antes de comenzar

- Compruebe que los Private AI Automation Services están configurados para el proyecto y que tienen permisos para solicitar elementos del catálogo de AI.

Recuerde que todos los valores son ejemplos de casos prácticos. Los valores de su cuenta dependen del entorno que tenga.

Implementar una máquina virtual de aprendizaje profundo en un dominio de carga de trabajo de VI

Como especialista en datos, puede implementar un entorno de desarrollo definido por software con una GPU desde el catálogo de Automation Service Broker de autoservicio. Puede personalizar la máquina virtual habilitada para GPU con parámetros de máquina para modelar los requisitos de desarrollo, especificar las configuraciones de software de AI/ML para cumplir con los requisitos de formación e inferencia, y especificar los paquetes de AI/ML del registro de NVIDIA NGC mediante una clave de acceso al portal.

Procedimiento

Implementar un clúster de Tanzu Kubernetes habilitado para IA

Como ingeniero de desarrollo y operaciones, puede solicitar un clúster de Tanzu Kubernetes habilitado para GPU, en el cual los nodos de trabajo pueden ejecutar cargas de trabajo de AI/ML.

El clúster de TKG contiene un operador de GPU NVIDIA, que es un operador de Kubernetes que se encarga de configurar el controlador NVIDIA adecuado para el hardware de GPU NVIDIA en los nodos del clúster de TKG. El clúster implementado está listo para usarse para cargas de trabajo de AI/ML sin necesidad de una configuración adicional relacionada con GPU.

Procedimiento

- Busque la tarjeta Clúster de Kubernetes AI y haga clic en Solicitar.

- Seleccione un proyecto.

- Introduzca un nombre y una descripción para la implementación.

- Seleccione el número de nodos del panel de control.

Ajuste Valor de ejemplo Cantidad de nodos 1 Clase de VM cpu-only-medium: 8 CPU y 16 GB de memoria La selección de clase define los recursos disponibles en la máquina virtual.

- Seleccione el número de nodos de trabajo.

Ajuste Descripción Cantidad de nodos 3 Clase de VM a100-medium: 4 vGPU (64 GB), 16 CPU y 32 GB de memoria - Haga clic en Enviar.

Resultados

La implementación contiene un espacio de nombres de supervisor, un clúster de TKG con tres nodos de trabajo, varios recursos dentro del clúster de TKG y una aplicación carvel que implementa la aplicación del operador de GPU.

Supervisar sus implementaciones de Private AI

Utilice la página Implementaciones para administrar las implementaciones y los recursos asociados, como realizar cambios en ellas, solucionar los problemas de las implementaciones con errores, hacer cambios en los recursos y destruir las implementaciones que no se utilizan.

Para administrar las implementaciones, seleccione .

Para obtener más información, consulte Cómo administrar mis implementaciones de Automation Service Broker.