Como administrador de nube, puede utilizar la pila de VMware Cloud Foundation para administrar la infraestructura habilitada para GPU y los dominios de carga de trabajo de AI/ML. En VMware Aria Automation, puede configurar y proporcionar clústeres de Tanzu Kubernetes Grid (TKG) y máquinas virtuales de aprendizaje profundo (DL VM) habilitados para GPU como elementos del catálogo que los especialistas en datos y los equipos de DevOps de la organización pueden solicitar en el catálogo de Automation Service Broker de autoservicio.

¿Qué es VMware Private AI Foundation?

VMware Private AI Foundation con NVIDIA proporciona una plataforma para aprovisionar cargas de trabajo de IA en VMware Cloud Foundation con varias GPU de NVIDIA. Además, la ejecución de cargas de trabajo de AI basadas en contenedores de NVIDIA GPU Cloud (NGC) está validada específicamente por VMware by Broadcom. Para obtener más información, consulte Qué es VMware Private AI Foundation con NVIDIA.

Private AI Automation Services es el nombre colectivo de todas las funciones de VMware Private AI Foundation que están disponibles en VMware Aria Automation.

Para comenzar a utilizar Private AI Automation Services, ejecute el Asistente de configuración de catálogos en VMware Aria Automation. El asistente le ayuda a conectar VMware Private AI Foundation a VMware Aria Automation.

¿Cómo funciona el Asistente de configuración de catálogos?

- Agregue una cuenta de nube. Las cuentas de nube son las credenciales que se usan para recopilar datos e implementar recursos en la instancia de vCenter.

- Agregue una licencia de NVIDIA.

- Seleccione el contenido que desea agregar al catálogo de Automation Service Broker.

- Cree un proyecto. El proyecto vincula a sus usuarios con regiones de la cuenta de nube a fin de que puedan implementar plantillas de nube con redes y recursos de almacenamiento en la instancia de vCenter.

- AI Workstation: una máquina virtual habilitada para GPU que se puede configurar con la vCPU, vGPU y memoria que se quiera y la opción de preinstalar marcos de AI/ML como PyTorch, muestras de CUDA y TensorFlow.

- AI RAG Workstation: una máquina virtual habilitada para GPU con solución de referencia Recovery Augmented Generation (RAG).

- Servidor de inferencias Triton: una máquina virtual habilitada para GPU con servidor de inferencias Triton.

- Clúster de AI Kubernetes: un clúster de VMware Tanzu Kubernetes Grid con nodos de trabajo compatibles con GPU para ejecutar cargas de trabajo nativas de la nube de AI/ML.

- Clúster RAG de Kubernetes AI: un clúster de VMware Tanzu Kubernetes Grid con nodos de trabajo compatibles con GPU para ejecutar una solución RAG de referencia.

Puede volver a ejecutar el asistente varias veces si necesita cambiar cualquiera de los ajustes que proporcionó, por ejemplo, si hay cambios en las licencias, o si desea crear elementos del catálogo de AI para otros proyectos. Cada vez que ejecuta el asistente, se crean cinco nuevos elementos de catálogo, además de los elementos creados anteriormente.

Puede modificar las plantillas de los elementos del catálogo que el asistente creó para satisfacer las necesidades específicas de su organización.

Antes de comenzar

- Compruebe que está ejecutando VMware Aria Automation 8.18.

- Compruebe que está ejecutando VMware Cloud Foundation 5.1.1 o posterior, que incluye vCenter 8.0 Update U2b.

- Compruebe que tiene una cuenta de nube de vCenter en VMware Aria Automation.

- Compruebe que tiene una organización de NVIDIA GPU Cloud Enterprise con una suscripción de servicio de nube prémium.

- Compruebe que tiene un clúster de supervisor habilitado para GPU configurado a través de la administración de cargas de trabajo.

- Configure VMware Aria Automation para VMware Private AI Foundation con NVIDIA. Consulte Configurar VMware Aria Automation VMware Private AI Foundation con NVIDIA.

- Complete el Inicio rápido de VMware Cloud Foundation antes de ejecutar el Asistente de configuración de catálogos. Su SDDC y los clústeres de supervisor deben estar registrados con VMware Aria Automation. Consulte Cómo comenzar a usar VMware Aria Automation con el inicio rápido de VMware Cloud Foundation.

- Compruebe que generó el token de configuración de cliente desde el servidor de licencias de NVIDIA y que tiene su clave de API del portal de NVIDIA NGC. La clave de acceso al portal de NVIDIA NGC se utiliza para descargar e instalar controladores de vGPU.

- Configure el inicio de sesión único (SSO) para la interfaz de consumo de nube (Cloud Consumption Interface, CCI). Consulte Configurar el inicio de sesión único para CCI.

- Compruebe que está suscrito a la biblioteca de contenido en https://packages.vmware.com/dl-vm/lib.json.

Procedimiento

- Después de instalar VMware Aria Automation e iniciar sesión por primera vez, haga clic en Comenzar inicio rápido.

- En la tarjeta Private AI Automation Services, haga clic en Iniciar.

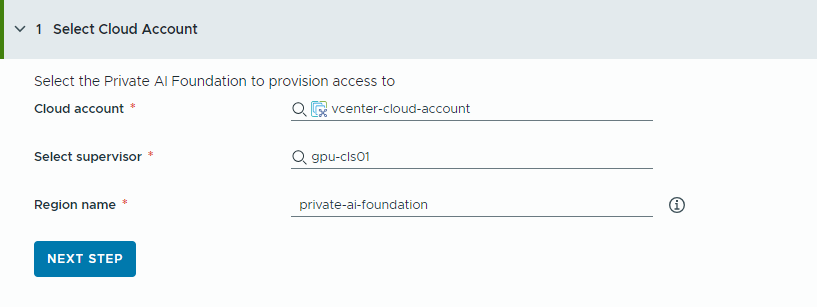

- Seleccione la cuenta de nube a la que se aprovisiona el acceso.

Recuerde que todos los valores son ejemplos de casos prácticos. Los valores de su cuenta dependen del entorno que tenga.

- Seleccione una cuenta de nube de vCenter.

- Seleccione un supervisor habilitado para GPU.

- Introduzca un nombre de región.

Una región se selecciona automáticamente si el supervisor ya está configurado con una región.

Si el supervisor no está asociado a una región, agregue una en este paso. Considere el uso de un nombre descriptivo para la región que ayude a los usuarios a distinguir las regiones habilitadas para GPU de otras regiones disponibles.

- Haga clic en Siguiente paso.

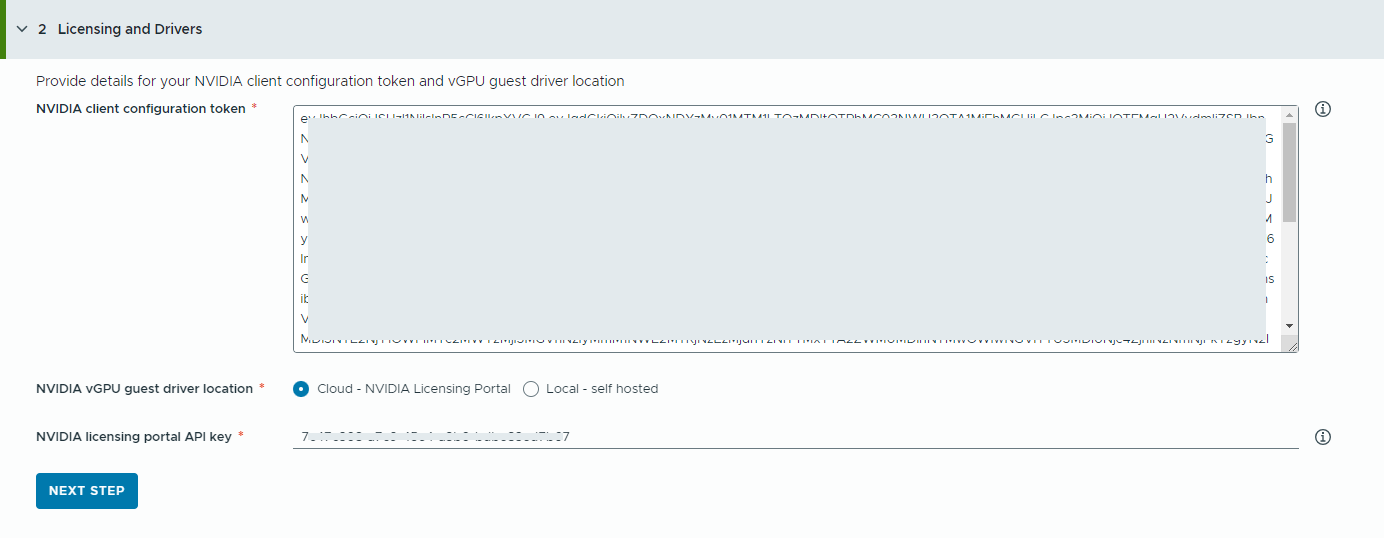

- Proporcione información sobre su servidor de licencias de NVIDIA.

- Copie y pegue el contenido del token de configuración de cliente de NVIDIA.

El token de configuración de cliente es necesario para habilitar todas las capacidades del controlador de vGPU.

- Seleccione la ubicación de los controladores de vGPU de NVIDIA.

- Nube: el controlador de vGPU de NVIDIA se aloja en el portal de licencias de NVIDIA.

Debe proporcionar la clave de API del portal de licencias de NVIDIA, que se utiliza para evaluar si un usuario tiene la autorización adecuada para descargar los controladores de vGPU de NVIDIA. La clave de API debe ser un UUID.

Nota: La clave de API que se genera desde el portal de licencias de NVIDIA no es la misma que la clave de API de NVAIE. - Local: el controlador de vGPU de NVIDIA se aloja en las instalaciones y se accede a él desde una red privada.

Debe proporcionar la ubicación de los controladores invitados de vGPU para las máquinas virtuales.

Para entornos aislados, el controlador de vGPU debe estar disponible en la red privada o el centro de datos.

- Nube: el controlador de vGPU de NVIDIA se aloja en el portal de licencias de NVIDIA.

- Haga clic en Siguiente paso.

- Copie y pegue el contenido del token de configuración de cliente de NVIDIA.

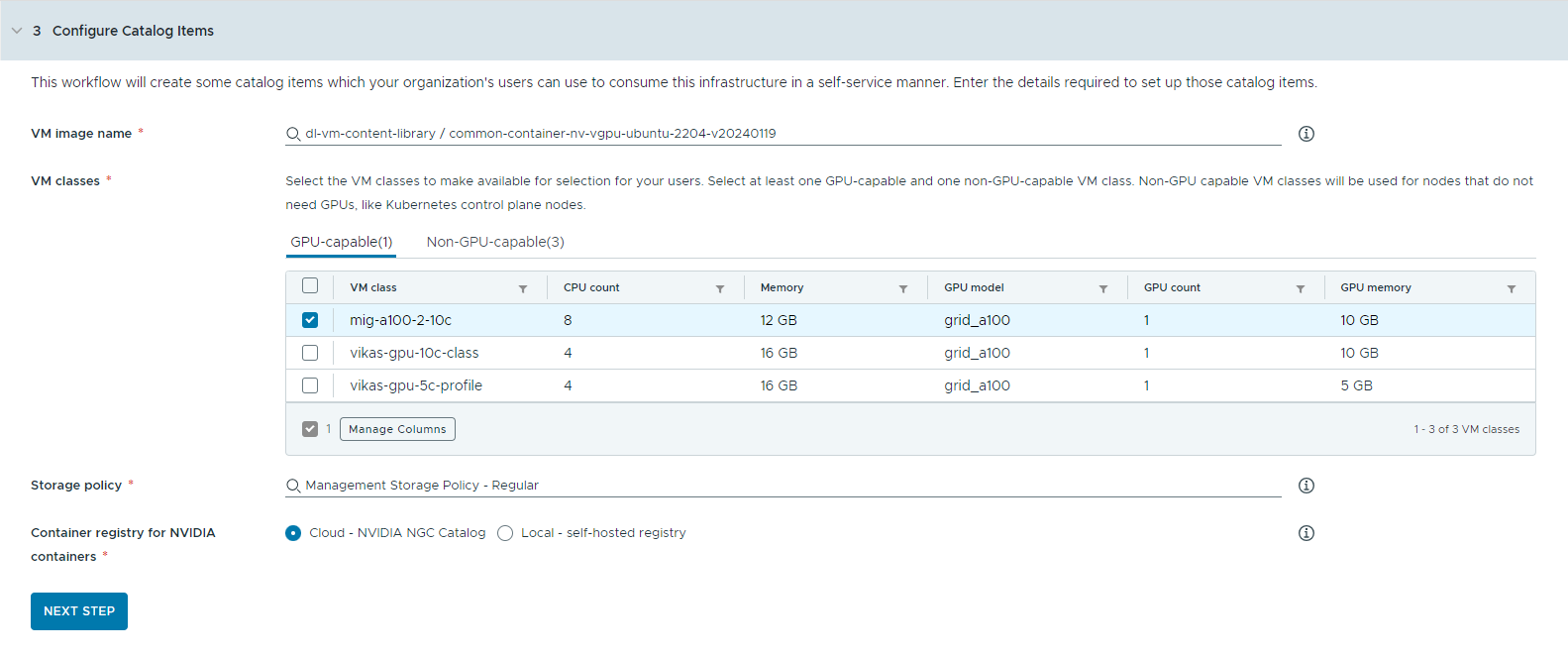

- Configure los elementos del catálogo.

- Seleccione la biblioteca de contenido que contiene la imagen de máquina virtual de aprendizaje profundo.

Solo puede acceder a una biblioteca de contenido a la vez. Si la biblioteca de contenido contiene imágenes de Kubernetes, esas imágenes se filtran.

- Seleccione la imagen de máquina virtual que quiere usar para crear la máquina virtual de estación de trabajo.

- Seleccione las clases de máquina virtual que desea poner a disposición de los usuarios del catálogo.

Debe agregar al menos una clase compatible con GPU y otra no compatible con GPU.

- Las clases de máquinas virtuales habilitadas para GPU se utilizan para la máquina virtual de aprendizaje profundo y para los nodos de trabajo del clúster de TKG. Cuando se implementa el elemento del catálogo, el clúster de TKG se crea con las clases de máquinas virtuales seleccionadas.

- Se requieren nodos no compatibles con GPU para ejecutar los planos de control de Kubernetes.

- Seleccione la directiva de almacenamiento que se aplicará a las máquinas virtuales.

- Especifique el registro de contenedor del que desea extraer los recursos de nube de GPU de NVIDIA.

- Nube: las imágenes de contenedor se extraen del catálogo de NVIDIA NGC.

- Local: para entornos aislados, los contenedores se extraen de un registro privado.

Debe proporcionar la ubicación del registro autoalojado. Si el registro requiere autenticación, también debe proporcionar las credenciales de inicio de sesión.

Puede utilizar Harbor como registro local para imágenes de contenedor del catálogo de NVIDIA NGC. Consulte Ajustar un registro de Harbor privado en VMware Private AI Foundation con NVIDIA.

- (Opcional) Configurar un servidor proxy.

En entornos sin acceso directo a Internet, el servidor proxy se utiliza para descargar el controlador de vGPU y extraer los contenedores de AI Workstation que no sean RAG.

Nota: La compatibilidad con entornos aislados está disponible para los elementos de catálogo AI Workstation y Servidor de inferencias Triton. Los elementos AI RAG Workstation y AI Kubernetes Cluster no admiten entornos aislados y necesitan conectividad a Internet. - Haga clic en Siguiente paso.

- Seleccione la biblioteca de contenido que contiene la imagen de máquina virtual de aprendizaje profundo.

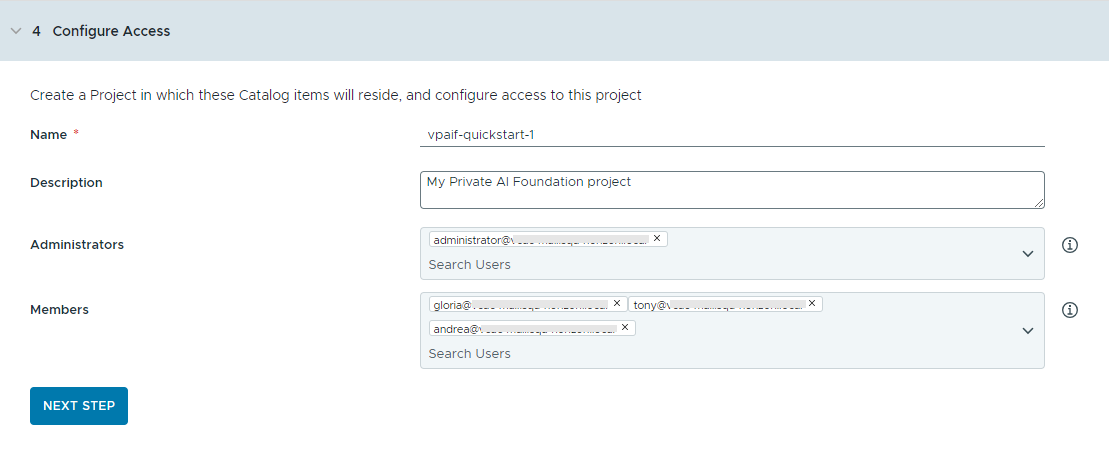

- Para configurar el acceso a los elementos del catálogo, cree un proyecto y asigne usuarios.

Los proyectos se utilizan para administrar personas, recursos asignados, plantillas de nube e implementaciones.

- Introduzca un nombre y una descripción para el proyecto.

El nombre del proyecto solo debe contener caracteres alfanuméricos en minúscula o guiones (-).

- Para que los elementos del catálogo estén disponibles para otros usuarios, agregue un Administrador y Miembros.

Los administradores tienen más permisos que los miembros. Para obtener más información, consulte Cuáles son las funciones de usuario de VMware Aria Automation.

- Haga clic en Siguiente paso.

- Introduzca un nombre y una descripción para el proyecto.

- Verifique su configuración en la página Resumen.

Conviene guardar los detalles de la configuración antes de ejecutar el asistente.

- Haga clic en Ejecutar inicio rápido.

Resultados

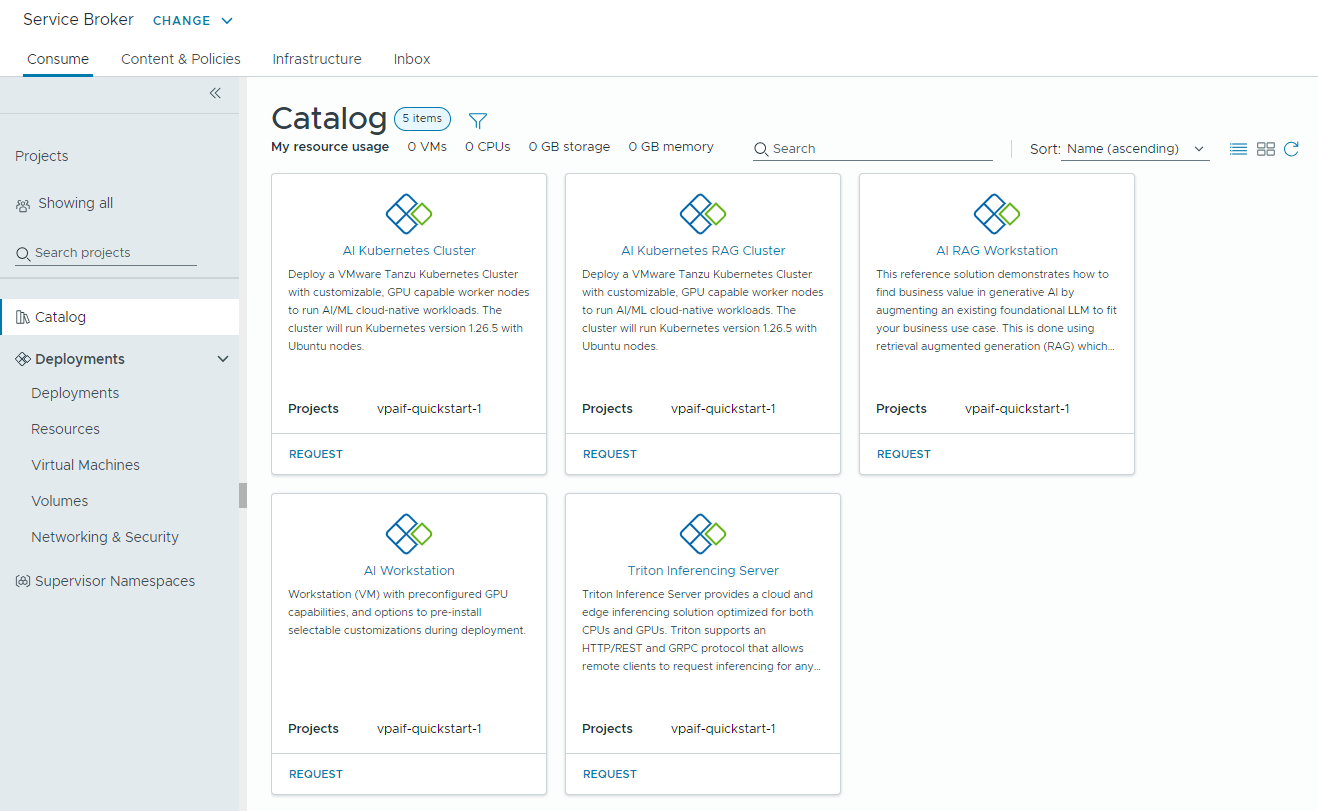

Se crean cinco elementos de catálogo (AI Workstation, AI RAG Workstation, Servidor de inferencias Triton, Clúster de AI Kubernetes y Clúster RAG de Kubernetes AI) en el catálogo de Automation Service Broker y los usuarios de la organización ahora pueden implementarlos.

Qué hacer a continuación

- Compruebe que las plantillas se encuentren disponibles en el catálogo para los miembros de los proyectos seleccionados con quienes compartió el contenido y supervise el proceso de aprovisionamiento para garantizar el éxito de la implementación. Consulte Cómo implementar elementos del catálogo de PAIF.

- Si desea controlar por cuánto tiempo puede existir una implementación, cree una concesión. Consulte Configurar directivas de Automation Service Broker.

- Para modificar las entradas de usuario en el momento de la solicitud, puede crear un formulario personalizado. Consulte Personalizar un icono de Automation Service Broker y un formulario de solicitud.

Solución de problemas

- Si se produce un error en el Asistente de configuración de catálogos, vuelva a ejecutar el asistente para un proyecto diferente.