Un enrutador lógico distribuido (distributed logical router, DLR) es un dispositivo virtual que contiene el plano de control de enrutamiento, a la vez que distribuye el plano de datos de los módulos del kernel en cada host de hipervisor. La función del plano de control del DLR depende de que el clúster de NSX Controller inserte actualizaciones de enrutamiento en los módulos del kernel.

- NSX Data Center for vSphere 6.2 y versiones posteriores permiten conectar interfaces lógicas (LIF) enrutadas mediante enrutadores lógicos a una VXLAN conectada en puente a una VLAN.

- Las interfaces del enrutador lógico y las interfaces puente no pueden conectarse a un dvPortgroup si el identificador de la VLAN está establecido en 0.

- Una instancia de enrutador lógico determinada no puede conectarse a los conmutadores lógicos que existen en zonas de transporte diferentes. El objetivo de esto es garantizar que todas las instancias de conmutadores lógicos y enrutadores lógicos estén alineadas.

- No se puede conectar un enrutador lógico a grupos de puertos respaldados por VLAN si ese enrutador lógico se conecta a conmutadores lógicos que abarcan más de un vSphere Distributed Switch (VDS). Esto garantiza la correcta alineación entre instancias del enrutador lógico con dvPortgroups de conmutadores lógicos en los hosts.

- No deben crearse interfaces de enrutadores lógicos en dos grupos de puertos distribuidos (dvPortgroups) diferentes con el mismo identificador de VLAN si las dos redes están en el mismo conmutador distribuido de vSphere.

- No deben crearse interfaces de enrutadores lógicos en dos dvPortgroups diferentes con el mismo identificador de VLAN si las dos redes están en conmutadores distribuidos de vSphere diferentes, pero los dos conmutadores distribuidos de vSphere comparten los mismos hosts. En otras palabras, pueden crearse interfaces de enrutadores lógicos en dos redes diferentes con el mismo identificador de VLAN si los dos dvPortgroups están en dos conmutadores distribuidos de vSphere diferentes, siempre que los conmutadores distribuidos de vSphere no compartan un host.

- Si se configura VXLAN, las interfaces del enrutador lógico se deben conectar a grupos de puertos distribuidos en el vSphere Distributed Switch donde VXLAN esté configurado. No conecte interfaces de enrutadores lógicos a grupos de puertos en otros vSphere Distributed Switches.

- Se admiten protocolos de enrutamiento dinámico (BGP y OSPF) solo en las interfaces de vínculo superior.

- Las reglas de firewall son aplicables solo en las interfaces de enlace ascendente, y están limitadas al tráfico de control y de administración destinado al dispositivo Edge virtual.

- Para obtener más información sobre la interfaz de administración DLR, consulte el artículo de la base de conocimiento http://kb.vmware.com/kb/2122060 con la guía de interfaz de administración de máquinas virtuales de control DLR para NSX.

Requisitos previos

- Debe tener asignada la función de administrador de Enterprise o administrador de NSX.

- Se debe crear un grupo de identificadores de segmentos local aunque no esté previsto crear conmutadores lógicos.

- Asegúrese de que el clúster de controladores esté en funcionamiento y disponible antes de crear o modificar la configuración del enrutador lógico. Los enrutadores lógicos no pueden distribuir información de enrutamiento a hosts sin la ayuda de los controladores NSX Controller. Los enrutadores lógicos dependen de los controladores NSX Controller para funcionar, mientras que las puertas de enlace de servicios Edge (Edge Services Gateways, ESG) no.

- Si se desea conectar un enrutador lógico a los dvPortgroups de VLAN, asegúrese de que todos los hosts del hipervisor con un dispositivo de enrutador lógico instalado puedan comunicarse entre sí en el puerto UDP 6999. Es necesaria la comunicación en este puerto para que funcione el proxy ARP basado en VLAN del enrutador lógico.

- Determine dónde implementar el dispositivo de enrutador lógico.

- El host de destino debe formar parte de la misma zona de transporte que los conmutadores lógico conectados a las interfaces del nuevo enrutador lógico.

- Evite colocarlo en el mismo host que uno o varios de sus ESG ascendentes si utiliza ESG en una configuración ECMP. Puede utilizar reglas de antiafinidad de DRS para aplicar esta práctica, lo que reducirá el impacto de los errores del host en el reenvío de enrutadores lógicos. Estas instrucciones no se aplican si tiene un ESG ascendente individual o en modo de alta disponibilidad. Para obtener más información, consulte Guía de diseño de virtualización de red de NSX en https://communities.vmware.com/docs/DOC-27683.

- Compruebe que el clúster del host en el que instala el dispositivo del enrutador lógico está preparado para NSX Data Center for vSphere. Consulte cómo preparar el clúster del host para NSX en Guía de instalación de NSX.

Procedimiento

Resultados

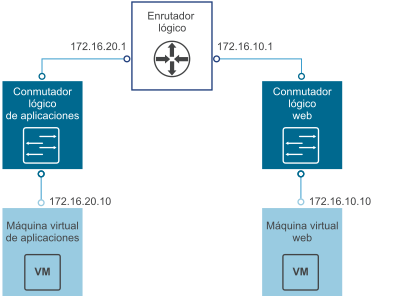

En el siguiente ejemplo de topología, la puerta de enlace predeterminada de la máquina virtual de la aplicación es 172.16.20.1. La puerta de enlace predeterminada de la máquina virtual web es 172.16.10.1. Compruebe que las máquinas virtuales puedan hacer ping en sus puertas de enlace predeterminadas y entre sí.

-

Vea un listado con toda la información de la instancia del enrutador lógico.

nsxmgr-l-01a> show logical-router list all Edge-id Vdr Name Vdr id #Lifs edge-1 default+edge-1 0x00001388 3 -

Vea un listado de los hosts que recibieron información de enrutamiento para el enrutador lógico del clúster de controladores.

nsxmgr-l-01a> show logical-router list dlr edge-1 host ID HostName host-25 192.168.210.52 host-26 192.168.210.53 host-24 192.168.110.53En el resultado se incluyen todos los hosts de todos los clústeres de hosts configurados como miembros de la zona de transporte a la que pertenece el conmutador lógico que está conectado al enrutador lógico especificado (en este ejemplo, edge-1).

-

Vea un listado con la información de la tabla de enrutamiento que se comunica a los hosts mediante el enrutador lógico. Las entradas de la tabla de enrutamiento deben ser coherentes en todos los hosts.

nsx-mgr-l-01a> show logical-router host host-25 dlr edge-1 route VDR default+edge-1 Route Table Legend: [U: Up], [G: Gateway], [C: Connected], [I: Interface] Legend: [H: Host], [F: Soft Flush] [!: Reject] [E: ECMP] Destination GenMask Gateway Flags Ref Origin UpTime Interface ----------- ------- ------- ----- --- ------ ------ --------- 0.0.0.0 0.0.0.0 192.168.10.1 UG 1 AUTO 4101 138800000002 172.16.10.0 255.255.255.0 0.0.0.0 UCI 1 MANUAL 10195 13880000000b 172.16.20.0 255.255.255.0 0.0.0.0 UCI 1 MANUAL 10196 13880000000a 192.168.10.0 255.255.255.248 0.0.0.0 UCI 1 MANUAL 10196 138800000002 192.168.100.0 255.255.255.0 192.168.10.1 UG 1 AUTO 3802 138800000002 -

Vea un listado con información adicional sobre el enrutador desde el punto de vista de uno de los hosts. Este resultado es útil para saber qué controlador se está comunicando con el host.

nsx-mgr-l-01a> show logical-router host host-25 dlr edge-1 verbose VDR Instance Information : --------------------------- Vdr Name: default+edge-1 Vdr Id: 0x00001388 Number of Lifs: 3 Number of Routes: 5 State: Enabled Controller IP: 192.168.110.203 Control Plane IP: 192.168.210.52 Control Plane Active: Yes Num unique nexthops: 1 Generation Number: 0 Edge Active: No

Compruebe el campo Dirección IP de controlador (Controller IP) en el resultado del comando show logical-router host host-25 dlr edge-1 verbose.

-

192.168.110.202 # show control-cluster logical-switches vni 5000 VNI Controller BUM-Replication ARP-Proxy Connections 5000 192.168.110.201 Enabled Enabled 0La salida para VNI 5000 muestra cero conexiones y el controlador 192.168.110.201 como propietaria de VNI 5000. Inicie sesión en ese controlador para recopilar más información de VNI 5000.192.168.110.201 # show control-cluster logical-switches vni 5000 VNI Controller BUM-Replication ARP-Proxy Connections 5000 192.168.110.201 Enabled Enabled 3El resultado en 192.168.110.201 muestra tres conexiones. Compruebe las VNI adicionales.192.168.110.201 # show control-cluster logical-switches vni 5001 VNI Controller BUM-Replication ARP-Proxy Connections 5001 192.168.110.201 Enabled Enabled 3192.168.110.201 # show control-cluster logical-switches vni 5002 VNI Controller BUM-Replication ARP-Proxy Connections 5002 192.168.110.201 Enabled Enabled 3Debido a que 192.168.110.201 es propietaria de las tres conexiones de VNI, se espera ver cero conexiones en el otro controlador 192.168.110.203.192.168.110.203 # show control-cluster logical-switches vni 5000 VNI Controller BUM-Replication ARP-Proxy Connections 5000 192.168.110.201 Enabled Enabled 0 - Antes de comprobar las tablas de MAC y ARP, haga ping de una máquina virtual a la otra.

Desde la máquina virtual de la aplicación a la máquina virtual web:

vmware@app-vm$ ping 172.16.10.10 PING 172.16.10.10 (172.16.10.10) 56(84) bytes of data. 64 bytes from 172.16.10.10: icmp_req=1 ttl=64 time=2.605 ms 64 bytes from 172.16.10.10: icmp_req=2 ttl=64 time=1.490 ms 64 bytes from 172.16.10.10: icmp_req=3 ttl=64 time=2.422 msRevise las tablas de MAC.192.168.110.201 # show control-cluster logical-switches mac-table 5000 VNI MAC VTEP-IP Connection-ID 5000 00:50:56:a6:23:ae 192.168.250.52 7192.168.110.201 # show control-cluster logical-switches mac-table 5001 VNI MAC VTEP-IP Connection-ID 5001 00:50:56:a6:8d:72 192.168.250.51 23Revise las tablas de ARP.192.168.110.201 # show control-cluster logical-switches arp-table 5000 VNI IP MAC Connection-ID 5000 172.16.20.10 00:50:56:a6:23:ae 7

192.168.110.201 # show control-cluster logical-switches arp-table 5001 VNI IP MAC Connection-ID 5001 172.16.10.10 00:50:56:a6:8d:72 23

Revise la información del enrutador lógico. Cada instancia del enrutador lógico se procesa en uno de los nodos del controlador.

El subcomando instance del comando show control-cluster logical-routers muestra un listado de los enrutadores lógicos que están conectados a este controlador.

El subcomando interface-summary muestra un listado de las LIF que el controlador adquirió de NSX Manager. Esta información se envía a los hosts que están en los clústeres de hosts administrados en la zona de transporte.

-

Vea un listado con todos los enrutadores lógicos conectados a este controlador.

controller # show control-cluster logical-routers instance all LR-Id LR-Name Universal Service-Controller Egress-Locale 0x1388 default+edge-1 false 192.168.110.201 localAnote el identificador de LR y utilícelo en el siguiente comando.

-

controller # show control-cluster logical-routers interface-summary 0x1388 Interface Type Id IP[] 13880000000b vxlan 0x1389 172.16.10.1/24 13880000000a vxlan 0x1388 172.16.20.1/24 138800000002 vxlan 0x138a 192.168.10.2/29 -

controller # show control-cluster logical-routers routes 0x1388 Destination Next-Hop[] Preference Locale-Id Source 192.168.100.0/24 192.168.10.1 110 00000000-0000-0000-0000-000000000000 CONTROL_VM 0.0.0.0/0 192.168.10.1 0 00000000-0000-0000-0000-000000000000 CONTROL_VM[root@comp02a:~] esxcfg-route -l VMkernel Routes: Network Netmask Gateway Interface 10.20.20.0 255.255.255.0 Local Subnet vmk1 192.168.210.0 255.255.255.0 Local Subnet vmk0 default 0.0.0.0 192.168.210.1 vmk0 - Muestre las conexiones del controlador a la VNI específica.

192.168.110.203 # show control-cluster logical-switches connection-table 5000 Host-IP Port ID 192.168.110.53 26167 4 192.168.210.52 27645 5 192.168.210.53 40895 6192.168.110.202 # show control-cluster logical-switches connection-table 5001 Host-IP Port ID 192.168.110.53 26167 4 192.168.210.52 27645 5 192.168.210.53 40895 6Estas direcciones IP de hosts son interfaces vmk0, no VTEP. Las conexiones entre hosts y controladores ESXi se crean en la red de administración. Aquí los números de puerto son puertos TCP efímeros que asigna la pila de direcciones IP del host ESXi cuando el host establece una conexión con el controlador.

-

En el host, puede ver la conexión de red del controlador vinculado al número de puerto.

[[email protected]:~] #esxcli network ip connection list | grep 26167 tcp 0 0 192.168.110.53:26167 192.168.110.101:1234 ESTABLISHED 96416 newreno netcpa-worker

-

Muestre las VNI activas en el host. Observe que el resultado es diferente entre los hosts. No todas las VNI están activas en todos los hosts. Una VNI está activa en un host si ese host posee una máquina virtual conectada al conmutador lógico.

[[email protected]:~] # esxcli network vswitch dvs vmware vxlan network list --vds-name Compute_VDS VXLAN ID Multicast IP Control Plane Controller Connection Port Count MAC Entry Count ARP Entry Count VTEP Count -------- ------------------------- ----------------------------------- --------------------- ---------- --------------- --------------- ---------- 5000 N/A (headend replication) Enabled (multicast proxy,ARP proxy) 192.168.110.203 (up) 1 0 0 0 5001 N/A (headend replication) Enabled (multicast proxy,ARP proxy) 192.168.110.202 (up) 1 0 0 0

Nota: Para habilitar el espacio de nombres vxlan en vSphere 6,0 y versiones posteriores, ejecute el comando /etc/init.d/hostd restart.En el caso de conmutadores lógicos en modo híbrido o de unidifusión, el comando esxcli network vswitch dvs vmware vxlan network list --vds-name <vds-name> contiene el siguiente resultado:

- El plano de control está habilitado.

- El proxy de multidifusión y el proxy ARP aparecen en el listado. El proxy AARP aparece en el listado aunque se haya deshabilitado la detección de direcciones IP.

- Una dirección IP de controlador válida aparece en el listado y la conexión está activa.

- Si un enrutador lógico está conectado al host ESXi, el recuento de puertos es al menos 1, incluso si no hay máquinas virtuales en el host conectado al conmutador lógico. Este puerto es vdrPort, que es un puerto dvPort especial conectado al módulo del kernel del enrutador lógico en el host ESXi.

-

En primer lugar, haga ping de una máquina virtual a otra en una subred diferente y, a continuación, muestre la tabla de MAC. Tenga en cuenta que la MAC interna es la entrada de la máquina virtual, mientras que la MAC externa y la dirección IP externa se refieren a la VTEP.

~ # esxcli network vswitch dvs vmware vxlan network mac list --vds-name=Compute_VDS --vxlan-id=5000 Inner MAC Outer MAC Outer IP Flags ----------------- ----------------- -------------- -------- 00:50:56:a6:23:ae 00:50:56:6a:65:c2 192.168.250.52 00000111~ # esxcli network vswitch dvs vmware vxlan network mac list --vds-name=Compute_VDS --vxlan-id=5001 Inner MAC Outer MAC Outer IP Flags ----------------- ----------------- -------------- -------- 02:50:56:56:44:52 00:50:56:6a:65:c2 192.168.250.52 00000101 00:50:56:f0:d7:e4 00:50:56:6a:65:c2 192.168.250.52 00000111

Qué hacer a continuación

Cuando instale un Dispositivo NSX Edge, NSX habilita el encendido o apagado automático de la máquina virtual en el host si vSphere HA está deshabilitado en el clúster. Si posteriormente las máquinas virtuales del dispositivo se migran a otros hosts en el clúster, es posible que los hosts nuevos no tengan habilitada la opción de encendido/apagado automático de la máquina virtual. Por este motivo, cuando instale dispositivos NSX Edge en clústeres que tienen vSphere HA deshabilitado, debe comprobar todos los hosts del clúster para asegurarse de que la opción de encendido o apagado automático de las máquinas virtuales esté habilitada. Consulte la sección sobre cómo editar la configuración de encendido y apagado de la máquina Virtual en Administrar máquinas virtuales de vSphere.

Después de implementar el enrutador lógico, haga doble clic en el identificador del enrutador lógico para configurar opciones adicionales, como interfaces, enrutamiento, firewall, puentes y relé DHCP.