Implementar clústeres de administración con la interfaz del instalador

En este tema se describe cómo utilizar la interfaz del instalador de Tanzu Kubernetes Grid para implementar un clúster de administración en vSphere cuando el supervisor de vSphere with Tanzu no está habilitado, en Amazon Web Services (AWS) y en Microsoft Azure. La interfaz del instalador de Tanzu Kubernetes Grid le guiará por la implementación del clúster de administración y le proporcionará diferentes configuraciones para seleccionarlas o volver a configurarlas. Si es la primera vez que implementa un clúster de administración en una plataforma de destino determinada, se recomienda utilizar la interfaz del instalador, excepto en los casos en los que se indique que debe implementar desde un archivo de configuración.

Requisitos previos

Antes de poder implementar un clúster de administración, debe asegurarse de que el entorno cumpla con los requisitos de la plataforma de destino.

Requisitos previos generales

- Asegúrese de haber cumplido todos los requisitos y de haber seguido todos los procedimientos descritos en Instalar la CLI de Tanzu y otras herramientas para su uso con clústeres de administración independiente.

-

Para las implementaciones de producción, se recomienda enfáticamente habilitar la administración de identidades para sus clústeres. Para obtener información sobre los pasos de preparación que se deben realizar antes de implementar un clúster de administración, consulte Obtener los detalles del proveedor de identidades en Configurar la administración de identidades.

-

Si va a implementar clústeres en un entorno restringido por Internet para vSphere o AWS, también debe realizar los pasos descritos en Preparar un entorno rentorno con acceso a Internet restringido. Estos pasos incluyen configurar

TKG_CUSTOM_IMAGE_REPOSITORYcomo una variable de entorno.

Requisitos previos de infraestructura

Cada plataforma de destino tiene requisitos previos adicionales para la implementación del clúster de administración.

- vSphere

-

Asegúrese de que cumple todos los requisitos enumerados en

Preparar para implementar clústeres de administración en vSphere.

Nota

En vSphere with Tanzu en vSphere 8, no es necesario implementar un clúster de administración. Consulte El supervisor de vSphere with Tanzu es un clúster de administración.

- AWS

-

- Asegúrese de que cumple todos los requisitos enumerados en Preparar para implementar clústeres de administración en AWS.

- Para obtener información sobre las configuraciones de los diferentes tamaños de las instancias de nodo, por ejemplo,

t3.largeot3.xlarge, consulte Tipos de instancia de Amazon EC2. - Para obtener información sobre los recursos de VPC y NAT que utiliza Tanzu Kubernetes Grid, consulte Uso de recursos en la cuenta de Amazon Web Services.

- Azure

-

- Asegúrese de que cumple todos los requisitos enumerados en Preparar para implementar clústeres de administración en Microsoft Azure.

- Para obtener información sobre las configuraciones de los diferentes tamaños de las instancias de nodo para Azure, por ejemplo,

Standard_D2s_v3oStandard_D4s_v3, consulte Tamaños de las máquinas virtuales en Azure.

Iniciar la interfaz del instalador de

De forma predeterminada, Tanzu Kubernetes Grid guarda kubeconfig para todos los clústeres de administración en el archivo ~/.kube-tkg/config. Si desea guardar el archivo kubeconfig del clúster de administración en una ubicación diferente, establezca la variable de entorno KUBECONFIG antes de ejecutar tanzu mc create.

-

En el equipo en el que descargó e instaló la CLI de Tanzu, ejecute el comando

tanzu mc createcon la opción--ui:tanzu management-cluster create --uiSi se cumplen los requisitos previos, la interfaz del instalador se iniciará en un navegador y le guiará por los pasos necesarios para configurar el clúster de administración.

Precaución

El comando

tanzu mc createtarda en completarse. Mientras se ejecutatanzu mc create, no ejecute invocaciones adicionales detanzu mc createen la misma máquina de arranque para implementar varios clústeres de administración, cambiar el contexto o editar~/.kube-tkg/config.En la siguiente sección Opciones de la interfaz del instalador se explica cómo se puede cambiar la ubicación en la que se ejecuta la interfaz del instalador, incluida la ejecución en un equipo diferente de la CLI de Tanzu.

-

Haga clic en el botón Implementar para VMware vSphere, Amazon EC2 o Microsoft Azure.

Opciones de la interfaz del instalador

De forma predeterminada, tanzu mc create --ui abre la interfaz del instalador de forma local en http://127.0.0.1:8080 del navegador predeterminado. Puede usar las opciones --browser y --bind para controlar dónde se ejecuta la interfaz del instalador:

--browserespecifica el explorador local en el que se abrirá la interfaz.- Los valores admitidos son

chrome,firefox,safari,ie,edgeonone. - Utilice

nonecon--bindpara ejecutar la interfaz en una máquina diferente, como se describe a continuación.

- Los valores admitidos son

-

--bindespecifica la dirección IP y el puerto desde los que se atenderá la interfaz.Precaución

El servicio a la interfaz del instalador desde una dirección IP y un puerto no predeterminados podría exponer la CLI de Tanzu a un riesgo potencial de seguridad mientras se ejecuta la interfaz. VMware recomienda transferir a la opción

–binduna dirección IP y un puerto en una red segura.

Los casos prácticos de --browser y --bind incluyen:

- Si otro proceso ya está utilizando

http://127.0.0.1:8080, utilice--bindpara prestar servicio a la interfaz desde un puerto local diferente. - Para que la interfaz del instalador aparezca localmente si está realizando un túnel SSH en la máquina de arranque o reenviando X11 a su pantalla, es posible que deba usar

--browser none. -

Para ejecutar la CLI de Tanzu y crear clústeres de administración en un equipo remoto, y ejecutar la interfaz del instalador de forma local o en otro lugar:

-

En la máquina de arranque remota, ejecute

tanzu mc create --uicon las siguientes opciones y valores:--bind: una dirección IP y un puerto para la máquina remota--browser:none

tanzu mc create --ui --bind 192.168.1.87:5555 --browser none -

En el equipo de la interfaz de usuario local, desplácese hasta la dirección IP del equipo remoto para acceder a la interfaz del instalador.

-

Configurar la plataforma de destino

Las opciones para configurar la plataforma de destino dependen del proveedor que utilice.

- vSphere

-

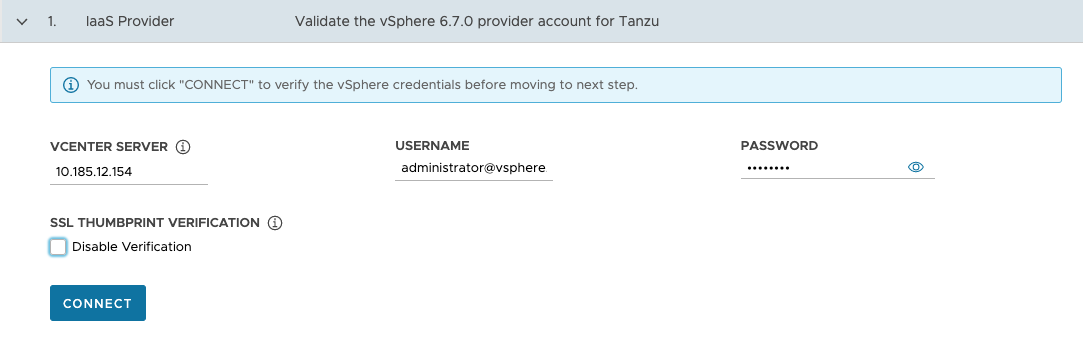

Configure la conexión a la instancia de vSphere.

-

En la sección proveedor de IaaS, introduzca la dirección IP o el nombre de dominio completo (FQDN) de la instancia de vCenter Server en la que se implementará el clúster de administración.

La compatibilidad con direcciones IPv6 en Tanzu Kubernetes Grid es limitada; consulte Implementar clústeres en IPv6 (solo vSphere). Si no va a implementar en un entorno de redes solo IPv6, debe proporcionar direcciones IPv4 en los siguientes pasos.

-

Introduzca el nombre de usuario y la contraseña del vCenter Single Sign-On para una cuenta de usuario que tenga los privilegios necesarios para la operación de Tanzu Kubernetes Grid.

El nombre de la cuenta debe incluir el dominio, por ejemplo,

[email protected].

-

(Opcional) En Verificación por huella digital de SSL, seleccione Deshabilitar verificación. Si selecciona esta casilla de verificación, el instalador omite la verificación por huella digital de certificado al conectarse al vCenter Server.

-

Haga clic en Conectar (Connect).

-

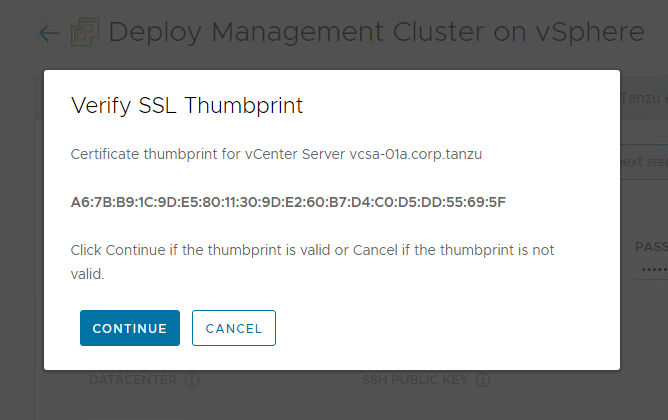

Compruebe la huella digital SSL del certificado de vCenter Server y haga clic en Continuar si es válida. Esta pantalla aparece solo si la casilla Deshabilitar verificación disponible arriba está desmarcada.

Para obtener información sobre cómo obtener la huella digital del certificado de vCenter Server, consulte Obtener huellas digitales de certificado vSphere.

-

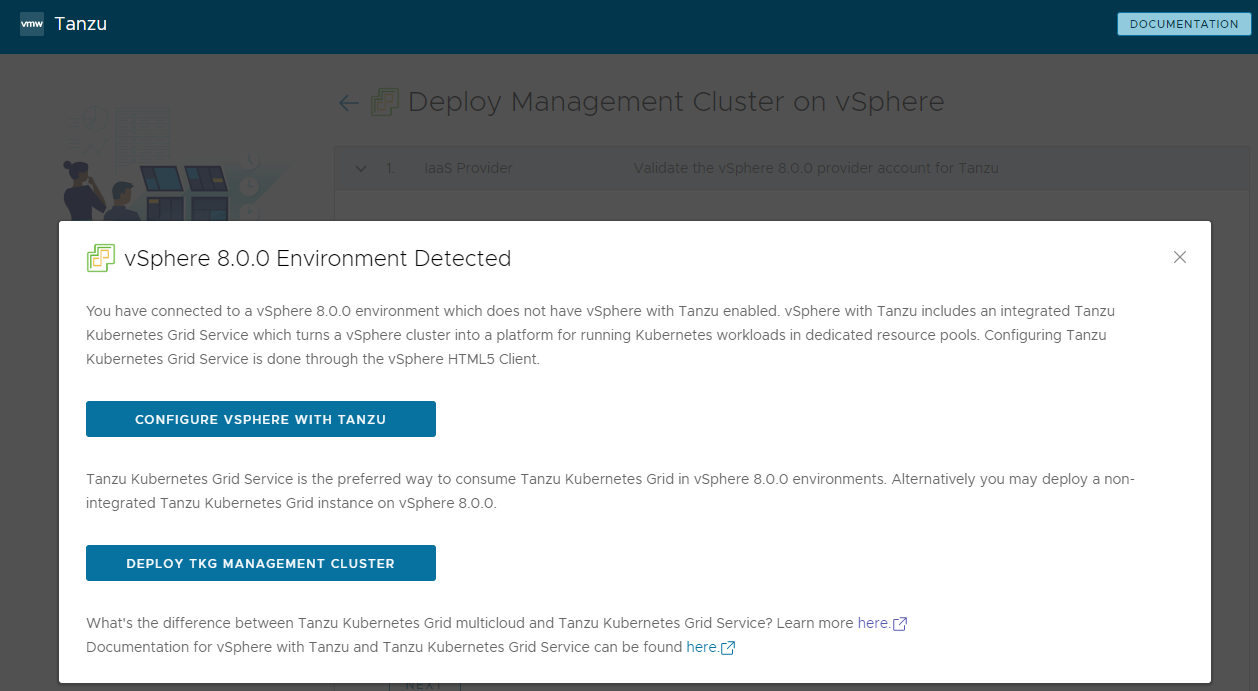

Si va a implementar un clúster de administración en una instancia de vSphere 7 o vSphere 8, confirme si desea continuar con la implementación.

En vSphere 7 y vSphere 8, vSphere with Tanzu ofrece un supervisor integrado que funciona como clúster de administración y proporciona una mejor experiencia que un clúster de administración independiente. Se admite la implementación de un clúster de administración de Tanzu Kubernetes Grid en vSphere 7 o vSphere 8 cuando el supervisor no está presente, pero la opción preferida es habilitar vSphere with Tanzu y utilizar el supervisor si es posible. Azure VMware Solution no admite un clúster supervisor, por lo que debe implementar un clúster de administración.

Para obtener información, consulte El supervisor de vSphere with Tanzu es un clúster de administración en Crear y administrar clústeres de carga de trabajo de TKG 2.1 con la CLI de Tanzu.

Para reflejar la recomendación de usar vSphere with Tanzu al implementar en vSphere 7 y vSphere 8, el instalador de Tanzu Kubernetes Grid se comporta de la siguiente manera:

- Si vSphere with Tanzu está habilitado, el instalador le informa de que no es posible implementar un clúster de administración y se cierra.

- Si vSphere with Tanzu no está habilitado, el instalador le informa de que es posible implementar un clúster de administración Tanzu Kubernetes Grid, pero no se recomienda, y presenta una opción:

- Configurar vSphere with Tanzu (Configure vSphere with Tanzu) abre el vSphere Client para que pueda configurar el supervisor como se describe en Configurar y administrar un supervisor en la documentación de vSphere 8.

- Implementar clúster de administración de TKG (Deploy TKG Management Cluster) permite seguir implementando un clúster de administración, para vSphere 7 o vSphere 8, y según sea necesario para Azure VMware Solution. Al utilizar vSphere 8, la opción preferida es habilitar vSphere with Tanzu y utilizar el supervisor integrado en lugar de implementar un clúster de administración Tanzu Kubernetes Grid.

-

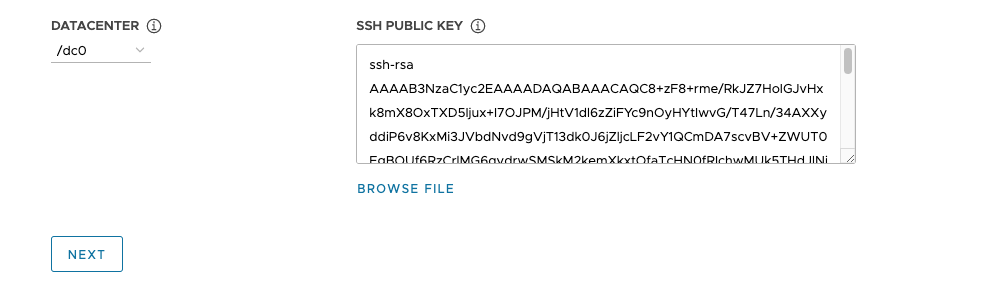

Seleccione el centro de datos en el que desea implementar el clúster de administración en el menú desplegable Centro de datos.

-

Agregue la clave pública SSH. Para agregar la clave pública SSH, utilice la opción Buscar archivo o pegue manualmente el contenido de la clave en el cuadro de texto. Haga clic en Siguiente.

-

- AWS

-

Configure la conexión a la cuenta de AWS.

-

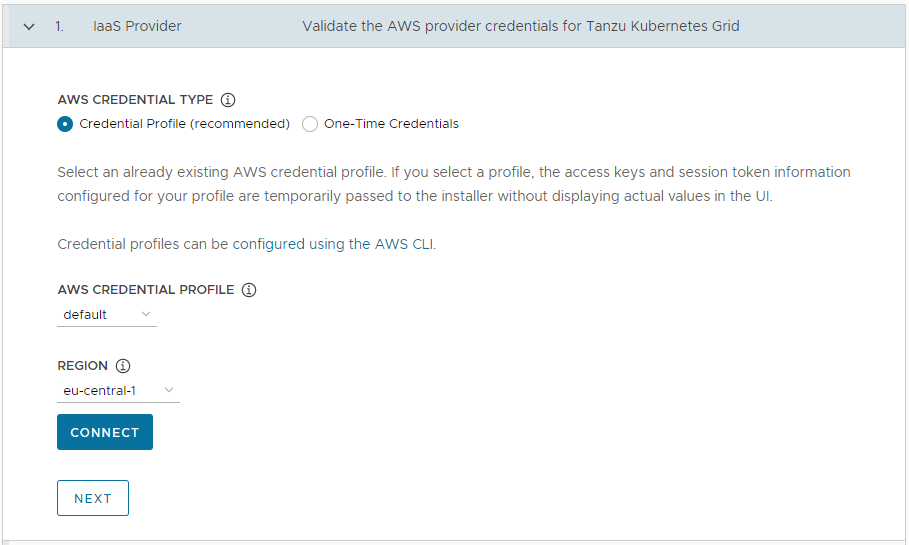

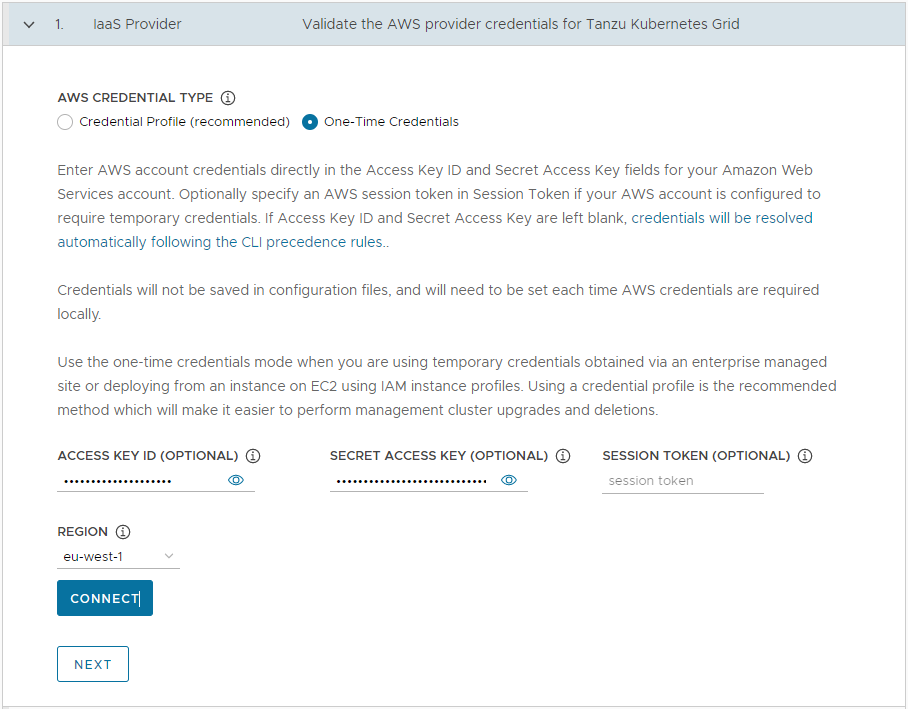

En la sección Proveedor de IaaS, seleccione cómo proporcionar las credenciales de la cuenta de AWS. Tiene dos opciones:

-

Perfil de credenciales (recomendado): Seleccione un perfil de credenciales de AWS ya existente. Si selecciona un perfil, la clave de acceso y la información del token de sesión configurados para el perfil se transfieren al instalador sin mostrar los valores reales en la interfaz de usuario. Para obtener información sobre cómo configurar perfiles de credenciales, consulte Archivos y perfiles específicos.

-

Credenciales de un solo uso: Introduzca las credenciales de la cuenta de AWS directamente en los campos identificador de clave de acceso y Clave de acceso secreta de su cuenta de AWS. De forma opcional, especifique un token de sesión de AWS en Token de sesión si la cuenta de AWS está configurada para requerir credenciales temporales. Para obtener más información sobre la adquisición de tokens de sesión, consulte Usar credenciales temporales con recursos de AWS.

-

-

En Region, seleccione la región de AWS en la que desea implementar el clúster de administración.

Si pretende implementar un clúster de administración de producción, esta región debe tener al menos tres zonas de disponibilidad.

- Haga clic en Conectar (Connect). Si la conexión se realiza correctamente, haga clic en Siguiente (Next).

-

En la sección VPC para AWS (VPC for AWS), seleccione el VPC ID (ID de VPC) en el menú desplegable. El bloque VPC CIDR se rellena automáticamente cuando se selecciona la VPC. Si va a implementar el clúster de administración en un entorno con acceso a Internet restringido, como un entorno con proxy o aislado, seleccione la casilla de verificación Esta no es una VPC con conexión a Internet.

-

- Azure

-

Configure la conexión a su cuenta de Microsoft Azure.

Importante

Si es la primera vez que implementa un clúster de administración en Azure con una nueva versión de Tanzu Kubernetes Grid, por ejemplo, v2.1.1, asegúrese de haber aceptado la licencia de imagen base para esa versión. Para obtener información, consulte Aceptar la licencia de imagen base en Preparar para implementar clústeres de administración en Microsoft Azure.

-

En la sección Proveedor de IaaS, introduzca los valores identificador de tenant, identificador de cliente e identificador de suscripción para su cuenta de Azure. Registró estos valores cuando registró una aplicación de Azure y creó un secreto para ella mediante el portal de Azure.

- Seleccione el entorno de Azure, ya sea Nube pública o Nube gubernamental de Estados Unidos. Para especificar otros entornos, implemente desde un archivo de configuración y configure

AZURE_ENVIRONMENT. - Haga clic en Conectar (Connect). El instalador comprueba la conexión y cambia la etiqueta del botón a Conectado.

- Seleccione la región de Azure en la que desea implementar el clúster de administración.

-

Pegue el contenido de la clave pública SSH, como

.ssh/id_rsa.pub, en el cuadro de texto. -

En Grupo de recursos, seleccione el botón de opción Seleccionar un grupo de recursos existente o el botón de opción Crear un nuevo grupo de recursos.

-

Si selecciona Seleccionar un grupo de recursos existente, utilice el menú desplegable para seleccionar el grupo y, a continuación, haga clic en Siguiente.

-

Si selecciona Crear un nuevo grupo de recursos, introduzca un nombre para el nuevo grupo de recursos y, a continuación, haga clic en Siguiente.

-

-

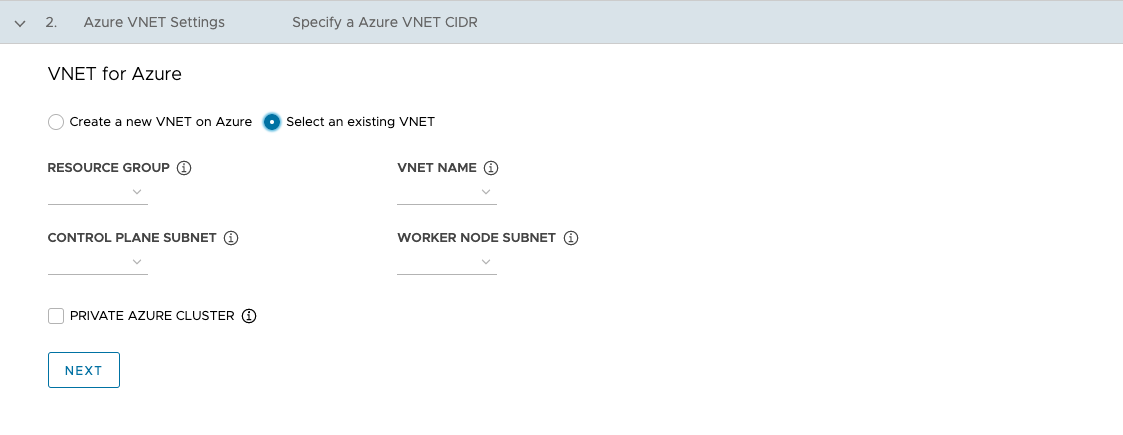

En la sección VNet para Azure, seleccione el botón de opción Crear una nueva VNet en Azure o el botón de opción Seleccionar una VNet existente.

-

Si selecciona Crear una nueva VNet en Azure, utilice el menú desplegable para seleccionar el grupo de recursos en el que se creará la VNet y proporcione lo siguiente:

- Un nombre y un bloque CIDR para la VNet. El valor predeterminado es

10.0.0.0/16. - Un nombre y un bloque CIDR para la subred del plano de control. El valor predeterminado es

10.0.0.0/24. - Un nombre y un bloque CIDR para la subred del nodo de trabajo. El valor predeterminado es

10.0.1.0/24.

Después de configurar estos campos, haga clic en Siguiente.

- Un nombre y un bloque CIDR para la VNet. El valor predeterminado es

-

Si selecciona Seleccionar una VNet existente, utilice los menús desplegables para seleccionar el grupo de recursos en el que se encuentra la VNet, el nombre de la VNet, el plano de control y las subredes del nodo de trabajo y, a continuación, haga clic en Siguiente.

-

Para que el clúster de administración sea privado, como se describe en Clústeres privados de Azure, habilite la casilla de verificación Clúster privado de Azure.

-

-

Configurar los ajustes del clúster de administración

Algunas de las opciones para configurar el clúster de administración dependen del proveedor que utilice.

-

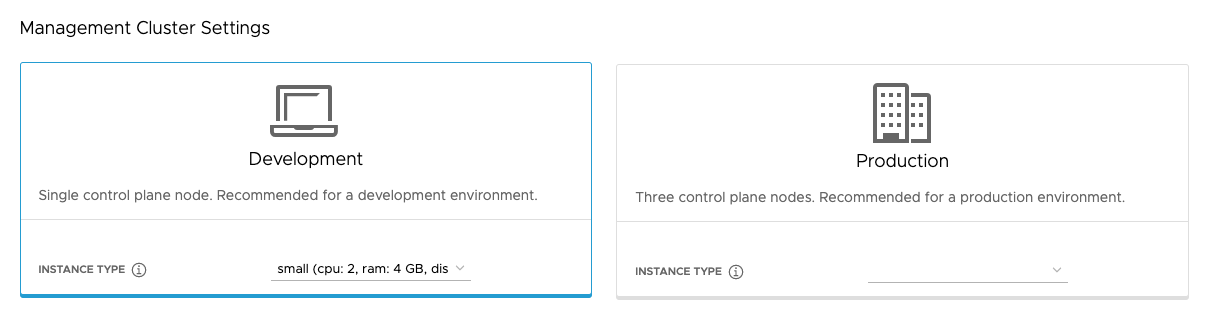

En la sección Configuración del clúster de administración, seleccione la ficha Desarrollo o Producción.

- Si selecciona Desarrollo, el instalador implementa un clúster de administración con un solo nodo de plano de control y un solo nodo de trabajo.

- Si selecciona Producción, el instalador implementa un clúster de administración de alta disponibilidad con tres nodos de plano de control y tres nodos de trabajo.

-

En cualquiera de las fichas Desarrollo o Producción, utilice el menú desplegable Tipo de instancia para seleccionar entre diferentes combinaciones de CPU, RAM y almacenamiento para las máquinas virtuales o las máquinas virtuales del nodo de plano de control.

Elija la configuración de las máquinas virtuales del nodo de plano de control en función de las cargas de trabajo esperadas que se ejecutarán. Por ejemplo, algunas cargas de trabajo pueden requerir una gran capacidad informática, pero relativamente poco almacenamiento, mientras que otras pueden requerir una gran cantidad de almacenamiento y menos capacidad informática. Si selecciona un tipo de instancia en la ficha Producción, el tipo de instancia que seleccionó se selecciona automáticamente para el Tipo de instancia del nodo de trabajo. Si es necesario, puede cambiar esta opción.

Si tiene pensado registrar el clúster de administración con Tanzu Mission Control, asegúrese de que los clústeres de carga de trabajo cumplan los requisitos enumerados en Requisitos para registrar un clúster de Tanzu Kubernetes con Tanzu Mission Control en la documentación de Tanzu Mission Control.

- vSphere

- Seleccione un tamaño de las configuraciones predefinidas de CPU, memoria y almacenamiento. La configuración mínima es de 2 CPU y 4 GB de memoria.

- AWS

- Seleccione un tamaño de instancia. El menú desplegable muestra las opciones alfabéticamente, no por tamaño. La configuración mínima es de 2 CPU y 8 GB de memoria. La lista de tipos de instancia compatibles varía según las diferentes regiones. Para obtener información sobre la configuración de los diferentes tamaños de las instancias, consulte Tipos de instancia de Amazon EC2.

- Azure

- Seleccione un tamaño de instancia. La configuración mínima es de 2 CPU y 8 GB de memoria. La lista de tipos de instancia compatibles varía según las diferentes regiones. Para obtener información sobre las configuraciones de los diferentes tamaños de las instancias de nodo para Azure, consulte Tamaños de las máquinas virtuales en Azure.

-

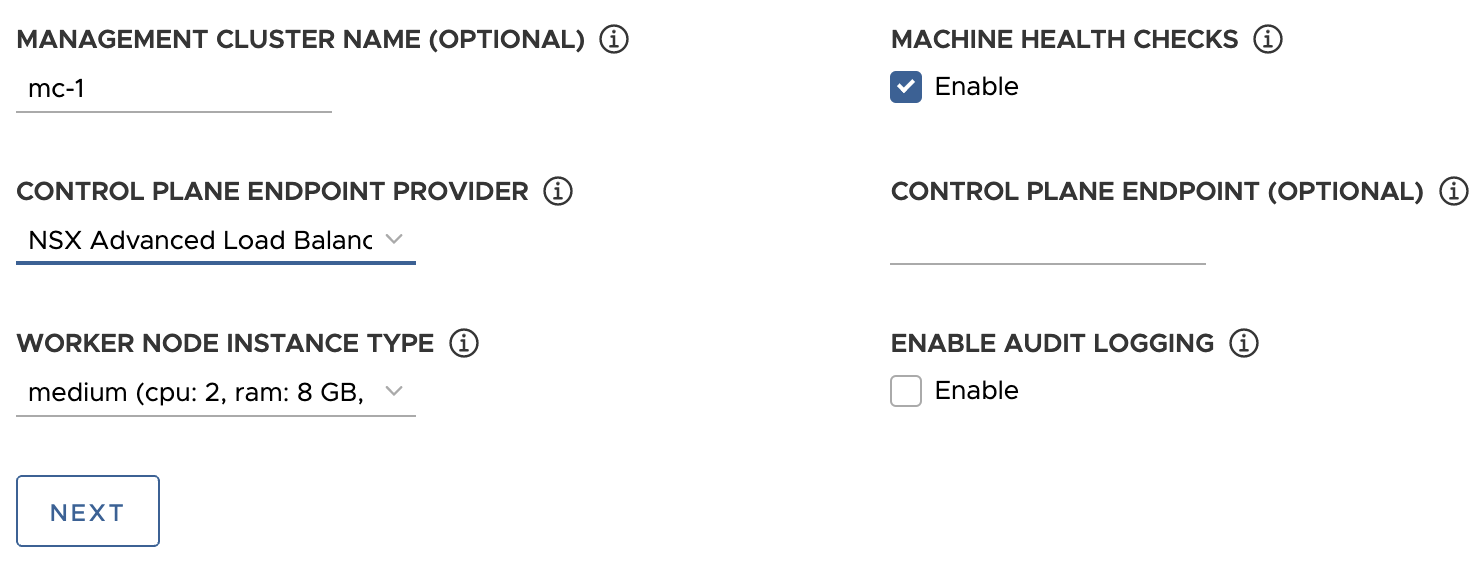

Opcionalmente, introduzca un nombre para el clúster de administración.

Si no especifica un nombre, Tanzu Kubernetes Grid genera automáticamente un nombre único. Si especifica un nombre, ese nombre debe terminar con una letra, no un carácter numérico, y debe cumplir con los requisitos de nombre de host de DNS, como se describe en RFC 952 y se modificó en RFC 1123.

-

(Opcional) Seleccione la casilla de verificación Comprobaciones de estado de la máquina (Machine Health Checks) si desea activar

MachineHealthCheck. Puede activar o desactivarMachineHealthChecken clústeres después de la implementación mediante la CLI. Para obtener instrucciones, consulte Configurar comprobaciones de estado de máquinas para clústeres de carga de trabajo. -

(Opcional) Seleccione la casilla de Habilitar el registro de auditoría para registrar las solicitudes realizadas al servidor de API de Kubernetes. Para obtener más información, consulte Registros de auditoría.

-

Configure ajustes adicionales específicos de su plataforma de destino.

- vSphere

-

Configure los ajustes específicos de vSphere.

- En Tipo de instancia de nodo de trabajo, seleccione la configuración de la máquina virtual del nodo de trabajo.

-

En Proveedor de endpoints del plano de control, seleccione Kube-Vip o NSX Advanced Load Balancer para elegir el componente que se utilizará para el servidor de API del plano de control.

Para utilizar NSX Advanced Load Balancer, primero debe implementarlo en el entorno de vSphere. Para obtener información, consulte Instalar NSX Advanced Load Balancer. Para obtener más información sobre las ventajas de usar NSX Advanced Load Balancer como proveedor del endpoint del plano de control, consulte Configurar NSX Advanced Load Balancer.

-

En Endpoint del plano de control, introduzca una dirección IP virtual estática o un FQDN para las solicitudes de API al clúster de administración. Esta opción es obligatoria si utiliza Kube-Vip.

Asegúrese de que esta dirección IP no esté en el rango de DHCP, sino en la misma subred que el rango de DHCP. Si asignó un FQDN a la dirección VIP, puede especificar el FQDN en lugar de la dirección VIP. Para obtener más información, consulte VIP y equilibradores de carga estáticos para vSphere.

Si utiliza NSX Advanced Load Balancer como proveedor de endpoint del plano de control, la VIP se asigna automáticamente desde el grupo de direcciones IP estáticas de NSX Advanced Load Balancer.

- AWS

-

Configurar los ajustes específicos de AWS.

-

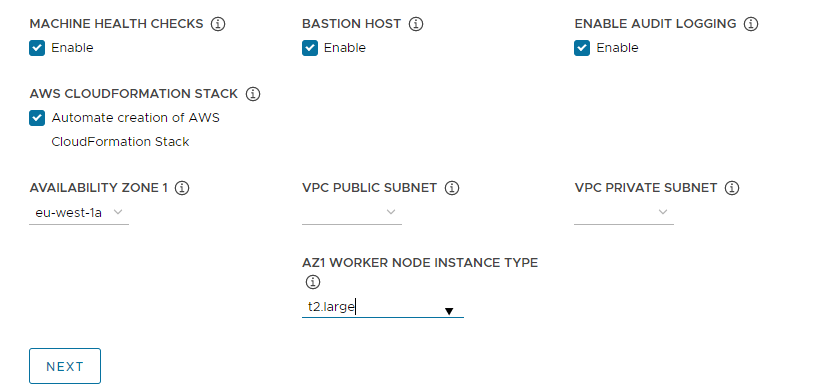

En Par de claves de EC2, especifique el nombre de un par de claves de AWS que ya esté registrado en su cuenta de AWS y en la región en la que va a implementar el clúster de administración. Es posible que lo haya configurado en Configurar credenciales de cuenta de AWS y clave SSH.

-

(Opcional) Desactive la casilla Host bastión si ya existe un host bastión en las zonas de disponibilidad en las que va a implementar el clúster de administración.

Si deja esta opción habilitada, Tanzu Kubernetes Grid crea un host bastión por usted.

-

Si es la primera vez que implementa un clúster de administración en esta cuenta de AWS, seleccione la casilla de verificación Creación automática de la pila de AWS CloudFormation.

Esta pila de CloudFormation crea los recursos de administración de identidades y acceso (IAM) que Tanzu Kubernetes Grid necesita para implementar y ejecutar clústeres en AWS. Para obtener más información, consulte Permisos establecidos por Tanzu Kubernetes Grid en Preparar para implementar clústeres de administración en AWS.

-

Configurar zonas de disponibilidad:

-

En el menú desplegable Zona de disponibilidad 1, seleccione una zona de disponibilidad para el clúster de administración. Solo puede seleccionar una zona de disponibilidad si seleccionó la ficha Desarrollo. Vea la imagen siguiente.

-

En el menú desplegable Tipo de instancia del nodo de trabajo de AZ1, seleccione la configuración de la máquina virtual del nodo de trabajo en la lista de instancias de que están disponibles en esta zona de disponibilidad.

-

Si seleccionó la ficha Producción anteriormente, utilice los menús desplegables Zona de disponibilidad 2, Zona de disponibilidad 3 y Tipo de instancia del nodo de trabajo para seleccionar tres zonas de disponibilidad únicas para el clúster de administración.

Cuando Tanzu Kubernetes Grid implementa el clúster de administración, que incluye tres nodos de plano de control y tres nodos de trabajo, distribuye los nodos de plano de control y los nodos de trabajo entre estas zonas de disponibilidad.

-

Utilice los menús desplegables (Subred pública de la VPC) VPC public subnet y Subred privada de la VPC (VPC private subnet) para seleccionar subredes en la VPC.

Si va a implementar un clúster de administración de producción, seleccione subredes para las tres zonas de disponibilidad. Las subredes públicas no están disponibles si seleccionó Esta no es una VPC con conexión a Internet en la sección anterior. La imagen siguiente muestra la ficha Desarrollo (Development).

-

-

- Azure

- En Tipo de instancia de nodo de trabajo, seleccione la configuración de la máquina virtual del nodo de trabajo.

-

Haga clic en Siguiente.

Configurar VMware NSX Advanced Load Balancer

La configuración de NSX Advanced Load Balancer solo se aplica a las implementaciones de vSphere.

- vSphere

-

VMware NSX Advanced Load Balancer (ALB) proporciona una solución de equilibrio de carga L4+L7 para vSphere. NSX ALB incluye un operador de Kubernetes que se integra con la API de Kubernetes para administrar el ciclo de vida de los recursos de equilibrio de carga y de entrada de las cargas de trabajo. Para utilizar NSX ALB, primero debe implementarlo en el entorno de vSphere. Para obtener información, consulte

Instalar NSX Advanced Load Balancer.

Importante

En vSphere 8, para utilizar NSX Advanced Load Balancer con un clúster de administración independiente de TKG y sus clústeres de carga de trabajo, necesita NSX ALB v22.1.2 o una versión posterior y TKG v2.1.1 o una versión posterior.

En la sección de VMware NSX Advanced Load Balancer opcional, puede configurar Tanzu Kubernetes Grid para que usen NSX Advanced Load Balancer. De forma predeterminada, todos los clústeres de carga de trabajo utilizarán el equilibrador de carga.

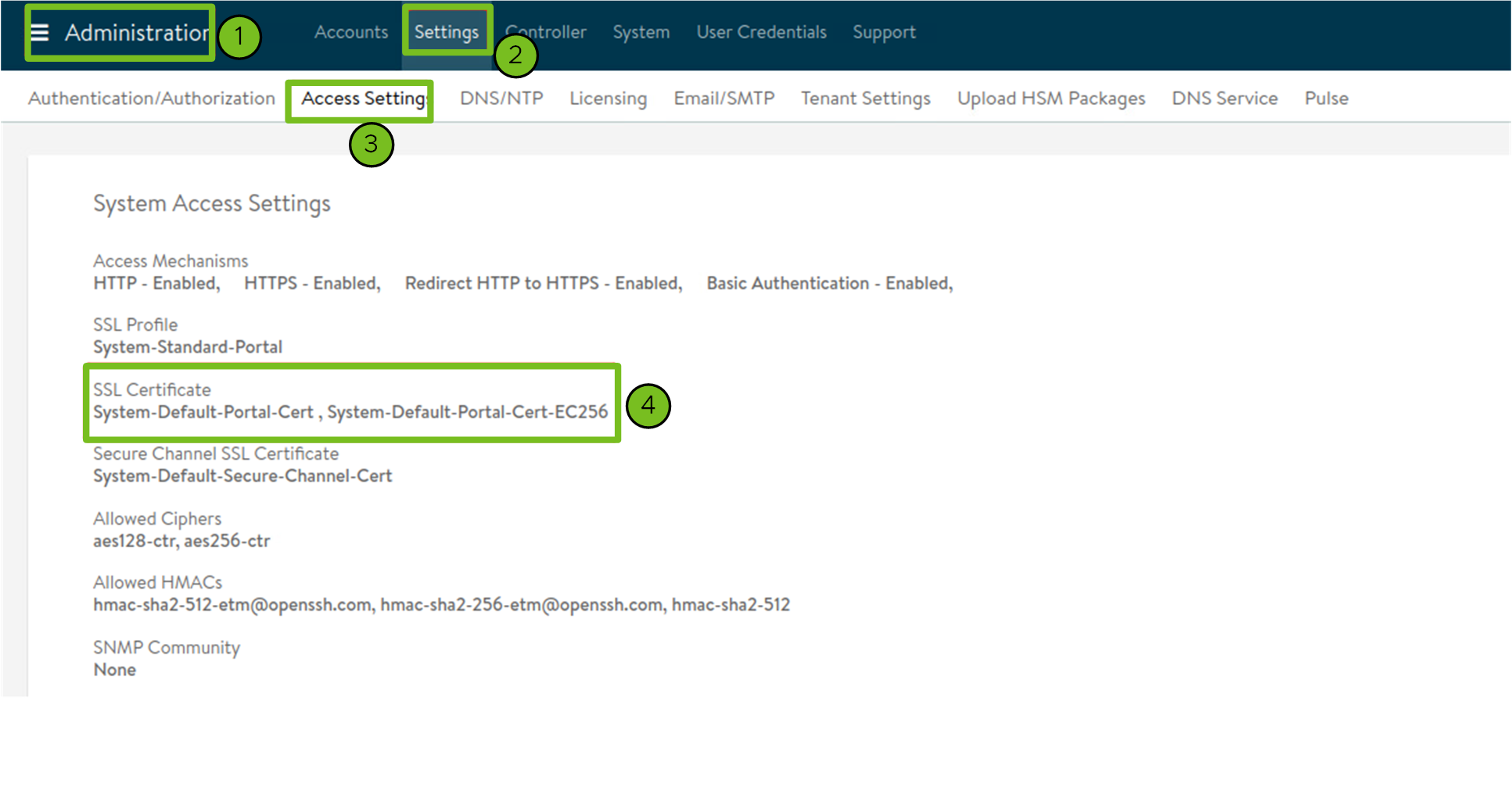

- Para el host controlador, introduzca la dirección IP o el FQDN de la máquina virtual del controlador.

- Introduzca el nombre de usuario y la contraseña que estableció para el host del controlador cuando lo implementó.

-

Pegue el contenido de la entidad de certificación que se utiliza para generar el certificado del controlador en el cuadro de texto Autoridad de controlador y haga clic en Verificar credenciales.

El contenido del certificado comienza con

-----BEGIN CERTIFICATE-----.Si tiene un certificado de controlador autofirmado, debe usar un certificado SSL/TLS que esté configurado en la pestaña Interfaz de usuario del controlador AVI > Administración > Configuración > Configuración de acceso, en Configuración de acceso del sistema > Certificado SSL. Puede recuperar el contenido del certificado como se describe en Configuración del controlador Avi: Certificado personalizado.

-

Utilice el menú desplegable Nombre de nube para seleccionar la nube que creó en la implementación de NSX Advanced Load Balancer.

Por ejemplo,

Default-Cloud. -

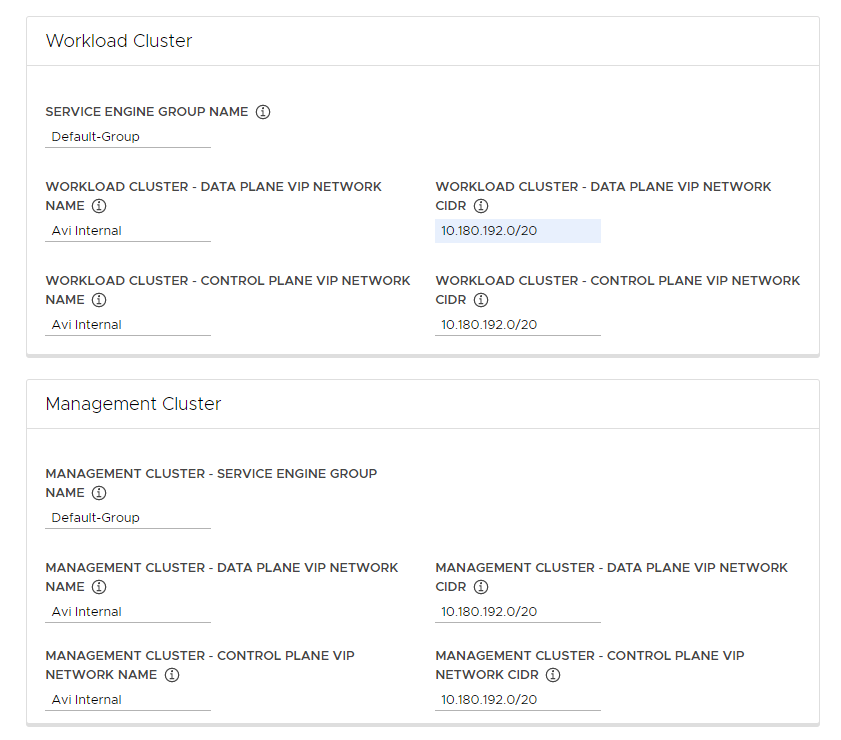

En la sección Clúster de carga de trabajo (Workload Cluster) y Clúster de administración (Management Cluster), utilice el menú desplegable Nombre del grupo de motores de servicio (Service Engine Group Name) para seleccionar un grupo de motores de servicio.

Por ejemplo,

Default-Group. -

En el menú desplegable Cluster - Data Plane VIP Network Name (Clúster de carga de trabajo: nombre de red VIP del plano de datos), seleccione el nombre de la red en la que reside el grupo de direcciones IP flotantes del equilibrador de carga.

La misma red se selecciona automáticamente para que la utilicen los planos de datos y control de los clústeres de carga de trabajo y los clústeres de administración. Puede cambiarlos si es necesario.

La red VIP para NSX ALB debe estar presente en la misma instancia de vCenter Server que la red de Kubernetes que utiliza Tanzu Kubernetes Grid. Esto permite a NSX Advanced Load Balancer detectar la red de Kubernetes en vCenter Server, así como implementar y configurar motores de servicio.

Puede ver red en la vista Infraestructura > Redes de la interfaz de NSX Advanced Load Balancer.

-

En los menús desplegables Clúster de carga de trabajo: CIDR de red VIP del plano de datos (Workload Cluster - Data Plane VIP Network CIDR) y Clúster de carga de trabajo: CIDR de red VIP del plano de control (Workload Cluster - Control Plane VIP Network CIDR), seleccione o introduzca el CIDR de la subred que se utilizará para la VIP del equilibrador de carga, para que lo utilicen los planos de datos y control de los clústeres de carga de trabajo y los clústeres de administración.

Esto proviene de una de las subredes configuradas de la red VIP. Puede ver el CIDR de subred de una red en particular en la vista Infraestructura > Redes de la interfaz de NSX Advanced Load Balancer. Los mismos CIDR se aplican automáticamente en la configuración del clúster de administración correspondiente. Puede cambiarlos si es necesario.

-

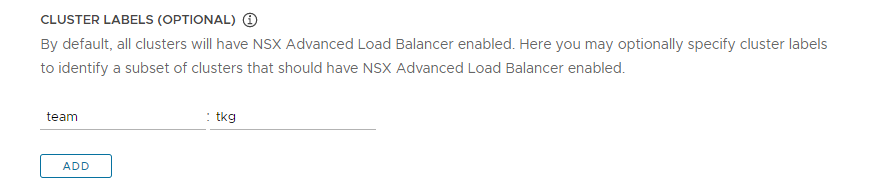

(Opcional) Introduzca una o varias etiquetas de clúster para identificar los clústeres en los que se habilitarán selectivamente NSX ALB o para personalizar la configuración de NSX ALB para diferentes grupos de clústeres.

De forma predeterminada, NSX Advanced Load Balancer está habilitado en todos los clústeres de carga de trabajo implementados con este clúster de administración, y los clústeres comparten el mismo controlador de VMware NSX Advanced Load Balancer, la nube, el grupo de motores de servicio y la misma red VIP. Esto no se puede cambiar posteriormente.

De forma opcional, puede habilitar NSX ALB solo en un subconjunto de clústeres o conservar la capacidad de personalizar más adelante la configuración de NSX ALB para diferentes grupos de clústeres. Esto resulta útil en los siguientes escenarios:

- Desea configurar diferentes conjuntos de clústeres de carga de trabajo en diferentes grupos de motores de servicio para implementar el aislamiento o para admitir más equilibradores de carga de tipo Servicio que la capacidad de un grupo de motores de servicio.

- Desea configurar diferentes conjuntos de clústeres de carga de trabajo en diferentes nubes, ya que se implementan en sitios separados.

Para habilitar NSX ALB de forma selectiva en lugar de globalmente, agregue etiquetas con el formato

key: value. Las etiquetas que defina aquí se utilizarán para crear un selector de etiquetas. Solo los objetosClusterdel clúster de carga de trabajo que tienen las etiquetas coincidentes tendrán habilitado el equilibrador de carga. Como consecuencia, es responsable de asegurarse de que el objetoClusterdel clúster de carga de trabajo tenga las etiquetas correspondientes.Por ejemplo, si utiliza

team: tkg, para habilitar el equilibrador de carga de trabajo en un clúster de carga de trabajo:-

Establezca

kubectlen el contexto del clúster de administración.kubectl config use-context management-cluster@admin -

Etiquete el objeto

Clusterdel clúster de carga de trabajo correspondiente con las etiquetas definidas. Si define varios valores de clave, debe aplicarlos todos.kubectl label cluster <cluster-name> team=tkg

-

Haga clic en Siguiente para configurar los metadatos.

- AWS

- Tanzu Kubernetes Grid on AWS crea automáticamente un equilibrador de carga cuando se implementa un clúster de administración.

- Azure

- Tanzu Kubernetes Grid en Azure crea automáticamente un equilibrador de carga cuando se implementa un clúster de administración.

Configurar metadatos

Esta sección es la misma para todas las plataformas de destino.

En la sección opcional Metadatos, proporcione de forma opcional información descriptiva sobre este clúster de administración.

Los metadatos que especifique aquí se aplican al clúster de administración y a los clústeres de carga de trabajo que administra, y se puede acceder a ellos mediante la herramienta de administración de clústeres de su elección.

- Ubicación: La ubicación geográfica en la que se ejecutan los clústeres de.

- Descripción: Una descripción de este clúster de administración. La descripción tiene una longitud máxima de 63 caracteres y debe comenzar y terminar con una letra. Solo puede contener letras minúsculas, números y guiones, sin espacios.

- Etiquetas: Pares de clave/valor para ayudar a los usuarios a identificar clústeres, por ejemplo,

release : beta,environment : stagingoenvironment : production. Para obtener más información, consulte Etiquetas y selectores en la documentación de Kubernetes.

Puede hacer clic en Añadir para aplicar varias etiquetas a los clústeres.

Si va a realizar la implementación en vSphere, haga clic en Siguiente para ir a Configurar recursos. Si va a realizar la implementación en AWS o Azure, haga clic en Siguiente para ir a Configurar proxies y red de Kubernetes.

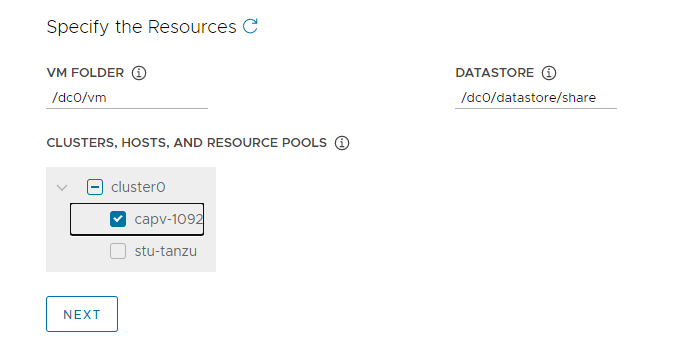

Configurar recursos de vSphere

Esta sección solo se aplica a las implementaciones de vSphere.

- vSphere

-

En la sección

Recursos, seleccione recurso de vSphere que utilizará el clúster de administración.

- Seleccione la carpeta de máquina virtual en la que desea colocar las máquinas virtuales del clúster de administración.

- Seleccione los almacenes de datos vSphere que utilizará el clúster de administración. La directiva de almacenamiento de las máquinas virtuales solo se puede especificar cuando se implementa el clúster de administración desde un archivo de configuración.

-

Seleccione el clúster, el host o el grupo de recursos en el que desea colocar el clúster de administración.

"Nota" Si los recursos adecuados aún no existen en vSphere, sin salir del instalador de Tanzu Kubernetes Grid, vaya a vSphere para crearlos. A continuación, haga clic en el botón de actualización para que se puedan seleccionar los nuevos recursos.

-

Haga clic en Siguiente para configurar la red y los proxies de Hubernetes.

- AWS

- Esta sección no se aplica a las implementaciones de AWS.

- Azure

- Esta sección no se aplica a las implementaciones de Azure.

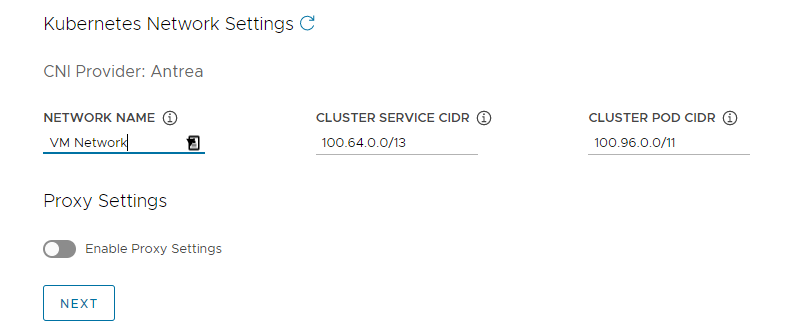

Configurar proxies y red de Kubernetes

Esta sección es la misma para todas las plataformas de destino, aunque parte de la información que proporcione depende del proveedor que esté utilizando.

-

En la sección Red de Kubernetes, configure las redes para los servicios de Kubernetes y haga clic en Siguiente.

- (solo vSphere) En Nombre de red, seleccione una red vSphere para utilizarla como red de servicio de Kubernetes.

- Revise los rangos de CIDR del servicio del clúster y CIDR del pod del clúster. Si los rangos de CIDR recomendados de

100.64.0.0/13y100.96.0.0/11no están disponibles, actualice los valores en CIDR del servicio del clúster y CIDR del pod del clúster.

-

(Opcional) Para enviar tráfico HTTP(S) saliente desde el clúster de administración a un proxy (por ejemplo, en un entorno restringido por Internet), active Aplicar configuración del proxy y siga las instrucciones que aparecen a continuación para introducir la información del proxy. Tanzu Kubernetes Grid aplica esta configuración a kubelet, containerd y el plano de control.

Puede utilizar un proxy para el tráfico HTTP y otro proxy para el tráfico HTTPS, o bien utilizar el mismo proxy para el tráfico HTTP y HTTPS.

Importante No puede cambiar el proxy después de implementar el clúster.

-

Para agregar la información del proxy de HTTP:

- En URL del proxy de HTTP, introduzca la URL del proxy que controla las solicitudes HTTP. La URL debe empezar con

http://. Por ejemplo,http://myproxy.com:1234. -

Si el proxy requiere autenticación, en Nombre de usuario del proxy de HTTP y Contraseña del proxy de HTTP, introduzca el nombre de usuario y la contraseña que se utilizarán para conectarse al proxy de HTTP.

Nota

No se pueden utilizar caracteres no alfanuméricos en las contraseñas al implementar clústeres de administración con la interfaz del instalador.

- En URL del proxy de HTTP, introduzca la URL del proxy que controla las solicitudes HTTP. La URL debe empezar con

-

Para agregar la información del proxy de HTTPS:

- Si desea utilizar la misma URL para el tráfico HTTP y HTTPS, seleccione Usar la misma configuración para el proxy de HTTPS.

-

Si desea utilizar una URL diferente para el tráfico HTTPS, haga lo siguiente:

- En URL del proxy de HTTPS, introduzca la URL del proxy que controla las solicitudes HTTPS. La URL debe empezar con

http://. Por ejemplo,http://myproxy.com:1234. -

Si el proxy requiere autenticación, en Nombre de usuario del proxy de HTTPS y Contraseña del proxy de HTTPS, introduzca el nombre de usuario y la contraseña que se utilizarán para conectarse al proxy de HTTPS.

Nota

No se pueden utilizar caracteres no alfanuméricos en las contraseñas al implementar clústeres de administración con la interfaz del instalador.

- En URL del proxy de HTTPS, introduzca la URL del proxy que controla las solicitudes HTTPS. La URL debe empezar con

-

En No hay proxy, introduzca una lista separada por comas de CIDR de red o nombres de host que deben omitir el proxy de HTTP(S). Si el clúster de administración se ejecuta en la misma red que la infraestructura, detrás del mismo proxy, establézcalo en los CIDR o los FQDN de la infraestructura para que el clúster de administración se comunique directamente con la infraestructura.

Por ejemplo,

noproxy.yourdomain.com,192.168.0.0/24.- vSphere

-

La lista

No hay ningún proxy debe incluir lo siguiente:

- La dirección IP o el nombre de host de vCenter. El tráfico a vCenter no se puede utilizar como proxy.

- El CIDR de la red vSphere que seleccionó en Nombre de red. El CIDR de la red de vSphere incluye la dirección IP del endpoint del plano de control. Si introdujo un FQDN en el endpoint del plano de control, agregue el FQDN y el CIDR de la red de vSphere a No hay ningún proxy. Internamente, Tanzu Kubernetes Grid anexa

localhost,127.0.0.1, los valores de CIDR del pod de clúster y CIDR del servicio del clúster,.svcy.svc.cluster.locala la lista que introduzca en este campo.

- AWS

-

Internamente, Tanzu Kubernetes Grid anexa

localhost,127.0.0.1, sus VPC CIDR, CIDR del pod de clúster y CIDR del servicio del clúster,.svc,.svc.cluster.localy169.254.0.0/16a la lista que introduzca en este campo. - Azure

-

De forma interna, Tanzu Kubernetes Grid anexa

localhost,127.0.0.1, el CIDR de la VNet, el CIDR del pod de clúster y el CIDR del servicio del clúster,.svc,.svc.cluster.local,169.254.0.0/16y168.63.129.16a la lista que introduzca en este campo.

Importante

Si las máquinas virtuales del clúster de administración necesitan comunicarse con servicios externos y endpoints de infraestructura en el entorno de Tanzu Kubernetes Grid, asegúrese de que los servidores proxy que configuró anteriormente puedan acceder a esos endpoints o agréguelos a No hay ningún proxy. Según la configuración del entorno, esto puede incluir, entre otros, el servidor LDAP o OIDC, Harbor y, en el caso de vSphere, VMware NSX y NSX Advanced Load Balancer.

-

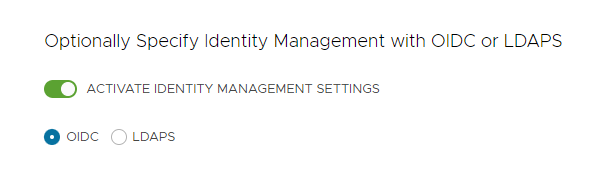

Configurar la administración de identidades

Esta sección es la misma para todas las plataformas de destino. Para obtener información sobre cómo Tanzu Kubernetes Grid implementa la administración de identidades, consulte Acerca de la administración de identidades y acceso.

-

En la sección Administración de identidades (Identity Management), de forma opcional seleccione Activar configuración de administración de identidades (Activate Identity Management Settings).

Puede desactivar la administración de identidades para implementaciones de prueba de concepto, pero se recomienda encarecidamente implementar la administración de identidades en implementaciones de producción. Si desactiva la administración de identidades, puede volver a activarla más tarde. Para obtener instrucciones sobre cómo volver a habilitar la administración de identidades, consulte Habilitar y configurar la administración de identidades en una implementación existente en Configurar la administración de identidades.

-

Si habilita la administración de identidades, seleccione OIDC o LDAPS.

Seleccione la pestaña OIDC o LDAPS a continuación para ver la información de configuración.

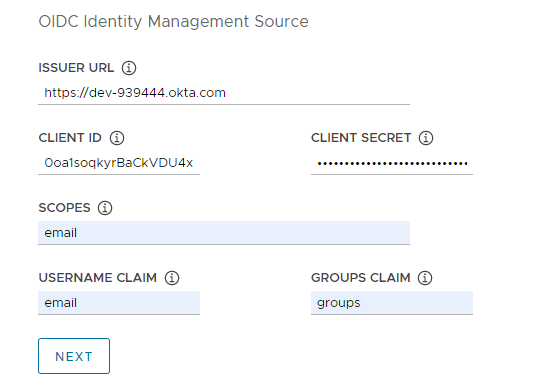

- OIDC

-

Proporcione los detalles de la cuenta del proveedor de OIDC, por ejemplo, Okta.

- URL del emisor: La dirección IP o DNS del servidor de OIDC.

- Identificador de cliente: El valor de

client_idque obtiene del proveedor de OIDC. Por ejemplo, si su proveedor es Okta, inicie sesión en Okta, cree una aplicación Web y seleccione las opciones de Credenciales del cliente para obtener unaclient_idysecret. - Secreto del cliente: El valor de

secretque obtiene del proveedor de OIDC. - Ámbitos: Una lista separada por comas de ámbitos adicionales para solicitar en la respuesta del token. Por ejemplo,

openid,groups,email. - Notificación de nombre de usuario: El nombre de la notificación de nombre de usuario. Esto se utiliza para establecer un nombre de usuario en la notificación de token de Web (JWT) JSON. En función del proveedor, introduzca notificaciones como

user_name,emailocode. - Notificación de grupos: El nombre de la notificación de grupos. Esto se utiliza para establecer un grupo de usuario en la notificación de JWT. Por ejemplo,

groups.

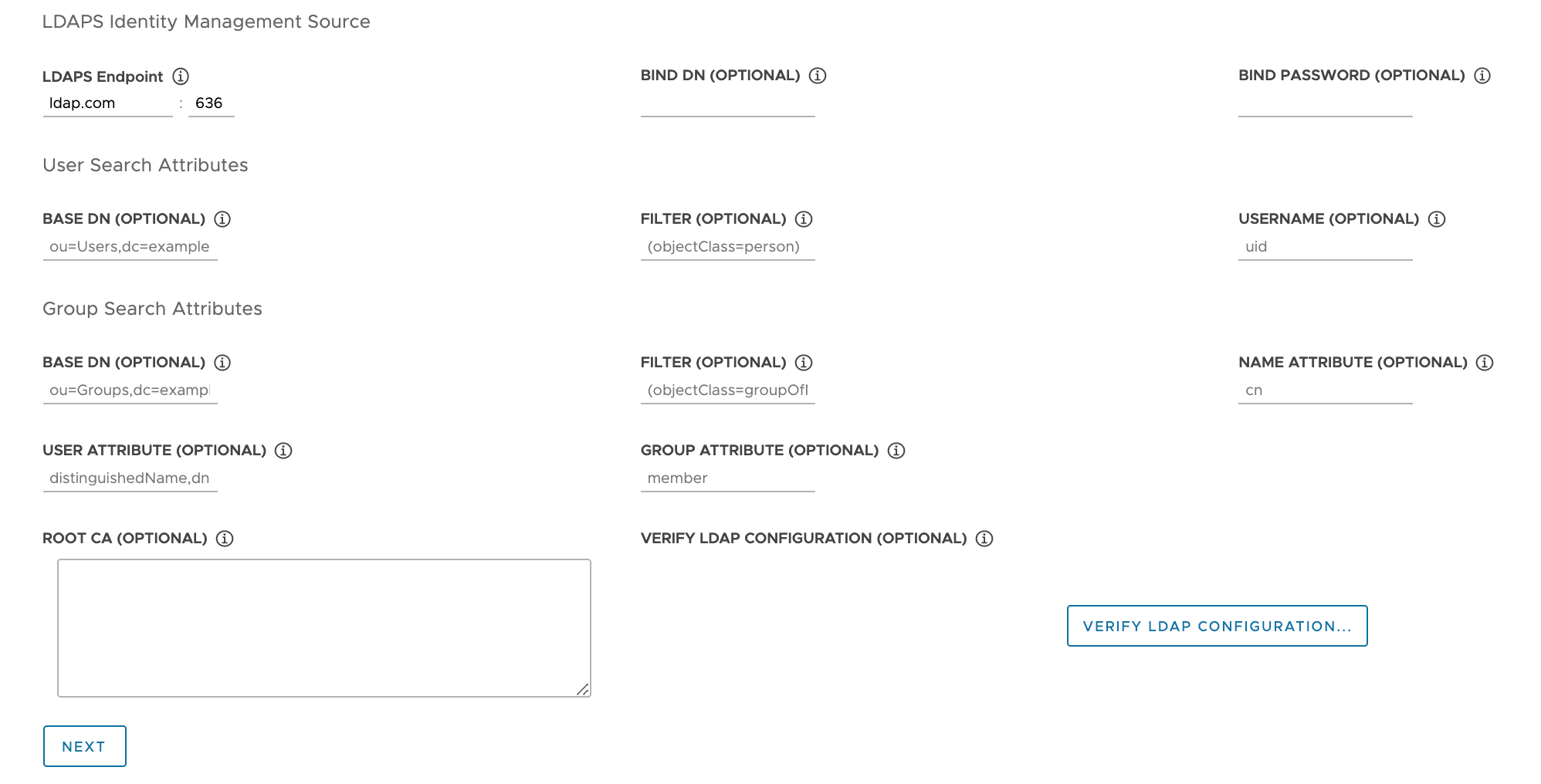

- LDAPS

-

Proporcione los detalles del servidor LDAPS de su empresa. Todos los ajustes excepto

Endpoint de LDAPS son opcionales.

- Endpoint de LDAPS: La dirección IP o DNS del servidor LDAPS. Proporcione la dirección y el puerto del servidor LDAP, con el formato

host:port. - DN de enlace: El DN de una cuenta de servicio de aplicaciones. El conector utiliza estas credenciales para buscar usuarios y grupos. No es necesario si el servidor LDAP proporciona acceso para la autenticación anónima.

- Contraseña de enlace: La contraseña de una cuenta de servicio de aplicaciones, si DN de enlace está establecido.

Proporcione los atributos de búsqueda de usuarios.

- DN base: El punto desde el que se inicia la búsqueda de LDAP. Por ejemplo,

OU=Users,OU=domain,DC=io. - Filtro: Un filtro opcional que utilizará la búsqueda de LDAP.

- Nombre de usuario: El atributo LDAP que contiene el identificador del usuario. Por ejemplo,

uid, sAMAccountName.

Proporcione los atributos de búsqueda de grupos.

- DN base: El punto desde el que se inicia la búsqueda de LDAP. Por ejemplo,

OU=Groups,OU=domain,DC=io. - Filtro: Un filtro opcional que utilizará la búsqueda de LDAP.

- Atributo de nombre: El atributo LDAP que contiene el nombre del grupo. Por ejemplo,

cn. - Atributo de usuario: El atributo del registro de usuario que se utiliza como el valor del atributo de pertenencia del registro de grupo. Por ejemplo,

distinguishedName, dn. - Atributo de grupo: El atributo del registro de grupo que contiene la información de usuario/miembro. Por ejemplo,

member.

Pegue el contenido del certificado de CA del servidor LDAPS en el cuadro de texto CA raíz.

(Opcional) Compruebe la configuración de LDAP.

- Haga clic en la opción Verificar configuración LDAP

-

Introduzca un nombre de usuario y un nombre de grupo.

Nota

En Tanzu Kubernetes Grid v1.4.x y versiones posteriores, estos campos se ignoran y revierten a

cnpara el nombre de usuario y aoupara el nombre de grupo. Para obtener actualizaciones sobre este problema conocido, consulte las Notas de la versión de VMware Tanzu Kubernetes Grid 1.5. -

Haga clic en Iniciar.

Después de completar la verificación, si ve algún error, debe examinarlo detenidamente en los pasos siguientes.

Nota

El host LDAP realiza esta comprobación y no los nodos del clúster de administración. Por lo tanto, es posible que la configuración LDAP funcione incluso si se produce un error en esta verificación.

- Endpoint de LDAPS: La dirección IP o DNS del servidor LDAPS. Proporcione la dirección y el puerto del servidor LDAP, con el formato

- Haga clic en Siguiente para ir a Seleccionar imagen base del sistema operativo.

Seleccionar la imagen base del sistema operativo

En la sección Imagen del sistema operativo, utilice el menú desplegable para seleccionar la plantilla de imagen de la versión del sistema operativo y Kubernetes que se utilizará para implementar máquinas virtuales de Tanzu Kubernetes Grid y haga clic en Siguiente.

Cómo se generan las opciones de imagen base del sistema operativo

El menú desplegable Imagen del sistema operativo incluye imágenes del sistema operativo que cumplen todos los criterios siguientes:

- La imagen está disponible en su IaaS.

- En vSphere, debe importar imágenes como se describe en Importar la plantilla de imagen base a vSphere. Ahora puede importar una imagen sin salir de la interfaz del instalador. Después de importarla, utilice el botón Actualizar para que aparezca en el menú desplegable.

- En Azure, debe aceptar la licencia como se describe en Aceptar la licencia de imagen base en Preparar para implementar clústeres de administración en Microsoft Azure.

- La imagen del sistema operativo se muestra en el archivo de la lista de materiales (BoM) de la versión de Tanzu Kubernetes (TKr) de la versión de Kubernetes en la que se ejecuta el clúster de administración.

- Los clústeres de administración de Tanzu Kubernetes Grid v2.1.1 se ejecutan en Kubernetes v1.24.10.

- Para utilizar una imagen personalizada, modifique el archivo de boM de TKr para que muestre la imagen, como se explica en Crear imágenes de máquina.

- vSphere, las imágenes de Azure y AWS aparecen en los bloques

ova,amiyazure, respectivamente.

- El nombre de la imagen en la IaaS coincide con su identificador en TKr BoM:

- vSphere, las imágenes de AWS y Azure se identifican por sus valores de campo

version,idysku, respectivamente.

- vSphere, las imágenes de AWS y Azure se identifican por sus valores de campo

Finalizar la implementación

Esta sección es la misma para todas las plataformas de destino.

-

En la sección Participación de CEIP (CEIP Participation), anule la selección de la casilla de verificación para no participar en el programa de mejora de la experiencia de cliente de VMware, y haga clic en Siguiente (Next).

También puede participar o no en el programa después de la implementación del clúster de administración. Para obtener información sobre el CEIP, consulte Administrar participación en el CEIP y https://www.vmware.com/solutions/trustvmware/ceip.html.

-

Haga clic en Revisar configuración para ver los detalles del clúster de administración que configuró. Si desea volver al asistente del instalador para modificar la configuración, haga clic en Editar configuración.

Al hacer clic en Revisar configuración, el instalador rellena el archivo de configuración del clúster, que se encuentra en el subdirectorio

~/.config/tanzu/tkg/clusterconfigs, con la configuración que especificó en la interfaz. Opcionalmente, puede exportar una copia de este archivo de configuración haciendo clic en Exportar configuración. -

Haga clic en Implementar clúster de administración.

La implementación del clúster de administración puede tardar varios minutos. La primera ejecución de

tanzu mc createtarda más que las ejecuciones posteriores porque debe extraer las imágenes de Docker necesarias en el almacén de imágenes de la máquina de arranque. Las ejecuciones posteriores no requieren este paso, por lo que son más rápidas. Puede seguir el progreso de la implementación del clúster de administración en la interfaz del instalador o en el terminal en el que ejecutótanzu mc create --ui. Si la máquina en la que ejecutatanzu mc createse apaga o se reinicia antes de que finalicen las operaciones locales, se producirá un error en la implementación. Si cierra accidentalmente el navegador o la pestaña del navegador en el que se ejecuta la implementación antes de que finalice, la implementación continuará en el terminal.

-

(Opcional) En Equivalente de comando de CLI, haga clic en el botón Copiar para copiar el comando de CLI de la configuración que especificó. Este comando de la CLI incluye la ruta de acceso al archivo de configuración rellenado por el instalador.

-

(solo vSphere) Después de implementar un clúster de administración en vSphere, debe configurar las direcciones IP de sus nodos de plano de control para que sean estáticas, como se describe en Configurar reservas de DHCP para el plano de control (solo vSphere) .

Qué hacer a continuación

- Guardar el archivo de configuración: El instalador guarda la configuración del clúster de administración en

~/.config/tanzu/tkg/clusterconfigscon un nombre de archivo generado con el formatoUNIQUE-ID.yaml. Este archivo de configuración tiene una estructura plana que establece variables de guion bajo en mayúscula comoCLUSTER_NAME. Después de que se haya completado la implementación, opcionalmente puede cambiar el nombre del archivo de configuración a un nombre que pueda recordar y guardarlo en una ubicación diferente para usarlo en el futuro. El instalador también genera una especificación de objeto basada en clases del tipo Kubernetes para el objetoClusterdel clúster de administración, que se guarda en un archivo con el mismo nombre que el clúster de administración. Esta especificación de objeto basada en clases se proporciona solo para información. Aún no se admite la implementación de clústeres de administración desde una especificación de objeto basada en clases. Para obtener más información sobre los tipos de clúster en TKG 2.x, consulte Clústeres de carga de trabajo en Acerca de Tanzu Kubernetes Grid. - Configurar la administración de identidades: Si habilitó la administración de identidades de LDAP o OIDC para el clúster de administración, debe realizar los pasos posteriores a la implementación descritos en Completar la configuración de administración de identidades para habilitar el acceso.

- Registre el clúster de administración con Tanzu Mission Control: Si desea registrar el clúster de administración con Tanzu Mission Control, consulte Registrar el clúster de administración con Tanzu Mission Control.

- Implementar clústeres de carga de trabajo: Una vez creado el clúster de administración, puede implementar clústeres de carga de trabajo como se describe en Crear clústeres de carga de trabajo en Crear y administrar clústeres de carga de trabajo de TKG 2.1 con CLI de Tanzu.

- Implementar otro clúster de administración: Para implementar más de un clúster de administración en cualquiera o en todos los vSphere, Azure y AWS, consulte Administrar sus clústeres de administración. En este tema también se proporciona información sobre cómo agregar clústeres de administración existentes a la instancia de CLI, obtener credenciales, escalar y eliminar clústeres de administración, agregar espacios de nombres y cómo participar o no en el CEIP.

Para obtener información sobre lo que ocurrió durante la implementación del clúster de administración y cómo conectar kubectl al clúster de administración, consulte Examinar y registrar un clúster de administración independiente recién implementado.