NSX ALB como proveedor de endpoint de plano de control

Cuando se integra con Tanzu Kubernetes Grid, NSX ALB puede proporcionar VIP de endpoint a los clústeres y realizar el equilibrio de carga en los nodos del plano de control del clúster. Esta función también permite personalizar la red VIP de endpoints y puertos del servidor de API del clúster .

La siguiente tabla proporciona una comparación de las funciones compatibles con NSX ALB y Kube-Vip:

| NSX ALB | Kube-Vip | |

|---|---|---|

| VIP de endpoint de clúster para IPAM | Proporcionado por NSX ALB |

Administrado manualmente por el cliente |

| Equilibrio de carga para los nodos del plano de control | Se equilibrará la carga del tráfico en todos los nodos del plano de control |

El tráfico solo se enrutará al nodo del plano de control principal |

| Puerto para el servidor de API | Cualquier puerto (el valor predeterminado es 6443) |

Cualquier puerto (el valor predeterminado es 6443) |

Configurar NSX ALB como proveedor de VIP de endpoint de clúster

Para configurar NSX ALB como proveedor de VIP de endpoint de clúster en un clúster de administración:

-

Cree un archivo YAML de configuración del clúster de administración y agregue el siguiente campo en el archivo:

AVI_CONTROL_PLANE_HA_PROVIDER: true -

Si desea utilizar una dirección IP estática para la VIP de endpoint, agregue el siguiente campo en el archivo:

VSPHERE_CONTROL_PLANE_ENDPOINT: <IP-ADDRESS>Asegúrese de que la VIP esté presente en el grupo de direcciones IP estáticas especificado en la red de VIP .

-

Si desea especificar un puerto para el servidor de la API, agregue el siguiente campo en el archivo:

AVI_CONTROL_PLANE_HA_PROVIDER: true CLUSTER_API_SERVER_PORT: <PORT-NUMBER>Nota

El clúster de administración y sus clústeres de carga de trabajo utilizarán este puerto para conectarse al servidor de API.

- Cree el clúster de administración mediante el comando

tanzu management-cluster create.

NSX ALB ahora está configurado como el proveedor de VIP de endpoint para el clúster de administración .

Para configurar NSX ALB como proveedor de VIP de endpoint de clúster en un clúster de carga de trabajo:

-

cree un archivo YAML de configuración del clúster de carga de trabajo y agregue el siguiente campo:

AVI_CONTROL_PLANE_HA_PROVIDER: true -

Si desea utilizar una dirección IP estática para la VIP de endpoint, agregue el siguiente campo en el archivo:

AVI_CONTROL_PLANE_HA_PROVIDER: true VSPHERE_CONTROL_PLANE_ENDPOINT: <IP-ADDRESS>Asegúrese de que la VIP esté presente en el grupo de direcciones IP estáticas especificado en la red de VIP .

-

Implemente el clúster de carga de trabajo mediante el comando

tanzu cluster create.

NSX ALB ahora está configurado como el proveedor de VIP de endpoint para el clúster de carga de trabajo.

Redes VIP independientes para endpoints de clúster y servicios de carga de trabajo

Si desea utilizar esta función en NSX ALB Essentials Edition, asegúrese de que la red que está utilizando no tenga firewalls ni directivas de red configuradas en ella. Si configuró firewalls o directivas de red en la red, implemente NSX ALB Enterprise Edition con la función de puerta de enlace automática para utilizar esta función.

Cuando se utiliza NSX ALB para proporcionar la VIP de endpoint de clúster, se puede personalizar la red de VIP para el endpoint del clúster y las direcciones IP externas de los servicios de carga de trabajo (equilibrador de carga y entrada). Puede separarlos en diferentes redes VIP para mejorar la seguridad y cumplir con otros requisitos de topología de red.

Configurar redes VIP independientes para el clúster de administración y los clústeres de carga de trabajo

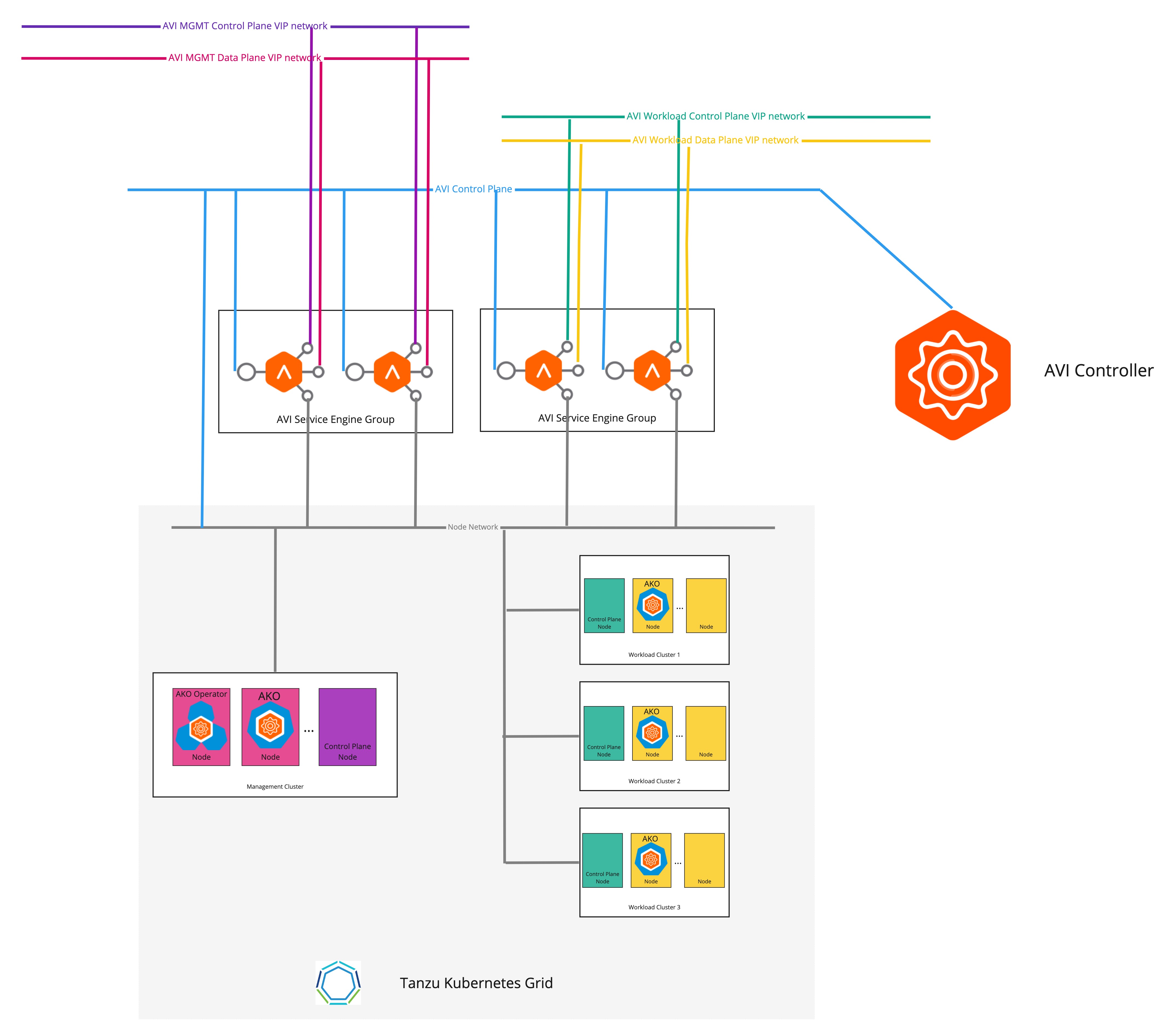

El siguiente diagrama describe la topología de la red cuando se configuran redes VIP independientes para el clúster de administración y los clústeres de carga de trabajo:

Para configurar redes VIP independientes para el clúster de administración y los clústeres de carga de trabajo:

-

Cree un archivo YAML de configuración del clúster de administración y agregue los siguientes campos al archivo:

AVI_CONTROL_PLANE_HA_PROVIDER: true # Network used to place workload clusters' services external IPs (load balancer & ingress services) AVI_DATA_NETWORK: AVI_DATA_NETWORK_CIDR: # Network used to place workload clusters' endpoint VIPs AVI_CONTROL_PLANE_NETWORK: AVI_CONTROL_PLANE_NETWORK_CIDR: # Network used to place management clusters' services external IPs (load balancer & ingress services) AVI_MANAGEMENT_CLUSTER_VIP_NETWORK_NAME: AVI_MANAGEMENT_CLUSTER_VIP_NETWORK_CIDR: # Network used to place management clusters' endpoint VIPs AVI_MANAGEMENT_CLUSTER_CONTROL_PLANE_VIP_NETWORK_NAME: AVI_MANAGEMENT_CLUSTER_CONTROL_PLANE_VIP_NETWORK_CIDR:Para obtener información sobre cómo crear un archivo de configuración del clúster de administración, consulte Crear un archivo de configuración del clúster de administración.

-

Cree el clúster de administración mediante el comando

tanzu management-cluster create.

La VIP de endpoint del clúster y la IP externa del servicio del equilibrador de carga ahora se colocan en redes diferentes.

Configurar redes VIP independientes para diferentes clústeres de carga de trabajo

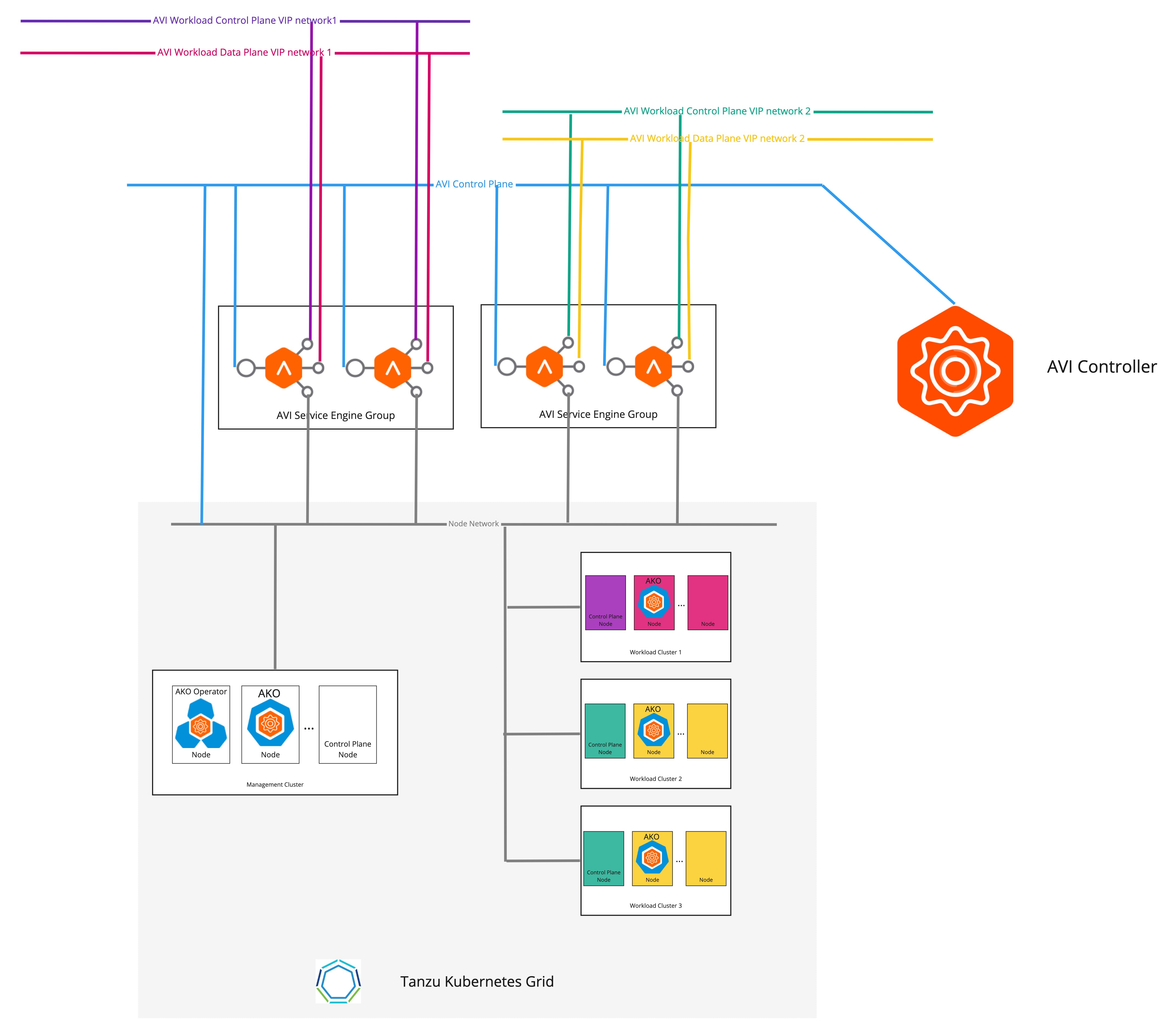

El siguiente diagrama describe la topología de la red cuando se configuran redes VIP independientes para diferentes clústeres de carga de trabajo .

Para configurar redes VIP independientes para diferentes clústeres de carga de trabajo:

-

Cree un objeto de CR

AKODeploymentConfigcomo se muestra en el siguiente ejemplo:apiVersion: networking.tkg.tanzu.vmware.com/v1alpha1 kind: AKODeploymentConfig metadata: name: install-ako-for-dev-cluster spec: adminCredentialRef: name: avi-controller-credentials namespace: tkg-system-networking certificateAuthorityRef: name: avi-controller-ca namespace: tkg-system-networking controller: 1.1.1.1 cloudName: Default-Cloud serviceEngineGroup: Default-Group clusterSelector: # match workload clusters with dev-cluster: "true" label matchLabels: dev-cluster: "true" controlPlaneNetwork: # clusters' endpoint VIP come from this VIP network cidr: 10.10.0.0/16 name: avi-dev-cp-network dataNetwork: # clusters' services external IP come from this VIP network cidr: 20.20.0.0/16 name: avi-dev-dp-network -

Aplique los cambios en el clúster de administración:

kubectl --context=MGMT-CLUSTER-CONTEXT apply -f <FILE-NAME> -

En el archivo YAML de configuración del clúster de carga de trabajo, agregue los campos obligatorios como se muestra en el siguiente ejemplo:

AVI_CONTROL_PLANE_HA_PROVIDER: true AVI_LABELS: '{"dev-cluster": "true"}' -

Cree el clúster de carga de trabajo mediante el comando

tanzu cluster create.

La VIP de endpoint de los clústeres de y la IP externa del servicio del equilibrador de carga ahora se colocan en redes diferentes.