La conception du réseau du centre de données physique inclut la définition de la topologie réseau pour connecter des commutateurs physiques et des hôtes ESXi, déterminant ainsi des paramètres de port de commutateur pour les VLAN et l'agrégation de liens, et la conception du routage.

Un réseau défini par logiciel (SDN) s'intègre aux composants du centre de données physique et utilise ceux-ci. SDN s'intègre à votre réseau physique pour prendre en charge le transit est-ouest dans le centre de données et le transit nord-sud vers les réseaux SDDC et à partir de ceux-ci.

Il existe plusieurs topologies de déploiement réseau du centre de données classique :

Accès à l'agrégation de cœurs

Feuille-tronc

SDN matériel

Feuille-tronc est la topologie de déploiement réseau du centre de données par défaut utilisée pour VMware Cloud Foundation.

VLAN et sous-réseaux pour VMware Cloud Foundation

Configurez vos VLAN et vos sous-réseaux conformément aux instructions et conditions requises pour VMware Cloud Foundation.

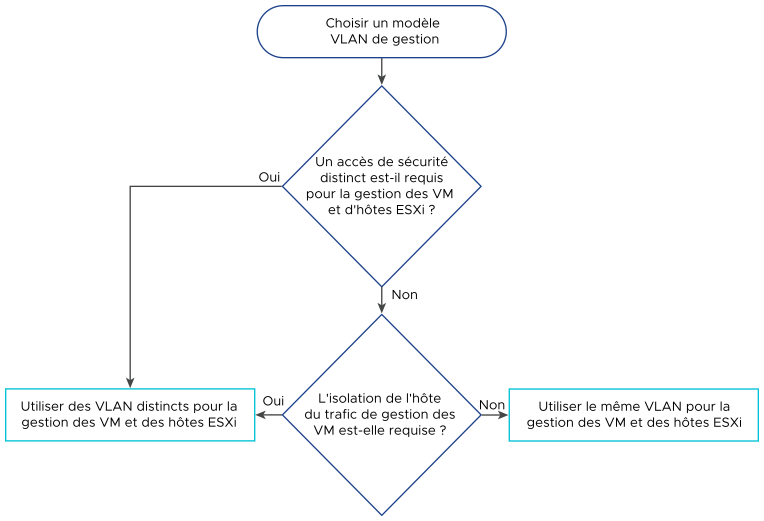

Lors de la conception de la configuration des VLAN et des sous-réseaux pour votre déploiement de VMware Cloud Foundation, tenez compte des instructions suivantes :

Toutes les topologies de déploiement |

Plusieurs zones de disponibilité |

Fédération NSX entre plusieurs instances de VMware Cloud Foundation |

Cluster de domaine de charge de travail VI de calcul sur plusieurs racks |

|---|---|---|---|

|

|

|

Utilisez l'espace d'adresses IPv4 RFC 1918 pour ces sous-réseaux et allouez un octet par rack et un autre octet par fonction réseau. |

Lors du déploiement des VLAN et des sous-réseaux pour VMware Cloud Foundation, ils doivent remplir les conditions requises suivantes en fonction de la topologie de VMware Cloud Foundation :

Fonction |

Instances de VMware Cloud Foundation avec une zone de disponibilité unique |

Instances de VMware Cloud Foundation avec plusieurs zones de disponibilité |

|---|---|---|

Gestion des VM |

|

|

Gestion des hôtes - première zone disponible |

|

|

vSphere vMotion : première zone de disponibilité |

|

|

vSAN : première zone de disponibilité |

|

|

Superposition de l'hôte : première zone de disponibilité |

|

|

NFS |

|

|

Liaison montante 01 |

|

|

Liaison montante 02 |

|

|

Superposition du dispositif Edge |

|

|

Gestion des hôtes - deuxième zone disponible |

|

|

vSphere vMotion : deuxième zone de disponibilité |

|

|

vSAN : deuxième zone de disponibilité |

|

|

Superposition de l'hôte : deuxième zone de disponibilité |

|

|

RTEP Edge |

|

|

Gestion et témoin : dispositif témoin à un troisième emplacement |

|

|

Fonction |

Instances de VMware Cloud Foundation avec un cluster de domaine de charge de travail VI de calcul sur plusieurs racks |

Instances de VMware Cloud Foundation avec disponibilité de NSX Edge sur plusieurs racks |

|---|---|---|

Gestion des VM |

|

|

Gestion des hôtes |

|

|

vSphere vMotion |

|

|

vSAN |

|

|

Superposition de l'hôte |

|

|

NFS |

|

|

Liaison montante 01 |

|

|

Liaison montante 02 |

|

|

Superposition du dispositif Edge |

|

|

Conditions requises et recommandations en matière de conception de réseau physique feuille-tronc pour VMware Cloud Foundation

Feuille-tronc est la topologie de déploiement réseau du centre de données par défaut utilisée pour VMware Cloud Foundation. Tenez compte de la bande passante réseau, de la configuration des ports de jonction, des trames Jumbo et de la configuration du routage pour NSX dans un déploiement comportant une ou plusieurs instances de VMware Cloud Foundation.

Conception logique du réseau physique feuille-tronc

Conditions requises et recommandations en matière de conception de réseau physique feuille-tronc

Les conditions requises et les recommandations pour la configuration du réseau feuille-tronc déterminent la disposition physique et l'utilisation des VLAN. Elles incluent également des conditions requises et des recommandations sur les trames Jumbo, et sur les exigences liées au réseau, telles que DNS, NTP et le routage.

ID de conditions requises |

Conditions requises pour la conception |

Justification |

Implication |

|---|---|---|---|

VCF-NET-REQD-CFG-001 |

N'utilisez pas la configuration EtherChannel (LAG, LACP ou vPC) pour les liaisons montantes de l'hôte ESXi. |

|

Aucun. |

VCF-NET-REQD-CFG-002 |

Utilisez des VLAN pour séparer les fonctions de réseau physique. |

|

Nécessite une configuration et une présentation uniformes sur toutes les jonctions mises à la disposition des hôtes ESXi. |

VCF-NET-REQD-CFG-003 |

Configurez les VLAN comme membres d'une jonction 802.1Q. |

Tous les VLAN deviennent disponibles sur les mêmes adaptateurs réseau physiques sur les hôtes ESXi. |

Le VLAN de gestion peut éventuellement agir en tant que VLAN natif. |

VCF-NET-REQD-CFG-004 |

Définissez la taille de la MTU sur au moins 1 700 octets (9 000 octets recommandés pour les trames Jumbo) sur les ports de commutateur physique, les commutateurs vSphere Distributed Switch, les groupes de ports vSphere Distributed Switch et les commutateurs N-VDS qui prennent en charge les types de trafic suivants :

|

|

Lors de l'ajustement de la taille des paquets MTU, vous devez également configurer l'intégralité du chemin réseau (adaptateurs réseau VMkernel, commutateurs virtuels, commutateurs physiques et routeurs) pour prendre en charge la même taille des paquets MTU. Dans un environnement comportant plusieurs zones de disponibilité, la MTU doit être configurée sur l'intégralité du chemin réseau entre les zones. |

ID de conditions requises |

Conditions requises pour la conception |

Justification |

Implication |

|---|---|---|---|

VCF-NET-L3MR-REQD-CFG-001 |

Pour un cluster de domaine de charge de travail VI de calcul sur plusieurs racks, fournissez des VLAN distincts par rack pour chaque fonction réseau.

|

Une infrastructure feuille-tronc de couche 3 possède une limite de couche 3 au niveau des commutateurs feuilles dans chaque rack créant une limite de couche 3 entre les racks. |

Nécessite des VLAN supplémentaires pour chaque rack. |

VCF-NET-L3MR-REQD-CFG-002 |

Pour un cluster de domaine de charge de travail VI de calcul sur plusieurs racks, les sous-réseaux de chaque réseau par rack doivent être routables et accessibles aux commutateurs feuilles dans les autres racks.

|

Garantit la circulation du trafic de chaque réseau entre les racks. |

Nécessite une configuration réseau physique supplémentaire pour rendre les réseaux routables entre les racks. |

ID de conditions requises |

Conditions requises pour la conception |

Justification |

Implication |

|---|---|---|---|

VCF-NET-REQD-CFG-005 |

Définissez la taille de MTU sur au moins 1 500 octets (1 700 octets préférés ; 9 000 octets recommandés pour les trames Jumbo) sur les composants du réseau physique entre les instances de VMware Cloud Foundation pour les types de trafic suivants.

|

|

Lors de l'ajustement de la taille des paquets MTU, vous devez également configurer l'intégralité du chemin réseau, c'est-à-dire les interfaces virtuelles, les commutateurs virtuels, les commutateurs physiques et les routeurs pour prendre en charge la même taille des paquets MTU. |

VCF-NET-REQD-CFG-006 |

Assurez-vous que la latence entre les instances de VMware Cloud Foundation connectées dans une fédération NSX est inférieure à 500 ms. |

La fédération NSX nécessite une latence inférieure à 500 ms. |

Aucun. |

VCF-NET-REQD-CFG-007 |

Fournissez une connexion routée entre les clusters NSX Manager dans les instances de VMware Cloud Foundation connectées dans une fédération NSX. |

La configuration de la fédération NSX nécessite une connectivité entre les instances du gestionnaire global NSX, les instances du gestionnaire local NSX et les clusters NSX Edge. |

Vous devez attribuer des adresses IP routables uniques pour chaque domaine de pannes. |

ID de recommandation |

Recommandation en matière de conception |

Justification |

Implication |

|---|---|---|---|

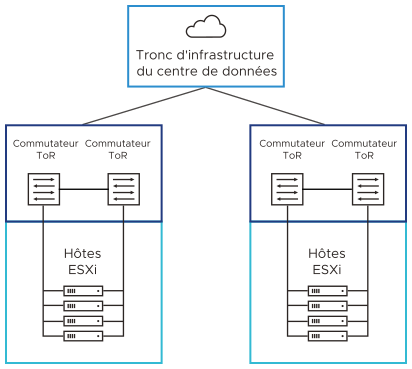

VCF-NET-RCMD-CFG-001 |

Utilisez deux commutateurs ToR pour chaque rack. |

Prend en charge l'utilisation de deux liaisons 10 GbE (au moins 25 GbE recommandés) vers chaque serveur, fournit une redondance et réduit la complexité globale de la conception. |

Nécessite deux commutateurs ToR par rack, ce qui peut augmenter les coûts. |

VCF-NET-RCMD-CFG-002 |

Mettez en œuvre l'architecture réseau physique suivante :

|

|

|

VCF-NET-RCMD-CFG-003 |

Utilisez un réseau physique configuré pour la contiguïté de routage BGP. |

|

Nécessite une configuration BGP dans le réseau physique. |

VCF-NET-RCMD-CFG-004 |

Attribuez des configurations d'adresses IP persistantes pour les points de terminaison de tunnel (TEP) NSX qui utilisent l'adressage des pools d'adresses IP dynamiques plutôt que celui des pools d'adresses IP dynamiques. |

|

L'ajout d'hôtes supplémentaires au cluster peut nécessiter l'augmentation des pools d'adresses IP statiques. |

VCF-NET-RCMD-CFG-005 |

Configurez les ports de jonction connectés aux cartes réseau ESXi comme PortFast de jonction. |

Réduit le délai de transition des ports vers l'état de transfert. |

Bien que cette conception n'utilise pas le protocole STP, celui-ci est généralement configuré par défaut sur les commutateurs. |

VCF-NET-RCMD-CFG-006 |

Configurez VRRP, HSRP ou une autre méthode de disponibilité de passerelle de couche 3 pour ces réseaux.

|

Garantit que les VLAN étendus entre les zones de disponibilité sont connectés à une passerelle hautement disponible. Sinon, une panne dans la passerelle de couche 3 entraîne une interruption du trafic dans la configuration SDN. |

Nécessite la configuration d'une technologie haute disponibilité pour les passerelles de couche 3 dans le centre de données. |

VCF-NET-RCMD-CFG-007 |

Utilisez des VLAN distincts pour les fonctions réseau de chaque cluster. |

Réduit la taille du domaine de diffusion de couche 2 à un cluster vSphere unique. |

Augmente le nombre global de VLAN requis pour une instance de VMware Cloud Foundation. |

ID de recommandation |

Recommandation en matière de conception |

Justification |

Implication |

|---|---|---|---|

VCF-NET-DES-RCMD-CFG-001 |

Mettez en œuvre l'architecture réseau physique suivante :

|

Prend en charge les conditions requises pour la bande passante élevée et les paquets par seconde pour les déploiements à grande échelle. |

Nécessite des commutateurs réseau de 100 GbE. |

ID de recommandation |

Recommandation en matière de conception |

Justification |

Implication |

|---|---|---|---|

VCF-NET-RCMD-CFG-008 |

Fournissez le routage BGP entre toutes les instances de VMware Cloud Foundation connectées dans une configuration de la fédération NSX. |

BGP est le protocole de routage pris en charge pour la fédération NSX. |

Aucun. |

VCF-NET-RCMD-CFG-009 |

Assurez-vous que la latence entre les instances de VMware Cloud Foundation connectées dans une fédération NSX est inférieure à 150 ms pour la mobilité des charges de travail. |

Une latence inférieure à 150 ms est requise pour les fonctionnalités suivantes :

|

Aucun. |