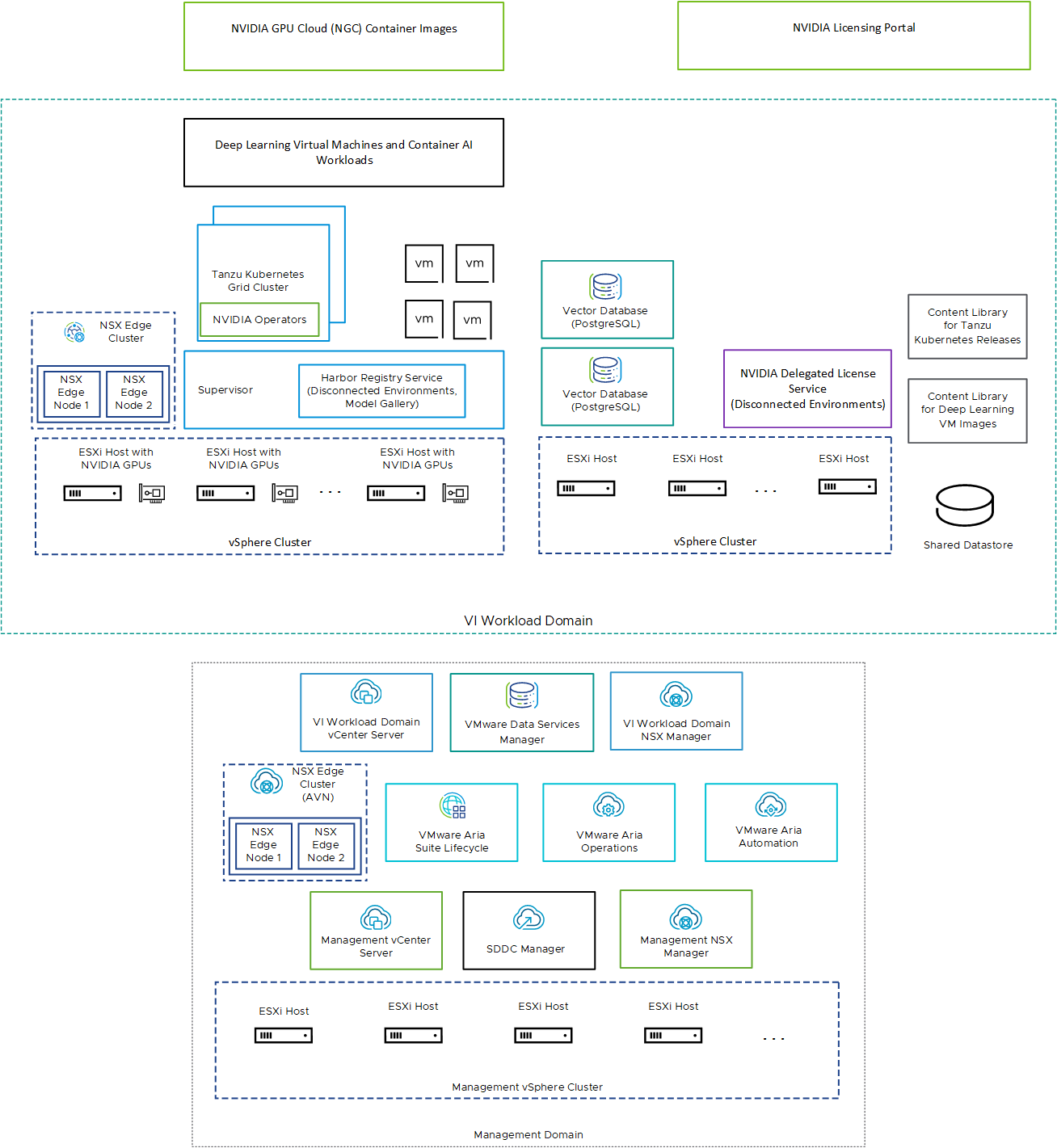

VMware Private AI Foundation with NVIDIA s'exécute en plus de l'ajout de la prise en charge de VMware Cloud Foundation pour toutes les charges de travail d'IA dans les domaines de charge de travail VI avec vSphere IaaS control plane provisionné à l'aide de kubectl et de VMware Aria Automation.

| Composant | Description |

|---|---|

| Hôtes ESXi avec GPU activé | Hôtes ESXi configurés de la manière suivante :

|

| Superviseur | Un ou plusieurs clusters vSphere doivent être activés pour vSphere IaaS control plane afin que vous puissiez exécuter des machines virtuelles et des conteneurs sur vSphere à l'aide de l'API Kubernetes. Un superviseur est un cluster Kubernetes, servant de plan de contrôle pour gérer les clusters de charge de travail et les machines virtuelles. |

| Registre Harbor | Vous pouvez utiliser un registre Harbor dans les cas suivants :

|

| Cluster NSX Edge | Cluster de nœuds NSX Edge qui fournit un routage nord-sud à 2 niveaux pour le superviseur et les charges de travail qu'il exécute. La passerelle de niveau 0 sur le cluster NSX Edge est en mode actif-actif. |

| Opérateurs NVIDIA |

|

| Base de données vectorielle |

|

|

Utilisez le portail de licences NVIDIA pour générer un jeton de configuration client afin d'attribuer une licence au pilote vGPU invité dans la machine virtuelle à apprentissage profond et les opérateurs GPU sur les clusters TKG. Dans un environnement déconnecté ou pour que vos charges de travail obtiennent des informations de licence sans utiliser de connexion Internet, hébergez les licences NVIDIA localement sur un dispositif DLS (Delegated License Service). |

| Bibliothèque de contenu | Les bibliothèques de contenu stockent les images pour les machines virtuelles à apprentissage profond et pour les versions de Tanzu Kubernetes. Utilisez ces images pour le déploiement de charges de travail d'IA dans l'environnement VMware Private AI Foundation with NVIDIA. Dans un environnement connecté, les bibliothèques de contenu extraient leur contenu des bibliothèques de contenu publiques gérées de VMware. Dans un environnement déconnecté, vous devez charger manuellement les images requises ou les extraire d'un serveur miroir de bibliothèque de contenu interne. |

| Catalogue NVIDIA GPU Cloud (NGC) | Portail des conteneurs optimisés pour le GPU de l'IA et de l'apprentissage automatique qui sont testés et prêts à s'exécuter sur des GPU NVIDIA pris en charge sur site au-dessus de VMware Private AI Foundation with NVIDIA. |

En tant qu'administrateur de cloud, utilisez les composants de gestion dans VMware Cloud Foundation de la manière suivante :

| Composant de gestion | Description |

|---|---|

| Instance de vCenter Server de gestion | Gérez les hôtes ESXi qui exécutent les composants de gestion du SDDC et prennent en charge l'intégration à d'autres solutions pour la surveillance et la gestion de l'infrastructure virtuelle. |

| Instance de NSX Manager de gestion | Fournissez des services de mise en réseau aux charges de travail de gestion dans VMware Cloud Foundation. |

| SDDC Manager |

|

| Instance de vCenter Server de domaine de charge de travail VI | Activez et configurez un superviseur. |

| NSX Manager de domaine de charge de travail VI | SDDC Manager utilise cette instance de NSX Manager pour déployer et mettre à jour des clusters NSX Edge. |

| Cluster NSX Edge (AVN) | Placez les composants de VMware Aria Suite sur une configuration prédéfinie de segments NSX, appelés réseaux virtuels d'application (AVN, Application Virtual Networks) pour le routage dynamique et l'équilibrage de charge. |

| VMware Aria Suite Lifecycle | Déployez et mettez à jour VMware Aria Automation et VMware Aria Operations. |

| VMware Aria Automation | Ajoutez des éléments de catalogue en libre-service pour le déploiement de charges de travail IA pour les ingénieurs DevOps, les scientifiques des données et les ingénieurs MLOps. |

| VMware Aria Operations | Surveillez la consommation de GPU dans les domaines de charge de travail avec GPU activé. |

| VMware Data Services Manager | Créez des bases de données vectorielles, telles qu'une base de données PostgreSQL avec l'extension pgvector. |