Pour migrer les interfaces VMkernel depuis un commutateur VSS ou DVS vers un commutateur N-VDS au niveau du cluster, configurez le profil de nœud de transport avec les détails du mappage réseau requis pour la migration (mappage des interfaces VMkernel vers les commutateurs logiques). De même, pour migrer les interfaces VMkernel sur un nœud hôte, configurez la configuration du nœud de transport. Pour restaurer les interfaces VMkernel migrées vers un commutateur VSS ou DVS, configurez la désinstallation du mappage réseau (mappage des ports logiques vers l'interface VMkernel) dans le profil de nœud de transport afin qu'elle soit réalisée lors de la désinstallation.

Au cours de la migration, les cartes réseau physique en cours d'utilisation sont migrées vers un commutateur N-VDS, alors que les cartes réseau physiques disponibles ou libres sont attachées au commutateur N-VDS après la migration.

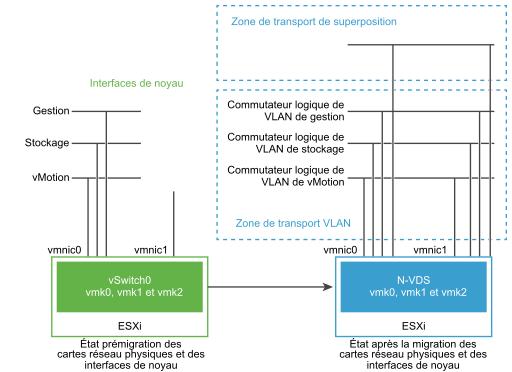

Dans la figure suivante, si un hôte possède seulement deux cartes réseau physiques, vous voudrez peut-être attribuer ces deux cartes réseau au N-VDS pour la redondance et leurs interfaces VMkernel associées afin que les interfaces ne perdent pas la connectivité avec l'hôte.

Avant la migration, l'hôte ESXi dispose de deux liaisons montantes dérivées de deux ports physiques : vmnic0 et vmnic1. Ici, vmnic0 est configurée pour être dans un état actif, attachée à un VSS, tandis que vmnic1 n'est pas utilisée. En outre, il existe trois interfaces VMkernel : vmk0, vmk1 et vmk2.

Vous pouvez migrer les interfaces VMkernel en utilisant l'interface utilisateur de NSX-T Data Center Manager ou les API de NSX-T Data Center. Reportez-vous à la section Guide de l'API de NSX-T Data Center.

Après la migration, vmnic0, vmnic1 et leurs interfaces VMkernel sont migrées vers le commutateur N-VDS. La vmnic0 et la vmnic1 sont connectées sur le VLAN et les zones de transport de superposition.

Considérations relatives à la migration de VMkernel

- Migration PNIC et VMkernel : avant de migrer des cartes réseau physiques liées et les interfaces VMkernel associées à un commutateur N-VDS, notez le mappage réseau (mappage de cartes réseau physiques au groupe de ports) sur le commutateur hôte.

- Migration PNIC uniquement : si vous prévoyez de migrer uniquement les cartes PNIC, assurez-vous que la carte réseau physique de gestion connectée à l'interface VMkernel de gestion n'est pas migrée. Cela entraîne une perte de connectivité avec l'hôte. Pour plus de détails, voir le champ Migration PNIC uniquement dans la section Ajouter un profil de nœud de transport.

- Restaurer la migration : avant de prévoir la restauration d'interfaces VMkernel migrées vers le commutateur hôte VSS ou DVS pour les cartes réseau physiques liées, assurez-vous d'avoir noté le mappage réseau (mappage de carte réseau physique au groupe de ports) sur le commutateur hôte. Il est obligatoire de configurer le profil de nœud de transport avec le mappage du commutateur d'hôte dans le champ Mappage réseau pour la désinstallation. Sans ce mappage, NSX-T Data Center ne sait pas vers quels groupes de ports les interfaces VMkernel doivent être remigrées. Cette situation peut entraîner une perte de connectivité au réseau vSAN.

- Enregistrement de vCenter Server avant la migration : si vous prévoyez de migrer un VMkernel ou une carte PNIC connectée vers un commutateur DVS, assurez-vous que vCenter Server est enregistré avec NSX Manager.

- Faire correspondre l'ID de VLAN : après la migration, l'interface de la carte réseau de gestion et de la VMkernel de gestion doit être sur le même VLAN auquel la carte réseau était connectée avant la migration. Si vmnic0 et vmk0 sont connectées au réseau de gestion et migrés vers un autre VLAN, la connectivité à l'hôte est perdue.

- Migration vers le commutateur VSS : il est impossible de remigrer deux interfaces VMkernel vers le même groupe de ports qu'un commutateur VSS.

- vMotion : effectuez une migration vMotion pour déplacer des charges de travail de VM vers un autre hôte avant la migration VMkernel et/ou PNIC. En cas d'échec de la migration, les VM de charge de travail ne sont pas affectées.

- vSAN : si le trafic vSAN est en cours d'exécution sur l'hôte, placez l'hôte en mode de maintenance via vCenter Server et déplacez les VM hors de l'hôte en utilisant la fonctionnalité vMotion avant la migration VMkernel et/ou PNIC.

-

Migration : si un VMkernel est déjà connecté à un commutateur cible, il peut toujours être sélectionné pour être migré vers le même commutateur. Cette propriété rend l'opération de migration VMK et/ou PNIC idempotent. Elle vous permet de migrer uniquement des PNIC vers un commutateur cible. Comme la migration requiert toujours au moins un VMkernel et un PNIC, vous sélectionnez un VMkernel déjà migré vers un commutateur cible lorsque vous migrez uniquement des PNIC vers un commutateur cible. Si aucun VMkernel ne doit être migré, créez un VMkernel temporaire via un serveur vCenter Server dans le commutateur source ou le commutateur cible. Ensuite, migrez-le avec les PNIC et supprimez le VMkernel temporaire via vCenter Server une fois la migration terminée.

- Partage d'adresses MAC : si une interface VMkernel et un PNIC partagent la même adresse MAC et qu'ils se trouvent dans le même commutateur, ils doivent être migrés ensemble vers le même commutateur cible s'ils sont tous les deux utilisés après la migration. Conservez toujours vmk0 et vmnic0 dans le même commutateur.

Vérifiez les adresses MAC utilisées par tous les VMK et les PNIC de l'hôte en exécutant les commandes suivantes :

esxcfg-vmknic -l

esxcfg-nics -l

- Ports logiques VIF créés après la migration : après la migration de VMkernel d'un commutateur VSS ou DVS vers un commutateur N-VDS, un port de commutateur logique de type VIF est créé sur l'instance de NSX Manager. Vous ne devez pas créer de règles de pare-feu distribué sur ces ports de commutateur logique VIF.

Migrer les interfaces VMkernel vers un commutateur N-VDS

Workflow de haut niveau utilisé pour migrer les interfaces VMkernel vers un commutateur N-VDS :

- Créez un commutateur logique si nécessaire.

- Mettez hors tension les machines virtuelles sur l'hôte depuis lequel les interfaces VMkernel et PNIC sont migrées vers un commutateur N-VDS.

- Configurez un profil de nœud de transport avec un mappage réseau utilisé pour migrer les interfaces VMkernel lors de la création de nœuds de transport. Le mappage réseau correspond au mappage d'une interface VMkernel à un commutateur logique.

Pour plus de détails, reportez-vous à la section Ajouter un profil de nœud de transport.

- Vérifiez que les mappages d'adaptateur réseau dans vCenter Server reflètent une nouvelle association du commutateur VMkernel avec un commutateur N-VDS. En cas de cartes réseau physiques liées, vérifiez que le mappage dans NSX-T Data Center reflète tout VMkernel lié à une carte réseau physique dans vCenter Server.

- Dans NSX Manager, accédez à Mise en réseau → Segments. Sur la page Segments, vérifiez que l'interface VMkernel est attachée au segment via un port logique nouvellement créé.

- En fonction de la version de NSX-T Data Center, sélectionnez l'une des options suivantes :

(NSX-T Data Center 3.2.2 ou version ultérieure) et sélectionnez l'onglet Cluster.

(NSX-T Data Center 3.2.1 ou version antérieure)

- Pour chaque nœud de transport, vérifiez que l'état dans la colonne État du nœud est Réussite pour confirmer que la configuration de nœud de transport est correctement validée.

- Vérifiez que l'état dans État de configuration est Réussite pour confirmer que l'hôte est correctement réalisé avec la configuration spécifiée.

Une fois que vous avez migré des interfaces VMkernel et des PNIC depuis un VDS vers un commutateur N-VDS à l'aide de l'interface utilisateur de NSX-T ou de l'API de nœud de transport, vCenter Server affiche des avertissements pour le VDS. Si l'hôte doit être connecté au VDS, supprimez l'hôte du VDS. Le serveur vCenter Server n'affiche plus d'avertissement pour le VDS.

Pour plus de détails sur les erreurs que vous pouvez rencontrer lors de la migration, reportez-vous à la section Erreurs de migration de VMkernel

Restaurer la migration d'interfaces VMkernel vers un commutateur VSS ou DVS

Workflow de haut niveau utilisé pour restaurer la migration d'interfaces VMkernel depuis un commutateur N-VDS vers un commutateur VSS ou DVS lors de la désinstallation de NSX-T Data Center :

- Sur l'hôte ESXi, mettez hors tension les machines virtuelles connectées aux ports logiques qui hébergent l'interface VMkernel après la migration.

- Configurez le profil de nœud de transport avec un mappage réseau utilisé pour migrer les interfaces VMkernel lors du processus de désinstallation. Le mappage réseau pendant la désinstallation mappe les interfaces VMkernel vers un groupe de ports sur un commutateur VSS ou DVS de l'hôte ESXi.

Note : Lors de la restauration de la migration d'un VMkernel vers un groupe de ports sur un commutateur DVS, assurez-vous que le type de groupe de ports est défini sur Éphémère.

Pour plus de détails, reportez-vous à la section Ajouter un profil de nœud de transport.

- Vérifiez que les mappages d'adaptateur réseau dans vCenter Server reflètent une nouvelle association du commutateur VMkernel avec un groupe de ports du commutateur VSS ou DVS.

- Dans NSX Manager, accédez à Mise en réseau → Segments. Sur la page Segments, vérifiez que le segment contenant les interfaces VMkernel est supprimé.

Pour plus de détails sur les erreurs que vous pouvez rencontrer lors de la migration, reportez-vous à la section Erreurs de migration de VMkernel

Mettre à jour le mappage du commutateur d'hôte

-

Hôtes avec état : les opérations d'ajout et de mise à jour sont prises en charge. Pour mettre à jour un mappage existant, vous pouvez ajouter une nouvelle entrée d'interface VMkernel à la configuration du mappage réseau. Si vous mettez à jour la configuration du mappage réseau d'une interface VMkernel qui est déjà migrée vers le commutateur N-VDS, le mappage réseau mis à jour n'est pas réalisé sur l'hôte.

-

Hôtes sans état : les opérations d'ajout, de mise à jour et de suppression sont prises en charge. Les modifications apportées à la configuration du mappage réseau sont réalisées après le redémarrage de l'hôte.

Pour mettre à jour les interfaces VMkernel vers un nouveau commutateur logique, vous pouvez modifier le profil de nœud de transport afin d'appliquer les mappages réseau au niveau du cluster. Si vous souhaitez que les mises à jour s'appliquent uniquement à un hôte spécifique, configurez le nœud de transport à l'aide des API au niveau de l'hôte.

- Pour mettre à jour tous les hôtes d'un cluster, modifiez le champ Mappage réseau pendant l'installation pour mettre à jour le mappage VMkernel vers des commutateurs logiques.

Pour plus de détails, reportez-vous à la section Ajouter un profil de nœud de transport.

- Enregistrez les modifications. Les modifications apportées à un profil de nœud de transport sont automatiquement appliquées à tous les hôtes membres du cluster, sauf sur les hôtes marqués avec l'état Remplacé.

- De même, pour mettre à jour un hôte unique, vous devez modifier le mappage VMkernel dans la configuration de nœud de transport.

Pour plus de détails sur les erreurs que vous pouvez rencontrer lors de la migration, reportez-vous à la section Erreurs de migration de VMkernel

Migrer les interfaces VMkernel sur un cluster sans état

- Préparez et configurez un hôte comme hôte de référence à l'aide des API du nœud de transport.

- Extrayez le profil d'hôte à partir de l'hôte de référence.

- Dans vCenter Server, appliquez le profil d'hôte au cluster sans état.

- Dans NSX-T Data Center, appliquez le profil de nœud de transport au cluster sans état.

- Redémarrez chaque hôte du cluster.

Les hôtes du cluster peuvent prendre plusieurs minutes pour réaliser les états mis à jour.

Scénarios d'échec de la migration

- Si la migration échoue pour une raison quelconque, l'hôte tente de migrer les cartes réseau physiques et les interfaces VMkernel à trois reprises.

- Si l'échec de la migration persiste, l'hôte effectue une restauration à la configuration précédente en conservant la connectivité de VMkernel avec la carte réseau physique de gestion, vmnic0.

- Si la restauration échoue à tel point que le VMkernel configuré pour la carte réseau physique de gestion a été perdu, vous devez réinitialiser l'hôte.

Scénarios de migration non pris en charge

Les scénarios suivants ne sont pris en charge :

- Les interfaces VMkernel migrées en même temps à partir de deux commutateurs VSS ou DVS différents.

- Sur les hôtes avec état, le mappage réseau est mis à jour pour mapper l'interface VMkernel vers un autre commutateur logique. Par exemple, avant la migration, le VMkernel est mappé au commutateur logique 1 et l'interface VMkernel est mappée au commutateur logique 2.