Utilisez le serveur PXE pour automatiser l'installation de NSX Edge sur un serveur bare metal ou utilisez un fichier ISO pour installer NSX Edge sur un serveur bare metal.

Le nœud NSX Edge bare metal est un serveur physique dédié qui exécute un logiciel NSX Edge de version spéciale. Le nœud NSX Edge bare metal nécessite une carte réseau prenant en charge le kit de développement du plan de données (DPDK, Data Plane Development Kit). VMware conserve une liste de compatibilité avec diverses cartes réseau de fournisseurs. Reportez-vous à Configuration requise système d'un serveur bare metal.

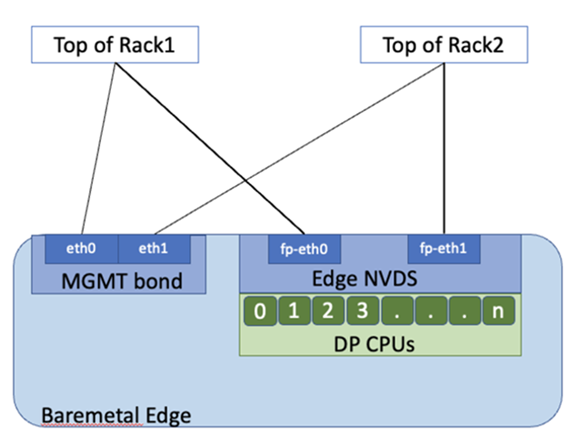

Les nœuds NSX Edge dans le diagramme sont illustrés par un commutateur N-VDS unique, configuré avec deux interfaces de chemin de données et deux cartes réseau dédiées pour la haute disponibilité du plan de gestion.

Les nœuds NSX Edge bare metal peuvent être configurés avec plus de 2 interfaces de chemin de données en fonction du nombre de cartes réseau disponibles sur le serveur. Les nœuds NSX Edge bare metal utilisent des pNIC comme liaisons montantes qui se connectent directement aux commutateurs ToR (Top of Rack). Pour fournir une haute disponibilité pour la gestion des dispositifs Edge bare metal, configurez deux pNIC sur le serveur comme lien Linux actif/en veille.

Les CPU sur le dispositif Edge sont attribués comme CPU de chemin de données (DP) qui fournissent des services de routage et avec état ou des CPU de services qui fournissent des services d'équilibrage de charge et VPN.

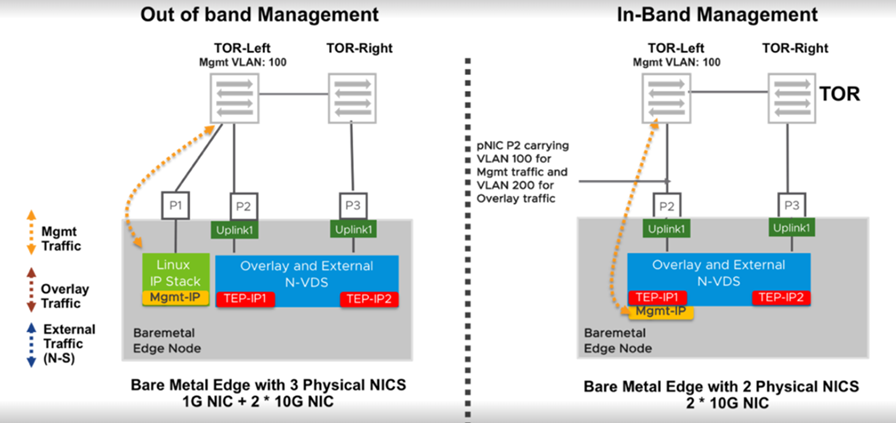

Lorsqu'un nœud Edge bare metal est installé, une interface dédiée est conservée pour la gestion. Cette configuration est appelée gestion hors bande. Si la redondance est souhaitée, deux cartes réseau peuvent être utilisées pour la haute disponibilité du plan de gestion. Le dispositif Edge bare metal prend également en charge la gestion intrabande dans laquelle le trafic de gestion peut exploiter une interface utilisée pour le trafic d'overlay ou externe (N-S), comme dans le diagramme.

Pour les nœuds Edge bare metal, tous les cœurs du premier nœud d'un serveur de nœuds multiples NUMA seront attribués au chemin de données NSX. Si le dispositif bare metal ne dispose que d'un seul nœud NUMA, 50 % des cœurs seront attribués pour le chemin de données NSX.

Les nœuds NSX Edge bare metal prennent en charge deux nœuds NUMA au maximum.

La fonctionnalité de mise en sous-cluster NUMA modifie le socket de la mémoire de segment de deux domaines NUMA à quatre domaines NUMA. Cette modification limite la taille de la mémoire de segment allouée à chaque socket et entraîne une insuffisance de mémoire de segment pour le socket 0 requise par le chemin de données. Vous devez désactiver la fonction de mise en sous-cluster NUMA dans le BIOS. Toute modification apportée au BIOS nécessite un redémarrage.

Pour vérifier si la fonctionnalité de mise en sous-cluster NUMA est activée, connectez-vous au dispositif NSX Edge bare metal en tant que racine et exécutez lscpu. La sortie est également capturée dans le bundle de support. S'il existe plus de deux nœuds NUMA, cela implique que la fonctionnalité de sous-NUMA est activée et qu'elle doit être désactivée via le BIOS.

- Lors de la configuration des liens LAG LACP sur des nœuds NSX Edge bare metal, les cœurs de chemin de données (cartes réseau de sauvegarde) doivent appartenir au même nœud NUMA pour que l'équilibrage de charge s'effectue sur les deux périphériques. Si les périphériques formant le lien s'étendent sur plusieurs nœuds NUMA, le lien utilise uniquement le CPU du périphérique réseau qui est le nœud NUMA local (0) pour transmettre des paquets. Par conséquent, les périphériques ne sont pas tous utilisés pour l'équilibrage du trafic qui est envoyé hors du périphérique de lien.

Dans ce cas, le basculement fonctionne toujours, car le basculement est exclusif de l'équilibrage de charge. Si le périphérique Ethernet connecté au nœud NUMA local est inactif, la liaison envoie le trafic vers l'autre périphérique, même s'il n'est pas local NUMA. L'optimisation de l'équilibrage de charge n'a pas d'incidence sur la fonctionnalité de basculement.

Exécutez la commande get dataplane pour afficher le nœud NUMA associé à chaque interface de chemin de données. Pour déplacer les cartes réseau associées au chemin de données vers un seul nœud NUMA, la reconfiguration physique du serveur est requise via le BIOS.

Conditions préalables

- Pour désactiver le clustering de sous-NUMA, modifiez les paramètres du BIOS. NSX ne prend pas en charge le clustering de sous-NUMA. Pour plus d'informations, reportez-vous à l'article de la base de connaissances, https://kb.vmware.com/s/article/91790.

- À partir de NSX v3.1.3, sur des nœuds bare metal NSX Edge, vous n'avez pas besoin de désactiver l'hyperthreading. L’hyperthreading est automatiquement désactivé.