Dans un environnement vSphere with Tanzu, un Cluster superviseur peut utiliser la pile de mise en réseau vSphere ou VMware NSX-T Data Center™ pour fournir une connectivité aux machines virtuelles, aux services et aux charges de travail du plan de contrôle Kubernetes. Lorsqu'un Cluster superviseur est configuré avec la pile de mise en réseau vSphere, tous les hôtes du cluster sont connectés à un vSphere Distributed Switch qui fournit la connectivité aux charges de travail Kubernetes et aux machines virtuelles du plan de contrôle. Un Cluster superviseur qui utilise la pile de mise en réseau vSphere nécessite un équilibrage de charge sur le réseau de gestion de vCenter Server pour fournir la connectivité aux utilisateurs DevOps et aux services externes. Un Cluster superviseur configuré avec VMware NSX-T Data Center™ utilise les réseaux logiciels de la solution ainsi qu'un équilibrage de charge NSX Edge pour fournir la connectivité aux services externes et aux utilisateurs DevOps.

Mise en réseau de Cluster superviseur avec NSX-T Data Center

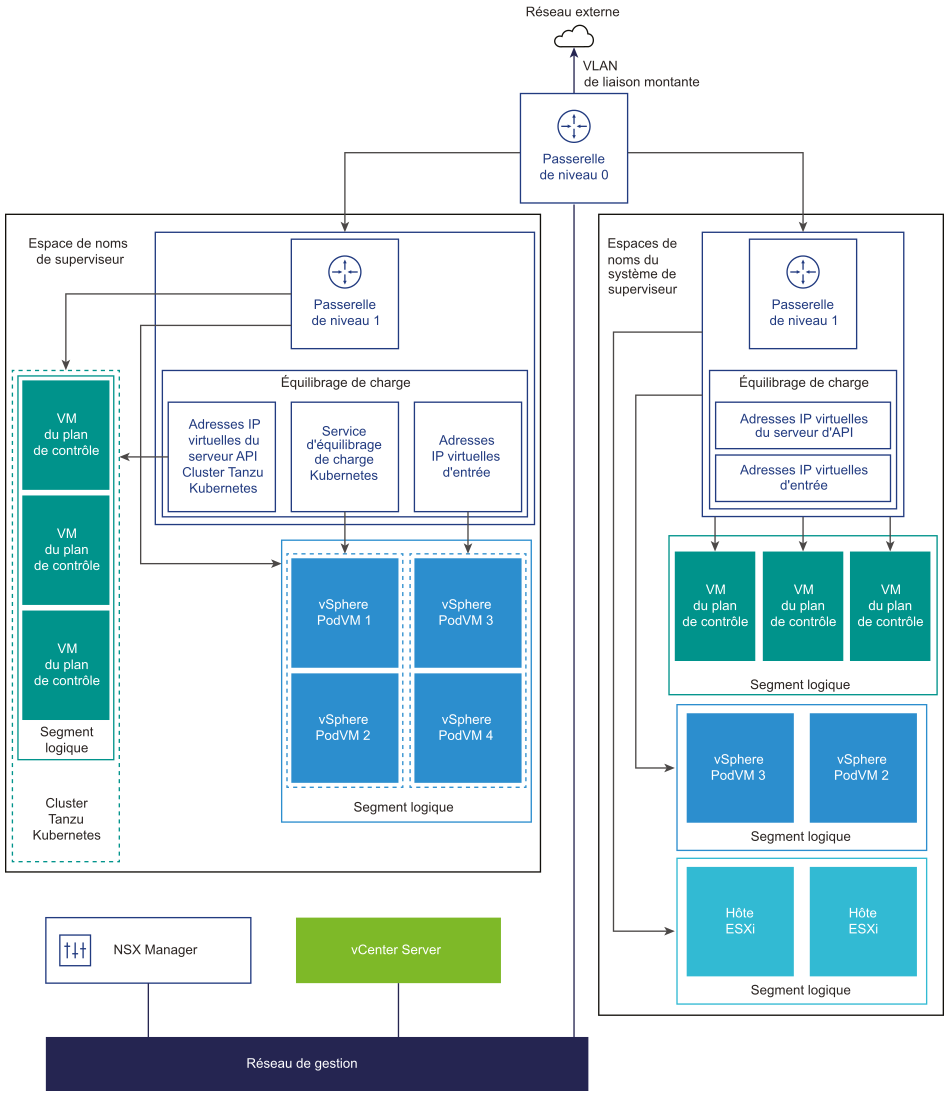

VMware NSX-T Data Center™ fournit une connectivité réseau aux objets à l'intérieur du Cluster superviseur et des réseaux externes. La connectivité aux hôtes ESXi constituant le cluster est gérée par les réseaux vSphere standard.

Vous pouvez également configurer la mise en réseau du Cluster superviseur manuellement à l'aide d'un déploiement de NSX-T Data Center existant ou en déployant une nouvelle instance de NSX-T Data Center.

| vSphere with Tanzu | NSX-T Data Center |

|---|---|

| Version 7.0 Update 3 | Versions 3.0, 3.0.x, 3.1, 3.1.1, 3.1.2 et 3.1.3. |

| Version 7.0 Update 2 | Versions 3.0, 3.0.x, 3.1, 3.1.1 et 3.1.2. |

| Version 7.0 Update 1c | Versions 3.0, 3.0.x, 3.1 et 3.1.1. |

| Version 7.0 Update 1 | Versions 3.0, 3.0.1, 3.0.1.1 et 3.0.2. |

| Version 7.0 | Version 3.0. |

Cette section décrit la topologie de mise en réseau lorsque vous installez et configurez vSphere with Tanzu version 7.0 Update 2. Pour plus d'informations sur la mise à niveau de vSphere with Tanzu 7.0 Update 1 vers la version 7.0 Update 2, reportez-vous à la section Mise à niveau de la topologie réseau.

- NSX Container Plug-in (NCP) fournit une intégration entre NSX-T Data Center et Kubernetes. Le composant principal de NCP s'exécute dans un conteneur et communique avec NSX Manager et avec le plan de contrôle Kubernetes. NCP surveille les modifications apportées aux conteneurs et à d'autres ressources et gère les ressources de mise en réseau, telles que les ports logiques, les segments, les routeurs et les groupes de sécurité des conteneurs en appelant NSX API.

Le NCP crée une passerelle de niveau 1 partagée pour les espaces de noms système et une passerelle de niveau 1 et un équilibrage de charge pour chaque espace de noms, par défaut. La passerelle de niveau 1 est connectée à la passerelle de niveau 0 et à un segment par défaut.

Les espaces de noms système sont des espaces de noms utilisés par les composants principaux qui font partie intégrante du fonctionnement du cluster superviseur et de Tanzo Kubernetes. Les ressources réseau partagées qui incluent la passerelle de niveau 1, l'équilibrage de charge et l'adresse IP SNAT sont regroupées dans un espace de noms système.

- NSX Edge fournit une connectivité à des objets de Cluster superviseur depuis des réseaux externes. Le cluster NSX Edge dispose d'un équilibrage de charge qui fournit une redondance aux serveurs d'API Kubernetes résidant sur les machines virtuelles du plan de contrôle, et à toutes les applications qui doivent être publiées et accessibles à l'extérieur du Cluster superviseur.

- Une passerelle de niveau 0 est associée au cluster NSX Edge pour fournir le routage au réseau externe. L'interface de liaison montante utilise le protocole de routage dynamique , BGP ou de routage statique.

- Chaque Espace de noms vSphere dispose d'un réseau distinct et d'un ensemble de ressources de mise en réseau partagées par des applications dans l'espace de noms, telles que la passerelle de niveau 1, le service d'équilibrage de charge et l'adresse IP SNAT.

- Les charges de travail s'exécutant dans des espaces vSphere ou des clusters Tanzu Kubernetes, qui se trouvent dans le même espace de noms, partagent une même adresse IP SNAT pour la connectivité nord-sud.

- Les charges de travail s'exécutant dans des espaces vSphere ou des clusters Tanzu Kubernetes auront la même règle d'isolation qui est mise en œuvre par le pare-feu par défaut.

- Une adresse IP SNAT distincte n'est pas requise pour chaque espace de noms Kubernetes. La connectivité est-ouest entre les espaces de noms ne sera pas SNAT.

- Les segments de chaque espace de noms résident sur le commutateur vSphere Distributed Switch (VDS) fonctionnant en mode standard associé au cluster NSX Edge. Le segment fournit un réseau superposé au Cluster superviseur.

- Les clusters superviseurs ont des segments séparés dans la passerelle de niveau 1 partagée. Pour chaque cluster Tanzu Kubernetes, les segments sont définis dans la passerelle de niveau 1 de l'espace de noms.

- Les processus Spherelet sur chaque hôte ESXi communiquent avec vCenter Server via une interface sur le réseau de gestion.

Pour en savoir plus sur la mise en réseau de Cluster superviseur, regardez la vidéo intitulée Service réseau vSphere 7 with Kubernetes - Partie 1 - Cluster superviseur.

Méthodes de configuration de la mise en réseau avec NSX-T Data Center

- La manière la plus simple de configurer la mise en réseau du Cluster superviseur est d'utiliser VMware Cloud Foundation SDDC Manager. Pour plus d'informations, reportez-vous à la documentation de VMware Cloud Foundation SDDC Manager. Pour plus d'informations, consultez la section Utilisation de la gestion de la charge de travail.

- Vous pouvez également configurer la mise en réseau du Cluster superviseur manuellement à l'aide d'un déploiement de NSX-T Data Center existant ou en déployant une nouvelle instance de NSX-T Data Center. Consultez Installer et configurer NSX-T Data Center pour vSphere with Tanzu pour plus d'informations.

Mise en réseau de Cluster superviseur avec vSphere Distributed Switch

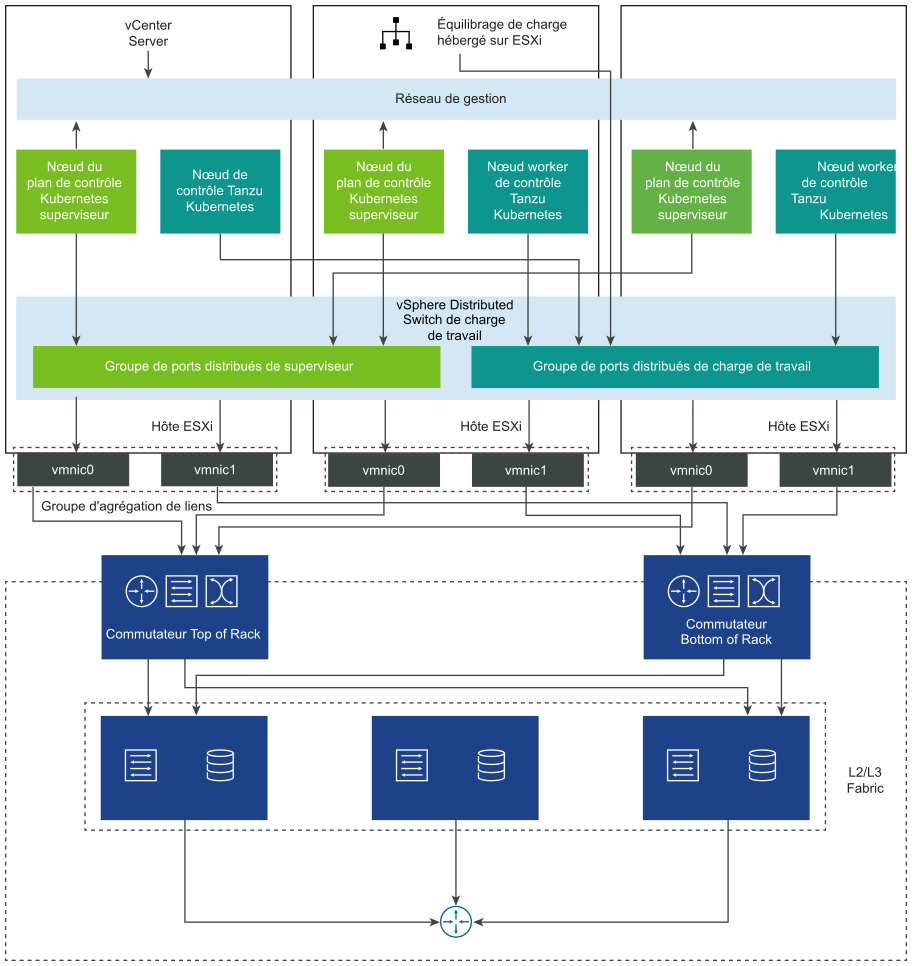

Un Cluster superviseur qui dépend d'un commutateur vSphere Distributed Switch utilise des groupes de ports distribués comme réseaux de charge de travail pour les espaces de noms.

Selon la topologie que vous mettez en œuvre pour le Cluster superviseur, vous pouvez utiliser un ou plusieurs groupes de ports distribués comme réseaux de charge de travail. Le réseau qui fournit la connectivité aux machines virtuelles du plan de contrôle Kubernetes est appelé réseau de charge de travail principal. Vous pouvez attribuer ce réseau à tous les espaces de noms sur le Cluster superviseur, ou vous pouvez utiliser différents réseaux pour chaque espace de noms. Les clusters Tanzu Kubernetes se connectent au réseau de charge de travail qui est attribué à l'espace de noms dans lequel résident les clusters.

Un Cluster superviseur qui dépend d'un commutateur vSphere Distributed Switch utilise un équilibrage de charge pour fournir la connectivité aux utilisateurs DevOps et aux services externes. Vous pouvez utiliser le NSX Advanced Load Balancer ou l'équilibrage de charge HAProxy.

Pour plus d'informations, reportez-vous à Configuration de la mise en réseau vSphere et de NSX Advanced Load Balancer pour vSphere with Tanzu et Installer et configurer l'équilibrage de charge HAProxy.