Lorsque vous utilisez ESXi avec un SAN iSCSI, suivez les recommandations de VMware pour éviter des problèmes.

Consultez votre représentant de stockage pour savoir si votre système de stockage prend en charge les fonctionnalités d'accélération matérielle API de stockage - Intégration de baie. Le cas échéant, consultez la documentation du fournisseur pour activer la prise en charge de l'accélération matérielle du côté du système de stockage. Pour plus d'informations, consultez Accélération matérielle du stockage en vSphere.

Prévention des problèmes de iSCSI SAN

Lorsque vous utilisez ESXi avec un SAN, vous devez suivre des directives spécifiques afin d'éviter des problèmes de SAN.

Suivez les conseils suivants :

- Placez une seule banque de données VMFS sur chaque LUN.

- Ne changez pas la politique de chemin que le système définit, sauf si vous comprenez les implications de tels changements.

- Documentez tout ce que vous faites. Incluez des informations sur la configuration, le contrôle d'accès, le stockage, le commutateur, le serveur et la configuration HBA iSCSI, les versions de logiciel et microprogramme, et le plan des câbles de stockage.

- Plan en cas de panne :

- Faîtes plusieurs copies de vos mappages topologiques. Pour chaque élément, envisagez les conséquences sur votre SAN si cet élément tombe en panne.

- Rayez chaque lien, commutateurs, HBA et autres éléments pour vérifier que vous n'avez omis aucun point de panne critique dans votre architecture.

- Assurez-vous que les HBA iSCSI sont installés dans les slots corrects de l'hôte ESXi selon la vitesse de l'emplacement et du bus. Équilibrez la charge de bus PCI entre les divers bus du serveur.

- Familiarisez-vous avec les différents points de contrôle de votre réseau de stockage, sur tous les points de visibilité, y compris l'ESXi, les graphiques de performance, les statistiques des commutateurs Ethernet et des performances de stockage.

- Modifiez les ID LUN uniquement lorsque les banques de données VMFS déployées sur les LUN n'ont pas de machines virtuelles en cours d'exécution. Si vous modifiez les ID, ces machines virtuelles en fonction sur les banque de données VMFS peuvent tomber en panne.

Après avoir modifié l'ID du LUN, vous devez réanalyser le stockage pour réinitialiser l'ID sur votre hôte. Pour plus d'informations sur l'utilisation de la réanalyse, consultez Réanalyser les opérations de stockage ESXi.

- Si vous changez le nom iSCSI par défaut de votre adaptateur iSCSI, assurez-vous que le nom que vous entrez est unique mondialement et correctement formaté. Pour éviter des problèmes d'accès de stockage, n'attribuez jamais le même nom iSCSI à différents adaptateurs, même sur différents hôtes.

Optimisation des performances du stockage SAN iSCSI

Plusieurs facteurs contribuent à l'optimisation d'un environnement SAN classique.

Si l'environnement de réseau est correctement configuré, les composants iSCSI fournissent un débit adéquat et une latence suffisamment basse pour les initiateurs et les cibles iSCSI. Si le réseau est congestionné et les liens, commutateurs et routeurs sont saturés, la performance iSCSI en souffre et risque de ne plus convenir à un environnement ESXi.

Performances des systèmes de stockage

Les performances des systèmes de stockage sont l'un des principaux facteurs contribuant aux performances de la totalité de l'environnement iSCSI.

En cas de problème de performances des systèmes de stockage, consultez la documentation de votre éditeur de systèmes de stockage.

Lors de l'attribution des LUN, souvenez-vous que chaque LUN partagé est accessible par plusieurs hôtes et que plusieurs machines virtuelles peuvent exécuter sur chaque hôte. Un LUN utilisé par l'hôte ESXi peut servir à des E/S provenant d'applications très variées et exécutées sur différents systèmes d'exploitation. En raison de ces charges de travail très variées, le groupe RAID contenant les LUN ESXi ne doit pas inclure de LUN utilisés par d'autres hôtes qui n'exécutent pas ESXi pour les applications intensives.

Activez le cache de lecture et le cache d'écriture.

L'équilibrage de charge est le processus distribution des requêtes d'E/S serveur sur tous les SP disponibles et les chemins d'accès au serveur d'hôte associé. Le but est d'optimiser les performances en termes de débit (E/S par seconde, méga-octets par seconde ou temps de réponse).

Les systèmes de stockage SAN nécessitent des modifications et des ajustements permanents pour s'assurer que les charges d'E/S sont réparties sur tous les chemins d'accès des systèmes de stockage. Pour répondre à cette exigence, répartissez les chemins d'accès vers les LUN entre tous les SP pour assurer un équilibrage de charge optimal. Une surveillance attentive permet de savoir quand il est nécessaire de rééquilibrer manuellement la répartition des LUN.

L'ajustement des systèmes de stockage équilibrées de manière statique implique la surveillance de statistiques de performance spécifiques (nombre d'opérations d'entrée-sortie par seconde, blocs par seconde et temps de réponse) et la répartition de la charge de travail des LUN pour répartir la charge de travail sur tous les SP.

Performances de serveur avec iSCSI

Pour garantir des performances optimales de l'hôte ESXi, tenez compte de plusieurs facteurs.

Chaque application de serveur doit avoir accès à son stockage désigné aux conditions suivantes :

- Vitesse d'E/S élevée (nombre d'opérations d'entrée-sortie par seconde)

- Rendement élevé (mégaoctets par seconde)

- Latence minimale (temps de réponse)

Comme chaque application a différentes exigences, ces objectifs peuvent être remplis en sélectionnant un groupe RAID approprié sur le système de stockage.

Pour atteindre les objectifs de performance, procédez comme suit :

- Placez chaque LUN sur un groupe RAID qui offre les niveaux de performance nécessaires. Surveillez les activités et l'utilisation des ressources des autres LUN dans le groupe RAID attribué. Un groupe RAID haute performance ayant un nombre excessif d'applications effectuant des E/S risque de ne pas satisfaire aux exigences de performance requises par une application exécutée sur l'hôte ESXi.

- Pour atteindre un débit maximal pour toutes les applications sur l'hôte pendant la période de pointe, installez un nombre suffisant de cartes réseau ou d'adaptateurs iSCSI matériels. Les entrées/sorties réparties sur plusieurs ports présentent un débit plus rapide et moins de latence pour chaque application.

- Pour assurer la redondance d'iSCSI logiciel, vérifiez que l'initiateur est connecté à tous les adaptateurs réseau utilisés pour la connectivité iSCSI.

- Lors de l'allocation de groupes LUN ou RAID aux systèmes ESXi, n'oubliez pas que plusieurs systèmes d'exploitation utilisent et partagent cette ressource. Les performances des LUN requises par l'hôte ESXi peuvent être beaucoup plus élevées que lorsque vous utilisez des machines physiques standard. Par exemple, si vous pensez exploiter quatre applications à fortes E/S, allouez quatre fois les capacités de performance aux LUN de l'ESXi.

- Lorsque vous utilisez plusieurs systèmes ESXi avec vCenter Server, les exigences de performance de stockage augmentent.

- Le nombre d'E/S en attente requises par applications exécutées sur un système ESXi doit correspondre au nombre d'E/S pouvant être traitées par le SAN.

Performances du réseau

Généralement, un SAN consiste en un ensemble d'ordinateurs connectés à un ensemble de systèmes de stockage par un réseau de commutateurs. Il arrive souvent que plusieurs ordinateurs accèdent au même stockage.

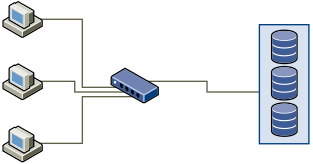

Le graphique suivant montre plusieurs systèmes informatiques connectés à un système de stockage via un commutateur Ethernet. Dans cette configuration, chaque système est connecté au commutateur via un lien Ethernet unique. Le commutateur est connecté au système de stockage via un lien Ethernet unique.

Lorsque les systèmes lisent les données du stockage, le stockage répond en envoyant suffisamment de données pour remplir le lien entre les systèmes de stockage et le commutateur Ethernet. Il est peu probable qu'un système ou qu'une machine virtuelle exploite totalement la vitesse du réseau. Cette situation peut toutefois survenir lorsque de nombreux systèmes partagent un périphérique de stockage unique.

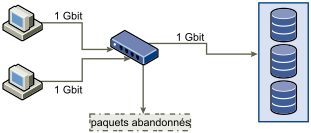

Lorsqu'ils écrivent des données sur le stockage, des systèmes ou machines virtuelles multiples peuvent tenter d'exploiter totalement la vitesse de leurs liens. Par conséquent, il peut arriver que le commutateur entre les systèmes et le système de stockage abandonne des paquets réseau. L'abandon de données peut se produire parce que le commutateur a plus de trafic à envoyer au système de stockage qu'un seul lien ne peut en transporter. La quantité de données que le commutateur peut transmettre est limitée par la vitesse du lien entre lui et le système de stockage.

La restauration de paquets réseau abandonnés provoque une forte détérioration des performances. En plus du temps passé à déterminer quelles données ont été abandonnées, leur retransmission utilise la bande passante qui peut autrement servir aux transactions actuelles.

Le trafic iSCSI est assuré sur le réseau par le protocole de contrôle de transmission TCP. TCP est un protocole de transmission fiable, qui veille à ce que les paquets abandonnés soient représentés, et enfin atteignent leur destination. TCP est conçu pour restaurer les paquets abandonnés, et les retransmettre rapidement et sans coupure. Toutefois, lorsque le commutateur abandonne des paquets régulièrement, les performances réseau peuvent en souffrir. Le réseau est encombré par les demandes de renvoi de données et les paquets renvoyés. Moins de données sont transférées que sur un réseau sans congestion.

La plupart des commutateurs Ethernet peuvent conserver en mémoire tampon, ou stocker, des données. Cette technique donne à chaque périphérique tentant d'envoyer des données une chance égale de rejoindre sa destination. La possibilité de conserver en mémoire tampon certaines transmissions, combinée avec de nombreux systèmes limitant le nombre de commandes en attente, réduit les transmissions en petites rafales. Les rafales de plusieurs systèmes peuvent être envoyées à un système de stockage à tour de rôle.

Si les transactions sont volumineuses et que plusieurs serveurs envoient des données via un port de commutateur unique, la capacité de mise en mémoire tampon peut être dépassée. Dans un tel cas, le commutateur abandonne les données qu'il ne peut pas envoyer, et le système de stockage doit demander une retransmission du paquet abandonné. Par exemple, si un commutateur Ethernet peut conserver en mémoire tampon 32 Ko, mais que le serveur envoie 256 Ko au périphérique de stockage, certaines de ces données sont abandonnées.

La plupart des commutateurs administrables fournissent des informations sur les paquets abandonnés, qui ressemblent à ceci :

*: interface is up IHQ: pkts in input hold queue IQD: pkts dropped from input queue OHQ: pkts in output hold queue OQD: pkts dropped from output queue RXBS: rx rate (bits/sec) RXPS: rx rate (pkts/sec) TXBS: tx rate (bits/sec) TXPS: tx rate (pkts/sec) TRTL: throttle count

| Interface | IHQ | IQD | OHQ | OQD | RXBS | RXPS | TXBS | TXPS | TRTL |

|---|---|---|---|---|---|---|---|---|---|

| * GigabitEthernet0/1 | 3 | 9922 | 0 | 0 | 476303000 | 62273 | 477840000 | 63677 | 0 |

Dans cet exemple provenant d'un commutateur Cisco, la bande passante utilisée est de 476303000 bits/seconde, moins de la moitié de la bande passante physique. Le port met en mémoire tampon les paquets entrants mais en a abandonné quelques-uns. La ligne finale de ce résumé d'interface indique dans la colonne IQD que le port a déjà abandonné presque 10 000 paquets arrivants.

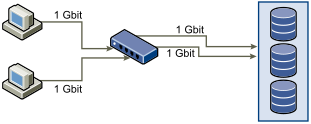

Pour éviter ce problème il est nécessaire de modifier la configuration en s'assurant que plusieurs liens ethernet arrivants ne se retrouve en goulot d'étranglement sur un seul lien sortant, provoquant une surcharge du lien trop abonné. Lorsque plusieurs liens transmettant à quasi saturation sont redirigés vers un plus petit nombre de liens, le surabonnement devient possible.

En règle générale, les applications ou systèmes écrivant une grande quantité de données sur le stockage doivent éviter le partage des liens Ethernet vers un périphérique de stockage. Ces types d'applications sont les plus efficaces avec des connexions multiples aux périphériques de stockage.

L'illustration Multiple connexions du commutateur au stockage montre des connexions multiples du commutateur au stockage.

L'utilisation de VLANs ou de VPNs n'apporte pas de solution adéquate au problème du surabonnement des liens en configurations partagées. Les VLANs et autres partitionnements virtuels d'un réseau fournissent un moyen de concevoir logiquement un réseau. Toutefois, ils ne modifient pas les capacités physiques des liens et des transmissions entre les commutateurs. Lorsque le trafic de stockage et les autres trafics sur le réseau partagent des connexions physiques, le surabonnement et la perte de paquets peuvent devenir possibles. Cela est aussi vrai pour les VLANs qui partagent des transmissions intercommutateur. La conception des performances pour un SAN doit prendre en compte les limitations physiques du réseau, pas les allocations logiques.

Consultation des statistiques des commutateurs Ethernet

Souvent les commutateurs ethernet fournissent des moyens de surveiller leur bon fonctionnement.

Les commutateurs dont certains ports opèrent à débit maximal souvent n'assurent pas une performance optimale. Si vous avez des ports dans votre SAN iSCSI opérant presque au maximum, réduisez leur charge. Si le port est connecté à un système ESXi ou à un stockage iSCSI, vous pouvez réduire sa charge par équilibrage de charge manuel.

Si le port est connecté entre de nombreux commutateurs ou routeurs, pensez à installer des liens supplémentaires entre ces composants afin de pouvoir gérer une plus grande charge. Les commutateurs ethernet fournissent aussi fréquemment des informations sur les erreurs de transmission, les paquets en file d'attente, et les paquets ethernet abandonnés. Si le commutateur rapporte régulièrement de telles conditions pour les ports utilisés par le trafic iSCSI, la performance du SAN iSCSI sera réduite.