Découvrez comment déployer un Superviseur avec la pile de mise en réseau VDS sur trois zones vSphere. Chaque zone vSphere est mappé à un cluster vSphere. En déployant le Superviseur sur trois zones vSphere, vous fournissez une haute disponibilité à vos charges de travail au niveau du cluster. Un Superviseur configuré avec la mise en réseau VDS prend en charge les clusters et les machines virtuelles Tanzu Kubernetes Grid créés via le service de machine virtuelle. Il ne prend pas en charge les Espaces vSphere.

Conditions préalables

- Répondez aux conditions préalables requises pour configurer un cluster vSphere en tant que Superviseur. Reportez-vous à la section Conditions préalables la configuration de vSphere IaaS control plane sur des clusters vSphere.

- Créez trois zones vSphere. Reportez-vous à la section Créer des zones vSphere pour un déploiement de Superviseur de plusieurs zones.

Procédure

- Dans le menu d'accueil, sélectionnez Gestion de la charge de travail.

- Sélectionnez une option d'attribution de licence pour le Superviseur.

-

Si vous disposez d'une licence valide pour l'édition Tanzu, cliquez sur Ajouter une licence pour ajouter la clé de licence à l'inventaire de licences de vSphere.

-

Si vous ne disposez pas encore d'une licence pour l'édition Tanzu, renseignez les détails de contact afin de pouvoir recevoir des communications de VMware et cliquez sur Prise en main.

La période d'évaluation d'un Superviseur est de 60 jours. Dans ce délai, vous devez attribuer au cluster une licence valide pour l'édition Tanzu. Si vous avez ajouté une clé de licence pour l'édition Tanzu, vous pouvez l'attribuer dans la période d'évaluation de 60 jours une fois que vous avez terminé la configuration du Superviseur.

-

- Sur l'écran Gestion de la charge de travail, cliquez de nouveau sur Prise en main.

- Sélectionnez la page vCenter Server et réseau, sélectionnez le système vCenter Server configuré pour le déploiement du Superviseur, sélectionnez vSphere Distributed Switch (VDS) comme pile de mise en réseau, puis cliquez sur Suivant.

- Sur la page Emplacement du superviseur, sélectionnez déploiement de zone vSphere pour déployer un Superviseur sur trois zones vSphere.

- Entrez le nom du nouveau Superviseur.

- Sélectionnez le centre de données dans lequel vous avez créé les zones vSphere pour le déploiement du Superviseur.

- Dans la liste des zones vSphere compatibles, sélectionnez trois zones.

- Cliquez sur Suivant.

- Sur la page Stockage, configurez le stockage pour le placement des machines virtuelles du plan de contrôle.

Option Description Nœud de plan de contrôle

Sélectionnez la stratégie de stockage pour le placement des machines virtuelles du plan de contrôle.

- Dans l'écran Équilibrage de charge, configurez les paramètres de l'équilibrage de charge.

- Entrez un nom pour l'équilibrage de charge.

- Sélectionnez le type d'équilibrage de charge.

Vous pouvez effectuer le sélectionner dans Équilibrage de charge NSX ou HAProxy.

- Configurer les paramètres de l'équilibrage de charge

-

Entrez les paramètres suivants pour NSX Advanced Load Balancer :

Option

Description

Nom Entrez un nom pour le dispositif NSX Advanced Load Balancer.

Point de terminaison du contrôleur NSX Advanced Load Balancer Adresse IP du contrôleur NSX Advanced Load Balancer.

Le port par défaut est

443.Nom d'utilisateur Nom d'utilisateur configuré avec NSX Advanced Load Balancer. Vous utilisez ce nom d'utilisateur pour accéder au contrôleur.

Mot de passe Mot de passe du nom d'utilisateur.

Certificat de serveur Certificat utilisé par le contrôleur.

Vous pouvez fournir le certificat que vous avez attribué lors de la configuration.

Pour plus d'informations, consultez Attribuer un certificat au contrôleur.

Nom du cloud Entrez le nom du cloud personnalisé que vous avez configuré. Notez que le nom du cloud est sensible à la casse. Pour utiliser Default-Cloud, laissez ce champ vide.

Pour plus d'informations, consultez Configurer le contrôleur.

-

Entrez les paramètres suivants pour HAProxy :

Option

Description

Point de terminaison du contrôleur d'équilibrage de charge HAProxy Adresse IP et port de l'API du plan de données HAProxy, qui est l'adresse IP de gestion du dispositif HAProxy. Ce composant contrôle le serveur HAProxy et s'exécute dans la machine virtuelle HAProxy.

Nom d'utilisateur Nom d'utilisateur configuré avec le fichier OVA HAProxy. Utilisez ce nom pour vous authentifier dans l'API du plan de données HAProxy.

Mot de passe Mot de passe du nom d'utilisateur.

Plages d'adresses IP virtuelles Plage d'adresses IP utilisée dans le réseau de charge de travail par les clusters Tanzu Kubernetes. Cette plage d'adresses IP provient de la liste des adresses IP qui ont été définies dans le CIDR que vous avez configuré lors du déploiement du dispositif HAProxy. Vous pouvez définir l'intégralité de la plage configurée dans le déploiement HAProxy, mais vous pouvez également définir un sous-ensemble de ce CIDR si vous souhaitez créer plusieurs Superviseurs et utiliser des adresses IP à partir de cette plage DE CIDR. Cette plage ne doit pas chevaucher la plage d'adresses IP définie pour le réseau de charge de travail dans cet assistant. La plage ne doit pas non plus chevaucher une portée DHCP sur ce réseau de charge de travail.

Certificat TLS de gestion HAProxy Certificat au format PEM qui est signé ou est une racine approuvée du certificat de serveur que l'API du plan de données présente.

-

Option 1 : Si l'accès racine est activé, effectuez un SSH vers la machine virtuelle HAProxy en tant que racine et copiez

/etc/haproxy/ca.crtvers l'Autorité de certification du serveur. N'utilisez pas de lignes d'échappement au format\n. -

Option 2 : cliquez avec le bouton droit sur la machine virtuelle HAProxy et sélectionnez Modifier les paramètres. Copiez le certificat d'autorité de certification à partir du champ approprié et convertissez-le à partir de Base64 à l'aide d'un outil de conversion tel que https://www.base64decode.org/.

-

Option 3 : exécutez le script PowerCLI suivant. Remplacez les variables

$vc,$vc_useret$vc_passwordpar des valeurs appropriées.$vc = "10.21.32.43" $vc_user = "[email protected]" $vc_password = "PASSWORD" Connect-VIServer -User $vc_user -Password $vc_password -Server $vc $VMname = "haproxy-demo" $AdvancedSettingName = "guestinfo.dataplaneapi.cacert" $Base64cert = get-vm $VMname |Get-AdvancedSetting -Name $AdvancedSettingName while ([string]::IsNullOrEmpty($Base64cert.Value)) { Write-Host "Waiting for CA Cert Generation... This may take a under 5-10 minutes as the VM needs to boot and generate the CA Cert (if you haven't provided one already)." $Base64cert = get-vm $VMname |Get-AdvancedSetting -Name $AdvancedSettingName Start-sleep -seconds 2 } Write-Host "CA Cert Found... Converting from BASE64" $cert = [Text.Encoding]::Utf8.GetString([Convert]::FromBase64String($Base64cert.Value)) Write-Host $cert

-

-

- Dans l'écran Réseau de gestion, configurez les paramètres du réseau qui sera utilisé pour les machines virtuelles du plan de contrôle Kubernetes.

- Sélectionnez un Mode réseau.

- Réseau DHCP. Dans ce mode, toutes les adresses IP du réseau de gestion, telles que les adresses IP de machine virtuelle du plan de contrôle, une adresse IP flottante, les serveurs DNS, les domaines DNS et de recherche et le serveur NTP, sont acquises automatiquement à partir d'un serveur DHCP. Pour obtenir des adresses IP flottantes, le serveur DHCP doit être configuré pour prendre en charge les identifiants de client. En mode DHCP, toutes les machines virtuelles du plan de contrôle utilisent des identifiants de client DHCP stables pour acquérir des adresses IP. Ces identifiants de client peuvent être utilisés pour configurer l'attribution d'adresses IP statiques pour les adresses IP des machines virtuelles du plan de contrôle sur le serveur DHCP afin de s'assurer qu'elles ne sont pas modifiées. La modification des adresses IP des machines virtuelles du plan de contrôle et des adresses IP flottantes n'est pas prise en charge.

Vous pouvez remplacer certains des paramètres hérités de DHCP en entrant des valeurs dans les champs de texte pour ces paramètres.

Option Description Réseau Sélectionnez le réseau qui gérera le trafic de gestion du Superviseur Adresse IP flottante Entrez une adresse IP qui détermine le point de départ pour la réservation de cinq adresses IP successives pour les machines virtuelles du plan de contrôle Kubernetes comme suit :

-

Une adresse IP pour chacune des machines virtuelles du plan de contrôle Kubernetes.

-

Une adresse IP flottante pour l'une des machines virtuelles du plan de contrôle Kubernetes devant être utilisée comme interface au réseau de gestion. La machine virtuelle du plan de contrôle à laquelle l'adresse IP flottante est attribuée est utilisée comme machine virtuelle principale pour les trois machines virtuelles du plan de contrôle Kubernetes. L'adresse IP flottante se déplace vers le nœud du plan de contrôle qui est le leader etcd dans le cluster Kubernetes. Cela améliore la disponibilité dans le cas d'un événement de partition de réseau.

-

Une adresse IP à utiliser comme tampon dans le cas où une machine virtuelle du plan de contrôle Kubernetes tombe en panne et qu'une nouvelle machine virtuelle du plan de contrôle est introduite pour la remplacer.

Serveurs DNS Entrez les adresses des serveurs DNS que vous utilisez dans votre environnement. Si le système vCenter Server est enregistré avec un nom de domaine complet, vous devez entrer les adresses IP des serveurs DNS que vous utilisez avec l'environnement vSphere afin que le nom de domaine complet soit résolu dans le Superviseur. Domaines de recherche DNS Entrez les noms de domaine que le DNS recherche dans les nœuds du plan de contrôle Kubernetes, tels que corp.local, afin que le serveur DNS puisse les résoudre. Serveurs NTP Entrez les adresses des serveurs NTP que vous utilisez dans votre environnement, le cas échéant. -

- Statique. Entrez manuellement tous les paramètres de mise en réseau du réseau de gestion.

Option Description Réseau Sélectionnez le réseau qui gérera le trafic de gestion du Superviseur Adresse IP de départ Entrez une adresse IP qui détermine le point de départ pour la réservation de cinq adresses IP successives pour les machines virtuelles du plan de contrôle Kubernetes comme suit :

-

Une adresse IP pour chacune des machines virtuelles du plan de contrôle Kubernetes.

-

Une adresse IP flottante pour l'une des machines virtuelles du plan de contrôle Kubernetes devant être utilisée comme interface au réseau de gestion. La machine virtuelle du plan de contrôle à laquelle l'adresse IP flottante est attribuée est utilisée comme machine virtuelle principale pour les trois machines virtuelles du plan de contrôle Kubernetes. L'adresse IP flottante se déplace vers le nœud du plan de contrôle qui est le leader etcd dans le cluster Kubernetes. Cela améliore la disponibilité dans le cas d'un événement de partition de réseau.

-

Une adresse IP à utiliser comme tampon dans le cas où une machine virtuelle du plan de contrôle Kubernetes tombe en panne et qu'une nouvelle machine virtuelle du plan de contrôle est introduite pour la remplacer.

Masque de sous-réseau Applicable uniquement à la configuration IP statique. Entrez le masque de sous-réseau du réseau de gestion. Par exemple,

255.255.255.0Passerelle Entrez une passerelle pour le réseau de gestion. Serveurs DNS Entrez les adresses des serveurs DNS que vous utilisez dans votre environnement. Si le système vCenter Server est enregistré avec un nom de domaine complet, vous devez entrer les adresses IP des serveurs DNS que vous utilisez avec l'environnement vSphere afin que le nom de domaine complet soit résolu dans le Superviseur. Domaines de recherche DNS Entrez les noms de domaine que le DNS recherche dans les nœuds du plan de contrôle Kubernetes, tels que corp.local, afin que le serveur DNS puisse les résoudre. Serveurs NTP Entrez les adresses des serveurs NTP que vous utilisez dans votre environnement, le cas échéant. -

- Réseau DHCP. Dans ce mode, toutes les adresses IP du réseau de gestion, telles que les adresses IP de machine virtuelle du plan de contrôle, une adresse IP flottante, les serveurs DNS, les domaines DNS et de recherche et le serveur NTP, sont acquises automatiquement à partir d'un serveur DHCP. Pour obtenir des adresses IP flottantes, le serveur DHCP doit être configuré pour prendre en charge les identifiants de client. En mode DHCP, toutes les machines virtuelles du plan de contrôle utilisent des identifiants de client DHCP stables pour acquérir des adresses IP. Ces identifiants de client peuvent être utilisés pour configurer l'attribution d'adresses IP statiques pour les adresses IP des machines virtuelles du plan de contrôle sur le serveur DHCP afin de s'assurer qu'elles ne sont pas modifiées. La modification des adresses IP des machines virtuelles du plan de contrôle et des adresses IP flottantes n'est pas prise en charge.

- Cliquez sur Suivant.

- Sélectionnez un Mode réseau.

- Sur la page Réseau de charge de travail, entrez les paramètres du réseau qui gérera le trafic de mise en réseau pour les charges de travail Kubernetes en cours d'exécution sur le Superviseur.

Note :

Si vous choisissez d'utiliser un serveur DHCP pour fournir les paramètres de mise en réseau pour les réseaux de charge de travail, vous ne pourrez pas créer de réseaux de charge de travail après avoir terminé la configuration du Superviseur.

- Sélectionnez un mode réseau.

- Réseau DHCP. Dans ce mode réseau, tous les paramètres de mise en réseau des réseaux de charge de travail sont acquis via DHCP. Vous pouvez également remplacer certains des paramètres hérités de DHCP en entrant des valeurs dans les champs de texte pour ces paramètres :

Option Description Réseau interne pour les services Kubernetes Entrez une notation CIDR qui détermine la plage d'adresses IP plus large pour les clusters et les services Tanzu Kubernetes qui s'exécutent à l'intérieur des clusters. Groupe de ports Sélectionnez le groupe de ports qui servira de réseau de charge de travail principal au Superviseur Le réseau principal gère le trafic des machines virtuelles du plan de contrôle Kubernetes et du trafic de charge de travail Kubernetes.

En fonction de votre topologie de mise en réseau, vous pouvez attribuer ultérieurement un groupe de ports différent pour servir de réseau à chaque espace de noms. Ainsi, vous pouvez fournir l'isolation de couche 2 entre les espaces de noms dans le Superviseur. Les espaces de noms qui ne disposent pas d'un groupe de ports différent attribué comme leur réseau utilisent le réseau principal. Les clusters Tanzu Kubernetes utilisent uniquement le réseau qui est attribué à l'espace de noms dans lequel ils sont déployés ou ils utilisent le réseau principal si aucun réseau explicite n'est attribué à cet espace de noms.

Nom de réseau Entrez le nom du réseau. Serveurs DNS Entrez les adresses IP des serveurs DNS que vous utilisez avec votre environnement, le cas échéant.

Par exemple, 10.142.7.1.

Lorsque vous entrez l'adresse IP du serveur DNS, une route statique est ajoutée sur chaque machine virtuelle du plan de contrôle. Cela indique que le trafic vers les serveurs DNS passe par le réseau de charge de travail.

Si les serveurs DNS que vous spécifiez sont partagés entre le réseau de gestion et le réseau de charge de travail, les recherches DNS sur les machines virtuelles du plan de contrôle sont routées via le réseau de charge de travail après la configuration initiale.

Serveurs NTP Entrez l'adresse du serveur NTP que vous utilisez avec votre environnement. - Statique. Configurer manuellement les paramètres du réseau de charge de travail

Option Description Réseau interne pour les services Kubernetes Entrez une notation CIDR qui détermine la plage d'adresses IP plus large pour les clusters et les services Tanzu Kubernetes qui s'exécutent à l'intérieur des clusters. Groupe de ports Sélectionnez le groupe de ports qui servira de réseau de charge de travail principal au Superviseur Le réseau principal gère le trafic des machines virtuelles du plan de contrôle Kubernetes et du trafic de charge de travail Kubernetes.

En fonction de votre topologie de mise en réseau, vous pouvez attribuer ultérieurement un groupe de ports différent pour servir de réseau à chaque espace de noms. Ainsi, vous pouvez fournir l'isolation de couche 2 entre les espaces de noms dans le Superviseur. Les espaces de noms qui ne disposent pas d'un groupe de ports différent attribué comme leur réseau utilisent le réseau principal. Les clusters Tanzu Kubernetes utilisent uniquement le réseau qui est attribué à l'espace de noms dans lequel ils sont déployés ou ils utilisent le réseau principal si aucun réseau explicite n'est attribué à cet espace de noms.

Nom de réseau Entrez le nom du réseau. Plages d'adresses IP Entrez une plage d'adresses IP pour allouer l'adresse IP des machines virtuelles et des charges de travail du plan de contrôle Kubernetes. Cette plage d'adresses connecte les nœuds Superviseur et, dans le cas d'un réseau de charge de travail unique, connecte également les nœuds de cluster Tanzu Kubernetes. Cette plage d'adresses IP ne doit pas chevaucher la plage d'adresses IP virtuelles de l'équilibrage de charge lors de l'utilisation de la configuration Par défaut pour HAProxy.

Masque de sous-réseau Entrez l'adresse IP du masque du sous-réseau. Passerelle Entrez la passerelle pour le réseau principal. Serveurs NTP Entrez l'adresse du serveur NTP que vous utilisez avec votre environnement. Serveurs DNS Entrez les adresses IP des serveurs DNS que vous utilisez avec votre environnement, le cas échéant. Par exemple, 10.142.7.1.

- Réseau DHCP. Dans ce mode réseau, tous les paramètres de mise en réseau des réseaux de charge de travail sont acquis via DHCP. Vous pouvez également remplacer certains des paramètres hérités de DHCP en entrant des valeurs dans les champs de texte pour ces paramètres :

- Cliquez sur Suivant.

- Sélectionnez un mode réseau.

- Dans la page Vérifier et confirmer, faites défiler l'écran vers le haut et examinez tous les paramètres que vous avez configurés jusqu'à présent, puis définissez les paramètres avancés du déploiement Superviseur.

Option Description Taille du plan de contrôle du superviseur Sélectionnez le dimensionnement des machines virtuelles du plan de contrôle. La taille des machines virtuelles du plan de contrôle détermine la quantité de charges de travail que vous pouvez exécuter sur le Superviseur. Vous pouvez sélectionner l'une des options suivantes : - Très petite : 2 CPU, 8 Go de mémoire, 32 Go de stockage

- Petite : 4 CPU, 16 Go de mémoire, 32 Go de stockage

- Moyenne : 8 CPU, 16 Go de mémoire, 32 Go de stockage

- Grande : 16 CPU, 32 Go de mémoire, 32 Go de stockage

Note : Une fois que vous avez sélectionné une taille de plan de contrôle, vous pouvez uniquement monter en puissance. Vous ne pouvez pas baisser en charge sur une taille inférieure.Noms DNS du serveur API Si vous le souhaitez, vous pouvez entrer les noms de domaine complets qui seront utilisés pour accéder au plan de contrôle du Superviseur, au lieu d'utiliser l'adresse IP du plan de contrôle du Superviseur. Les noms de domaine complets que vous entrez seront intégrés dans un certificat généré automatiquement. En utilisant des noms de domaine complets pour le Superviseur, vous pouvez omettre de spécifier une adresse IP sand dans le certificat d'équilibreur de charge. Exporter la configuration Exportez un fichier JSON contenant les valeurs de configuration du Superviseur que vous avez entrées. Vous pouvez modifier et importer ultérieurement le fichier si vous souhaitez redéployer le Superviseur ou si vous souhaitez déployer un nouveau Superviseur avec une configuration similaire.

L'exportation de la configuration du Superviseur peut vous faire économiser du temps et éviter d'entrer à nouveau toutes les valeurs de configuration dans cet assistant en cas de redéploiement du Superviseur.

- Cliquez sur Terminer lorsque vous êtes prêt à vérifier les paramètres.

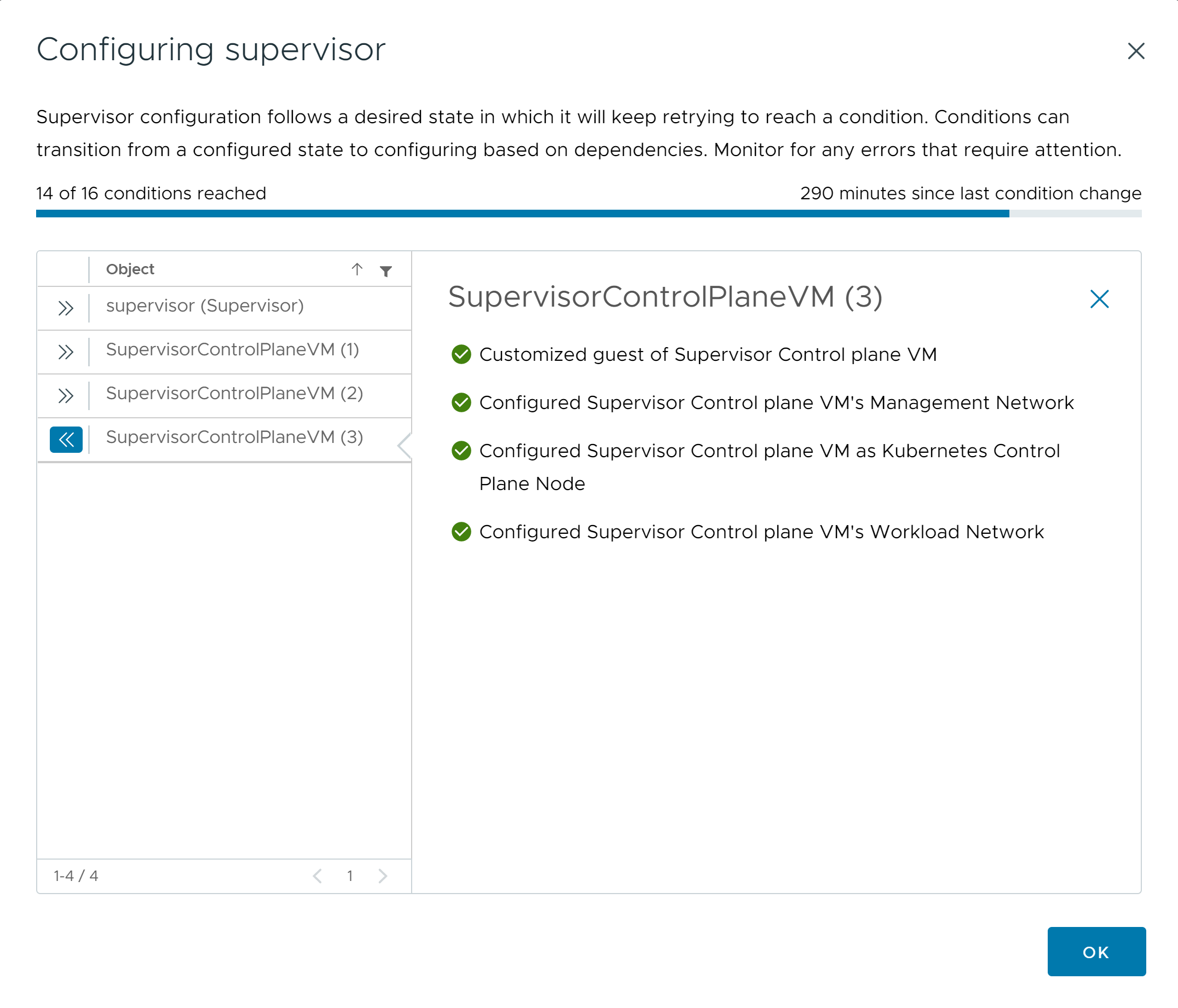

L'activation du Superviseur initie la création et la configuration des machines virtuelles du plan de contrôle et d'autres composants.

Que faire ensuite

Pour que le processus d'activation se termine, le Superviseur doit atteindre l'état souhaité, ce qui signifie que toutes les conditions sont toutes réunies. Un Superviseur est activé, son état passe de Configuration à Exécution. Lorsque le Superviseur est dans l'état Configuration, le système tente en continu de réunir chacune de ces conditions. Si une condition n'est pas atteinte, l'opération est rétentée jusqu'à ce qu'elle réussisse. C'est la raison pour laquelle le nombre de conditions qui sont atteintes peut évoluer, par exemple 10 conditions sur 16 atteintes, puis 4 conditions sur 16 atteintes etc. Dans de très rares cas, l'état peut passer à Erreur, s'il existe des erreurs qui empêchent d'atteindre l'état souhaité.

Pour plus d'informations sur les erreurs d'activation et sur leur dépannage, reportez-vous à la section Résolution des erreurs d'état de santé sur le cluster superviseur lors de la configuration initiale ou de la mise à niveau.

Si vous souhaitez tenter de redéployer le Superviseur en modifiant les valeurs de configuration que vous avez entrées dans l'assistant, consultez Déployer un Superviseur en important un fichier de configuration JSON.