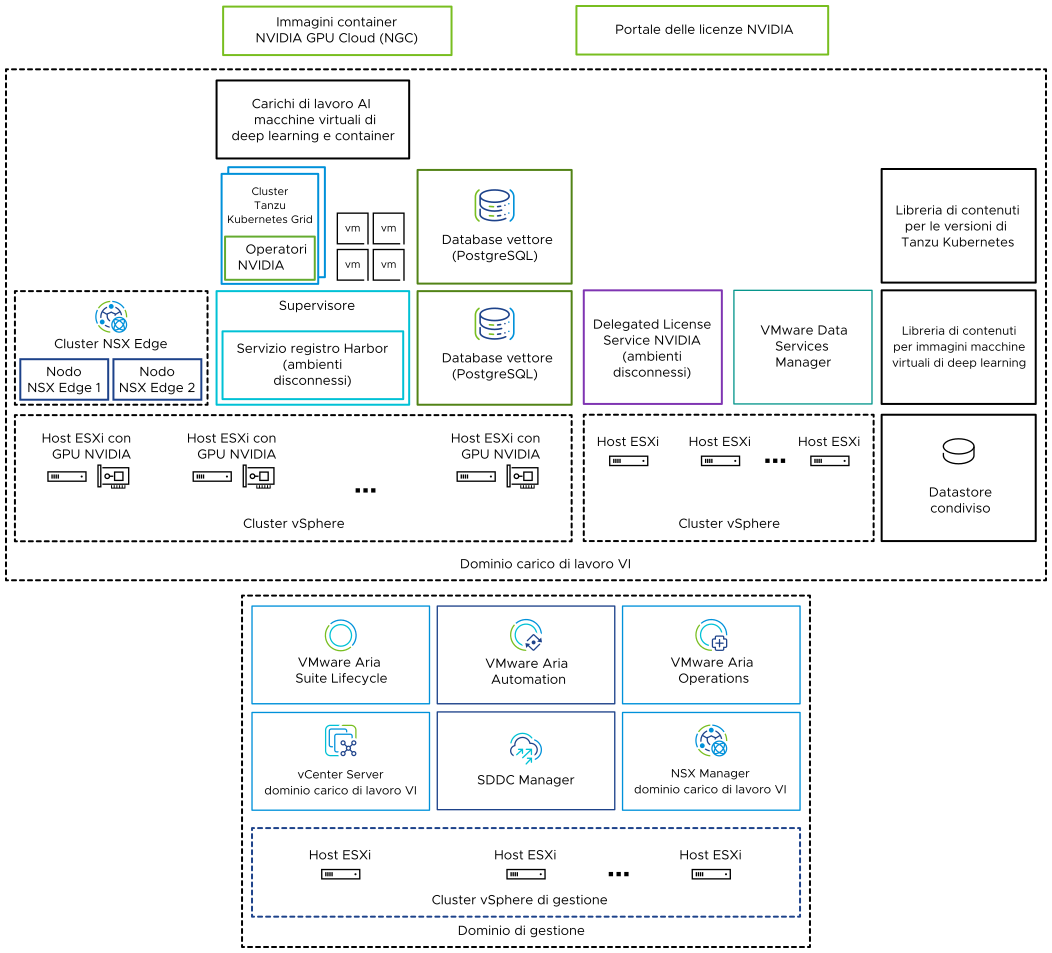

Poiché è una soluzione che include più componenti, VMware Private AI Foundation with NVIDIA può essere utilizzato per eseguire carichi di lavoro di AI generativa utilizzando l'elaborazione accelerata di NVIDIA, nonché la gestione dell'infrastruttura virtuale e la gestione del cloud di VMware Cloud Foundation.

VMware Private AI Foundation with NVIDIA fornisce una piattaforma per il provisioning dei carichi di lavoro AI negli host ESXi con GPU NVIDIA. Inoltre, l'esecuzione dei carichi di lavoro AI basati su container NVIDIA GPU Cloud (NGC) è convalidata in modo specifico da VMware.

VMware Private AI Foundation with NVIDIA supporta due casi d'uso:

- Caso d'uso di sviluppo

- Gli amministratori del cloud e i tecnici DevOps possono eseguire il provisioning dei carichi di lavoro AI, tra cui RAG (Retrieval-Augmented Generation), sotto forma di macchine virtuali di deep learning. I data scientist possono utilizzare queste macchine virtuali di deep learning per lo sviluppo di AI.

- Caso d'uso di produzione

- Gli amministratori del cloud possono fornire ai tecnici DevOps un ambiente VMware Private AI Foundation with NVIDIA per il provisioning di carichi di lavoro AI pronti per la produzione nei cluster Tanzu Kubernetes Grid (TKG) in vSphere with Tanzu.

Licenze

Per accedere alle funzionalità seguenti, è necessaria la licenza del componente aggiuntivo VMware Private AI Foundation with NVIDIA:

- Configurazione di Private AI in VMware Aria Automation per gli elementi catalogo, per semplificare il provisioning delle macchine virtuali di deep learning con accelerazione GPU e dei cluster TKG.

- Provisioning dei database PostgreSQL con l'estensione pgvector con il supporto Enterprise.

- Distribuzione e utilizzo dell'immagine della macchina virtuale di deep learning fornita da VMware by Broadcom.

È possibile distribuire carichi di lavoro AI con e senza il supervisore abilitato e utilizzare le metriche di GPU in vCenter Server e VMware Aria Operations con la licenza di VMware Cloud Foundation.

I componenti software NVIDIA sono disponibili per l'uso con una licenza di NVIDIA AI Enterprise.

Quali sono i componenti di VMware Private AI Foundation with NVIDIA?

| Componente | Descrizione |

|---|---|

| Host ESXi abilitati per GPU | Host ESXi configurati nel modo seguente:

|

| Supervisore | Uno o più cluster vSphere abilitati per vSphere with Tanzu in modo che sia possibile eseguire macchine virtuali e container in vSphere utilizzando l'API di Kubernetes. Un supervisore stesso è un cluster Kubernetes che funge da piano di controllo per gestire i cluster del carico di lavoro e le macchine virtuali. |

| Registro Harbor | Registro immagini locale in un ambiente disconnesso in cui vengono ospitate le immagini del container scaricate dal catalogo NVIDIA NGC. |

| Cluster NSX Edge | Cluster di nodi NSX Edge che fornisce il routing nord-sud a 2 livelli per il supervisore e i carichi di lavoro che esegue. Il gateway di livello 0 nel cluster NSX Edge è in modalità attivo-attivo. |

| Operatori NVIDIA |

|

| Database vettore | Database PostgreSQL in cui è abilitata l'estensione pgvector in modo che sia possibile utilizzarlo nei carichi di lavoro AI Retrieval Augmented Generation (RAG). |

|

Utilizzare il portale delle licenze NVIDIA per generare un token di configurazione client per assegnare una licenza al driver guest della vGPU nella macchina virtuale di deep learning e agli operatori della GPU nei cluster TKG. In un ambiente disconnesso o per fare in modo che i carichi di lavoro ricevano informazioni sulla licenza senza utilizzare una connessione Internet, ospitare localmente le licenze NVIDIA in un'appliance DLS (Delegated License Service). |

| Libreria di contenuti | Nelle librerie di contenuti vengono archiviate le immagini per le macchine virtuali di deep learning e per le versioni di Tanzu Kubernetes. Utilizzare queste immagini per la distribuzione dei carichi di lavoro AI nell'ambiente VMware Private AI Foundation with NVIDIA. In un ambiente connesso le librerie di contenuti estraggono i loro contenuti dalle librerie di contenuti pubbliche gestite da VMware. In un ambiente disconnesso è necessario caricare manualmente le immagini richieste o estrarle da un server mirror della libreria di contenuti interna. |

| Catalogo NVIDIA GPU Cloud (NGC) | Portale per container AI e ML ottimizzati per GPU che sono testati e pronti per l'esecuzione nelle GPU NVIDIA supportate in locale oltre a VMware Private AI Foundation with NVIDIA. |

In qualità di amministratore del cloud, utilizzare i componenti di gestione in VMware Cloud Foundation

| Componente di gestione | Descrizione |

|---|---|

| SDDC Manager | Utilizzare SDDC Manager per le attività seguenti:

|

| vCenter Server del dominio del carico di lavoro VI | Utilizzare questa istanza di vCenter Server per abilitare e configurare un supervisore. |

| NSX Manager del dominio carico di lavoro VI | SDDC Manager utilizza questa istanza di NSX Manager per distribuire e aggiornare i cluster NSX Edge. |

| VMware Aria Suite Lifecycle | Utilizzare VMware Aria Suite Lifecycle per distribuire e aggiornare VMware Aria Automation e VMware Aria Operations. |

| VMware Aria Automation | Utilizzare VMware Aria Automation per aggiungere elementi catalogo self-service per la distribuzione dei carichi di lavoro AI per i tecnici DevOps e i data scientist. |

| VMware Aria Operations | Utilizzare VMware Aria Operations per monitorare l'utilizzo della GPU nei domini del carico di lavoro abilitati per GPU. |

| VMware Data Services Manager | Utilizzare VMware Data Services Manager per creare database vettore, ad esempio un database PostgreSQL con estensione pgvector. |