In un ambiente vSphere with Tanzu, un Cluster supervisore può utilizzare lo stack di rete di vSphere oppure VMware NSX-T Data Center™ per fornire connettività ai carichi di lavoro, ai servizi e alle macchine virtuali del piano di controllo di Kubernetes. Quando un Cluster supervisore è configurato con lo stack di rete di vSphere, tutti gli host del cluster sono connessi a un vSphere Distributed Switch, che fornisce connettività ai carichi di lavoro di Kubernetes e alle macchine virtuali del piano di controllo. Un Cluster supervisore che utilizza lo stack di rete di vSphere richiede un bilanciamento del carico nella rete di gestione del vCenter Server per fornire connettività ai servizi esterni e agli utenti DevOps. Un Cluster supervisore configurato con VMware NSX-T Data Center™ utilizza le reti basate su software della soluzione, nonché un bilanciamento del carico NSX Edge per fornire connettività ai servizi esterni e agli utenti DevOps.

Rete del Cluster supervisore con NSX-T Data Center

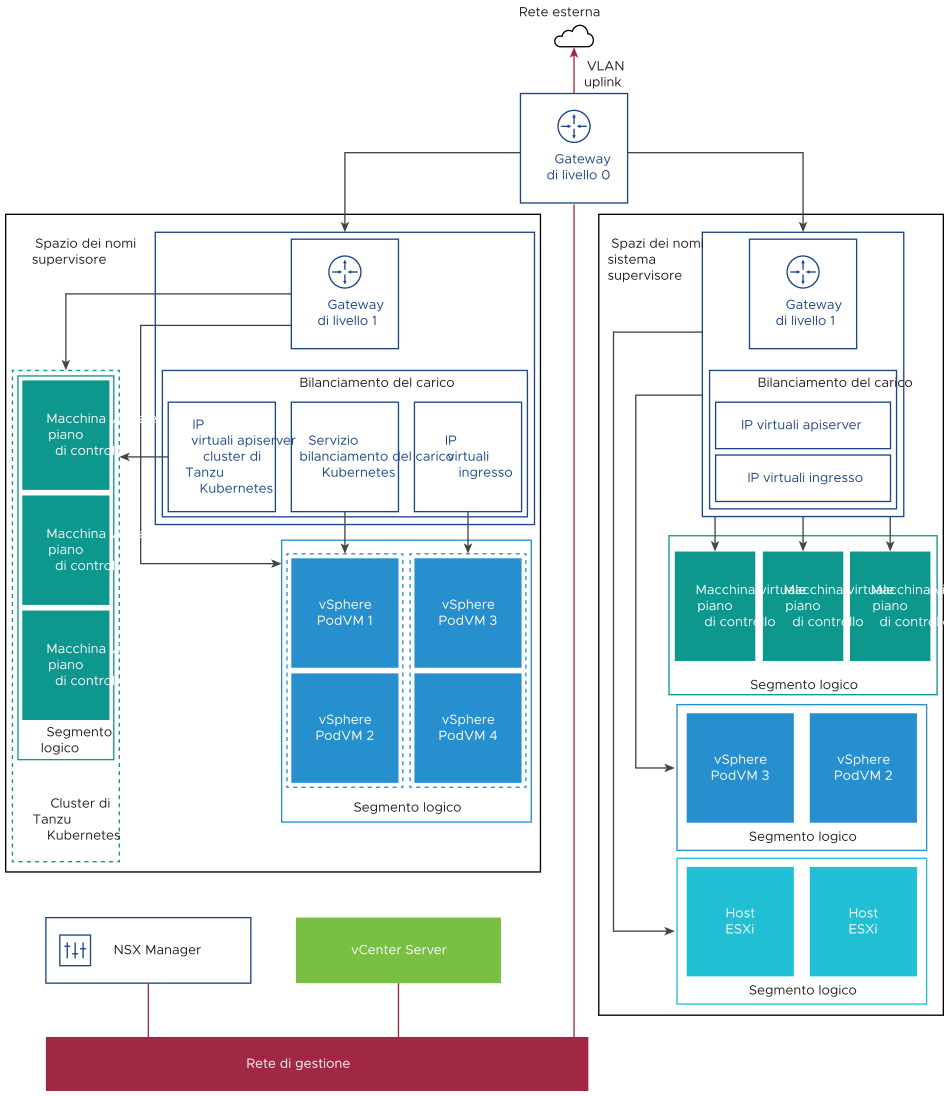

VMware NSX-T Data Center™ fornisce connettività di rete agli oggetti nel Cluster supervisore e nelle reti esterne. La connettività agli host ESXi che comprendono il cluster è gestita dalle reti di vSphere standard.

È inoltre possibile configurare manualmente le reti del Cluster supervisore utilizzando una distribuzione NSX-T Data Center esistente o distribuendo una nuova istanza di NSX-T Data Center.

| vSphere with Tanzu | NSX-T Data Center |

|---|---|

| Versione 7.0 Update 3 | Versioni 3.0, 3.0.x, 3.1, 3.1.1, 3.1.2 e 3.1.3. |

| Versione 7.0 Update 2 | Versioni 3.0, 3.0.x, 3.1, 3.1.1 e 3.1.2. |

| Versione 7.0 Update 1c | Versioni 3.0, 3.0.x, 3.1 e 3.1.1. |

| Versione 7.0 Update 1 | Versioni 3.0, 3.0.1, 3.0.1.1 e 3.0.2. |

| Versione 7.0 | Versione 3.0. |

In questa sezione viene descritta la topologia di rete quando si installa e si configura vSphere with Tanzu versione 7.0 Update 2. Per informazioni sull'aggiornamento quando si esegue l'aggiornamento da vSphere with Tanzu versione 7.0 Update 1 alla versione 7.0 Update 2, vedere Aggiornamento della topologia di rete.

- NSX Container Plug-in (NCP) fornisce l'integrazione tra NSX-T Data Center e Kubernetes. Il componente principale di NCP viene eseguito in un container e comunica con NSX Manager e con il piano di controllo di Kubernetes. NCP monitora le modifiche apportate ai container e alle altre risorse e gestisce le risorse di rete come porte logiche, segmenti, router e gruppi di sicurezza per i container chiamando NSX API.

Per impostazione predefinita, NCP crea un gateway di livello 1 condiviso per gli spazi dei nomi del sistema e il bilanciamento del carico e un gateway di livello 1 per ogni spazio dei nomi. Il gateway di livello 1 è connesso al gateway di livello 0 e a un segmento predefinito.

Gli spazi dei nomi del sistema sono spazi dei nomi utilizzati dai componenti principali che sono fondamentali per il funzionamento del cluster supervisore e di Tanzu Kubernetes. Le risorse di rete condivise che includono il gateway di livello 1, il bilanciamento del carico e l'IP SNAT sono raggruppate in uno spazio dei nomi del sistema.

- NSX Edge fornisce connettività da reti esterne a oggetti Cluster supervisore. Il cluster di NSX Edge include un bilanciamento del carico che fornisce una ridondanza ai server dell'API Kubernetes che si trovano nelle macchine virtuali del piano di controllo e a qualsiasi applicazione che deve essere pubblicata e accessibile dall'esterno del Cluster supervisore.

- Un gateway di livello 0 viene associato al cluster di NSX Edge per fornire il routing alla rete esterna. L'interfaccia di uplink utilizza il protocollo di routing dinamico, BGP o il routing statico.

- Ogni Spazio dei nomi vSphere dispone di una rete separata e di un set di risorse di rete condivise dalle applicazioni nello spazio dei nomi, ad esempio, gateway di livello 1, servizio di bilanciamento del carico e indirizzo IP SNAT.

- I carichi di lavoro in esecuzione in pod vSphere, macchine virtuali normali o cluster di Tanzu Kubernetes, che si trovano nello stesso spazio dei nomi, condividono lo stesso IP SNAT per la connettività nord-sud.

- I carichi di lavoro in esecuzione in pod vSphere o in cluster di Tanzu Kubernetes avranno la stessa regola di isolamento implementata dal firewall predefinito.

- Non è necessario un IP SNAT separato per ogni spazio dei nomi Kubernetes. La connettività est-ovest tra gli spazi dei nomi non sarà SNAT.

- I segmenti per ogni spazio dei nomi risiedono nel vSphere Distributed Switch (VDS) in modalità standard associato al cluster NSX Edge. Il segmento fornisce una rete di overlay al Cluster supervisore.

- I cluster supervisore hanno segmenti separati all'interno del gateway di livello 1 condiviso. Per ogni cluster Tanzu Kubernetes, i segmenti vengono definiti all'interno del gateway di livello 1 dello spazio dei nomi.

- I processi Spherelet in ogni host ESXi comunicano con il vCenter Server tramite un'interfaccia nella rete di gestione.

Per maggiori informazioni sulla rete del Cluster supervisore, guardare il video vSphere 7 with Kubernetes Network Service - Part 1 - The Supervisor Cluster.

Metodi di configurazione di rete con NSX-T Data Center

- Il modo più semplice per configurare i servizi di rete del Cluster supervisore consiste nell'utilizzare VMware Cloud Foundation SDDC Manager. Per ulteriori informazioni, vedere la documentazione della VMware Cloud Foundation SDDC Manager. Per informazioni, vedere Working with Workload Management.

- È inoltre possibile configurare manualmente le reti del Cluster supervisore utilizzando una distribuzione NSX-T Data Center esistente o distribuendo una nuova istanza di NSX-T Data Center. Per ulteriori informazioni, vedere Installare e configurare NSX-T Data Center per vSphere with Tanzu.

Rete del Cluster supervisore con vSphere Distributed Switch

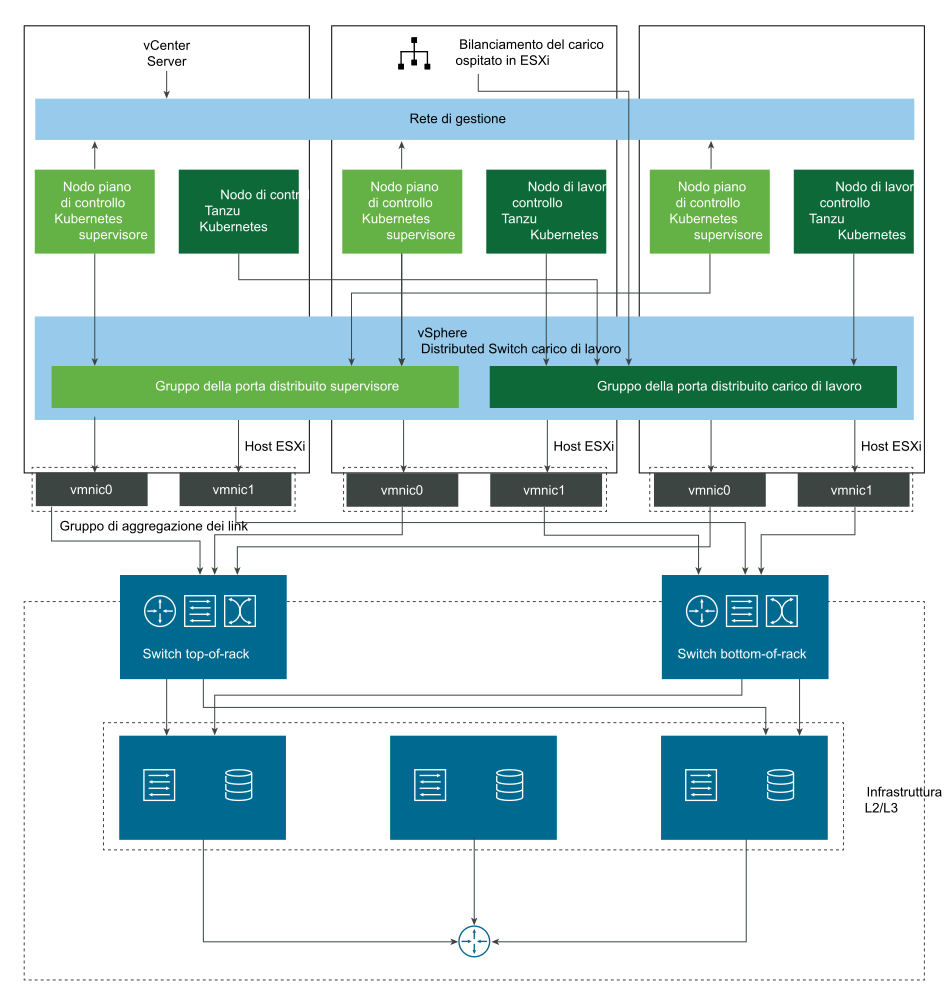

Un Cluster supervisore supportato da un vSphere Distributed Switch utilizza gruppi di porte distribuiti come reti del carico di lavoro per gli spazi dei nomi.

In base alla topologia implementata per il Cluster supervisore, è possibile utilizzare uno o più gruppi di porte distribuiti come reti del carico di lavoro. La rete che fornisce la connettività alle macchine virtuali del piano di controllo Kubernetes è denominata rete del carico di lavoro primaria. Questa rete può essere assegnata a tutti gli spazi dei nomi nel Cluster supervisore oppure è possibile utilizzare reti diverse per ogni spazio dei nomi. I cluster di Tanzu Kubernetes si connettono alla rete del carico di lavoro assegnata allo spazio dei nomi in cui si trovano i cluster.

Un Cluster supervisore supportato da un vSphere Distributed Switch utilizza un bilanciamento del carico per fornire connettività ai servizi esterni e agli utenti DevOps. È possibile utilizzare NSX Advanced Load Balancer o il bilanciamento del carico HAProxy.

Per ulteriori informazioni, vedere Configurazione di rete vSphere e NSX Advanced Load Balancer per vSphere with Tanzu e Installare e configurare il bilanciamento del carico HAProxy.