クラウド管理者が VMware Aria Automation で Private AI Automation Services を設定している場合は、Automation Service Broker カタログを使用して AI ワークロードを申請できます。

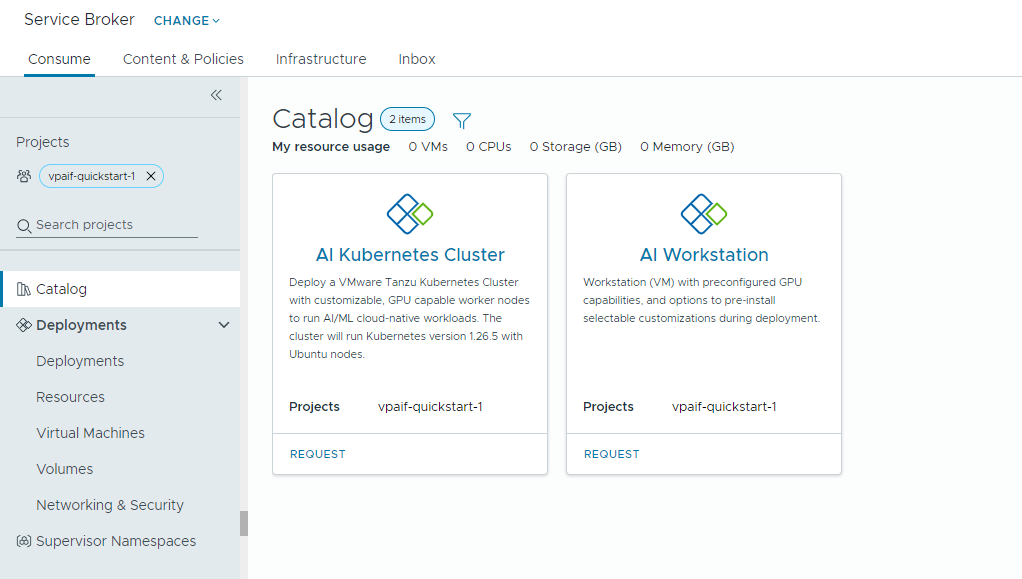

Private AI Automation Services では、それぞれの権限を持つユーザーがアクセスして申請できる Automation Service Broker の 2 つのカタログ アイテムがサポートされます。

- AI Workstation - NVIDIA から目的の vCPU、vGPU、メモリ、AI/ML ソフトウェアを使用して構成できる GPU 対応の仮想マシン。

- AI Kubernetes クラスタ - NVIDIA GPU オペレータを使用して構成できる GPU 対応の Tanzu Kubernetes クラスタ。

開始する前に

- プロジェクトに Private AI Automation Services が構成されており、AI カタログ アイテムを申請する権限があることを確認します。

ここでのすべての値は、使用事例で使用されるサンプルです。アカウントの値は環境によって異なります。

VI ワークロード ドメインへのディープ ラーニング仮想マシンの展開

データ サイエンティストは、セルフサービス Automation Service Broker カタログから単一の GPU Software-Defined 開発環境を展開できます。マシン パラメータを使用して GPU 対応の仮想マシンをカスタマイズし、開発要件のモデル化、トレーニングと推論の要件を満たす AI/ML ソフトウェア構成の指定、ポータル アクセス キーを介した NVIDIA NGC レジストリからの AI/ML パッケージの指定を行うことができます。

手順

AI 対応の Tanzu Kubernetes クラスタの展開

DevOps エンジニアは、ワーカー ノードが AI/ML ワークロードを実行できる GPU 対応の Tanzu Kubernetes クラスタを申請できます。

TKG クラスタには NVIDIA GPU オペレータが含まれています。これは、TKG クラスタ ノードで NVIDIA GPU ハードウェアに適した NVIDIA ドライバを設定する Kubernetes Operator です。展開されたクラスタはすぐに AI/ML ワークロードに使用できます。追加の GPU 関連の設定は必要ありません。

手順

- [AI Kubernetes クラスタ] カードを見つけて、[申請] をクリックします。

- プロジェクトを選択します。

- 展開の名前と説明を入力します。

- コントロール ペイン ノードの数を選択します。

設定 サンプル値 ノード数 1 仮想マシン クラス cpu-only-medium - 8 CPU、16 GB のメモリ 選択したクラスによって、仮想マシン内で使用可能なリソースが決まります。

- ワーカー ノードの数を選択します。

設定 説明 ノード数 3 仮想マシン クラス a100-medium - 4 vGPU (64 GB)、16 CPU、32 GB のメモリ - [送信] をクリックします。

結果

展開には、スーパーバイザー名前空間、3 台のワーカー ノードを持つ TKG クラスタ、TKG クラスタ内の複数のリソース、GPU オペレータ アプリケーションを展開する carvel アプリケーションが含まれています。

Private AI 展開の監視

[展開] 画面を使用して、展開および関連付けられたリソースの管理、展開の変更、失敗した展開のトラブルシューティング、リソースの変更、および使用されていない展開の削除を実行します。

展開を管理するには、 の順に選択します。

詳細については、Automation Service Broker 展開の管理方法を参照してください。