クラウド管理者が VMware Aria Automation で Private AI Automation Services を設定している場合は、Automation Service Broker カタログを使用して AI ワークロードにアクセスしたり、AI ワークロードを申請したりできます。

注: このドキュメントは、

VMware Aria Automation 8.18 に基づいています。

VMware Aria Automation 8.18.1 の

VMware Private AI Foundation 機能については、

VMware Private AI Foundation with NVIDIA ドキュメントを参照してください。

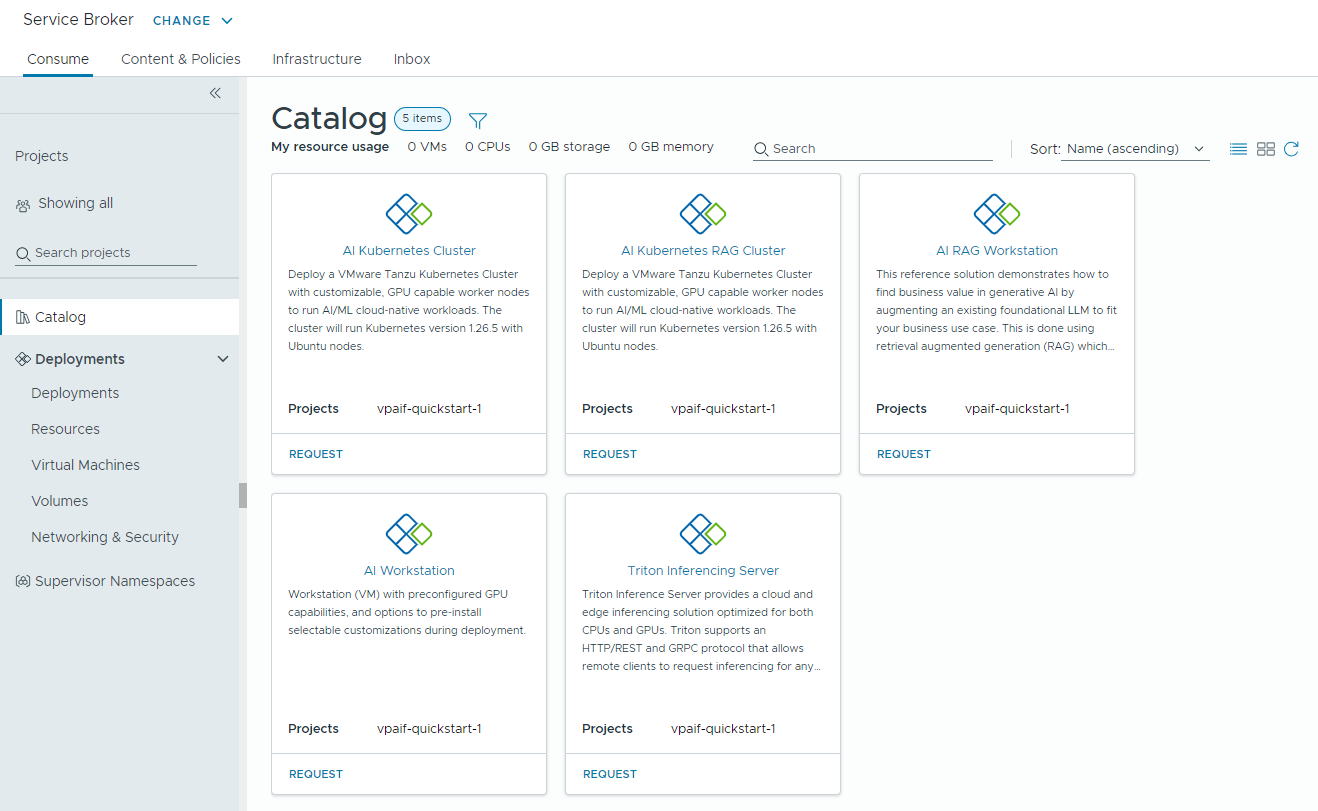

データ サイエンティストや DevOps エンジニアは、次の

Private AI Automation Services カタログ アイテムを申請できます。

- [AI Workstation] - 目的の vCPU、vGPU、メモリ、および AI/ML フレームワーク(PyTorch、CUDA Samples、TensorFlow など)を事前にインストールするオプションを使用して構成できる GPU 対応の仮想マシン。

- [AI RAG Workstation] - 取得拡張生成 (RAG) リファレンス ソリューションを持つ GPU 対応の仮想マシン。

- [Triton 推論サーバ] - NVIDIA Triton 推論サーバを持つ GPU 対応の仮想マシン。

- [AI Kubernetes クラスタ] - AI/ML クラウド ネイティブ ワークロードを実行するための GPU 対応のワーカー ノードを持つ VMware Tanzu Kubernetes Grid クラスタ。

- [AI Kubernetes RAG クラスタ] - リファレンス RAG ソリューションを実行するための GPU 対応のワーカー ノードを持つ VMware Tanzu Kubernetes Grid クラスタ。

開始する前に

- クラウド管理者がプロジェクト用の Private AI Automation Services を構成済みであることを確認します。

- AI カタログ アイテムを申請する権限があることを確認します。

Private AI Automation Services カタログ アイテムにアクセスする方法

Automation Service Broker で、[使用] タブを開いて [カタログ] をクリックします。使用可能なカタログ アイテムは、選択したプロジェクトに基づいて異なります。プロジェクトを選択しなかった場合は、使用可能なすべてのカタログ アイテムがカタログに表示されます。

このセクションで説明する手順に示されている値はすべて、使用事例で使用されるサンプルです。アカウントの値は環境によって異なります。

Private AI 展開を監視する方法

Automation Service Broker の [展開] 画面を使用して、展開および関連付けられたリソースの管理、展開の変更、失敗した展開のトラブルシューティング、リソースの変更、および使用されていない展開の削除を実行します。

展開を管理するには、 の順に選択します。

詳細については、Automation Service Broker 展開の管理方法を参照してください。