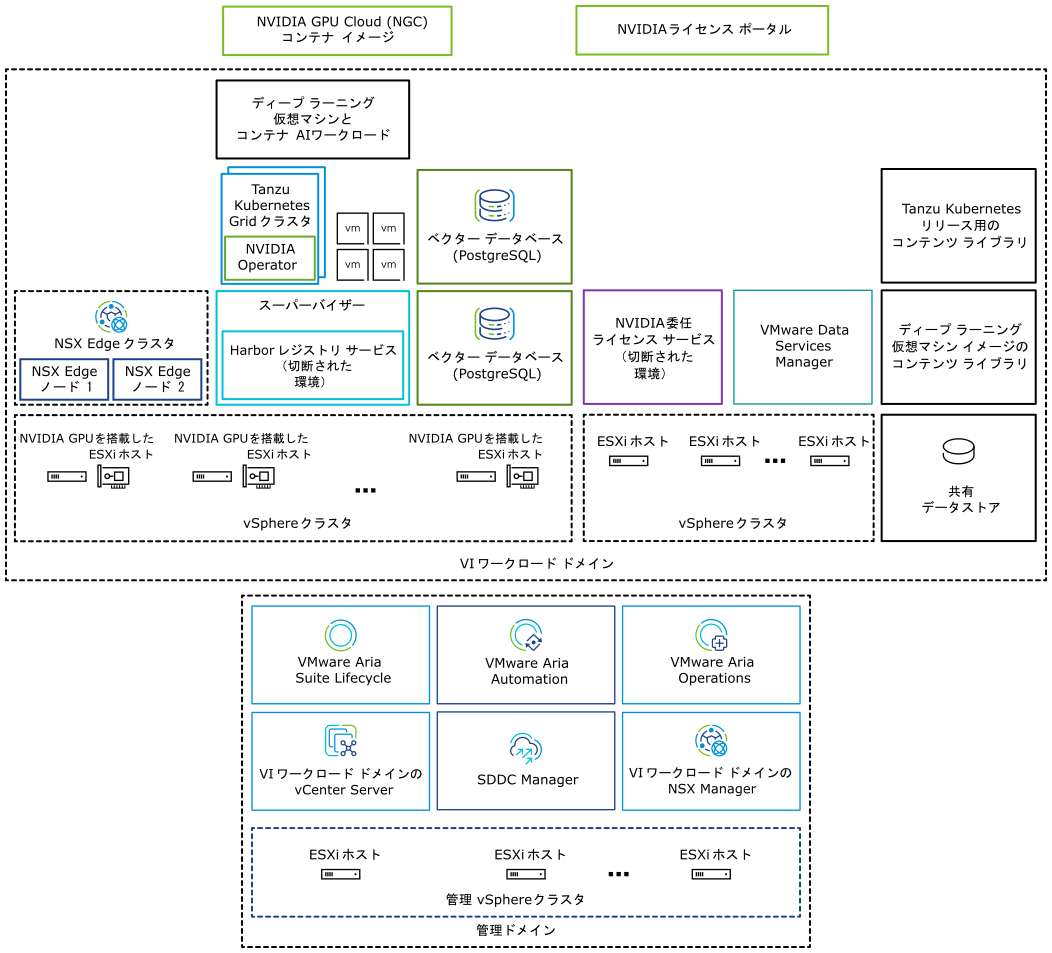

マルチコンポーネント ソリューションの VMware Private AI Foundation with NVIDIA を使用すると、NVIDIA のアクセラレーション コンピューティングと VMware Cloud Foundation の仮想インフラストラクチャ管理およびクラウド管理を使用して、生成 AI ワークロードを実行できます。

VMware Private AI Foundation with NVIDIA は、NVIDIA GPU を搭載した ESXi ホストで AI ワークロードをプロビジョニングするためのプラットフォームを提供します。さらに、NVIDIA GPU Cloud (NGC) コンテナに基づく AI ワークロードの実行は、VMware によって特に検証されています。

VMware Private AI Foundation with NVIDIA では、次の 2 つのユースケースがサポートされています。

- 開発のユースケース

- クラウド管理者と DevOps エンジニアは、ディープ ラーニング仮想マシンの形式で、Retrieval-Augmented Generation (RAG) などの AI ワークロードをプロビジョニングできます。データ サイエンティストは、これらのディープ ラーニング仮想マシンを AI 開発に使用できます。

- 本番環境のユースケース

- クラウド管理者は、DevOps エンジニアに、vSphere with Tanzu 上の Tanzu Kubernetes Grid (TKG) クラスタで本番環境対応の AI ワークロードをプロビジョニングするための VMware Private AI Foundation with NVIDIA 環境を提供できます。

ライセンス

以下の機能にアクセスするには、VMware Private AI Foundation with NVIDIA アドオン ライセンスが必要です。

- カタログ アイテムのための VMware Aria Automation でのプライベート AI セットアップにより、GPU アクセラレーション ディープ ラーニング仮想マシンと TKG クラスタを簡単にプロビジョニングする。

- エンタープライズ サポート付きの pgvector 拡張機能を使用して PostgreSQL データベースをプロビジョニングする。

- VMware by Broadcom が提供するディープ ラーニング仮想マシン イメージを展開して使用する。

スーパーバイザーを有効にした状態および有効にしていない状態で AI ワークロードを展開し、VMware Cloud Foundation ライセンスの下で vCenter Server と VMware Aria Operations で GPU メトリックを使用できます。

NVIDIA ソフトウェア コンポーネントは、NVIDIA AI Enterprise ライセンスの下で使用できます。

VMware Private AI Foundation with NVIDIA コンポーネントとは

| コンポーネント | 説明 |

|---|---|

| GPU 対応 ESXi ホスト | 次の方法で構成された ESXi ホスト:

|

| スーパーバイザー | Kubernetes API を使用して vSphere 上で仮想マシンとコンテナを実行できるように、vSphere with Tanzu で 1 つ以上の vSphere クラスタが有効になっています。スーパーバイザーは Kubernetes クラスタ自身であり、ワークロード クラスタと仮想マシンを管理するための制御プレーンとして機能します。 |

| Harbor レジストリ | NVIDIA NGC カタログからダウンロードしたコンテナ イメージをホストする切断された環境のローカル イメージ レジストリ。 |

| NSX Edge クラスタ | スーパーバイザーとそれが実行するワークロードに 2 層の North-South ルーティングを提供する NSX Edge ノードのクラスタ。 NSX Edge クラスタの Tier-0 ゲートウェイは、アクティブ/アクティブ モードです。 |

| NVIDIA Operator |

|

| ベクター データベース | pgvector 拡張機能が有効になっている PostgreSQL データベース。Retrieval Augmented Generation (RAG) AI ワークロードで使用できます。 |

|

NVIDIA ライセンス ポータルを使用してクライアント構成トークンを生成し、ディープ ラーニング仮想マシンのゲスト vGPU ドライバと TKG クラスタの GPU Operator にライセンスを割り当てます。 切断された環境で、またはインターネット接続を使用せずにワークロードがライセンス情報を取得できるように、NVIDIA ライセンスを委任ライセンス サービス (DLS) アプライアンスでローカルにホストします。 |

| コンテンツ ライブラリ | コンテンツ ライブラリには、ディープ ラーニング仮想マシンと Tanzu Kubernetes リリースのイメージが保存されます。これらのイメージは、VMware Private AI Foundation with NVIDIA 環境内での AI ワークロードの展開に使用します。接続された環境では、コンテンツ ライブラリは VMware が管理するパブリック コンテンツ ライブラリからコンテンツをプルします。切断された環境では、必要なイメージを手動でアップロードするか、内部コンテンツ ライブラリのミラー サーバからプルする必要があります。 |

| NVIDIA GPU Cloud (NGC) カタログ | VMware Private AI Foundation with NVIDIA 上のサポートされるオンプレミスの NVIDIA GPU でテストされ、実行の準備ができている、AI および機械学習用の GPU 向けに最適化されたコンテナのポータル。 |

クラウド管理者は、VMware Cloud Foundation の管理コンポーネントを使用します。

| 管理コンポーネント | 説明 |

|---|---|

| SDDC Manager | SDDC Manager を使用して、次のタスクを実行します。

|

| VI ワワークロード ドメインの vCenter Server | この vCenter Server インスタンスを使用して、スーパーバイザーを有効にして構成します。 |

| VI ワークロード ドメインの NSX Manager | SDDC Manager はこの NSX Manager を使用して NSX Edge クラスタを展開および更新します。 |

| VMware Aria Suite Lifecycle | VMware Aria Suite Lifecycle を使用して、VMware Aria Automation と VMware Aria Operations を展開および更新します。 |

| VMware Aria Automation | VMware Aria Automation を使用して、DevOps エンジニアおよびデータ サイエンティストの AI ワークロードを展開するためのセルフサービス カタログ アイテムを追加します。 |

| VMware Aria Operations | VMware Aria Operations を使用して、GPU 対応ワークロード ドメインでの GPU 使用を監視します。 |

| VMware Data Services Manager | VMware Data Services Manager を使用して、pgvector 拡張機能を備えた PostgreSQL データベースなどのベクター データベースを作成します。 |