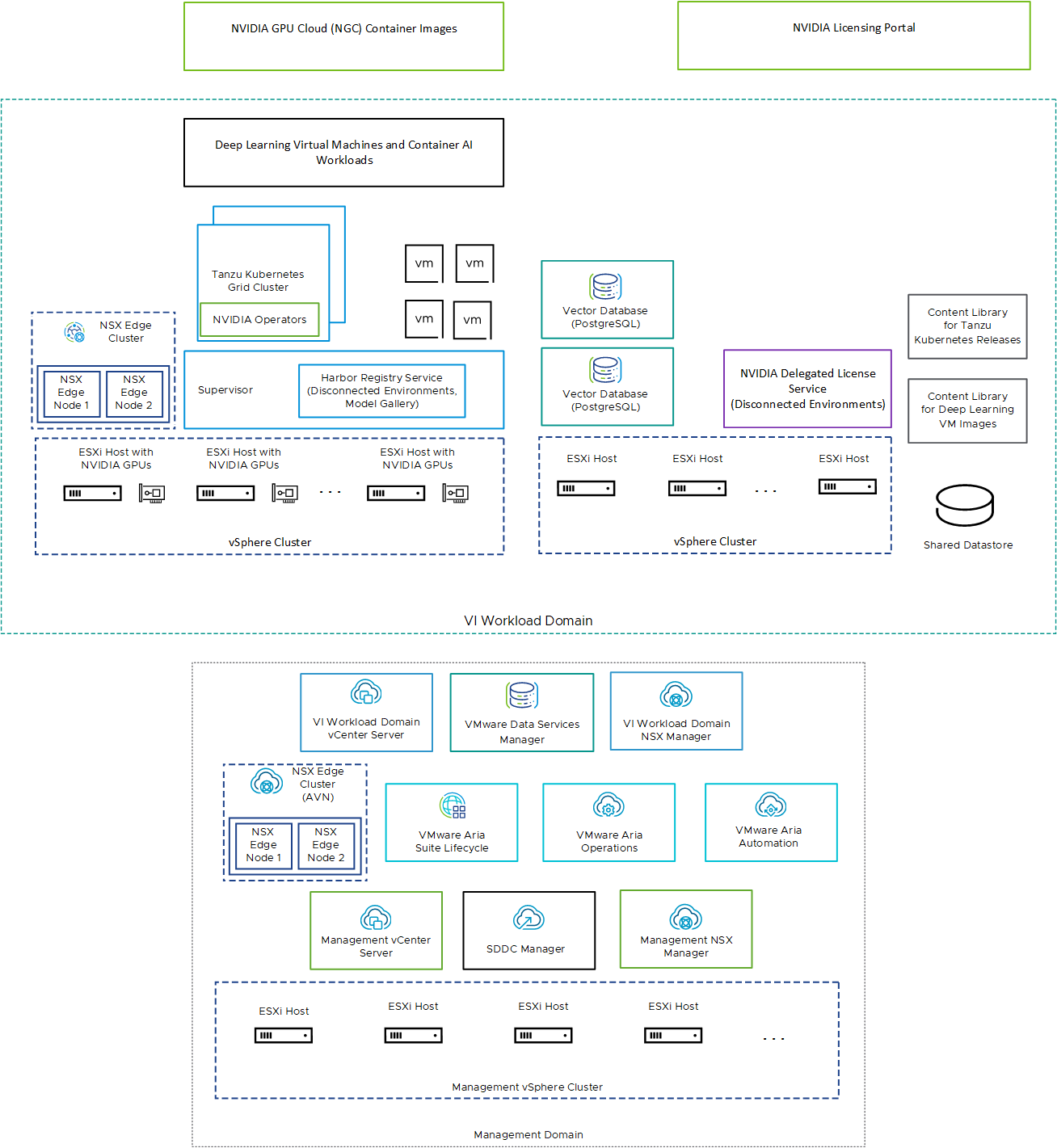

VMware Private AI Foundation with NVIDIA は、VMware Cloud Foundation 上で実行され、kubectl と VMware Aria Automation を使用してプロビジョニングされた vSphere IaaS control plane を使用して VI ワークロード ドメインの AI ワークロードのサポートを追加します。

| コンポーネント | 説明 |

|---|---|

| GPU 対応 ESXi ホスト | 次の方法で構成された ESXi ホスト:

|

| スーパーバイザー | Kubernetes API を使用して vSphere 上で仮想マシンとコンテナを実行できるように、vSphere IaaS control plane で 1 つ以上の vSphere クラスタが有効になっています。スーパーバイザーは Kubernetes クラスタ自身であり、ワークロード クラスタと仮想マシンを管理するための制御プレーンとして機能します。 |

| Harbor レジストリ | Harbor レジストリは、次の場合に使用できます。

|

| NSX Edge クラスタ | スーパーバイザーとそれが実行するワークロードに 2 層の North-South ルーティングを提供する NSX Edge ノードのクラスタ。 NSX Edge クラスタの Tier-0 ゲートウェイは、アクティブ/アクティブ モードです。 |

| NVIDIA Operator |

|

| ベクター データベース |

|

|

NVIDIA ライセンス ポータルを使用してクライアント構成トークンを生成し、ディープ ラーニング仮想マシンのゲスト vGPU ドライバと TKG クラスタの GPU Operator にライセンスを割り当てます。 切断された環境で、またはインターネット接続を使用せずにワークロードがライセンス情報を取得できるように、NVIDIA ライセンスを委任ライセンス サービス (DLS) アプライアンスでローカルにホストします。 |

| コンテンツ ライブラリ | コンテンツ ライブラリには、ディープ ラーニング仮想マシンと Tanzu Kubernetes リリースのイメージが保存されます。これらのイメージは、VMware Private AI Foundation with NVIDIA 環境内での AI ワークロードの展開に使用します。接続された環境では、コンテンツ ライブラリは VMware が管理するパブリック コンテンツ ライブラリからコンテンツをプルします。切断された環境では、必要なイメージを手動でアップロードするか、内部コンテンツ ライブラリのミラー サーバからプルする必要があります。 |

| NVIDIA GPU Cloud (NGC) カタログ | VMware Private AI Foundation with NVIDIA 上のサポートされるオンプレミスの NVIDIA GPU でテストされ、実行の準備ができている、AI および機械学習用の GPU 向けに最適化されたコンテナのポータル。 |

クラウド管理者は、次の方法で VMware Cloud Foundation の管理コンポーネントを使用します。

| 管理コンポーネント | 説明 |

|---|---|

| 管理 vCenter Server | SDDC の管理コンポーネントを実行し、仮想インフラストラクチャの監視と管理のための他のソリューションとの統合をサポートする ESXi ホストを管理します。 |

| 管理 NSX Manager | VMware Cloud Foundation の管理ワークロードにネットワーク サービスを提供します。 |

| SDDC Manager |

|

| VI ワワークロード ドメインの vCenter Server | スーパーバイザーを有効にして構成します。 |

| VI ワークロード ドメインの NSX Manager | SDDC Manager はこの NSX Manager を使用して NSX Edge クラスタを展開および更新します。 |

| NSX Edge クラスタ (AVN) | 動的ルーティングとロード バランシングのために、アプリケーション仮想ネットワーク (AVN) と呼ばれる NSX セグメントの事前定義された構成に VMware Aria Suite コンポーネントを配置します。 |

| VMware Aria Suite Lifecycle | VMware Aria Automation と VMware Aria Operations を展開および更新します。 |

| VMware Aria Automation | DevOps エンジニア、データ サイエンティスト、および MLOps エンジニア向けに AI ワークロードを展開するためのセルフサービス カタログ アイテムを追加します。 |

| VMware Aria Operations | GPU 対応のワークロード ドメインの GPU 消費を監視します。 |

| VMware Data Services Manager | pgvector 拡張機能を備えた PostgreSQL データベースなどのベクター データベースを作成します。 |