VMware Cloud Foundation 5.2.1 の VMware Private AI Foundation with NVIDIA 以降、MLOps エンジニアである場合は、中央の Harbor コンテナ レジストリを使用してディープ ラーニング仮想マシンと TKG クラスタ全体に ML モデルを分散できます。

ML モデルに中央モデルギャラリーを使用すると、次の利点があります。

- ディープ ラーニング仮想マシンで検証したモデルを組織内に分散します。インターネット上のモデルは、悪意のあるコードを含むか、悪意のある動作に合わせて調整されている可能性があります。

- 組織間で継続的に提供を行うか、プラットフォームまたは環境間で提供を促進するためにモデルを分散します。

- 制御された環境でモデルの整合性を維持します。

- Harbor プロジェクト アクセス機能を使用すると、モデルのトレーニングと調整に使用される機密データへのアクセスを制限できます。

- メタデータは、ML モデルの内容と依存関係を記述する Open Container Initiative (OCI) 形式で格納します。これにより、ターゲット モデルを実行できるプラットフォームを特定できます。

Harbor を使用して、NVIDIA NGC カタログ、Hugging Face、および別の ML モデル カタログのモデルを格納できます。

モデル ギャラリーについて

VMware Private AI Foundation with NVIDIA のモデル ギャラリーは、次の構成を持つ Harbor プロジェクトです。

| モデル ギャラリー エンティティ | Harbor または OCI エンティティ | 要件 |

|---|---|---|

| モデル ギャラリー | ユーザー アクセスが構成されているプロジェクト | Habor レジストリ内での一意の名前を付ける必要があります。 |

| モデル | OCI リポジトリ | OCI 形式に従ってプロジェクト内での一意の名前を付ける必要があります。 |

| リビジョン | OCI アーティファクト | コンテンツ ダイジェストによって識別される Immutable マニフェスト。 同じモデル データを複数回プッシュすると、1 つのリビジョンのみが保存されます。モデル データが変更されると、プッシュ操作ごとに新しいリビジョンが作成されます。 モデル リビジョンにタグを付けることができます。コンテナ エコシステムとは異なり、サポートされていますが、 |

| ファイル | OCI レイヤーと BLOB | - |

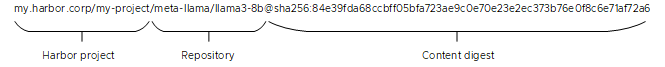

たとえば、Harbor は Llama モデルのリビジョンの例として次の形式を使用します。

モデル ギャラリーへのモデルのプッシュとプル

VMware Private AI Foundation with NVIDIA では、ディープ ラーニング仮想マシンを使用して、パブリック コンテナ レジストリまたは組織内のコンテナ レジストリからダウンロードしたモデルを検証および微調整できます。次に、仮想マシンで pais コマンド ライン ユーティリティを使用して、Harbor 内のモデル ギャラリーとの間でモデルをプッシュおよびプルします。