ID 管理の構成

このトピックでは、スタンドアローン管理クラスタを使用して、Tanzu Kubernetes Grid (TKG) で ID 管理を有効にして構成する方法について説明します。

ID 管理の有効化と構成について

LDAPS または OIDC の ID プロバイダを構成することで、管理クラスタの展開中または展開後に ID 管理を有効にできます。ID 管理を有効にした後に作成するワークロード クラスタは、管理クラスタと同じ ID プロバイダを使用するように自動的に構成されます。新たに有効にした ID 管理を使用して,既存のワークロード クラスタを遡って構成するには、「ワークロード クラスタでの ID 管理の有効化」の説明に従ってください。

ID 管理を有効にして構成するには、次の手順を実行します。管理クラスタおよびワークロード クラスタにアクセスするために、管理者以外の標準の kubeconfig ファイルを使用する場合は、このトピックの手順を完了した後、「RBAC の構成」の手順に従って、ロールベースのアクセス制御 (RBAC) を構成する必要があります。

(推奨)管理クラスタの展開中に ID 管理を有効にして構成するには:

- ID プロバイダの詳細を取得します。

- 取得した詳細を使用して、Tanzu Kubernetes Grid で LDAPS または OIDC を構成します。

- 管理クラスタが作成されたら、認証サービスが正しく実行されていることを確認し、構成を完了します。

手順については、以下の「(推奨)管理クラスタの展開中の ID 管理の有効化と構成」を参照してください。

管理クラスタの展開後に ID 管理を有効にして構成するには:

- ID プロバイダの詳細を取得します。

- 管理クラスタの Pinniped アドオン シークレットを生成します。

- 認証サービスが正しく実行されていることを確認し、構成を完了します。

- 管理クラスタがワークロード クラスタを管理する場合は、ID 管理を有効にする前に作成されたワークロード クラスタごとに Pinniped アドオン シークレットを生成します。

手順については、以下の「既存の環境での ID 管理の有効化と構成」を参照してください。

(推奨)管理クラスタの展開中の ID 管理の有効化と構成

このセクションでは、管理クラスタの展開中に ID 管理を有効にして構成する方法について説明します。

ID プロバイダの詳細の取得

ID 管理を有効にするには、ID プロバイダが必要です。Tanzu Kubernetes Grid は、LDAPS および OIDC の ID プロバイダをサポートします。

- 会社の内部 LDAPS サーバを ID プロバイダとして使用するには、LDAP 管理者から LDAPS 情報を取得します。

- OIDC を ID プロバイダとして使用するには、OpenID Connect 標準をサポートする ID プロバイダのアカウント(Okta など)が必要です。

例:Okta での Tanzu Kubernetes Grid アプリケーションの登録

Okta を OIDC プロバイダとして使用するには、Okta でアカウントを作成し、アカウントに Tanzu Kubernetes Grid のアプリケーションを登録する必要があります。

- Okta アカウントがない場合は、Okta アカウントを作成します。

- [管理 (Admin)] ボタンをクリックして管理ポータルに移動します。

- [アプリケーション (Applications)] に移動し、[アプリケーション統合の作成 (Create App Integration)] をクリックします。

- [ログイン方法 (Sign-in method)] で [OIDC - OpenID Connect] を選択し、[アプリケーション タイプ (Application type)] で [Web アプリケーション (Web Application)] を選択して、[次へ (Next)] をクリックします。

- アプリケーションに名前を付けます。

- [認証タイプ (Grant Type)] の [ユーザーに代わって動作するクライアント (Client acting on behalf of a user)] で、[認証コード (Authorization Code)] と [リフレッシュ トークン (Refresh Token)] の両方が選択されていることを確認します。

- プレースホルダの [ログイン リダイレクト URI (Sign-in redirect URI)] を入力します。たとえば、「

http://localhost:8080/authorization-code/callback」と入力します。管理クラスタを展開した後、実際の URL でこれを更新します。 - [割り当て (Assignments)] で、アプリケーションにユーザーとグループを割り当てます。アプリケーションに割り当てるユーザーとグループは、管理クラスタ、およびそれを使用して展開するワークロード クラスタにアクセスできるユーザーです。

- 保存 をクリックします。

- アプリケーションの [全般 (General)] タブで、[クライアント ID (Client ID)] および [クライアント シークレット (Client secret)] をコピーして保存します。これらの認証情報は、管理クラスタを展開するときに必要になります。

重要TKG 2.3 以降を使用するには、すべての OIDC プロバイダがリフレッシュ トークンを発行するように構成する必要があります。

Tanzu Kubernetes Grid での LDAPS または OIDC 設定の構成

上記で取得した詳細を使用して、Tanzu Kubernetes Grid で LDAPS または OIDC を構成します。

- インストーラ インターフェイスを使用して管理クラスタを展開する場合は、[ID 管理 (Identity Management)] セクションで [LDAPS] または [OIDC] を構成します。手順については、「インストーラ インターフェイスを使用した管理クラスタの展開」の「ID 管理の構成」を参照してください。

-

構成ファイルから管理クラスタを展開する場合は、構成ファイルで

LDAP_*またはOIDC_*変数を設定します。例:

LDAP:

IDENTITY_MANAGEMENT_TYPE: ldap LDAP_BIND_DN: "cn=bind-user,ou=people,dc=example,dc=com" LDAP_BIND_PASSWORD: "example-password" LDAP_GROUP_SEARCH_BASE_DN: dc=example,dc=com LDAP_GROUP_SEARCH_FILTER: &(objectClass=posixGroup)(memberUid={}) LDAP_GROUP_SEARCH_NAME_ATTRIBUTE: cn LDAP_GROUP_SEARCH_USER_ATTRIBUTE: uid LDAP_HOST: ldaps.example.com:636 LDAP_ROOT_CA_DATA_B64: "" LDAP_USER_SEARCH_BASE_DN: ou=people,dc=example,dc=com LDAP_USER_SEARCH_FILTER: &(objectClass=posixAccount)(uid={}) LDAP_USER_SEARCH_NAME_ATTRIBUTE: uidOIDC:

IDENTITY_MANAGEMENT_TYPE: oidc OIDC_IDENTITY_PROVIDER_CLIENT_ID: 0oa2i[...]NKst4x7 OIDC_IDENTITY_PROVIDER_CLIENT_SECRET: 331!b70[...]60c_a10-72b4 OIDC_IDENTITY_PROVIDER_GROUPS_CLAIM: groups OIDC_IDENTITY_PROVIDER_ISSUER_URL: https://dev-[...].okta.com OIDC_IDENTITY_PROVIDER_SCOPES: openid,groups,email,offline_access OIDC_IDENTITY_PROVIDER_USERNAME_CLAIM: email管理クラスタ構成ファイルの準備方法については、「管理クラスタ構成ファイルの作成」を参照してください。

ID 管理の構成の完了

管理クラスタが展開されたら、次のセクションで説明する手順に従って ID 管理の構成を完了します。

kubectlを管理クラスタに接続します。- 「ID 管理サービスのステータスの確認」の説明に従って、認証サービスのステータスを確認して、正しく実行されていることを確認します。

- (OIDC のみ)OIDC プロバイダへのコールバック URI を指定します。

- 管理クラスタにアクセスするための管理者以外の標準の

kubeconfigファイルの使用をサポートするには、管理クラスタ用の RBAC を構成してください。

管理クラスタへの kubectl の接続

ID 管理を構成するには、管理クラスタの admin コンテキストを取得して使用する必要があります。

-

管理クラスタの

adminコンテキストを取得します。このトピックの手順では、id-mgmt-testという名前の管理クラスタを使用します。tanzu mc kubeconfig get id-mgmt-test --admin管理クラスタの名前が

id-mgmt-testの場合は、「Credentials of workload cluster 'id-mgmt-test' have been saved. You can now access the cluster by running 'kubectl config use-context id-mgmt-test-admin@id-mgmt-test'」という確認メッセージが表示されるはずです。クラスタのadminコンテキストを使用すると、IDP による認証を必要とせずにクラスタにフル アクセスできます。 -

kubectlを管理クラスタのadminコンテキストに設定します。kubectl config use-context id-mgmt-test-admin@id-mgmt-test

ID 管理サービスのステータスの確認

Tanzu Kubernetes Grid は、Pinniped を使用してクラスタを OIDC および LDAP ID プロバイダと統合します。ID 管理を有効にすると、Tanzu Kubernetes Grid は pinniped-supervisor サービスを pinniped-supervisor 名前空間に作成し、pinniped-concierge を pinniped-concierge 名前空間に作成します。次の手順に従って Pinniped サービスのステータスを確認し、サービスが公開されている EXTERNAL-IP アドレスを書き留めます。

-

管理クラスタで実行されているサービスに関する情報を取得します。ID 管理サービスは、

pinniped-supervisor名前空間で実行されます。kubectl get services -n pinniped-supervisor出力には次のエントリが表示されます。

NSX Advanced Load Balancer (ALB) を使用する vSphere:

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/pinniped-supervisor LoadBalancer 100.70.70.12 20.52.230.18 5556:31234/TCP 84mAmazon Web Services (AWS):

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/pinniped-supervisor LoadBalancer 100.69.13.66 ab1[...]71.eu-west-1.elb.amazonaws.com 443:30865/TCP 56mAzure:

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/pinniped-supervisor LoadBalancer 100.69.169.220 20.54.226.44 443:30451/TCP 84mNSX ALB を使用しない vSphere:

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/pinniped-supervisor NodePort 100.70.70.12 <none> 5556:31234/TCP 84m -

次の情報を書き留めてください。

- NSX ALB を使用する vSphere、AWS、および Azure:

EXTERNAL-IPにリストされている、pinniped-supervisorサービスの外部アドレスを書き留めます。 - NSX ALB を使用しない vSphere:

pinniped-supervisorサービスが実行されているポートを書き留めます。上記の例では、このポートは31234です。

- NSX ALB を使用する vSphere、AWS、および Azure:

-

管理クラスタ内のすべてのサービスが実行されていることを確認します。

kubectl get pods -APinniped サービスが起動して実行されるまで数分かかる場合があります。たとえば、AWS 環境と Azure 環境では、サービスは

LoadBalancerの IP アドレスの準備が整うのを待つ必要があります。次の手順に進む前に、pinniped-post-deploy-jobが完了したことを確認してください。NAMESPACE NAME READY STATUS RESTARTS AGE [...] pinniped-supervisor pinniped-post-deploy-job-hq8fc 0/1 Completed 0 85m

注

kubectl get podsを実行できるのは、管理クラスタのadminコンテキストを使用しているためです。通常のコンテキストを使用して管理クラスタに接続しようとするユーザーは、リソースにアクセスできません。これは、まだアクセスする権限がないためです。

LDAP ID 管理サービスのステータスの確認

Tanzu Kubernetes Grid は、Pinniped を使用してクラスタを LDAP ID サービスと統合して、サービス エンドポイントを公開します。LDAP を有効にすると、Tanzu Kubernetes Grid は、pinniped-supervisor サービスを pinniped-supervisor 名前空間に作成し、pinniped-concierge サービスを pinniped-concierge 名前空間に作成します。

-

管理クラスタ内のすべてのサービスが実行されていることを確認します。

kubectl get services -APinniped サービスが起動して実行されるまで数分かかる場合があります。たとえば、AWS 環境と Azure 環境では、サービスは

LoadBalancerの IP アドレスの準備が整うのを待つ必要があります。次の手順に進む前に、pinniped-post-deploy-jobが完了したことを確認してください。NAMESPACE NAME READY STATUS RESTARTS AGE [...] pinniped-supervisor pinniped-post-deploy-job-hq8fc 0/1 Completed 0 85m注

kubectl get podsを実行できるのは、管理クラスタのadminコンテキストを使用しているためです。通常のコンテキストを使用して管理クラスタに接続しようとするユーザーは、リソースにアクセスできません。これは、まだアクセスする権限がないためです。 - 「管理クラスタ用の RBAC の構成」に進みます。

(OIDC のみ)OIDC プロバイダへのコールバック URI の指定

OIDC 認証を使用するように管理クラスタを構成した場合は、その管理クラスタのコールバック URI を OIDC ID プロバイダに提供する必要があります。たとえば、OIDC を使用していて、IDP が Okta の場合は、次の手順を実行します。

- Okta アカウントにログインします。

- メイン メニューで、[アプリケーション (Applications)] に移動します。

- Tanzu Kubernetes Grid 用に作成したアプリケーションを選択します。

- [全般設定 (General Settings)] パネルで、[編集 (Edit)] をクリックします。

-

[ログイン (Login)] で、

pinniped-supervisorが実行されているノードのアドレスを含めるように [ログイン リダイレクト URI (Login redirect URIs)] を更新します。-

NSX ALB を使用する vSphere、AWS、および Azure:前の手順で書き留めた

pinniped-supervisorサービスの外部 IP アドレスとポート番号を追加します。https://EXTERNAL-IP/callback -

NSX ALB を使用しない vSphere:API エンドポイントとして設定した IP アドレスと、前の手順で書き留めた

pinniped-supervisorポート番号を追加します。https://API-ENDPOINT-IP:31234/callbackいずれの場合も、

httpではなくhttpsを指定する必要があります。

-

- 保存 をクリックします。

管理クラスタ用の RBAC の構成

管理クラスタへのアクセスに管理者以外の標準の kubeconfig ファイルを使用するよう計画している場合は、ID 管理の構成が完了したら、「管理クラスタ用の RBAC の構成」の手順に従って RBAC を構成します。

既存の環境での ID 管理の有効化と構成

このセクションでは、既存の環境で ID 管理を有効にして構成する方法について説明します。

ID プロバイダの詳細の取得

上記の「ID プロバイダの詳細の取得」の説明に従ってください。

管理クラスタの Pinniped アドオン シークレットの生成

この手順では、Pinniped アドオンを構成し、管理クラスタに認証コンポーネントを展開します。Pinniped アドオンの Kubernetes シークレットを生成するには、次の手順を実行します。

-

kubectlのコンテキストを管理クラスタに設定します。たとえば、id-mgmt-testという名前の管理クラスタの場合は次のようになります。kubectl config use-context id-mgmt-test-admin@id-mgmt-test -

管理クラスタを展開したときに定義した構成設定を新しいファイルにコピーして、クラスタ構成ファイルを作成します。OIDC や LDAP などの ID プロバイダの詳細など、次の設定を管理クラスタ構成ファイルに追加します。

注

これらの変数は管理クラスタにのみ設定する必要があります。

# Identity management type. This must be "oidc" or "ldap". IDENTITY_MANAGEMENT_TYPE: # Explicitly set the namespace, which for management clusters is "tkg-system". NAMESPACE: tkg-system # Set these variables if you want to configure OIDC. OIDC_IDENTITY_PROVIDER_CLIENT_ID: OIDC_IDENTITY_PROVIDER_CLIENT_SECRET: OIDC_IDENTITY_PROVIDER_GROUPS_CLAIM: OIDC_IDENTITY_PROVIDER_ISSUER_URL: OIDC_IDENTITY_PROVIDER_SCOPES: "email,profile,groups,offline_access" OIDC_IDENTITY_PROVIDER_USERNAME_CLAIM: # Set these variables if you want to configure LDAP. LDAP_BIND_DN: LDAP_BIND_PASSWORD: LDAP_GROUP_SEARCH_BASE_DN: LDAP_GROUP_SEARCH_FILTER: LDAP_GROUP_SEARCH_NAME_ATTRIBUTE: dn LDAP_GROUP_SEARCH_USER_ATTRIBUTE: dn LDAP_HOST: LDAP_ROOT_CA_DATA_B64: LDAP_USER_SEARCH_BASE_DN: LDAP_USER_SEARCH_FILTER: LDAP_USER_SEARCH_ID_ATTRIBUTE: dn LDAP_USER_SEARCH_NAME_ATTRIBUTE: # Set these variables if you want to configure certificate duration CERT_DURATION: 2160h CERT_RENEW_BEFORE: 360hこれらの変数のうちどれがオプションで省略可能かを確認するには、ID プロバイダを構成する際の変数(OIDC 用)および ID プロバイダを構成する際の変数(LDAP 用)を参照してください。

管理クラスタがプロキシの背後にある場合は、新しい構成ファイルにプロキシ構成の詳細が含まれていることを確認します。

TKG_HTTP_PROXY: TKG_HTTPS_PROXY: TKG_NO_PROXY:これらの変数の詳細については、プロキシ構成の説明を参照してください。

vSphere:内部チェックに合格するためのダミー値として、

VSPHERE_CONTROL_PLANE_ENDPOINT構成設定を未使用の IP アドレスに変更します。 -

ローカル環境で、

IDENTITY_MANAGEMENT_TYPEがoidcまたはldapのいずれかに設定されており、noneに設定されていないことを確認します。echo $IDENTITY_MANAGEMENT_TYPEこの変数が

noneに設定されている場合は、exportコマンドを実行して、oidcまたはldapに設定し直します。 -

FILTER_BY_ADDON_TYPE環境変数をauthentication/pinnipedに設定して、tanzu management-cluster createが Pinniped 関連のオブジェクトでのみ動作するようにします。export FILTER_BY_ADDON_TYPE="authentication/pinniped" -

Pinniped アドオンのシークレットを生成します。

tanzu management-cluster create CLUSTER-NAME --dry-run -f CLUSTER-CONFIG-FILE > CLUSTER-NAME-example-secret.yamlここで、

CLUSTER-NAMEはターゲット管理クラスタの名前です。CLUSTER-CONFIG-FILEは、上記で作成した構成ファイルです。

環境変数の設定により、

tanzu management-cluster create --dry-runが完全なクラスタ マニフェストではなく Kubernetes シークレットを生成します。 -

シークレットを確認してから、管理クラスタに適用します。例:

kubectl apply -f CLUSTER-NAME-example-secret.yaml -

シークレットを適用したら、

kubectl get appコマンドを実行して、Pinniped アドオンのステータスを確認します。$ kubectl get app CLUSTER-NAME-pinniped -n tkg-system NAME DESCRIPTION SINCE-DEPLOY AGE pinniped Reconcile succeeded 3m23s 7h50m返されたステータスが

Reconcile failedの場合は、次のコマンドを実行してエラーの詳細を取得します。kubectl get app CLUSTER-NAME-pinniped -n tkg-system -o yaml

ID 管理の構成の完了

上記の「ID 管理の構成の完了」の説明に従ってください。

ワークロード クラスタでの ID 管理の有効化

管理クラスタで ID 管理を有効にしたときに作成するワークロード クラスタは、同じ ID 管理サービスを使用するように自動的に構成されます。

ブラウザを使用しないマシンでのユーザー認証

ブートストラップ マシンがジャンプボックスなどのディスプレイのないマシンである場合は、ローカル マシンで実行されているブラウザからクラスタへの認証を行うことができます。これを行う方法は、クラスタの Pinniped バージョン(クラスタがベースとしている Tanzu Kubernetes リリースに基づく)によって異なります。

| クラスタ TKr のバージョン | ブラウザレスの認証手順 |

|---|---|

| TKr v1.23.10(Tanzu Kubernetes Grid v1.6.1 のデフォルト)以降 | 以下の手順を参照してください。 |

| 古い TKr に基づくクラスタ、または古いバージョンの Tanzu Kubernetes Grid によって作成されたクラスタ | Tanzu Kubernetes Grid v1.4 ドキュメントの「Authenticate Users on a Machine Without a Browser」の手順に従ってください。 |

注Tanzu Kubernetes Grid v2.4 では、非インタラクティブなアカウントまたはパスワード付与に基づくブラウザレス CLI ログインはサポートされていません。

-

ローカル マシンのターミナル ウィンドウから

sshを実行して、ブートストラップ マシンにリモートでログインします。 -

TANZU_CLI_PINNIPED_AUTH_LOGIN_SKIP_BROWSER=true環境変数を設定します。これにより、--skip-browserオプションがクラスタのkubeconfigに追加されます。# Linux export TANZU_CLI_PINNIPED_AUTH_LOGIN_SKIP_BROWSER=true # Windows set TANZU_CLI_PINNIPED_AUTH_LOGIN_SKIP_BROWSER=true -

クラスタの標準の

kubeconfigをローカル ファイルにエクスポートします。コマンドには--adminオプションが含まれていないため、エクスポートされるkubeconfigは、adminバージョンではなく、標準のkubeconfigです。たとえば、kubeconfigファイルを/tmp/my-cluster-kubeconfigにエクスポートするには、次の手順を実行します。-

管理クラスタの場合は、次のコマンドを実行します。

tanzu mc kubeconfig get --export-file /tmp/my-cluster-kubeconfig「

You can now access the cluster by specifying '--kubeconfig /tmp/my-mgmt-cluster-kubeconfig' flag when using 'kubectl' command」という確認メッセージが表示されるはずです。 -

ワークロード クラスタの場合は、次のコマンドを実行します。

tanzu cluster kubeconfig get my-cluster --export-file /tmp/my-cluster-kubeconfig

-

-

新しく作成した

kubeconfigファイルを使用して、クラスタに接続します。kubectl get pods -A --kubeconfig /tmp/my-cluster-kubeconfigCLI は、ID プロバイダのログイン リンクを出力します。例:

Log in by visiting this link: https://10.180.105.166:31234/oauth2/authorize?access_type=offline&client_id=pinniped-cli&code_challenge=-aJ617vJZXZeEnHPab1V2_VHPmc5VwspFig5QQKyTwg&code_challenge_method=S256&nonce=cafaf8f4d2cb714ef8fb3320c1b088ba&redirect_uri=http%3A%2F%2F127.0.0.1%3A33087%2Fcallback&response_mode=form_post&response_type=code&scope=offline_access+openid+pinniped%3Arequest-audience&state=fff3d4d46b36359d5ba2f24fad471dd8 Optionally, paste your authorization code: -

リンクをコピーし、ローカル マシンのブラウザに貼り付けます。

-

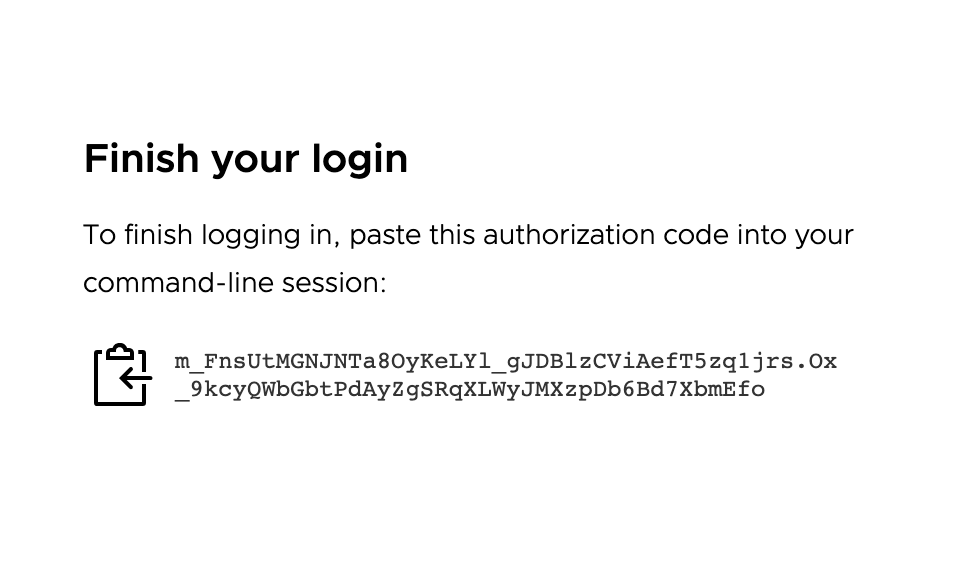

ブラウザで、ID プロバイダにログインします。認証コードを CLI に貼り付けるよう求めるページが表示されます。

-

認証コードをコピーして、CLI の「

Optionally, paste your authorization code:」プロンプトの後に貼り付けます。 -

以前に使用したのと同じ

kubeconfigファイルを使用して、クラスタに再度接続します。kubectl get pods -A --kubeconfig FILE-PATH-

認証済みユーザーのクラスタでロール バインドをすでに構成している場合、出力にはポッド情報が表示されます。

-

クラスタでロール バインドを構成していない場合は、ポッドへのユーザー アカウント アクセスを拒否するメッセージが表示されます。

Error from server (Forbidden): pods is forbidden: User "[email protected]" cannot list resource "pods" in API group "" at the cluster scope。これは、ユーザーが正常に認証されたが、クラスタ上のリソースにアクセスする権限がまだないことが原因で発生します。ユーザーによるクラスタ リソースへのアクセスを許可するには、クラスタ ロール バインドを作成して、クラスタで RBAC を構成する必要があります。- 「管理クラスタでのロール バインドの作成」を参照してください。

- 「ワークロード クラスタでのロール バインドの作成」を参照してください。

-

既存の展開での ID 管理の無効化

ID 管理が有効になっている既存の展開で ID 管理を無効化するには、次の手順を実行します。

-

kubectlのコンテキストを管理クラスタに設定します。たとえば、id-mgmt-testという名前の管理クラスタの場合は次のようになります。kubectl config use-context id-mgmt-test-admin@id-mgmt-test -

管理クラスタ構成ファイルを取得し、

IDENTITY_MANAGEMENT_TYPE: noneを設定するように編集します。 -

--dry-runを使用してtanzu management-cluster createを実行し、Pinniped 関連オブジェクトをフィルタリングして、Pinniped シークレット定義を生成します。FILTER_BY_ADDON_TYPE=authentication/pinniped tanzu management-cluster create --dry-run CLUSTER-CONFIG > PINNIPED-SECRETここで、

CLUSTER-CONFIGはクラスタ構成ファイルで、PINNIPED-SECRETは生成された PinnipedSecret定義に付ける名前です(例:mc-no-idp.yaml)。 -

新しいシークレットを適用して、管理クラスタで Pinniped を無効にします。

kubectl apply -f PINNIPED-SECRET -

管理クラスタで Pinniped を無効にすると、そのクラスベースのクラスタは自動的に無効化されますが、レガシー クラスタは手動で無効にする必要があります。

-

管理クラスタ コンテキストに残っている Pinniped シークレットを一覧表示します。

kubectl get secret -A | grep pinniped-addon -

リストされているシークレット名と名前空間を使用して、

kubectl get secret出力内のシークレット(存在する場合)を調べます。kubectl get secret SECRET-NAME -n SECRET-NAMESPACE -o yaml -

次のいずれかを含むシークレットを削除します。

type: tkg.tanzu.vmware.com/addon- これらはレガシー クラスタのシークレットです- 任意の OIDC または LDAP 構成

kubectl delete secret SECRET-NAMEここで、

SECRET-NAMEはSecret仕様で設定されたmetadata.nameの値です。

-

次の手順

管理者以外の標準の kubeconfig ファイルを使用して、ユーザーによる管理クラスタおよびワークロード クラスタへのアクセスを許可する場合は、RBAC 認可を構成する必要があります。

- 管理クラスタの RBAC を構成するには、「管理クラスタ用の RBAC の構成」の手順に従ってください。

- このトピックの手順を完了したら、ワークロード クラスタの作成を開始できます。ワークロード クラスタの RBAC を構成するには、「ワークロード クラスタ用の RBAC の構成」の手順に従ってください。