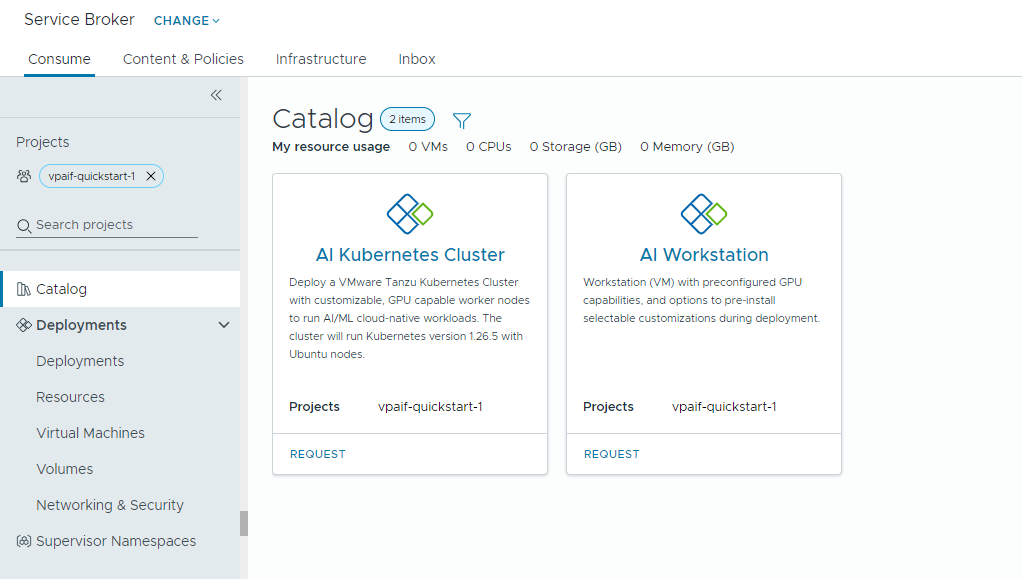

如果雲端管理員已在 VMware Aria Automation 中設定 Private AI Automation Services,則可以使用 Automation Service Broker 目錄請求 AI 工作負載。

Private AI Automation Services 支援 Automation Service Broker 中的兩個目錄項目,具有相應權限的使用者可以存取和請求這些目錄項目。

- AI Workstation - 已啟用 GPU 的虛擬機器,可以從 NVIDIA 設定所需的 vCPU、vGPU、記憶體和 AI/ML 軟體。

- AI Kubernetes 叢集 – 已啟用 GPU 的 Tanzu Kubernetes 叢集,可以設定 NVIDIA GPU Operator。

開始之前

- 確認已為您的專案設定 Private AI Automation Services,並且您有權請求 AI 目錄項目。

請注意,此處的所有值均為使用案例範例。帳戶值取決於環境。

將深度學習虛擬機部署到 VI 工作負載網域

身為資料科學家,您可以從自助 Automation Service Broker 目錄中部署單一 GPU 軟體定義的開發環境。您可以使用機器參數自訂已啟用 GPU 的虛擬機器以模擬開發需求,指定 AI/ML 軟體組態以符合訓練和推理需求,以及透過入口網站存取金鑰從 NVIDIA NGC 登錄指定 AI/ML 套件。

程序

部署已啟用 AI 的Tanzu Kubernetes叢集

身為 DevOps 工程師,您可以請求已啟用 GPU 的 Tanzu Kubernetes 叢集,Worker 節點可在這些叢集中執行 AI/ML 工作負載。

TKG 叢集包含一個 NVIDIA GPU Operator,它是 Kubernetes Operator,負責為 TKG 叢集節點上的 NVIDIA GPU 硬體設定正確的 NVIDIA 驅動程式。部署的叢集可用於 AI/ML 工作負載,而無需進行額外的 GPU 相關設定。

程序

- 找到 AI Kubernetes 叢集卡,然後按一下請求。

- 選取專案。

- 輸入部署的名稱和說明。

- 選取控制窗格節點的數目。

設定 範例值 節點計數 1 虛擬機器類別 cpu-only-medium - 8 個 CPU 和 16 GB 記憶體 選取的類別將定義虛擬機器中的可用資源。

- 選取工作節點的數目。

設定 說明 節點計數 3 虛擬機器類別 a100-medium - 4 個 vGPU (64 GB),16 個 CPU 和 32 GB 記憶體 - 按一下提交。

結果

部署中包含一個主管命名空間、一個具有三個 Worker 節點的 TKG 叢集、TKG 叢集內的多個資源以及一個用於部署 GPU Operator 應用程式的 carvel 應用程式。

監控您的私人 AI 部署

您可以使用 [部署] 頁面管理部署和相關聯的資源,對部署進行變更,疑難排解失敗的部署,對資源進行變更,以及銷毀未使用的部署。

若要管理部署,請選取。

如需詳細資訊,請參閱如何管理我的 Automation Service Broker 部署。