作为云管理员,您可以利用 VMware Cloud Foundation 堆栈来管理启用了 GPU 的基础架构和 AI/ML 工作负载域。在 VMware Aria Automation 中,您可以提供启用了 GPU 的深度学习虚拟机 (DL VM) 和 Tanzu Kubernetes Grid (TKG) 集群并将其设置为目录项,组织中的数据科学家和 DevOps 团队可以在自助 Automation Service Broker 目录中请求这些目录项。

什么是 VMware Private AI Foundation?

VMware Private AI Foundation with NVIDIA 为在 VMware Cloud Foundation with NVIDIA GPU 上置备 AI 工作负载提供了一个平台。此外,VMware by Broadcom 专门对基于 NVIDIA GPU Cloud (NGC) 容器运行 AI 工作负载进行了验证。要了解更多信息,请参见什么是 VMware Private AI Foundation with NVIDIA。

Private AI Automation Services 是 VMware Aria Automation 中提供的所有 VMware Private AI Foundation 功能的统称。

要开始使用 Private AI Automation Services,请在 VMware Aria Automation 中运行目录设置向导。该向导可帮助您将 VMware Private AI Foundation 连接到 VMware Aria Automation。

目录设置向导的工作原理是什么?

- 添加云帐户。云帐户是用于从 vCenter 实例收集数据以及将资源部署到其中的凭据。

- 添加 NVIDIA 许可证。

- 选择要添加到 Automation Service Broker 目录的内容。

- 创建项目。该项目将您的用户与云帐户区域链接起来,以便他们可以将云模板连同网络和存储资源一起部署到您的 vCenter 实例中。

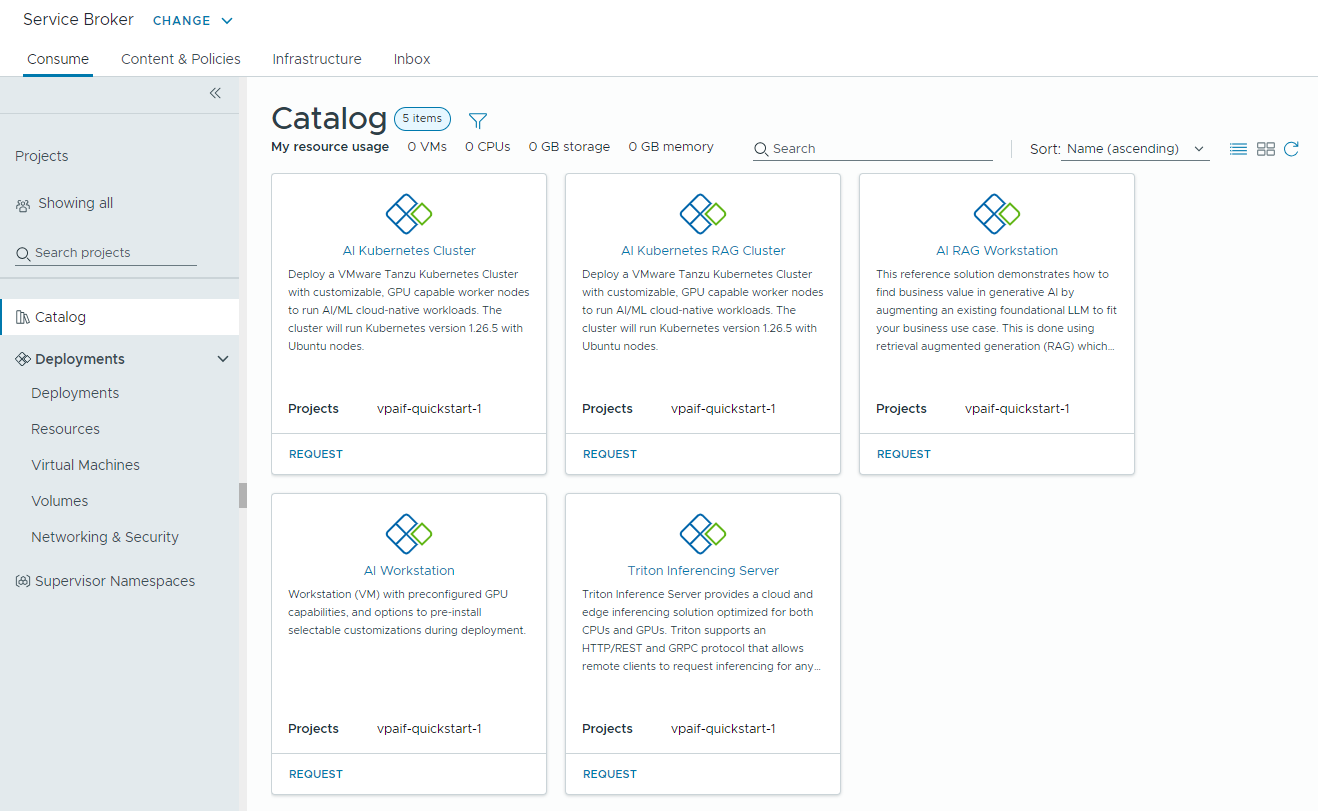

- AI Workstation – 启用了 GPU 的虚拟机(可以配置所需的 vCPU、vGPU、内存)以及用于预安装 AI/ML 框架(如 PyTorch、CUDA Samples 和 TensorFlow)的选项。

- AI RAG Workstation – 启用了 GPU 的虚拟机,具有检索增强生成 (RAG) 参考解决方案。

- Triton Inference Server – 启用了 GPU 的虚拟机,具有 Triton Inference Server。

- AI Kubernetes 集群 – VMware Tanzu Kubernetes Grid 集群,具有支持 GPU 的 Worker 节点,可运行 AI/ML 云原生工作负载。

- AI Kubernetes RAG 集群 – VMware Tanzu Kubernetes Grid 集群,具有支持 GPU 的 Worker 节点,可运行参考 RAG 解决方案。

如果需要更改提供的任何设置(如许可更改),或者如果要为其他项目创建 AI 目录项,则可以多次运行该向导。每次运行向导时,除了之前创建的任何项目外,都会为您创建五个新目录项。

您可以修改向导创建的目录项的模板,以满足组织的特定需求。

开始之前

- 确认您运行的是 VMware Aria Automation 8.18。

- 确认您运行的是 VMware Cloud Foundation 5.1.1 或更高版本,其中包括 vCenter 8.0 Update U2b 或更高版本。

- 确认您在 VMware Aria Automation 中拥有 vCenter 云帐户。

- 确认您拥有具有高级云服务订阅的 NVIDIA GPU Cloud Enterprise 组织。

- 确认您具有通过工作负载管理配置的启用了 GPU 的主管集群。

- 为 VMware Private AI Foundation with NVIDIA 配置 VMware Aria Automation。请参见为 VMware Private AI Foundation with NVIDIA 设置 VMware Aria Automation。

- 在运行目录设置向导之前,请完成 VMware Cloud Foundation 快速入门。SDDC 和主管集群必须注册到 VMware Aria Automation。请参见如何使用 VMware Cloud Foundation 快速入门开始使用 VMware Aria Automation。

- 确认您已从 NVIDIA 许可服务器生成客户端配置令牌,并且您拥有 NVIDIA NGC 门户 API 密钥。NVIDIA NGC 门户访问密钥用于下载和安装 vGPU 驱动程序。

- 为 Cloud Consumption Interface (CCI) 配置单点登录 (SSO)。请参见为 CCI 设置单点登录。

- 确认您已在 https://packages.vmware.com/dl-vm/lib.json 中订阅内容库。

过程

- 首次安装 VMware Aria Automation 并登录后,单击启动快速入门。

- 在 Private AI Automation Services 卡视图上,单击启动。

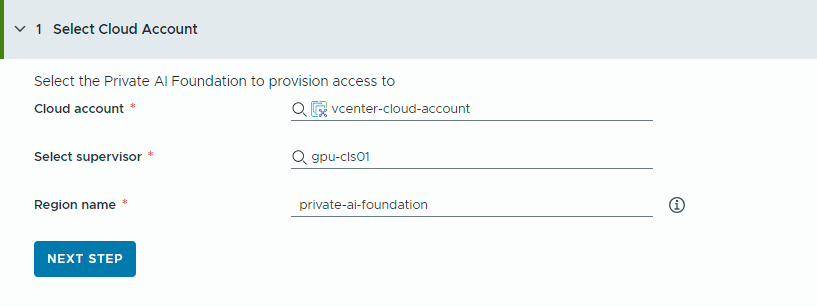

- 选择要置备访问权限的 云帐户。

请记住,此处的所有值均为用例示例。您的帐户值取决于您的环境。

- 选择 vCenter 云帐户。

- 选择启用了 GPU 的主管。

- 输入区域名称。

如果主管已配置区域,则会自动选择一个区域。

如果主管未与区域关联,需要在此步骤添加一个区域。请考虑为区域使用描述性名称,以帮助用户区分启用了 GPU 的区域与其他可用区域。

- 单击下一步。

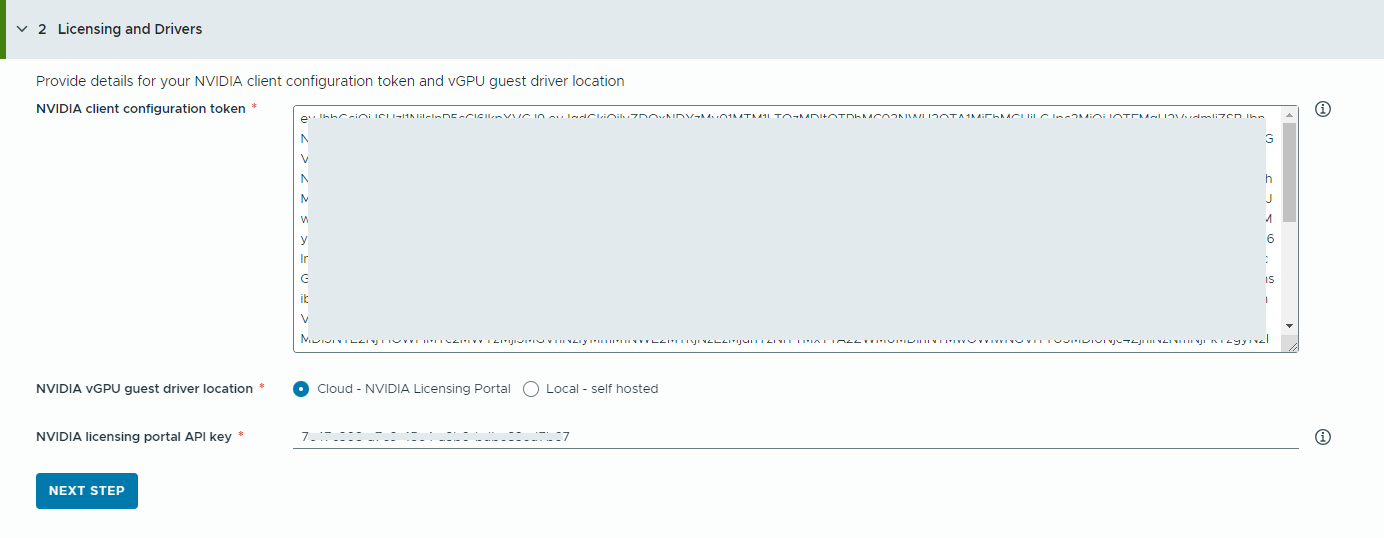

- 提供有关 NVIDIA 许可证服务器的信息。

- 复制并粘贴 NVIDIA 客户端配置令牌的内容。

需要客户端配置令牌才能启用 vGPU 驱动程序的全部功能。

- 选择 NVIDIA vGPU 驱动程序的位置。

- 云 – NVIDIA vGPU 驱动程序托管在 NVIDIA 许可门户上。

您必须提供 NVIDIA 许可门户 API 密钥,用于评估用户是否有权下载 NVIDIA vGPU 驱动程序。API 密钥必须是 UUID。

注: 从 NVIDIA 许可门户生成的 API 密钥与 NVAIE API 密钥不同。 - 本地 – NVIDIA vGPU 驱动程序托管在内部部署环境中,并从专用网络进行访问。

必须为虚拟机提供 vGPU 客户机驱动程序的位置。

对于气隙环境,vGPU 驱动程序必须可通过专用网络或数据中心访问。

- 云 – NVIDIA vGPU 驱动程序托管在 NVIDIA 许可门户上。

- 单击下一步。

- 复制并粘贴 NVIDIA 客户端配置令牌的内容。

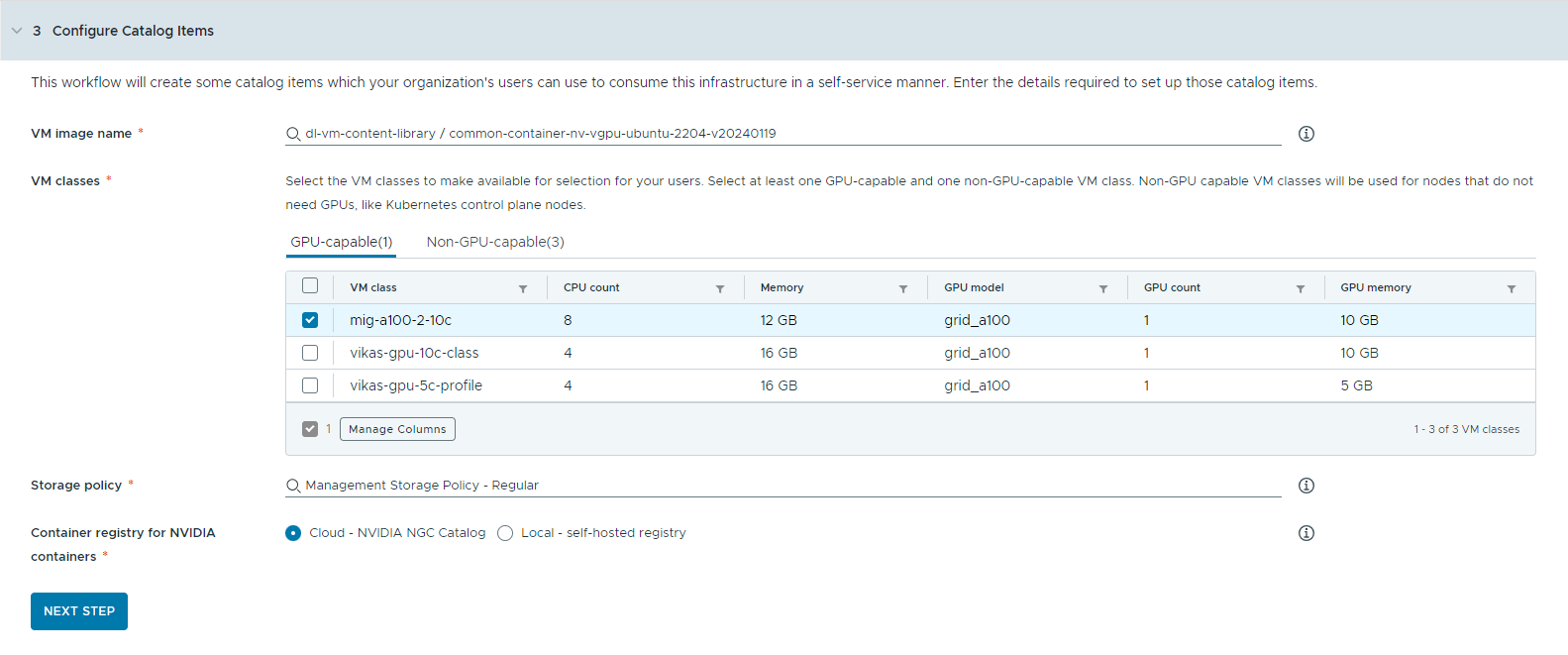

- 配置目录项。

- 选择包含深度学习虚拟机映像的内容库。

一次只能访问一个内容库。如果内容库包含 Kubernetes 映像,则会筛选掉这些映像。

- 选择要用于创建 Workstation 虚拟机的虚拟机映像。

- 选择要提供给目录用户的虚拟机类。

您必须至少添加一个支持 GPU 的类和一个不支持 GPU 的类。

- 启用了 GPU 的虚拟机类用于深度学习虚拟机和 TKG 集群的 Worker 节点。部署目录项时,会使用选定的虚拟机类创建 TKG 集群。

- 运行 Kubernetes 控制平面需要不支持 GPU 的节点。

- 选择要应用于虚拟机的存储策略。

- 指定要提取 NVIDIA GPU Cloud 资源的容器注册表。

- 云 – 容器映像从 NVIDIA NGC 目录提取。

- 本地 – 对于气隙环境,容器从专用注册表提取。

您必须提供自托管注册表的位置。如果注册表需要身份验证,还必须提供登录凭据。

可以将 Harbor 用作 NVIDIA NGC 目录中容器映像的本地注册表。请参见在 VMware Private AI Foundation with NVIDIA 中设置专用 Harbor 注册表。

- (可选)配置代理服务器。

在无法直接访问 Internet 的环境中,可使用代理服务器下载 vGPU 驱动程序并提取非 RAG AI Workstation 容器。

注: AI Workstation 和 Triton Inference Server 目录项支持气隙环境。AI RAG Workstation 和 AI Kubernetes 集群目录项不支持气隙环境,需要 Internet 连接。 - 单击下一步。

- 选择包含深度学习虚拟机映像的内容库。

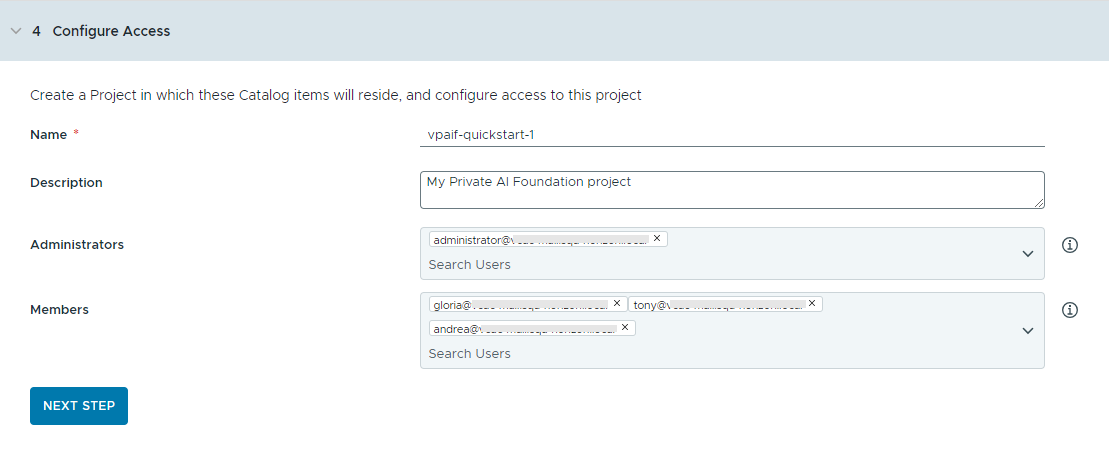

- 通过创建项目并分配用户来配置对目录项的访问权限。

项目用于管理人员、分配的资源、云模板和部署。

- 输入项目的名称和描述。

项目名称只能包含小写字母数字字符或连字符 (-)。

- 要使目录项可供其他人使用,请添加管理员和成员。

管理员比成员拥有更多的权限。有关详细信息,请参见VMware Aria Automation 用户角色有哪些。

- 单击下一步。

- 输入项目的名称和描述。

- 在摘要页面上验证您的配置。

在运行向导之前,请考虑保存配置的详细信息。

- 单击运行快速入门。

结果

在 Automation Service Broker 目录中将创建五个目录项(AI Workstation、AI RAG Workstation、Triton Inferencing Server、AI Kubernetes 集群和 AI Kubernetes RAG 集群),组织中的用户现在可以对其进行部署。

后续操作

- 确认目录中的模板可供您与其共享内容的所选项目成员使用,并监控置备过程以确保成功部署。请参见如何部署 PAIF 目录项。

- 如果要控制部署可存在的时间,请创建租约。请参见设置 Automation Service Broker 策略。

- 要在请求时修改用户输入,可以创建自定义表单。请参见自定义 Automation Service Broker 图标和请求表单。

故障排除

- 如果目录设置向导失败,请为其他项目再次运行该向导。