Als Cloud-Administrator können Sie den VMware Cloud Foundation-Stack verwenden, um eine GPU-fähige Infrastruktur und KI-/ML-Arbeitslastdomänen zu verwalten. In VMware Aria Automation können Sie GPU-fähige Deep Learning-VMs (DL) und Tanzu Kubernetes Grid-Cluster (TKG) als Katalogelemente bereitstellen, die von Datenwissenschaftlern und DevOps-Teams in Ihrer Organisation im Automation Service Broker-Self-Service-Katalog angefordert werden können.

Definition von VMware Private AI Foundation

Bei VMware Private AI Foundation mit NVIDIA handelt es sich um eine Plattform für die Bereitstellung von KI-Arbeitslasten in VMware Cloud Foundation mit NVIDIA GPUs. Darüber hinaus wird die Ausführung von KI-Arbeitslasten basierend auf NVIDIA GPU Cloud-Containern (NGC) insbesondere durch VMware by Broadcom validiert. Weitere Informationen finden Sie unter Definition von VMware Private AI Foundation mit NVIDIA.

Private AI Automation Services ist der Oberbegriff für alle VMware Private AI Foundation-Funktionen, die in VMware Aria Automation verfügbar sind.

Um mit Private AI Automation Services zu beginnen, führen Sie den Assistenten für die Katalogeinrichtung in VMware Aria Automation aus. Mithilfe des Assistenten können Sie VMware Private AI Foundation mit VMware Aria Automation verbinden.

Funktionsweise des Assistenten für die Katalogeinrichtung

- Fügen Sie ein Cloud-Konto hinzu. Cloud-Konten sind die Anmeldeinformationen, die zum Erfassen von Daten von und zum Bereitstellen von Ressourcen an Ihre vCenter-Instanz verwendet werden.

- Fügen Sie eine NVIDIA-Lizenz hinzu.

- Wählen Sie den Inhalt aus, der dem Automation Service Broker-Katalog hinzugefügt werden soll.

- Erstellen Sie ein Projekt. Das Projekt verknüpft Ihre Benutzer mit Cloud-Kontoregionen, sodass sie Cloud-Vorlagen mit Netzwerken und Speicherressourcen für Ihre vCenter-Instanz bereitstellen können.

- KI-Workstation – eine GPU-fähige virtuelle Maschine, die mit der gewünschten vCPU, vGPU, Arbeitsspeicher und der Option zur Vorabinstallation von KI-/ML-Frameworks wie PyTorch, CUDA Samples und TensorFlow konfiguriert werden kann.

- KI-RAG-Workstation – eine GPU-fähige virtuelle Maschine mit RAG (Retrieval Augmented Generation).

- Triton Inference Server – eine GPU-fähige virtuelle Maschine mit Triton Inference Server.

- KI-Kubernetes-Cluster – ein VMware Tanzu Kubernetes Grid-Cluster mit GPU-fähigen Worker-Knoten zum Ausführen von cloudnativen KI-/ML-Arbeitslasten.

- KI-Kubernetes-RAG-Cluster – ein VMware Tanzu Kubernetes Grid-Cluster mit GPU-fähigen Worker-Knoten zum Ausführen einer RAG-Referenzlösung.

Sie können den Assistenten mehrmals ausführen, wenn Sie die von Ihnen bereitgestellten Einstellungen ändern müssen, wie z. B. bei Änderungen an der Lizenzierung oder bei Erstellung von KI-Katalogelementen für andere Projekte. Bei jeder Ausführung des Assistenten werden zusätzlich zu den zuvor erstellten Elementen fünf neue Katalogelemente für Sie angelegt.

Sie können die Vorlagen für die Katalogelemente, die der Assistent erstellt hat, ändern, um die spezifischen Anforderungen Ihrer Organisation zu erfüllen.

Bevor Sie beginnen

- Stellen Sie sicher, dass Sie VMware Aria Automation 8.18 ausführen.

- Stellen Sie sicher, dass Sie VMware Cloud Foundation 5.1.1 oder höher ausführen und vCenter 8.0 Update U2b im Lieferumfang enthalten ist.

- Stellen Sie sicher, dass ein vCenter-Konto in VMware Aria Automation vorhanden ist.

- Stellen Sie sicher, dass Sie über eine NVIDIA GPU Cloud Enterprise-Organisation mit einem Premium-Cloud-Dienstabonnement verfügen.

- Stellen Sie sicher, dass Sie über einen GPU-fähigen Supervisor-Cluster verfügen, der über die Arbeitslastverwaltung konfiguriert wurde.

- Konfigurieren Sie VMware Aria Automation für VMware Private AI Foundation mit NVIDIA. Weitere Informationen hierzu finden Sie unter Einrichten von VMware Aria Automation für VMware Private AI Foundation mit NVIDIA.

- Schließen Sie den Schnellstart von VMware Cloud Foundation ab, bevor Sie den Assistenten für die Katalogeinrichtung ausführen. Ihr SDDC und Ihre Supervisor-Cluster müssen bei VMware Aria Automation registriert sein. Weitere Informationen hierzu finden Sie unter Vorgehensweise für den Einstieg in VMware Aria Automation mithilfe des VMware Cloud Foundation-Schnellstarts.

- Stellen Sie sicher, dass Sie das Client-Konfigurations-Token aus dem NVIDIA-Lizenzierungsserver erzeugt haben und dass Sie über den API-Schlüssel des NVIDIA NGC-Portals verfügen. Der Zugriffsschlüssel des NVIDIA NGC-Portals wird zum Herunterladen und Installieren von vGPU-Treibern verwendet.

- Konfigurieren Sie Single Sign-On (SSO) für die Cloud Consumption Interface (CCI). Weitere Informationen hierzu finden Sie unter Einrichten von Single Sign-On für CCI.

- Stellen Sie sicher, dass Sie die Inhaltsbibliothek unter https://packages.vmware.com/dl-vm/lib.json abonniert haben.

Verfahren

- Nachdem Sie VMware Aria Automation installiert und sich zum ersten Mal angemeldet haben, klicken Sie auf Schnellstart starten.

- Klicken Sie auf der Karte Private AI Automation Services auf Starten.

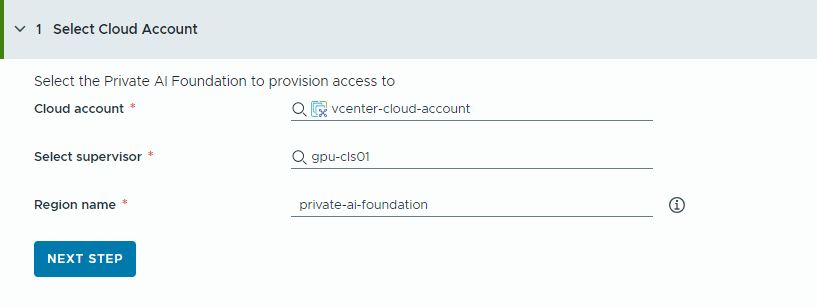

- Wählen Sie das Cloud-Konto aus, auf das der Zugriff bereitgestellt werden soll.

Beachten Sie, dass es sich hier bei allen Werten um Anwendungsbeispiele handelt. Ihre Kontowerte hängen von Ihrer Umgebung ab.

- Wählen Sie ein vCenter-Cloud-Konto aus.

- Wählen Sie einen GPU-fähigen Supervisor aus.

- Geben Sie einen Namen für die Region ein.

Eine Region wird automatisch ausgewählt, wenn der Supervisor bereits mit einer Region konfiguriert ist.

Wenn der Supervisor keiner Region zugeordnet ist, fügen Sie in diesem Schritt einen Supervisor hinzu. Verwenden Sie einen beschreibenden Namen für Ihre Region, damit die Benutzer GPU-fähige Regionen von anderen verfügbaren Regionen unterscheiden können.

- Klicken Sie auf Nächster Schritt.

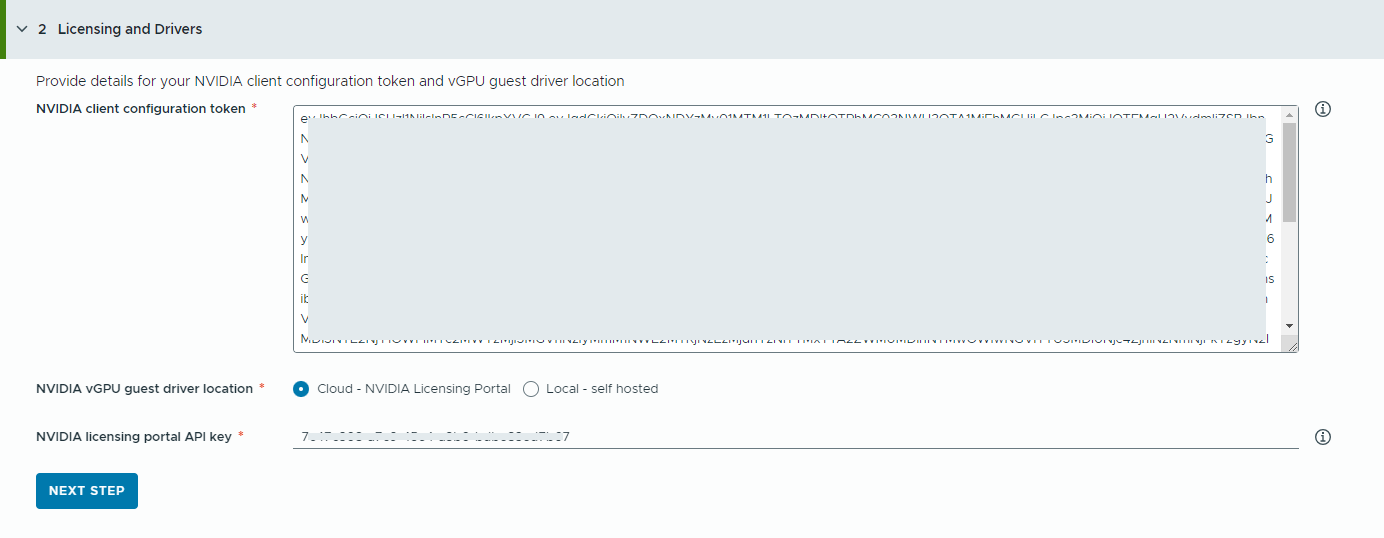

- Stellen Sie Informationen zum NVIDIA-Lizenzserver bereit.

- Kopieren Sie den Inhalt des NVIDIA-Client-Konfigurations-Tokens und fügen Sie ihn ein.

Das Client-Konfigurations-Token wird benötigt, um alle Funktionen des vGPU-Treibers zu aktivieren.

- Wählen Sie den Speicherort der NVIDIA vGPU-Treiber aus.

- Cloud – Der NVIDIA vGPU-Treiber wird auf dem NVIDIA-Lizenzierungsportal gehostet.

Sie müssen den API-Schlüssel des NVIDIA-Lizenzierungsportals bereitstellen, mit dem überprüft wird, ob ein Benutzer über die geeignete Berechtigung zum Herunterladen der NVIDIA vGPU-Treiber verfügt. Der API-Schlüssel muss eine UUID sein.

Hinweis: Der im NVIDIA-Lizenzierungsportal erzeugte API-Schlüssel entspricht nicht dem NVAIE-API-Schlüssel. - Lokal – Der NVIDIA vGPU-Treiber wird lokal gehostet und von einem privaten Netzwerk aus aufgerufen.

Sie müssen den Speicherort der vGPU-Gasttreiber für VMs angeben.

Für Air-Gapped-Umgebungen muss der vGPU-Treiber in Ihrem privaten Netzwerk oder Datencenter verfügbar sein.

- Cloud – Der NVIDIA vGPU-Treiber wird auf dem NVIDIA-Lizenzierungsportal gehostet.

- Klicken Sie auf Nächster Schritt.

- Kopieren Sie den Inhalt des NVIDIA-Client-Konfigurations-Tokens und fügen Sie ihn ein.

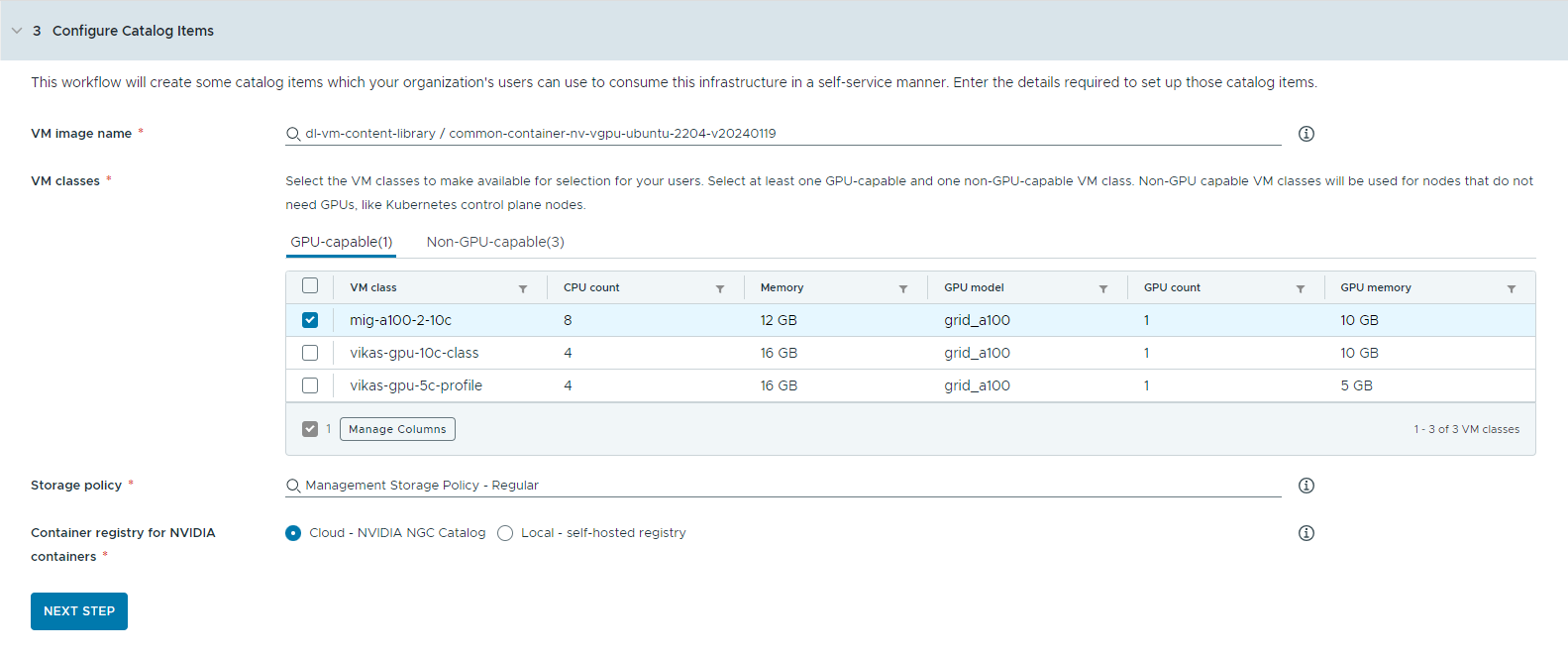

- Konfigurieren Sie die Katalogelemente.

- Wählen Sie die Inhaltsbibliothek aus, die das Deep Learning-VM-Image enthält.

Sie können jeweils nur auf eine einzige Inhaltsbibliothek zugreifen. Wenn die Inhaltsbibliothek Kubernetes-Images enthält, werden diese Images herausgefiltert.

- Wählen Sie das VM-Image aus, das Sie zum Erstellen der Workstation-VM verwenden möchten.

- Wählen Sie die VM-Klassen aus, die Sie Ihren Katalogbenutzern zur Verfügung stellen möchten.

Sie müssen mindestens eine GPU-fähige und eine nicht GPU-fähige Klasse hinzufügen.

- GPU-fähige VM-Klassen werden für die Deep Learning-VM und für die Worker-Knoten des TKG-Clusters verwendet. Wenn das Katalogelement bereitgestellt wird, wird der TKG-Cluster mit den ausgewählten VM-Klassen erstellt.

- Zum Ausführen der Kubernetes-Steuerungsebenen werden nicht GPU-fähige Knoten benötigt.

- Wählen Sie die Speicherrichtlinie aus, die auf die virtuellen Maschinen angewendet werden soll.

- Geben Sie die Containerregistrierung an, in die NVIDIA GPU-Cloud-Ressourcen abgerufen werden sollen.

- Cloud – Die Container-Images werden aus dem NVIDIA NGC-Katalog abgerufen.

- Lokal – Für Air-Gapped-Umgebungen werden die Container aus einer privaten Registrierung abgerufen.

Sie müssen den Speicherort der selbstgehosteten Registrierung angeben. Wenn für die Registrierung eine Authentifizierung erforderlich ist, müssen Sie auch Anmeldedaten angeben.

Sie können Harbor als lokale Registrierung für Container-Images aus dem NVIDIA NGC-Katalog verwenden. Weitere Informationen finden Sie unter Setting Up a Private Harbor Registry in VMware Private AI Foundation with NVIDIA.

- (Optional) Konfigurieren Sie einen Proxyserver.

In Umgebungen ohne direkten Internetzugriff wird der Proxyserver zum Herunterladen des vGPU-Treibers und zum Abrufen der KI-Workstation-Container, die nicht von RAG stammen, verwendet.

Hinweis: Unterstützung für Air-Gapped-Umgebungen ist für die Katalogelemente KI-Workstation und Triton Inference Server verfügbar. Die Elemente KI-RAG-Workstation und KI-Kubernetes-Cluster unterstützen keine Air-Gap-Umgebungen und benötigen eine Internetverbindung. - Klicken Sie auf Nächster Schritt.

- Wählen Sie die Inhaltsbibliothek aus, die das Deep Learning-VM-Image enthält.

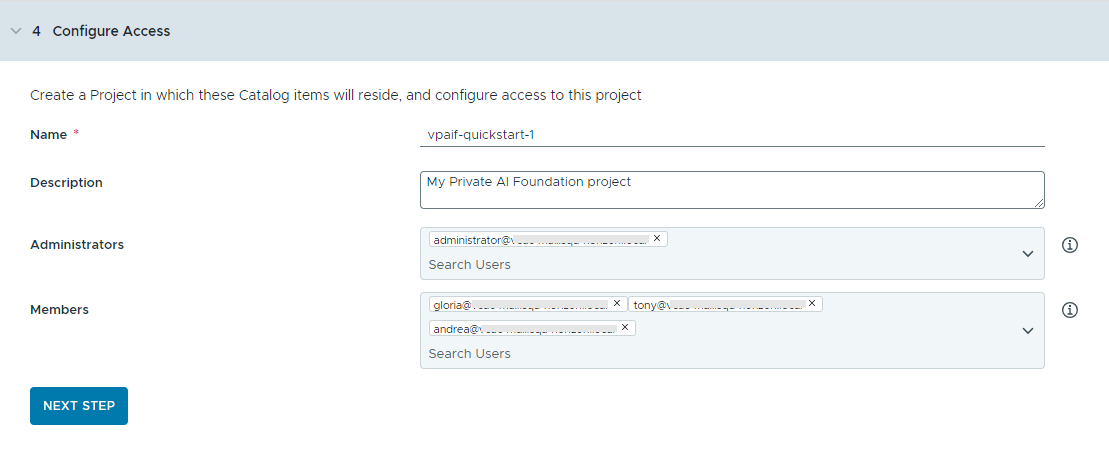

- Konfigurieren Sie den Zugriff auf die Katalogelemente, indem Sie ein Projekt erstellen und Benutzer zuweisen.

Projekte werden verwendet, um Personen, zugewiesene Ressourcen, Cloud-Vorlagen und Bereitstellungen zu verwalten.

- Geben Sie einen Namen und eine Beschreibung für das Projekt ein.

Der Projektname darf nur Kleinbuchstaben, Ziffern oder Bindestriche (-) enthalten.

- Zur Bereitstellung der Katalogelemente für andere Benutzer fügen Sie einen Administrator und Mitglieder hinzu.

Administratoren verfügen über mehr Berechtigungen als Mitglieder. Weitere Informationen finden Sie unter Definition der VMware Aria Automation-Benutzerrollen.

- Klicken Sie auf Nächster Schritt.

- Geben Sie einen Namen und eine Beschreibung für das Projekt ein.

- Überprüfen Sie die Konfiguration auf der Seite Übersicht.

Speichern Sie die Details Ihrer Konfiguration, bevor Sie den Assistenten ausführen.

- Klicken Sie auf Schnellstart ausführen.

Ergebnisse

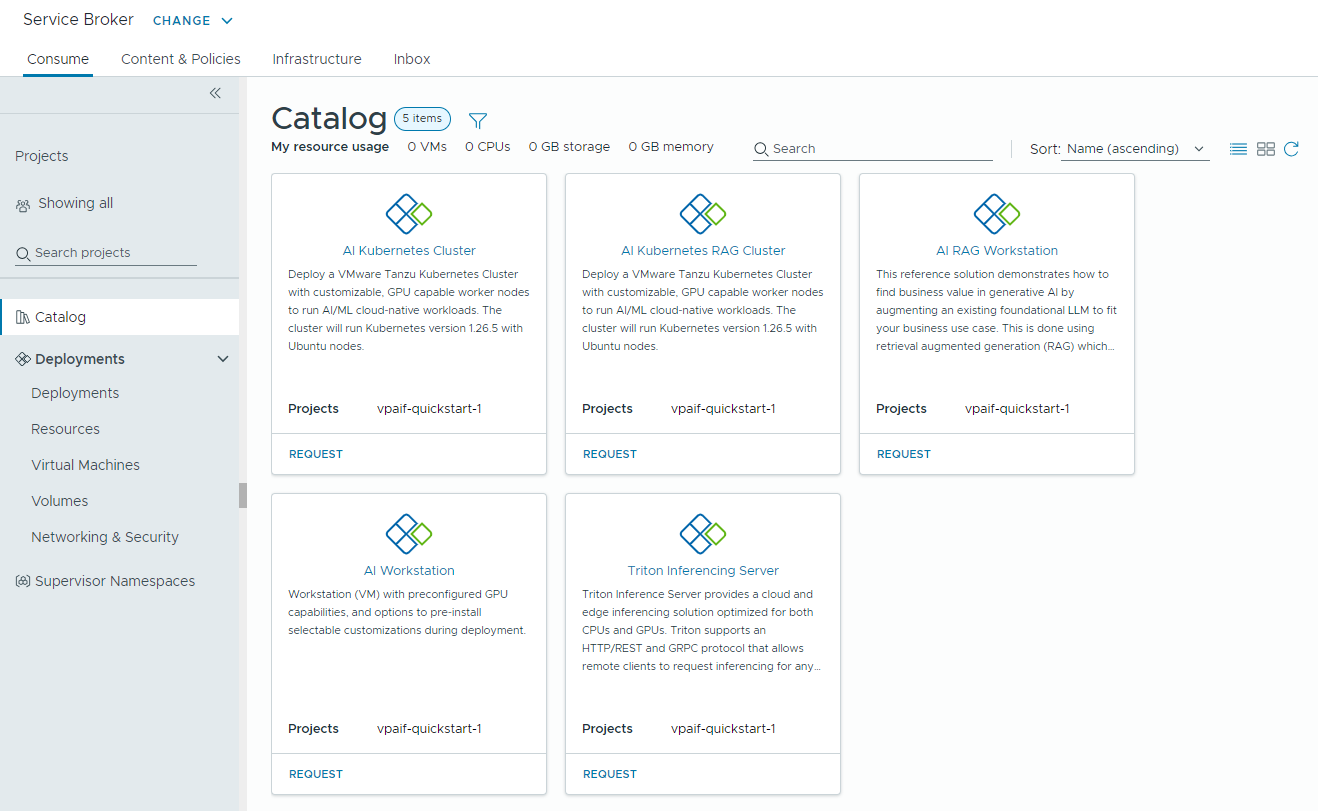

Fünf Katalogelemente – KI-Workstation, KI-RAG-Workstation, Triton Inferencing Server, KI-Kubernetes-Cluster und KI-Kubernetes-RAG-Cluster, werden im Automation Service Broker-Katalog erstellt. Benutzer in Ihrer Organisation können sie jetzt bereitstellen.

Nächste Schritte

- Stellen Sie sicher, dass die Vorlagen im Katalog für die Mitglieder der ausgewählten Projekte verfügbar sind, für die Sie den Inhalt freigegeben haben. Überwachen Sie darüber hinaus den Bereitstellungsprozess, um eine erfolgreiche Bereitstellung zu gewährleisten. Weitere Informationen hierzu finden Sie unter Vorgehensweise zum Bereitstellen von PAIF-Katalogelementen.

- Erstellen Sie eine Lease, um die Dauer einer Bereitstellung festzulegen. Weitere Informationen hierzu finden Sie unter Einrichten von Automation Service Broker-Richtlinien.

- Sie können ein benutzerdefiniertes Formular erstellen, um Benutzereingaben zur Anforderungszeit zu ändern. Weitere Informationen hierzu finden Sie unter Anpassen eines Symbols und eines Anforderungsformulars für Automation Service Broker.

Fehlerbehebung

- Wenn der Assistent für die Katalogeinrichtung fehlschlägt, führen Sie den Assistenten für ein anderes Projekt erneut aus.