Déployer des clusters de gestion avec l’interface du programme d’installation de

Cette rubrique décrit comment utiliser l'interface du programme d'installation de Tanzu Kubernetes Grid pour déployer un cluster de gestion sur vSphere lorsque vSphere with Tanzu superviseur n'est pas activé, sur Amazon Web Services (AWS) et sur Microsoft Azure. L'interface du programme d'installation de Tanzu Kubernetes Grid vous guide tout au long du déploiement du cluster de gestion et fournit différentes configurations que vous pouvez sélectionner ou reconfigurer. Si vous déployez pour la première fois un cluster de gestion sur une plate-forme d'infrastructure donnée, il est recommandé d'utiliser l'interface du programme d'installation, sauf dans les cas où vous avez noté que vous devez effectuer le déploiement à partir d'un fichier de configuration.

ImportantTanzu Kubernetes Grid v2.4.x est la dernière version de TKG qui prend en charge la création de clusters de gestion TKG autonomes sur AWS et Azure. La possibilité de créer des clusters de gestion TKG autonomes sur AWS et Azure sera supprimée dans Tanzu Kubernetes Grid version v2.5.

À partir de maintenant, VMware vous recommande d'utiliser Tanzu Mission Control pour créer des clusters AWS EKS et Azure AKS natifs au lieu de créer des clusters de gestion TKG autonomes ou de nouveaux clusters de charge de travail TKG sur AWS et Azure. Pour plus d'informations sur la création de clusters AWS EKS et Azure AKS natifs avec Tanzu Mission Control, reportez-vous aux sections Gestion du cycle de vie des clusters AWS EKS et Gestion du cycle de vie des clusters Azure AKS dans la documentation de Tanzu Mission Control.

Pour plus d'informations, reportez-vous à la section Obsolescence des clusters de gestion et de charge de travail TKG sur AWS et Azure des Notes de mise à jour de VMware Tanzu Kubernetes Grid v2.4.

Conditions requises

Avant de pouvoir déployer un cluster de gestion, vous devez vous assurer que votre environnement répond aux conditions requises pour la plate-forme cible.

Conditions préalables générales

- Assurez-vous que vous avez respecté toutes les conditions requises et que vous avez suivi l'ensemble des procédures décrites dans la section Installer la CLI Tanzu et la CLI Kubernetes à utiliser avec des clusters de gestion autonomes.

-

Pour les déploiements de production, il est vivement recommandé d'activer la gestion des identités pour vos clusters. Pour plus d'informations sur les étapes préparatoires à effectuer avant de déployer un cluster de gestion, reportez-vous à la section Obtenir les détails de votre fournisseur d'identité dans Configurer la gestion des identités.

-

Si vous déployez des clusters dans un environnement à accès restreint à Internet vers vSphere ou AWS, vous devez également effectuer les étapes décrites dans la section Préparer un environnement à accès restreint à Internet. Ces étapes incluent la définition de

TKG_CUSTOM_IMAGE_REPOSITORYen tant que variable d'environnement.

Conditions préalables à l'infrastructure

Chaque plate-forme cible présente des conditions préalables supplémentaires pour le déploiement du cluster de gestion.

- vSphere

-

Assurez-vous que vous avez respecté toutes les conditions requises répertoriées dans la section

Préparer le déploiement des clusters de gestion dans vSphere.

Remarque

Sur vSphere with Tanzu dans vSphere 8, vous n'avez pas besoin de déployer un cluster de gestion. Reportez-vous à la section Le superviseur vSphere with Tanzu est un cluster de gestion.

- AWS

-

- Assurez-vous que vous avez respecté toutes les conditions requises répertoriées dans la section Préparer le déploiement des clusters de gestion sur AWS.

- Pour plus d'informations sur les configurations des différentes tailles d'instances de nœud, par exemple

t3.largeout3.xlarge, reportez-vous à la section Types d'instances Amazon EC2. - Pour plus d'informations sur les ressources VPC et NAT que Tanzu Kubernetes Grid utilise, reportez-vous à la section Utilisation des ressources dans votre compte Amazon Web Services.

- Azure

-

- Assurez-vous que vous avez respecté les conditions requises répertoriées dans la section Préparer le déploiement des clusters de gestion sur Microsoft Azure.

- Pour plus d'informations sur les configurations des différentes tailles d'instances de nœud pour Azure, par exemple,

Standard_D2s_v3ouStandard_D4s_v3, reportez-vous à la section Tailles des machines virtuelles dans Azure.

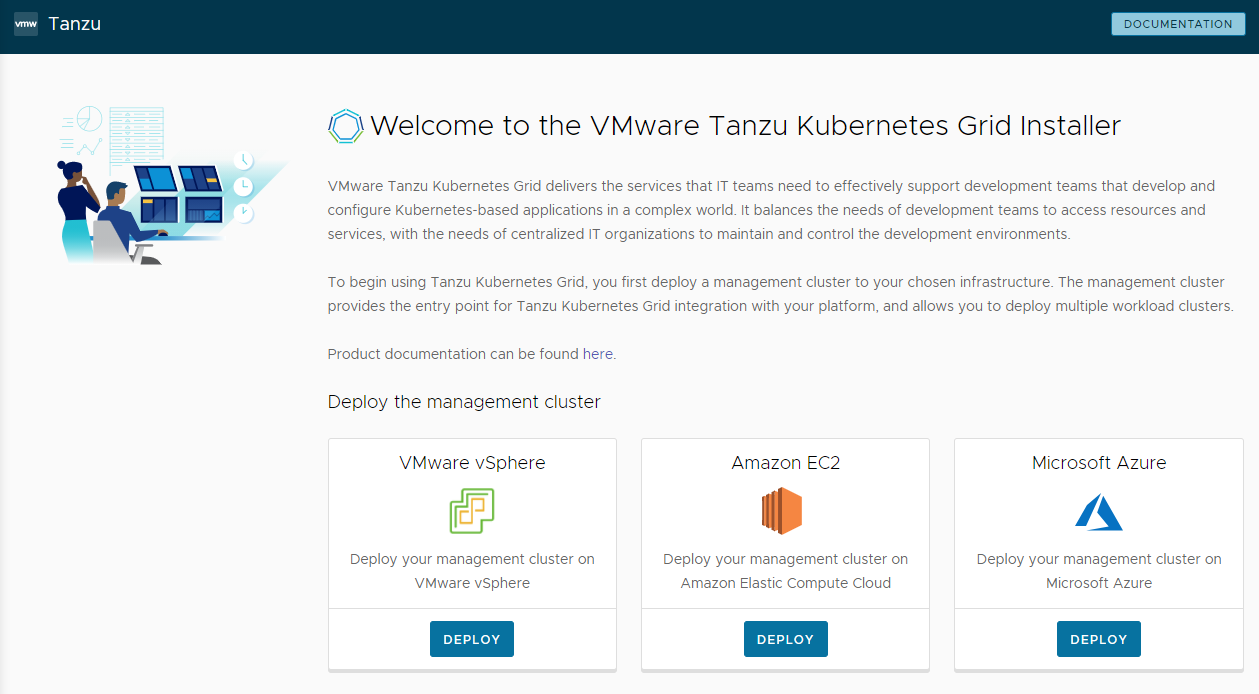

Démarrer l’interface du programme d’installation

Par défaut, Tanzu Kubernetes Grid enregistre le fichier kubeconfig pour tous les clusters de gestion dans ~/.kube-tkg/config. Si vous souhaitez enregistrer le fichier kubeconfig de votre cluster de gestion dans un autre emplacement, définissez la variable d'environnement KUBECONFIG avant d'exécuter tanzu mc create.

-

Sur la machine sur laquelle vous avez téléchargé et installé la CLI Tanzu, exécutez la commande

tanzu mc createavec l'option--ui:tanzu management-cluster create --uiSi les conditions préalables sont remplies, l'interface du programme d'installation se lance dans un navigateur et vous aide à configurer le cluster de gestion.

Attention :

la commande

tanzu mc createprend du temps pour s'exécuter entièrement. Lorsquetanzu mc createest en cours d'exécution, n'exécutez pas d'appels supplémentaires detanzu mc createsur la même machine de démarrage pour déployer plusieurs clusters de gestion, changer le contexte ou modifier~/.kube-tkg/config.La section Options de l'interface du programme d'installation ci-dessous explique comment vous pouvez modifier l'emplacement d'exécution de l'interface du programme d'installation, notamment l'exécuter sur une autre machine à partir de la CLI Tanzu.

-

Cliquez sur le bouton Déployer (Deploy) pour VMware vSphere, Amazon EC2 ou Microsoft Azure.

Options de l’interface du programme d’installation

Par défaut, tanzu mc create --ui ouvre l'interface du programme d'installation localement, à l'adresse http://127.0.0.1:8080, dans votre navigateur par défaut. Vous pouvez utiliser les options --browser et --bind pour contrôler l'emplacement d'exécution de l'interface du programme d'installation :

--browserspécifie le navigateur local dans lequel ouvrir l'interface.- Les valeurs prises en charge sont

chrome,firefox,safari,ie,edgeounone. - Utilisez

noneavec--bindpour exécuter l'interface sur une autre machine, comme décrit ci-dessous.

- Les valeurs prises en charge sont

-

--bindspécifie l'adresse IP et le port de destination de l'interface.Attention :

Le fait de servir l'interface du programme d'installation à partir d'une adresse IP et d'un port qui ne sont pas définis par défaut peut exposer la CLI Tanzu à un risque de sécurité lorsque l'interface est en cours d'exécution. VMware recommande de transmettre à l'option

–bindune adresse IP et un port sur un réseau sécurisé.

Cas d'utilisation pour --browser et --bind inclus :

- Si un autre processus utilise déjà

http://127.0.0.1:8080, utilisez--bindpour servir l'interface à partir d'un port local différent. - Pour que l'interface du programme d'installation s'affiche localement si vous utilisez un tunnel SSH dans la machine de démarrage ou si vous effectuez le transfert X11 de son affichage, vous devrez peut-être utiliser

--browser none. -

Pour exécuter la CLI Tanzu et créer des clusters de gestion sur une machine distante, puis exécuter l'interface du programme d'installation localement ou ailleurs :

-

Sur la machine de démarrage distante, exécutez

tanzu mc create --uiavec les options et valeurs suivantes :--bind: une adresse IP et un port pour la machine distante--browser:none

tanzu mc create --ui --bind 192.168.1.87:5555 --browser none -

Sur la machine d'interface utilisateur locale, accédez à l'adresse IP de la machine distante pour accéder à l'interface du programme d'installation.

-

Configurer la plate-forme cible

Les options de configuration de la plate-forme cible dépendent du fournisseur que vous utilisez.

- vSphere

-

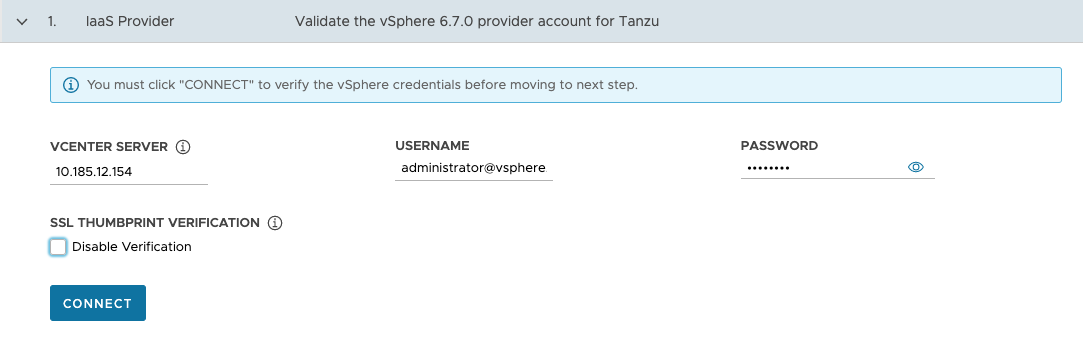

Configurez la connexion à votre instance de vSphere.

-

Dans la section Fournisseur IaaS (IaaS Provider), entrez l'adresse IP ou le nom de domaine complet (FQDN) de l'instance de vCenter Server sur laquelle déployer le cluster de gestion.

La prise en charge des adresses IPv6 dans Tanzu Kubernetes Grid est limitée, reportez-vous à la section Déployer des clusters sur IPv6 (vSphere uniquement). Si vous n'effectuez pas le déploiement dans un environnement de mise en réseau IPv6 uniquement, vous devez fournir des adresses IPv4 dans les étapes suivantes.

-

Entrez le nom d'utilisateur et le mot de passe vCenter Single Sign-On d'un compte d'utilisateur disposant des privilèges requis pour le fonctionnement de Tanzu Kubernetes Grid.

Le nom du compte doit inclure le domaine, par exemple

[email protected].

-

(Facultatif) Sous Vérification de l'empreinte numérique SSL (SSL Thumbprint Verification), sélectionnez Désactiver la vérification (Disable Verification). Si vous cochez cette case, le programme d'installation contourne la vérification de l'empreinte numérique de certificat lors de la connexion à vCenter Server.

-

Cliquez sur Connecter.

-

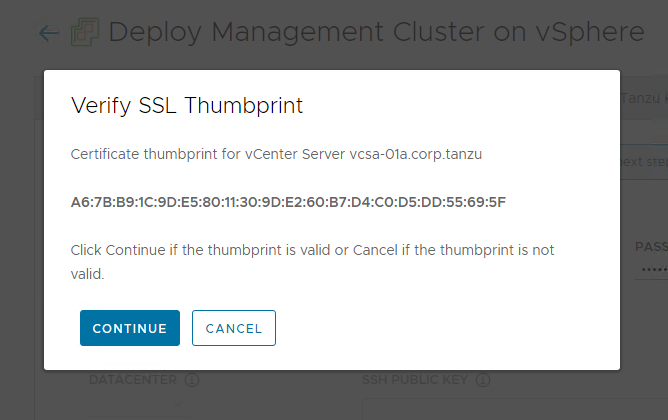

Vérifiez l'empreinte SSL du certificat vCenter Server et cliquez sur Continuer (Continue) si elle est valide. Cet écran s'affiche uniquement si la case Disable Verification (Désactiver la vérification) ci-dessus est décochée.

Pour plus d'informations sur l'obtention de l'empreinte numérique du certificat vCenter Server, reportez-vous à la section Obtenir les empreintes numériques du certificat vSphere.

-

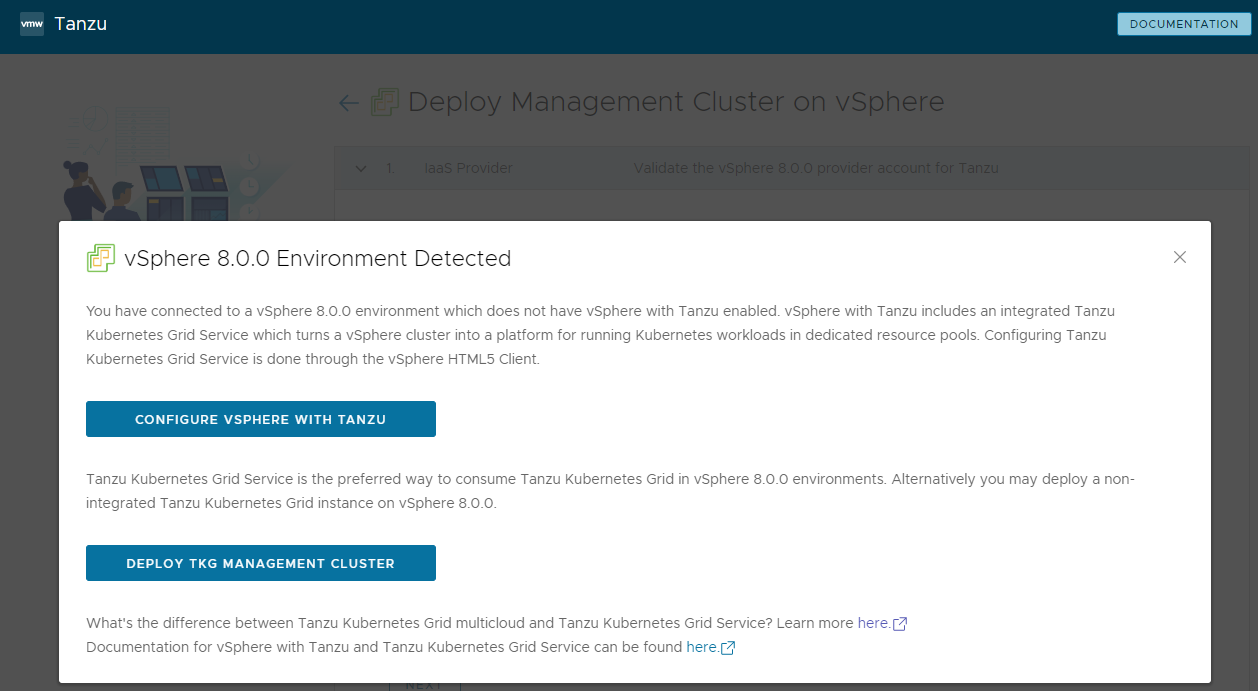

Si vous déployez un cluster de gestion sur une instance de vSphere 7 ou vSphere 8, confirmez si vous souhaitez ou non poursuivre le déploiement.

Sur vSphere 7 et vSphere 8, vSphere with Tanzu inclut un superviseur intégré qui fonctionne comme cluster de gestion et fournit une meilleure expérience qu'un cluster de gestion autonome. Le déploiement d'un cluster de gestion Tanzu Kubernetes Grid vers vSphere 7 ou vSphere 8 lorsque le superviseur n'est pas présent est pris en charge, mais l'option préférée consiste, si possible, à activer vSphere with Tanzu et à utiliser le superviseur. Azure VMware Solution ne prend pas en charge le cluster superviseur, vous devez donc déployer un cluster de gestion.

Pour plus d'informations, reportez-vous à la section Le superviseur vSphere with Tanzu est un cluster de gestion du document Création et gestion de clusters de charge de travail TKG 2.3 avec la CLI Tanzu.

Si vSphere with Tanzu est activé, l'interface du programme d'installation indique que vous pouvez utiliser le service TKG comme moyen préféré pour exécuter des charges de travail Kubernetes, auquel cas vous n'avez pas besoin d'un cluster de gestion autonome. Il présente un choix :

-

Configurer vSphere with Tanzu ouvre vSphere Client de sorte que vous pouvez configurer votre superviseur comme décrit dans la section Configuration et gestion d'un superviseur dans la documentation de vSphere 8.

-

Déployer le cluster de gestion TKG (Deploy TKG Management Cluster) vous permet de continuer à déployer un cluster de gestion, pour vSphere 7 ou vSphere 8, et comme requis pour Azure VMware Solution.

-

-

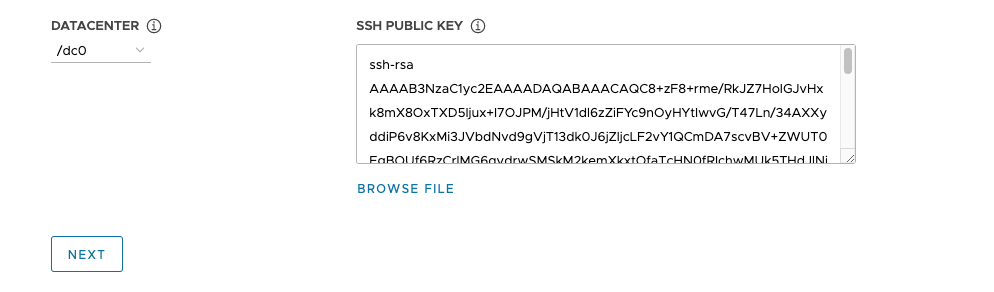

Sélectionnez le centre de données dans lequel déployer le cluster de gestion dans le menu déroulant Centre de données (Datacenter).

-

Ajoutez votre clé publique SSH. Pour ajouter votre clé publique SSH, utilisez l'option Parcourir le fichier (Browse File) ou collez manuellement le contenu de la clé dans la zone de texte. Cliquez sur Suivant.

-

- AWS

-

Configurez la connexion à votre compte AWS.

-

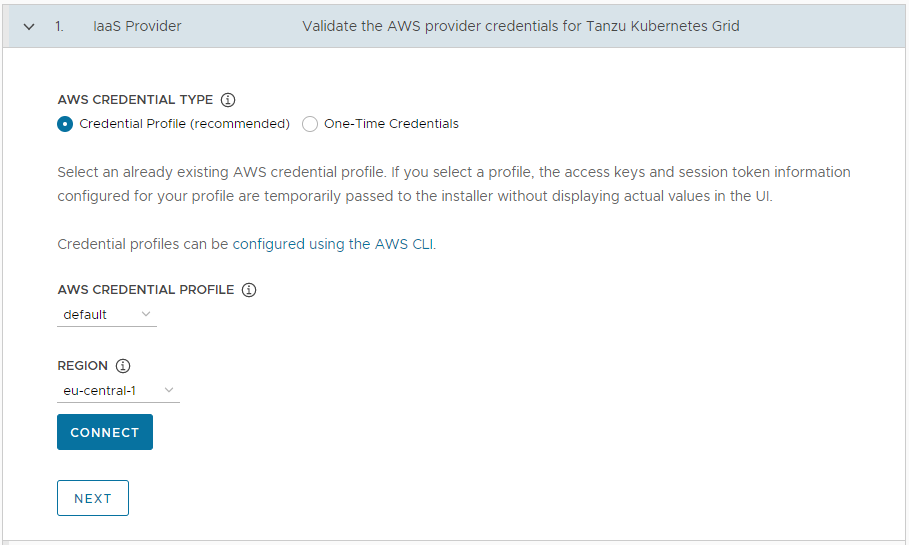

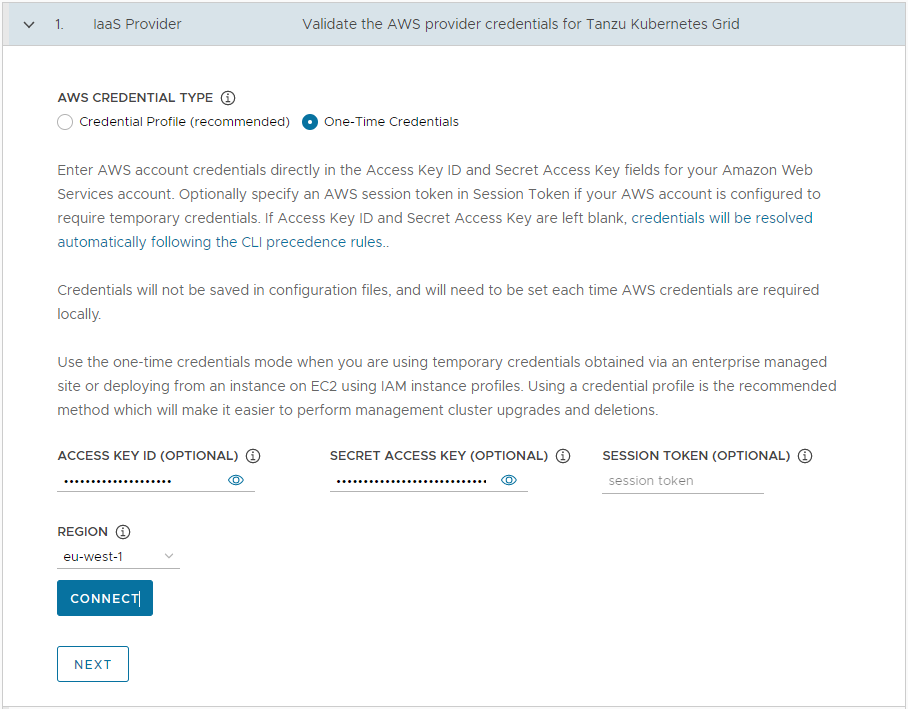

Dans la section Fournisseur IaaS (IaaS Provider), sélectionnez comment fournir les informations d'identification de votre compte AWS. Deux options s'offrent à vous :

-

Profil d'informations d'identification (recommandé) : Sélectionnez un profil d’informations d’identification AWS déjà existant. Si vous sélectionnez un profil, les informations de clé d'accès et de jeton de session configurées pour votre profil sont transmises au programme d'installation sans afficher les valeurs réelles dans l'interface utilisateur. Pour plus d'informations sur la configuration de profils d'informations d'identification, reportez-vous à la section Fichiers et profils d'informations d'identification.

-

Informations d'identification à usage unique : Entrez les informations d'identification du compte AWS directement dans les champs ID de clé Access (Access Key ID) et Clé d'accès secrète (Secret Access Key) de votre compte AWS. Vous pouvez également spécifier un jeton de session AWS dans Jeton de session (Session Token) si votre compte AWS est configuré pour exiger des informations d'identification temporaires. Pour plus d'informations sur l'acquisition de jetons de session, reportez-vous à la section Utilisation d'informations d'identification temporaires avec des ressources AWS.

-

-

Dans Région (Region), sélectionnez la région AWS dans laquelle déployer le cluster de gestion.

Si vous prévoyez de déployer un cluster de gestion de production, cette région doit comporter au moins trois zones de disponibilité.

- Cliquez sur Connecter. Si la connexion est établie, cliquez sur Suivant (Next).

-

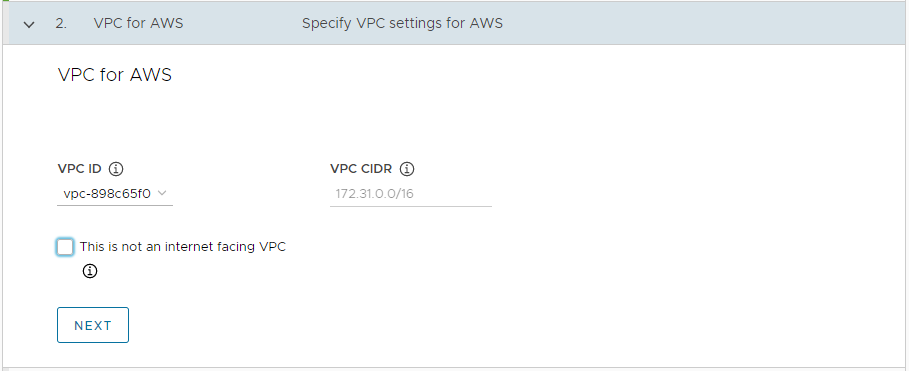

Dans la section VPC pour AWS (VPC for AWS), sélectionnez l'ID de VPC (VPC ID) dans le menu déroulant. Le bloc CIDR VPC (VPC CIDR) est rempli automatiquement lorsque vous sélectionnez le VPC. Si vous déployez le cluster de gestion dans un environnement à accès restreint à Internet, tel qu'un environnement mis sous proxy ou isolé, cochez la case Il ne s'agit pas d'un VPC connecté à Internet (This is not an internet facing VPC).

-

- Azure

-

Configurez la connexion à votre compte Microsoft Azure.

Important

Si vous déployez pour la première fois un cluster de gestion sur Azure avec une nouvelle version de Tanzu Kubernetes Grid (la version v2.3, par exemple), assurez-vous que vous avez accepté la licence d'image de base pour cette version. Pour plus d'informations, reportez-vous à la section Accepter la licence d'image de base dans Préparer le déploiement des clusters de gestion sur Microsoft Azure.

-

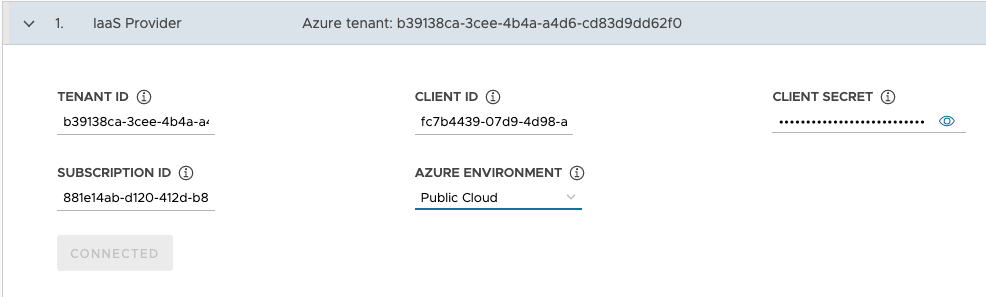

Dans la section Fournisseur IaaS (IaaS Provider), entrez les valeurs ID de locataire (Tenant ID), ID de client (Client ID), Secret du client (Client Secret) et ID d'abonnement (Subscription ID) pour votre compte Azure. Vous avez enregistré ces valeurs lorsque vous avez enregistré une application Azure et créé un secret pour celle-ci à l'aide du portail Azure.

- Sélectionnez votre Environnement Azure (Azure Environment) : Cloud public (Public Cloud) ou Cloud du gouvernement des États-Unis (US Government Cloud). Vous pouvez spécifier d'autres environnements en effectuant le déploiement à partir d'un fichier de configuration et en définissant

AZURE_ENVIRONMENT. - Cliquez sur Connecter. Le programme d'installation vérifie la connexion et modifie l'étiquette du bouton sur Connecté (Connected).

- Sélectionnez la région Azure dans laquelle déployer le cluster de gestion.

-

Collez le contenu de votre clé publique SSH, tel que

.ssh/id_rsa.pub, dans la zone de texte. -

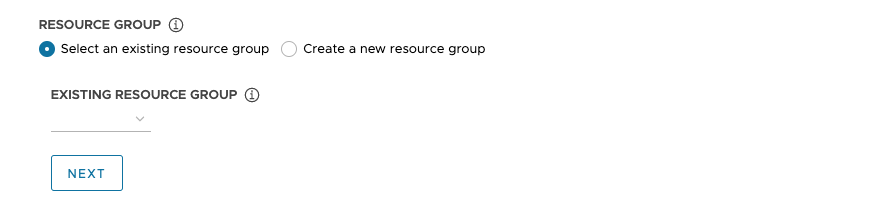

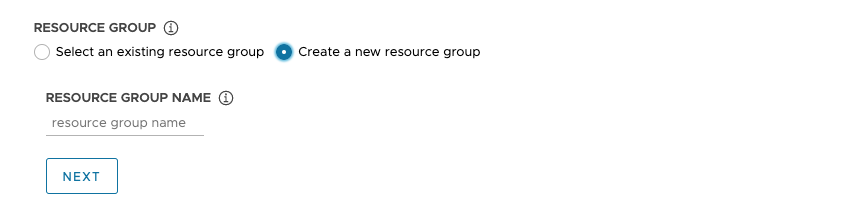

Sous Groupe de ressources (Resource Group), sélectionnez la case d'option Sélectionner un groupe de ressources existant (Select an existing resource group) ou la case d'option Créer un groupe de ressources (Create a new resource group).

-

Si vous sélectionnez Sélectionner un groupe de ressources existant (Select an existing resource group), utilisez le menu déroulant pour sélectionner le groupe, puis cliquez sur Suivant (Next).

-

Si vous sélectionnez Créer un groupe de ressources (Create a new resource group), entrez un nom pour le nouveau groupe de ressources, puis cliquez sur Suivant (Next).

-

-

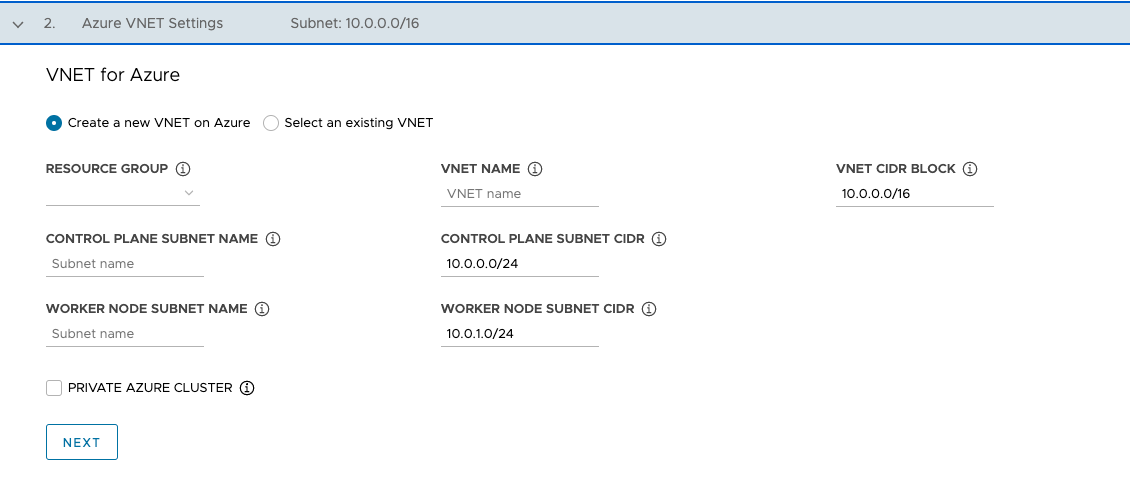

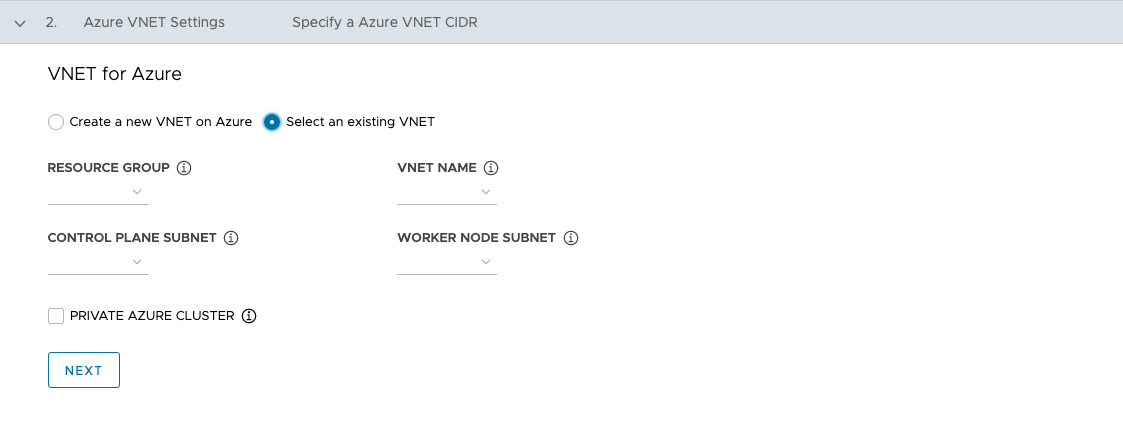

Dans la section Réseau virtuel pour Azure (VNet for Azure), sélectionnez la case d'option Créer un réseau virtuel sur Azure (Create a new VNet on Azure) ou la case d'option Sélectionner un réseau virtuel existant (Select an existing VNet).

-

Si vous sélectionnez Créer un réseau virtuel sur Azure (Create a new VNet on Azure), utilisez le menu déroulant pour sélectionner le groupe de ressources dans lequel créer le réseau virtuel et fournissez les informations suivantes :

- Un nom et un bloc CIDR pour le réseau virtuel. La valeur par défaut est

10.0.0.0/16. - Un nom et un bloc CIDR pour le sous-réseau du plan de contrôle. La valeur par défaut est

10.0.0.0/24. - Un nom et un bloc CIDR pour le sous-réseau du nœud worker. La valeur par défaut est

10.0.1.0/24.

Après avoir configuré ces champs, cliquez sur Suivant (Next).

- Un nom et un bloc CIDR pour le réseau virtuel. La valeur par défaut est

-

Si vous sélectionnez Sélectionnez un réseau virtuel existant (Select an existing VNet), utilisez les menus déroulants pour sélectionner le groupe de ressources dans lequel se trouve le réseau virtuel, le nom du réseau virtuel, le plan de contrôle et les sous-réseaux du nœud worker, puis cliquez sur Suivant (Next).

-

Pour rendre le cluster de gestion privé, comme décrit dans la section Clusters privés Azure, cochez la case Cluster Azure privé (Private Azure Cluster).

-

-

Configurer les paramètres du cluster de gestion

Certaines options de configuration du cluster de gestion dépendent du fournisseur que vous utilisez.

-

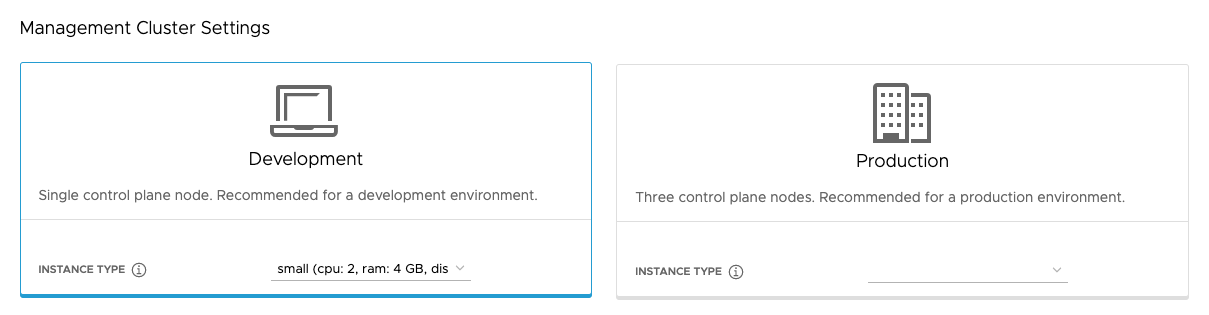

Dans la section Paramètres du cluster de gestion (Management Cluster Settings), sélectionnez la vignette Développement (Development) ou Production.

- Si vous sélectionnez Développement (Development), le programme d'installation déploie un cluster de gestion avec un seul nœud de plan de contrôle et un seul nœud worker.

- Si vous sélectionnez Production, le programme d'installation déploie un cluster de gestion hautement disponible avec trois nœuds de plan de contrôle et trois nœuds worker.

-

Dans les vignettes Développement (Development) ou Production, utilisez le menu déroulant Type d'instance (Instance type) pour effectuer une sélection parmi différentes combinaisons de CPU, de RAM et de stockage pour la ou les machines virtuelles du nœud de contrôle.

Choisissez la configuration des machines virtuelles du nœud du plan de contrôle en fonction des charges de travail attendues qu'il exécutera. Par exemple, certaines charges de travail peuvent nécessiter une grande capacité de calcul, mais un stockage relativement faible, tandis que d'autres peuvent nécessiter une grande quantité de stockage et une capacité de calcul inférieure. Si vous sélectionnez un type d'instance dans la vignette Production, le type d'instance que vous avez sélectionné est automatiquement sélectionné pour le Type d'instance de nœud Worker (Worker Node Instance Type). Si nécessaire, vous pouvez modifier cette option.

Si vous prévoyez d'enregistrer le cluster de gestion dans Tanzu Mission Control, assurez-vous que vos clusters de charge de travail répondent aux conditions requises répertoriées dans la section Conditions requises pour l'enregistrement d'un cluster Tanzu Kubernetes dans Tanzu Mission Control de la documentation Tanzu Mission Control.

- vSphere

- Sélectionnez une taille dans les configurations prédéfinies de CPU, de mémoire et de stockage. La configuration minimale est de 2 CPU et de 4 Go de mémoire.

- AWS

- Sélectionnez une taille d’instance. Le menu déroulant répertorie les choix par ordre alphabétique, pas par taille. La configuration minimale est de 2 CPU et de 8 Go de mémoire. La liste des types d'instance compatibles varie selon les régions. Pour plus d'informations sur la configuration des différentes tailles d'instances, reportez-vous à la section Types d'instances Amazon EC2.

- Azure

- Sélectionnez une taille d’instance. La configuration minimale est de 2 CPU et de 8 Go de mémoire. La liste des types d'instance compatibles varie selon les régions. Pour plus d'informations sur les configurations des différentes tailles d'instances de nœud pour Azure, reportez-vous à la section Tailles des machines virtuelles dans Azure.

-

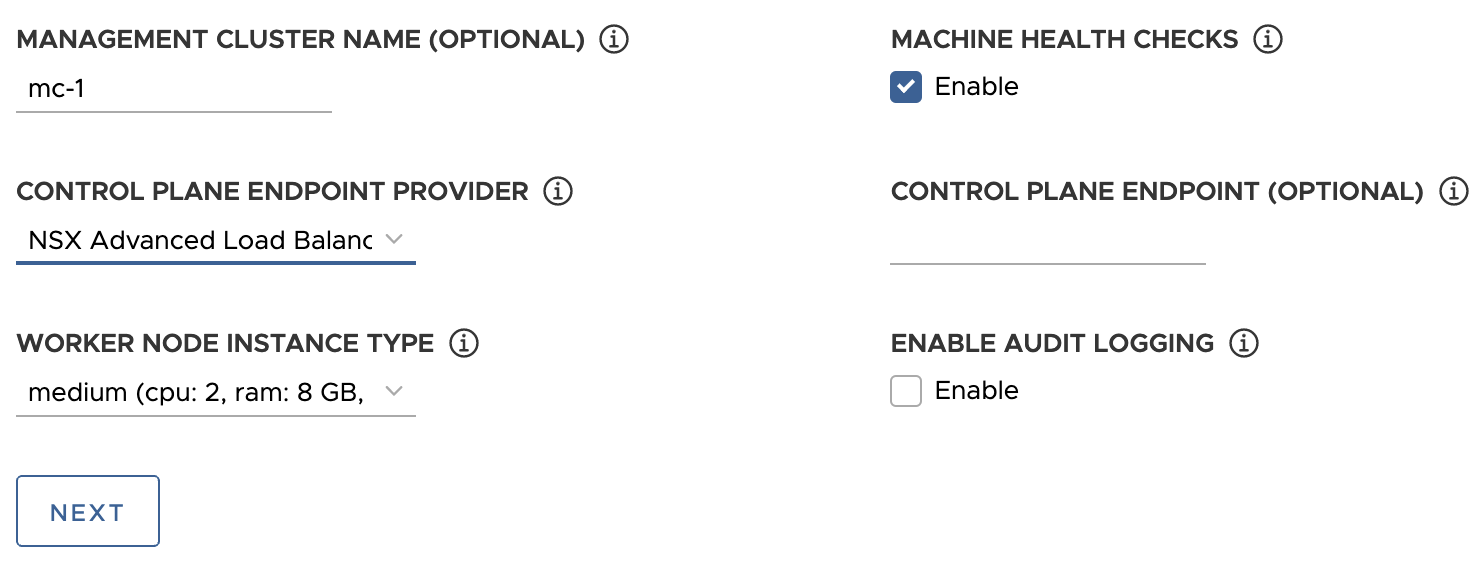

Entrez éventuellement un nom pour votre cluster de gestion.

Si vous ne spécifiez pas de nom, Tanzu Kubernetes Grid génère automatiquement un nom unique. Si vous spécifiez un nom, ce nom doit se terminer par une lettre et non par un caractère numérique, et doit être conforme aux exigences de nom d'hôte DNS telles que définies dans RFC 952 et modifiées dans RFC 1123.

-

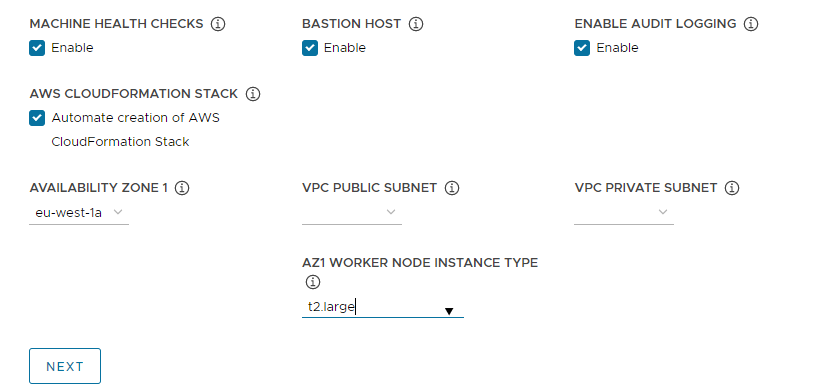

(Facultatif) Décochez la case Contrôles de santé de la machine (Machine Health Checks) si vous souhaitez désactiver

MachineHealthCheck. Vous pouvez activer ou désactiverMachineHealthChecksur les clusters après le déploiement à l'aide de la CLI. Pour obtenir des instructions, reportez-vous à la section Configurer les contrôles de santé de la machine pour les clusters de charge de travail. -

(Facultatif) Cochez la case Activer la journalisation d'audit (Enable Audit Logging) pour enregistrer les demandes effectuées au serveur d'API Kubernetes. Pour plus d'informations, reportez-vous à la section Journalisation d'audit.

-

Configurez des paramètres supplémentaires spécifiques à votre plate-forme cible.

- vSphere

-

Configurez les paramètres spécifiques à vSphere.

- Sous Type d'instance du nœud worker (Worker Node Instance Type), sélectionnez la configuration de la machine virtuelle du nœud worker.

-

Sous Fournisseur de points de terminaison de plan de contrôle (Control Plane Endpoint Provider), sélectionnez Kube-Vip ou NSX Advanced Load Balancer pour choisir le composant à utiliser pour le serveur d'API du plan de contrôle.

Pour utiliser NSX Advanced Load Balancer, vous devez d'abord le déployer dans votre environnement vSphere. Pour plus d'informations, reportez-vous à la section Installer NSX Advanced Load Balancer. Pour plus d'informations sur les avantages de l'utilisation de NSX Advanced Load Balancer comme fournisseur de points de terminaison de plan de contrôle, reportez-vous à la section Configurer NSX Advanced Load Balancer.

-

Sous Point de terminaison du plan de contrôle (Control Plane Endpoint), entrez une adresse IP virtuelle statique ou un nom de domaine complet pour les demandes d'API au cluster de gestion. Ce paramètre est requis si vous utilisez Kube-Vip.

Assurez-vous que cette adresse IP ne se trouve pas dans votre plage DHCP, mais se trouve dans le même sous-réseau que la plage DHCP. Si vous avez mappé un nom de domaine complet à l'adresse VIP, vous pouvez spécifier le nom de domaine complet au lieu de l'adresse VIP. Pour plus d'informations, reportez-vous à la section Adresses IP virtuelles et équilibrages de charge pour vSphere.

Si vous utilisez NSX Advanced Load Balancer comme fournisseur de point de terminaison du plan de contrôle, l'adresse IP virtuelle est automatiquement attribuée à partir du pool d'adresses IP statiques NSX Advanced Load Balancer.

- AWS

-

Configurez les paramètres spécifiques à AWS.

-

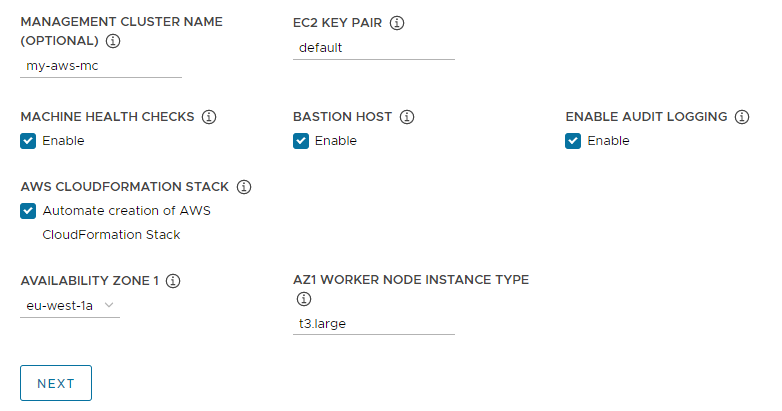

Dans Paire de clés EC2 (EC2 Key Pair), spécifiez le nom d'une paire de clés AWS déjà enregistrée dans votre compte AWS et dans la région dans laquelle vous déployez le cluster de gestion. Vous avez peut-être configuré cette option dans la section Configurer les informations d'identification du compte AWS et la clé SSH.

-

(Facultatif) Désactivez la case Hôte bastion (Bastion Host) si un hôte bastion existe déjà dans la ou les zones de disponibilité dans lesquelles vous déployez le cluster de gestion.

Si vous laissez cette option activée, Tanzu Kubernetes Grid crée un hôte bastion pour vous.

-

S'il s'agit de la première fois que vous déployez un cluster de gestion sur ce compte AWS, cochez la case Automatiser la création de la pile AWS CloudFormation (Automate creation of AWS CloudFormation Stack).

Cette pile CloudFormation crée les ressources de gestion des identités et des accès (IAM) dont Tanzu Kubernetes Grid a besoin pour déployer et exécuter des clusters sur AWS. Pour plus d'informations, reportez-vous à la section Autorisations définies par Tanzu Kubernetes Grid dans Préparer le déploiement de clusters de gestion sur AWS.

-

Configurer les zones de disponibilité :

-

Dans le menu déroulant Zone de disponibilité 1 (Availability Zone 1), sélectionnez une zone de disponibilité pour le cluster de gestion. Vous ne pouvez sélectionner qu'une seule zone de disponibilité si vous avez sélectionné la vignette Développement (Development). Reportez-vous à l'image ci-dessous.

-

Dans le menu déroulant Type d'instance de nœud worker AZ1 (AZ1 Worker Node Instance Type), sélectionnez la configuration de la machine virtuelle du nœud worker dans la liste des instances disponibles dans cette zone de disponibilité.

-

Si vous avez sélectionné la vignette Production ci-dessus, utilisez les menus déroulants Zone de disponibilité 2 (Availability Zone 2), Zone de disponibilité 3 (Availability Zone 3) et Type d'instance de nœud worker AZ (AZ Worker Node Instance Type) pour sélectionner trois zones de disponibilité uniques pour le cluster de gestion.

Lorsque Tanzu Kubernetes Grid déploie le cluster de gestion, qui inclut trois nœuds de plan de contrôle et trois nœuds worker, il distribue les nœuds du plan de contrôle et les nœuds worker dans ces zones de disponibilité.

-

Utilisez les menus déroulants sous-réseau public VPC (VPC public subnet) et sous-réseau privé VPC (VPC private subnet) pour sélectionner des sous-réseaux sur le VPC.

Si vous déployez un cluster de gestion de production, sélectionnez des sous-réseaux pour les trois zones de disponibilité. Les sous-réseaux publics ne sont pas disponibles si vous avez sélectionné Il ne s'agit pas d'un VPC connecté à Internet (This is not an internet facing VPC) dans la section précédente. L'image suivante montre la vignette Développement (Development).

-

-

- Azure

- Sous Type d'instance du nœud worker (Worker Node Instance Type), sélectionnez la configuration de la machine virtuelle du nœud worker.

-

Cliquez sur Suivant.

Configurer VMware NSX Advanced Load Balancer

La configuration de NSX Advanced Load Balancer s'applique uniquement aux déploiements vSphere.

- vSphere

-

VMware NSX Advanced Load Balancer (ALB) fournit une solution d'équilibrage de charge L4+L7 pour vSphere. NSX ALB inclut un opérateur Kubernetes qui s’intègre à l’API Kubernetes pour gérer le cycle de vie des ressources d’équilibrage de charge et d’entrée pour les charges de travail. Pour utiliser NSX ALB, vous devez d’abord le déployer dans votre environnement vSphere. Pour plus d'informations, reportez-vous à la section

Installer NSX Advanced Load Balancer.

Important

Sur vSphere 8, pour utiliser NSX Advanced Load Balancer avec un cluster de gestion autonome TKG et ses clusters de charge de travail, vous avez besoin de NSX ALB 22.1.2 ou version ultérieure et de TKG 2.1.1 ou version ultérieure.

Dans la section VMware NSX Advanced Load Balancer facultative, vous pouvez configurer Tanzu Kubernetes Grid pour utiliser NSX Advanced Load Balancer. Par défaut, tous les clusters de charge de travail utiliseront l’équilibrage de charge.

- Pour Hôte du contrôleur (Controller Host), entrez l'adresse IP ou le nom de domaine complet de la machine virtuelle du contrôleur.

- Entrez le nom d'utilisateur et le mot de passe que vous avez définis pour l'hôte du contrôleur lorsque vous l'avez déployé.

-

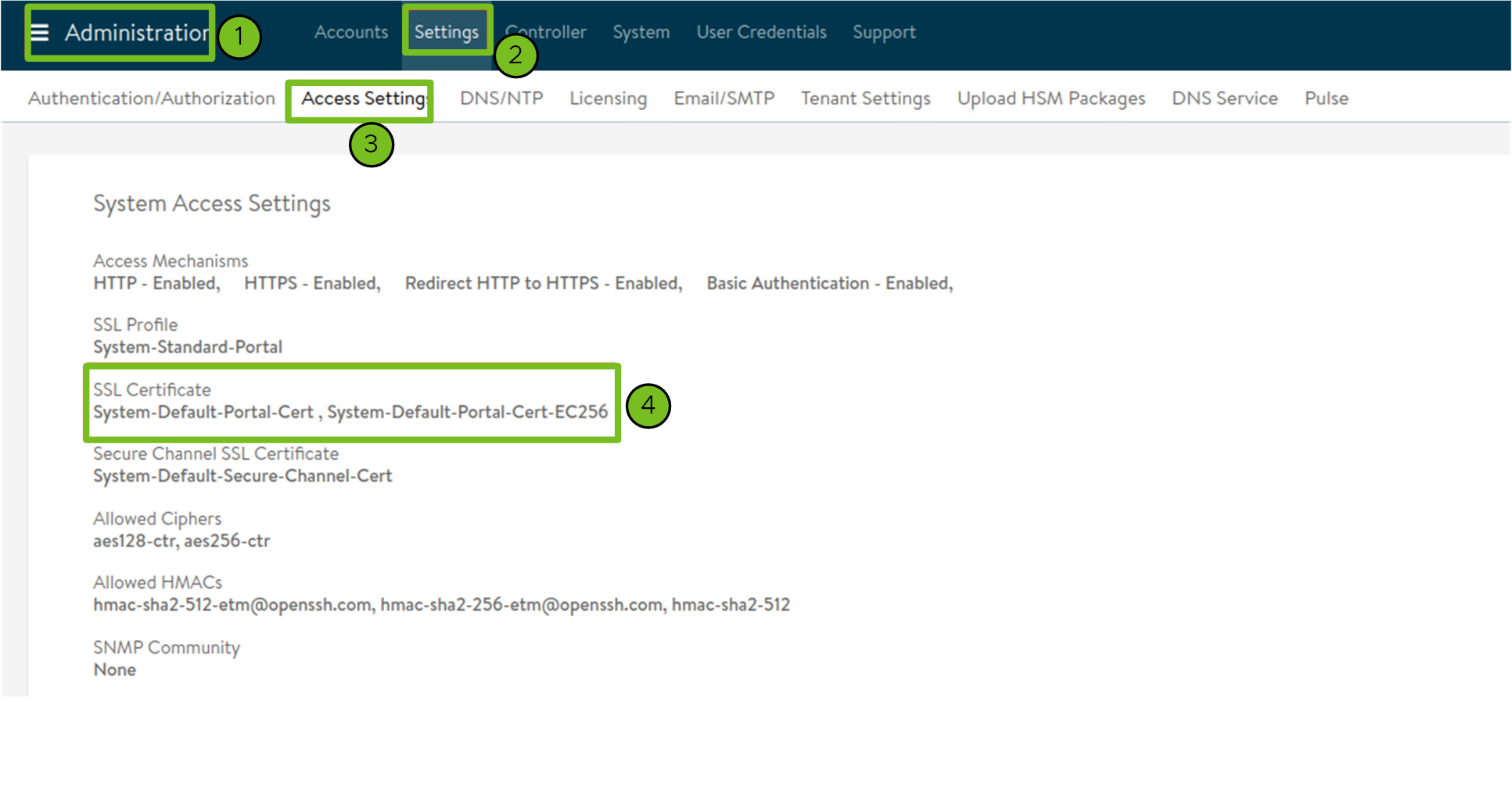

Collez le contenu de l'autorité de certification utilisée pour générer votre certificat de contrôleur dans la zone de texte Autorité de certification du contrôleur (Controller Certificate Authority) et cliquez sur Vérifier les informations d'identification (Verify Credentials).

Le contenu du certificat commence par

-----BEGIN CERTIFICATE-----.Si vous disposez d'un certificat de contrôleur auto-signé, il doit utiliser un certificat SSL/TLS configuré dans l'onglet Interface utilisateur du contrôleur Avi (Avi Controller UI) > Administration > Paramètres (Settings) > Paramètres d'accès (Access Settings), sous Paramètres d'accès au système (System Access Settings) > Certificat SSL (SSL Certificate). Vous pouvez récupérer le contenu des certificats comme décrit dans la section Configuration du contrôleur Avi : certificat personnalisé.

-

Utilisez le menu déroulant Nom du cloud (Cloud Name) pour sélectionner le cloud que vous avez créé dans votre déploiement NSX Advanced Load Balancer.

Par exemple,

Default-Cloud. -

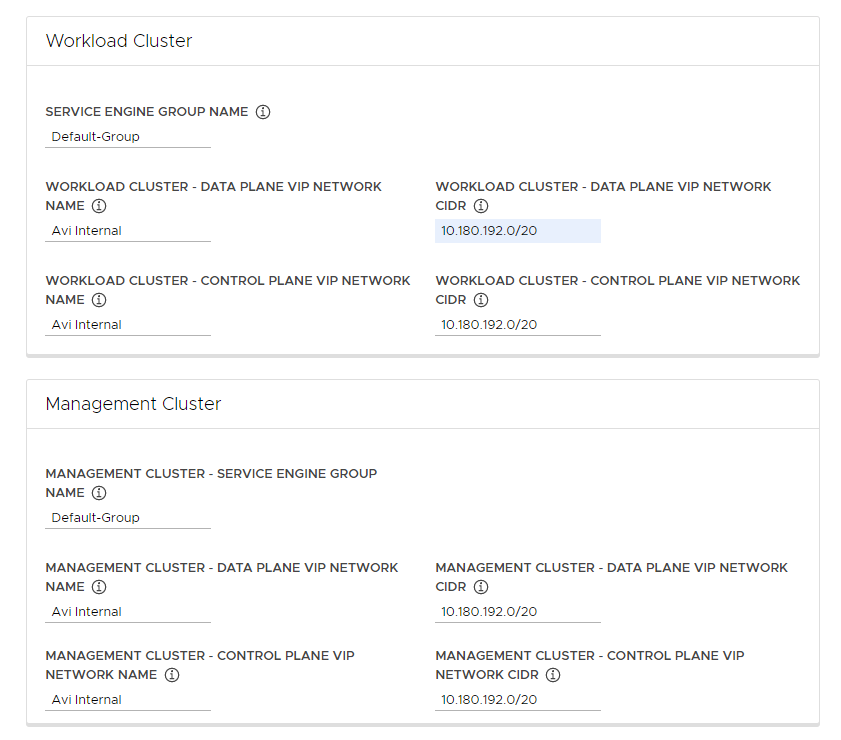

Dans les sections Cluster de charge de travail (Workload Cluster) et Cluster de gestion (Management Cluster), utilisez le menu déroulant Nom du groupe de moteurs de service (Service Engine Group Name) pour sélectionner un groupe de moteurs de service.

Par exemple,

Default-Group. -

Dans le menu déroulant Cluster de charge de travail - Nom du réseau d'adresses IP virtuelles du plan de données(Workload Cluster - Data Plane VIP Network Name), sélectionnez le nom du réseau sur lequel réside le pool d'adresses IP flottantes de l'équilibrage de charge.

Le même réseau est automatiquement sélectionné pour être utilisé par les données et les plans de contrôle des clusters de charge de travail et des clusters de gestion. Vous pouvez les modifier si nécessaire.

Le réseau VIP pour NSX ALB doit être présent dans la même instance de vCenter Server que le réseau Kubernetes que Tanzu Kubernetes Grid utilise. Cela permet à NSX Advanced Load Balancer de détecter le réseau Kubernetes dans vCenter Server et de déployer et de configurer des moteurs de service.

Vous pouvez voir le réseau dans la vue Infrastructure > Réseaux (Networks) de l'interface NSX Advanced Load Balancer.

-

Dans les menus déroulants Cluster de charge de travail - CIDR du réseau d'adresses IP virtuelles du plan de données (Workload Cluster - Data Plane VIP Network CIDR) et Cluster de charge de travail - Réseau d'adresse IP virtuelle du plan de contrôle (Workload Cluster - Control Plane VIP Network CIDR), sélectionnez ou entrez le CIDR du sous-réseau à utiliser pour l'adresse IP virtuelle de l'équilibrage de charge, à utiliser par les plans de données et de contrôle des clusters de charge de travail et des clusters de gestion.

Cela provient de l'un des sous-réseaux configurés du réseau VIP. Vous pouvez voir le CIDR de sous-réseau d'un réseau particulier dans la vue Infrastructure > Réseaux (Networks) de l'interface NSX Advanced Load Balancer. Les mêmes CIDR sont automatiquement appliqués dans les paramètres de cluster de gestion correspondants. Vous pouvez les modifier si nécessaire.

-

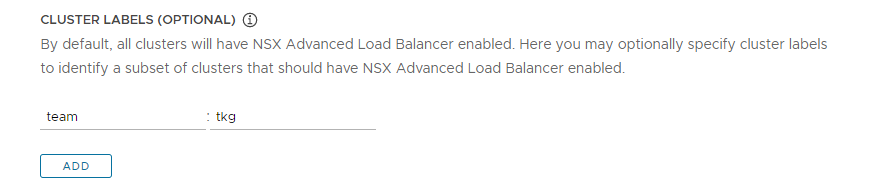

(Facultatif) Entrez une ou plusieurs étiquettes de cluster pour identifier les clusters sur lesquels activer de manière sélective NSX ALB ou pour personnaliser les paramètres NSX ALB pour différents groupes de clusters.

Par défaut, NSX Advanced Load Balancer est activé sur tous les clusters de charge de travail déployés avec ce cluster de gestion, et les clusters partagent une même instance de VMware NSX Advanced Load Balancer Controller, ainsi que les mêmes cloud, groupe de moteurs de service et réseau VIP. Cette configuration ne peut pas être modifiée ultérieurement.

Vous pouvez activer NSX ALB sur un sous-ensemble de clusters uniquement ou conserver la possibilité de personnaliser ultérieurement les paramètres NSX ALB pour différents groupes de clusters. Cela est utile dans les scénarios suivants :

- Vous souhaitez configurer différents ensembles de clusters de charge de travail sur différents groupes de moteurs de service pour implémenter l'isolation ou pour prendre en charge plus d'équilibrages de charge de type de service que la capacité d'un groupe de moteurs de service.

- Vous souhaitez configurer différents ensembles de clusters de charge de travail sur différents clouds, car ils sont déployés sur des sites distincts.

Pour activer NSX ALB de manière sélective plutôt que globale, ajoutez des étiquettes au format

key: value. Les étiquettes que vous définissez ici seront utilisées pour créer un sélecteur d’étiquette. Seuls les objets du cluster de charge de travailClusterayant les étiquettes correspondantes auront l'équilibrage de charge activé. Par conséquent, il vous incombe de vous assurer que l'objetClusterdu cluster de charge de travail dispose des étiquettes correspondantes.Par exemple, si vous utilisez

team: tkgpour activer l'équilibrage de charge sur un cluster de charge de travail :-

Définissez

kubectldans le contexte du cluster.kubectl config use-context management-cluster@admin -

Nommez l'objet

Clusterdu cluster de charge de travail correspondant avec les étiquettes définies. Si vous définissez plusieurs valeurs de clé, vous devez les appliquer toutes.kubectl label cluster <cluster-name> team=tkg

-

Cliquez sur Suivant (Next) pour configurer les métadonnées.

- AWS

- Tanzu Kubernetes Grid on AWS crée automatiquement un équilibrage de charge lorsque vous déployez un cluster de gestion.

- Azure

- Tanzu Kubernetes Grid sur Azure crée automatiquement un équilibrage de charge lorsque vous déployez un cluster de gestion.

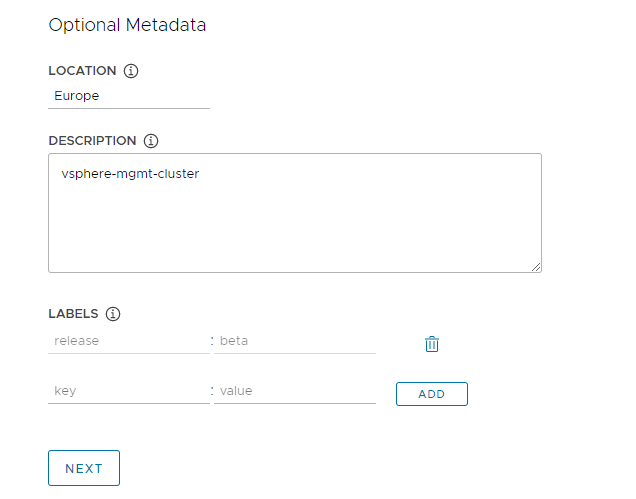

Configurer les métadonnées

Cette section est la même pour toutes les plates-formes cibles.

Dans la section facultative Métadonnées (Metadata), vous pouvez fournir des informations descriptives sur ce cluster de gestion.

Toutes les métadonnées que vous spécifiez ici s'appliquent au cluster de gestion et aux clusters de charge de travail qu'il gère et sont accessibles à l'aide de l'outil de gestion de cluster de votre choix.

- Emplacement (Location) : Emplacement géographique dans lequel les clusters s’exécutent.

- Description : Description de ce cluster de gestion. La description a une longueur maximale de 63 caractères et doit commencer et se terminer par une lettre. Elle ne peut contenir que des minuscules, des chiffres et des traits d'union, sans espace.

- Étiquettes (Labels) : Paires clé/valeur pour aider les utilisateurs à identifier les clusters, par exemple

release : beta,environment : stagingouenvironment : production. Pour plus d'informations, consultez la section Étiquettes et sélecteurs dans la documentation de Kubernetes.

Vous pouvez cliquer sur Ajouter (Add) pour appliquer plusieurs étiquettes aux clusters.

Si vous effectuez le déploiement sur vSphere, cliquez sur Suivant (Next) pour accéder à Configurer les ressources (Configure Resources). Si vous effectuez le déploiement sur AWS ou Azure, cliquez sur Suivant (Next) pour accéder à Configurer le réseau Kubernetes et les proxys (Configure the Kubernetes Network and Proxies).

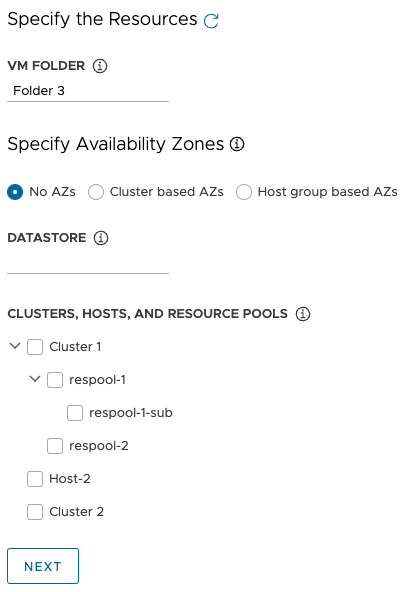

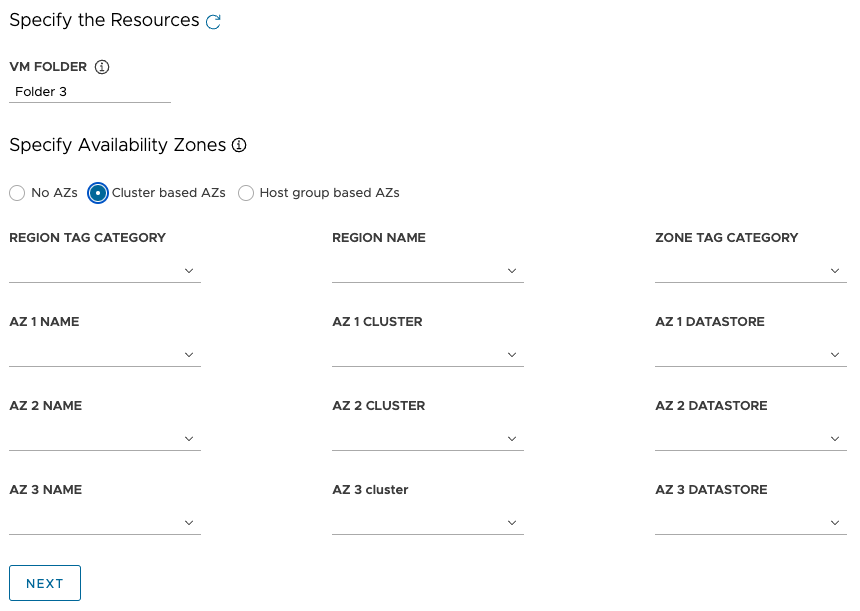

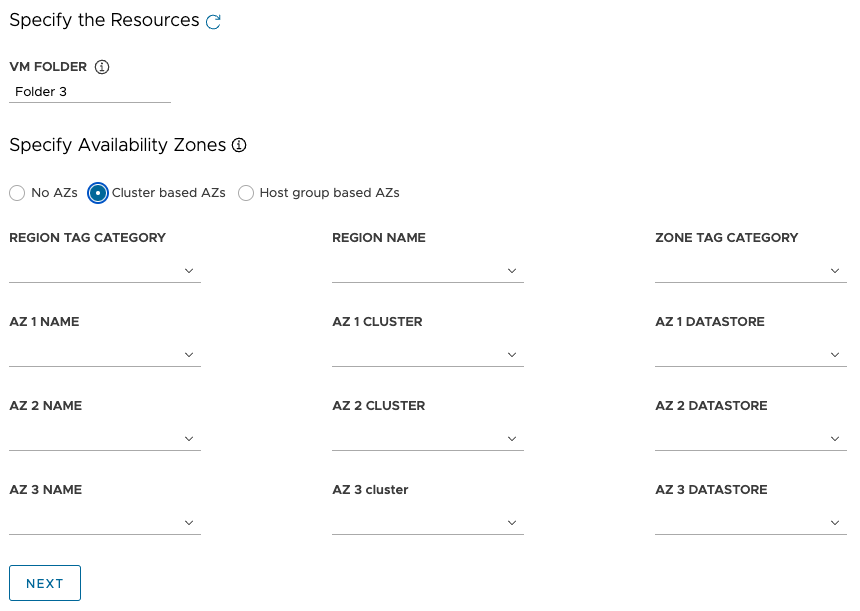

Configurer les ressources vSphere

Cette section s’applique uniquement aux déploiements vSphere.

- vSphere

-

Dans la section

Ressources (Resources), sélectionnez les ressources vSphere que le cluster de gestion doit utiliser.

- Sélectionnez le dossier de machine virtuelle dans lequel placer les machines virtuelles du cluster de gestion.

-

Sélectionnez les banques de données vSphere que le cluster de gestion doit utiliser. La stratégie de stockage des machines virtuelles ne peut être spécifiée que lorsque vous déployez le cluster de gestion à partir d'un fichier de configuration.

-

Sous Spécifier les zones de disponibilité (Specify Availability Zones), choisissez l'emplacement des nœuds du cluster de gestion, puis renseignez les détails suivants :

-

Aucune zone de disponibilité (No AZs) : Pour placer des nœuds par cluster, hôte ou pool de ressources, sélectionnez le cluster, l'hôte ou le pool de ressources dans lequel placer les nœuds.

-

Zones de disponibilité basées sur un cluster (Cluster based AZs) : Pour répartir des nœuds sur plusieurs clusters de calcul dans un centre de données, spécifiez leurs zones de disponibilité de l'une des manières suivantes :

- Sélectionnez une région ou une zone, par son nom ou sa catégorie, qui contient les zones de disponibilité.

- Sélectionnez jusqu'à trois zones de disponibilité spécifiques par nom, cluster ou catégorie.

-

Zones de disponibilité basées sur un groupe d'hôtes (Host group based AZs) : Pour répartir des nœuds sur plusieurs hôtes dans un cluster de calcul unique, spécifiez leurs zones de disponibilité de l'une des manières suivantes :

- Sélectionnez une région ou une zone, par son nom ou sa catégorie, qui contient les zones de disponibilité.

- Sélectionnez jusqu'à trois zones de disponibilité spécifiques par nom, groupe d'hôtes ou groupe de VM.

Remarque

Si les ressources appropriées n'existent pas déjà dans vSphere, sans quitter le programme d'installation de Tanzu Kubernetes Grid, accédez à vSphere pour les créer. Cliquez ensuite sur le bouton Actualiser (Refresh) pour que les nouvelles ressources puissent être sélectionnées.

-

- Cliquez sur Suivant (Next) pour configurer le réseau Kubernetes et les proxys.

- AWS

- Cette section ne s’applique pas aux déploiements AWS.

- Azure

- Cette section ne s’applique pas aux déploiements Azure.

Configurer le réseau Kubernetes et les proxys

Cette section est la même pour toutes les plates-formes cibles, bien que certaines informations que vous fournissez dépendent du fournisseur que vous utilisez.

-

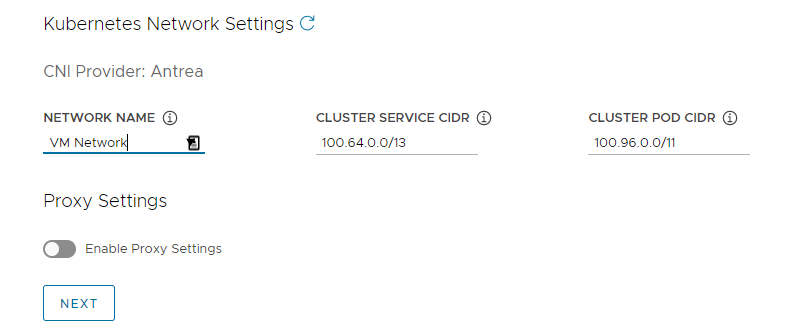

Dans la section Réseau Kubernetes (Kubernetes Network), configurez la mise en réseau des services Kubernetes et cliquez sur Suivant (Next).

- (vSphere uniquement) Sous Nom de réseau (Network Name), sélectionnez un réseau vSphere à utiliser comme réseau de service Kubernetes.

- Vérifiez les plages CIDR de service de cluster (Cluster Service CIDR) et CIDR de l'espace de cluster (Cluster Pod CIDR). Si les plages de CIDR recommandées de

100.64.0.0/13et100.96.0.0/11sont indisponibles, mettez à jour les valeurs sous CIDR de service de cluster (Cluster Service CIDR) et CIDR de l'espace de Cluster (Cluster Pod CIDR).

-

(Facultatif) Pour envoyer le trafic HTTP(S) sortant du cluster de gestion vers un proxy, par exemple dans un environnement à accès restreint à Internet, basculez Activer les paramètres du proxy (Enable Proxy Settings) et suivez les instructions ci-dessous pour entrer les informations de votre proxy. Tanzu Kubernetes Grid applique ces paramètres à kubelet, containerd et au plan de contrôle.

Vous pouvez choisir d'utiliser un proxy pour le trafic HTTP et un autre proxy pour le trafic HTTPS ou d'utiliser le même proxy pour les trafic HTTP et HTTPS.

Important

Vous ne pouvez pas modifier le proxy après avoir déployé le cluster.

-

Pour ajouter vos informations de proxy HTTP :

- Sous URL du proxy HTTP (HTTP Proxy URL), entrez l'URL du proxy qui gère les demandes HTTP. L'URL doit commencer par

http://. Par exemple,http://myproxy.com:1234. -

Si le proxy nécessite une authentification, sous Nom d'utilisateur du proxy HTTP (HTTP Proxy Username) et Mot de passe du proxy HTTP (HTTP Proxy Password), entrez le nom d'utilisateur et le mot de passe à utiliser pour vous connecter à votre proxy HTTP.

Remarque

Les caractères non alphanumériques ne peuvent pas être utilisés dans les mots de passe lors du déploiement de clusters de gestion avec l'interface du programme d'installation.

- Sous URL du proxy HTTP (HTTP Proxy URL), entrez l'URL du proxy qui gère les demandes HTTP. L'URL doit commencer par

-

Pour ajouter vos informations de proxy HTTPS :

- Si vous souhaitez utiliser la même URL pour les trafics HTTP et HTTPS, sélectionnez Utilisez la même configuration pour le proxy HTTPS (Use the same configuration for https proxy).

-

Si vous souhaitez utiliser une URL différente pour le trafic HTTPS, procédez comme suit :

- Sous URL du proxy HTTPS (HTTPS Proxy URL), entrez l'URL du proxy qui gère les demandes HTTP. L'URL doit commencer par

http://. Par exemple,http://myproxy.com:1234. -

Si le proxy nécessite une authentification, sous Nom d'utilisateur du proxy HTTPS (HTTPS Proxy Username) et Mot de passe du proxy HTTPS (HTTP Proxy Password), entrez le nom d'utilisateur et le mot de passe à utiliser pour vous connecter à votre proxy HTTP.

Remarque

Les caractères non alphanumériques ne peuvent pas être utilisés dans les mots de passe lors du déploiement de clusters de gestion avec l'interface du programme d'installation.

- Sous URL du proxy HTTPS (HTTPS Proxy URL), entrez l'URL du proxy qui gère les demandes HTTP. L'URL doit commencer par

-

Sous Aucun proxy (No proxy), entrez une liste de CIDR réseau ou de noms d'hôte qui doivent contourner le proxy HTTP(S), séparés par des virgules. Si votre cluster de gestion s'exécute sur le même réseau que votre infrastructure, derrière le même proxy, définissez-le sur vos CIDR ou noms de domaine complets d'infrastructure afin que le cluster de gestion communique directement avec l'infrastructure.

Par exemple,

noproxy.yourdomain.com,192.168.0.0/24.- vSphere

-

Votre liste

Aucun proxy (No proxy) doit inclure les éléments suivants :

- Adresse IP ou nom d’hôte de vCenter. Le trafic vers vCenter ne peut pas être mis en proxy.

- CIDR du réseau vSphere que vous avez sélectionné sous Nom du réseau (Network Name). Le CIDR du réseau vSphere inclut l'adresse IP de votre Point de terminaison de plan de contrôle (Control Plane Endpoint). Si vous avez entré un nom de domaine complet sous Point de terminaison de plan de contrôle (Control Plane Endpoint), ajoutez le nom de domaine complet et le CIDR du réseau vSphere à Aucun proxy (No proxy). En interne, Tanzu Kubernetes Grid ajoute

localhost,127.0.0.1, les valeurs CIDR de l'espace de cluster (Cluster Pod CIDR) et CIDR du service de cluster (Cluster Service CIDR),.svcet.svc.cluster.localà la liste que vous entrez dans ce champ.

- AWS

-

En interne, Tanzu Kubernetes Grid ajoute

localhost,127.0.0.1, votre CIDR VPC, CIDR de l'espace de cluster (Cluster Pod CIDR) et CIDR de service de cluster (Cluster Service CIDR),.svc,.svc.cluster.localet169.254.0.0/16à la liste que vous entrez dans ce champ. - Azure

-

En interne, Tanzu Kubernetes Grid ajoute

localhost,127.0.0.1, votre CIDR de réseau virtuel, CIDR de l'espace de cluster (Cluster Pod CIDR) et CIDR de service de cluster (Cluster Service CIDR),.svc,.svc.cluster.local,169.254.0.0/16et168.63.129.16à la liste que vous entrez dans ce champ.

Important

Si les machines virtuelles du cluster de gestion doivent communiquer avec des services externes et des points de terminaison d'infrastructure dans votre environnement Tanzu Kubernetes Grid, assurez-vous que ces points de terminaison sont accessibles par les proxys que vous avez configurés ci-dessus ou ajoutez-les à Aucun proxy (No proxy). En fonction de la configuration de votre environnement, cela peut inclure, sans s'y limiter, votre serveur OIDC ou LDAP, Harbor et, dans le cas de vSphere, VMware NSX et NSX Advanced Load Balancer.

-

Configurer la gestion des identités

Cette section est la même pour toutes les plates-formes cibles. Pour plus d'informations sur la manière dont Tanzu Kubernetes Grid implémente la gestion des identités, reportez-vous à la section À propos de la gestion des identités et des accès.

-

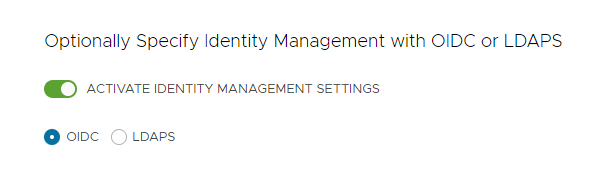

Dans la section Gestion des identités (Identity Management), vous pouvez désactiver Activer les paramètres de gestion des identités (Activate Identity Management Settings).

Vous pouvez désactiver la gestion des identités pour les déploiements de validation technique, mais il est fortement recommandé d'implémenter la gestion des identités dans les déploiements de production. Si vous désactivez la gestion des identités, vous pouvez la réactiver ultérieurement. Pour obtenir des instructions sur la réactivation de la gestion des identités, reportez-vous à la section Activer et configurer la gestion des identités dans un déploiement existant dans Configurer la gestion des identités.

-

Si vous activez la gestion des identités, sélectionnez OIDC ou LDAPS.

Sélectionnez l'onglet OIDC ou LDAPS ci-dessous pour afficher les informations de configuration.

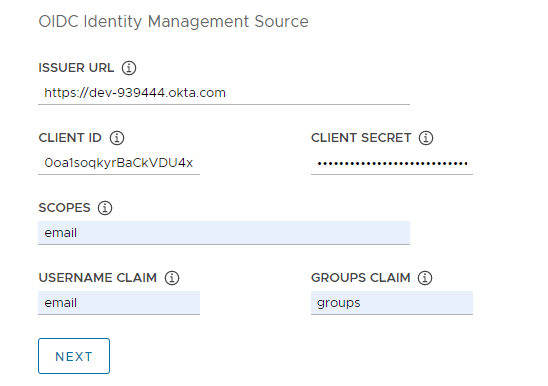

- OIDC

-

Fournissez les détails de votre compte de fournisseur OIDC, par exemple, Okta.

- URL de l'émetteur (Issuer URL) : Adresse IP ou DNS de votre serveur OIDC.

- ID de client (Client ID) : valeur

client_idque vous obtenez de votre fournisseur OIDC. Par exemple, si votre fournisseur est Okta, connectez-vous à Okta, créez une application Web et sélectionnez les options Informations d'identification du client (Client Credentials) afin d'obtenir unclient_idetsecret. - Secret du client (Client Secret) : valeur

secretque vous obtenez de votre fournisseur OIDC. - Portées (Scopes) : Liste séparée par des virgules de portées supplémentaires à demander dans la réponse du jeton. Par exemple,

openid,groups,email. - Réclamation de nom (Username Claim) : nom de votre réclamation de nom d'utilisateur. Cela permet de définir le nom d'utilisateur d'un utilisateur dans la réclamation JWT (JSON Web Token). En fonction de votre fournisseur, entrez des réclamations telles que

user_name,emailoucode. - Réclamation de groupes (Groups Claim) : nom de la réclamation de vos groupes. Il est utilisé pour définir le groupe d'un utilisateur dans la réclamation JWT. Par exemple,

groups.

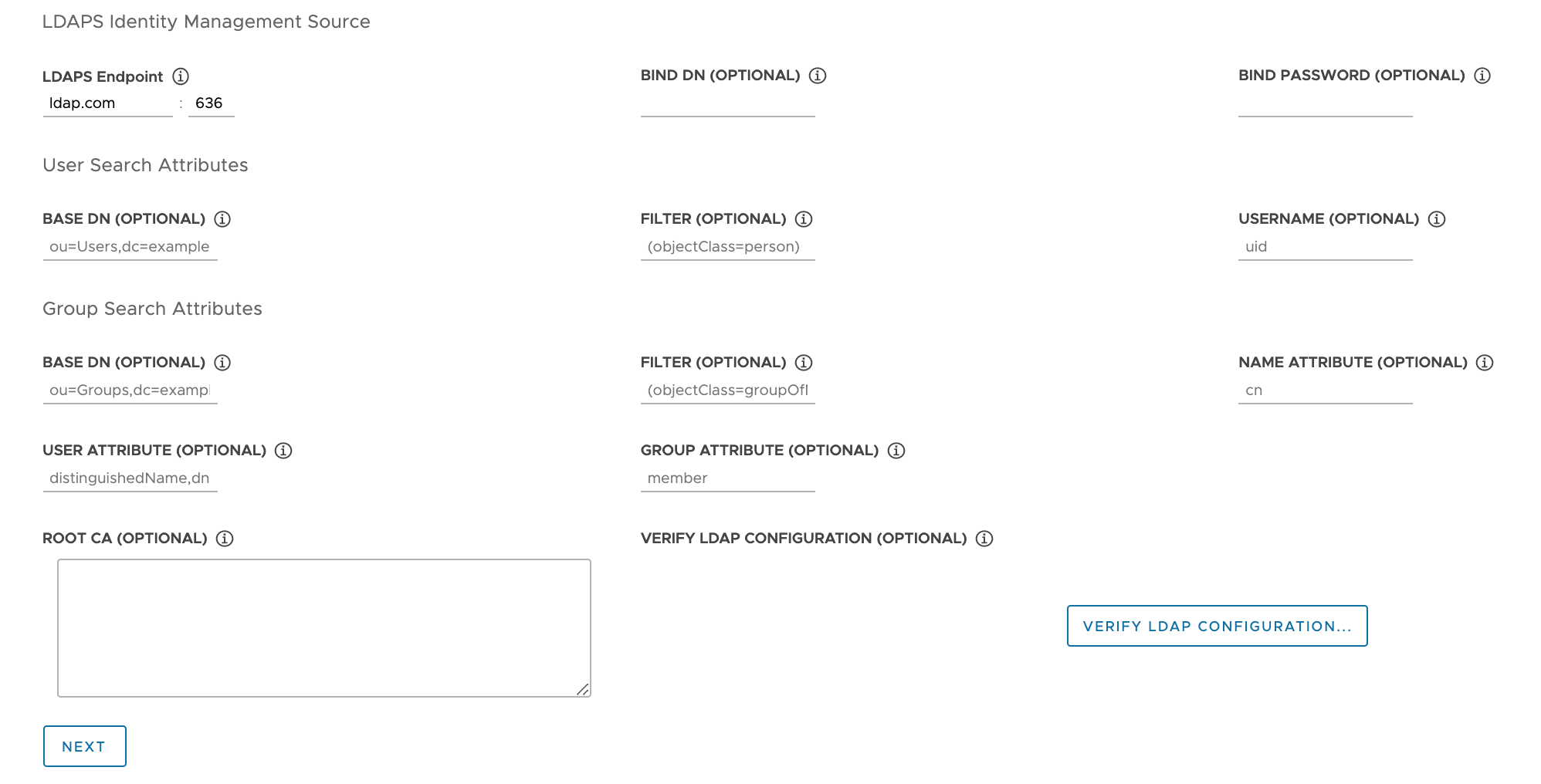

- LDAPS

-

Fournissez les détails du serveur LDAPS de votre entreprise. Tous les paramètres à l'exception de

Point de terminaison LDAPS (LDAPS Endpoint) sont facultatifs.

- Point de terminaison LDAPS (LDAPS Endpoint) : adresse IP ou DNS de votre serveur LDAPS. Fournissez l'adresse et le port du serveur LDAP, sous la forme

host:port. - Nom unique de liaison (Bind DN) : Nom unique d'un compte de service d'application. Le connecteur utilise ces informations d'identification pour rechercher des utilisateurs et des groupes. Non requis si le serveur LDAP fournit un accès pour l'authentification anonyme.

- Mot de passe de liaison (Bind Password) : mot de passe d'un compte de service d'application, si Nom unique de liaison (Bind DN) est défini.

Fournissez les attributs de recherche d'utilisateurs.

- Nom unique de base (Base DN) : point à partir duquel démarrer la recherche LDAP. Par exemple,

OU=Users,OU=domain,DC=io. - Filtre (Filter) : filtre facultatif à utiliser par la recherche LDAP.

- Nom d'utilisateur (Username) : attribut LDAP qui contient l'ID d'utilisateur. Par exemple,

uid, sAMAccountName.

Fournissez les attributs de recherche de groupe.

- Nom unique de base (Base DN) : Point à partir duquel démarrer la recherche LDAP. Par exemple,

OU=Groups,OU=domain,DC=io. - Filtre (Filter) : filtre facultatif à utiliser par la recherche LDAP.

- Attribut du nom (Name Attribute) : attribut LDAP qui contient le nom du groupe. Par exemple,

cn. - Attribut utilisateur (User Attribute) : attribut de l'enregistrement d'utilisateur qui est utilisé comme valeur de l'attribut d'appartenance de l'enregistrement de groupe. Par exemple,

distinguishedName, dn. - Attribut de groupe (Group Attribute) : attribut de l'enregistrement de groupe qui contient les informations sur l'utilisateur/membre. Par exemple,

member.

Collez le contenu du certificat d'autorité de certification du serveur LDAPS dans la zone de texte Certificat d'autorité racine (Root CA).

(Facultatif) Vérifiez les paramètres LDAP.

- Cliquez sur l'option Vérifier la configuration LDAP (Verify LDAP Configuration).

-

Tapez un nom d'utilisateur et un nom de groupe.

Remarque

Dans Tanzu Kubernetes Grid v1.4.x et versions ultérieures, ces champs sont ignorés et les valeurs

cnpour le nom d'utilisateur etoupour le nom du groupe sont rétablies. Pour obtenir des mises à jour sur ce problème connu, reportez-vous aux Notes de mise à jour de VMware Tanzu Kubernetes Grid 1.5. -

Cliquez sur Démarrer.

Une fois la vérification terminée, si vous constatez des échecs, vous devez les examiner attentivement lors des étapes suivantes.

Remarque

L'hôte LDAP effectue cette vérification et non les nœuds de cluster de gestion. Par conséquent, votre configuration LDAP peut fonctionner même si cette vérification échoue.

- Point de terminaison LDAPS (LDAPS Endpoint) : adresse IP ou DNS de votre serveur LDAPS. Fournissez l'adresse et le port du serveur LDAP, sous la forme

- Cliquez sur Suivant (Next) pour accéder à Sélectionner l'image de SE de base.

Sélectionner l'image de SE de base

Dans la section Image de SE (OS Image), utilisez le menu déroulant pour sélectionner le modèle d'image de version du système d'exploitation et de Kubernetes à utiliser pour le déploiement de machines virtuelles Tanzu Kubernetes Grid, puis cliquez sur Suivant (Next).

Mode de génération des choix d'images de SE de base

Le menu déroulant Image de SE (OS Image) inclut des images de système d'exploitation qui répondent à tous les critères suivants :

- L'image est disponible dans votre IaaS.

- Sur vSphere, vous devez importer des images comme décrit dans Importer le modèle d'image de base dans vSphere. Vous pouvez importer une image maintenant, sans quitter l'interface du programme d'installation. Après l'avoir importée, utilisez le bouton Actualiser (Refresh) pour qu'elle s'affiche dans le menu déroulant.

- Sur Azure, vous devez accepter la licence comme décrit dans Acceptez la licence de l'image de base dans Préparer le déploiement des clusters de gestion sur Microsoft Azure.

- L'image de SE est répertoriée dans le fichier de nomenclature de la version de Tanzu Kubernetes (TKR) pour la version de Kubernetes sur laquelle le cluster de gestion s'exécute.

- Les clusters de gestion Tanzu Kubernetes Grid v2.3 s'exécutent sur Kubernetes v1.26.8.

- Pour utiliser une image personnalisée, modifiez le fichier de nomenclature de la TKR pour répertorier l'image, comme expliqué dans Créer des images de machine.

- Les images vSphere, AWS et Azure sont répertoriées dans les blocs

ova,amietazurede la nomenclature, respectivement.

- Le nom de l'image dans IaaS correspond à son identifiant dans la nomenclature de la TKR :

- Les images vSphere, AWS et Azure sont identifiées par leurs valeurs de champ

version,idetsku, respectivement.

- Les images vSphere, AWS et Azure sont identifiées par leurs valeurs de champ

Finaliser le déploiement

Cette section est la même pour toutes les plates-formes cibles.

-

Dans la section Participation au CEIP (CEIP Participation), vous pouvez décocher la case pour refuser de participer au programme d'amélioration du produit VMware, puis cliquez sur Suivant (Next).

Vous pouvez également vous inscrire ou vous retirer du programme après le déploiement du cluster de gestion. Pour plus d'informations sur le programme d'amélioration du produit, reportez-vous aux sections Gérer la participation au programme d'amélioration du produit et https://www.vmware.com/solutions/trustvmware/ceip.html.

-

Cliquez sur Vérifier la configuration (Review Configuration) pour afficher les détails du cluster de gestion que vous avez configuré. Si vous souhaitez revenir à l'assistant du programme d'installation pour modifier votre configuration, cliquez sur Modifier la configuration (Edit Configuration).

Lorsque vous cliquez sur Vérifier la configuration (Review Configuration), le programme d'installation renseigne le fichier de configuration du cluster, qui se trouve dans le sous-répertoire

~/.config/tanzu/tkg/clusterconfigs, avec les paramètres que vous avez spécifiés dans l'interface. Vous pouvez exporter une copie de ce fichier de configuration en cliquant sur Exporter la configuration (Export Configuration). -

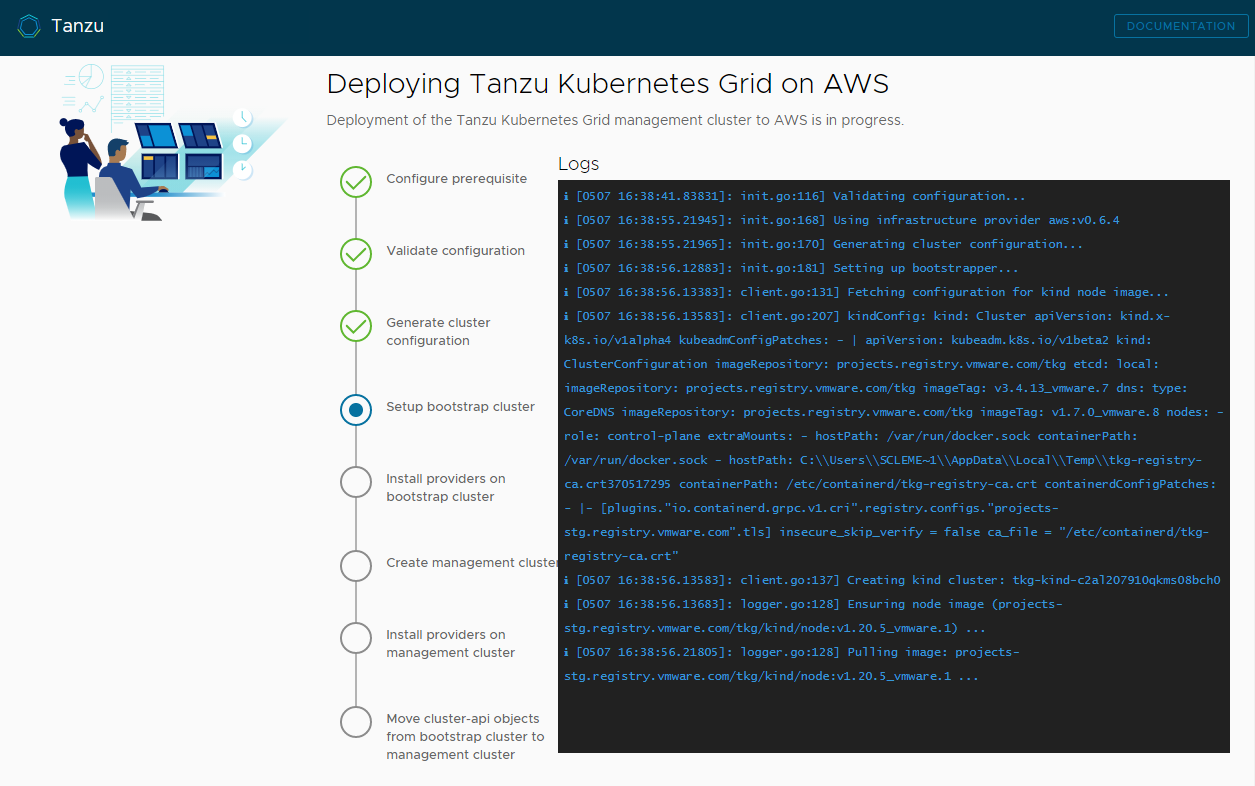

Cliquez sur Déployer le cluster de gestion (Deploy Management Cluster).

Le déploiement du cluster de gestion peut prendre plusieurs minutes. La première exécution de

tanzu mc createprend plus de temps que les exécutions suivantes, car elle doit extraire les images Docker requises dans le magasin d'images sur votre machine de démarrage. Les exécutions suivantes ne nécessitent pas cette étape, elles sont donc plus rapides. Vous pouvez suivre la progression du déploiement du cluster de gestion dans l'interface du programme d'installation ou dans le terminal sur lequel vous avez exécutétanzu mc create --ui. Si la machine sur laquelle vous exécuteztanzu mc creates'arrête ou redémarre avant la fin des opérations locales, le déploiement échouera. Si vous fermez par inadvertance le navigateur ou l'onglet du navigateur dans lequel le déploiement s'exécute avant qu'il ne se termine, le déploiement se poursuit dans le terminal.

-

(Facultatif) Sous Équivalent de commande de CLI (CLI Command Equivalent), cliquez sur le bouton Copier (Copy) pour copier la commande de CLI de la configuration que vous avez spécifiée. Cette commande de CLI inclut le chemin d'accès au fichier de configuration renseigné par le programme d'installation.

-

(vSphere uniquement) Après avoir déployé un cluster de gestion sur vSphere, vous devez configurer les adresses IP de ses nœuds de plan de contrôle pour qu'elles soient statiques, comme décrit dans Configurer des réservations DHCP pour le plan de contrôle (vSphere uniquement).

Tâches suivantes

- Enregistrez le fichier de configuration : le programme d'installation enregistre la configuration du cluster de gestion dans

~/.config/tanzu/tkg/clusterconfigsavec un nom de fichier généré au formatUNIQUE-ID.yaml. Ce fichier de configuration dispose d'une structure plate qui définit les variables en majuscules avec des tirets de soulignement telles queCLUSTER_NAME. Une fois le déploiement terminé, vous pouvez également renommer le fichier de configuration avec un nom pertinent et l'enregistrer dans un autre emplacement pour une utilisation ultérieure. Le programme d'installation génère également une spécification d'objet basée sur une classe de style Kubernetes pour l'objetClusterdu cluster de gestion, qui est enregistrée dans un fichier portant le même nom que le cluster de gestion. Cette spécification d'objet basée sur une classe est fournie à des fins d'informations uniquement. Le déploiement de clusters de gestion à partir d'une spécification d'objet basée sur une classe n'est pas encore pris en charge. Pour plus d'informations sur les types de clusters dans TKG 2.x, reportez-vous à la section Clusters de travail dans À propos de Tanzu Kubernetes Grid. - Configurer la gestion des identités : si vous avez activé la gestion des identités OIDC ou LDAP pour le cluster de gestion, vous devez effectuer les étapes de post-déploiement décrites dans la section Terminer la configuration de la gestion des identités pour activer l'accès.

- Enregistrez votre cluster de gestion dans Tanzu Mission Control : si vous souhaitez enregistrer votre cluster de gestion dans Tanzu Mission Control, reportez-vous à la section Enregistrer votre cluster de gestion dans Tanzu Mission Control.

- Déployer des clusters de charge de travail : Une fois votre cluster de gestion créé, vous pouvez déployer des clusters de charge de travail, comme décrit dans la section Création de clusters de charge de travail du document Création et gestion de clusters de charge de travail TKG 2.3 avec la CLI Tanzu.

- Déployer un autre cluster de gestion : Pour déployer plusieurs clusters de gestion, sur une ou sur l'ensemble des instances de vSphere, d'Azure et d'AWS, reportez-vous à la section Gestion de vos clusters de gestion. Cette rubrique fournit également des informations sur l'ajout de clusters de gestion existants à votre instance de CLI, l'obtention d'informations d'identification, la mise à l'échelle et la suppression de clusters de gestion, l'ajout d'espaces de noms et la manière d'accepter ou de refuser le CEIP.

Pour plus d'informations sur ce qui s'est passé lors du déploiement du cluster de gestion et sur la connexion de kubectl au cluster de gestion, reportez-vous à la section Examiner et enregistrer le cluster de gestion autonome récemment déployé.