L'amministratore del cloud può utilizzare lo stack VMware Cloud Foundation per gestire l'infrastruttura abilitata per GPU e i domini dei carichi di lavoro IA/ML. In VMware Aria Automation, è possibile configurare e fornire macchine virtuali di deep learning (DL VM) e cluster di Tanzu Kubernetes Grid (TKG) abilitati per GPU come elementi del catalogo che i data scientist e i team DevOps dell'organizzazione possono richiedere nel catalogo self-service di Automation Service Broker.

Che cos'è VMware Private AI Foundation?

VMware Private AI Foundation con NVIDIA fornisce una piattaforma per il provisioning dei carichi di lavoro IA in VMware Cloud Foundation con GPU NVIDIA. Inoltre, l'esecuzione dei carichi di lavoro IA basati su container NVIDIA GPU Cloud (NGC) viene convalidata specificamente da VMware by Broadcom. Per ulteriori informazioni, vedere Che cos'è VMware Private AI Foundation con NVIDIA.

Private AI Automation Services è il nome collettivo di tutte le funzionalità di VMware Private AI Foundation disponibili in VMware Aria Automation.

Per iniziare a utilizzare Private AI Automation Services, eseguire Configurazione guidata catalogo in VMware Aria Automation. La procedura guidata consente di connettere VMware Private AI Foundation a VMware Aria Automation.

Come funziona Configurazione guidata catalogo?

- Aggiungere un account cloud. Gli account cloud sono le credenziali utilizzate per raccogliere dati da e distribuire risorse nell'istanza di vCenter.

- Aggiungere una licenza di NVIDIA.

- Selezionare il contenuto da aggiungere al catalogo di Automation Service Broker.

- Creare un progetto. Il progetto collega gli utenti alle regioni degli account cloud, in modo che possano distribuire modelli cloud con le reti e le risorse di storage nell'istanza di vCenter.

- Workstation IA: una macchina virtuale abilitata per la GPU che può essere configurata con la vCPU, la vGPU e la memoria desiderate e la possibilità di preinstallare framework AI/ML come PyTorch, campioni CUDA e TensorFlow.

- AI RAG Workstation: una macchina virtuale abilitata per la GPU con soluzione di riferimento Retrieval Augmented Generation (RAG).

- Triton Inference Server: una macchina virtuale abilitata per GPU con Triton Inference Server.

- AI Kubernetes Cluster: un cluster VMware Tanzu Kubernetes Grid con nodi worker con supporto GPU per eseguire carichi di lavoro nativi del cloud AI/ML.

- AI Kubernetes RAG Cluster: un cluster VMware Tanzu Kubernetes Grid con nodi worker con supporto GPU per eseguire una soluzione RAG di riferimento.

È possibile eseguire nuovamente la procedura guidata più volte se è necessario modificare le impostazioni specificate, ad esempio per modificare le licenze o creare elementi del catalogo IA per altri progetti. Ogni volta che si esegue la procedura guidata, vengono creati cinque nuovi elementi del catalogo oltre a tutti gli elementi creati in precedenza.

È possibile modificare i modelli per gli elementi del catalogo creati dalla procedura guidata per soddisfare le esigenze specifiche dell'organizzazione.

Prima di iniziare

- Verificare che sia in esecuzione VMware Aria Automation 8.18.

- Verificare che sia in esecuzione VMware Cloud Foundation 5.1.1 o versione successiva, che include vCenter 8.0 Update U2b o versione successiva.

- Verificare di disporre di un account cloud vCenter in VMware Aria Automation.

- Verificare di disporre di un'organizzazione NVIDIA GPU Cloud Enterprise con una sottoscrizione al servizio cloud premium.

- Verificare di disporre di un cluster supervisore abilitato per GPU configurato tramite la gestione del carico di lavoro.

- Configurare VMware Aria Automation per VMware Private AI Foundation con NVIDIA. Vedere Configurazione di VMware Aria Automation per VMware Private AI Foundation con NVIDIA.

- Completare l'Avvio rapido di VMware Cloud Foundation prima di eseguire Configurazione guidata catalogo. I cluster supervisore e SDDC devono essere registrati in VMware Aria Automation. Vedere Come iniziare a utilizzare VMware Aria Automation con Avvio rapido di VMware Cloud Foundation.

- Verificare di aver generato il token di configurazione del client dal server di licenze di NVIDIA e di disporre della chiave API di NVIDIA NGC Portal. La chiave di accesso a NVIDIA NGC Portal viene utilizzata per scaricare e installare i driver vGPU.

- Configurare Single Sign-On (SSO) per Cloud Consumption Interface (CCI). Vedere Configurazione di Single Sign-On per CCI.

- Verificare di aver effettuato la sottoscrizione alla libreria dei contenuti in https://packages.vmware.com/dl-vm/lib.json.

Procedura

- Dopo aver installato VMware Aria Automation e aver effettuato l'accesso per la prima volta, fare clic su Inizia Avvio rapido.

- Nella scheda Servizi di automazione IA privati, fare clic su Inizia.

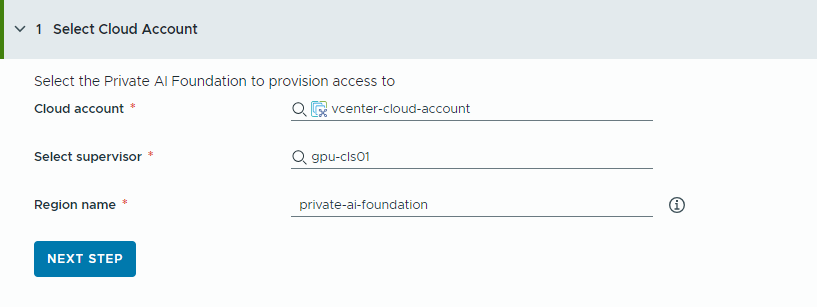

- Selezionare l'account cloud a cui fornire l'accesso.

Tenere presente che tutti i valori indicati qui sono esempi di casi d'uso. I valori dell'account variano in base all'ambiente in uso.

- Selezionare un account cloud vCenter.

- Selezionare un supervisore abilitato per la GPU.

- Immettere il nome di una regione.

Se il supervisore è già configurato con una regione, viene selezionata automaticamente una regione.

Se il supervisore non è associato a una regione, aggiungerne uno in questo passaggio. È consigliabile utilizzare un nome descrittivo per la regione che consenta agli utenti di distinguere le regioni abilitate per GPU dalle altre regioni disponibili.

- Fare clic su Passaggio successivo.

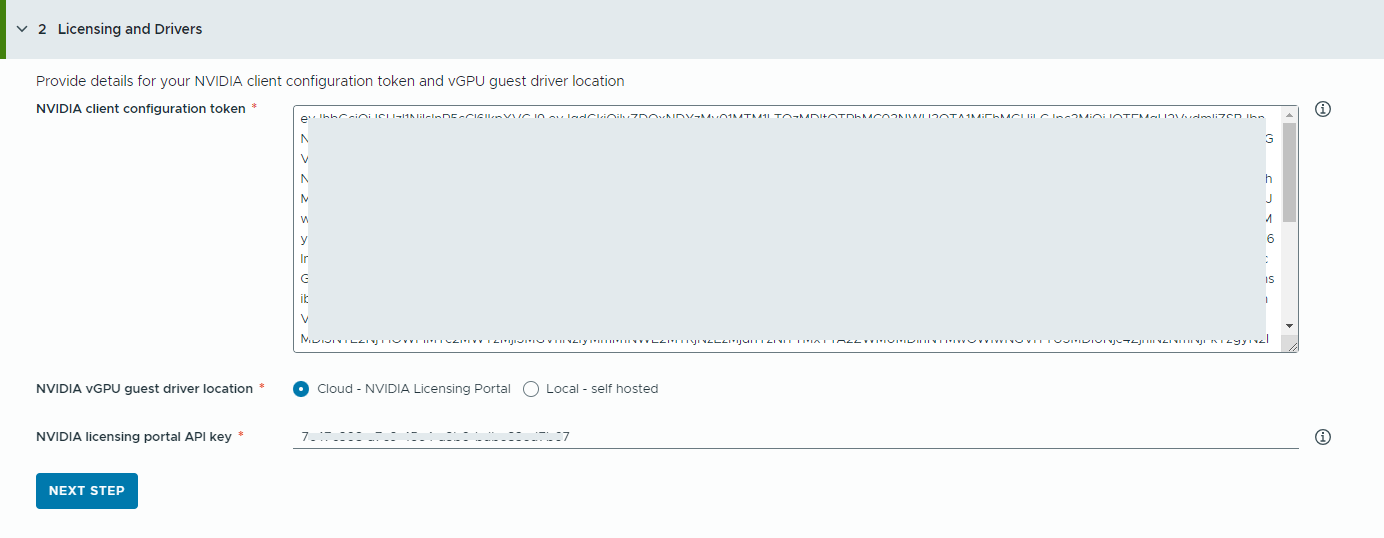

- Fornire informazioni sul server di gestione delle licenze di NVIDIA.

- Copiare e incollare i contenuti del token di configurazione del client di NVIDIA.

Il token di configurazione del client è necessario per abilitare le funzionalità complete del driver vGPU.

- Selezionare la posizione dei driver vGPU NVIDIA.

- Cloud : il driver vGPU NVIDIA è ospitato in NVIDIA Licensing Portal.

È necessario fornire la chiave dell'API di NVIDIA Licensing Portal, che viene utilizzata per valutare se un utente dispone delle autorizzazioni per scaricare i driver vGPU NVIDIA. La chiave API deve essere un UUID.

Nota: La chiave API generata da NVIDIA Licensing Portal non è uguale alla chiave API NVAIE. - Locale: il driver vGPU NVIDIA è ospitato in locale e vi si accede da una rete privata.

È necessario specificare la posizione dei driver guest vGPU per le macchine virtuali.

Per gli ambienti air gap, il driver vGPU deve essere disponibile nella rete privata o nel data center.

- Cloud : il driver vGPU NVIDIA è ospitato in NVIDIA Licensing Portal.

- Fare clic su Passaggio successivo.

- Copiare e incollare i contenuti del token di configurazione del client di NVIDIA.

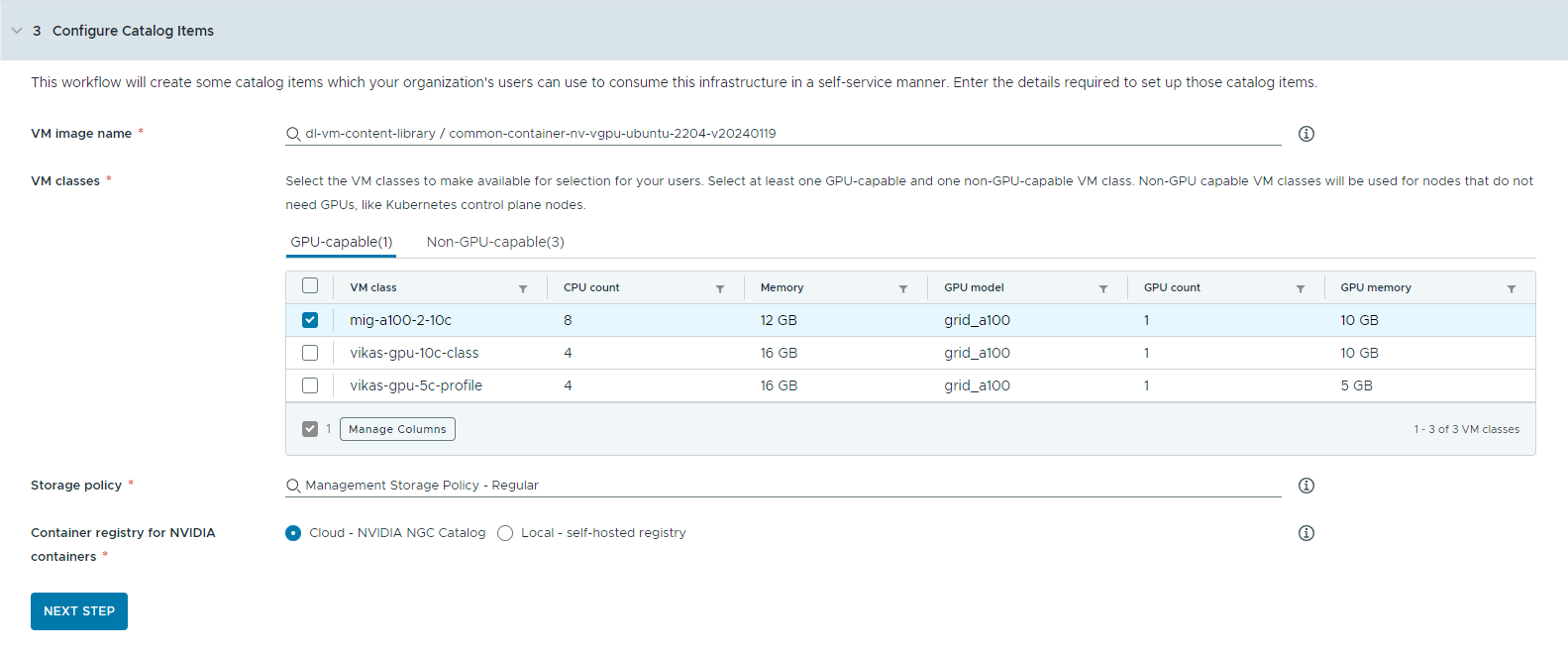

- Configurare gli elementi del catalogo.

- Selezionare la libreria di contenuti che contiene l'immagine della macchina virtuale di deep learning.

È possibile accedere a una sola libreria di contenuti alla volta. Se la libreria di contenuti contiene immagini Kubernetes, tali immagini vengono escluse.

- Selezionare l'immagine della macchina virtuale che si desidera utilizzare per creare la macchina virtuale workstation.

- Selezionare le classi di macchine virtuali che si desidera rendere disponibili per gli utenti del catalogo.

È necessario aggiungere almeno una classe con supporto GPU e una classe senza supporto GPU.

- Le classi di macchine virtuali abilitate per GPU vengono utilizzate per la macchina virtuale di deep learning e per i nodi worker del cluster TKG. Quando l'elemento del catalogo viene distribuito, il cluster TKG viene creato con le classi di macchine virtuali selezionate.

- Per eseguire i piani di controllo di Kubernetes, sono necessari nodi non abilitati per GPU.

- Selezionare il criterio di storage da applicare alle macchine virtuali.

- Specificare il registro del container in cui si desidera estrarre le risorse cloud GPU di NVIDIA.

- Cloud : le immagini dei container vengono estratte dal catalogo NVIDIA NGC.

- Locale: per gli ambienti air gap, i container vengono estratti da un registro privato.

È necessario specificare la posizione del registro self-hosted. Se il registro richiede l'autenticazione, è necessario fornire anche le credenziali di accesso.

È possibile utilizzare Harbor come registro locale per le immagini del container del catalogo NVIDIA NGC. Vedere Configurazione di un registro Harbor privato in VMware Private AI Foundation con NVIDIA..

- (Facoltativo) Configurare un server proxy.

Negli ambienti che non hanno accesso diretto a Internet, il server proxy viene utilizzato per scaricare il driver vGPU ed estrarre i container di Workstation IA non RAG.

Nota: Il supporto per gli ambienti air gap è disponibile per gli elementi del catalogo Workstation IA e Triton Server Inference. Gli elementi AI RAG Workstation e AI Kubernetes Cluster non supportano gli ambienti air gap e richiedono connettività Internet. - Fare clic su Passaggio successivo.

- Selezionare la libreria di contenuti che contiene l'immagine della macchina virtuale di deep learning.

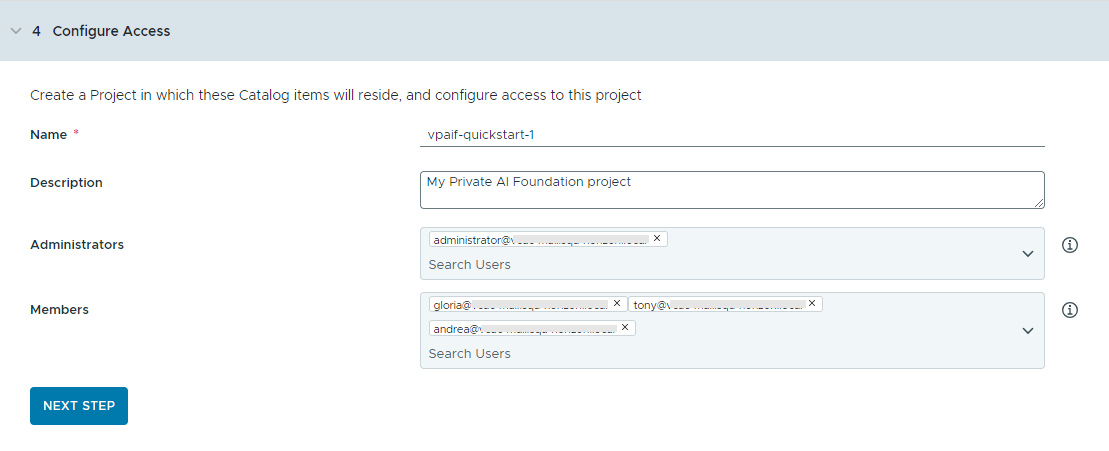

- Configurare l'accesso agli elementi del catalogo creando un progetto e assegnando gli utenti.

I progetti vengono utilizzati per gestire le persone, le risorse assegnate, i modelli cloud e le distribuzioni.

- Immettere un nome e una descrizione per il progetto.

Il nome del progetto può contenere solo caratteri alfanumerici minuscoli o trattini (-).

- Per rendere gli elementi del catalogo disponibili per altri utenti, aggiungere un Amministratore e Membri.

Gli amministratori hanno più autorizzazioni di quelle dei membri. Per ulteriori informazioni, vedere Quali sono i ruoli utente di VMware Aria Automation.

- Fare clic su Passaggio successivo.

- Immettere un nome e una descrizione per il progetto.

- Verificare la configurazione nella pagina Riepilogo.

Prima di eseguire la procedura guidata, è consigliabile salvare i dettagli della configurazione.

- Fare clic su Esegui Avvio rapido.

Risultati

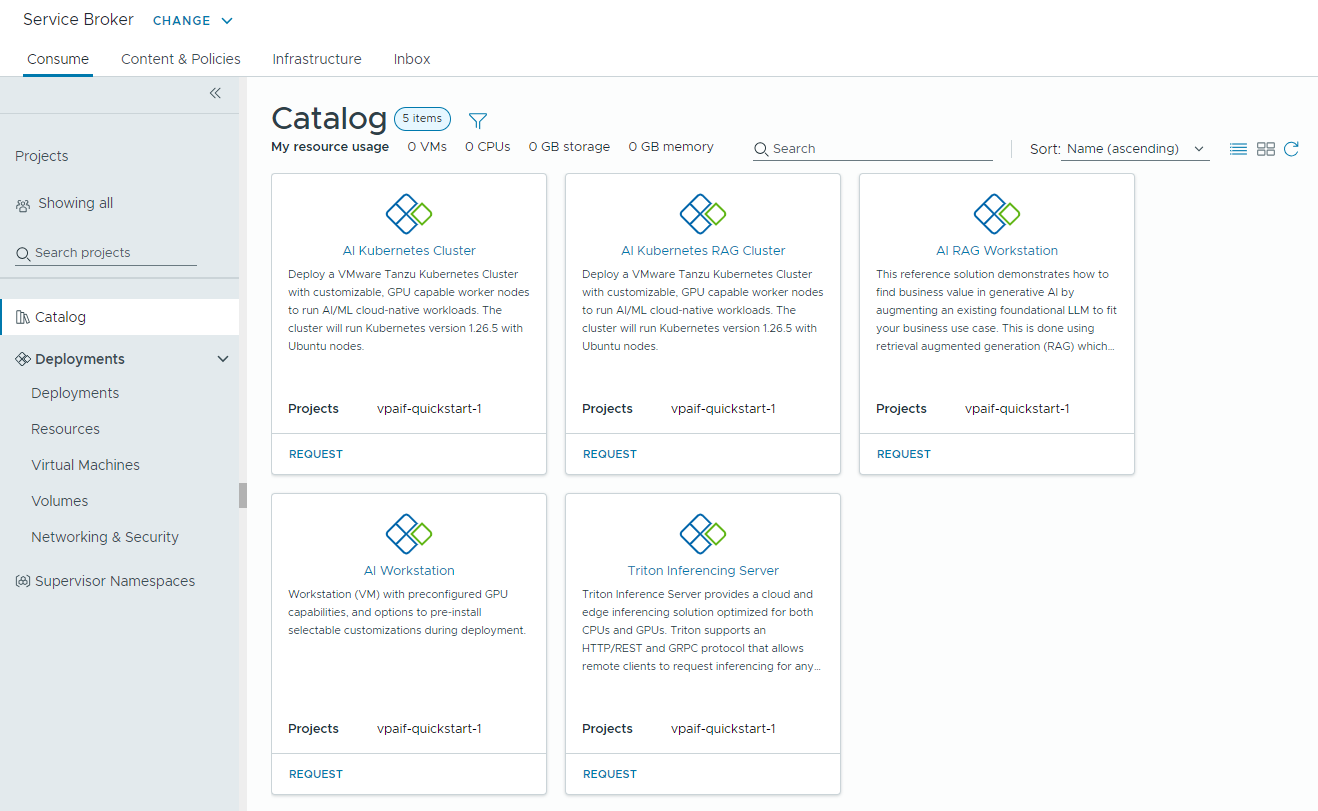

Vengono creati cinque elementi del catalogo (Workstation IA, AI RAG Workstation, Triton Inferencing Server, AI Kubernetes Cluster e AI Kubernetes RAG Cluster) nel catalogo di Automation Service Broker e gli utenti dell'organizzazione possono ora distribuirli.

Passaggi successivi

- Verificare che i modelli siano disponibili nel catalogo per i membri dei progetti selezionati con cui è stato condiviso il contenuto e monitorare il processo di provisioning per garantire la corretta distribuzione. Vedere Come distribuire gli elementi del catalogo PAIF.

- Se si desidera controllare per quanto tempo può esistere una distribuzione, creare un lease. Vedere Configurazione dei criteri di Automation Service Broker.

- Per modificare gli input utente al momento della richiesta, è possibile creare un modulo personalizzato. Vedere Personalizzazione di un'icona e del modulo di richiesta di Automation Service Broker.

Risoluzione dei problemi

- Se Configurazione guidata catalogo non riesce, eseguire di nuovo la procedura guidata per un progetto diverso.