Per consentire agli sviluppatori di distribuire carichi di lavoro AI/ML in cluster TKGS, l'amministratore di vSphere può configurare l'ambiente di vSphere with Tanzu per supportare l'hardware NVIDIA GPU.

Workflow per l'amministratore di vSphere sulla distribuzione dei carichi di lavoro AI/ML nei cluster TKGS

| Passaggio | Azione | Collega |

|---|---|---|

| 0 | Verificare i requisiti di sistema. |

Vedere Passaggio 0 dell'amministratore: revisione dei requisiti di sistema. |

| 1 | Installare il dispositivo NVIDIA GPU supportato negli host ESXi. |

Vedere Passaggio 1 dell'amministratore: installare il dispositivo GPU NVIDIA supportato negli host ESXi. |

| 2 | Configurare le impostazioni grafiche del dispositivo ESXi per le operazioni vGPU. |

Vedere Passaggio 2 dell'amministratore: configurare ciascun host ESXi per le operazioni vGPU. |

| 3 | Installare NVIDIA vGPU Manager (VIB) in ogni host ESXi. |

Vedere Passaggio 3 dell'amministratore: installare il driver NVIDIA Host Manager su ciascun host ESXi. |

| 4 | Verificare il funzionamento del driver NVIDIA e la modalità di virtualizzazione GPU. |

|

| 5 | Abilitare Gestione carico di lavoro in un cluster con configurazione GPU. Il risultato è un cluster supervisore in esecuzione negli host ESXi abilitati per vGPU. |

|

| 6 | Creare una Libreria di contenuti per le versioni di Tanzu Kubernetes e popolare la libreria con il file OVA di Ubuntu supportato richiesto per i carichi di lavoro di vGPU. |

|

| 7 | Creare una classe di macchine virtuali personalizzata con un determinato profilo vGPU selezionato. |

|

| 8 | Creare e configurare uno spazio dei nomi vSphere per i cluster TKGS GPU: aggiungere un utente con autorizzazioni di modifica e storage per volumi persistenti. |

|

| 9 | Associare la libreria di contenuti al file OVA di Ubuntu e la classe di macchine virtuali personalizzata per vGPU allo spazio dei nomi vSphere creato per TGKS. |

|

| 10 | Verificare che il cluster supervisore sia fornito in provisioning e accessibile per l'operatore cluster. |

Vedere Passaggio 10 dell'amministratore: verificare che il cluster supervisore sia accessibile. |

Passaggio 0 dell'amministratore: revisione dei requisiti di sistema

| Requisito | Descrizione |

|---|---|

| Infrastruttura vSphere |

vSphere 7 Update 3 Monthly Patch 1 ESXi build vCenter Server build |

| Gestione carico di lavoro |

Versione spazio dei nomi vSphere

|

| Cluster supervisore |

Versione di Cluster supervisore

|

| OVA Ubuntu TKR | Release di Tanzu Kubernetes Ubuntu

|

| Driver host NVIDIA vGPU |

Scaricare il VIB dal sito Web di NGC. Per ulteriori informazioni, consultare la documentazione relativa al driver software della vGPU. Ad esempio:

|

| License Server NVIDIA per vGPU |

Nome di dominio completo fornito dall'organizzazione |

Passaggio 1 dell'amministratore: installare il dispositivo GPU NVIDIA supportato negli host ESXi

Per distribuire carichi di lavoro IA/ML in TKGS, installare uno o più dispositivi GPU NVIDIA supportati in ogni host ESXi che include il cluster vCenter in cui sarà abilitato Gestione carico di lavoro.

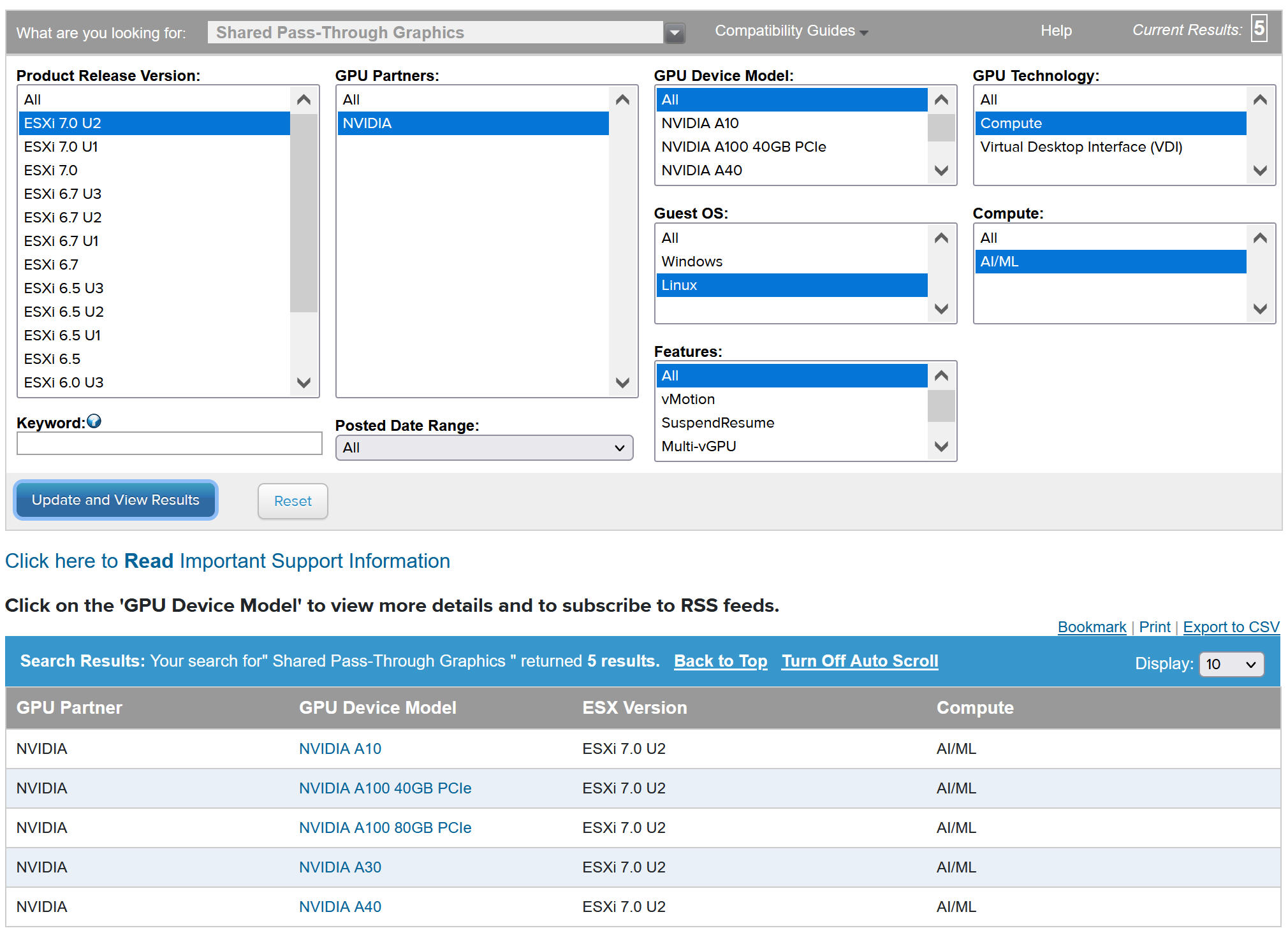

Per visualizzare i dispositivi GPU NVIDIA compatibili, fare riferimento alla guida alla compatibilità di VMware.

Il dispositivo GPU NVIDA deve supportare i profili vGPU NVIDIA AI Enterprise (NVAIE) più recenti. Per istruzioni, fare riferimento al documento NVIDIA Virtual GPU Software Supported GPUs.

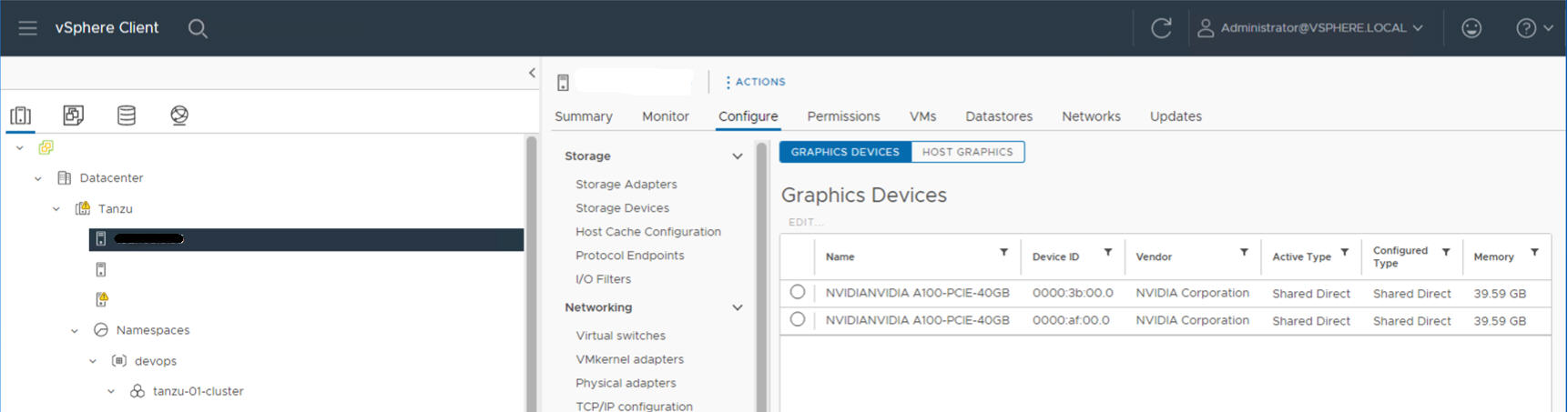

Ad esempio, nel seguente host ESXi sono installati due dispositivi NVIDIA GPU A100.

Passaggio 2 dell'amministratore: configurare ciascun host ESXi per le operazioni vGPU

Configurare ciascun host ESXi per la vGPU abilitando Condiviso diretta e SR-IOV.

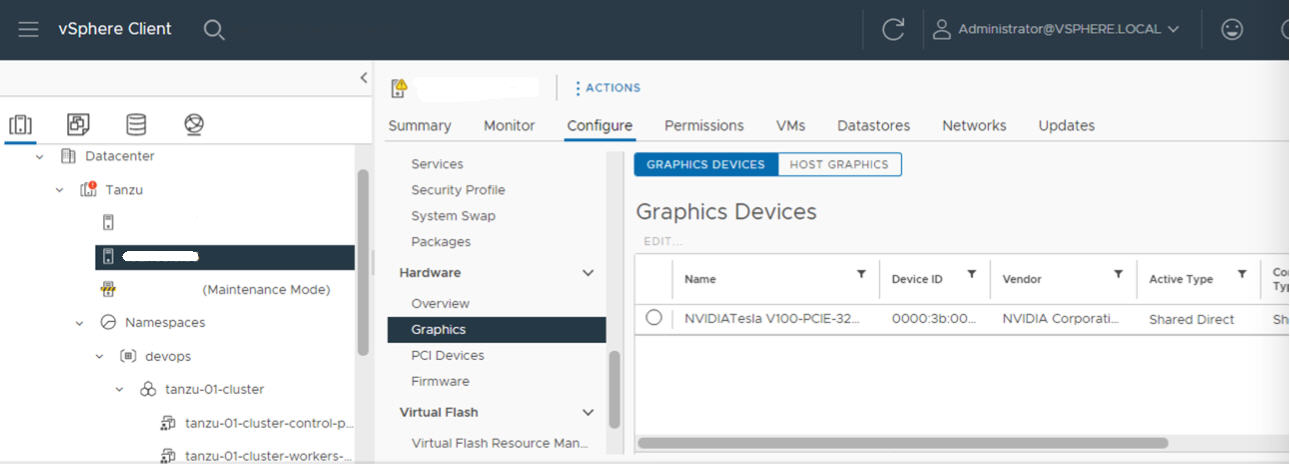

Abilitare Condiviso diretta su ciascun host ESXi

Per sbloccare la funzionalità NVIDIA vGPU, abilitare la modalità Condiviso diretta su ogni host ESXi che include il cluster vCenter in cui sarà abilitato Gestione carico di lavoro.

- Accedere a vCenter Server utilizzando vSphere Client.

- Selezionare un host ESXi nel cluster vCenter.

- Selezionare .

- Selezionare il dispositivo acceleratore GPU NVIDIA.

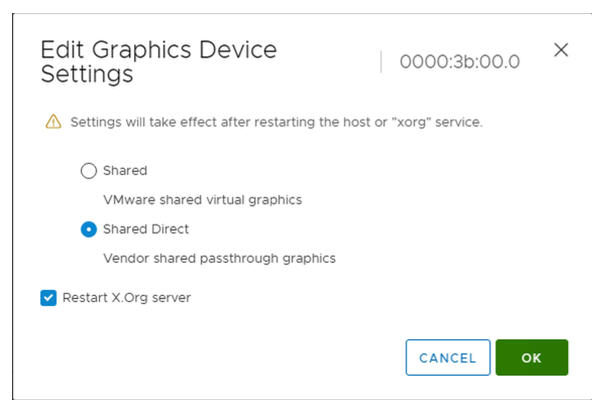

- Modificare le impostazioni dell dispositivo grafico.

- Selezionare Condiviso diretta.

- Selezionare Riavvia server X.Org.

- Fare clic su OK per salvare le configurazione.

- Fare clic con il pulsante destro del mouse sull'host ESXi e passarlo in modalità di manutenzione.

- Riavviare l'host.

- Quando l'host è di nuovo in esecuzione, disattivare la modalità di manutenzione.

- Ripetere questo processo per ogni host ESXi nel cluster vCenter in cui sarà abilitato Gestione carico di lavoro.

Attivare il BIOS SR-IOV per i dispositivi NVIDIA GPU A30 e A100

Se si utilizza il dispositivo GPU NVIDIA A30 o A100, necessario per la GPU multi-istanza ( modalità MIG), è necessario abilitare SR-IOV nell'host ESXi. Se SR-IOV non è abilitato, non è possibile avviare le macchine virtuali dei nodi del cluster di Tanzu Kubernetes. Se si verifica questa condizione, viene visualizzato il seguente messaggio di errore nel riquadro Attività recenti di vCenter Server in cui è abilitato Gestione carico di lavoro.

Could not initialize plugin libnvidia-vgx.so for vGPU nvidia_aXXX-xx. Failed to start the virtual machine. Module DevicePowerOn power on failed.

Per abilitare SR-IOV, accedere all'host ESXi utilizzando la console Web. Selezionare . Selezionare il dispositivo GPU NVIDIA e fare clic su Configura SR-IOV. Da questa sezione è possibile attivare SR-IOV. Per ulteriori istruzioni, vedere la pagina Single Root I/O Virtualization (SR-IOV) nella documentazione di vSphere.

Passaggio 3 dell'amministratore: installare il driver NVIDIA Host Manager su ciascun host ESXi

Per eseguire macchine virtuali dei nodi del cluster di Tanzu Kubernetes con accelerazione grafica della NVIDIA vGPU, installare il driver NVIDIA Host Manager su ciascun host ESXi, incluso il cluster vCenter in cui sarà abilitato Gestione carico di lavoro.

I componenti del driver NVIDIA vGPU Host Manager sono incorporati in un pacchetto bundle di installazione per vSphere (VIB). Il VIB NVAIE viene fornito dall'organizzazione tramite il programma di licenza NVIDIA GRID. VMware non fornisce VIB NVAIE né li rende disponibili per il download. Come parte del programma di gestione delle licenze NVIDIA, l'organizzazione configura un server di gestione delle licenze. Per ulteriori informazioni, fare riferimento alla guida rapida del software Virtual GPU di NVIDIA.

esxcli system maintenanceMode set --enable true esxcli software vib install -v ftp://server.domain.example.com/nvidia/signed/NVIDIA_bootbank_NVIDIA-VMware_ESXi_7.0_Host_Driver_460.73.02-1OEM.700.0.0.15525992.vib esxcli system maintenanceMode set --enable false /etc/init.d/xorg restart

Passaggio 4 dell'amministratore: verificare che gli host ESXi siano pronti per le operazioni di NVIDIA vGPU

- Accedere tramite SSH all'host ESXi, accedere alla modalità shell ed eseguire il comando

nvidia-smi. NVIDIA System Management Interface è un'utilità da riga di comando fornita da NVIDA vGPU Host Manager. L'esecuzione di questo comando restituisce le GPU e i driver nell'host. - Eseguire il comando seguente per verificare che il driver NVIDIA sia installato correttamente:

esxcli software vib list | grep NVIDA. - Verificare che l'host sia configurato con la GPU condivisa diretta e che SR-IOV sia attivato (se si utilizzano dispositivi NVIDIA A30 o A100).

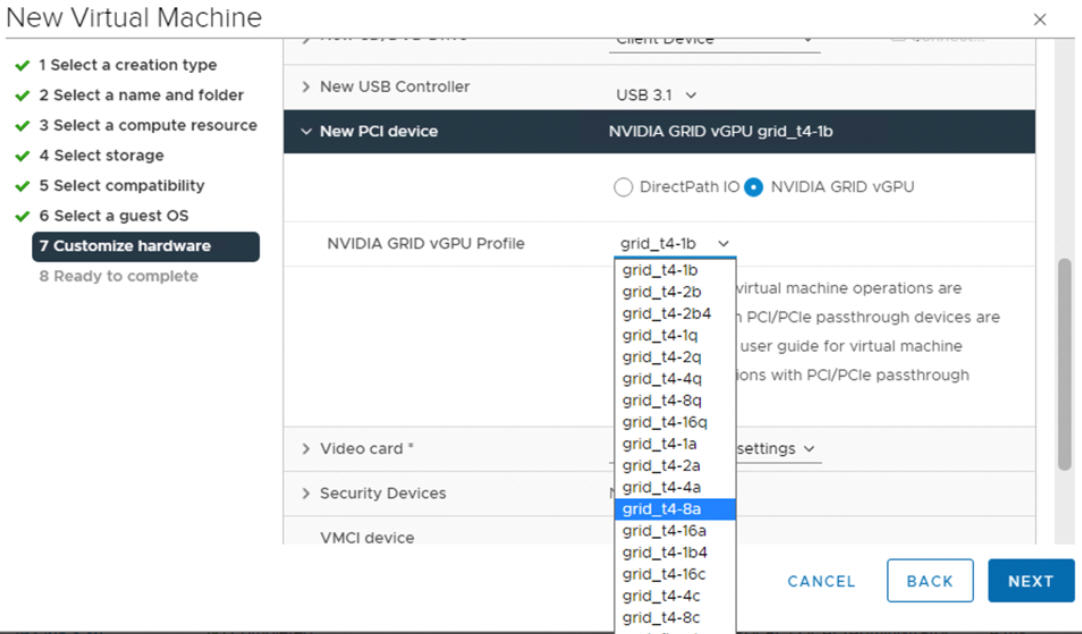

- Utilizzando vSphere Client, nell'host ESXi configurato per la GPU, creare una nuova macchina virtuale con un dispositivo PCI incluso. Il profilo NVIDIA vGPU deve essere visualizzato e selezionabile.

Passaggio 5 dell'amministratore: abilitare Gestione carico di lavoro nel cluster vCenter configurato con vGPU

Ora che gli host ESXi sono configurati per supportare NVIDIA vGPU, creare un cluster vCenter che includa questi host. Per supportare Gestione carico di lavoro, il cluster vCenter deve soddisfare requisiti specifici, tra cui storage condiviso, alta disponibilità e DRS completamente automatizzato.

L'abilitazione di Gestione carico di lavoro richiede anche la selezione di uno stack di rete, una rete vDS vSphere nativa o una rete NSX-T Data Center. Se si utilizza la rete vDS, è necessario installare un bilanciamento del carico, NSX Advanced o HAProxy.

| Attività | Istruzioni |

|---|---|

| Creare un cluster vCenter che soddisfi i requisiti per abilitare Gestione carico di lavoro | Prerequisiti per la configurazione di vSphere with Tanzu in un cluster |

| Configurare la rete per Cluster supervisore, NSX-T o vDS con un bilanciamento del carico. | Configurazione di NSX-T Data Center per vSphere with Tanzu. Configurazione di rete vSphere e NSX Advanced Load Balancer per vSphere with Tanzu. Configurazione di vSphere Networking e bilanciamento del carico del proxy HA per vSphere with Tanzu. |

| Abilitare Gestione carico di lavoro |

Abilitazione della gestione del carico di lavoro con la rete NSX-T Data Center. Abilitazione della gestione dei carichi di lavoro con la rete vSphere. |

Passaggio 6 dell'amministratore: creare una libreria di contenuti per la versione Ubuntu di Tanzu Kubernetes

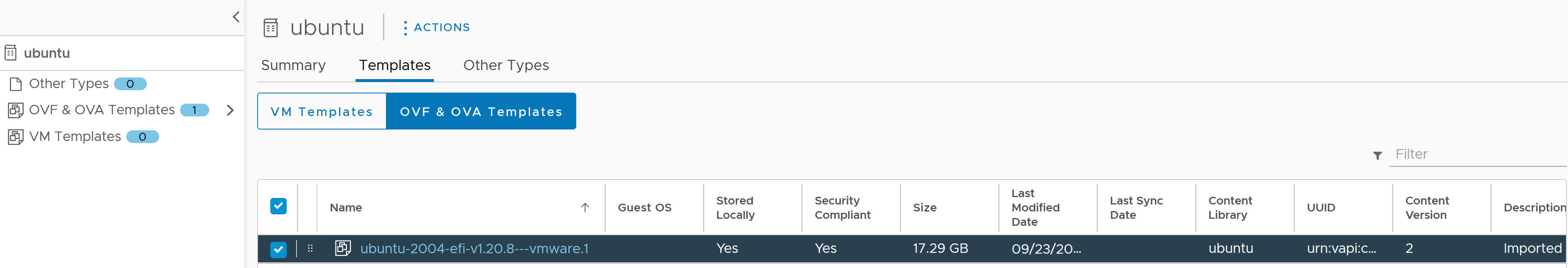

Una volta abilitato Gestione carico di lavoro in un cluster vCenter configurato con GPU, il passaggio successivo consiste nel creare una libreria di contenuti per l'immagine OVA della versione di Tanzu Kubernetes.

NVIDIA vGPU richiede il sistema operativo Ubuntu. VMware fornisce un file OVA di Ubuntu per questo scopo. Non è possibile utilizzare la versione Tanzu Kubernetes PhotonOS per i cluster vGPU.

| Tipo di libreria dei contenuti | Descrizione |

|---|---|

| Creare una Libreria di contenuti con sottoscrizione e sincronizzare automaticamente l'OVA di Ubuntu con il proprio ambiente. | Creazione, protezione e sincronizzazione di una libreria di contenuti con sottoscrizione per Release di Tanzu Kubernetes |

| Creare una Libreria di contenuti locale e caricare manualmente l'OVA di Ubuntu nel proprio ambiente. | Creazione, protezione e sincronizzazione di una libreria di contenuti locale per le Release di Tanzu Kubernetes |

Passaggio 7 dell'amministratore: creare una classe di macchine virtuali personalizzata con il profilo vGPU

Il passaggio successivo consiste nel creare una classe di macchine virtuali personalizzata con un profilo vGPU. Il sistema utilizzerà questa definizione di classe per la creazione dei nodi del cluster di Tanzu Kubernetes.

- Accedere al vCenter Server utilizzando vSphere Client.

- Selezionare Gestione carico di lavoro.

- Selezionare Servizi.

- Selezionare Classi di macchine virtuali.

- Fare clic su Crea classe di macchine virtuali.

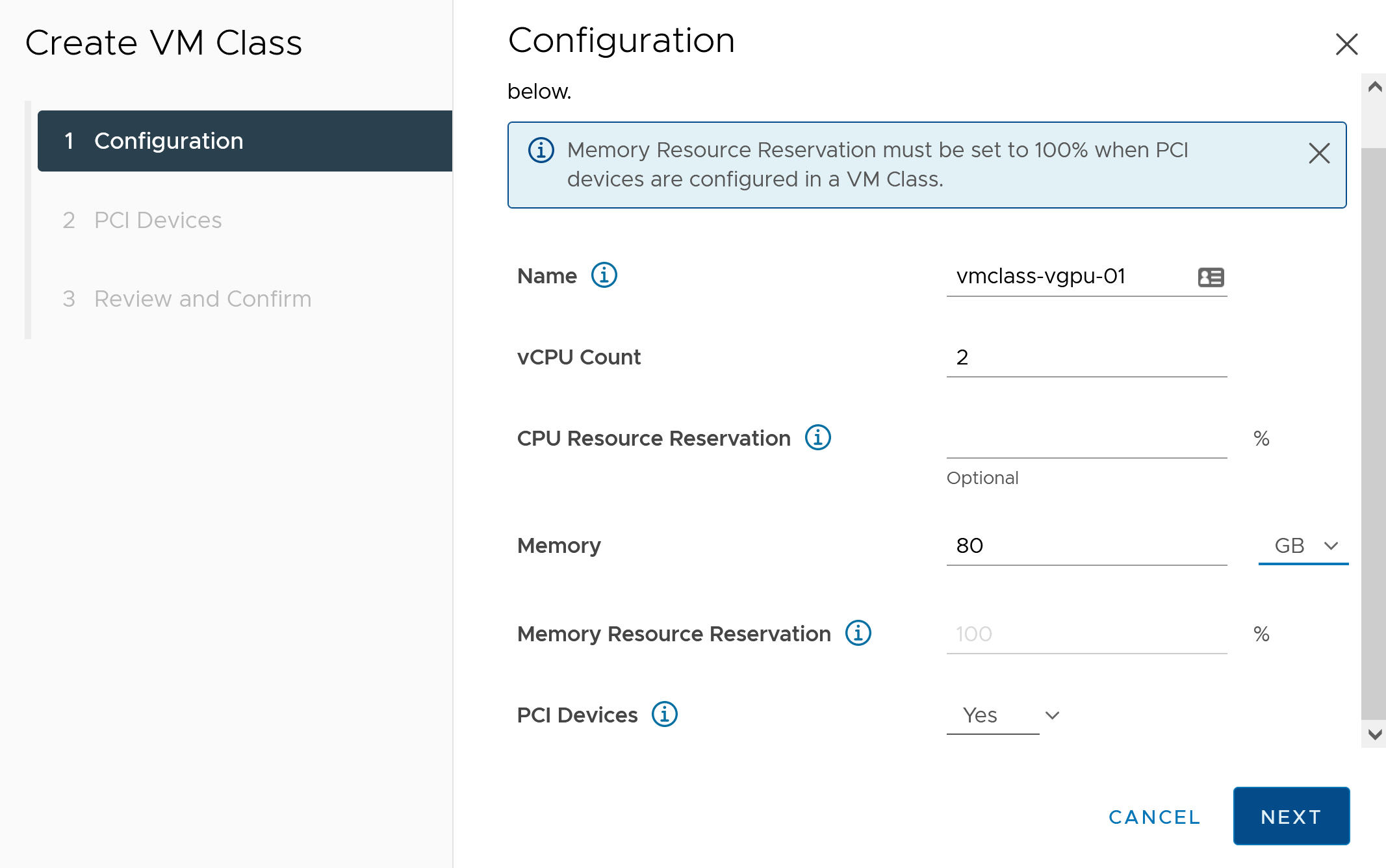

- Nella scheda Configurazione, configurare la classe di macchine virtuali personalizzata.

Campo di configurazione Descrizione Nome Immettere un nome auto-descrittivo per la classe di macchine virtuali personalizzata, ad esempio vmclass-vgpu-1. Conteggio vCPU 2 Prenotazione risorsa CPU Facoltativo, OK per lasciare vuoto Memoria 80 GB, ad esempio Prenotazione risorsa di memoria 100% (obbligatorio quando i dispositivi PCI sono configurati in una classe di macchine virtuali) Dispositivi PCI Sì Nota: Selezionando Sì in Dispositivi PCI si indica al sistema che si sta utilizzando un dispositivo GPU e si modificata la configurazione della classe di macchine virtuali per supportare la configurazione della vGPU.Ad esempio:

- Fare clic su Avanti.

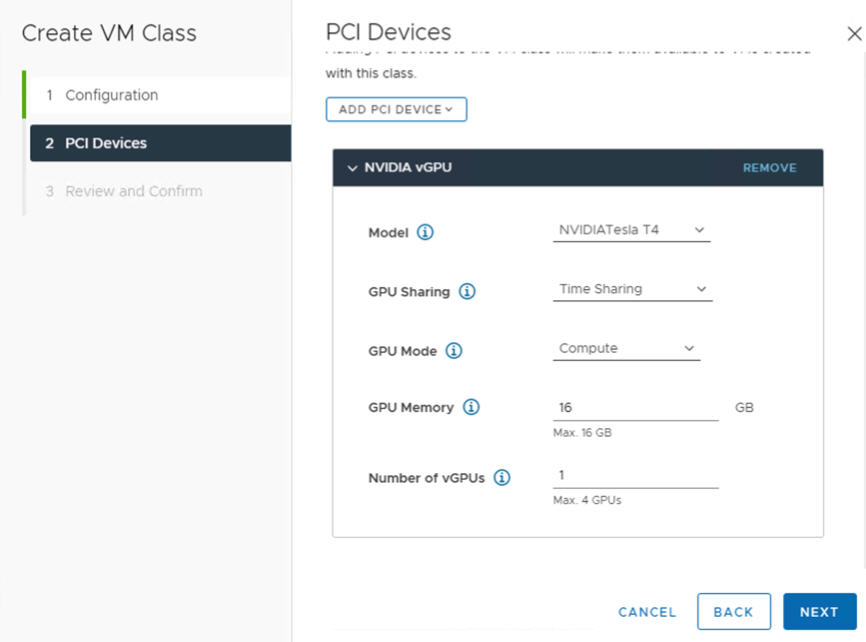

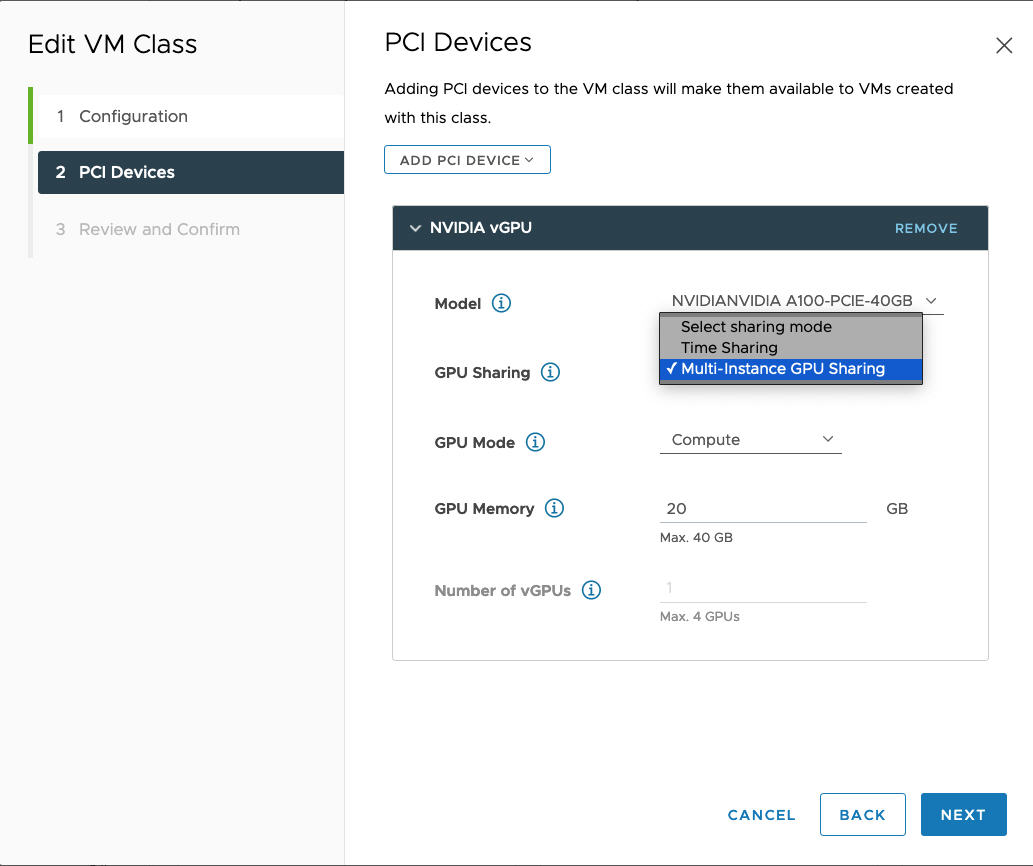

- Nella scheda Dispositivi PCI, selezionare l'opzione .

- Configurare il modello NVIDIA vGPU.

Campo NVIDIA vGPU Descrizione Modello Selezionare il modello di dispositivo hardware GPU NVIDIA tra quelli disponibili nel menu . Se il sistema non mostra alcun profilo, in nessuno degli host del cluster sono supportati dispositivi PCI. Condivisione GPU Questa impostazione definisce il modo in cui il dispositivo GPU viene condiviso tra le macchine virtuali abilitate per la GPU. Sono disponibili due tipi di implementazioni di vGPU: Condivisione dell'ora e Condivisione GPU multi-istanza.

In modalità Condivisione dell'ora, lo strumento di pianificazione della vGPU indica alla GPU di eseguire il lavoro per ogni macchina virtuale abilitata per vGPU in serie per un periodo di tempo con l'obiettivo di massimo sforzo delle prestazioni di bilanciamento tra vGPU.

La modalità MIG consente l'esecuzione di più macchine virtuali abilitate per vGPU in parallelo in un singolo dispositivo GPU. La modalità MIG si basa su un'architettura GPU più recente ed è supportata solo su dispositivi NVIDIA A100 e A30. Se l'opzione MIG non è visualizzata, il dispositivo PCI selezionato non la supporta.

Modalità GPU Elabora Memoria GPU 8 GB, ad esempio Numero di vGPU 1 ad esempio Di seguito è riportato un esempio di profilo NVIDIA vGPU configurato in modalità Condivisione dell'ora:

Di seguito è riportato un esempio di profilo NVIDIA vGPU configurato in modalità MIG con dispositivo GPU supportato:

- Fare clic su Avanti.

- Rivedere e confermare le selezioni.

- Fare clic su Fine.

- Verificare che la nuova classe di macchine virtuali personalizzata sia disponibile nell'elenco delle classi di macchine virtuali.

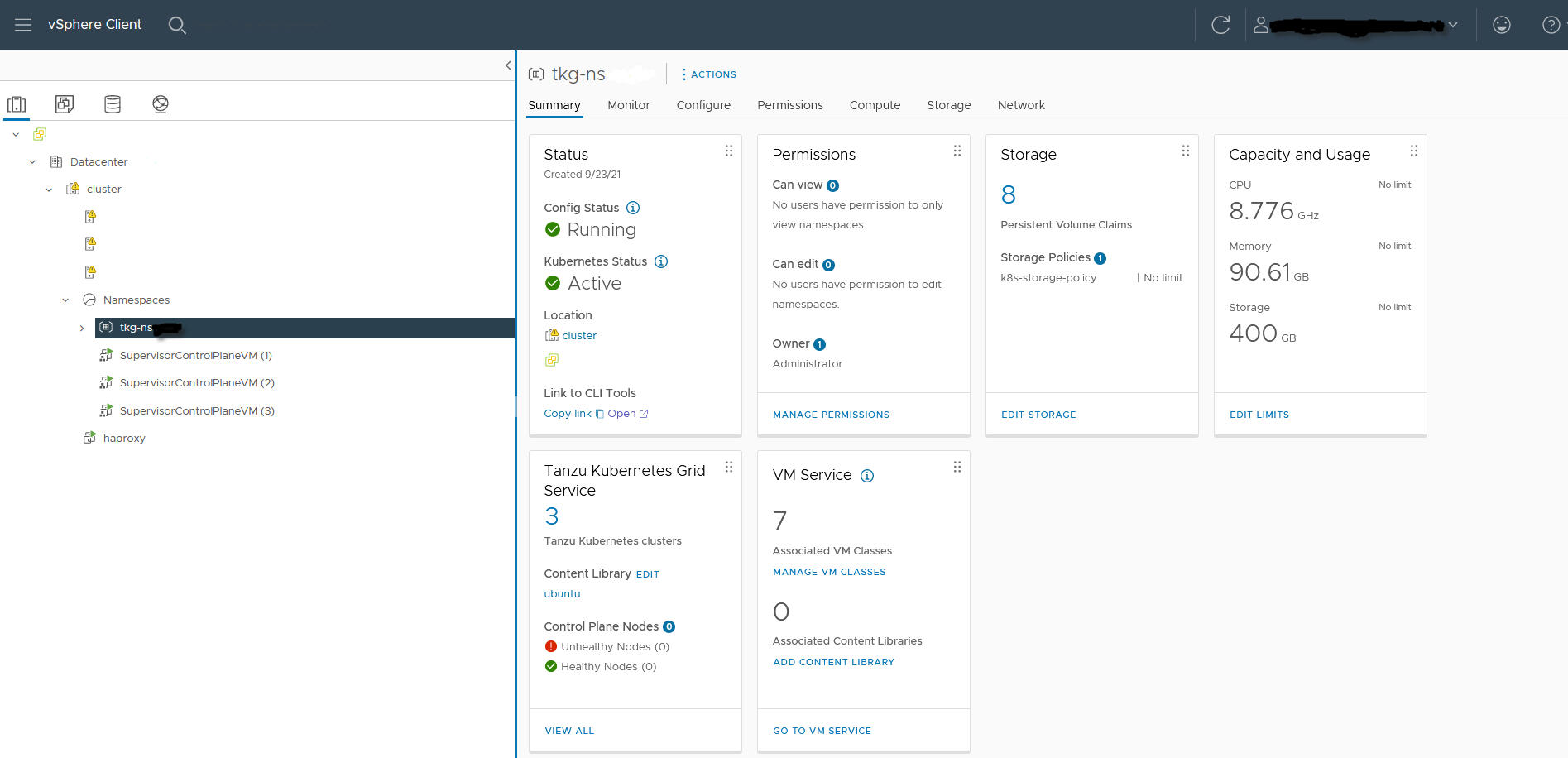

Passaggio 8 dell'amministratore: creare e configurare uno spazio dei nomi vSphere per il cluster GPU TKGS

Creare uno spazio dei nomi vSphere per ogni cluster GPU TKGS di cui si intende eseguire il provisioning. Configurare lo spazio dei nomi aggiungendo un utente SSO vSphere con autorizzazioni Modifica e collegando un criterio di storage per volumi persistenti.

A tale scopo, vedere Creazione e configurazione di uno Spazio dei nomi vSphere.

Passaggio 9 dell'amministratore: associare la libreria di contenuti e la classe di macchine virtuali allo spazio dei nomi vSphere

| Attività | Descrizione |

|---|---|

| Associare la libreria di contenuti con l'OVA di Ubuntu per vGPU allo spazio dei nomi vSphere in cui verrà eseguito il provisioning del cluster TKGS. | Vedere Configurazione di uno Spazio dei nomi vSphere per Release di Tanzu Kubernetes. |

| Associare la classe di macchine virtuali personalizzata al profilo vGPU con lo spazio dei nomi vSphere dove verrà eseguito il provisioning del cluster TKGS. | Vedere Associazione di una classe di macchine virtuali a uno spazio dei nomi in vSphere with Tanzu. |

Passaggio 10 dell'amministratore: verificare che il cluster supervisore sia accessibile

L'ultima attività di amministrazione consiste nel verificare che Cluster supervisore sia fornito in provisioning e disponibile all'operatore del cluster per il provisioning di un cluster TKGS per i carichi di lavoro AI/ML.

- Scaricare e installare Strumenti CLI Kubernetes di vSphere.

Vedere Download e installazione di Strumenti CLI Kubernetes di vSphere.

- Connettersi a Cluster supervisore.

Vedere Connessione al Cluster supervisore come utente vCenter Single Sign-On.

- Fornire all'operatore cluster il collegamento per scaricare Strumenti CLI Kubernetes di vSphere e il nome dello spazio dei nomi vSphere.