Il processo di configurazione della scheda nell'host ESXi implica la configurazione del binding VMkernel per una scheda di rete TCP e quindi l'aggiunta di una scheda software per NVMe su TCP. In seguito, è possibile aggiungere un controller NVMe.

| Azione | Descrizione |

|---|---|

| Nell'host ESXi, installare una scheda che supporti la tecnologia NVMe su TCP | Ad esempio, i40en. |

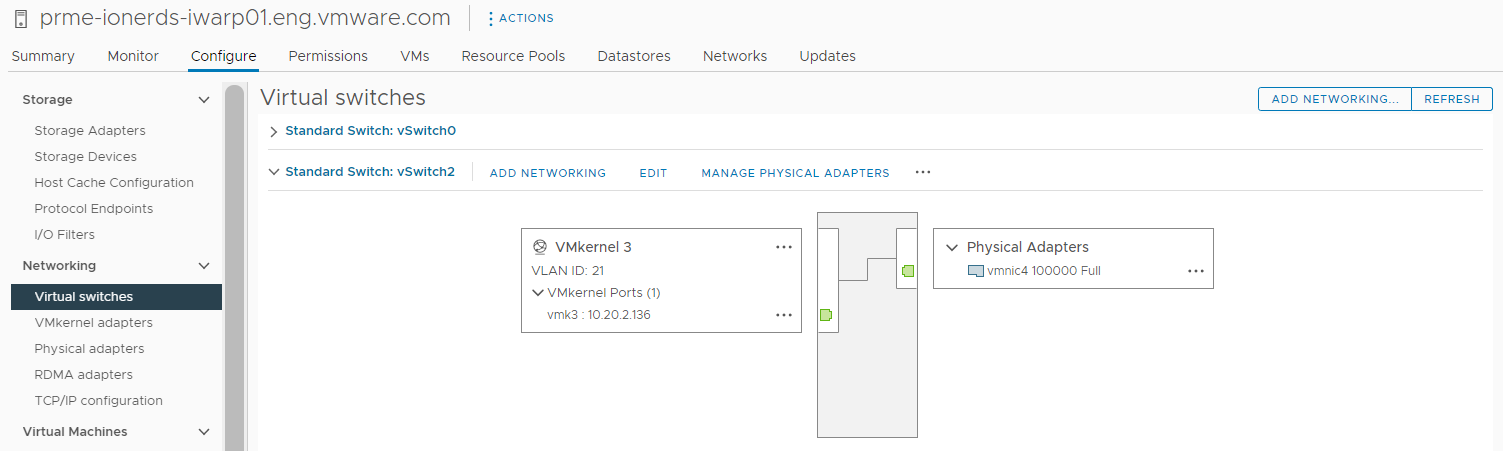

| Configurazione del binding VMkernel per la scheda NVMe su TCP | Il binding di VMkernel per NVMe su TCP implica la creazione di un commutatore virtuale e la connessione della scheda di rete fisica e della scheda VMkernel al commutatore virtuale. Tramite questa connessione, la scheda TCP viene associata alla scheda VMkernel. Nella configurazione, è possibile utilizzare un vSphere standard switch o un vSphere Distributed Switch. |

| Aggiungere la scheda software NVMe su TCP | Utilizzare vSphere Client per abilitare le schede di storage software per NVMe su TCP. |

| Aggiunta di controller per NVMe su Fabrics | Utilizzare vSphere Client per aggiungere un controller NVMe. Dopo aver aggiunto il controller, gli spazi dei nomi NVMe associati al controller diventano disponibili per l'host ESXi. I dispositivi di storage NVMe che rappresentano gli spazi dei nomi nell'ambiente ESXi vengono visualizzati nell'elenco dei dispositivi di storage. |

Configurazione del binding VMkernel per la scheda NVMe su TCP

Il binding della porta per NVMe su TCP implica la creazione di un commutatore virtuale e la connessione della scheda di rete fisica e della scheda VMkernel al commutatore virtuale. Tramite questa connessione, la scheda TCP viene associata alla scheda VMkernel. Nella configurazione, è possibile utilizzare un vSphere standard switch o un vSphere Distributed Switch.

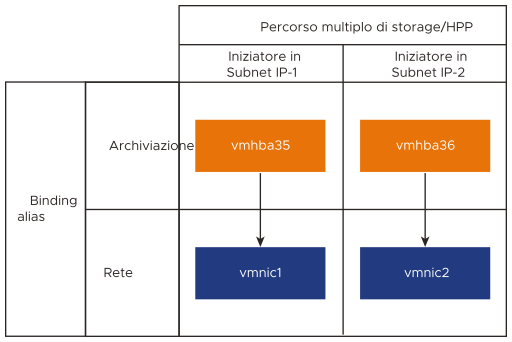

Il diagramma seguente illustra il binding porta per la scheda NVMe su TCP.

Per ulteriori informazioni sulla creazione di commutatori, vedere Creazione di un vSphere Standard Switch o Creazione di un vSphere Distributed Switch nella documentazione Rete di vSphere.

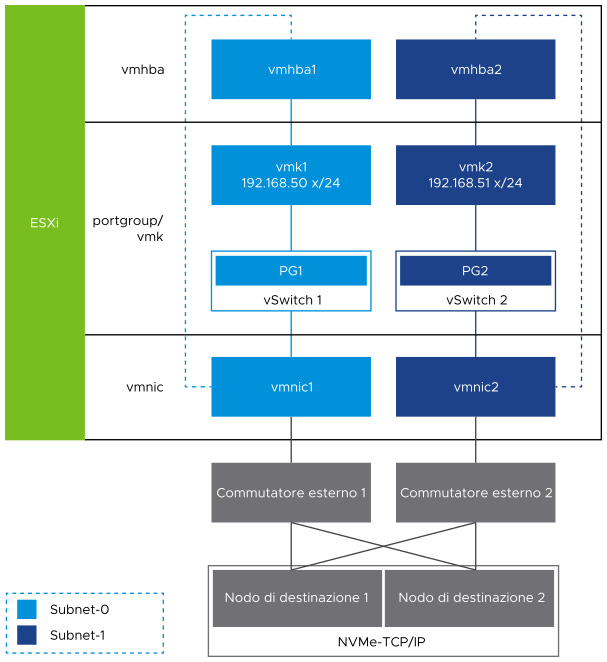

Esempio di topologia di rete con NVMe su TCP

In questo esempio, due commutatori standard vSphere e due schede di rete (vmnic) nell'host forniscono alta disponibilità. Si connettono a due commutatori esterni.

Configurazione del binding di VMkernel per la scheda TCP con un vSphere Standard Switch

È possibile configurare il binding di VMkernel per la scheda TCP utilizzando un vSphere Standard Switch e un uplink per ogni commutatore. Per configurare la connessione di rete, è necessario creare una scheda VMkernel virtuale per ciascuna scheda di rete fisica. È possibile utilizzare la mappatura 1:1 tra ogni scheda di rete virtuale e fisica.

Procedura

Configurazione del binding di VMkernel per la scheda TCP con un vSphere Distributed Switch

È possibile configurare il binding porta di VMkernel per la scheda TCP utilizzando un vSphere Distributed Switch e un uplink per commutatore. Per configurare la connessione di rete, è necessario creare una scheda VMkernel virtuale per ciascuna scheda di rete fisica. È possibile utilizzare la mappatura 1:1 tra ogni scheda di rete virtuale e fisica.

Procedura

Operazioni successive

Aggiungere le schede software NVMe su RDMA o NVMe su TCP

ESXi supporta le schede software NVMe su RDMA e NVMe su TCP. Utilizzare vSphere Client per aggiungere le schede di storage software per NVMe su RDMA o NVMe su TCP.

Prerequisiti

- Nell'host ESXi, installare una scheda che supporti i tipi di storage seguenti.

- Scheda NVMe su RDMA. Ad esempio, Mellanox Technologies MT27700 Family ConnectX-4.

- Scheda NVMe su TCP. Ad esempio, i40en.

- Configurare il binding VMkernel per le schede.

- Per NVMe su RDMA, vedere Configurazione del binding VMkernel per la scheda RDMA.

- Per NVMe su TCP, vedere Configurazione del binding VMkernel per la scheda NVMe su TCP.

Procedura

risultati

Aggiunta di controller per NVMe su Fabrics

Utilizzare vSphere Client per aggiungere un controller NVMe. Dopo aver aggiunto il controller, gli spazi dei nomi NVMe associati al controller diventano disponibili per l'host ESXi. I dispositivi di storage NVMe che rappresentano gli spazi dei nomi nell'ambiente ESXi vengono visualizzati nell'elenco dei dispositivi di storage.

Prerequisiti

- Assicurarsi che l'host ESXi disponga di adattatori appropriati per il tipo di storage in uso. Vedere Requisiti per lo storage NVMe di VMware.

- Se si utilizza lo storage NVMe su RDMA (RoCE v2), eseguire le attività seguenti:

- Se si utilizza lo storage NVMe su TCP, eseguire le attività seguenti:

Procedura

- In vSphere Client, passare all'host ESXi.

- Fare clic sulla scheda Configura.

- In Storage, fare clic su Schede di storage, quindi selezionare la scheda (vmhba#) da configurare.

- Fare clic sulla scheda Controller e su Aggiungi controller.

- Nella finestra di dialogo Aggiungi controller selezionare uno dei metodi di individuazione seguenti.

Opzione Descrizione Automaticamente Questa opzione indica che l'host può individuare automaticamente i controller e accettare la connessione a qualsiasi controller disponibile. - Specificare i seguenti parametri per l'individuazione dei controller.

- Per NVMe su RDMA (RoCE v2), l'indirizzo IP e il numero di porta di trasporto.

- Per NVMe su TCP, l'indirizzo IP, il numero della porta di trasporto e il parametro digest.

- Fare clic su Individua controller.

- Nell'elenco dei controller, selezionare il controller da utilizzare.

Manualmente Con questo metodo, è necessario immettere manualmente i dettagli del controller. L'host richiede una connessione a un controller specifico utilizzando i parametri specificati: - NQN sottosistema

- Identificazione della porta di destinazione.

- Per NVMe su RDMA (RoCE v2), l'indirizzo IP e il numero di porta di trasporto (facoltativo).

- Per NVMe su TCP, l'indirizzo IP, il numero della porta di trasporto (facoltativo) e il parametro digest (facoltativo).

- Per NVMe su Fibre Channel, WorldWideNodeName e WorldWidePortName.

- Dimensione coda amministratore. Un parametro facoltativo che specifica la dimensione della coda di amministratori del controller. Un valore predefinito è 16.

- Timeout keep-alive. Parametro facoltativo da specificare in secondi il timeout keep-alive tra l'adattatore e il controller. Un valore di timeout predefinito è 60 secondi.

Nota: Le dimensioni della coda di I/O e il numero della coda di I/O sono parametri facoltativi che possono essere impostati solo tramite esxcli. - Specificare i seguenti parametri per l'individuazione dei controller.

risultati

Il controller viene visualizzato nell'elenco dei controller. L'host può ora individuare gli spazi dei nomi NVMe associati al controller. I dispositivi di storage NVMe che rappresentano gli spazi dei nomi nell'ambiente ESXi vengono visualizzati nell'elenco dei dispositivi di storage di vSphere Client.