vSphere IaaS control plane 환경의 ESXi 호스트에 하나 이상의 NVIDIA GRID GPU 그래픽 디바이스가 있는 경우 NVIDIA GRID vGPU(가상 GPU) 기술을 사용하도록 VM을 구성할 수 있습니다. ESXi 호스트의 다른 PCI 디바이스를 패스스루 모드의 VM에서 사용할 수 있도록 구성할 수도 있습니다.

vSphere IaaS control plane에 vGPU가 있는 VM 배포

NVIDIA GRID GPU 그래픽 디바이스는 CPU에 과부하를 주지 않은 상태로 복잡한 그래픽 작업을 고성능으로 실행 및 최적화하기 위해 설계되었습니다. NVIDIA GRID vGPU는 여러 VM 간에 물리적 단일 GPU를 별도의 vGPU 지원 패스스루 디바이스로 공유하여 뛰어난 그래픽 성능, 비용 효율성 및 확장성을 제공합니다.

고려 사항

- 3개 영역 감독자는 vGPU가 있는VM을 지원하지 않습니다.

- VM 서비스에서 관리되는 vGPU 디바이스가 있는 VM은 ESXi 호스트가 유지 보수 모드로 전환되면 자동으로 전원이 꺼집니다. 그러면 VM에서 실행되는 워크로드에 일시적으로 영향을 줄 수 있습니다. 호스트가 유지 보수 모드를 종료하면 VM의 전원이 자동으로 켜집니다.

- DRS는 클러스터의 호스트 전반에 너비 우선 방식으로 vGPU VM을 분산합니다. 자세한 내용은 "vSphere 리소스 관리" 가이드에서 vGPU VM의 DRS 배치를 참조하십시오.

요구 사항

NVIDIA vGPU를 구성하려면 다음 요구 사항을 따릅니다.

- VMware 호환성 가이드에서 ESXi가 지원되는지 확인하고 벤더에 문의하여 호스트가 전원 및 구성 요구 사항을 충족하는지 확인합니다.

- Shared Direct 모드에서 하나 이상의 디바이스를 사용하여 ESXi 호스트 그래픽 설정을 구성합니다. "vSphere 리소스 관리" 설명서에서 호스트 그래픽 구성을 참조하십시오.

- vGPU 디바이스가 있는 VM에 사용하는 컨텐츠 라이브러리에는 부팅 모드가 EFI로 설정된 이미지(예: CentOS)가 포함되어야 합니다.

- NVIDIA vGPU 소프트웨어를 설치합니다. NVIDIA는 다음 구성 요소를 포함하는 vGPU 소프트웨어 패키지를 제공합니다.

자세한 내용은 해당 NVIDIA 가상 GPU 소프트웨어 설명서를 참조하십시오.

- vGPU Manager - vSphere 관리자가 ESXi 호스트에 설치합니다. VMware 기술 자료 문서 2033434를 참조하십시오.

- 게스트 VM 드라이버 - VM을 배포하고 부팅한 후 DevOps 엔지니어가 VM에 설치합니다. vSphere IaaS control plane의 VM에 NVIDIA 게스트 드라이버 설치의 내용을 참조하십시오.

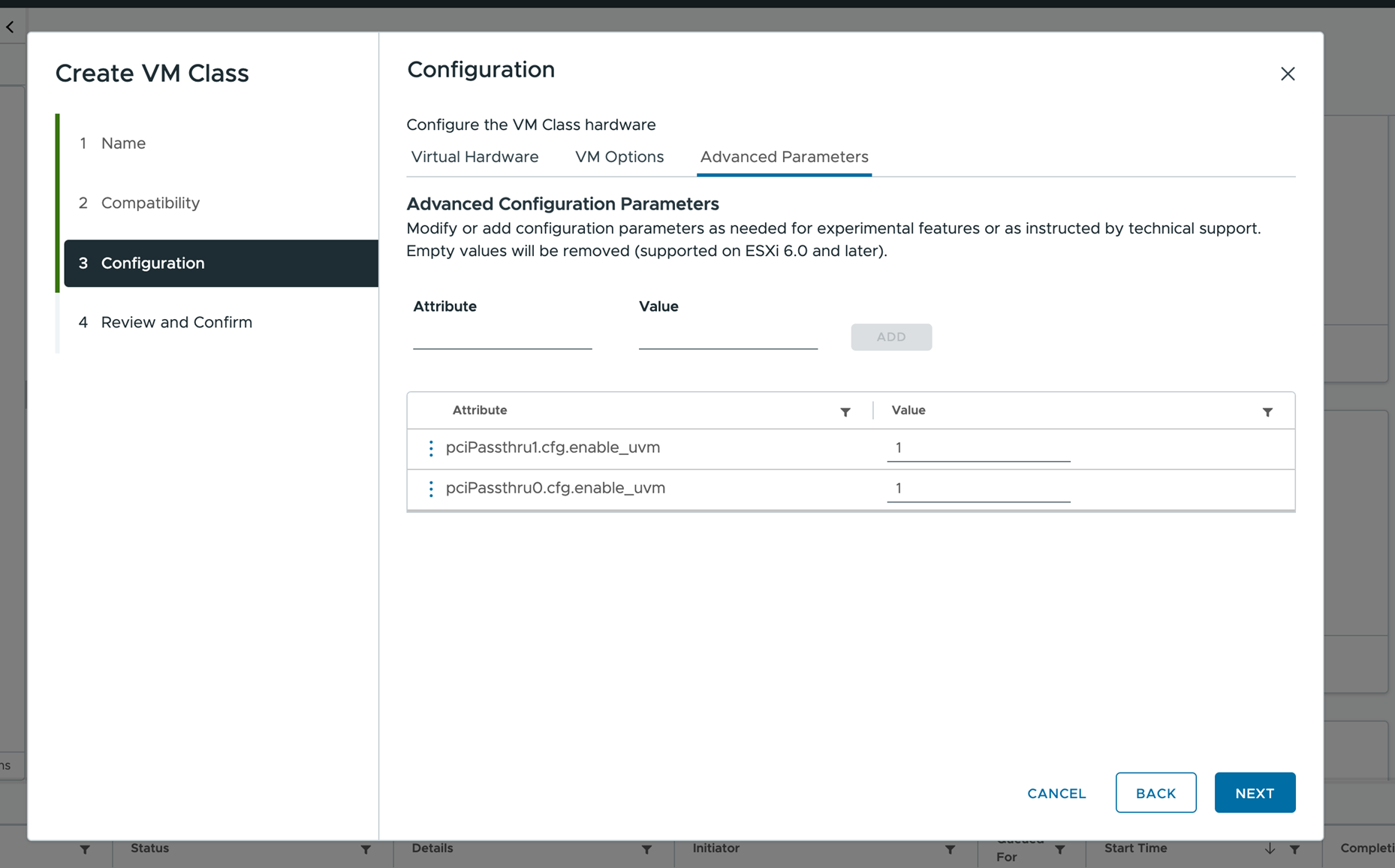

vSphere Client를 사용하여 VM 클래스에 vGPU 디바이스 추가

기존 VM 클래스를 생성하거나 편집하여 NVIDIA GRID vGPU(가상 GPU)를 추가합니다.

사전 요구 사항

프로시저

결과

데이터 센터 CLI를 사용하여 VM 클래스에 vGPU 디바이스 추가

vSphere Client 외에도 DCLI(데이터 센터 CLI) 명령을 사용하여 vGPU 및 고급 구성을 추가할 수 있습니다.

DCLI 명령에 대한 자세한 내용은 데이터 센터 CLI를 사용하여 VM 클래스 생성 및 관리 항목을 참조하십시오.

프로시저

vSphere IaaS control plane의 VM에 NVIDIA 게스트 드라이버 설치

VM에 vGPU용으로 구성된 PCI 디바이스가 포함된 경우 vSphere IaaS control plane 환경에서 VM을 생성하고 부팅한 후에 NVIDIA vGPU 그래픽 드라이버를 설치하여 GPU 작업이 완전하게 사용되도록 설정합니다.

사전 요구 사항

- vGPU를 사용하여 VM을 배포합니다. VM YAML 파일이 vGPU 정의가 있는 VM 클래스를 참조하는지 확인합니다. vSphere IaaS control plane에서 가상 시스템 배포의 내용을 참조하십시오.

- NVIDIA 다운로드 사이트에서 vGPU 소프트웨어 패키지를 다운로드하고 패키지 압축을 풀고 게스트 드라이브 구성 요소를 준비했는지 확인합니다. 자세한 내용은 해당 NVIDIA 가상 GPU 소프트웨어 설명서를 참조하십시오.

참고: 드라이버 구성 요소의 버전은 vSphere 관리자가 ESXi 호스트에 설치한 vGPU Manager의 버전과 일치해야 합니다.

프로시저

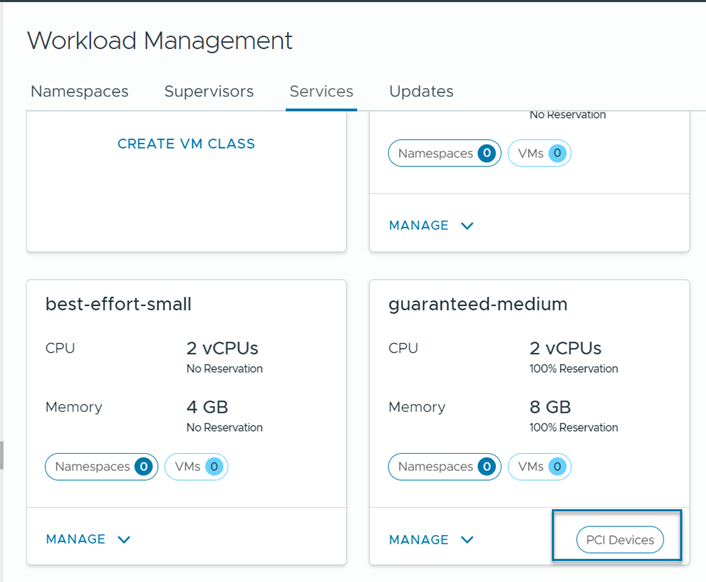

vSphere IaaS control plane에 PCI 디바이스가 있는 VM 배포

vGPU 외에도 패스스루 모드의 VM에서 사용할 수 있도록 ESXi 호스트에서 다른 PCI 디바이스를 구성할 수 있습니다.

![[새 디바이스 추가] 메뉴의 [PCI 디바이스] 옵션](images/GUID-21E14AD3-806E-4965-90E8-8E821B6EB28F-low.png)