Bereitstellen von Verwaltungsclustern mithilfe der Schnittstelle des Installationsprogramms

In diesem Thema wird beschrieben, wie Sie die Installationsschnittstelle von Tanzu Kubernetes Grid verwenden, um einen Verwaltungscluster auf vSphere, wenn vSphere with Tanzu-Supervisor nicht aktiviert ist, auf Amazon Web Services (AWS) und auf Microsoft Azure bereitzustellen. Die Schnittstelle des Tanzu Kubernetes Grid-Installationsprogramms führt Sie durch die Bereitstellung des Verwaltungsclusters und bietet verschiedene Konfigurationen, die Sie auswählen oder neu konfigurieren können. Wenn Sie zum ersten Mal einen Verwaltungscluster für eine bestimmte Zielplattform bereitstellen, sollten Sie die Benutzeroberfläche des Installationsprogramms verwenden, außer in den Fällen, in denen die Bereitstellung aus einer Konfigurationsdatei durchgeführt werden muss.

Voraussetzungen

Bevor Sie einen Verwaltungscluster bereitstellen können, müssen Sie sicherstellen, dass Ihre Umgebung die Anforderungen der Zielplattform erfüllt.

Allgemeine Voraussetzungen

- Stellen Sie sicher, dass alle Anforderungen erfüllt sind und Sie alle Verfahren unter Installieren der Tanzu CLI und anderer Tools für die Verwendung mit eigenständigen Verwaltungsclustern befolgt haben.

-

Für Produktionsbereitstellungen wird dringend empfohlen, die Identitätsverwaltung für Ihre Cluster zu aktivieren. Informationen zu den vorbereitenden Schritten, die vor der Bereitstellung eines Verwaltungsclusters durchgeführt werden müssen, finden Sie unter Abrufen Ihrer Identitätsanbieterinformationen in Konfiguration der Identitätsverwaltung.

-

Wenn Sie Cluster in einer Umgebung mit Internetbeschränkungen für vSphere oder AWS bereitstellen, müssen Sie auch die Schritte in Vorbereiten einer Umgebung mit Internetbeschränkungen durchführen. Diese Schritte umfassen das Festlegen von

TKG_CUSTOM_IMAGE_REPOSITORYals Umgebungsvariable.

Infrastrukturvoraussetzungen

Für jede Zielplattform gelten zusätzliche Voraussetzungen für die Bereitstellung des Verwaltungsclusters.

- vSphere

-

Stellen Sie sicher, dass alle unter

Vorbereitung zum Bereitstellen von Verwaltungsclustern auf vSphere aufgeführten Anforderungen erfüllt sind.

Hinweis

Auf vSphere with Tanzu in vSphere 8 müssen Sie keinen Verwaltungscluster bereitstellen. Weitere Informationen finden Sie unter vSphere with Tanzu Supervisor ist ein Verwaltungscluster.

- AWS

-

- Stellen Sie sicher, dass alle unter Vorbereitung zum Bereitstellen von Verwaltungsclustern auf AWS aufgeführten Anforderungen erfüllt sind.

- Informationen zu den Konfigurationen der verschiedenen Größen von Knoteninstanzen, z. B.

t3.largeodert3.xlargefinden Sie unter Amazon EC2-Instanztypen. - Informationen zu von Tanzu Kubernetes Grid verwendeten VPC- und NAT-Ressourcen finden Sie unter Ressourcennutzung in Ihrem Amazon Web Services-Konto.

- Azure

-

- Stellen Sie sicher, dass die unter Vorbereitung zum Bereitstellen von Verwaltungsclustern auf Microsoft Azure aufgeführten Anforderungen erfüllt sind.

- Informationen zu den Konfigurationen der verschiedenen Größen von Knoteninstanzen für Azure, z. B.

Standard_D2s_v3oderStandard_D4s_v3finden Sie unter Größen virtueller Maschinen in Azure.

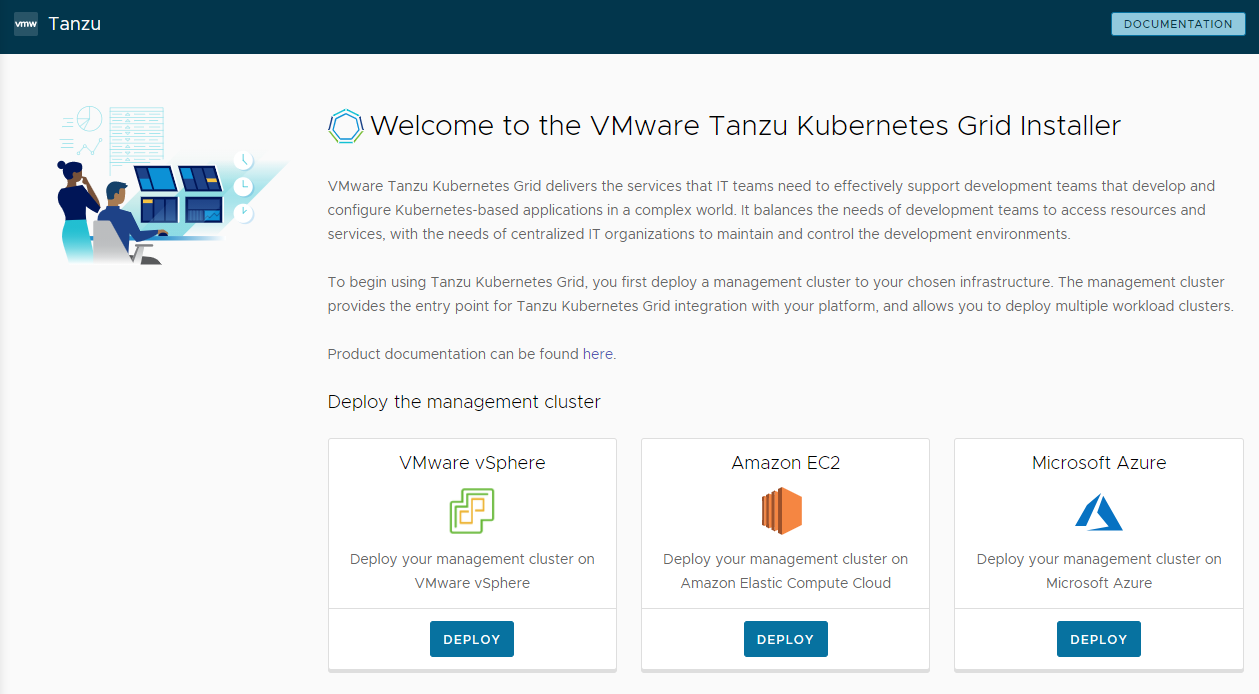

Starten der Schnittstelle des Installationsprogramms

Standardmäßig speichert Tanzu Kubernetes Grid die Datei kubeconfig für alle Verwaltungscluster im Verzeichnis ~/.kube-tkg/config. Wenn Sie die Datei kubeconfig für Ihren Verwaltungscluster an einem anderen Speicherort speichern möchten, legen Sie die Umgebungsvariable KUBECONFIG fest, bevor Sie tanzu mc create ausführen.

-

Führen Sie auf der Maschine, auf der Sie die Tanzu CLI heruntergeladen und installiert haben, den Befehl

tanzu mc createmit der Option--uiaus:tanzu management-cluster create --uiWenn die Voraussetzungen erfüllt sind, wird die Schnittstelle des Installationsprogramms in einem Browser gestartet und führt Sie durch die Schritte zum Konfigurieren des Verwaltungsclusters.

Vorsicht

Der Befehl

tanzu mc createnimmt einige Zeit in Anspruch. Führen Sie während der Ausführung vontanzu mc createkeine zusätzlichen Aufrufe vontanzu mc createauf derselben Bootstrap-Maschine aus, um mehrere Verwaltungscluster bereitzustellen, den Kontext zu ändern oder~/.kube-tkg/configzu bearbeiten.Im Abschnitt Optionen der Schnittstelle des Installationsprogramms wird erläutert, wie Sie ändern können, wo die Schnittstelle des Installationsprogramms ausgeführt wird, einschließlich der Möglichkeit einer Ausführung auf einer anderen Maschine über die Tanzu CLI.

-

Klicken Sie für VMware vSphere, Amazon EC2 oder Microsoft Azure auf die Schaltfläche Bereitstellen.

Optionen der Schnittstelle des Installationsprogramms

Standardmäßig öffnet tanzu mc create --ui die Schnittstelle des Installationsprogramms lokal auf http://127.0.0.1:8080 in Ihrem Standardbrowser. Sie können die Optionen --browser und --bind verwenden, um zu steuern, wo die Schnittstelle des Installationsprogramms ausgeführt wird:

--browsergibt den lokalen Browser an, in dem die Schnittstelle geöffnet werden soll.- Unterstützte Werte sind

chrome,firefox,safari,ie,edgeodernone. - Verwenden Sie

nonemit--bind, um die Schnittstelle wie unten beschrieben auf einer anderen Maschine auszuführen.

- Unterstützte Werte sind

-

--bindgibt die IP-Adresse und den Port an, von denen aus die Schnittstelle bereitgestellt werden soll.Vorsicht

Die Bereitstellung der Schnittstelle des Installationsprogramms über eine nicht standardmäßige IP-Adresse und einen nicht standardmäßigen Port könnte die Tanzu CLI einem potenziellen Sicherheitsrisiko aussetzen, solange die Schnittstelle ausgeführt wird. VMware empfiehlt die Übergabe einer IP und eines Port in einem sicheren Netzwerk an die Option

–bind.

Anwendungsbeispiele für --browser und --bind:

- Wenn ein anderer Prozess bereits

http://127.0.0.1:8080verwendet, verwenden Sie--bind, um die Benutzeroberfläche von einem anderen lokalen Port aus zu bedienen. - Damit die Benutzeroberfläche des Installationsprogramms lokal angezeigt wird, wenn SSH-Tunneling auf der Bootstrap-Maschine durchgeführt wird oder dessen Anzeige per X11-Forwarding weitergeleitet wird, müssen Sie möglicherweise

--browser noneverwenden. -

So führen Sie die Tanzu CLI aus und erstellen Verwaltungscluster auf einer Remotemaschine, während die Benutzeroberfläche des Installationsprogramms lokal oder an anderer Stelle ausgeführt wird:

-

Führen Sie auf der Remote-Bootstrap-Maschine

tanzu mc create --uimit den folgenden Optionen und Werten aus:--bind: eine IP-Adresse und ein Port für die Remotemaschine--browser:none

tanzu mc create --ui --bind 192.168.1.87:5555 --browser none -

Navigieren Sie auf der Maschine mit der lokalen Benutzeroberfläche zur IP-Adresse der Remotemaschine, um auf die Benutzeroberfläche des Installationsprogramms zuzugreifen.

-

Konfigurieren der Zielplattform

Die Optionen zum Konfigurieren der Zielplattform hängen vom verwendeten Anbieter ab.

- vSphere

-

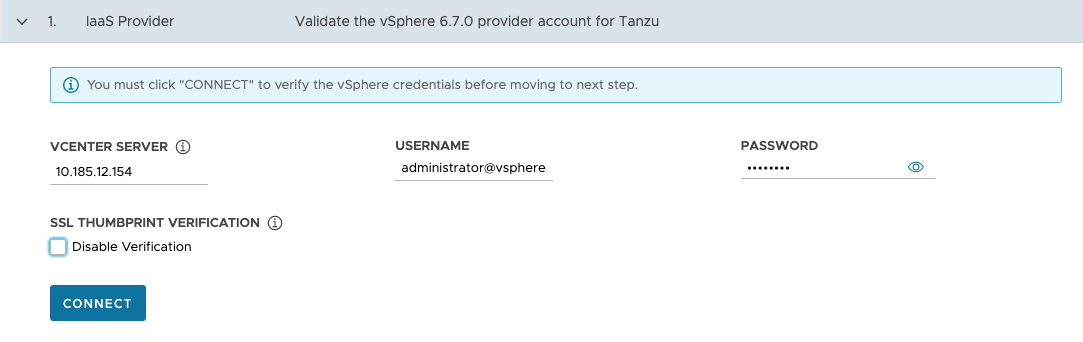

Konfiguration der Verbindung zu Ihrer vSphere-Instanz.

-

Geben Sie im Abschnitt IaaS-Anbieter die IP-Adresse oder den vollqualifizierten Domänennamen (FQDN) der vCenter Server-Instanz ein, auf der der Verwaltungscluster bereitgestellt werden soll.

Die Unterstützung für IPv6-Adressen in Tanzu Kubernetes Grid ist begrenzt. Weitere Informationen finden Sie unter Bereitstellen von Clustern auf IPv6 (nur vSphere). Wenn die Bereitstellung nicht für eine auf IPv6 beschränkte Netzwerkumgebung vorgesehen ist, müssen Sie IPv4-Adressen mithilfe der folgenden Schritte angeben.

-

Geben Sie den vCenter Single Sign-On-Benutzernamen und das Kennwort für ein Benutzerkonto ein, das über die erforderlichen Berechtigungen für Tanzu Kubernetes Grid-Vorgänge verfügt.

Der Kontoname muss die Domäne enthalten, z. B.

[email protected].

-

(Optional) Wählen Sie unter SL-Fingerabdrucküberprüfung die Option Verifizierung deaktivieren aus. Wenn Sie dieses Kontrollkästchen aktivieren, umgeht das Installationsprogramm die Verifizierung des Zertifikatfingerabdrucks beim Aufbau einer Verbindung mit dem vCenter Server.

-

Klicken Sie auf Verbinden.

-

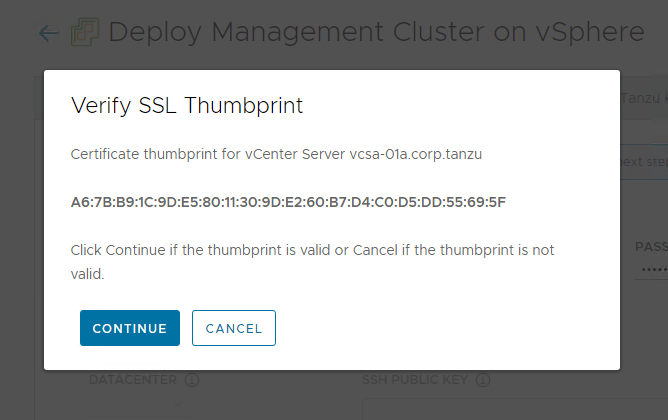

Überprüfen Sie den SSL-Fingerabdruck des vCenter Server-Zertifikats und klicken Sie auf Weiter, wenn er gültig ist. Dieser Bildschirm wird nur angezeigt, wenn das obige Kontrollkästchen Verifizierung deaktivieren deaktiviert ist.

Informationen zum Abrufen des Fingerabdrucks des vCenter Server-Zertifikats finden Sie unter Abrufen von Fingerabdrücken des vSphere-Zertifikats.

-

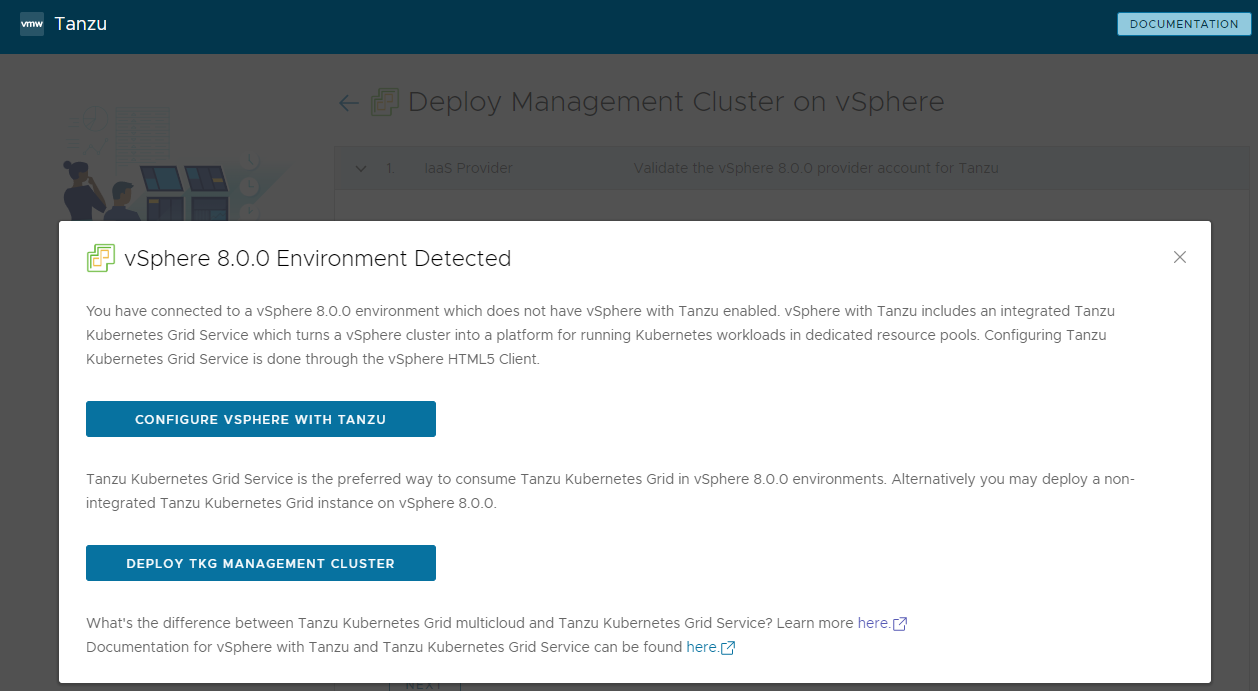

Wenn Sie einen Verwaltungscluster auf einer vSphere 7- oder vSphere 8-Instanz bereitstellen, bestätigen Sie, ob Sie mit der Bereitstellung fortfahren möchten.

In vSphere 7 und vSphere 8 stellt vSphere with Tanzu einen integrierten Supervisor bereit, der als Verwaltungscluster funktioniert und eine bessere Benutzererfahrung bietet als ein eigenständiger Verwaltungscluster. Die Bereitstellung eines Tanzu Kubernetes Grid-Verwaltungsclusters in vSphere 7 oder vSphere 8 wird auch bei nicht vorhandenem Supervisor unterstützt, es ist jedoch vorzuziehen, vSphere with Tanzu zu aktivieren und nach Möglichkeit den Supervisor zu verwenden. Azure VMware Solution unterstützt keinen Supervisor-Cluster, sodass Sie einen Verwaltungscluster bereitstellen müssen.

Weitere Informationen finden Sie unter vSphere with Tanzu Supervisor ist ein Verwaltungscluster.

Entsprechend der Empfehlung zur Verwendung von vSphere with Tanzu bei der Bereitstellung auf vSphere 7 und vSphere 8 verhält sich das Tanzu Kubernetes Grid-Installationsprogramm wie folgt:

- Wenn vSphere with Tanzu aktiviert ist, informiert Sie das Installationsprogramm, dass die Bereitstellung eines Verwaltungsclusters nicht möglich ist, und wird beendet.

- Wenn vSphere with Tanzu nicht aktiviert ist informiert Sie das Installationsprogramm darüber, dass die Bereitstellung eines Tanzu Kubernetes Grid-Verwaltungsclusters möglich ist, aber nicht empfohlen wird, und stellt Sie vor die Wahl:

- Mit der Option Konfigurieren vSphere with Tanzu (Configure vSphere with Tanzu) wird der vSphere Client geöffnet, sodass Sie Ihren Supervisor konfigurieren können, wie unter Konfiguration und Verwalten eines Supervisors in der Dokumentation zu vSphere 8 beschrieben.

- Mit der Option TKG-Verwaltungscluster bereitstellen (Deploy TKG Management Cluster) können Sie weiterhin einen Verwaltungscluster für vSphere 7 oder vSphere 8 und je nach Bedarf für Azure VMware Solution bereitstellen. Bei Verwendung von vSphere 8 besteht die bevorzugte Option darin, vSphere with Tanzu zu aktivieren und den integrierten Supervisor zu verwenden, anstatt einen Tanzu Kubernetes Grid-Verwaltungscluster bereitzustellen.

-

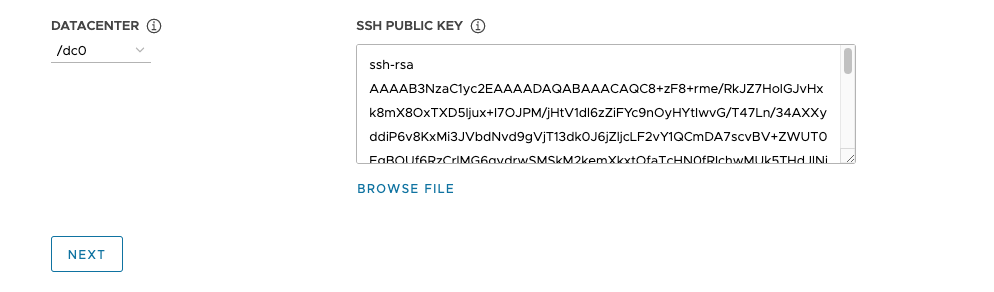

Wählen Sie im Dropdown-Menü Datencenter das Datencenter aus, in dem der Verwaltungscluster bereitgestellt werden soll.

-

Fügen Sie Ihren öffentlichen SSH-Schlüssel hinzu. Um Ihren öffentlichen SSH-Schlüssel hinzuzufügen, verwenden Sie die Option Datei durchsuchen oder fügen Sie den Inhalt des Schlüssels manuell in das Textfeld ein. Klicken Sie auf Weiter (Next).

-

- AWS

-

Konfigurieren Sie die Verbindung mit Ihrem AWS-Konto.

-

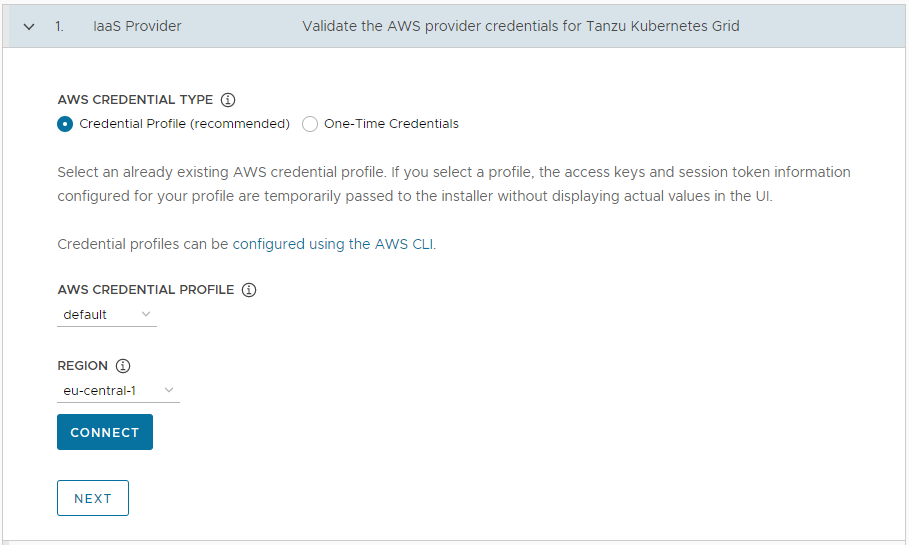

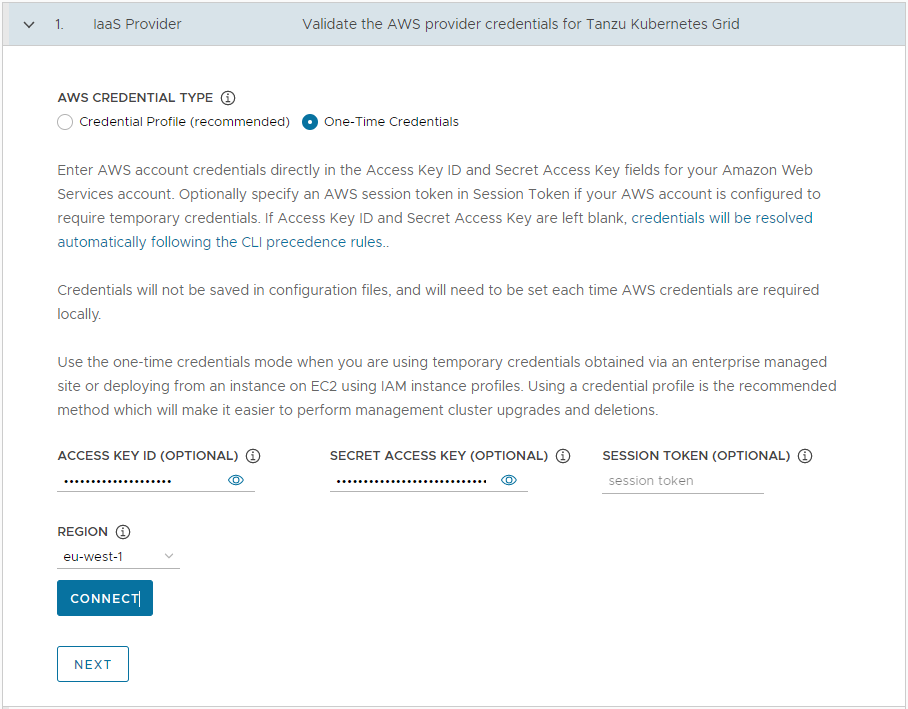

Wählen Sie im Abschnitt IaaS-Anbieter aus, wie die Anmeldedaten für Ihr AWS-Konto bereitgestellt werden sollen. Die folgenden beiden Möglichkeiten stehen zur Verfügung:

-

Anmeldedatenprofil (empfohlen): Auswahl eines bereits vorhandenen AWS-Anmeldedatenprofils. Wenn Sie ein Profil auswählen, werden die für Ihr Profil konfigurierten Informationen zum Zugriffsschlüssel und zum Sitzungstoken an das Installationsprogramm übergeben, ohne dass die tatsächlichen Werte in der Benutzeroberfläche angezeigt werden. Informationen zum Einrichten von Anmeldedatenprofilen finden Sie unter Anmeldedatendateien und -profile.

-

Einmalige Anmeldedaten: Geben Sie die Anmeldedaten für das AWS-Konto direkt in die Felder Zugriffsschlüssel-ID und Geheimer Zugriffsschlüssel für Ihr AWS-Konto ein. Geben Sie optional ein AWS-Sitzungstoken in Sitzungstoken an, wenn Ihr AWS-Konto so konfiguriert ist, dass temporäre Anmeldedaten erforderlich sind. Weitere Informationen zum Abrufen eines Sitzungstokens finden Sie unter Verwenden temporärer Anmeldedaten mit AWS-Ressourcen.

-

-

Wählen Sie in Region die AWS-Region aus, in der der Verwaltungscluster bereitgestellt werden soll.

Wenn ein Produktionsverwaltungs-Cluster bereitgestellt werden soll, muss diese Region über mindestens drei Verfügbarkeitsbereiche verfügen.

- Klicken Sie auf Verbinden. Wenn die Verbindung erfolgreich hergestellt wurde, klicken Sie auf Weiter (Next).

-

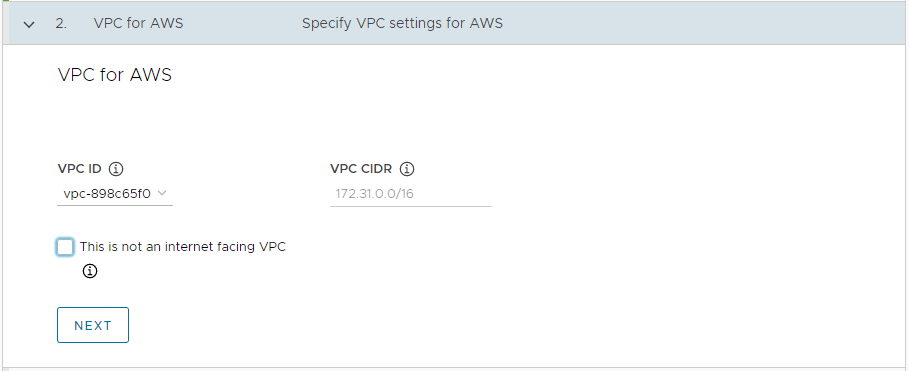

Wählen Sie im Abschnitt VPC für AWS (VPC for AWS) die Option VPC-ID (VPC ID) aus dem Dropdown-Menü aus. Der Block VPC CIDR wird automatisch ausgefüllt, wenn Sie die VPC auswählen. Wenn Sie den Verwaltungscluster in einer Umgebung mit Internetbeschränkungen bereitstellen, z. B. in einer Proxy- oder Air-Gap-Umgebung, aktivieren Sie das Kontrollkästchen Dies ist keine internetseitige VPC (This is not an internet facing VPC).

-

- Azure

-

Konfigurieren Sie die Verbindung mit Ihrem Microsoft Azure-Konto.

Wichtig

Wenn Sie zum ersten Mal einen Verwaltungscluster in Azure mit einer neuen Version von Tanzu Kubernetes Grid (z. B. v2.2) bereitstellen, müssen Sie sicherstellen, dass Sie die Lizenz für das Basisimage dieser Version akzeptiert haben. Weitere Informationen finden Sie in der Dokumentation zum Akzeptieren der Lizenz für das Basisimage in der Anleitung für die Vorbereitung der Bereitstellung von Verwaltungsclustern in Microsoft Azure.

-

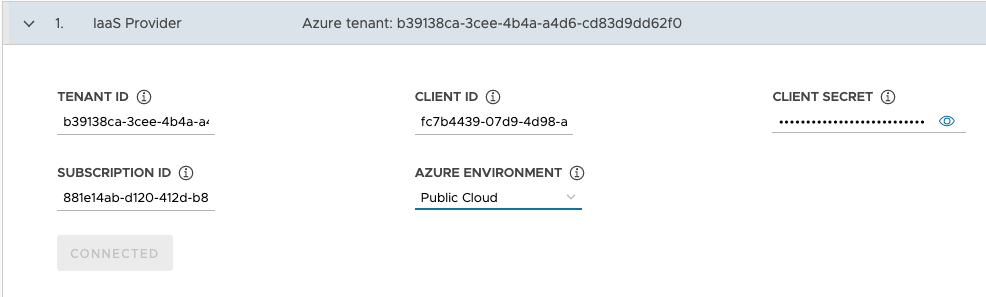

Geben Sie im Abschnitt IaaS-Anbieter (IaaS Provider) die Werte Tenant-ID (Tenant ID), Client-ID (Client ID), Geheimer Clientschlüssel (Client Secret) und Abonnement-ID (Subscription ID) für Ihr Azure-Konto ein. Diese Werte wurden aufgezeichnet, als Sie eine Azure-App registriert und über das Azure-Portal einen geheimen Schlüssel dafür erstellt haben.

- Wählen Sie Ihre Azure-Umgebung aus, entweder Public Cloud oder US Government Cloud. Sie können bei Bereitstellung über eine Konfigurationsdatei und Festlegung von

AZURE_ENVIRONMENTandere Umgebungen angeben. - Klicken Sie auf Verbinden. Das Installationsprogramm überprüft die Verbindung und ändert die Beschriftung der Schaltfläche in Verbunden (Connected).

- Wählen Sie die Azure-Region aus, in der der Verwaltungscluster bereitgestellt werden soll.

-

Fügen Sie den Inhalt Ihres öffentlichen SSH-Schlüssels in das Textfeld ein, z. B.

.ssh/id_rsa.pub. -

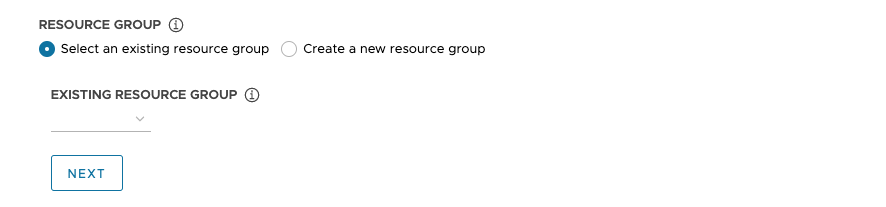

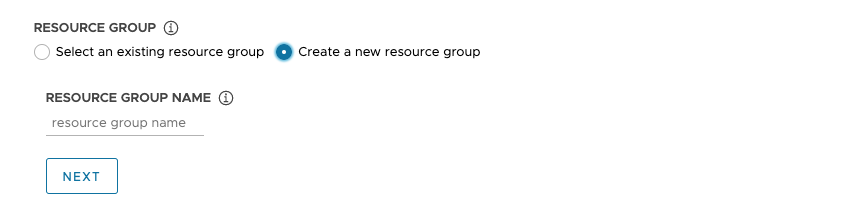

Wählen Sie unter Ressourcengruppe (Resource Group) entweder Vorhandene Ressourcengruppe auswählen (Select an existing resource group) oder Neue Ressourcengruppe erstellen (Create a new resource group) aus.

-

Wenn Sie Vorhandene Ressourcengruppe auswählen (Select an existing resource group) auswählen, verwenden Sie das Dropdown-Menü, um die Gruppe auszuwählen, und klicken Sie dann auf Weiter (Next).

-

Wenn Sie Neue Ressourcengruppe erstellen (Create a new resource group) auswählen, geben Sie einen Namen für die neue Ressourcengruppe ein und klicken Sie dann auf Weiter (Next).

-

-

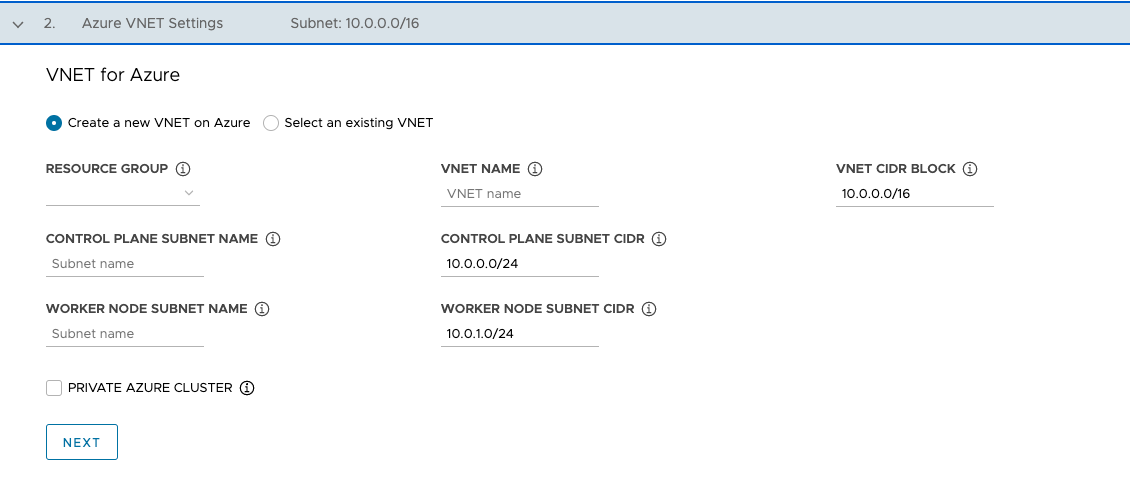

Wählen Sie im Abschnitt VNet für Azure (VNet for Azure) entweder Neues VNet in Azure erstellen (Create a new VNet on Azure) oder Vorhandenes VNet auswählen (Select an existing VNet) aus.

-

Wenn Sie Neues VNet in Azure erstellen (Create a new VNet on Azure) auswählen, wählen Sie im Dropdown-Menü die Ressourcengruppe aus, in der das VNet erstellt werden soll, und geben Sie Folgendes an:

- Einen Namen und einen CIDR-Block für das VNet. Der Standardwert ist

10.0.0.0/16. - Einen Namen und einen CIDR-Block für das Steuerungsebenen-Subnetz. Der Standardwert ist

10.0.0.0/24. - Einen Namen und einen CIDR-Block für das Worker-Knoten-Subnetz. Der Standardwert ist

10.0.1.0/24.

Klicken Sie nach dem Konfigurieren dieser Felder auf Weiter (Next).

- Einen Namen und einen CIDR-Block für das VNet. Der Standardwert ist

-

Wenn Sie Vorhandenes VNet auswählen (Select an existing VNet) auswählen, verwenden Sie die Dropdown-Menüs, um die Ressourcengruppe, in der sich das VNet befindet, den VNet-Namen und die Subnetze der Steuerungsebene sowie der Worker-Knoten auszuwählen, und klicken Sie dann auf Weiter (Next).

-

Aktivieren Sie das Kontrollkästchen Privater Azure-Cluster (Private Azure Cluster), um den Verwaltungscluster als privat festzulegen, wie unter Private Cluster in Azure beschrieben.

-

-

Konfiguration der Verwaltungsclustereinstellungen

Einige der Optionen für die Konfiguration des Verwaltungsclusters hängen vom verwendeten Anbieter ab.

-

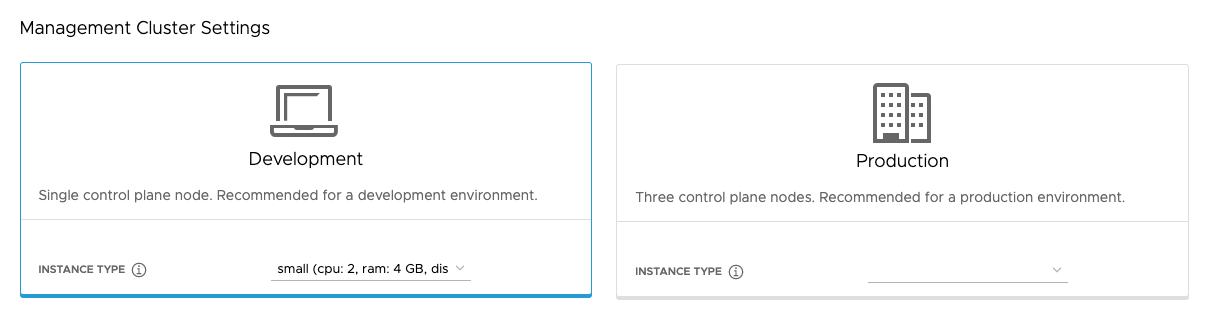

Wählen Sie im Abschnitt Verwaltungsclustereinstellungen (Management Cluster Settings) die Kachel Entwicklung (Development) oder Produktion (Production) aus.

- Wenn Sie Entwicklung (Development) auswählen, stellt das Installationsprogramm einen Verwaltungscluster mit einem einzelnen Steuerungsebenenknoten und einem einzelnen Worker-Knoten bereit.

- Wenn Sie Produktion (Production) auswählen, stellt das Installationsprogramm einen hochverfügbaren Verwaltungscluster mit drei Steuerungsebenen- und drei Worker-Knoten bereit.

-

Verwenden Sie in einer der Kacheln Entwicklung (Development) oder Produktion (Production) das Dropdown-Menü Instanztyp (Instance type), um aus verschiedenen Kombinationen von CPU, RAM und Speicher für die VM oder die VMs des Steuerungsebenenknotens auszuwählen.

Wählen Sie die Konfiguration für die VMs des Steuerungsebenenknotens entsprechend der erwarteten Arbeitslasten aus, die ausgeführt werden sollen. Beispielsweise benötigen einige Arbeitslasten möglicherweise eine große Rechenleistung, aber relativ wenig Speicher, während andere möglicherweise eine große Menge an Speicher und weniger Rechenleistung benötigen. Wenn Sie einen Instanztyp in der Kachel Produktion (Production) auswählen, wird der ausgewählte Instanztyp automatisch als Worker-Knoten-Instanztyp ausgewählt. Sie können dies bei Bedarf ändern.

Wenn Sie den Verwaltungscluster bei Tanzu Mission Control registrieren möchten, stellen Sie sicher, dass Ihre Arbeitslastcluster die unter Anforderungen für die Registrierung eines Tanzu Kubernetes-Clusters bei Tanzu Mission Control in der Dokumentation von Tanzu Mission Control aufgeführten Anforderungen erfüllen.

- vSphere

- Wählen Sie eine Größe aus den vordefinierten CPU-, Arbeitsspeicher- und Speicherkonfigurationen aus. Die Mindestkonfiguration umfasst 2 CPUs und 4 GB Arbeitsspeicher.

- AWS

- Wählen Sie eine Instanzgröße aus. Im Dropdown-Menü werden die Optionen alphabetisch und nicht nach Größe aufgelistet. Die Mindestkonfiguration umfasst 2 CPUs und 8 GB Arbeitsspeicher. Die Liste der kompatiblen Instanztypen variiert je nach Region. Informationen zur Konfiguration der verschiedenen Instanzgrößen finden Sie unter Amazon EC2-Instanztypen.

- Azure

- Wählen Sie eine Instanzgröße aus. Die Mindestkonfiguration umfasst 2 CPUs und 8 GB Arbeitsspeicher. Die Liste der kompatiblen Instanztypen variiert je nach Region. Informationen zu den Konfigurationen der verschiedenen Größen von Knoteninstanzen für Azure finden Sie unter Größen virtueller Maschinen in Azure.

-

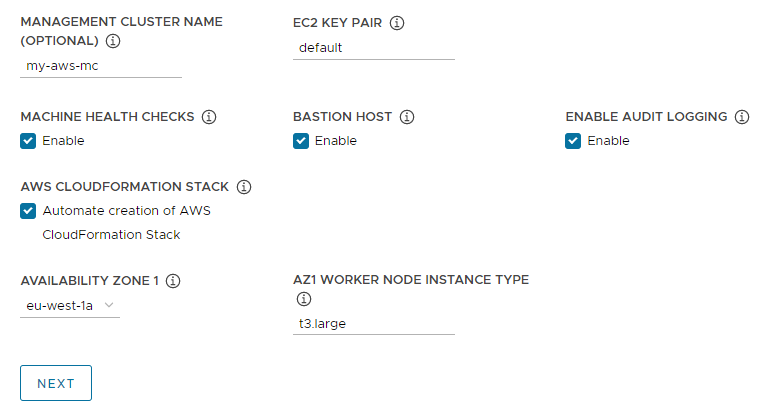

Geben Sie optional einen Namen für Ihren Verwaltungscluster ein.

Wenn Sie keinen Namen angeben, generiert Tanzu Kubernetes Grid automatisch einen eindeutigen Namen. Wenn Sie einen Namen angeben, muss dieser mit einem Buchstaben, nicht mit einem numerischen Zeichen, enden und mit den DNS-Hostnamenanforderungen übereinstimmen, die in RFC 952 beschrieben und in RFC 1123 geändert wurden.

-

(Optional) Aktivieren Sie das Kontrollkästchen Maschinenintegritätsprüfungen (Machine Health Checks), wenn Sie

MachineHealthCheckaktivieren möchten. Sie könnenMachineHealthCheckauf Clustern nach der Bereitstellung mithilfe der CLI aktivieren oder deaktivieren. Eine Anleitung dafür finden Sie unter Konfiguration von Maschinenintegritätsprüfungen für Arbeitslastcluster. -

(Optional) Aktivieren Sie das Kontrollkästchen Überwachungsprotokollierung aktivieren (Enable Audit Logging), um Anforderungen an den Kubernetes-API-Server aufzuzeichnen. Weitere Informationen finden Sie unter Überwachungsprotokollierung.

-

Konfigurieren Sie zusätzliche Einstellungen, die für Ihre Zielplattform spezifisch sind.

- vSphere

-

Konfigurieren Sie die vSphere-spezifischen Einstellungen.

- Wählen Sie unter Worker-Knoten-Instanztyp (Worker Node Instance Type) die Konfiguration für die Worker-Knoten-VM aus.

-

Wählen Sie unter Endpoint-Anbieter der Steuerungsebene (Control Plane Endpoint Provider) die Option Kube-Vip oder NSX Advanced Load Balancer aus, um die Komponente auszuwählen, die für den API-Server der Steuerungsebene verwendet werden soll.

Um NSX Advanced Load Balancer zu verwenden, müssen Sie ihn zuerst in Ihrer vSphere-Umgebung bereitstellen. Weitere Informationen finden Sie unter Installation von NSX Advanced Load Balancer. Weitere Informationen zu den Vorteilen der Verwendung von NSX Advanced Load Balancer als Endpoint-Anbieter der Steuerungsebene finden Sie unter Konfigurieren von NSX Advanced Load Balancer.

-

Geben Sie unter Steuerungsebenen-Endpoint (Control Plane Endpoint) eine statische virtuelle IP-Adresse oder einen FQDN für API-Anforderungen an den Verwaltungscluster ein. Diese Einstellung ist erforderlich, wenn Sie Kube-Vip verwenden.

Stellen Sie sicher, dass sich diese IP-Adresse nicht in Ihrem DHCP-Bereich, sondern im selben Subnetz wie der DHCP-Bereich befindet. Wenn Sie der VIP-Adresse einen FQDN zugeordnet haben, können Sie anstelle der VIP-Adresse den FQDN angeben. Weitere Informationen finden Sie unter Statische VIPs und Lastausgleichsdienste für vSphere.

Wenn Sie NSX Advanced Load Balancer als Endpoint-Anbieter der Steuerungsebene verwenden, wird die VIP automatisch aus dem statischen IP-Pool von NSX Advanced Load Balancer zugewiesen.

- AWS

-

Konfigurieren Sie die AWS-spezifischen Einstellungen.

-

Geben Sie unter EC2-Schlüsselpaar (EC2 Key Pair) den Namen eines AWS-Schlüsselpaars an, das bereits bei Ihrem AWS-Konto und in der Region registriert ist, in der Sie den Verwaltungscluster bereitstellen. Sie haben dies möglicherweise in Konfiguration der AWS-Kontoanmeldedaten und des SSH-Schlüssels eingerichtet.

-

(Optional) Deaktivieren Sie das Kontrollkästchen Bastion-Host (Bastion Host), wenn in den Verfügbarkeitsbereichen, in denen Sie den Verwaltungscluster bereitstellen, bereits ein Bastion-Host vorhanden ist.

Wenn Sie diese Option aktiviert lassen, erstellt Tanzu Kubernetes Grid einen Bastion-Host für Sie.

-

Wenn Sie zum ersten Mal einen Verwaltungscluster in diesem AWS-Konto bereitstellen, aktivieren Sie das Kontrollkästchen Erstellung des AWS CloudFormation-Stacks automatisieren (Automate creation of AWS CloudFormation Stack).

Dieser CloudFormation-Stack erstellt die IAM-Ressourcen (Identity and Access Management), die Tanzu Kubernetes Grid zum Bereitstellen und Ausführen von Clustern auf AWS benötigt. Weitere Informationen finden Sie unter Von Tanzu Kubernetes Grid festgelegte Berechtigungen in Vorbereitung zum Bereitstellen von Verwaltungsclustern auf AWS.

-

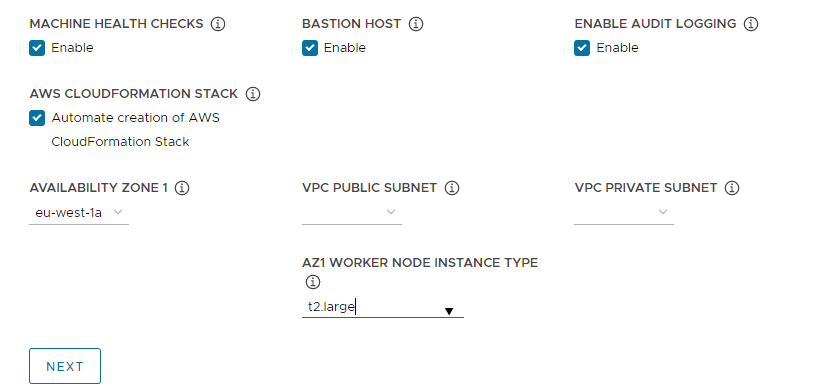

Konfigurieren von Verfügbarkeitsbereichen:

-

Wählen Sie im Dropdown-Menü Verfügbarkeitsbereich 1 (Availability Zone 1) einen Verfügbarkeitsbereich für den Verwaltungscluster aus. Sie können nur dann einen Verfügbarkeitsbereich auswählen, wenn Sie die Kachel Entwicklung (Development) ausgewählt haben. Siehe hierzu die Abbildung unten.

-

Wählen Sie im Dropdown-Menü AZ1-Worker-Knoten-Instanztyp (AZ1 Worker Node Instance Type) die Konfiguration für die Worker-Knoten-VM aus der Liste der In diesem Verfügbarkeitsbereich verfügbaren Instanzen aus.

-

Wenn Sie oben die Kachel Produktion (Production) ausgewählt haben, verwenden Sie die Dropdown-Menüs Verfügbarkeitsbereich 2 (Availability Zone 2), Verfügbarkeitsbereich 3 (Availability Zone 3) und AZ-Worker-Knoten-Instanztyp (AZ Worker Node Instance Type), um drei eindeutige Verfügbarkeitsbereiche für den Verwaltungscluster auszuwählen.

Wenn Tanzu Kubernetes Grid den Verwaltungscluster bereitstellt, der drei Steuerungsebenenknoten und drei Worker-Knoten enthält, werden die Steuerungsebenen- und Worker-Knoten auf diese Verfügbarkeitszonen verteilt.

-

Verwenden Sie die Dropdown-Menüs Öffentliches VPC-Subnetz (VPC public subnet) und privates VPC-Subnetz (VPC private subnet), um Subnetze in der VPC auszuwählen.

Wenn Sie einen Produktionsverwaltungscluster bereitstellen, wählen Sie Subnetze für alle drei Verfügbarkeitsbereiche aus. Öffentliche Subnetze sind nicht verfügbar, wenn Sie im vorherigen Abschnitt Dies ist keine internetseitige VPC (This is not an internet facing VPC) ausgewählt haben. Die folgende Abbildung zeigt die Kachel Entwicklung (Development).

-

-

- Azure

- Wählen Sie unter Worker-Knoten-Instanztyp (Worker Node Instance Type) die Konfiguration für die Worker-Knoten-VM aus.

-

Klicken Sie auf Weiter (Next).

Konfigurieren von VMware NSX Advanced Load Balancer

Das Konfigurieren von NSX Advanced Load Balancer betrifft nur vSphere-Bereitstellungen.

- vSphere

-

VMware NSX Advanced Load Balancer (ALB) bietet eine L4+L7-Lastausgleichslösung für vSphere. NSX ALB enthält einen Kubernetes-Operator, der in die Kubernetes-API integriert ist, um den Lebenszyklus von Lastausgleichs- und Ingress-Ressourcen für Arbeitslasten zu verwalten. Um NSX ALB zu verwenden, müssen Sie ihn zuerst in Ihrer vSphere-Umgebung bereitstellen. Weitere Informationen finden Sie unter

Installation von NSX Advanced Load Balancer.

Wichtig

Um unter vSphere 8 NSX Advanced Load Balancer mit einem eigenständigen TKG-Verwaltungscluster und dessen Arbeitslastclustern zu verwenden, benötigen Sie NSX ALB v22.1.2 oder höher und TKG v2.2 oder höher.

Im optionalen Abschnitt VMware NSX Advanced Load Balancer können Sie Tanzu Kubernetes Grid für die Verwendung von NSX Advanced Load Balancer konfigurieren. Standardmäßig verwenden alle Arbeitslastcluster den Lastausgleichsdienst.

- Geben Sie für Controller-Host (Controller Host) die IP-Adresse oder den FQDN der Controller-VM ein.

- Geben Sie Benutzername und Kennwort ein, die bei der Bereitstellung für den Controller-Host festgelegt wurden.

-

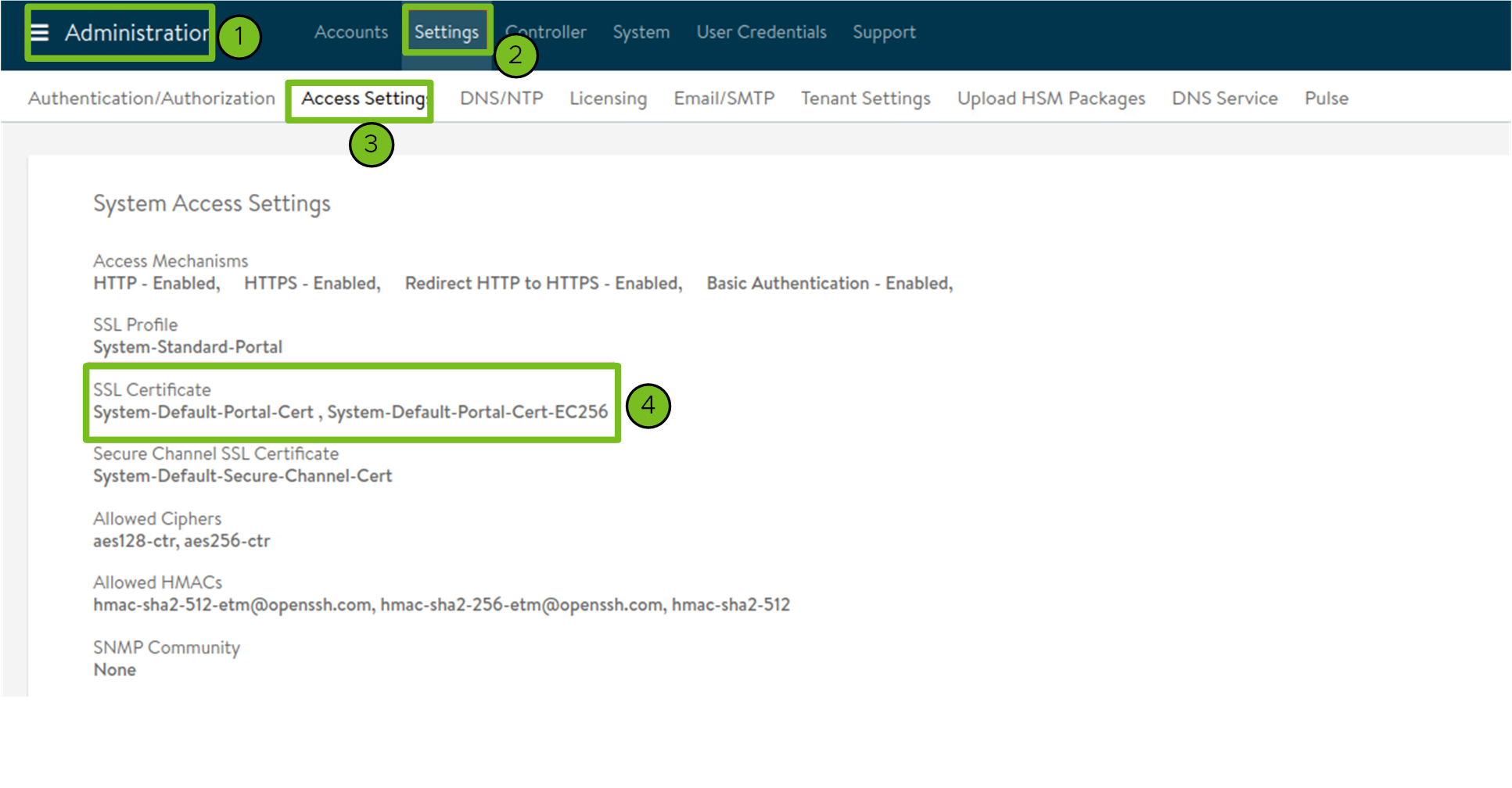

Fügen Sie den Inhalt der Zertifizierungsstelle, die zum Generieren Ihres Controller-Zertifikats verwendet wird, in das Textfeld Controller-Zertifizierungsstelle (Controller Certificate Authority) ein und klicken Sie auf Anmeldedaten verifizieren (Verify Credentials).

Der Zertifikatsinhalt beginnt mit

-----BEGIN CERTIFICATE-----.Wenn Sie über ein selbstsigniertes Controller-Zertifikat verfügen, muss es ein SSL/TLS-Zertifikat verwenden, das auf der Avi Controller-Benutzeroberfläche > Verwaltung (Administration) > Einstellungen (Settings) > Zugriffseinstellungen (Access Settings) auf der Registerkarte Systemzugriffseinstellungen (System Access Settings) > SSL-Zertifikat (SSL Certificate) konfiguriert ist. Sie können die Inhalte von Zertifikaten abrufen, wie in Einrichten eines AVI-Controllers: beschrieben. Benutzerdefiniertes Zertifikat.

-

Verwenden Sie das Dropdown-Menü Cloudname (Cloud Name), um die Cloud auszuwählen, die Sie in Ihrer NSX Advanced Load Balancer-Bereitstellung erstellt haben.

Beispiel:

Default-Cloud. -

Wählen Sie im Abschnitt Arbeitslastcluster (Workload Cluster) und Verwaltungscluster (Management Cluster) das Dropdown-Menü Name der Service-Engine-Gruppe (Service Engine Group Name) aus, um eine Dienstmodulgruppe auszuwählen.

Beispiel:

Default-Group. -

Wählen Sie im Dropdown-Menü Name Arbeitslastcluster – Name des VIP-Netzwerks der Datenebene (Workload Cluster - Data Plane VIP Network Name) den Namen des Netzwerks aus, in dem sich der dynamische IP-Pool des Lastausgleichsdiensts befindet.

Dasselbe Netzwerk wird automatisch für die Verwendung durch die Daten- und Steuerungsebenen von Arbeitslastclustern und Verwaltungsclustern ausgewählt. Sie können diese bei Bedarf ändern.

Das VIP-Netzwerk für NSX ALB muss in derselben vCenter Server-Instanz wie das Kubernetes-Netzwerk vorhanden sein, das Tanzu Kubernetes Grid verwendet. Auf diese Weise kann NSX Advanced Load Balancer das Kubernetes-Netzwerk in vCenter Server erkennen und Dienst-Engines bereitstellen und konfigurieren.

Sie können das Netzwerk in der Ansicht Infrastruktur (Infrastructure) > Netzwerke (Networks) der Benutzeroberfläche von NSX Advanced Load Balancer anzeigen.

-

Wählen Sie in den Dropdown-Menüs Arbeitslastcluster – VIP-Netzwerk-CIDR der Datenebene (Workload Cluster - Data Plane VIP Network CIDR) und Arbeitslastcluster – VIP-Netzwerk-CIDR der Steuerungsebene (Workload Cluster - Control Plane VIP Network CIDR) das CIDR des Subnetzes aus, das für die Lastausgleichsdienst-VIP verwendet werden soll, damit es von den Daten- und Steuerungsebenen von Arbeitslast- und Verwaltungsclustern genutzt werden kann. Wenn das CIDR nicht ausgewählt werden kann, geben Sie es bitte ein.

Dies stammt aus einem der konfigurierten Subnetze des VIP-Netzwerks. Sie können das Subnetz-CIDR eines bestimmten Netzwerks in der Ansicht Infrastruktur (Infrastructure) > Netzwerke (Networks) der Benutzeroberfläche von NSX Advanced Load Balancer anzeigen. Dieselben CIDRs werden automatisch in den entsprechenden Verwaltungsclustereinstellungen angewendet. Sie können diese bei Bedarf ändern.

-

(Optional) Geben Sie eine oder mehrere Clusterbezeichnungen ein, um Cluster zu benennen, auf denen NSX ALB selektiv aktiviert werden soll, oder um NSX ALB-Einstellungen für verschiedene Clustergruppen anzupassen.

Standardmäßig ist NSX Advanced Load Balancer auf allen Arbeitslastclustern aktiviert, die mit diesem Verwaltungscluster bereitgestellt werden, und die Cluster teilen sich Controller, Cloud, Dienst-Engine-Gruppe und VIP-Netzwerk von VMware NSX Advanced Load Balancer. Dies kann später nicht geändert werden.

Optional können Sie NSX ALB nur auf einer Teilmenge von Clustern aktivieren oder die Möglichkeit aufrechterhalten, NSX ALB-Einstellungen später für verschiedene Clustergruppen anzupassen. Dies ist in den folgenden Szenarien nützlich:

- Sie möchten verschiedene Sätze von Arbeitslastclustern für unterschiedliche Dienst-Engine-Gruppen konfigurieren, um Isolierung zu implementieren oder mehr Lastausgleichsdienste zu unterstützen, als die Kapazität einer Dienstmodulgruppe zulassen würde.

- Sie möchten verschiedene Sätze von Arbeitslastclustern für unterschiedliche Clouds konfigurieren, da sie an verschiedenen Sites bereitgestellt werden.

Um NSX ALB selektiv und nicht global zu aktivieren, fügen Sie Bezeichnungen im Format

key: valuehinzu. Die hier definierten Bezeichnungen werden zum Erstellen einer Bezeichnungsauswahl verwendet. Der Lastausgleichsdienst wird nur für Arbeitslastcluster-Clusterobjekte mit übereinstimmenden Bezeichnungen aktiviert. Folglich müssen Sie sicherstellen, dass dasClusterobjekt des Arbeitslastclusters die entsprechenden Bezeichnungen aufweist.Wenn Sie beispielsweise

team: tkgverwenden, um den Lastausgleichsdienst auf einem Arbeitslastcluster zu aktivieren:-

Legen Sie für

kubectlden Kontext des Verwaltungsclusters fest.kubectl config use-context management-cluster@admin -

Kennzeichnen Sie das

Clusterobjekt des entsprechenden Arbeitslastclusters mit den definierten Bezeichnungen. Wenn Sie mehrere Schlüsselwerte definieren, müssen Sie sie alle anwenden.kubectl label cluster <cluster-name> team=tkg

-

Klicken Sie auf Weiter (Next), um Metadaten zu konfigurieren.

- AWS

- Tanzu Kubernetes Grid on AWS erstellt automatisch einen Lastausgleichsdienst, wenn Sie einen Verwaltungscluster bereitstellen.

- Azure

- Tanzu Kubernetes Grid on Azure erstellt automatisch einen Lastausgleichsdienst, wenn Sie einen Verwaltungscluster bereitstellen.

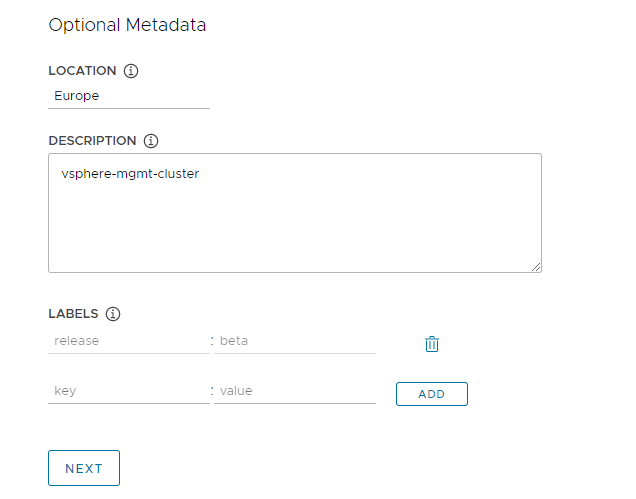

Metadaten konfigurieren

Dieser Abschnitt ist für alle Zielplattformen identisch.

Geben Sie im optionalen Abschnitt Metadaten (Metadata) optional beschreibende Informationen zu diesem Verwaltungscluster an.

Alle hier angegebenen Metadaten gelten für den Verwaltungscluster und die Arbeitslastcluster, die er verwaltet, und können mithilfe des Clusterverwaltungstools Ihrer Wahl aufgerufen werden.

- Standort (Location): Der geografische Standort, an dem die Cluster ausgeführt werden.

- Beschreibung (Description): Eine Beschreibung dieses Verwaltungsclusters. Die Beschreibung darf maximal 63 Zeichen lang sein und muss mit einem Buchstaben beginnen und enden. Sie darf nur Kleinbuchstaben, Zahlen und Bindestriche ohne Leerzeichen enthalten.

- Bezeichnungen (Labels): Schlüssel/Wert-Paare, die Benutzern bei der Identifizierung von Clustern helfen, z. B.

release : beta,environment : stagingoderenvironment : production. Weitere Informationen finden Sie unter Bezeichnungen und Selektoren in der Kubernetes-Dokumentation.

Sie können auf Hinzufügen (Add) klicken, um mehrere Bezeichnungen auf die Cluster anzuwenden.

Wenn Sie in vSphere bereitstellen, klicken Sie auf Weiter (Next), um zu Ressourcen konfigurieren zu wechseln. Wenn Sie in AWS oder Azure bereitstellen, klicken Sie auf Weiter (Next), um zu Kubernetes-Netzwerk und Proxys konfigurieren zu wechseln.

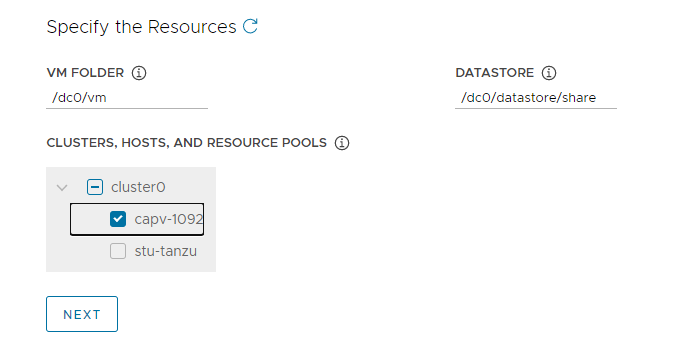

vSphere-Ressourcen konfigurieren

Dieser Abschnitt betrifft nur auf vSphere-Bereitstellungen.

- vSphere

-

Wählen Sie im Abschnitt

Ressourcen (Resources) vSphere-Ressourcen aus, die vom Verwaltungscluster verwendet werden sollen.

- Wählen Sie den VM-Ordner aus, in dem die Verwaltungscluster-VMs platziert werden sollen.

- Wählen Sie die vSphere-Datenspeicher aus, die vom Verwaltungscluster verwendet werden sollen. Die Speicherrichtlinie für die VMs kann nur angegeben werden, wenn Sie den Verwaltungscluster über eine Konfigurationsdatei bereitstellen.

-

Wählen Sie den Cluster, Host oder Ressourcenpool aus, in dem der Verwaltungscluster platziert werden soll.

„Hinweis“ Wenn in vSphere noch keine geeigneten Ressourcen vorhanden sind, wechseln Sie zu vSphere, um sie zu erstellen, ohne das Installationsprogramm für Tanzu Kubernetes Grid zu beenden. Klicken Sie dann auf die Schaltfläche „Aktualisieren (Refresh)“, damit die neuen Ressourcen ausgewählt werden können.

-

Klicken Sie auf Weiter (Next), um das Kubernetes-Netzwerk und die Proxys zu konfigurieren.

- AWS

- Dieser Abschnitt trifft für AWS-Bereitstellungen nicht zu.

- Azure

- Dieser Abschnitt trifft für Azure-Bereitstellungen nicht zu.

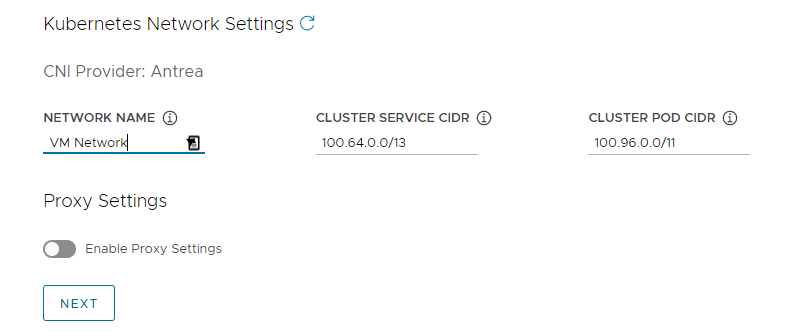

Konfigurieren des Kubernetes-Netzwerks und der Proxys

Dieser Abschnitt ist für alle Zielplattformen identisch, wobei einige der von Ihnen bereitgestellten Informationen vom verwendeten Anbieter abhängen.

-

Konfigurieren Sie im Abschnitt Kubernetes-Netzwerk (Kubernetes Network) das Netzwerk für Kubernetes-Dienste und klicken Sie auf Weiter (Next).

- (nur vSphere) Wählen Sie unter Netzwerkname (Network Name) ein vSphere-Netzwerk aus, das als Kubernetes-Dienstnetzwerk verwendet werden soll.

- Überprüfen Sie die Bereiche Clusterdienst-CIDR (Cluster Service CIDR) und Cluster-Pod-CIDR (Cluster Pod CIDR). Wenn die empfohlenen CIDR-Bereiche von

100.64.0.0/13und100.96.0.0/11nicht verfügbar sind, aktualisieren Sie die Werte unter Clusterdienst-CIDR (Cluster Service CIDR) und Cluster-Pod-CIDR (Cluster Pod CIDR).

-

(Optional) Um ausgehenden HTTP(S)-Datenverkehr vom Verwaltungscluster an einen Proxy zu senden, z. B. in einer Umgebung mit Internetbeschränkungen, schalten Sie Proxy-Einstellungen aktivieren (Enable Proxy Settings) um und geben Sie anhand der folgenden Anweisungen Ihre Proxy-Informationen ein. Tanzu Kubernetes Grid wendet diese Einstellungen auf kubelet, containerd und die Steuerungsebene an.

Sie können einen Proxy für HTTP-Datenverkehr und einen anderen Proxy für HTTPS-Datenverkehr oder denselben Proxy für HTTP- und HTTPS-Datenverkehr verwenden.

Wichtig Sie können Proxys nach der Bereitstellung des Clusters nicht mehr ändern.

-

So fügen Sie Ihre HTTP-Proxy-Informationen hinzu:

- Geben Sie unter HTTP-Proxy-URL (HTTP Proxy URL) die URL des Proxys ein, der HTTP-Anforderungen verarbeitet. Die URL muss mit

http://beginnen. Beispiel:http://myproxy.com:1234. -

Wenn der Proxy eine Authentifizierung erfordert, geben Sie unter HTTP-Proxy-Benutzername (HTTP Proxy Username) und HTTP-Proxy-Kennwort (HTTP Proxy Password) Benutzernamen und Kennwort ein, die für die Verbindung mit Ihrem HTTP-Proxy verwendet werden sollen.

Hinweis

Bei Bereitstellung von Verwaltungsclustern mithilfe der Benutzeroberfläche des Installationsprogramms können bei Kennwörtern keine nicht alphanumerischen Zeichen verwendet werden.

- Geben Sie unter HTTP-Proxy-URL (HTTP Proxy URL) die URL des Proxys ein, der HTTP-Anforderungen verarbeitet. Die URL muss mit

-

So fügen Sie Ihre HTTPS-Proxy-Informationen hinzu:

- Wenn Sie dieselbe URL sowohl für HTTP- als auch für HTTPS-Datenverkehr verwenden möchten, wählen Sie Dieselbe Konfiguration für HTTPS-Proxy verwenden (Use the same configuration for https proxy) aus.

-

Wenn Sie eine andere URL für HTTPS-Datenverkehr verwenden möchten, gehen Sie wie folgt vor:

- Geben Sie unter HTTPS-Proxy-URL (HTTPS Proxy URL) die URL des Proxys ein, der HTTP-Anforderungen verarbeitet. Die URL muss mit

http://beginnen. Beispiel:http://myproxy.com:1234. -

Wenn der Proxy eine Authentifizierung erfordert, geben Sie unter HTTPS-Proxy-Benutzername (HTTPS Proxy Username) und HTTPS-Proxy-Kennwort (HTTP Proxy Password) Benutzernamen und Kennwort ein, die für die Verbindung mit Ihrem HTTP-Proxy verwendet werden sollen.

Hinweis

Bei Bereitstellung von Verwaltungsclustern mithilfe der Benutzeroberfläche des Installationsprogramms können bei Kennwörtern keine nicht alphanumerischen Zeichen verwendet werden.

- Geben Sie unter HTTPS-Proxy-URL (HTTPS Proxy URL) die URL des Proxys ein, der HTTP-Anforderungen verarbeitet. Die URL muss mit

-

Geben Sie unter Kein Proxy (No proxy) eine kommagetrennte Liste von Netzwerk-CIDRs oder Hostnamen ein, die den HTTP(S)-Proxy umgehen müssen. Wenn Ihr Verwaltungscluster im selben Netzwerk wie Ihre Infrastruktur hinter demselben Proxy ausgeführt wird, legen Sie dies auf Ihre Infrastruktur-CIDRs oder FQDNs fest, damit der Verwaltungscluster direkt mit der Infrastruktur kommuniziert.

Beispiel:

noproxy.yourdomain.com,192.168.0.0/24.- vSphere

-

Ihre Liste

Kein Proxy (No proxy) muss Folgendes enthalten:

- IP-Adresse oder Hostname für vCenter. Datenverkehr zu vCenter kann nicht per Proxy erfolgen.

- Das CIDR des vSphere-Netzwerks, das Sie unter Netzwerkname (Network Name) ausgewählt haben. Das vSphere-Netzwerk-CIDR, das die IP-Adresse Ihres Steuerungsebenen-Endpoints enthält. Wenn Sie unter Steuerungsebenen-Endpoint (Control Plane Endpoint) einen FQDN eingegeben haben, fügen Sie sowohl den FQDN als auch das vSphere Netzwerk-CIDR zu Kein Proxy (No proxy) hinzu. Intern hängt Tanzu Kubernetes Grid

localhost,127.0.0.1, die Werte von Cluster-Pod-CIDR (Cluster Pod CIDR) und Clusterdienst-CIDR (Cluster Service CIDR),.svcund.svc.cluster.localan die Liste an, die Sie in dieses Feld eingeben.

- AWS

-

Intern hängt Tanzu Kubernetes Grid

localhost,127.0.0.1, Ihr VPC-CIDR, Cluster-Pod-CIDR (Cluster Pod CIDR) und Clusterdienst-CIDR (Cluster Service CIDR),.svc,.svc.cluster.localund169.254.0.0/16an die Liste an, die Sie in dieses Feld eingeben. - Azure

-

Intern hängt Tanzu Kubernetes Grid

localhost,127.0.0.1, Ihr VNet-CIDR, Cluster-Pod-CIDR (Cluster Pod CIDR), und Clusterdienst-CIDR (Cluster Service CIDR),.svc,.svc.cluster.local,169.254.0.0/16und168.63.129.16an die Liste an, die Sie in dieses Feld eingeben.

Wichtig

Wenn die Verwaltungscluster-VMs mit externen Diensten und Infrastruktur-Endpoints in Ihrer Tanzu Kubernetes Grid-Umgebung kommunizieren müssen, stellen Sie sicher, dass diese Endpoints über die oben konfigurierten Proxys erreichbar sind, oder fügen Sie sie zu Kein Proxy (No proxy) hinzu. Je nach Konfiguration Ihrer Umgebung kann dafür unter anderem Folgendes erforderlich sein: Ihr OIDC- oder LDAP-Server, Harbor und im Fall von vSphere VMware NSX und NSX Advanced Load Balancer.

-

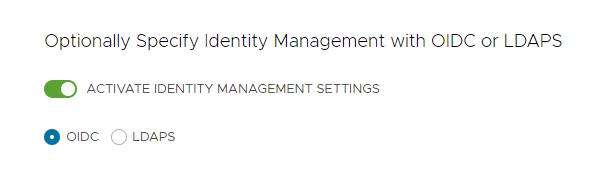

Konfiguration der Identitätsverwaltung

Dieser Abschnitt ist für alle Zielplattformen identisch. Informationen zur Implementierung der Identitätsverwaltung durch Tanzu Kubernetes Grid finden Sie unter Informationen zur Identitäts- und Zugriffsverwaltung.

-

Wählen Sie im Abschnitt Identitätsverwaltung (Identity Management) optional Identitätsverwaltungseinstellungen aktivieren (Activate Identity Management Settings).

Sie können die Identitätsverwaltung für Proof-of-Concept-Bereitstellungen deaktivieren. In Produktionsbereitstellungen wird jedoch dringend empfohlen, die Identitätsverwaltung zu implementieren. Wenn Sie die Identitätsverwaltung deaktivieren, können Sie sie später erneut aktivieren. Anweisungen zum erneuten Aktivieren der Identitätsverwaltung finden Sie unter Aktivieren und Konfigurieren der Identitätsverwaltung in einer vorhandenen Bereitstellung in Konfigurieren der Identitätsverwaltung.

-

Wenn Sie die Identitätsverwaltung aktivieren, wählen Sie OIDC oder LDAPS aus.

Wählen Sie unten die Registerkarte „OIDC“ oder „LDAPS“ aus, um die Konfigurationsinformationen anzuzeigen.

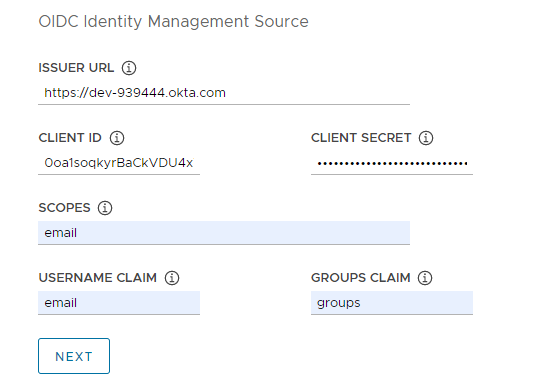

- OIDC

-

Geben Sie Details Ihres OIDC-Anbieterkontos an, z. B. Okta.

- Aussteller-URL (Issuer URL): Die IP- oder DNS-Adresse Ihres OIDC-Servers.

- Client-ID (Client ID): Der

client_id-Wert, den Sie von Ihrem OIDC-Anbieter erhalten. Ist Ihr Anbieter beispielsweise Okta, melden Sie sich bei Okta an, erstellen Sie eine Web-Anwendung und wählen Sie die Option Client-Anmeldedaten (Client Credentials) aus, um Werte fürclient_idundsecretzu erhalten. - Geheimer Clientschlüssel (Client Secret): Der

secret-Wert, den Sie von Ihrem OIDC-Anbieter erhalten. - Geltungsbereiche (Scopes): Eine kommagetrennte Liste mit zusätzlichen Geltungsbereichen, die in der Token-Antwort angefordert werden sollen. Beispiel:

openid,groups,email. - Benutzernamensanspruch (Username Claim): Der Name Ihres Benutzernamensanspruchs. Dies wird verwendet, um den Benutzernamen eines Benutzers im JWT-Anspruch (JSON-Web Token) festzulegen. Geben Sie je nach Anbieter Ansprüche wie

user_name,emailodercodeein. - Gruppenanspruch (Groups Claim): Der Name Ihres Gruppenanspruchs. Dies wird verwendet, um die Gruppe eines Benutzers im JWT-Anspruch festzulegen. Beispiel:

groups.

- LDAPS

-

Geben Sie Details zum LDAPS-Server Ihres Unternehmens an. Alle Einstellungen mit Ausnahme von

LDAPS-Endpoint (LDAPS Endpoint) sind optional.

- LDAPS-Endpoint (LDAPS Endpoint): Die IP- oder DNS-Adresse Ihres LDAPS-Servers. Geben Sie die Adresse und den Port des LDAP-Servers im Format

host:portan. - Bind-DN (Bind DN): Der DN für ein Anwendungsdienstkonto. Der Connector verwendet diese Anmeldedaten, um nach Benutzern und Gruppen zu suchen. Nicht erforderlich, wenn der LDAP-Server Zugriff für die anonyme Authentifizierung bereitstellt.

- Bind-Kennwort (Bind Password): Das Kennwort für ein Anwendungsdienstkonto, wenn Bind-DN (Bind DN) festgelegt ist.

Geben Sie die Attribute der Benutzersuche an.

- Basis-DN (Base DN): Der Punkt, von dem aus die LDAP-Suche gestartet werden soll. Beispiel:

OU=Users,OU=domain,DC=io. - Filter: Ein optionaler Filter, der von der LDAP-Suche verwendet werden soll.

- Benutzername (Username): Das LDAP-Attribut, das die Benutzer-ID enthält. Beispiel:

uid, sAMAccountName.

Geben Sie die Attribute der Gruppensuche an.

- Basis-DN (Base DN): Der Punkt, von dem aus die LDAP-Suche gestartet werden soll. Beispiel:

OU=Groups,OU=domain,DC=io. - Filter: Ein optionaler Filter, der von der LDAP-Suche verwendet werden soll.

- Namensattribut (Name Attribute): Das LDAP-Attribut, das den Namen der Gruppe enthält. Beispiel:

cn. - Benutzerattribut (User Attribute): Das Attribut des Benutzerdatensatzes, das als Wert des Mitgliedschaftsattributs des Gruppendatensatzes verwendet wird. Beispiel:

distinguishedName, dn. - Gruppenattribut (Group Attribute): Das Attribut des Gruppendatensatzes, das die Benutzer-/Mitgliedsinformationen enthält. Beispiel:

member.

Fügen Sie den Inhalt des CA-Zertifikats des LDAPS-Servers in das Textfeld Stamm-CA (Root CA) ein.

(Optional) Überprüfen Sie die LDAP-Einstellungen.

- Klicken Sie auf die Option LDAP-Konfiguration verifizieren (Verify LDAP Configuration).

-

Geben Sie einen Benutzernamen und einen Gruppennamen ein.

Hinweis

In Tanzu Kubernetes Grid v1.4.x und höher werden diese Felder ignoriert und auf

cnfür den Benutzernamen undoufür den Gruppennamen zurückgesetzt. Updates zu diesem bekannten Problem finden Sie in den Versionshinweisen zu VMware Tanzu Kubernetes Grid 1.5. -

Klicken Sie auf Start.

Wenn nach Abschluss der Überprüfung Fehler angezeigt werden, müssen Sie diese in nachfolgenden Schritten genau überprüfen.

Hinweis

Der LDAP-Host führt diese Prüfung durch, nicht die Verwaltungsclusterknoten. Somit funktioniert Ihre LDAP-Konfiguration möglicherweise auch dann, wenn diese Überprüfung fehlschlägt.

- LDAPS-Endpoint (LDAPS Endpoint): Die IP- oder DNS-Adresse Ihres LDAPS-Servers. Geben Sie die Adresse und den Port des LDAP-Servers im Format

- Klicken Sie auf Weiter (Next), um zu Basisbetriebssystem-Image auswählen zu gelangen.

Basisbetriebssystem-Image auswählen

Verwenden Sie im Abschnitt Betriebssystem-Image (OS Image) das Dropdown-Menü, um die Image-Vorlagen des Betriebssystems und der Kubernetes-Version auszuwählen, die für die Bereitstellung von Tanzu Kubernetes Grid-VMs verwendet werden sollen, und klicken Sie auf Weiter (Next).

Erstellung von Auswahlmöglichkeiten für Basisbetriebssystem-Images

Das Dropdown-Menü Betriebssystem-Image (OS Image) enthält Betriebssystem-Images, die alle der folgenden Kriterien erfüllen:

- Das Image ist in Ihrem IaaS verfügbar.

- Für vSphere müssen Sie Images wie unter Basisimage-Vorlage in vSphere importieren beschrieben importieren. Sie können jetzt ein Image importieren, ohne die Benutzeroberfläche des Installationsprogramms zu beenden. Verwenden Sie nach dem Import die Schaltfläche „Aktualisieren (Update)“, damit das Image im Dropdown-Menü angezeigt wird.

- Für Azure müssen Sie die Lizenz akzeptieren, wie unter Akzeptieren der Lizenz für das Basisimage in Vorbereitung zum Bereitstellen von Verwaltungsclustern auf Microsoft Azure beschrieben.

- Das Betriebssystem-Image ist in der Stücklistendatei (BoM) des Tanzu Kubernetes-Release (TKr) für die Kubernetes-Version aufgeführt, auf der der Verwaltungscluster ausgeführt wird.

- Tanzu Kubernetes Grid v2.2-Verwaltungscluster werden auf Kubernetes v1.25.7 ausgeführt.

- Um ein benutzerdefiniertes Image zu verwenden, ändern Sie die BoM-Datei des TKr, damit das Image aufgelistet wird, wie in Erstellen von Maschinen-Images erläutert.

- vSphere-, AWS- und Azure-Images werden in den Blöcken

ova,amiundazureder BoM aufgelistet.

- Der Image-Name im IaaS stimmt mit seinem Bezeichner in der TKr-BoM überein:

- vSphere-, AWS- und Azure-Images werden durch die Feldwerte

version,idbzw.skuidentifiziert.

- vSphere-, AWS- und Azure-Images werden durch die Feldwerte

Bereitstellung finalisieren

Dieser Abschnitt ist für alle Zielplattformen identisch.

-

Deaktivieren Sie im Abschnitt Teilnahme an CEIP (CEIP Participation) optional das Kontrollkästchen, um nicht am Programm zur Verbesserung der Benutzerfreundlichkeit von VMware teilzunehmen. Klicken Sie anschließend auf Weiter (Next).

Sie können das Programm auch nach der Bereitstellung des Verwaltungsclusters aktivieren bzw. deaktivieren. Informationen zu CEIP finden Sie unter Teilnahme an CEIP verwalten und https://www.vmware.com/solutions/trustvmware/ceip.html.

-

Klicken Sie auf Konfiguration überprüfen (Review Configuration), um die Details des von Ihnen konfigurierten Verwaltungsclusters anzuzeigen. Wenn Sie zum Installationsassistenten zurückkehren möchten, um Ihre Konfiguration zu ändern, klicken Sie auf Konfiguration bearbeiten (Edit Configuration).

Wenn Sie auf Konfiguration bearbeiten (Edit Configuration) klicken, füllt das Installationsprogramm die Clusterkonfigurationsdatei, die sich im Unterverzeichnis

~/.config/tanzu/tkg/clusterconfigsbefindet, mit den Einstellungen auf, die Sie in der Benutzeroberfläche angegeben haben. Sie können optional eine Kopie dieser Konfigurationsdatei exportieren, indem Sie auf Konfiguration exportieren (Export Configuration) klicken. -

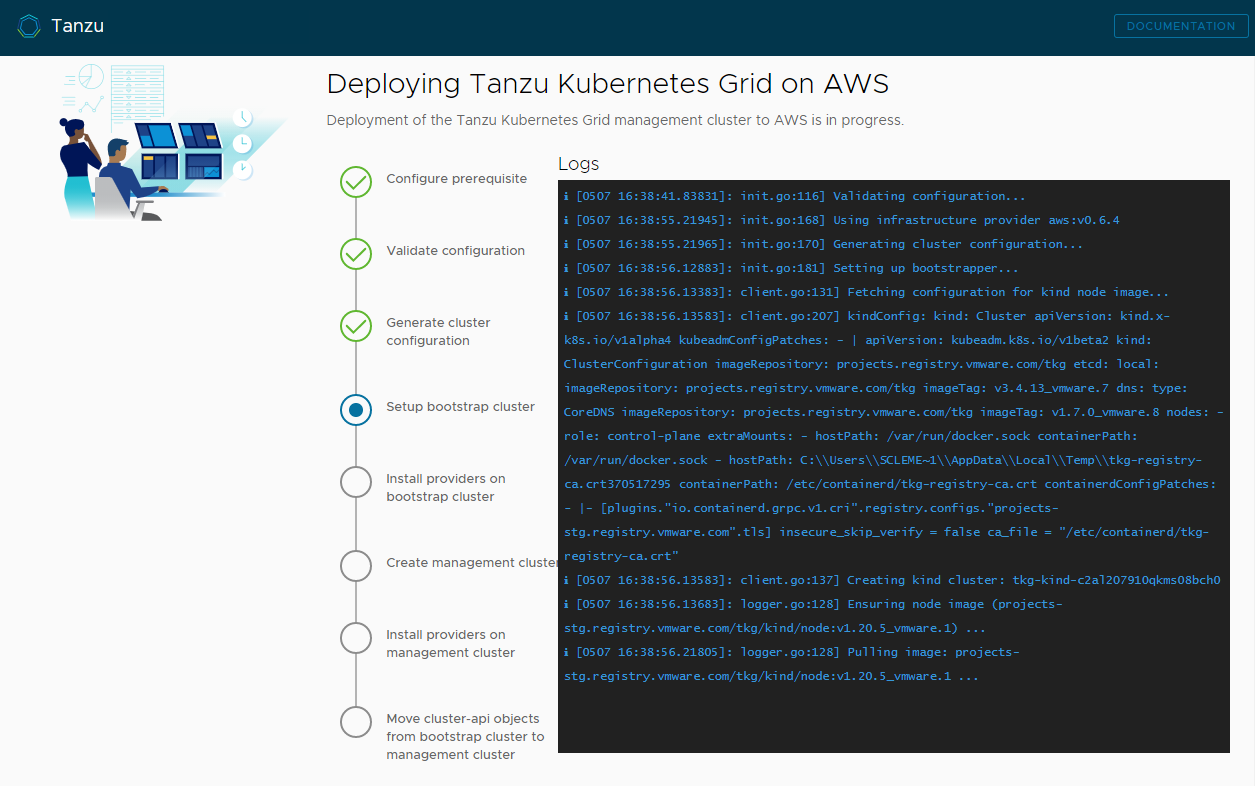

Klicken Sie auf Verwaltungscluster bereitstellen (Deploy Management Cluster).

Die Bereitstellung des Verwaltungsclusters kann einige Minuten dauern. Die erste Ausführung von

tanzu mc createdauert länger als nachfolgende Ausführungen, da die erforderlichen Docker-Images in den Image-Speicher auf Ihrer Bootstrap-Maschine eingefügt werden müssen. Für nachfolgende Ausführungen ist dieser Schritt nicht erforderlich, daher erfolgen sie schneller. Sie können den Fortschritt der Bereitstellung des Verwaltungsclusters in der Benutzeroberfläche des Installationsprogramms oder über das Terminal verfolgen, in dem Sietanzu mc create --uiausgeführt haben. Wenn die Maschine, auf der Sietanzu mc createausführen, vor Abschluss der lokalen Vorgänge heruntergefahren oder neu gestartet wird, schlägt die Bereitstellung fehl. Wenn Sie den Browser oder die Browserregisterkarte, in dem/der die Bereitstellung ausgeführt wird, versehentlich vor Beendigung der Bereitstellung schließen, wird diese im Terminal fortgesetzt.

-

(Optional) Klicken Sie unter Gleichwertiger CLI-Befehl (CLI Command Equivalent) auf die Schaltfläche Kopieren (Copy), um den CLI-Befehl für die angegebene Konfiguration zu kopieren. Dieser CLI-Befehl enthält den Pfad zur Konfigurationsdatei, die vom Installationsprogramm aufgefüllt wird.

-

(Nur vSphere) Nachdem Sie einen Verwaltungscluster auf vSphere bereitstellen, müssen Sie die IP-Adressen der Knoten der Steuerungsebene als statisch konfigurieren, wie unter Konfigurieren von DHCP-Reservierungen für die Steuerungsebene (nur vSphere) beschrieben.

Nächste Schritte

- Speichern der Konfigurationsdatei: Das Installationsprogramm speichert die Konfiguration des Verwaltungsclusters unter

~/.config/tanzu/tkg/clusterconfigsmit einem generierten Dateinamen im FormatUNIQUE-ID.yaml. Diese Konfigurationsdatei verfügt über eine flache Struktur, die Variablen in Großbuchstaben mit Unterstrichen festlegt, z. B.CLUSTER_NAME. Nachdem die Bereitstellung abgeschlossen ist, können Sie den Namen der Konfigurationsdatei optional in einen aussagekräftigen Namen umbenennen und die Datei zur zukünftigen Verwendung an einem anderen Speicherort speichern. Das Installationsprogramm generiert auch eine klassenbasierte Kubernetes-Objektspezifikation im Kubernetes-Stil für das ObjektClusterdes Verwaltungsclusters, das in einer Datei mit demselben Namen wie der Verwaltungscluster gespeichert wird. Diese klassenbasierte Objektspezifikation dient nur zu Informationszwecken. Die Bereitstellung von Verwaltungsclustern anhand einer klassenbasierten Objektspezifikation wird noch nicht unterstützt. Weitere Informationen zu Clustertypen in TKG 2.2 finden Sie unter Arbeitslasten in Informationen zu Tanzu Kubernetes Grid. - Konfiguration der Identitätsverwaltung: Wenn Sie die OIDC- oder LDAP-Identitätsverwaltung für den Verwaltungscluster aktiviert haben, müssen Sie nach der Bereitstellung die unter Abschließen der Konfiguration des Identitätsanbieters beschriebenen Schritte ausführen, um den Zugriff zu aktivieren.

- Registrieren Ihres Verwaltungsclusters bei Tanzu Mission Control: Wenn Sie Ihren Verwaltungscluster bei Tanzu Mission Control registrieren möchten, finden Sie weitere Informationen unter Registrieren Ihres Verwaltungsclusters bei Tanzu Mission Control.

- Bereitstellen von Arbeitslastclustern: Nachdem der Verwaltungscluster erstellt wurde, können Sie Arbeitslastcluster wie unter Erstellen von Arbeitslastclustern in Erstellen und Verwalten von TKG 2.2-Arbeitslastclustern mit der Tanzu CLI beschrieben bereitstellen.

- Bereitstellen eines weiteren Verwaltungsclusters: Informationen zum Bereitstellen mehrerer Verwaltungscluster auf vSphere, Azure und AWS finden Sie unter Verwalten Ihrer Verwaltungscluster. Dieses Thema enthält auch Informationen zum Hinzufügen vorhandener Verwaltungscluster zu Ihrer CLI-Instanz, zum Abrufen von Anmeldedaten, zum Skalieren und Löschen von Verwaltungsclustern, zum Hinzufügen von Namespaces und zur An- oder Abmeldung bei CEIP.

Informationen zu den Vorgängen während der Bereitstellung des Verwaltungsclusters sowie der Verbindung von kubectl mit dem Verwaltungscluster finden Sie unter Untersuchen und Registrieren eines neu bereitgestellten eigenständigen Verwaltungsclusters.