Les périphériques de stockage à mémoire non volatile (NVM) utilisant de la mémoire persistante sont de plus en plus répandus dans les centres de données. Pour se connecter à des périphériques NVM locaux et en réseau, ESXi utilise le protocole NVM Express (NVMe), un protocole normalisé conçu spécifiquement pour la communication à plusieurs files d'attente haute performance avec des périphériques NVM.

Concepts de VMware NVMe

Avant de commencer à utiliser le stockage NVMe dans l'environnement ESXi, découvrez les concepts de base de NVMe.

- NVM Express (NVMe)

- NVMe est une méthode de connexion et de transfert de données entre un hôte et un système de stockage cible. NVMe est conçu pour être utilisé avec un support de stockage plus rapide équipé d'une mémoire non volatile, tel que les périphériques Flash. Ce type de stockage peut atteindre une faible latence, une utilisation de CPU réduite et des performances élevées, il sert généralement d'alternative au stockage SCSI.

- Transports NVMe

- Le stockage NVMe peut être directement attaché à un hôte à l'aide d'une interface PCIe ou indirectement via différents transports d'infrastructure. VMware NVMe over Fabrics (NVMe-oF) fournit une connectivité à distance entre un hôte et un périphérique de stockage cible sur une baie de stockage partagée.

- Espaces de noms NVMe

- Dans la baie de stockage NVMe, un espace de noms est un volume de stockage soutenu par une quantité de mémoire non volatile. Dans le contexte d' ESXi, l'espace de noms est analogue à un périphérique de stockage ou LUN. Lorsque votre hôte ESXi découvre l'espace de noms NVMe, un périphérique Flash représentant l'espace de noms apparaît dans la liste des périphériques de stockage dans vSphere Client. Vous pouvez utiliser le terminal pour créer une banque de données et stocker des machines virtuelles.

- Contrôleurs NVMe

- Un contrôleur est associé à un ou plusieurs espaces de noms NVMe et fournit un chemin d'accès entre l'hôte ESXi et les espaces de noms de la baie de stockage. Pour accéder au contrôleur, l'hôte peut utiliser deux mécanismes : la découverte de contrôleur et la connexion au contrôleur. Pour plus d'informations, consultez Ajouter des contrôleurs pour NVMe over Fabrics.

- Découverte de contrôleur

- Avec ce mécanisme, l'hôte ESXi contacte d'abord un contrôleur de découverte. Le contrôleur de découverte renvoie une liste des contrôleurs disponibles. Après que vous sélectionnez un contrôleur auquel votre hôte peut accéder, tous les espaces de noms associés à ce contrôleur deviennent disponibles pour votre hôte.

- Connexion au contrôleur

- Votre hôte ESXi se connecte au contrôleur que vous spécifiez. Tous les espaces de noms associés à ce contrôleur deviennent disponibles pour votre hôte.

- Sous-système NVMe

- En général, un sous-système NVMe est une baie de stockage qui peut inclure plusieurs contrôleurs NVMe, plusieurs espaces de noms, un support de stockage de mémoire non volatile et une interface entre le contrôleur et le support de stockage de mémoire non volatile. Le sous-système est identifié par un nom qualifié NVMe (NQN) de sous-système.

- VMware High-Performance Plug-in (HPP)

- Par défaut, l'hôte ESXi utilise le HPP pour réclamer les cibles NVMe-oF. Lors de la sélection de chemins physiques pour les demandes d'E/S, le HPP applique un schéma PSS (Path Selection Schemes) approprié. Pour plus d'informations sur le HPP, reportez-vous à VMware High Performance Plug-In et Path Selection Schemes. Pour modifier le mécanisme de sélection de chemin par défaut, reportez-vous à Modification de la stratégie de sélection de chemin d'accès.

Architecture et composants de base de VMware NVMe

ESXi prend en charge le stockage local NVMe over PCIe et le stockage NVMe-oF partagé, tel que NVMe over Fibre Channel, NVMe over RDMA (RoCE v2) et NVMe over TCP.

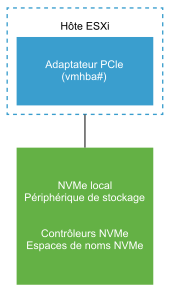

- VMware NVMe over PCIe

-

Dans cette configuration, votre hôte

ESXi utilise un adaptateur de stockage PCIe pour accéder à un ou plusieurs périphériques de stockage NVMe locaux. Après l'installation de l'adaptateur sur l'hôte, ce dernier découvre les périphériques NVMe disponibles et ceux-ci figurent sur la liste des périphériques de stockage dans

vSphere Client.

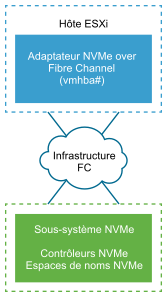

- VMware NVMe over Fibre Channel

-

Cette technologie mappe NVMe sur le protocole Fibre Channel pour permettre le transfert de données et de commandes entre un hôte et un périphérique de stockage cible. Ce transport peut utiliser une infrastructure Fibre Channel existante mise à niveau pour prendre en charge NVMe.

Pour accéder au stockage NVMe over Fibre Channel, installez un adaptateur de stockage Fibre Channel qui prend en charge NVMe sur votre hôte ESXi. Il n'est pas nécessaire de configurer l'adaptateur. Celui-ci se connecte automatiquement à un sous-système NVMe approprié et découvre tous les périphériques de stockage NVMe partagés qu'il peut atteindre. Vous pourrez ensuite reconfigurer l'adaptateur et déconnecter ses contrôleurs ou bien connecter d'autres contrôleurs qui n'étaient pas disponibles lors du démarrage de l'hôte. Pour plus d'informations, consultez Ajouter des contrôleurs pour NVMe over Fabrics.

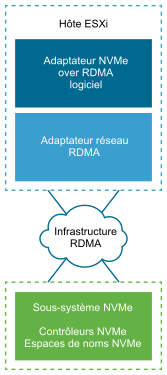

- NVMe over RDMA (RoCE v2)

-

Cette technologie utilise un transport d'accès direct à la mémoire à distance (RDMA) entre deux systèmes sur le réseau. Le transport permet l'échange de données dans la mémoire principale en contournant le système d'exploitation ou le processeur d'un système.

ESXi prend en charge la technologie RDMA over Converged Ethernet v2 (RoCE v2), ce qui permet un accès direct à la mémoire distante sur un réseau Ethernet.

Pour accéder au stockage, l'hôte ESXi utilise un adaptateur réseau RDMA installé sur votre hôte et un adaptateur de stockage NVMe over RDMA logiciel. Vous devez configurer les deux adaptateurs afin de les utiliser pour la découverte de stockage. Pour plus d'informations, consultez Configuration de NVMe over RDMA (RoCE v2) sur ESXi.

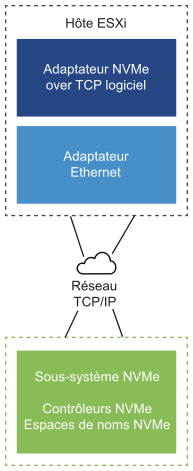

- NVMe over TCP

-

Cette technologie utilise des connexions Ethernet entre deux systèmes. Pour accéder au stockage, l'hôte ESXi utilise un adaptateur réseau installé sur votre hôte et un adaptateur logiciel de stockage NVMe over RDMA. Vous devez configurer les deux adaptateurs afin de les utiliser pour la découverte de stockage. Pour plus d'informations, consultez Configuration de NVMe over TCP sur ESXi.