クラウド管理者は、VMware Cloud Foundation スタックを使用して、GPU 対応のインフラストラクチャと AI/ML ワークロード ドメインを管理できます。VMware Aria Automation では、組織内のデータ サイエンティストと DevOps チームがセルフサービス Automation Service Broker カタログで申請できるカタログ アイテムとして、GPU 対応のディープ ラーニング仮想マシン (DL VM) および Tanzu Kubernetes Grid (TKG) クラスタをセットアップして提供できます。

VMware Private AI Foundation について

VMware Private AI Foundation with NVIDIA は、NVIDIA GPU を搭載した VMware Cloud Foundation に AI ワークロードをプロビジョニングするためのプラットフォームを提供します。また、NVIDIA GPU Cloud (NGC) コンテナに基づく AI ワークロードの実行は、VMware by Broadcom によって明確に検証されます。詳細については、VMware Private AI Foundation with NVIDIA についてを参照してください。

Private AI Automation Services は、VMware Aria Automation で使用可能な VMware Private AI Foundation のすべての機能の総称です。

Private AI Automation Services を開始するには、VMware Aria Automation でカタログのセットアップ ウィザードを実行します。このウィザードは、VMware Private AI Foundation を VMware Aria Automation に接続するのに役立ちます。

カタログ セットアップ ウィザードの仕組み

- クラウド アカウントを追加します。クラウド アカウントは、vCenter インスタンスからデータを収集し、リソースを展開するための認証情報です。

- NVIDIA ライセンスを追加します。

- Automation Service Broker カタログに追加するコンテンツを選択します。

- プロジェクトを作成します。プロジェクトにより、ユーザーがクラウド アカウント リージョンにリンクされます。これにより、ユーザーは、ネットワークおよびストレージ リソースを使用してクラウド テンプレートを vCenter インスタンスに展開できます。

- [AI Workstation] - 目的の vCPU、vGPU、メモリ、および AI/ML フレームワーク(PyTorch、CUDA Samples、TensorFlow など)を事前にインストールするオプションを使用して構成できる GPU 対応の仮想マシン。

- [AI RAG Workstation] - 取得拡張生成 (RAG) リファレンス ソリューションを持つ GPU 対応の仮想マシン。

- [Triton 推論サーバ] - Triton 推論サーバを持つ GPU 対応の仮想マシン。

- [AI Kubernetes クラスタ] - AI/ML クラウド ネイティブ ワークロードを実行するための GPU 対応のワーカー ノードを持つ VMware Tanzu Kubernetes Grid クラスタ。

- [AI Kubernetes RAG クラスタ] - リファレンス RAG ソリューションを実行するための GPU 対応のワーカー ノードを持つ VMware Tanzu Kubernetes Grid クラスタ。

ライセンスの変更など、指定した設定を変更する必要がある場合、または他のプロジェクトの AI カタログ アイテムを作成する場合は、ウィザードを複数回再度実行できます。ウィザードを実行するたびに、以前に作成したアイテムに加えて、5 つの新しいカタログ アイテムが作成されます。

組織の特定のニーズに合わせて、ウィザードが作成したカタログ アイテムのテンプレートを変更できます。

開始する前に

- VMware Aria Automation 8.18 を実行していることを確認します。

- vCenter 8.0 Update U2b 以降を含む VMware Cloud Foundation 5.1.1 以降を実行していることを確認します。

- VMware Aria Automation で vCenter クラウド アカウントが用意されていることを確認します。

- プレミアム クラウド サービス サブスクリプションを持つ NVIDIA GPU Cloud Enterprise 組織が用意されていることを確認します。

- ワークロード管理を介して GPU 対応のスーパーバイザー クラスタが構成されていることを確認します。.

- VMware Private AI Foundation with NVIDIA 用に VMware Aria Automation を構成します。VMware Private AI Foundation with NVIDIA 用の VMware Aria Automation の設定を参照してください。

- カタログのセットアップ ウィザードを実行する前に、VMware Cloud Foundation のクイックスタートを完了します。SDDC とスーパーバイザー クラスタは VMware Aria Automation に登録する必要があります。VMware Cloud Foundation クイックスタートを使用して VMware Aria Automation を開始する方法を参照してください。

- NVIDIA ライセンス サーバからクライアント構成トークンを生成したこと、および NVIDIA NGC ポータルの API キーがあることを確認します。NVIDIA NGC ポータルのアクセス キーは、vGPU ドライバのダウンロードとインストールに使用されます。

- クラウド使用量インターフェイス (CCI) のシングル サインオン (SSO) を構成します。CCI のシングル サインオンの設定を参照してください。

- コンテンツ ライブラリ (https://packages.vmware.com/dl-vm/lib.json) にサブスクライブしていることを確認します。

手順

- VMware Aria Automation をインストールして初めてログインした後、[クイックスタートの起動] をクリックします。

![[クイックスタートの起動] タイルが表示されたコンソール。](images/GUID-4D75F288-C411-4F5A-9FB7-8297D9ADE6B8-low.png)

- [Private AI Automation Services] カードの [起動] をクリックします。

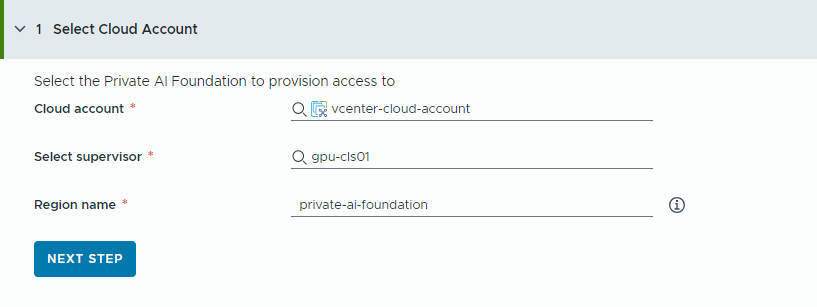

- アクセスをプロビジョニングするクラウド アカウントを選択します。

ここでのすべての値は、使用事例で使用されるサンプルです。アカウントの値は環境によって異なります。

- vCenter クラウド アカウントを選択します。

- GPU が有効なスーパーバイザーを選択します。

- リージョン名を入力します。

スーパーバイザーがすでにリージョンで構成されている場合は、リージョンが自動的に選択されます。

スーパーバイザーがリージョンに関連付けられていない場合は、この手順で追加します。ユーザーが GPU 対応のリージョンを他の使用可能なリージョンと区別するのに役立つ、地域のわかりやすい名前を使用することを検討してください。

- [次のステップ] をクリックします。

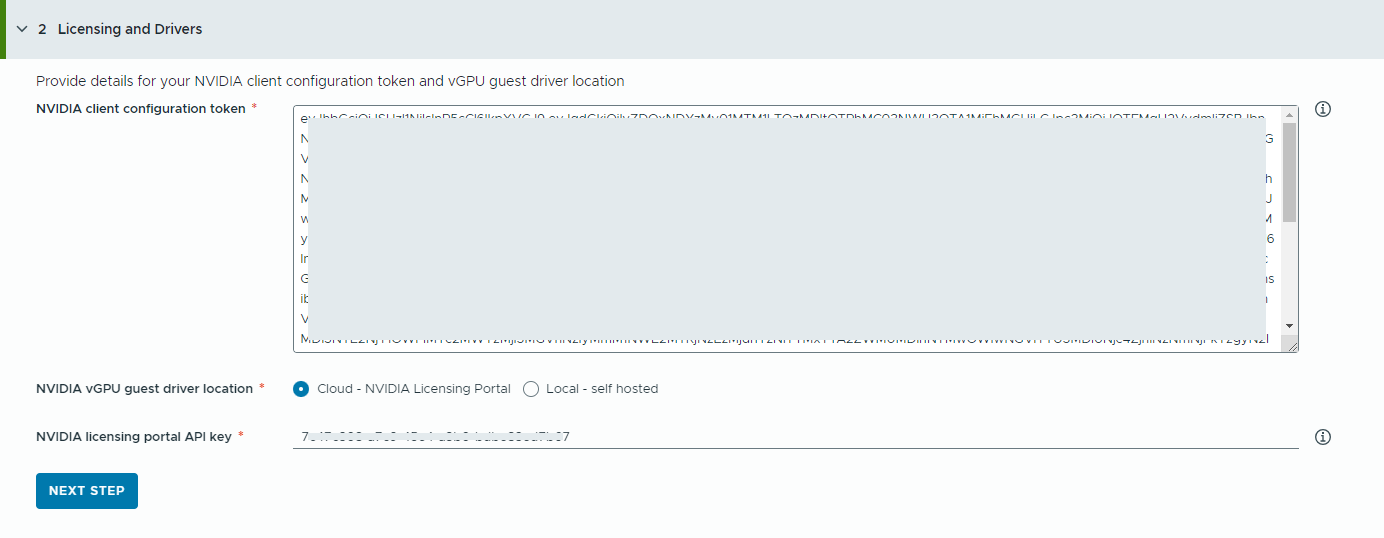

- NVIDIA ライセンス サーバに関する情報を指定します。

- NVIDIA クライアント構成トークンの内容をコピーして貼り付けます。

vGPU ドライバのすべての機能を有効にするには、クライアント構成トークンが必要です。

- NVIDIA vGPU ドライバの場所を選択します。

- クラウド - NVIDIA vGPU ドライバは NVIDIA Licensing Portal でホストされます。

NVIDIA Licensing Portal の API キーを指定する必要があります。このキーは、NVIDIA vGPU ドライバのダウンロードに適した資格がユーザーにあるかどうかを評価するために使用されます。API キーは UUID である必要があります。

注: NVIDIA Licensing Portal から生成する API キーは、NVAIE API キーと同じではありません。 - ローカル - NVIDIA vGPU ドライバはオンプレミスでホストされ、プライベート ネットワークからアクセスされます。

仮想マシンの vGPU ゲスト ドライバの場所を指定する必要があります。

エアギャップ環境の場合、プライベート ネットワークまたはデータセンターで vGPU ドライバを使用できる必要があります。

- クラウド - NVIDIA vGPU ドライバは NVIDIA Licensing Portal でホストされます。

- [次のステップ] をクリックします。

- NVIDIA クライアント構成トークンの内容をコピーして貼り付けます。

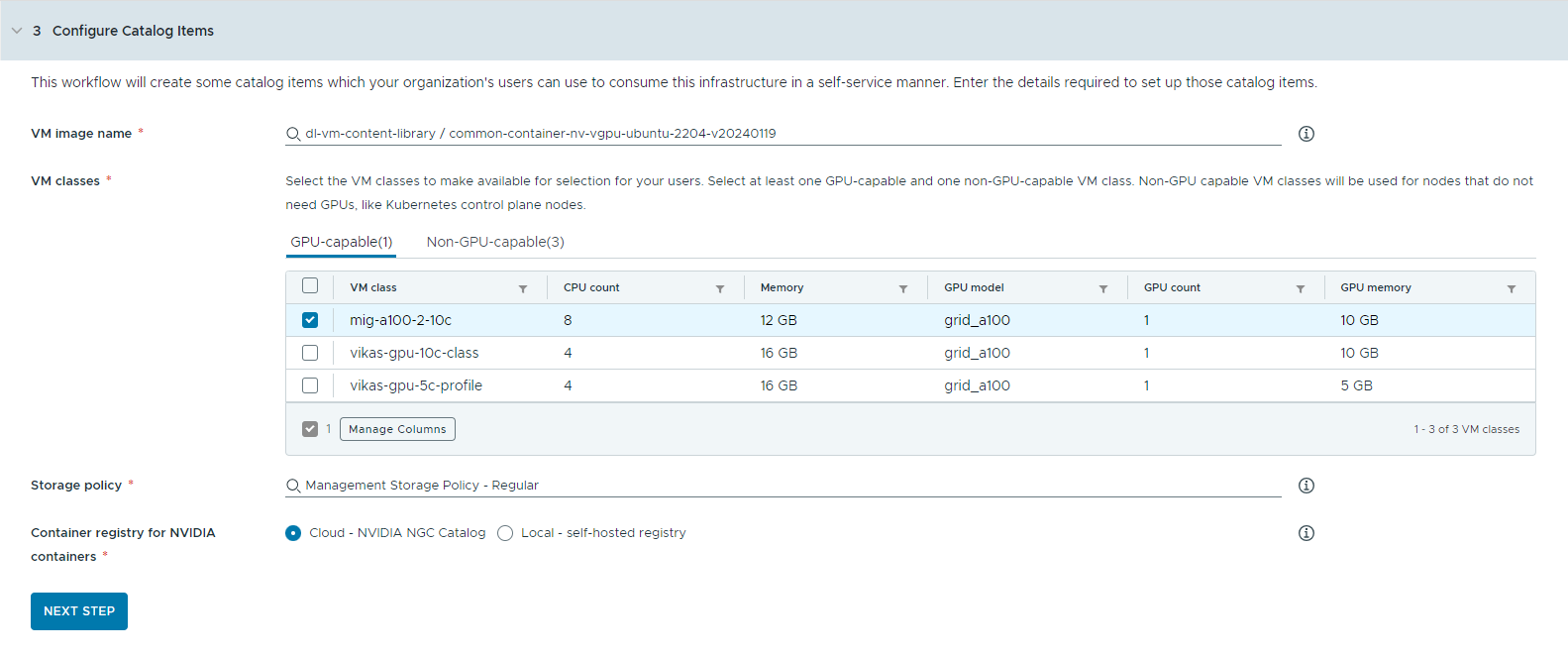

- カタログ アイテムを構成します。

- ディープ ラーニング仮想マシン イメージを含むコンテンツ ライブラリを選択します。

一度にアクセスできるコンテナ ライブラリは 1 つのみです。コンテンツ ライブラリに Kubernetes イメージが含まれている場合、それらのイメージは除外されます。

- ワークステーション仮想マシンの作成に使用する仮想マシン イメージを選択します。

- カタログ ユーザーが使用できるようにする仮想マシン クラスを選択します。

少なくとも 1 つの GPU 対応クラスと 1 つの非 GPU 対応クラスを追加する必要があります。

- GPU 対応の仮想マシン クラスは、ディープ ラーニング仮想マシンと TKG クラスタのワーカー ノードに使用されます。カタログ アイテムが展開されると、選択した仮想マシン クラスを使用して TKG クラスタが作成されます。

- Kubernetes 制御プレーンを実行するには、GPU 非対応ノードが必要です。

- 仮想マシンに適用するストレージ ポリシーを選択します。

- NVIDIA GPU Cloud リソースをプルするコンテナ レジストリを指定します。

- クラウド - コンテナ イメージは、NVIDIA NGC カタログからプルされます。

- ローカル - エアギャップ環境の場合、コンテナはプライベート レジストリからプルされます。

自己ホスト型レジストリの場所を指定する必要があります。レジストリで認証が必要な場合は、ログイン認証情報も指定する必要があります。

NVIDIA NGC カタログのコンテナ イメージのローカル レジストリとして Harbor を使用できます。「VMware Private AI Foundation with NVIDIA でのプライベート Harbor レジストリのセットアップ」を参照してください。

- (オプション)プロキシ サーバを構成します。

インターネットに直接アクセスできない環境では、プロキシ サーバを使用して vGPU ドライバをダウンロードし、非 RAG AI Workstation コンテナをプルします。

注: エアギャップ環境のサポートは、AI Workstation および Triton 推論サーバ カタログ アイテムで使用できます。AI RAG Workstation および AI Kubernetes クラスタ アイテムではエアギャップ環境がサポートされていないため、インターネット接続が必要です。 - [次のステップ] をクリックします。

- ディープ ラーニング仮想マシン イメージを含むコンテンツ ライブラリを選択します。

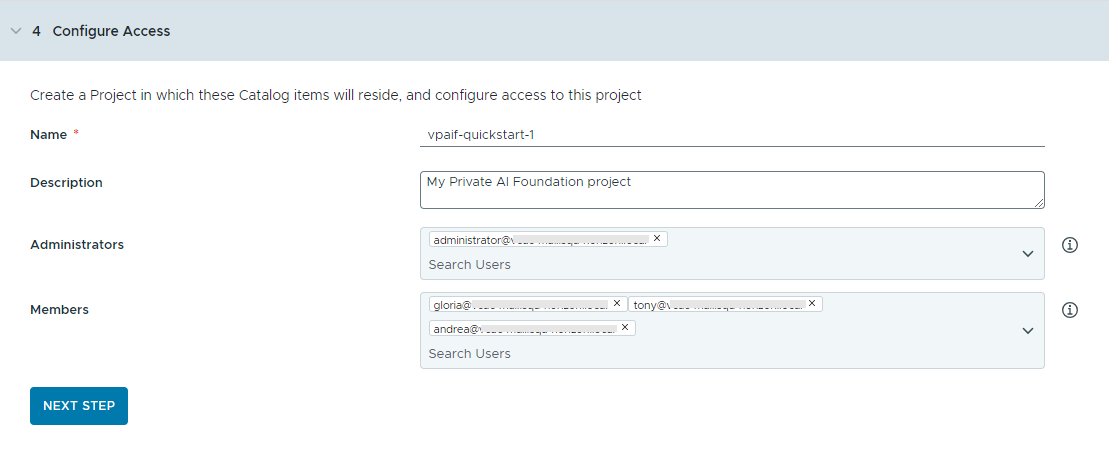

- プロジェクトを作成してユーザーを割り当てることで、カタログ アイテムへのアクセスを構成します。

プロジェクトは、ユーザー、割り当てられたリソース、クラウド テンプレート、および展開を管理するために使用されます。

- プロジェクトの名前と説明を入力します。

プロジェクト名には、小文字の英数字またはハイフン (-) のみを使用する必要があります。

- カタログ アイテムを他のユーザーが使用できるようにするには、[管理者] と [メンバー] を追加します。

管理者には、メンバーが持つ以上の権限があります。詳細については、VMware Aria Automation のユーザー ロールについてを参照してください。

- [次のステップ] をクリックします。

- プロジェクトの名前と説明を入力します。

- [サマリ] 画面で構成を確認します。

ウィザードを実行する前に、構成の詳細を保存することを検討してください。

- [クイックスタートを実行] をクリックします。

結果

5 つのカタログ アイテム([AI Workstation]、[AI RAG Workstation]、[Triton 推論サーバ]、[AI Kubernetes クラスタ]、[AI Kubernetes RAG クラスタ])が Automation Service Broker カタログに作成され、組織内のユーザーがそれらを展開できるようになりました。

![Private AI Foundation カタログ アイテムを含む Service Broker の [カタログ] 画面の表示。](images/GUID-7D415041-E729-444E-8065-74AAB5C852AA-low.png)

次の手順

- コンテンツを共有している選択されたプロジェクトのメンバーがカタログからテンプレートを使用できることを確認し、プロビジョニング プロセスを監視して展開が正常に完了するようにします。PAIF カタログ アイテムを展開する方法を参照してください。

- 展開が存続できる期間を制御する場合は、リースを作成します。Automation Service Broker ポリシーの設定を参照してください。

- 申請時にユーザー入力を変更するには、カスタム フォームを作成します。Automation Service Broker のアイコンと申請フォームのカスタマイズを参照してください。

トラブルシューティング

- カタログのセットアップ ウィザードが失敗した場合は、別のプロジェクトに対してウィザードを再度実行します。