ESXi ホストのアダプタ構成プロセスでは、TCP ネットワーク アダプタの VMkernel バインドを設定してから、NVMe over TCP のソフトウェア アダプタを追加します。その後、NVMe コントローラを追加できます。

| アクション | 説明 |

|---|---|

| ESXi ホストに、NVMe over TCP テクノロジーをサポートするアダプタをインストールします。 | 例:i40en。 |

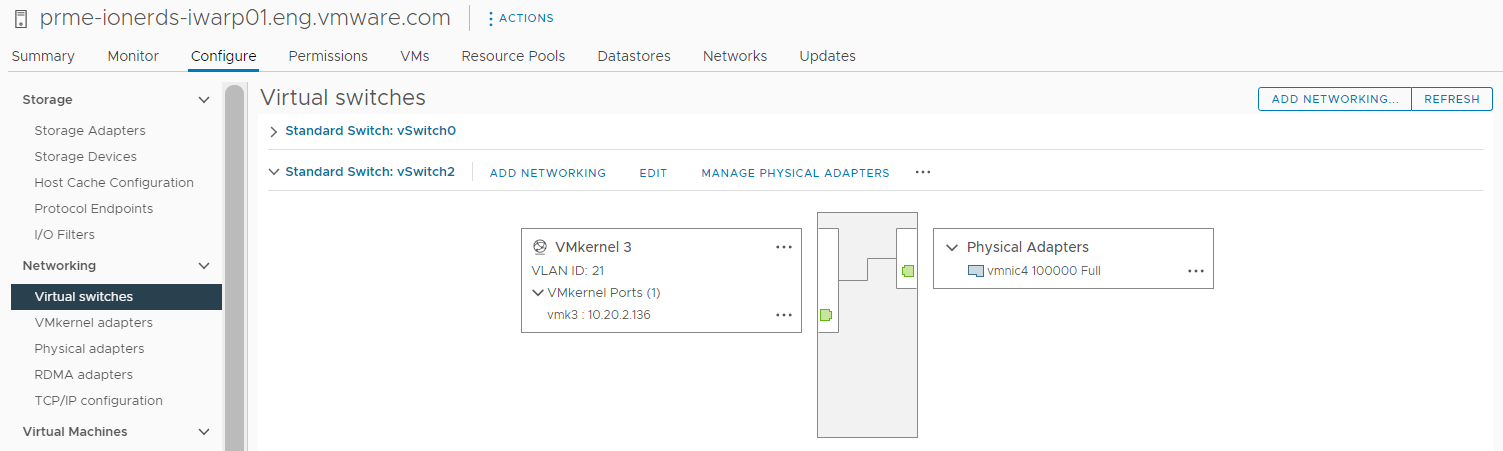

| NVMe over TCP アダプタの VMkernel バインドの構成 | NVMe over TCP で VMkernel バインドを行うには、仮想スイッチを作成し、物理ネットワーク アダプタと VMkernel アダプタを仮想スイッチに接続します。この接続を介して、TCP アダプタが VMkernel アダプタにバインドされます。この構成では、vSphere 標準スイッチまたは vSphere Distributed Switch を使用できます。 |

| ソフトウェア NVMe over TCP アダプタの追加 | vSphere Client を使用して、NVMe over TCP のソフトウェア ストレージ アダプタを有効にします。 |

| NVMe over Fabrics のコントローラの追加 | NVMe コントローラを追加するには、vSphere Client を使用します。コントローラを追加すると、コントローラに関連付けられている NVMe 名前空間を ESXi ホストで使用できるようになります。ESXi 環境内の名前空間を表す NVMe ストレージ デバイスが、ストレージ デバイス リストに表示されます。 |

NVMe over TCP アダプタの VMkernel バインドの構成

NVMe over TCP でポートのバインドを行うには、仮想スイッチを作成し、物理ネットワーク アダプタと VMkernel アダプタを仮想スイッチに接続します。この接続を介して、TCP アダプタが VMkernel アダプタにバインドされます。この構成では、vSphere 標準スイッチまたは vSphere Distributed Switch を使用できます。

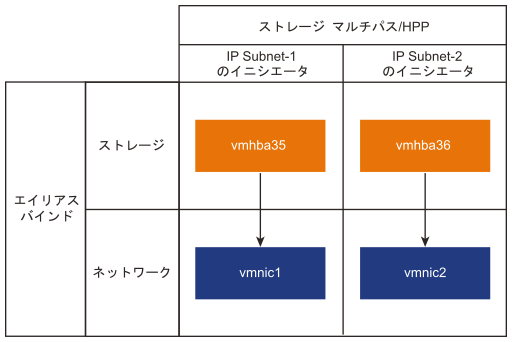

次の図は、NVMe over TCP アダプタのポート バインドを示しています。

スイッチの作成に関する詳細については、ドキュメント『vSphere のネットワーク』の「vSphere 標準スイッチの作成」または「vSphere Distributed Switch の作成」を参照してください。

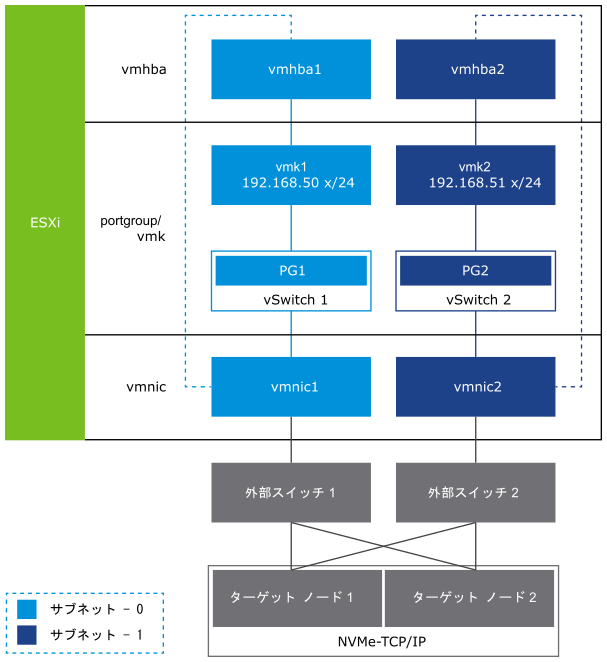

NVMe over TCP を使用したネットワーク トポロジの例

この例では、ホスト上の 2 つの vSphere 標準スイッチおよび 2 つのネットワーク アダプタ (vmnic) が高可用性を実現しています。これらは 2 つの外部スイッチに接続されています。

vSphere 標準スイッチを使用した TCP アダプタの VMkernel バインドの構成

vSphere 標準スイッチとスイッチごとに 1 つのアップリンクを使用して、TCP アダプタの VMkernel バインドを構成できます。ネットワーク接続の構成には、各物理ネットワーク アダプタへの仮想 VMkernel アダプタの作成が含まれます。各仮想および物理ネットワーク アダプタ間で 1:1 のマッピングを使用します。

手順

vSphere Distributed Switch を使用した TCP アダプタの VMkernel バインドの構成

vSphere Distributed Switch とスイッチごとに 1 つのアップリンクを使用して、TCP アダプタの VMkernel ポート バインドを構成できます。ネットワーク接続の構成には、各物理ネットワーク アダプタへの仮想 VMkernel アダプタの作成が含まれます。各仮想および物理ネットワーク アダプタ間で 1:1 のマッピングを使用します。

手順

次のタスク

ソフトウェア NVMe over RDMA または NVMe over TCP アダプタの追加

ESXi では、NVMe over RDMA および NVMe over TCP ソフトウェア アダプタがサポートされています。NVMe over RDMA または NVMe over TCP のソフトウェア ストレージ アダプタを追加するには、vSphere Client を使用します。

前提条件

- ESXi ホストに、次のタイプのストレージをサポートするアダプタをインストールします。

- NVMe over RDMA アダプタ。例:Mellanox Technologies MT27700 Family ConnectX-4。

- NVMe over TCP アダプタ。例:i40en。

- アダプタの VMkernel バインドを構成します。

- NVMe over RDMA の場合は、RDMA アダプタの VMkernel バインドの構成を参照してください。

- NVMe over TCP の場合は、NVMe over TCP アダプタの VMkernel バインドの構成を参照してください。

手順

結果

NVMe over Fabrics のコントローラの追加

NVMe コントローラを追加するには、vSphere Client を使用します。コントローラを追加すると、コントローラに関連付けられている NVMe 名前空間を ESXi ホストで使用できるようになります。ESXi 環境内の名前空間を表す NVMe ストレージ デバイスが、ストレージ デバイス リストに表示されます。

前提条件

- 使用しているストレージのタイプに適したアダプタが ESXi ホストにあることを確認してください。VMware NVMe ストレージの要件を参照してください。

- NVMe over RDMA (RoCE v2) ストレージを使用する場合は、次のタスクを実行します。

- NVMe over TCP ストレージを使用する場合は、次のタスクを実行します。

手順

- vSphere Client で、ESXi ホストに移動します。

- [設定] タブをクリックします。

- [ストレージ] で、[ストレージ アダプタ] をクリックし、設定するアダプタ (vmhba#) を選択します。

- [コントローラ] タブをクリックして、[コントローラの追加] をクリックします。

- [コントローラの追加] ダイアログ ボックスで、次のいずれかの検出方法を選択します。

オプション 説明 自動 このオプションは、ホストがコントローラを自動的に検出し、使用可能なコントローラへの接続を許可することを示します。 - コントローラを検出するための次のパラメータを指定します。

- NVMe over RDMA (RoCE v2) の場合は、IP アドレスと転送ポート番号。

- NVMe over TCP の場合は、IP アドレス、転送ポート番号、ダイジェスト パラメータ。

- [コントローラの検出] をクリックします。

- コントローラのリストから、使用するコントローラを選択します。

手動 この方法では、コントローラの詳細を手動で入力します。ホストは、指定されたパラメータを使用して特定のコントローラへの接続を要求します。 - サブシステム NQN

- ターゲット ポートの ID。

- NVMe over RDMA (RoCE v2) の場合は、IP アドレスと転送ポート番号(オプション)。

- NVMe over TCP の場合は、IP アドレス、転送ポート番号(オプション)、ダイジェスト パラメータ(オプション)。

- NVMe over Fibre Channel の場合は、WorldWideNodeName および WorldWidePortName。

- 管理キューのサイズ。コントローラの管理キューのサイズを指定するオプションのパラメータ。デフォルト値は 16 です。

- キープアライブ タイムアウト。アダプタとコントローラ間のキープ アライブ タイムアウト値を秒単位で指定するオプションのパラメータ。デフォルトのタイムアウト値は 60 秒です。

注: I/O キュー サイズと I/O キュー番号は、 esxcli を使用した場合にのみ設定できるオプションのパラメータです。 - コントローラを検出するための次のパラメータを指定します。

結果

コントローラがコントローラのリストに表示されます。これでホストは、コントローラに関連付けられている NVMe 名前空間を検出できるようになります。ESXi 環境内の名前空間を表す NVMe ストレージ デバイスが、vSphere Client のストレージ デバイス リストに表示されます。