ESXi ホストのアダプタ構成プロセスでは、RDMA ネットワーク アダプタの VMkernel バインドを設定してから、ソフトウェア NVMe over RDMA アダプタを追加します。その後、NVMe コントローラを追加できます。

| アクション | 説明 |

|---|---|

| RDMA ネットワーク アダプタの表示 | ESXi ホストで、RDMA (RoCE v2) をサポートするネットワーク アダプタをインストールします。例:Mellanox Technologies MT27700 Family ConnectX-4。 ネットワーク アダプタをインストールしたら、vSphere Client を使用して RDMA アダプタと物理ネットワーク アダプタを確認します。 |

| RDMA アダプタの VMkernel バインドの構成 | NVMe over RDMA でのポートのバインドを行うには、スイッチを作成し、物理ネットワーク アダプタと VMkernel アダプタをスイッチに接続する必要があります。この接続を介して、RDMA アダプタが VMkernel アダプタにバインドされます。この構成では、vSphere 標準スイッチまたは vSphere Distributed Switch を使用できます。 |

| ソフトウェア NVMe over RDMA アダプタの追加 | vSphere Client を使用して、NVMe over RDMA のソフトウェア ストレージ アダプタを有効にします。 |

| NVMe over Fabrics のコントローラの追加 | NVMe コントローラを追加するには、vSphere Client を使用します。コントローラを追加すると、コントローラに関連付けられている NVMe 名前空間を ESXi ホストで使用できるようになります。ESXi 環境内の名前空間を表す NVMe ストレージ デバイスが、ストレージ デバイス リストに表示されます。 |

次のビデオでは、NVMe over RDMA アダプタを設定する手順について説明します。

RDMA ネットワーク アダプタの表示

RDMA (RoCE v2) をサポートするネットワーク アダプタを ESXi ホストにインストールした後、vSphere Client を使用して RDMA アダプタと物理ネットワーク アダプタを確認します。

手順

RDMA アダプタの VMkernel バインドの構成

NVMe over RDMA でのポートのバインドを行うには、スイッチを作成し、物理ネットワーク アダプタと VMkernel アダプタをスイッチに接続する必要があります。この接続を介して、RDMA アダプタが VMkernel アダプタにバインドされます。この構成では、vSphere 標準スイッチまたは vSphere Distributed Switch を使用できます。

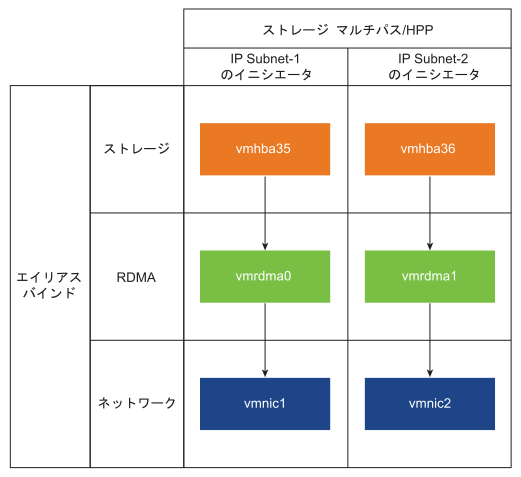

次の図は、NVMe over RDMA アダプタのポート バインドを示しています。

スイッチの作成に関する詳細については、ドキュメント『vSphere のネットワーク』の「vSphere 標準スイッチの作成」または「vSphere Distributed Switch の作成」を参照してください。

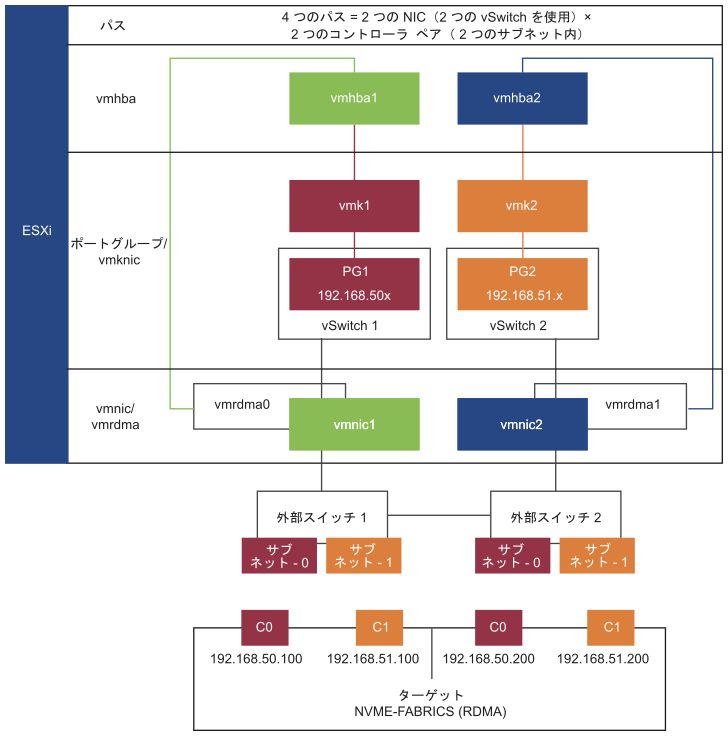

NVMe over RDMA を使用したネットワーク トポロジの例

この例では、2 台の vSphere 標準スイッチと 2 つのアップリンク(RDMA 対応 NIC)によって、高可用性を実現しています。これらは、2 つのサブネット内の 2 つのコントローラ ペアに接続されています。

複数の vSwitch と複数のアップリンク (RNIC) による高可用性

vSphere 標準スイッチを使用した VMkernel バインドの構成

vSphere 標準スイッチとスイッチごとに 1 つのアップリンクを使用して、RDMA アダプタの VMkernel ポート バインドを構成できます。ネットワーク接続の構成には、各物理ネットワーク アダプタへの仮想 VMkernel アダプタの作成が含まれます。各仮想および物理ネットワーク アダプタ間で 1:1 のマッピングを使用します。

手順

- VMkernel アダプタとネットワーク コンポーネントを使用して vSphere 標準スイッチを作成します。

- vSphere Client で、ホストを選択し、[ネットワーク] タブをクリックします。

- の順にクリックします。

- [VMkernel ネットワーク アダプタ] を選択し、[次へ] をクリックします。

- [新しい標準スイッチ] を選択し、[次へ] をクリックします。

- [割り当てられたアダプタ] で、[+] をクリックします。

使用可能な物理アダプタのリストが表示されます。

- 必要な物理アダプタ vmnic を選択し、[OK] をクリックします。

注: RDMA アダプタに対応する物理ネットワーク アダプタを選択します。RDMA アダプタ vmrdma と物理ネットワーク アダプタ vmnic との間の関連付けを確認するには、 RDMA ネットワーク アダプタの表示を参照してください。

- [VMkernel ポート設定] で、必要な値を入力します。

ストレージ パスに VLAN を使用している場合は、VLAN ID を入力します。

- [IP 設定] リストで、VMkernel IPv4 設定を入力します。

- [使用可能なサービス] で [NVMe over RDMA] を選択します。

- スイッチが正しく構成されていることを確認します。

- [構成] タブの [ネットワーク] の下で、[仮想スイッチ] を選択します。

- スイッチを展開し、構成を確認します。

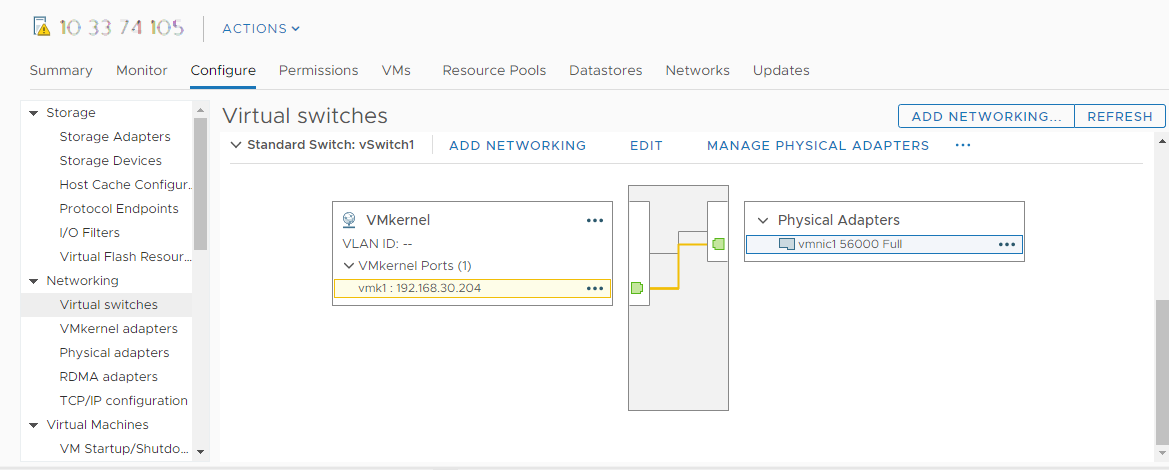

次の図は、物理ネットワーク アダプタと VMkernel アダプタが vSphere 標準スイッチに接続されていることを示しています。この接続を介して、RDMA アダプタが VMkernel アダプタにバインドされます。

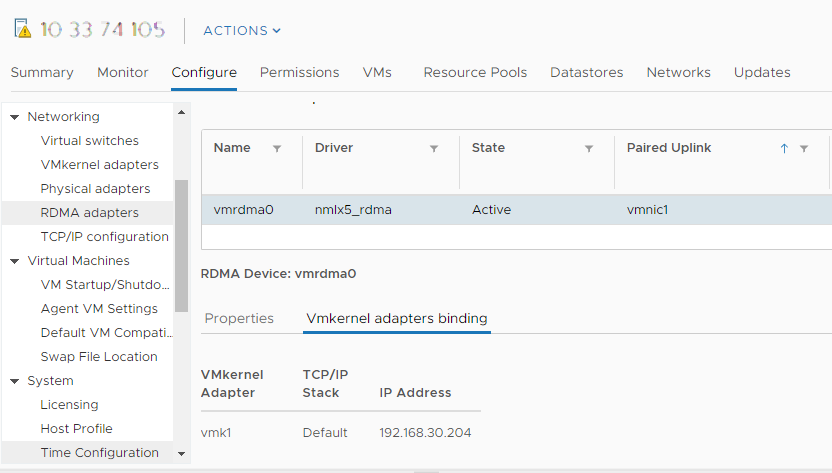

- RDMA アダプタの VMkernel バインドの構成を確認します。

- [ネットワーク] リストで [RDMA アダプタ] をクリックし、リストから RDMA アダプタを選択します。

- [VMkernel アダプタのバインド] タブをクリックして、関連する VMkernel アダプタがページに表示されることを確認します。

この例では、 vmrdma0 RDMA アダプタは vmnic1 ネットワーク アダプタとペアになっており、 vmk1 VMkernel アダプタに接続されています。

vSphere 標準スイッチと NIC チーミングを使用した VMkernel バインドの構成

vSphere 標準スイッチを NIC チーミング構成と共に使用して、RDMA アダプタの VMkernel ポート バインドを構成できます。NIC チーミングを使用すると、ネットワークの冗長性を実現できます。2 つ以上のネットワーク アダプタ (NIC) をチームとして構成し、高可用性とロード バランシングに使用します。

手順

vSphere Distributed Switch を使用した VMkernel バインドの構成

vSphere Distributed Switch とスイッチごとに 1 つのアップリンクを使用して、RDMA アダプタの VMkernel ポート バインドを構成できます。ネットワーク接続の構成には、各物理ネットワーク アダプタへの仮想 VMkernel アダプタの作成が含まれます。各仮想および物理ネットワーク アダプタ間で 1:1 のマッピングを使用します。

手順

- VMkernel アダプタとネットワーク コンポーネントを使用して vSphere Distributed Switch を作成します。

- vSphere Client で [データセンター] を選択し、[ネットワーク] タブをクリックします。

- [アクション] をクリックし、 の順に選択します。

- スイッチの名前を選択します。

データセンターの場所がホスト内にあることを確認して、 [次へ] をクリックします。

- 互換性のある ESXi バージョンを選択して、[次へ] をクリックします。

- 必要なアップリンク数を入力し、[終了] をクリックします。

- 1 台以上のホストを Distributed Switch に追加します。

- vSphere Client で [データセンター] を選択し、[Distributed Switch] をクリックします。

使用可能な DSwitch のリストが表示されます。

- DSwitch を右クリックし、メニューから [ホストの追加と管理] を選択します。

- [ホストの追加] を選択し、[次へ] をクリックします。

- ホストを選択して、[次へ] をクリックします。

- [アップリンクの割り当て] を選択します。

- vmnic に割り当てる適切なアップリンクを入力します。

- VMkernel アダプタを割り当てて、[次へ] をクリックします。

- vSphere Client で DSwitch を選択し、[ポート] タブをクリックします。

ここで、スイッチに対して作成されたアップリンクを確認できます。

- vSphere Client で [データセンター] を選択し、[Distributed Switch] をクリックします。

- NVMe over RDMA ストレージ パス用に分散ポート グループを作成します。

- vSphere Client で、必要な DSwitch を選択します。

- [アクション] をクリックし、 の順に選択します。

- [設定] で、ポート グループの全般プロパティを入力します。

特定の VLAN を構成済みの場合は、それを VLAN ID に追加します。注: VLAN を適切に構成しないと、ネットワーク接続の問題が発生する可能性があります。

- VMkernel アダプタを構成します。

- vSphere Client で、[DSwitch] リストを展開し、分散ポート グループを選択します。

- の順にクリックします。

- [メンバー ホストの選択] ダイアログ ボックスで、ホストを選択し、[OK] をクリックします。

- [VMkernel アダプタの設定] ダイアログ ボックスで、MTU がスイッチの MTU と一致していることを確認します。

- 適切にタグ付けするには、[使用可能なサービス] で [NVMe over RDMA] を選択します。

- [終了] をクリックします。

- RDMA 対応の複数の NIC を追加するには、手順 b と手順 c を繰り返します。

- 分散ポート グループの NIC チーミング ポリシーを設定します。

- [分散ポート グループ] で、 の順にクリックします。

- [チーミングおよびフェイルオーバー] をクリックし、アクティブなアップリンクを確認します。

- 1 つのアップリンクを [アクティブ] としてポート グループに割り当て、他のアップリンクを [未使用] として割り当てます。

作成された各ポート グループについて、手順 c を繰り返します。

次のタスク

ソフトウェア NVMe over RDMA または NVMe over TCP アダプタの追加

ESXi では、NVMe over RDMA および NVMe over TCP ソフトウェア アダプタがサポートされています。NVMe over RDMA または NVMe over TCP のソフトウェア ストレージ アダプタを追加するには、vSphere Client を使用します。

前提条件

- ESXi ホストに、次のタイプのストレージをサポートするアダプタをインストールします。

- NVMe over RDMA アダプタ。例:Mellanox Technologies MT27700 Family ConnectX-4。

- NVMe over TCP アダプタ。例:i40en。

- アダプタの VMkernel バインドを構成します。

- NVMe over RDMA の場合は、RDMA アダプタの VMkernel バインドの構成を参照してください。

- NVMe over TCP の場合は、NVMe over TCP アダプタの VMkernel バインドの構成を参照してください。

手順

結果

NVMe over Fabrics のコントローラの追加

NVMe コントローラを追加するには、vSphere Client を使用します。コントローラを追加すると、コントローラに関連付けられている NVMe 名前空間を ESXi ホストで使用できるようになります。ESXi 環境内の名前空間を表す NVMe ストレージ デバイスが、ストレージ デバイス リストに表示されます。

前提条件

- 使用しているストレージのタイプに適したアダプタが ESXi ホストにあることを確認してください。VMware NVMe ストレージの要件を参照してください。

- NVMe over RDMA (RoCE v2) ストレージを使用する場合は、次のタスクを実行します。

- NVMe over TCP ストレージを使用する場合は、次のタスクを実行します。

手順

- vSphere Client で、ESXi ホストに移動します。

- [設定] タブをクリックします。

- [ストレージ] で、[ストレージ アダプタ] をクリックし、設定するアダプタ (vmhba#) を選択します。

- [コントローラ] タブをクリックして、[コントローラの追加] をクリックします。

- [コントローラの追加] ダイアログ ボックスで、次のいずれかの検出方法を選択します。

オプション 説明 自動 このオプションは、ホストがコントローラを自動的に検出し、使用可能なコントローラへの接続を許可することを示します。 - コントローラを検出するための次のパラメータを指定します。

- NVMe over RDMA (RoCE v2) の場合は、IP アドレスと転送ポート番号。

- NVMe over TCP の場合は、IP アドレス、転送ポート番号、ダイジェスト パラメータ。

- [コントローラの検出] をクリックします。

- コントローラのリストから、使用するコントローラを選択します。

手動 この方法では、コントローラの詳細を手動で入力します。ホストは、指定されたパラメータを使用して特定のコントローラへの接続を要求します。 - サブシステム NQN

- ターゲット ポートの ID。

- NVMe over RDMA (RoCE v2) の場合は、IP アドレスと転送ポート番号(オプション)。

- NVMe over TCP の場合は、IP アドレス、転送ポート番号(オプション)、ダイジェスト パラメータ(オプション)。

- NVMe over Fibre Channel の場合は、WorldWideNodeName および WorldWidePortName。

- 管理キューのサイズ。コントローラの管理キューのサイズを指定するオプションのパラメータ。デフォルト値は 16 です。

- キープアライブ タイムアウト。アダプタとコントローラ間のキープ アライブ タイムアウト値を秒単位で指定するオプションのパラメータ。デフォルトのタイムアウト値は 60 秒です。

注: I/O キュー サイズと I/O キュー番号は、 esxcli を使用した場合にのみ設定できるオプションのパラメータです。 - コントローラを検出するための次のパラメータを指定します。

結果

コントローラがコントローラのリストに表示されます。これでホストは、コントローラに関連付けられている NVMe 名前空間を検出できるようになります。ESXi 環境内の名前空間を表す NVMe ストレージ デバイスが、vSphere Client のストレージ デバイス リストに表示されます。

![RDMA アダプタは vmrdma0 としてリストに表示されます。[ペアリングされたアップリンク] 列には、ネットワーク コンポーネントが vmnic1 として表示されます。](images/GUID-583E7E12-0BE6-44B4-A3A1-9EA4F7FB1BE8-low.png)