개발자가 TKGS 클러스터에 AI/ML 워크로드를 배포할 수 있도록 하려면 vSphere 관리자가 NVIDIA GPU 하드웨어를 지원하도록 vSphere with Tanzu 환경을 설정해야 합니다.

TKGS 클러스터에 AI/ML 워크로드를 배포하기 위한 vSphere 관리자 워크플로

| 단계 | 작업 | 연결 |

|---|---|---|

| 0 | 시스템 요구 사항을 검토합니다. |

관리자 0단계: 시스템 요구 사항 검토의 내용을 참조하십시오. |

| 1 | ESXi 호스트에 지원되는 NVIDIA GPU 디바이스를 설치합니다. |

관리자 1단계: ESXi 호스트에 지원되는 NVIDIA GPU 디바이스 설치의 내용을 참조하십시오. |

| 2 | vGPU 작업에 대한 ESXi 디바이스 그래픽 설정을 구성합니다. |

관리자 2단계: vGPU 작업을 위한 각 ESXi 호스트 구성의 내용을 참조하십시오. |

| 3 | 각 ESXi 호스트에 NVIDIA vGPU Manager(VIB)를 설치합니다. |

관리자 3단계: 각 ESXi 호스트에 NVIDIA 호스트 관리자 드라이버 설치의 내용을 참조하십시오. |

| 4 | NVIDIA 드라이버 작업 및 GPU 가상화 모드를 확인합니다. |

관리자 4단계: ESXi 호스트가 NVIDIA vGPU 작업을 수행할 준비가 되었는지 확인의 내용을 참조하십시오. |

| 5 | GPU 구성 클러스터에서 워크로드 관리를 사용하도록 설정합니다. 그러면 감독자 클러스터가 vGPU 지원 ESXi 호스트에서 실행됩니다. |

관리자 5단계: vGPU 구성 vCenter 클러스터에서 워크로드 관리 사용의 내용을 참조하십시오. |

| 6 | Tanzu Kubernetes 릴리스에 대한 컨텐츠 라이브러리를 생성* 또는 업데이트하고 라이브러리를 vGPU 워크로드에 필요한 지원되는 Ubuntu OVA로 채웁니다. |

관리자 6단계: Tanzu Kubernetes Ubuntu 릴리스로 컨텐츠 라이브러리 생성 또는 업데이트의 내용을 참조하십시오.

참고: *필요한 경우. TKGS 클러스터 Photon 이미지에 대한 컨텐츠 라이브러리가 이미 있는 경우 Ubuntu 이미지에 대한 새 컨텐츠 라이브러리를 생성하지 마십시오.

|

| 7 | 특정 vGPU 프로파일이 선택된 사용자 지정 VM 클래스를 생성합니다. |

관리자 7단계: vGPU 프로파일을 사용하여 사용자 지정 VM 클래스 생성 항목을 참조하십시오. |

| 8 | TKGS GPU 클러스터에 대한 vSphere 네임스페이스를 생성하고 구성합니다. 편집 권한이 있는 사용자와 영구 볼륨에 대한 스토리지를 추가합니다. |

관리자 8단계: TKGS GPU 클러스터에 대한 vSphere 네임스페이스 생성 및 구성 항목을 참조하십시오. |

| 9 | 컨텐츠 라이브러리를 Ubuntu OVA와 연결하고 vGPU에 대한 사용자 지정 VM 클래스를 TGKS용으로 생성한 vSphere 네임스페이스와 연결합니다. |

관리자 9단계: 컨텐츠 라이브러리 및 VM 클래스를 vSphere 네임스페이스와 연결 항목을 참조하십시오. |

| 10 | 감독자 클러스터가 프로비저닝되었고 클러스터 운영자가 액세스할 수 있는지 확인합니다. |

관리자 10단계: 감독자 클러스터에 액세스할 수 있는지 확인 항목을 참조하십시오. |

관리자 0단계: 시스템 요구 사항 검토

| 요구 사항 | 설명 |

|---|---|

| vSphere 인프라 |

vSphere 7 업데이트 3 월간 패치 1 ESXi 빌드 vCenter Server 빌드 |

| 워크로드 관리 |

vSphere 네임스페이스 버전

|

| 감독자 클러스터 |

감독자 클러스터 버전

|

| TKR Ubuntu OVA | Tanzu Kubernetes 릴리스 Ubuntu

|

| NVIDIA vGPU 호스트 드라이버 |

NGC 웹 사이트에서 VIB를 다운로드합니다. 자세한 내용은 vGPU 소프트웨어 드라이버 설명서를 참조하십시오. 예:

|

| vGPU용 NVIDIA 라이센스 서버 |

조직에서 제공한 FQDN |

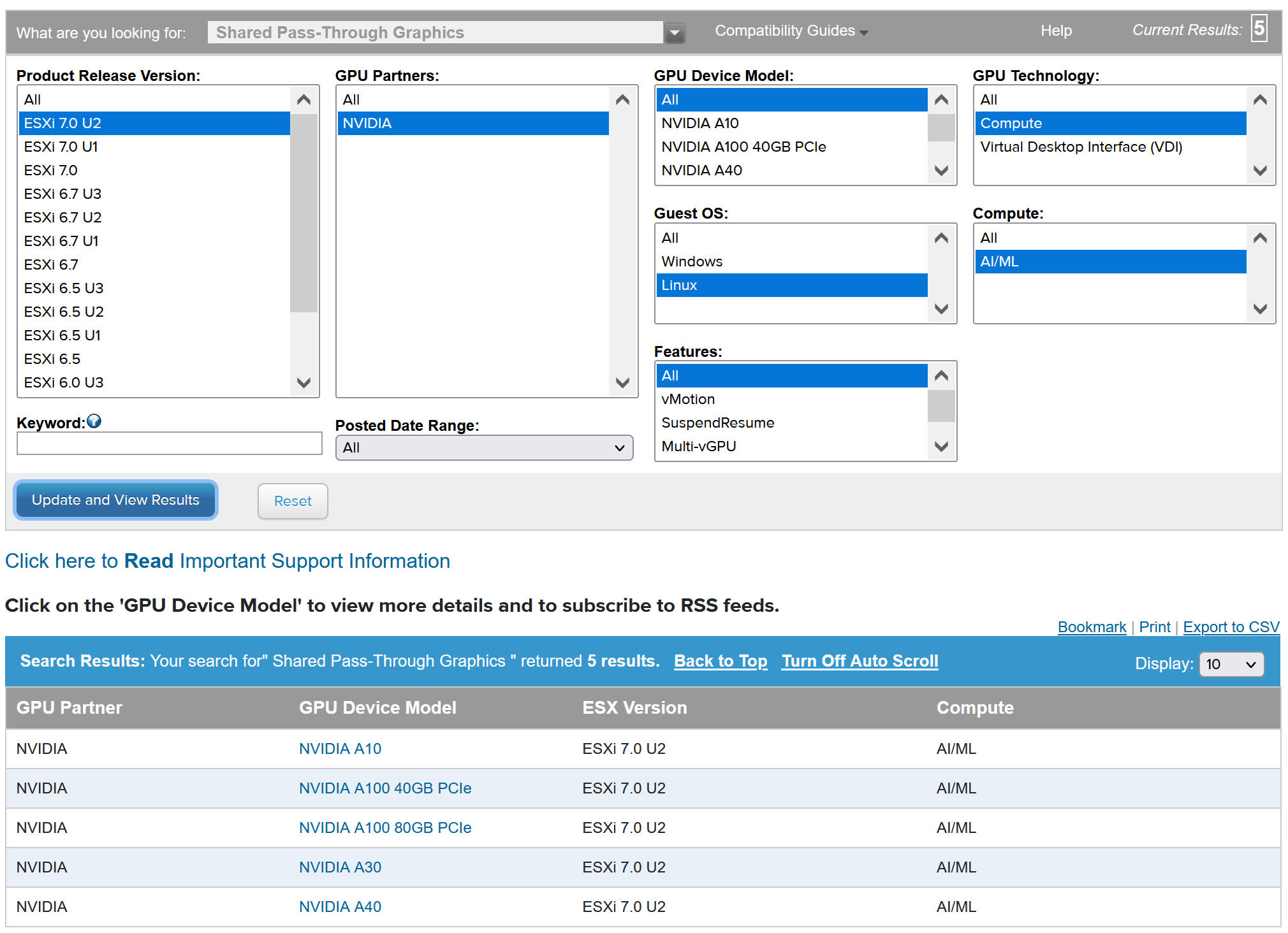

관리자 1단계: ESXi 호스트에 지원되는 NVIDIA GPU 디바이스 설치

TKGS에 AI/ML 워크로드를 배포하려면 워크로드 관리가 사용되도록 설정될 vCenter 클러스터를 구성하는 각 ESXi 호스트에 하나 이상의 지원되는 NVIDIA GPU 디바이스를 설치합니다.

호환되는 NVIDIA GPU 디바이스를 보려면 VMware 호환성 가이드를 참조하십시오.

NVIDA GPU 디바이스는 최신 NVAIE(NVIDIA AI Enterprise) vGPU 프로파일을 지원해야 합니다. 지침을 보려면 NVIDIA 가상 GPU 소프트웨어 지원 GPU 설명서를 참조하십시오.

예를 들어 다음 ESXi 호스트에는 두 개의 NVIDIA GPU A100 디바이스가 설치되어 있습니다.

![vSphere Client의 [그래픽 디바이스] 탭에 NVIDIA GPU A100 디바이스가 나열됩니다.](images/GUID-9F07693E-0109-4456-B0A6-3D9D1BA404D4-high.jpg)

관리자 2단계: vGPU 작업을 위한 각 ESXi 호스트 구성

Shared Direct 및 SR-IOV를 사용하도록 설정하여 vGPU에 대해 각 ESXi 호스트를 구성합니다.

각 ESXi 호스트에서 Shared Direct 사용

NVIDIA vGPU 기능의 잠금을 해제하려면 워크로드 관리가 사용되도록 설정될 vCenter 클러스터를 구성하는 각 ESXi 호스트에서 Shared Direct 모드를 사용하도록 설정합니다.

- vSphere Client를 사용하여 vCenter Server에 로그인합니다.

- vCenter 클러스터에서 ESXi 호스트를 선택합니다.

- 을 선택합니다.

- NVIDIA GPU 가속기 디바이스를 선택합니다.

- 그래픽 디바이스 설정을 편집합니다.

- Shared Direct를 선택합니다.

- X.Org 서버 다시 시작을 선택합니다.

- 확인을 클릭하여 구성을 저장합니다.

- ESXi 호스트를 마우스 오른쪽 버튼으로 클릭하고 유지 보수 모드로 전환합니다.

- 호스트를 재부팅합니다.

- 호스트가 다시 실행되면 호스트를 유지 보수 모드에서 해제합니다.

- 워크로드 관리가 사용되도록 설정될 vCenter 클러스터의 각 ESXi 호스트에 대해 이 프로세스를 반복합니다.

![Shared Direct 및 Restart X.Org 서버 옵션이 선택된 [그래픽 디바이스 설정 편집] 페이지입니다.](images/GUID-D3A546A5-7242-4515-A31A-A714BB93782E-high.jpg)

![vSphere Client의 [그래픽 디바이스] 탭에 Shared Direct 모드가 사용되도록 설정된 NVIDIA GPU A100 디바이스가 나열됩니다.](images/GUID-58CC6EEB-4538-48FB-B5C0-D1A98EF925A8-high.jpg)

NVIDIA GPU A30 및 A100 디바이스용 SR-IOV BIOS 켜기

다중 인스턴스 GPU(MIG 모드)에 필요한 NVIDIA A30 또는 A100 GPU 디바이스를 사용 중인 경우 ESXi 호스트에서 SR-IOV를 사용하도록 설정해야 합니다. SR-IOV를 사용하도록 설정하지 않으면 Tanzu Kubernetes 클러스터 노드 VM을 시작할 수 없습니다. 이 문제가 발생하면 워크로드 관리가 사용되도록 설정된 vCenter Server의 최근 작업 창에 다음과 같은 오류 메시지가 표시됩니다.

Could not initialize plugin libnvidia-vgx.so for vGPU nvidia_aXXX-xx. Failed to start the virtual machine. Module DevicePowerOn power on failed.

SR-IOV를 사용하도록 설정하려면 웹 콘솔을 사용하여 ESXi 호스트에 로그인합니다. 를 선택합니다. NVIDIA GPU 디바이스를 선택하고 SR-IOV 구성을 클릭합니다. 여기에서 SR-IOV를 켤 수 있습니다. 추가 지침은 vSphere 설명서에서 SR-IOV(Single Root I/O Virtualization)를 참조하십시오.

관리자 3단계: 각 ESXi 호스트에 NVIDIA 호스트 관리자 드라이버 설치

NVIDIA vGPU 그래픽 가속을 사용하여 Tanzu Kubernetes 클러스터 노드 VM을 실행하려면 워크로드 관리가 사용되도록 설정될 vCenter 클러스터를 구성하는 각 ESXi 호스트에 NVIDIA 호스트 관리자 드라이버를 설치합니다.

NVIDIA vGPU 호스트 관리자 드라이버 구성 요소는 VIB(vSphere 설치 번들)에 패키지됩니다. NVAIE VIB는 NVIDIA GRID 라이센싱 프로그램을 통해 조직에서 제공합니다. VMware는 NVAIE VIB를 제공하지 않으며 이에 대한 다운로드 서비스도 제공하지 않습니다. 조직에서는 NVIDIA 라이센싱 프로그램의 일부로 라이센싱 서버를 설정합니다. 자세한 내용은 NVIDIA 가상 GPU 소프트웨어 빠른 시작 가이드를 참조하십시오.

esxcli system maintenanceMode set --enable true esxcli software vib install -v ftp://server.domain.example.com/nvidia/signed/NVIDIA_bootbank_NVIDIA-VMware_ESXi_7.0_Host_Driver_460.73.02-1OEM.700.0.0.15525992.vib esxcli system maintenanceMode set --enable false /etc/init.d/xorg restart

관리자 4단계: ESXi 호스트가 NVIDIA vGPU 작업을 수행할 준비가 되었는지 확인

- SSH를 사용하여 ESXi 호스트에 연결하고 셸 모드로 전환한 후 명령

nvidia-smi를 실행합니다. NVIDIA 시스템 관리 인터페이스는 NVIDA vGPU 호스트 관리자가 제공하는 명령줄 유틸리티입니다. 이 명령을 실행하면 호스트에서 GPU 및 드라이버가 반환됩니다. - 다음 명령을 실행하여 NVIDIA 드라이버가 제대로 설치되었는지 확인합니다.

esxcli software vib list | grep NVIDA. - 호스트가 GPU Shared Direct로 구성되어 있고 SR-IOV가 켜져 있는지 확인합니다(NVIDIA A30 또는 A100 디바이스를 사용 중인 경우).

- GPU용으로 구성된 ESXi 호스트에서 vSphere Client를 사용하여 PCI 디바이스가 포함된 새 가상 시스템을 생성합니다. NVIDIA vGPU 프로파일이 표시되면서 선택 가능한 상태가 됩니다.

![NVIDIA vGPU 프로파일이 선택된 [하드웨어 사용자 지정] 탭입니다.](images/GUID-FDD9B658-B177-49D0-B9D3-A18FFF3D1116-high.jpg)

관리자 5단계: vGPU 구성 vCenter 클러스터에서 워크로드 관리 사용

이제 ESXi 호스트가 NVIDIA vGPU를 지원하도록 구성되었으므로 이러한 호스트로 구성된 vCenter 클러스터를 생성합니다. 워크로드 관리를 지원하려면 vCenter 클러스터가 공유 스토리지, 고가용성, 완전히 자동화된 DRS를 비롯한 특정 요구 사항을 충족해야 합니다.

또한 워크로드 관리를 사용하도록 설정하려면 네이티브 vSphere vDS 네트워킹 또는 NSX-T Data Center 네트워킹 중에서 하나의 네트워킹 스택을 선택해야 합니다. vDS 네트워킹을 사용하는 경우 NSX Advanced 또는 HAProxy 로드 밸런서를 설치해야 합니다.

| 작업 | 지침 |

|---|---|

| 워크로드 관리를 사용하도록 설정하기 위한 요구 사항을 충족하는 vCenter 클러스터 생성 | vSphere 클러스터에서 vSphere with Tanzu를 구성하기 위한 사전 요구 사항 |

| 감독자 클러스터, NSX-T 또는 로드 밸런서가 포함된 vDS에 대한 네트워킹 구성 | vSphere with Tanzu에 대한 NSX-T Data Center 구성. vSphere with Tanzu에 대한 vSphere 네트워킹 및 NSX Advanced Load Balancer 구성. |

| 워크로드 관리 사용 |

관리자 6단계: Tanzu Kubernetes Ubuntu 릴리스로 컨텐츠 라이브러리 생성 또는 업데이트

NVIDIA vGPU에는 Ubuntu 운영 체제가 필요합니다. VMware 이러한 목적으로 Ubuntu OVA를 제공합니다. vGPU 클러스터에는 PhotonOS Tanzu Kubernetes 릴리스를 사용할 수 없습니다.

| 컨텐츠 라이브러리 유형 | 설명 |

|---|---|

| 구독 컨텐츠 라이브러리를 생성하고 Ubuntu OVA를 환경과 자동으로 동기화합니다. | Tanzu Kubernetes 릴리스용 구독 컨텐츠 라이브러리 생성, 보안 및 동기화 |

| 로컬 컨텐츠 라이브러리를 생성하고 Ubuntu OVA를 환경에 수동으로 업로드합니다. | Tanzu Kubernetes 릴리스용 로컬 컨텐츠 라이브러리 생성, 보안 및 동기화 |

![Ubuntu의 [OVF 및 OVA 템플릿] 페이지에 컨텐츠 라이브러리에서 사용할 수 있는 Ubuntu OVA가 표시됩니다.](images/GUID-042D9891-0A32-40A7-A213-1D183CAB6315-high.jpg)

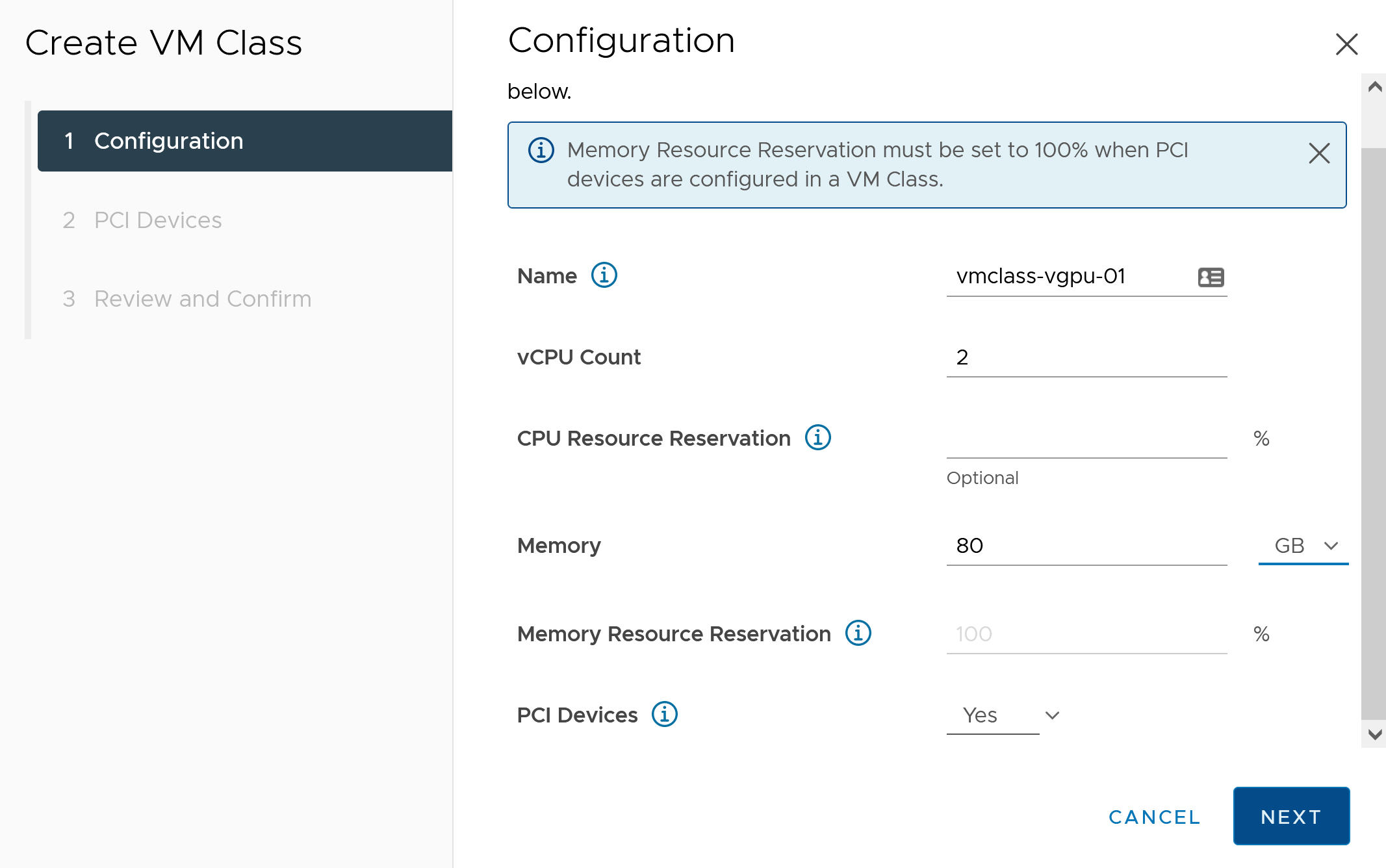

관리자 7단계: vGPU 프로파일을 사용하여 사용자 지정 VM 클래스 생성

다음 단계에서는 vGPU 프로파일을 사용하여 사용자 지정 VM 클래스를 생성합니다. 시스템에서는 Tanzu Kubernetes 클러스터 노드를 생성할 때 이 클래스 정의를 사용합니다.

- vSphere Client를 사용하여 vCenter Server에 로그온합니다.

- 워크로드 관리를 선택합니다.

- 서비스를 선택합니다.

- VM 클래스를 선택합니다.

- VM 클래스 생성을 클릭합니다.

- 구성 탭에서 사용자 지정 VM 클래스를 구성합니다.

구성 필드 설명 이름 사용자 지정 VM 클래스에 대한 자체 설명 이름을 입력합니다(예: vmclass-vgpu-1). vCPU 수 2 CPU 리소스 예약 선택 사항, 비워 둘 수 있음 메모리 예: 80GB 메모리 리소스 예약 100%(PCI 디바이스가 VM 클래스에 구성된 경우 필수) PCI 디바이스 예 참고: PCI 디바이스에 대해 [예]를 선택하면 GPU 디바이스를 사용 중임을 시스템에 알리고 vGPU 구성을 지원하도록 VM 클래스 구성이 변경됩니다.예:

- 다음을 클릭합니다.

- PCI 디바이스 탭에서 옵션을 선택합니다.

- NVIDIA vGPU 모델을 구성합니다.

NVIDIA vGPU 필드 설명 모델 메뉴에서 사용 가능한 NVIDIA GPU 하드웨어 디바이스 모델을 선택합니다. 시스템에 프로파일이 표시되지 않으면 클러스터의 어떤 호스트에도 지원되는 PCI 디바이스가 없는 것입니다. GPU 공유 이 설정은 GPU 디바이스가 GPU 지원 VM 간에 공유되는 방식을 정의합니다. vGPU 구현에는 시간 공유와 다중 인스턴스 GPU 공유의 두 가지 유형이 있습니다.

시간 공유 모드에서 vGPU 스케줄러는 vGPU 간에 성능을 밸런싱하는 최선의 목표로 일정 기간 동안 각 vGPU 지원 VM에 대해 직렬로 작업을 수행하도록 GPU에 지시합니다.

MIG 모드에서는 여러 vGPU 지원 VM을 단일 GPU 디바이스에서 병렬로 실행할 수 있습니다. MIG 모드는 최신 GPU 아키텍처를 기반으로 하며 NVIDIA A100 및 A30 디바이스에서만 지원됩니다. MIG 옵션이 표시되지 않으면 선택한 PCI 디바이스가 MIG 옵션을 지원하지 않는 것입니다.

GPU 모드 계산 GPU 메모리 예: 8GB vGPU 수 예: 1 예를 들어 시간 공유 모드로 구성된 NVIDIA vGPU 프로파일은 다음과 같습니다.

![시간 공유 모드에서 구성한 NVIDIA vGPU 프로파일이 있는 [PCI 디바이스] 탭입니다.](images/GUID-26039367-9949-4881-A354-8BC21EA341F5-high.jpg)

예를 들어 지원되는 GPU 디바이스에서 MIG 모드로 구성된 NVIDIA vGPU 프로파일은 다음과 같습니다.

![다중 인스턴스 GPU 공유 모드에서 구성한 NVIDIA vGPU 프로파일이 있는 [PCI 디바이스] 탭입니다.](images/GUID-3D1D77DF-F588-4B04-8F91-78BACB93CFD9-high.jpg)

- 다음을 클릭합니다.

- 선택 항목을 검토하고 확인합니다.

- 마침을 클릭합니다.

- 새 사용자 지정 VM 클래스를 VM 클래스 목록에서 사용할 수 있는지 확인합니다.

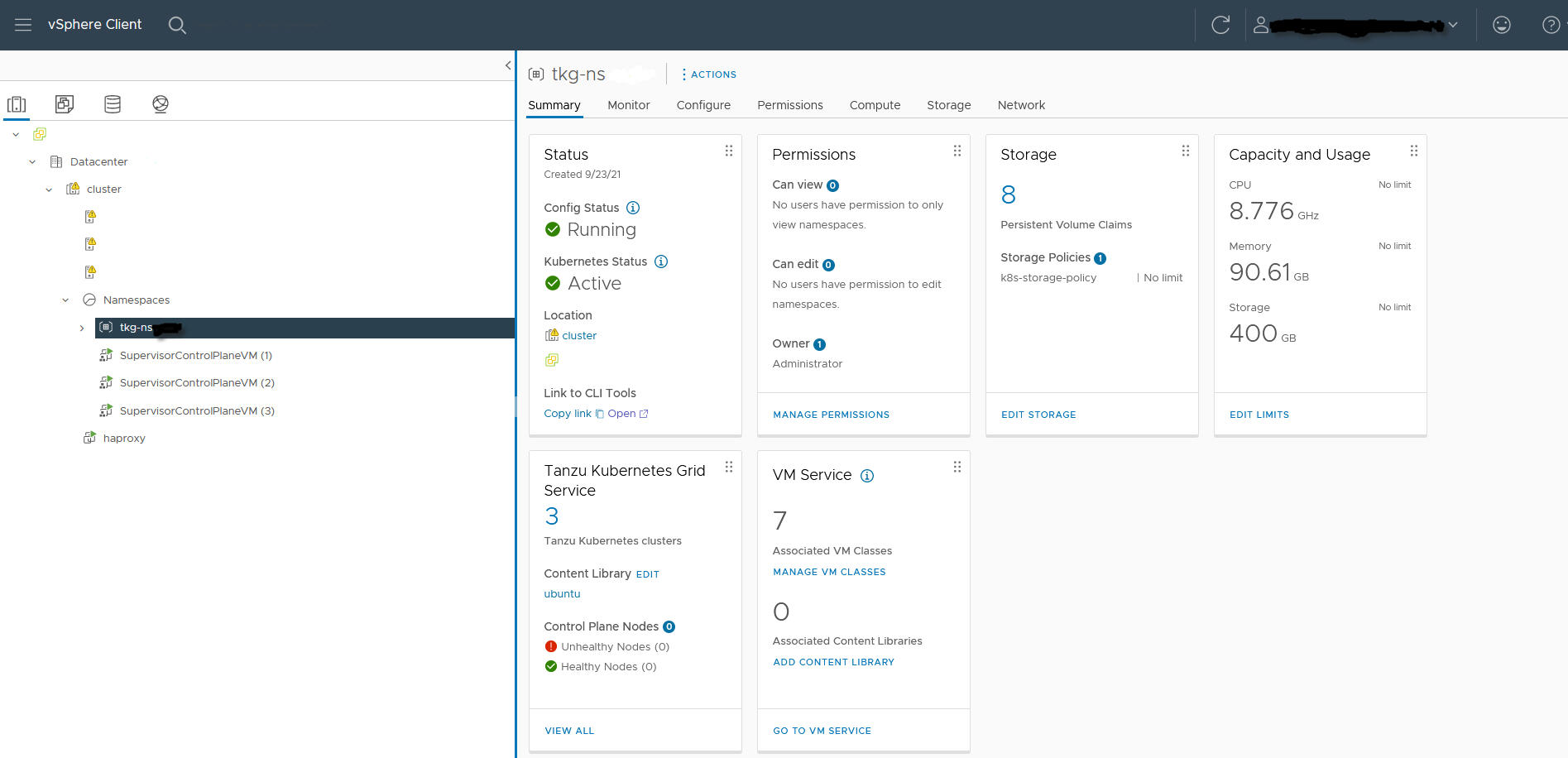

관리자 8단계: TKGS GPU 클러스터에 대한 vSphere 네임스페이스 생성 및 구성

프로비저닝할 각 TKGS GPU 클러스터에 대해 vSphere 네임스페이스를 생성합니다. 편집 권한이 있는 vSphere SSO 사용자를 추가하여 네임스페이스를 구성하고 영구 볼륨에 대한 스토리지 정책을 연결합니다.

이 작업을 수행하려면 vSphere 네임스페이스 생성 및 구성 항목을 참조하십시오.

관리자 9단계: 컨텐츠 라이브러리 및 VM 클래스를 vSphere 네임스페이스와 연결

| 작업 | 설명 |

|---|---|

| vGPU용 Ubuntu OVA를 포함하는 컨텐츠 라이브러리를 TKGS 클러스터를 프로비저닝할 vSphere 네임스페이스와 연결합니다. | Tanzu Kubernetes 릴리스에 대한 vSphere 네임스페이스 구성의 내용을 참조하십시오. |

| vGPU 프로파일을 포함하는 사용자 지정 VM 클래스를 TKGS 클러스터를 프로비저닝할 vSphere 네임스페이스와 연결합니다. | vSphere with Tanzu에서 VM 클래스를 네임스페이스와 연결의 내용을 참조하십시오. |

관리자 10단계: 감독자 클러스터에 액세스할 수 있는지 확인

마지막 관리 작업은 감독자 클러스터가 프로비저닝되었는지 그리고 클러스터 운영자가 AI/ML 워크로드에 대한 TKGS 클러스터를 프로비저닝하는 데 이를 사용할 수 있는지 확인하는 것입니다.

- vSphere에 대한 Kubernetes CLI 도구를 다운로드하고 설치합니다.

vSphere에 대한 Kubernetes CLI 도구 다운로드 및 설치의 내용을 참조하십시오.

- 감독자 클러스터에 연결합니다.

vCenter Single Sign-On 사용자로 감독자 클러스터에 연결의 내용을 참조하십시오.

- 클러스터 운영자에게 vSphere에 대한 Kubernetes CLI 도구를 다운로드할 수 있는 링크와 vSphere 네임스페이스의 이름을 제공합니다.

TKGS 클러스터에 AI/ML 워크로드를 배포하기 위한 클러스터 운영자 워크플로의 내용을 참조하십시오.