若要使開發人員能夠在 TKGS 叢集上部署 AI/ML 工作負載,vSphere 管理員應設定 vSphere with Tanzu 環境以支援 NVIDIA GPU 硬體。

在 TKGS 叢集上部署 AI/ML 工作負載的 vSphere 管理員工作流程

| 步驟 | 動作 | 連結 |

|---|---|---|

| 0 | 檢閱系統需求。 |

請參閱管理員步驟 0:檢閱系統需求。 |

| 1 | 在 ESXi 主機上安裝受支援的 NVIDIA GPU 裝置。 |

|

| 2 | 設定適用於 vGPU 操作的 ESXi 裝置圖形設定。 |

|

| 3 | 在每個 ESXi 主機上安裝 NVIDIA vGPU Manager (VIB)。 |

|

| 4 | 驗證 NVIDIA 驅動程式操作和 GPU 虛擬化模式。 |

|

| 5 | 在設定了 GPU 的叢集上啟用工作負載管理。這會產生在啟用了 vGPU 的 ESXi 主機上執行的主管叢集。 |

|

| 6 | 為 Tanzu Kubernetes 版本建立*或更新內容程式庫,並在程式庫中填入 vGPU 工作負載所需的受支援 Ubuntu OVA。 |

請參閱

管理員步驟 6:為 Tanzu Kubernetes Ubuntu 版本建立或更新內容程式庫。

備註: *如有必要。如果已為 TKGS 叢集 Photon 映像建立了內容程式庫,則無需為 Ubuntu 映像建立新的內容程式庫。

|

| 7 | 建立自訂虛擬機器類別並選取特定的 vGPU 設定檔。 |

|

| 8 | 為 TKGS GPU 叢集建立並設定 vSphere 命名空間:新增具有編輯權限的使用者,以及持續性磁碟區儲存區。 |

|

| 9 | 將包含 Ubuntu OVA 的內容程式庫和 vGPU 的自訂虛擬機器類別與您為 TGKS 建立的 vSphere 命名空間相關聯。 |

|

| 10 | 驗證主管叢集是否已佈建,以及是否可供叢集營運人員存取。 |

管理員步驟 0:檢閱系統需求

| 需求 | 說明 |

|---|---|

| vSphere 基礎結構 |

vSphere 7 Update3 Monthly Patch 1 ESXi 組建版本 vCenter Server 組建版本 |

| 工作負載管理 |

vSphere 命名空間版本

|

| 主管叢集 |

主管叢集 版本

|

| TKR Ubuntu OVA | Tanzu Kubernetes 版本 Ubuntu

|

| NVIDIA vGPU 主機驅動程式 |

從 NGC 網站下載 VIB。如需詳細資訊,請參閱 vGPU 軟體驅動程式說明文件。例如:

|

| 用於 vGPU 的 NVIDIA 授權伺服器 |

您的組織提供的 FQDN |

管理員步驟 1:在 ESXi 主機上安裝受支援的 NVIDIA GPU 裝置

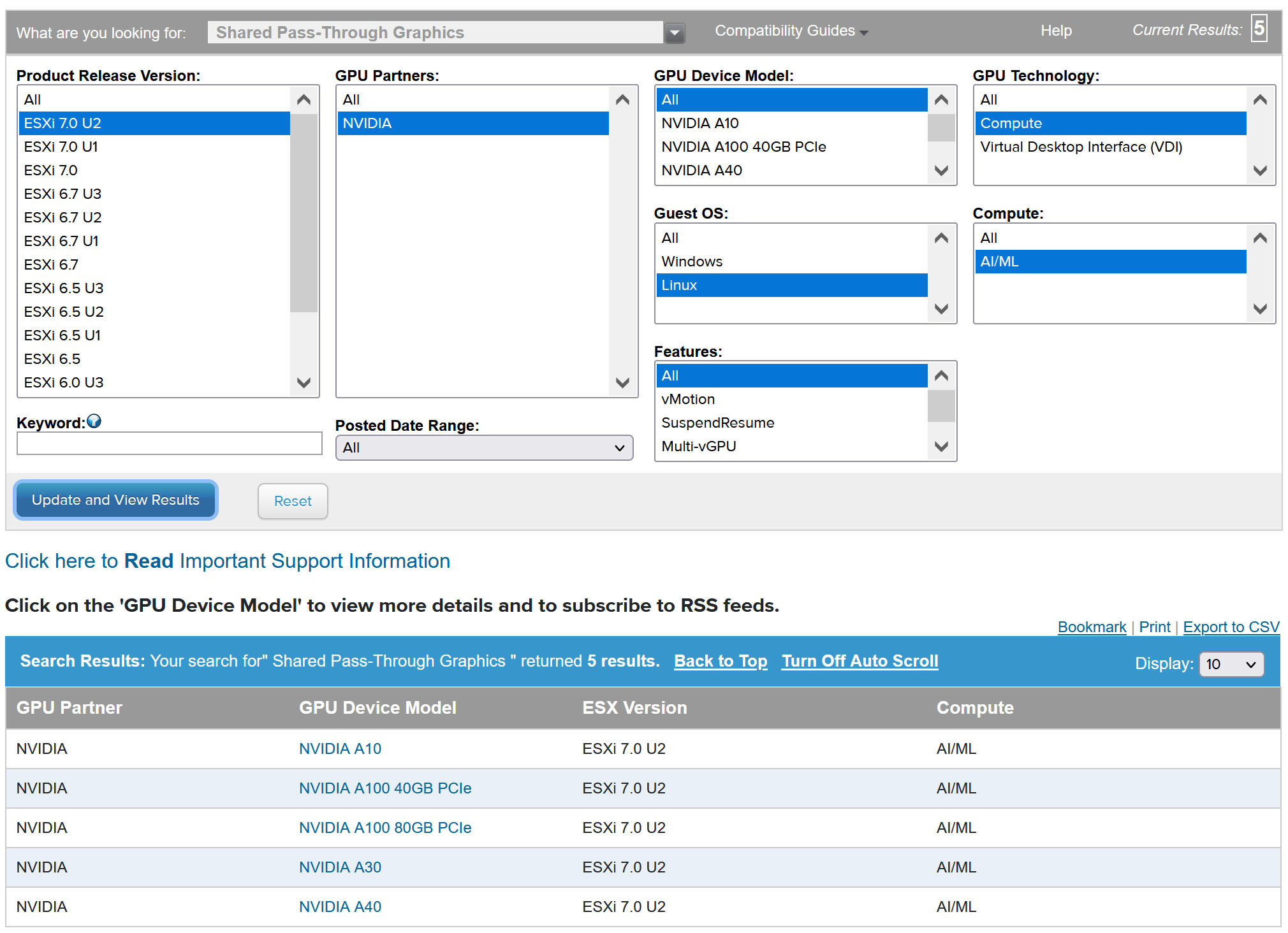

若要在 TKGS 上部署 AI/ML 工作負載,請在將啟用工作負載管理的 vCenter 叢集中的每個 ESXi 主機上安裝一或多個受支援的 NVIDIA GPU 裝置。

若要檢視相容的 NVIDIA GPU 裝置,請參閱《VMware 相容性指南》。

NVIDA GPU 裝置應支援最新的 NVIDIA AI Enterprise (NVAIE) vGPU 設定檔。如需相關指導,請參閱 NVIDIA 虛擬 GPU 軟體支援的 GPU 說明文件。

例如,以下 ESXi 主機上安裝了兩個 NVIDIA GPU A100 裝置。

![vSphere Client 中的 [圖形裝置] 索引標籤列出了 NVIDIA GPU A100 裝置。](images/GUID-9F07693E-0109-4456-B0A6-3D9D1BA404D4-high.jpg)

管理員步驟 2:針對 vGPU 操作設定每個 ESXi 主機

透過啟用 [直接共用] 和 SR-IOV,設定 vGPU 的每個 ESXi 主機。

在每個 ESXi 主機上啟用直接共用

若要解除鎖定 NVIDIA vGPU 功能,請在將啟用工作負載管理的 vCenter 叢集中的每個 ESXi 主機上啟用直接共用模式。

- 使用 vSphere Client 登入 vCenter Server。

- 選取 vCenter 叢集中的 ESXi 主機。

- 選取。

- 選取 NVIDIA GPU 加速器裝置。

- 編輯圖形裝置設定。

- 選取直接共用。

- 選取重新啟動 X.Org 伺服器。

- 按一下確定可儲存組態。

- 在 ESXi 主機上按一下滑鼠右鍵,然後將其置於維護模式。

- 將主機重新開機。

- 當主機再次執行時,將其退出維護模式。

- 對將啟用工作負載管理的 vCenter 叢集中的每個 ESXi 主機重複此過程。

![[編輯圖形裝置設定] 頁面,其中選取了 [直接共用] 和 [重新啟動 X.Org 伺服器] 選項。](images/GUID-D3A546A5-7242-4515-A31A-A714BB93782E-high.jpg)

![vSphere Client 中的 [圖形裝置] 索引標籤列出了已啟用 [直接共用] 模式的 NVIDIA GPU A100 裝置。](images/GUID-58CC6EEB-4538-48FB-B5C0-D1A98EF925A8-high.jpg)

為 NVIDIA GPU A30 和 A100 裝置開啟 SR-IOV BIOS

如果使用多執行個體 GPU (MIG 模式) 所需的 NVIDIA A30 或 A100 GPU 裝置,則必須在 ESXi 主機上啟用 SR-IOV。如果未啟用 SR-IOV,Tanzu Kubernetes 叢集節點虛擬機器將無法啟動。如果發生這種情況,您會在啟用了工作負載管理的 vCenter Server 的最近的工作窗格中看到以下錯誤訊息。

Could not initialize plugin libnvidia-vgx.so for vGPU nvidia_aXXX-xx. Failed to start the virtual machine. Module DevicePowerOn power on failed.

若要啟用 SR-IOV,請使用 Web 主控台登入 ESXi 主機。選取。選取 NVIDIA GPU 裝置,然後按一下設定 SR-IOV。您可以從此處開啟 SR-IOV。如需其他指導,請參閱 vSphere 說明文件中的單一根目錄 I/O 虛擬化 (SR-IOV)。

管理員步驟 3:在每個 ESXi 主機上安裝 NVIDIA 主機管理器驅動程式

若要執行具有 NVIDIA vGPU 圖形加速的 Tanzu Kubernetes 叢集節點虛擬機器,請在將啟用工作負載管理的 vCenter 叢集中的每個 ESXi 主機上安裝 NVIDIA 主機管理器驅動程式。

NVIDIA vGPU 主機管理器驅動程式元件封裝在 vSphere 安裝服務包 (VIB) 中。NVAIE VIB 由您的組織透過其 NVIDIA GRID 授權方案提供給您。VMware 不提供 NVAIE VIB,也不提供下載服務。根據 NVIDIA 授權方案,授權伺服器由您的組織設定。如需詳細資訊,請參閱 NVIDIA 虛擬 GPU 軟體快速入門指南。

esxcli system maintenanceMode set --enable true esxcli software vib install -v ftp://server.domain.example.com/nvidia/signed/NVIDIA_bootbank_NVIDIA-VMware_ESXi_7.0_Host_Driver_460.73.02-1OEM.700.0.0.15525992.vib esxcli system maintenanceMode set --enable false /etc/init.d/xorg restart

管理員步驟 4:驗證 ESXi 主機是否已做好執行 NVIDIA vGPU 操作的準備

- 透過 SSH 登入 ESXi 主機,進入 shell 模式,然後執行命令

nvidia-smi。NVIDIA 系統管理介面是由 NVIDA vGPU 主機管理員提供的命令列公用程式。執行此命令將傳回主機上的 GPU 和驅動程式。 - 執行以下命令以驗證是否已正確安裝 NVIDIA 驅動程式:

esxcli software vib list | grep NVIDA。 - 驗證主機是否設定了 GPU 直接共用並開啟了 SR-IOV (如果使用的是 NVIDIA A30 或 A100 裝置)。

- 使用 vSphere Client,在為 GPU 設定的 ESXi 主機上建立一個包含 PCI 裝置的新虛擬機器。NVIDIA vGPU 設定檔應顯示且可選取。

![[自訂硬體] 索引標籤,其中選取了 NVIDIA vGPU 設定檔。](images/GUID-FDD9B658-B177-49D0-B9D3-A18FFF3D1116-high.jpg)

管理員步驟 5:在設定了 vGPU 的 vCenter 叢集上啟用工作負載管理

現在,ESXi 主機已設定為支援 NVIDIA vGPU,請建立包含這些主機的 vCenter 叢集。若要支援工作負載管理,vCenter 叢集必須滿足特定要求,包括共用儲存區、高可用性、全自動 DRS。

若要啟用工作負載管理,還需要選取網路堆疊 (本機 vSphere vDS 網路或 NSX-T Data Center 網路)。如果使用 vDS 網路,則需要安裝負載平衡器 (NSX Advanced 或 HAProxy)。

| 工作 | 指示 |

|---|---|

| 建立滿足啟用工作負載管理所需要求的 vCenter 叢集 | 在 vSphere 叢集上設定 vSphere with Tanzu 的必要條件 |

| 為 主管叢集 (NSX-T 或具有負載平衡器的 vDS) 設定網路。 | 為 vSphere with Tanzu 設定 NSX-T Data Center. 為 vSphere with Tanzu 設定 vSphere 網路和 NSX Advanced Load Balancer. |

| 啟用工作負載管理 |

管理員步驟 6:為 Tanzu Kubernetes Ubuntu 版本建立或更新內容程式庫

NVIDIA vGPU 需要使用 Ubuntu 作業系統。VMware 出於此類目的提供了 Ubuntu OVA。不能將 PhotonOS Tanzu Kubernetes 版本用於 vGPU 叢集。

| 內容程式庫類型 | 說明 |

|---|---|

| 建立已訂閱內容程式庫並自動將 Ubuntu OVA 與您的環境同步。 | 為 Tanzu Kubernetes 版本建立、保護和同步已訂閱內容程式庫 |

| 建立本機內容程式庫並手動將 Ubuntu OVA 上傳到您的環境。 | 為 Tanzu Kubernetes 版本建立、保護和同步本機內容程式庫 |

![Ubuntu 中的 [OVF 與 OVA 範本] 頁面顯示內容程式庫中可用的 Ubuntu OVA。](images/GUID-042D9891-0A32-40A7-A213-1D183CAB6315-high.jpg)

管理員步驟 7:建立包含 vGPU 設定檔的自訂虛擬機器類別

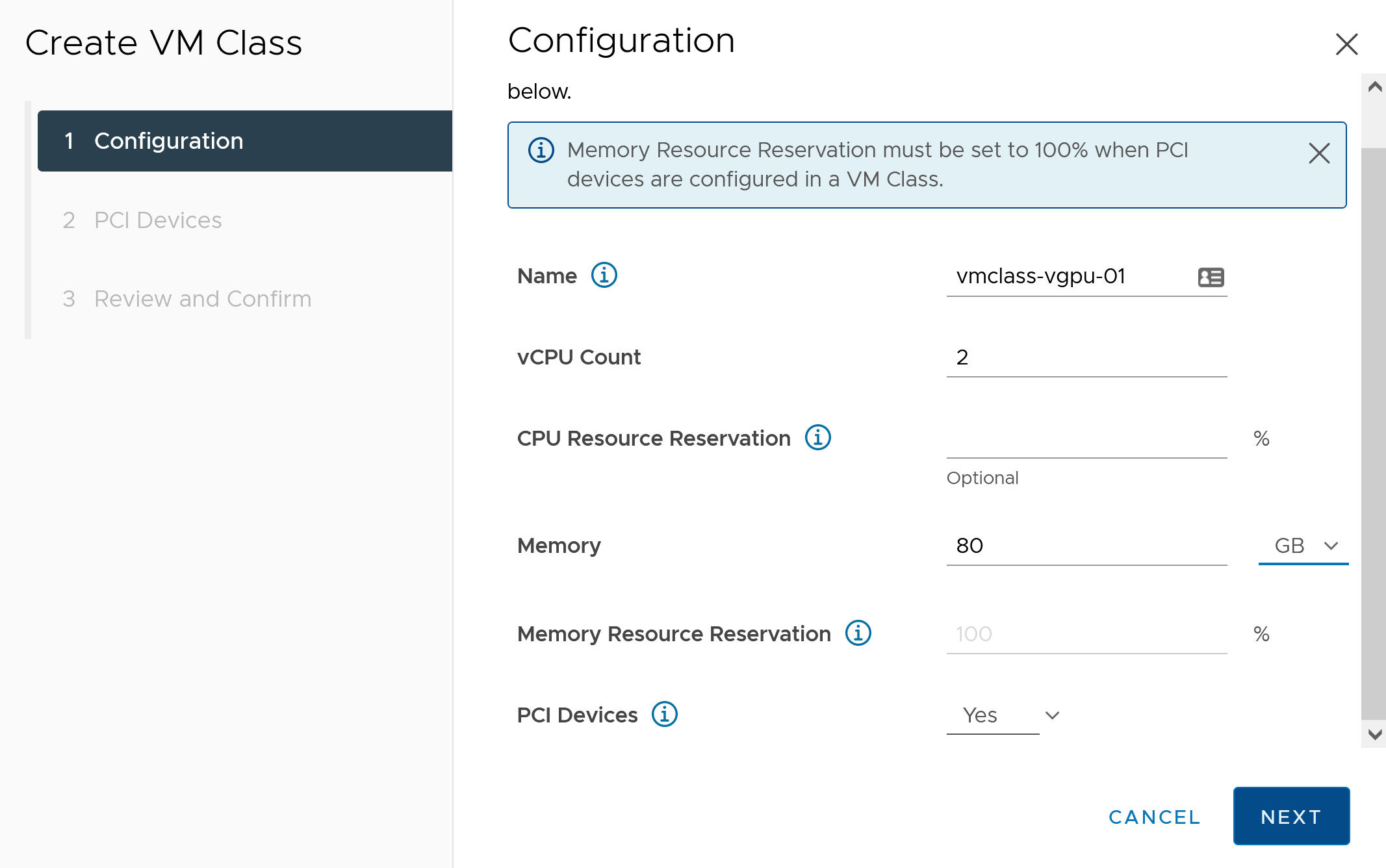

下一步是建立包含 vGPU 設定檔的自訂虛擬機器類別。系統在建立 Tanzu Kubernetes 叢集節點時將使用此類別定義。

- 使用 vSphere Client 登入 vCenter Server。

- 選取工作負載管理。

- 選取服務。

- 選取虛擬機器類別。

- 按一下建立虛擬機器類別。

- 在組態索引標籤上,設定自訂虛擬機器類別。

組態欄位 說明 名稱 輸入自訂虛擬機器類別的自描述性名稱,例如 vmclass-vgpu-1。 vCPU 計數 2 CPU 資源保留 可選,按一下 [確定] 留空 記憶體 例如 80 GB 記憶體資源保留 100% (如果在虛擬機器類別中設定了 PCI 裝置,則強制使用此值) PCI 裝置 是 備註: 針對 PCI 裝置選取 [是] 將告知系統您使用的是 GPU 裝置,並將變更虛擬機器類別組態以支援 vGPU 組態。例如:

- 按下一步。

- 在 PCI 裝置索引標籤上選取 選項。

- 設定 NVIDIA vGPU 型號。

NVIDIA vGPU 欄位 說明 型號 從 功能表所提供的型號中選取 NVIDIA GPU 硬體裝置型號。如果系統未顯示任何設定檔,表示叢集中的所有主機都不具有受支援的 PCI 裝置。 GPU 共用 此設定定義如何在啟用了 GPU 的虛擬機器之間共用 GPU 裝置。vGPU 實作有兩種類型:時間共用和多執行個體 GPU 共用。

在 [時間共用] 模式下,vGPU 排程器指示 GPU 在一段時間內依序為每個啟用了 vGPU 的虛擬機器執行工作,並將盡最大努力平衡各 vGPU 的效能。

MIG 模式允許多個啟用了 vGPU 的虛擬機器在單個 GPU 裝置上並行執行。MIG 模式基於較新的 GPU 架構,僅在 NVIDIA A100 和 A30 裝置上受支援。如果沒有看到 MIG 選項,表示您選取的 PCI 裝置不支援該選項。

GPU 模式 運算 GPU 記憶體 例如 8 GB vGPU 數目 例如 1 例如,以下是在 [時間共用] 模式下設定的 NVIDIA vGPU 設定檔:

![[PCI 裝置] 索引標籤,包含在 [時間共用] 模式下設定的 NVIDIA vGPU 設定檔。](images/GUID-26039367-9949-4881-A354-8BC21EA341F5-high.jpg)

例如,以下是在具有受支援 GPU 裝置的情況下在 MIG 模式下設定的 NVIDIA vGPU 設定檔:

![[PCI 裝置] 索引標籤,包含在 [多執行個體 GPU 共用] 模式下設定的 NVIDIA vGPU 設定檔。](images/GUID-3D1D77DF-F588-4B04-8F91-78BACB93CFD9-high.jpg)

- 按下一步。

- 查看並確認您的選擇。

- 按一下完成。

- 驗證虛擬機器類別清單中是否有新的自訂虛擬機器類別。

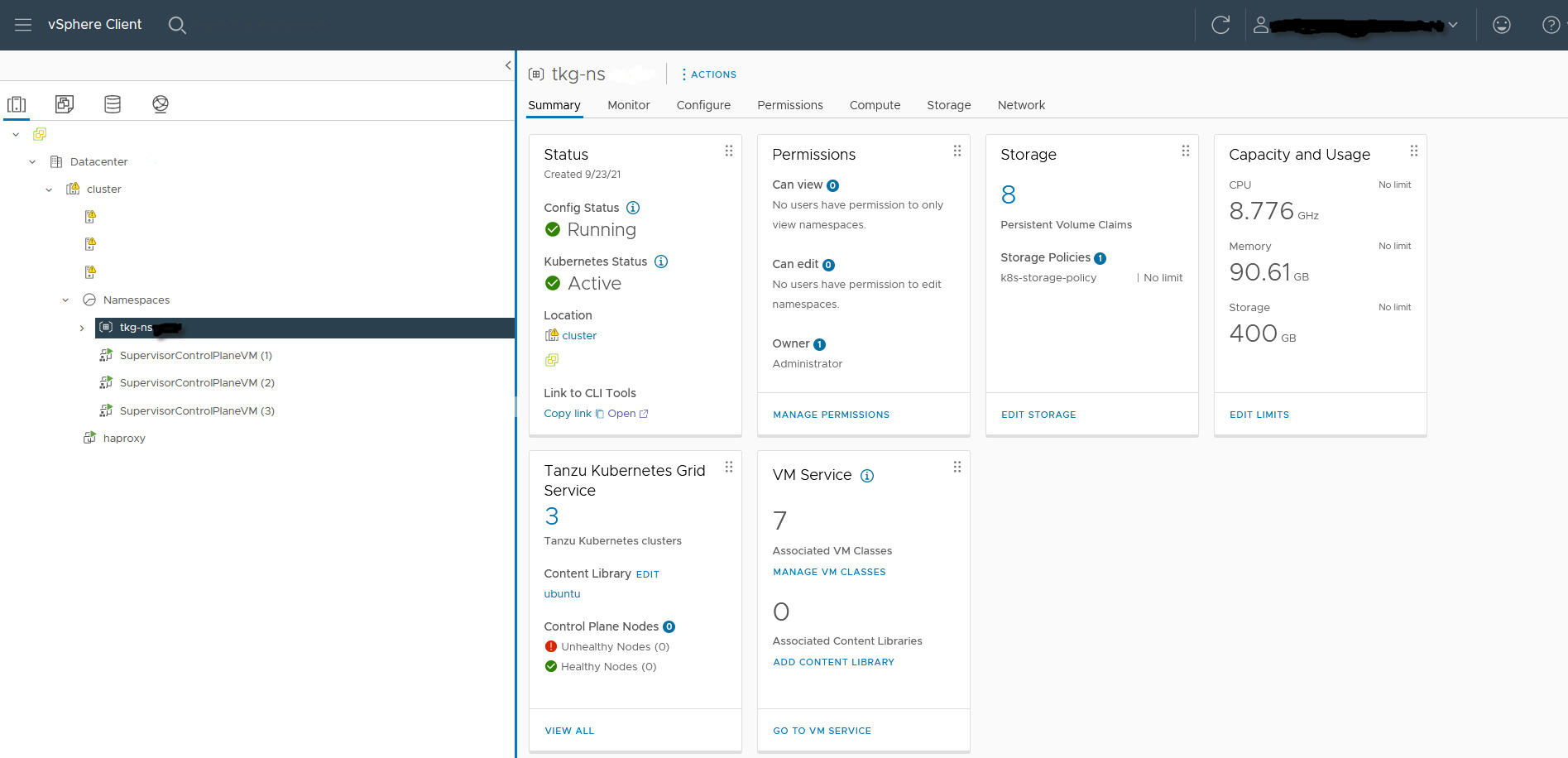

管理員步驟 8:為 TKGS GPU 叢集建立和設定 vSphere 命名空間

為計劃佈建的每個 TKGS GPU 叢集建立一個 vSphere 命名空間。透過新增具有編輯權限的 vSphere SSO 使用者設定命名空間,並連結用於持續性磁碟區的儲存區原則。

若要執行此操作,請參閱建立和設定 vSphere 命名空間。

管理員步驟 9:將內容程式庫和虛擬機器類別與 vSphere 命名空間相關聯

| 工作 | 說明 |

|---|---|

| 將包含用於 vGPU 的 Ubuntu OVA 的內容程式庫與將在其中佈建 TKGS 叢集的 vSphere 命名空間相關聯。 | |

| 將具有 vGPU 設定檔的自訂虛擬機器類別與將在其中佈建 TKGS 叢集的 vSphere 命名空間相關聯。 |

管理員步驟 10:驗證主管叢集是否可存取

最後一個管理工作是驗證 主管叢集 是否已佈建,以及是否可供叢集營運人員用於為 AI/ML 工作負載佈建 TKGS 叢集。

- 下載並安裝 vSphere 適用的 Kubernetes CLI 工具。

- 連線至 主管叢集。

- 為叢集營運人員提供用於下載 vSphere 適用的 Kubernetes CLI 工具 的連結以及 vSphere 命名空間的名稱。