Speichergeräte mit nicht flüchtigem Arbeitsspeicher (NVM), die persistenten Arbeitsspeicher verwenden, sind in Datencentern beliebt. Für die Verbindung mit lokalen und vernetzten NVM-Geräten verwendet ESXi das NVM Express(NVMe)-Protokoll, ein standardisiertes Protokoll, das speziell für die Hochleistungskommunikation mit NVM-Geräten mit mehreren Warteschlangen entwickelt wurde.

VMware NVMe-Konzepte

Bevor Sie mit der Arbeit mit NVMe-Speicher in der ESXi-Umgebung beginnen, informieren Sie sich über die grundlegenden NVMe-Konzepte.

- NVM Express (NVMe)

- NVMe ist eine Methode zum Verbinden und Übertragen von Daten zwischen einem Host und einem Zielspeichersystem. NVMe ist für die Verwendung mit schnelleren Speichermedien ausgelegt, die mit nicht flüchtigem Arbeitsspeicher ausgestattet sind, z. B. Flash-Geräten. Diese Art von Speicher kann eine niedrige Latenz, eine niedrige CPU-Auslastung und eine hohe Leistung erzielen und dient in der Regel als Alternative zum SCSI-Speicher.

- NVMe-Transporte

- NVMe-Speicher kann über eine PCIe-Schnittstelle direkt oder über verschiedene Fabric-Transporte indirekt mit einem Host verbunden werden. VMware NVMe over Fabrics (NVMe-oF) stellt Konnektivität über Entfernungen zwischen einem Host und einem Zielspeichergerät auf einem freigegebenen Speicher-Array bereit.

- NVMe-Namespaces

- Im NVMe-Speicher-Array ist ein Namespace ein Speichervolume, das durch eine bestimmte Menge an nicht flüchtigem Arbeitsspeicher gestützt wird. Im Kontext von ESXi ist der Namespace analog zu einem Speichergerät oder einer LUN. Nachdem Ihr ESXi-Host den NVMe-Namespace ermittelt hat, wird ein Flash-Gerät, das den Namespace repräsentiert, in der Liste der Speichergeräte im vSphere Client angezeigt. Sie können das Gerät verwenden, um einen Datenspeicher zu erstellen und virtuelle Maschinen zu speichern.

- NVMe-Controller

- Ein Controller ist mit einem oder mehreren NVMe-Namespaces verknüpft und bietet einen Zugriffspfad zwischen dem ESXi-Host und den Namespaces im Speicher-Array. Für den Zugriff auf den Controller kann der Host zwei Mechanismen verwenden, die Controller-Ermittlung und die Controller-Verbindung. Weitere Informationen finden Sie unter Hinzufügen von Controllern für NVMe over Fabrics.

- Controller-Ermittlung

- Mit diesem Mechanismus kontaktiert der ESXi-Host zuerst einen Ermittlungs-Controller. Der Ermittlungs-Controller gibt eine Liste der verfügbaren Controller zurück. Nachdem Sie einen Controller ausgewählt haben, auf den Ihr Host zugreifen kann, stehen alle diesem Controller zugeordneten Namespaces für Ihren Host zur Verfügung.

- Controller-Verbindung

- Ihr ESXi-Host stellt eine Verbindung mit dem von Ihnen angegebenen Controller her. Alle diesem Controller zugeordneten Namespaces werden Ihrem Host zur Verfügung gestellt.

- NVMe-Subsystem

- Im Allgemeinen handelt es sich bei einem NVMe-Subsystem um ein Speicher-Array, das mehrere NVMe-Controller, mehrere Namespaces, ein nicht flüchtiges Speichermedium und eine Schnittstelle zwischen dem Controller und einem nicht flüchtigen Speichermedium enthalten kann. Das Subsystem wird durch einen Subsystem NVMe Qualified Name (NQN) identifiziert.

- VMware-Hochleistungs-Plug-In (VMware High-Performance Plug-in, HPP)

- Standardmäßig verwendet der ESXi-Host das HPP, um die NVMe-oF-Ziele zu beanspruchen. Bei der Auswahl von physischen Pfaden für E/A-Anforderungen wendet das HPP ein geeignetes Pfadauswahlschema (PSS) an. Weitere Informationen zum HPP finden Sie unter VMware High Performance-Plug-In und Pfadauswahlschemas. Informationen zum Ändern des standardmäßigen Pfadauswahlmechanismus finden Sie unter Ändern der Pfadauswahl-Richtlinie.

Grundlegende VMware NVMe-Architektur und -Komponenten

ESXi unterstützt lokalen NVMe over PCIe-Speicher und gemeinsam genutzten NVMe-oF-Speicher, z. B. NVMe over Fibre Channel, NVMe over RDMA (RoCE v2) und NVMe over TCP.

- VMware NVMe over PCIe

-

In dieser Konfiguration verwendet Ihr

ESXi-Host einen PCIe-Speicheradapter für den Zugriff auf ein oder mehrere lokale NVMe-Speichergeräte. Nachdem Sie den Adapter auf dem Host installiert haben, erkennt der Host die verfügbaren NVMe-Geräte, und diese werden in der Liste der Speichergeräte im

vSphere Client angezeigt.

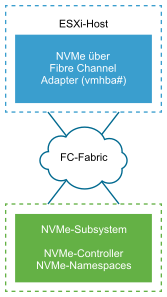

- VMware NVMe over Fibre Channel

-

Diese Technologie ordnet NVMe dem Fibre-Channel-Protokoll zu, um die Übertragung von Daten und Befehlen zwischen einem Host und einem Zielspeichergerät zu ermöglichen. Dieser Transport kann vorhandene Fibre Channel-Infrastruktur verwenden, die zur Unterstützung von NVMe aktualisiert wurde.

Um auf den NVMe over Fibre Channel-Speicher zuzugreifen, installieren Sie einen Fibre Channel-Speicheradapter, der NVMe auf Ihrem ESXi-Host unterstützt. Es ist kein Konfigurieren des Adapters erforderlich. Er stellt automatisch eine Verbindung zu einem geeigneten NVMe-Subsystem her und erkennt alle gemeinsam genutzten NVMe-Speichergeräte, die er erreichen kann. Sie können den Adapter später neu konfigurieren und seine Controller trennen oder andere Controller verbinden, die während des Hoststarts nicht verfügbar waren. Weitere Informationen finden Sie unter Hinzufügen von Controllern für NVMe over Fabrics.

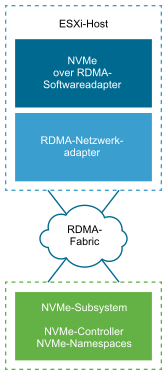

- NVMe over RDMA (RoCE v2)

-

Diese Technologie verwendet einen RDMA-Transport (Remote Direct Memory Access) zwischen zwei Systemen im Netzwerk. Der Transport ermöglicht den Datenaustausch im Hauptspeicher, wobei das Betriebssystem oder der Prozessor eines der beiden Systeme umgangen werden.

ESXi unterstützt RDMA over Converged Ethernet v2 (ROCE v2)-Technologie, die einen direkten Remote-Arbeitsspeicherzugriff über ein Ethernet-Netzwerk ermöglicht.

Für den Zugriff auf Speicher verwendet der ESXi-Host einen RDMA-Netzwerkadapter, der auf Ihrem Host installiert ist, und einen NVMe over RDMA-Software-Speicheradapter. Sie müssen beide Adapter so konfigurieren, dass sie für die Speichererkennung verwendet werden. Weitere Informationen finden Sie unter Konfigurieren von NVMe over RDMA (RoCE v2) auf ESXi.

- NVMe over TCP

-

Diese Technologie verwendet Ethernet-Verbindungen zwischen zwei Systemen. Für den Zugriff auf Speicher verwendet der ESXi-Host einen auf Ihrem Host installierten Netzwerkadapter sowie einen NVMe over TCP-Softwarespeicheradapter. Sie müssen beide Adapter so konfigurieren, dass sie für die Speichererkennung verwendet werden. Weitere Informationen finden Sie unter Konfigurieren von NVMe over TCP auf ESXi.