Der Adapter-Konfigurationsvorgang auf dem ESXi-Host umfasst das Einrichten der VMkernel-Bindung für einen RDMA-Netzwerkadapter und das anschließende Hinzufügen eines NVMe over RDMA-Softwareadapters. Anschließend können Sie einen NVMe-Controller hinzufügen.

| Aktion | Beschreibung |

|---|---|

| Anzeigen von RDMA-Netzwerkadaptern | Installieren Sie auf Ihrem ESXi-Host einen Netzwerkadapter, der RDMA (RoCE v2) unterstützt. Beispiel: Mellanox Technologies MT27700 Family ConnectX-4. Nachdem Sie den Netzwerkadapter installiert haben, verwenden Sie die vSphere Client, um den RDMA-Adapter und einen physischen Netzwerkadapter zu überprüfen. |

| Konfigurieren der VMkernel-Bindung für den RDMA-Adapter | Die Port-Bindung für NVMe over RDMA umfasst das Erstellen eines Switches und das Verbinden des physischen Netzwerkadapters und des VMkernel-Adapters mit dem Switch. Über diese Verbindung wird der RDMA-Adapter an den VMkernel-Adapter gebunden. In der Konfiguration können Sie einen vSphere Standard-Switch oder einen vSphere Distributed Switch verwenden. |

| Hinzufügen des Software NVMe over RDMA-Adapters | Aktivieren Sie die Software-Speicheradapter für NVMe over RDMA mit vSphere Client. |

| Hinzufügen von Controllern für NVMe over Fabrics | Verwenden Sie den vSphere Client, um einen NVMe-Controller hinzuzufügen. Nachdem Sie den Controller hinzugefügt haben, werden die dem Controller zugeordneten NVMe-Namespaces für Ihren ESXi-Host verfügbar. Die NVMe-Speichergeräte, die die Namespaces in der ESXi-Umgebung darstellen, werden in der Liste der Speichergeräte angezeigt. |

Das folgende Video führt Sie durch die Schritte zum Konfigurieren von NVMe over RDMA-Adaptern.

Anzeigen von RDMA-Netzwerkadaptern

Nachdem Sie einen Netzwerkadapter installiert haben, der RDMA (RoCE v2) auf Ihrem ESXi-Host unterstützt, verwenden Sie den vSphere Client zum Überprüfen des RDMA-Adapters und eines physischen Netzwerkadapters.

Prozedur

Konfigurieren der VMkernel-Bindung für den RDMA-Adapter

Die Port-Bindung für NVMe over RDMA umfasst das Erstellen eines Switches und das Verbinden des physischen Netzwerkadapters und des VMkernel-Adapters mit dem Switch. Über diese Verbindung wird der RDMA-Adapter an den VMkernel-Adapter gebunden. In der Konfiguration können Sie einen vSphere Standard-Switch oder einen vSphere Distributed Switch verwenden.

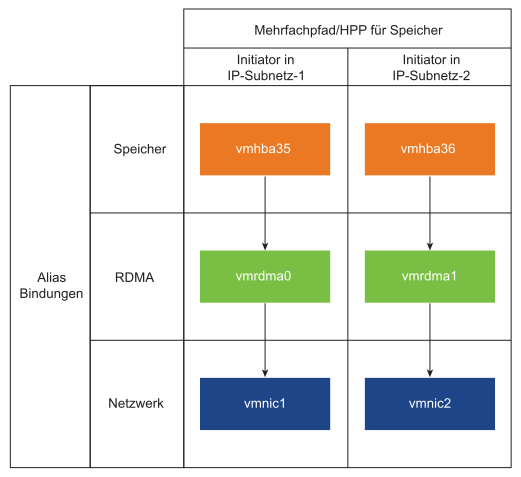

Im folgenden Diagramm wird die Port-Bindung für den NVMe over RDMA-Adapter angezeigt.

Informationen zum Erstellen von Switches finden Sie unter vSphere Standard-Switch erstellen oder vSphere Distributed Switch erstellen in der vSphere-Netzwerk-Dokumentation.

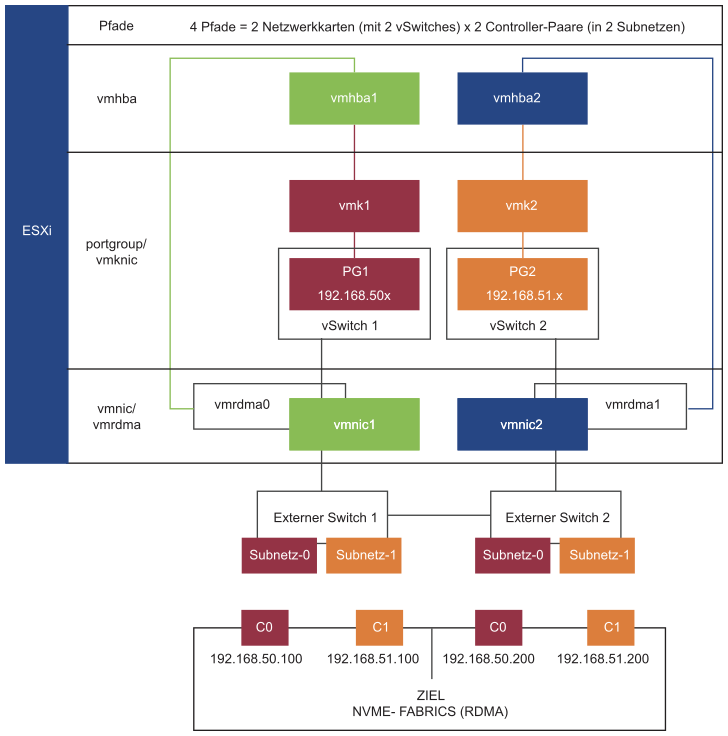

Beispiel einer Netzwerktopologie mit NVMe over RDMA

In diesem Beispiel stellen zwei vSphere Standard-Switches und zwei Uplinks (RDMA-fähige Netzwerkkarten) Hochverfügbarkeit bereit. Sie stellen eine Verbindung zu zwei Controller-Paaren in zwei Subnetzen her.

Hochverfügbarkeit mit mehreren vSwitches und mehreren Uplinks (RNICs)

Konfigurieren der VMkernel-Bindung mit einem vSphere Standard-Switch

Sie können eine VMkernel-Port-Bindung für den RDMA-Adapter mithilfe eines vSphere Standard-Switches und eines Uplinks pro Switch konfigurieren. Zum Konfigurieren der Netzwerkverbindung muss für jeden physischen Netzwerkadapter ein virtueller VMkernel-Adapter erstellt werden. Sie verwenden eine 1:1-Zuordnung zwischen jedem virtuellen und physischen Netzwerkadapter.

Prozedur

- Erstellen Sie einen vSphere Standard-Switch mit einem VMkernel-Adapter und der Netzwerkkomponente.

- Wählen Sie im vSphere Client Ihren Host aus und klicken Sie auf die Registerkarte Netzwerke.

- Klicken Sie auf .

- Wählen Sie VMkernel-Netzwerkadapter aus und klicken Sie auf WEITER.

- Wählen Sie Neuer Standard-Switch und klicken Sie auf WEITER.

- Klicken Sie unter Zugewiesene Adapter auf +.

Die Liste der verfügbaren physischen Adapter wird angezeigt.

- Wählen Sie den notwendigen physischen Adapter vmnic aus und klicken Sie auf OK.

Hinweis: Stellen Sie sicher, dass Sie den physischen Netzwerkadapter auswählen, der dem RDMA-Adapter entspricht. Zum Anzeigen der Verknüpfung zwischen dem RDMA-Adapter vmrdma und dem physischen Netzwerkadapter vmnic finden Sie Informationen unter Anzeigen von RDMA-Netzwerkadaptern.

- Geben Sie unter Porteinstellungen für VMkernel die notwendigen Werte ein.

Geben Sie bei Verwendung von VLAN für den Speicherpfad die VLAN-ID ein.

- Geben Sie in der Liste IP-Einstellungen die IPv4-Einstellungen für den VMkernel ein.

- Wählen Sie unter „Verfügbare Dienste“ die Option NVMe over RDMA aus.

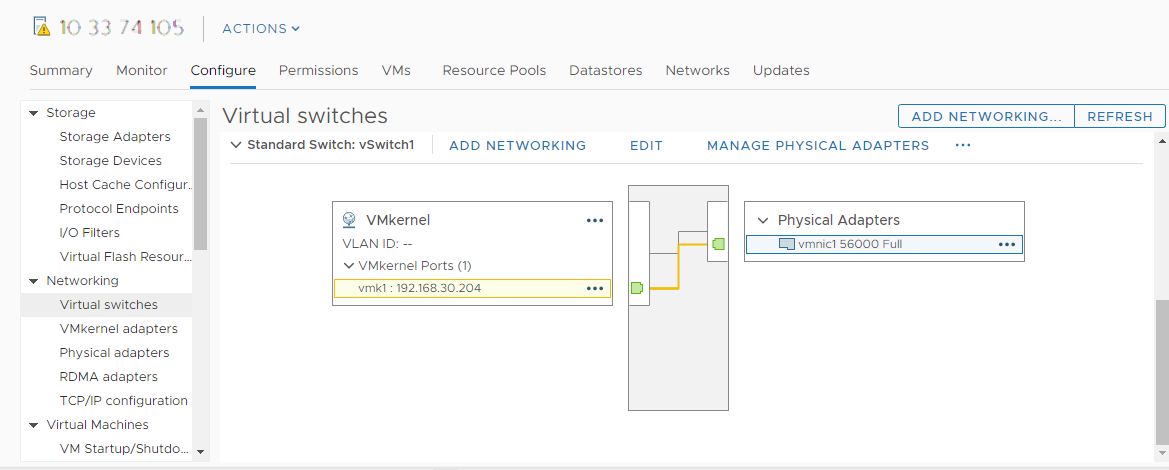

- Stellen Sie sicher, dass der Switch ordnungsgemäß konfiguriert ist.

- Wählen Sie auf der Registerkarte Konfigurieren die Option Virtuelle Switches unter Netzwerk aus.

- Erweitern Sie den Switch und überprüfen Sie die zugehörige Konfiguration.

Die Abbildung zeigt, dass der physische Netzwerkadapter und der VMkernel-Adapter mit dem vSphere Standard-Switch verbunden sind. Über diese Verbindung ist der RDMA-Adapter an den VMkernel-Adapter gebunden.

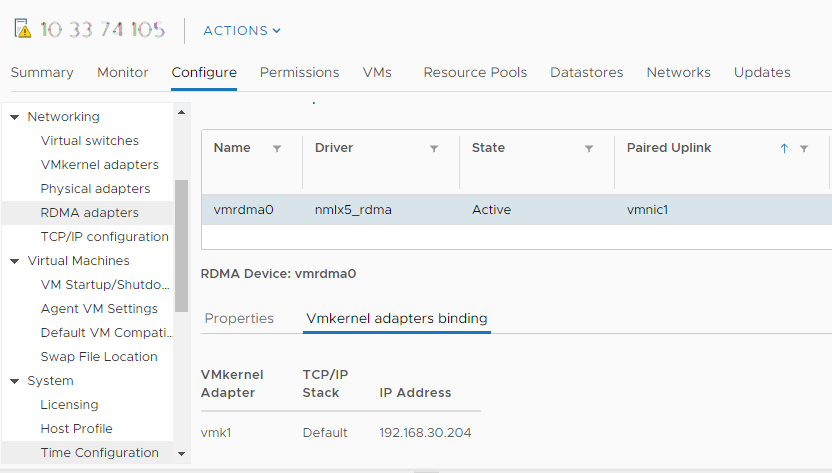

- Überprüfen Sie die Konfiguration der VMkernel-Bindung für den RDMA-Adapter.

- Klicken Sie unter der Liste Netzwerk auf RDMA-Adapter und wählen Sie den RDMA-Adapter in der Liste aus.

- Klicken Sie auf die Registerkarte Bindung von VMkernel-Adaptern und stellen Sie sicher, dass der zugehörige VMkernel-Adapter auf der Seite angezeigt wird.

In diesem Beispiel wird der RDMA-Adapter vmrdma0mit dem Netzwerkadapter vmnic1 gekoppelt und mit dem VMkernel-Adapter vmk1 verbunden.

Konfigurieren der VMkernel-Bindung mit einem vSphere Standard-Switch und NIC-Gruppierung

Sie können eine VMkernel-Port-Bindung für den RDMA-Adapter konfigurieren, indem Sie einen vSphere Standard-Switch mit der NIC-Gruppierungskonfiguration verwenden. Sie können die NIC-Gruppierung verwenden, um Netzwerkredundanz zu erreichen. Sie können zwei oder mehr Netzwerkadapter (NICs) als Gruppe für Hochverfügbarkeit und Lastausgleich konfigurieren.

Prozedur

Konfigurieren der VMkernel-Bindung mit einem vSphere Distributed Switch

Sie können eine VMkernel-Port-Bindung für den RDMA-Adapter mithilfe eines vSphere Distributed Switches und eines Uplinks pro Switch konfigurieren. Zum Konfigurieren der Netzwerkverbindung muss für jeden physischen Netzwerkadapter ein virtueller VMkernel-Adapter erstellt werden. Sie verwenden eine 1:1-Zuordnung zwischen jedem virtuellen und physischen Netzwerkadapter.

Prozedur

- Erstellen Sie einen vSphere Distributed Switch mit einem VMkernel-Adapter und der Netzwerkkomponente.

- Wählen Sie im vSphere Client die Option Datencenter aus und klicken Sie auf die Registerkarte Netzwerke.

- Klicken Sie auf Aktionen und wählen Sie aus.

- Wählen Sie einen Namen für den Switch aus.

Stellen Sie sicher, dass der Speicherort des Datencenters innerhalb Ihres Hosts vorhanden ist, und klicken Sie auf Weiter.

- Wählen Sie eine kompatible ESXi-Version aus und klicken Sie auf Weiter.

- Geben Sie die erforderliche Anzahl an Uplinks ein und klicken Sie auf Beenden.

- Fügen Sie einen oder mehrere Hosts zu Ihrem Distributed Virtual Switch hinzu.

- Wählen Sie im vSphere Client die Option Datencenter aus und klicken Sie auf Distributed Switches.

Eine Liste der verfügbaren DSwitches wird angezeigt.

- Klicken Sie mit der rechten Maustaste auf den DSwitch und wählen Sie Hosts hinzufügen und verwalten aus.

- Wählen Sie Hosts hinzufügen aus und klicken Sie auf Weiter.

- Wählen Sie den Host aus und klicken Sie auf Weiter.

- Wählen Sie Uplink zuweisen aus.

- Geben Sie den relevanten Uplink ein, um die vmnic zuzuweisen.

- Weisen Sie einen VMkernel-Adapter zu und klicken Sie auf Weiter.

- Wählen Sie im vSphere Client den DSwitch aus und klicken Sie auf die Registerkarte Ports.

Sie können die Uplinks anzeigen, die für Ihren Switch erstellt wurden.

- Wählen Sie im vSphere Client die Option Datencenter aus und klicken Sie auf Distributed Switches.

- Erstellen Sie verteilte Portgruppen für den Speicherpfad „NVMe over RDMA“.

- Wählen Sie im vSphere Client den erforderlichen DSwitch aus.

- Klicken Sie auf Aktionen und wählen Sie aus.

- Geben Sie unter Einstellungen konfigurieren die allgemeinen Eigenschaften der Portgruppe ein.

Wenn ein spezielles VLAN konfiguriert wurde, fügen Sie es in der VLAN-ID hinzu.Hinweis: Netzwerkkonnektivitätsprobleme können auftreten, wenn das VLAN nicht ordnungsgemäß konfiguriert wurde.

- Konfigurieren Sie die VMkernel-Adapter.

- Erweitern Sie im vSphere Client die Liste DSwitch und wählen Sie die verteilte Portgruppe aus.

- Klicken Sie auf .

- Wählen Sie im Dialogfeld Mitglieder-Hosts auswählen Ihren Host aus und klicken Sie auf OK.

- Stellen Sie im Dialogfeld VMkernel-Adapter konfigurieren sicher, dass die MTU mit der Switch-MTU übereinstimmt.

- Wählen Sie unter Verfügbare Dienste die Option NVMe over RDMA für das entsprechende Tagging aus.

- Klicken Sie auf Beenden.

- Wiederholen Sie Schritt B und Schritt C, um mehrere RDMA-fähige Netzwerkkarten hinzuzufügen.

- Legen Sie NIC-Gruppierungsrichtlinien für die verteilten Portgruppen fest.

- Klicken Sie unter Verteilte Portgruppe auf .

- Klicken Sie auf Teaming und Failover und überprüfen Sie die aktiven Uplinks.

- Weisen Sie einen Uplink als Aktiv für die Portgruppe zu und den anderen Uplink als Nicht verwendet.

Wiederholen Sie Schritt C für jede erstellte Portgruppe.

Nächste Maßnahme

Hinzufügen von Software NVMe over RDMA- oder NVMe oder TCP-Softwareadaptern

ESXi unterstützt NVMe over RDMA- und NVMe over TCP-Softwareadapter. Fügen Sie die Software-Speicheradapter für NVMe over RDMA oder NVMe over TCP mit dem vSphere Client hinzu.

Voraussetzungen

- Installieren Sie auf Ihrem ESXi-Host einen Adapter, der die folgenden Speichertypen unterstützt.

- NVMe over RDMA-Adapter. Beispiel: Mellanox Technologies MT27700 Family ConnectX-4.

- NVMe over TCP-Adapter. Beispiel: i40en.

- Konfigurieren Sie die VMkernel-Bindung für Ihre Adapter.

- Informationen zu NVMe over RDMA finden Sie unter Konfigurieren der VMkernel-Bindung für den RDMA-Adapter.

- Informationen zu NVMe over TCP finden Sie unter Konfigurieren der VMkernel-Bindung für den NVMe over TCP-Adapter.

Prozedur

Ergebnisse

Hinzufügen von Controllern für NVMe over Fabrics

Verwenden Sie den vSphere Client, um einen NVMe-Controller hinzuzufügen. Nachdem Sie den Controller hinzugefügt haben, werden die dem Controller zugeordneten NVMe-Namespaces für Ihren ESXi-Host verfügbar. Die NVMe-Speichergeräte, die die Namespaces in der ESXi-Umgebung darstellen, werden in der Liste der Speichergeräte angezeigt.

Voraussetzungen

- Stellen Sie sicher, dass Ihr ESXi-Host über die entsprechenden Adapter für Ihren Speichertyp verfügt. Weitere Informationen hierzu finden Sie unter Anforderungen für VMware NVMe-Speicher.

- Wenn Sie NVMe over RDMA (RoCE v2)-Speicher verwenden, führen Sie die folgenden Aufgaben aus:

- Wenn Sie NVMe over TCP-Speicher verwenden, führen Sie die folgenden Aufgaben aus:

Prozedur

- Navigieren Sie im vSphere Client zum ESXi-Host.

- Klicken Sie auf die Registerkarte Konfigurieren.

- Klicken Sie unter Speicher auf Speicheradapter und wählen Sie den zu konfigurierenden Adapter (vmhba#) aus.

- Klicken Sie auf die Registerkarte Controller und dann auf Controller hinzufügen.

- Wählen Sie im Dialogfeld Controller hinzufügen eine der folgenden Erkennungsmethoden aus.

Option Bezeichnung Automatisch Diese Option gibt an, dass Ihr Host Controller automatisch erkennen und eine Verbindung zu jedem verfügbaren Controller akzeptieren kann. - Geben Sie die folgenden Parameter zum Erkennen von Controllern an.

- Für NVMe over RDMA (ROCE v2) geben Sie die IP-Adresse und die Transport-Portnummer an.

- Für NVMe over TCP werden die IP-Adresse, die Nummer des Transportports und der Digest-Parameter verwendet.

- Klicken Sie auf Controller erkennen.

- Wählen Sie in der Liste der Controller den zu verwendenden Controller aus.

Manuell Mit dieser Methode geben Sie Controller-Details manuell ein. Der Host fordert mithilfe der von Ihnen angegebenen Parameter eine Verbindung zu einem bestimmten Controller an: - NQN des Subsystems

- Angabe des Zielports.

- Für NVMe over RDMA (RoCE v2) geben Sie die IP-Adresse und die Nummer des Transportports (optional) an.

- Für NVMe over TCP werden die IP-Adresse, die Nummer des Transportports (optional) und der Digest-Parameter (optional) verwendet.

- Für NVMe over Fibre Channel geben Sie den WorldWideNodeName und den WorldWidePortName an.

- Größe der Verwaltungswarteschlange. Ein optionaler Parameter, der die Größe der Verwaltungswarteschlange des Controllers angibt. Der Standardwert ist 16.

- Keep Alive-Zeitüberschreitung. Ein optionaler Parameter, der die Keep-Alive-Zeitüberschreitung in Sekunden zwischen dem Adapter und dem Controller angibt. Der Standardwert für die Zeitüberschreitung beträgt 60 Sekunden.

Hinweis: Die Größe und Nummer der E/A-Warteschlange sind optionale Parameter, die nur über esxcli festgelegt werden können. - Geben Sie die folgenden Parameter zum Erkennen von Controllern an.

Ergebnisse

Der Controller ist in der Liste der Controller aufgeführt. Ihr Host kann jetzt die NVMe-Namespaces erkennen, die dem Controller zugeordnet sind. Die NVMe-Speichergeräte, die die Namespaces in der ESXi-Umgebung darstellen, werden in der Liste der Speichergeräte auf dem vSphere Client angezeigt.