Damit Entwickler KI-/ML-Arbeitslasten auf TKG-Clustern bereitstellen können, richten Sie als vSphere-Administrator die Supervisor-Umgebung zur Unterstützung der NVIDIA GPU-Hardware ein.

Schritt 1 für Administratoren: Überprüfen der Systemanforderungen

| Anforderung | Beschreibung |

|---|---|

| vSphere 8-Infrastruktur |

vCenter Server und ESXi-Hosts |

| Workload Management-Lizenz |

vSphere Namespaces und Supervisor |

| TKR Ubuntu-OVA | |

| NVIDIA vGPU-Hosttreiber |

Laden Sie das VIB von der NGC-Website herunter. Weitere Informationen finden Sie in der Dokumentation des vGPU Software-Treibers. |

| NVIDIA-Lizenzserver für vGPU |

Von Ihrer Organisation bereitgestellter FQDN |

Schritt 2 für Administratoren: Installieren des unterstützten NVIDIA GPU-Geräts auf ESXi-Hosts

Zur Bereitstellung von KI-/ML-Arbeitslasten auf TKG installieren Sie mindestens ein unterstütztes NVIDIA GPU-Gerät auf allen ESXi-Hosts, aus denen sich der vCenter-Cluster zusammensetzt, auf dem Arbeitslastverwaltung aktiviert wird.

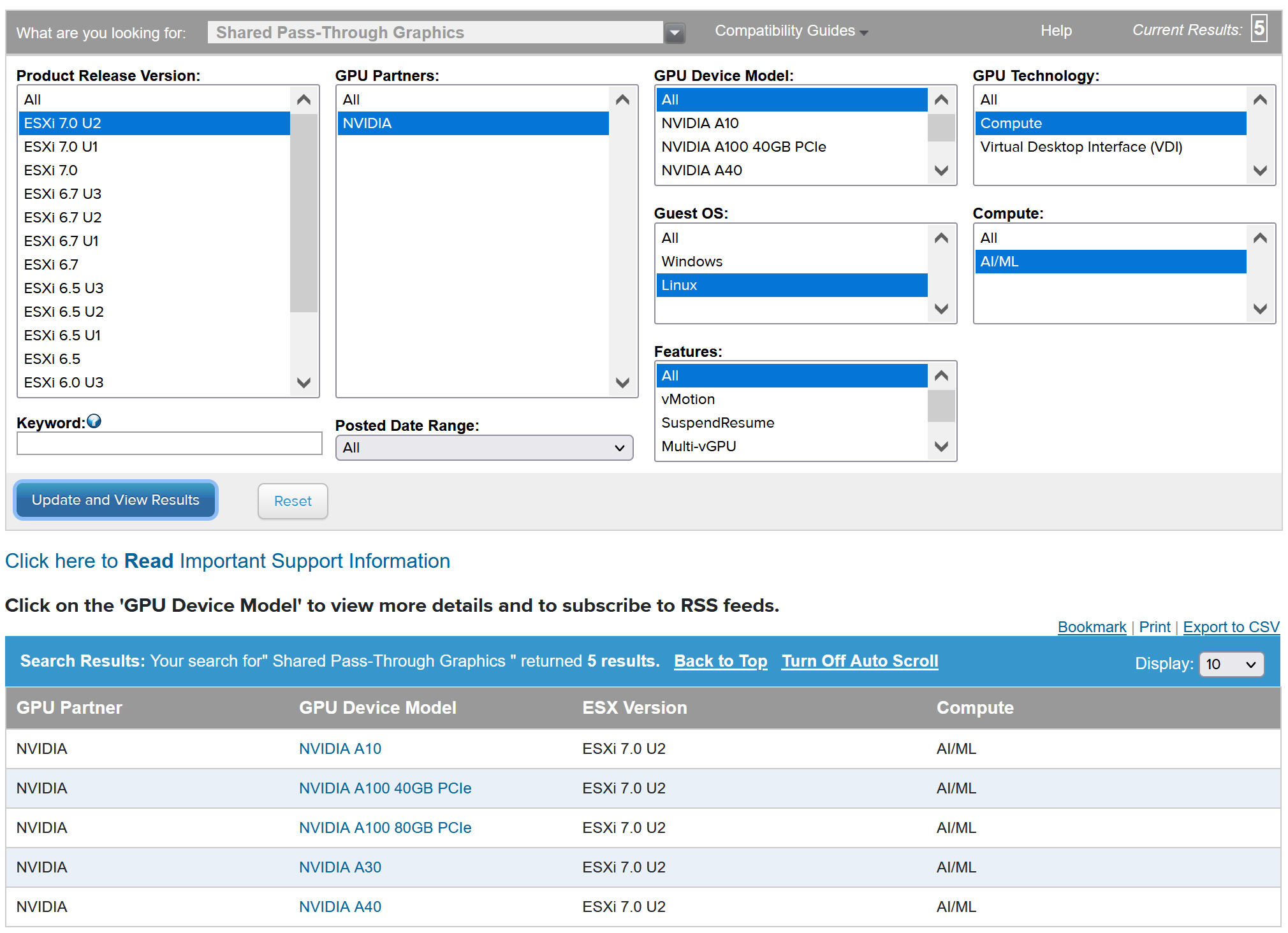

Informationen zum Anzeigen kompatibler NVIDIA GPU-Geräte finden Sie im VMware-Kompatibilitätshandbuch.

Das NVIDIA GPU-Gerät sollte die aktuellen vGPU-Profile von NVIDIA AI Enterprise (NVAIE) unterstützen. Weitere Informationen finden Sie in der Dokumentation Von der NVIDIA Virtual GPU-Software unterstützte GPUs.

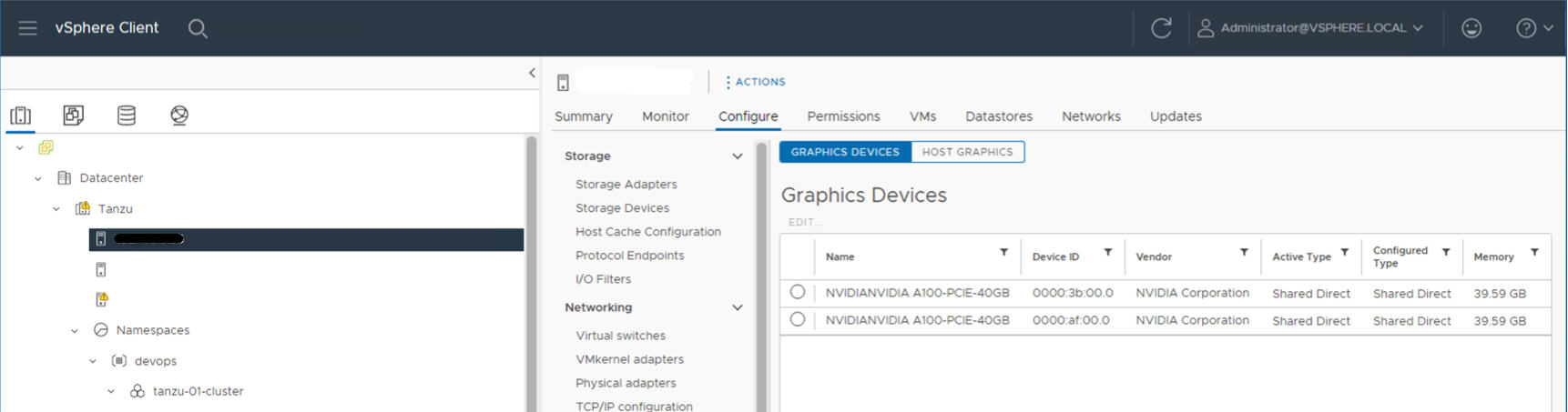

Auf dem folgenden ESXi-Host sind beispielsweise zwei NVIDIA GPU A100-Geräte installiert.

Schritt 3 für Administratoren: Konfigurieren aller ESXi-Hosts für vGPU-Vorgänge

Konfigurieren Sie für jeden ESXi-Host im vCenter-Cluster mit aktivierter Arbeitslastverwaltung den Host für NVIDIA vGPU, indem Sie „Direkt freigegeben“ und SR-IOV aktivieren.

Aktivieren von „Direkt freigegeben“ auf allen ESXi-Hosts

Aktivieren Sie zum Entsperren der NVIDIA vGPU-Funktion den Modus Direkt freigegeben auf allen ESXi-Hosts, aus denen sich der vCenter-Cluster zusammensetzt, auf dem Arbeitslastverwaltung aktiviert ist.

- Melden Sie sich beim vCenter Server mithilfe des vSphere Client an.

- Wählen Sie einen ESXi-Host im vCenter-Cluster aus.

- Wählen Sie aus.

- Wählen Sie das Gerät für die NVIDIA GPU-Beschleunigung aus.

- Bearbeiten Sie die Einstellungen des Grafikgeräts.

- Wählen Sie Direkt freigegeben aus.

- Wählen Sie unter Richtlinie für die Zuweisung von freigegebenen Passthrough-GPUs für optimale Leistung die Option VMs über GPUs verteilen aus.

- Klicken Sie auf OK, um die Konfiguration zu speichern.

- Beachten Sie, dass die Einstellungen nach dem Neustart des Hosts wirksam werden.

- Klicken Sie mit der rechten Maustaste auf den ESXi-Host und versetzen Sie ihn in den Wartungsmodus.

- Starten Sie den Host neu.

- Wenn der Host erneut ausgeführt wird, beenden Sie den Wartungsmodus.

- Wiederholen Sie diesen Vorgang für alle ESXi-Hosts in dem vSphere-Cluster, der Arbeitslastverwaltung unterstützt.

Einschalten von SR-IOV BIOS für NVIDIA GPU A30- und A100-Geräte

Wenn Sie NVIDIA A30- oder A100-GPU-Geräte verwenden, die für GPU mit mehreren Instanzen (MIG-Modus) benötigt werden, müssen Sie SR-IOV auf dem ESXi-Host aktivieren. Wenn SR-IOV nicht aktiviert ist, können Tanzu Kubernetes-Clusterknoten-VMs nicht gestartet werden. In diesem Fall wird die folgende Fehlermeldung im Bereich Aktuelle Aufgaben des vCenter Server angezeigt, für den Arbeitslastverwaltung aktiviert ist.

Could not initialize plugin libnvidia-vgx.so for vGPU nvidia_aXXX-xx. Failed to start the virtual machine. Module DevicePowerOn power on failed.

Melden Sie sich zum Aktivieren von SR-IOV über die Webkonsole beim ESXi-Host an. Wählen Sie aus. Wählen Sie das NVIDIA GPU-Gerät aus und klicken Sie auf SR-IOV konfigurieren. An dieser Stelle können Sie SR-IOV aktivieren. Weitere Informationen finden Sie unter Single Root I/O Virtualization (SR-IOV) in der vSphere-Dokumentation.

vGPU mit Dynamic DirectPath IO (Passthrough-fähiges Gerät)

- Melden Sie sich über vSphere Client bei vCenter Server an.

- Wählen Sie den ESXi-Zielhost im vCenter-Cluster aus.

- Wählen Sie aus.

- Wählen Sie die Registerkarte Alle PCI-Geräte aus.

- Wählen Sie das Zielgerät für die NVIDIA GPU-Beschleunigung aus.

- Klicken Sie auf Passthrough umschalten.

- Klicken Sie mit der rechten Maustaste auf den ESXi-Host und versetzen Sie ihn in den Wartungsmodus.

- Starten Sie den Host neu.

- Wenn der Host erneut ausgeführt wird, beenden Sie den Wartungsmodus.

Schritt 4 für Administratoren: Installieren des Treibers für den NVIDIA-Hostmanager auf allen ESXi-Hosts

Zum Ausführen von Tanzu Kubernetes-Clusterknoten-VMs mit der NVIDIA vGPU-Grafikbeschleunigung installieren Sie den Treiber des NVIDIA-Hostmanagers auf allen ESXi-Hosts, aus denen sich der vCenter-Cluster zusammensetzt, in dem Arbeitslastverwaltung aktiviert wird.

Die Treiberkomponenten des NVIDIA vGPU-Hostmanagers sind in einem vSphere-Installationspaket (VIB) enthalten. Das NVAIE-VIB wird Ihnen von Ihrer Organisation über das NVIDIA GRID-Lizenzierungsprogramm zur Verfügung gestellt. VMware stellt NVAIE-VIBs weder bereit noch können diese heruntergeladen werden. Im Rahmen des NVIDIA-Lizenzierungsprogramms richtet Ihre Organisation einen Lizenzierungsserver ein. Weitere Informationen finden Sie in der Kurzanleitung der Virtual GPU-Software von NVIDIA.

esxcli system maintenanceMode set --enable true esxcli software vib install -v ftp://server.domain.example.com/nvidia/signed/NVIDIA_bootbank_NVIDIA-VMware_ESXi_7.0_Host_Driver_460.73.02-1OEM.700.0.0.15525992.vib esxcli system maintenanceMode set --enable false /etc/init.d/xorg restart

Schritt 5 für Administratoren: Sicherstellen, dass ESXi-Hosts für NVIDIA vGPU-Vorgänge zur Verfügung stehen

- Melden Sie sich per SSH beim ESXi-Host an, wechseln Sie in den Shell-Modus und führen Sie den Befehl

nvidia-smiaus. Bei der NVIDIA-Systemverwaltungsschnittstelle handelt es sich um ein Befehlszeilendienstprogramm, das vom NVIDIA vGPU-Hostmanager bereitgestellt wird. Wenn Sie diesen Befehl ausführen, werden die GPUs und Treiber auf dem Host zurückgegeben. - Führen Sie den folgenden Befehl aus, um sicherzustellen, dass der NVIDIA-Treiber ordnungsgemäß installiert ist:

esxcli software vib list | grep NVIDA. - Stellen Sie sicher, dass der Host mit „Direkt freigegeben“ für GPU konfiguriert und SR-IOV eingeschaltet ist (bei Verwendung von NVIDIA A30- oder A100-Geräten).

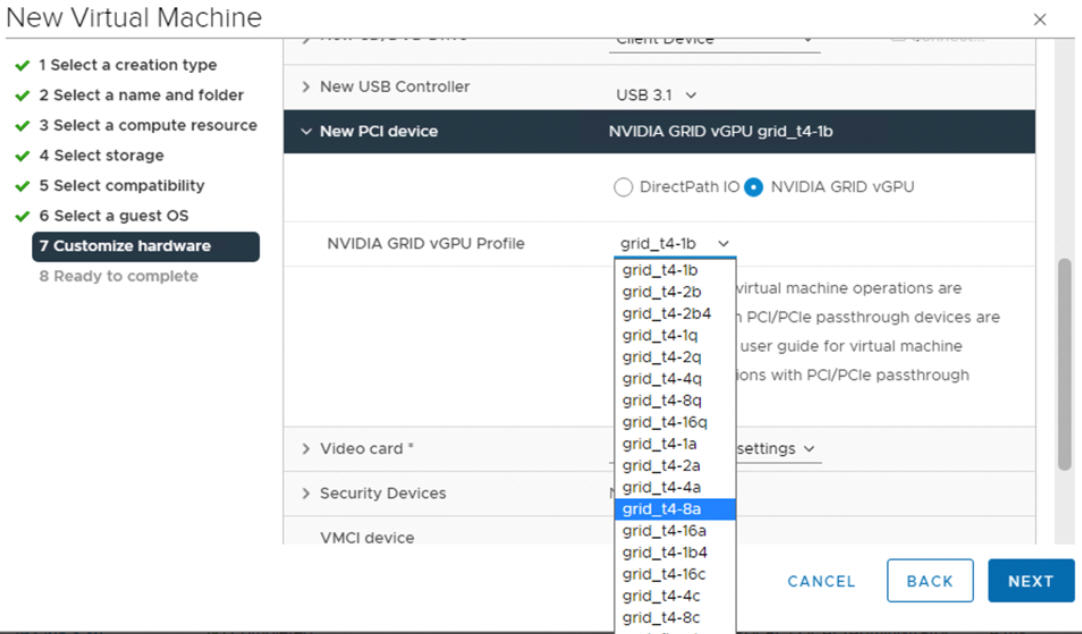

- Erstellen Sie mithilfe des vSphere Clients auf dem für GPU konfigurierten ESXi-Host eine neue virtuelle Maschine mit einem im Lieferumfang enthaltenen PCI-Gerät. Das NVIDIA vGPU-Profil sollte angezeigt werden und auswählbar sein.

Schritt 6 für Administratoren: Aktivieren der Arbeitslastverwaltung

Schritt 7 für Administratoren: Erstellen oder Aktualisieren einer Inhaltsbibliothek mit einer TKR Ubuntu-Version

Das Ubuntu-Betriebssystem wird für NVIDIA vGPU benötigt. Sie können die PhotonOS-Edition einer Tanzu Kubernetes-Version nicht für vGPU-Cluster verwenden.

VMware stellt Ubuntu-Editionen von Tanzu Kubernetes-Versionen bereit. Ab vSphere 8 wird die Ubuntu-Edition mithilfe einer Anmerkung in der Cluster-YAML angegeben.

Schritt 8 für Administratoren: Erstellen einer benutzerdefinierten VM-Klasse mit dem vGPU-Profil

Erstellen Sie eine benutzerdefinierte VM-Klasse mit einem vGPU-Profil. Sie verwenden diese VM-Klasse dann in der Clusterspezifikation, um die TKGS-Clusterknoten zu erstellen. Weitere Informationen finden Sie unter: Erstellen einer benutzerdefinierten VM-Klasse für NVIDIA vGPU-Geräte.

Schritt 9 für Administratoren: Konfigurieren des vSphere-Namespace

Erstellen Sie einen vSphere-Namespace für jeden bereitzustellenden TKG vGPU-Cluster. Weitere Informationen hierzu finden Sie unter Erstellen eines vSphere-Namespace für das Hosting von TKG-Dienst-Clustern.

Konfigurieren Sie den vSphere-Namespace, indem Sie vSphere SSO-Benutzer/Gruppen mit Bearbeitungsberechtigungen hinzufügen und eine Speicherrichtlinie für dauerhafte Volumes anhängen. Weitere Informationen hierzu finden Sie unter Konfigurieren eines vSphere-Namespace für TKG-Dienst-Cluster.

Verknüpfen Sie die TKR-Inhaltsbibliothek, in der das gewünschte Ubuntu-Image gespeichert ist, mit dem vSphere-Namespace. Weitere Informationen hierzu finden Sie unter Verknüpfen der TKR-Inhaltsbibliothek mit dem TKG-Dienst.

- Wählen Sie unter „vSphere-Namespace auswählen“ die Kachel VM-Dienst aus und klicken Sie auf VM-Klassen verwalten.

- Suchen Sie in der Liste der Klassen nach der von Ihnen erstellten benutzerdefinierten VM-Klasse.

- Aktivieren Sie die Klasse und klicken Sie auf Hinzufügen.

Schritt 10 für Administratoren: Überprüfen der Bereitschaft von Supervisor

Mithilfe der letzten Verwaltungsaufgabe wird sichergestellt, dass Supervisor bereitgestellt wird und vom Cluster-Operator zur Bereitstellung eines TKG-Clusters für KI-/ML-Arbeitslasten verwendet werden kann.

Weitere Informationen finden Sie unter Herstellen einer Verbindung zu TKG-Dienst-Clustern mithilfe der vCenter SSO-Authentifizierung.